1.本发明属于人工智能视频处理技术领域,涉及一种视频超分辨率方法及系统,具体涉及一种基于孪生超分辨率网络的压缩视频超分辨率方法及系统。

背景技术:

2.超分辨率是一种基于深度学习等智能化方法对各类质量不佳的图像和视频处理成高分辨率的技术。近年来,随着深度学习技术的发展,基于深度学习的超分辨率领域正在以前所未有的速度发展。目前,超分辨率技术的应用主要体现在老照片、视频的恢复,重要古代资料的恢复,获得更清晰的监控视频,手机相机的拍照成像等等领域。

3.传统超分辨率方法在生成高低分辨率训练数据对时,一般对视频进行高斯模糊后再进行四倍下采样以生成低分辨率数据。依据这样的范式,超分模型在近些年来获得了越来越好的表现。然而,不论是将这样训练得到的模型直接应用到压缩数据中,还是将模型简单地在压缩视频数据对上重新训练,都会遭受非常严重的性能损失。视频压缩是视频传输等场景的关键步骤,因此,针对压缩视频进行超分辨率有很强的现实意义。

4.视频压缩过程损失了高频细节信息,导致压缩视频的超分辨率重建更为困难。对比学习是较为典型的无监督或自监督学习方法,其主要思想是使模型能够更加充分地学习到编码器的特征,尽可能地缩小相似样本之间的距离,拉大压缩视频样本与负样本的距离,从而让聚类的界限更加明显。对比学习作为一种学习策略,在图像超分等领域取得了较好的效果。但一般而言,现存的研究中仅仅简单的将非当前超分视频的帧作为负样本,制约了对比学习的超分效果。

技术实现要素:

5.为了解决上述技术问题,本发明提出了一种超分辨率网络的压缩视频超分辨率方法及系统。基于对比学习的架构,将传统高斯模糊和bicubic下采样的非压缩视频与压缩视频一起输入孪生超分辨率网络中,促使孪生超分辨率网络学习到对压缩失真不敏感的特征表达,获得有利于压缩视频的孪生超分辨率网络。

6.本发明的方法所采用的技术方案是:一种孪生基于超分辨率网络的压缩视频超分辨率方法,将待处理低分辨率视频输入所述孪生超分辨率网络,获得超分辨率视频;所述孪生超分辨率网络,由两支并行设置超分辨率网络组成;所述超分辨率网络,包括编码器网络和上采样模块;所述编码器网络,由两类卷积层和若干pfrb模块组成;第一类卷积层以输入连续三帧图像的中心帧为输入,每帧大小为64

×

64

×

3,该卷积层将其大小转换为batchsize

×

64

×

64

×

80的特征图,第二类卷积层以除中心帧外其他的补充帧作为输入,输入数据大小为batchsize

×

64

×

64

×

6,卷积层将这样的数据转换为batchsize

×

64

×

64

×

80的特征图,最后,将这两个特征同上一轮上采样前的超分结果一起,输入连续的pfrb模块中;两种输入对应的两个编码器网络共享一个权重;其中,batchsize为梯度优化的批量样本数;

所述pfrb模块,数据先被输入到三个大小为3

×

3的卷积层中,这三个卷积层的输入输出通道数均为80,记输出为x1,然后对该卷积层的输出进行拼接,再使用一个1

×

1的卷积层将总通道数240变换为80,并且将得到的结果分别和x1中的三个结果进行拼接,得到的结果记为x2,最后,将x2中的三个结果分别输入到三个卷积层中,将输入数据的通道数压缩为80,然后将得到的三个结果与最初输入的三个结果对应加和,得到最终的结果;其中,各卷积层之间均使用leakyrelu激活函数来引入非线性关系;所述上采样模块,输入数据的大小为batchsize

×3×

64

×

64

×

80,首先经过一个3

×

3的卷积层,将数据通道数240转换为80,继续输入卷积层中,将通道数80转换为48;使用pytorch中的pixelshuffle函数对数据进行尺度为2的上采样,通道数压缩为12;得到的结果再经过一个卷积层处理,最后使用pixelshuffle函数进行一次尺度为2的上采样;输出的超分数据的尺寸为batchsize

×3×

256

×

256

×

3。

7.本发明的系统所采用的技术方案是:一种孪生基于超分辨率网络的压缩视频超分辨率系统,包括:一个或多个处理器;存储装置,用于存储一个或多个程序,当所述一个或多个程序被所述一个或多个处理器执行时,使得所述一个或多个处理器实现所述的孪生基于超分辨率网络的压缩视频超分辨率方法。

8.本发明的优点和积极效果:(1)本发明将负样本定义为本样本对应的压缩数据和bd数据的差,相较于过去方法中简单定义为其他的样本相比效果更好。相比于单样本输入网络,负样本,正样本与压缩视频样本一起能促使网络对压缩视频样本进行超分。

9.(2)本发明实现对压缩视频的超分辨率模型,解决了传统模型在压缩视频上效果急剧下降的问题。

附图说明

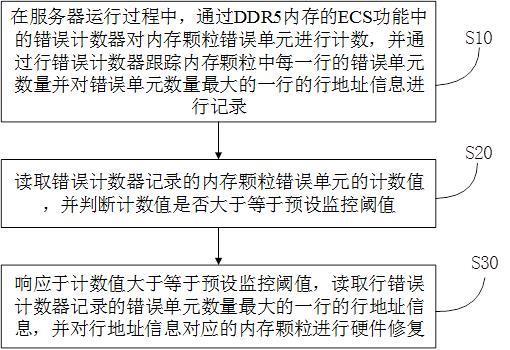

10.图1为本发明实施例的孪生超分辨率网络结构图;图2为本发明实施例的孪生超分辨率网络训练流程图;图3为本发明实施例的孪生超分辨率网络先行者与后继者架构图;图4为本发明实施例的孪生超分辨率网络主观实验结果。

具体实施方式

11.为了便于本领域普通技术人员理解和实施本发明,下面结合附图及实施例对本发明作进一步的详细描述,应当理解,此处所描述的实施示例仅用于说明和解释本发明,并不用于限定本发明。

12.现有的卷积神经网络结构在bd降质上能达到很好的效果,但是一旦切换场景,模型的表现将遭受大幅度下降。而将原始帧、bd降质帧和压缩帧这3个耦合样本送入孪生网络进行对比学习,能获得一个在压缩视频上也表现良好的超分辨率模型。

13.本发明提供的一种孪生基于超分辨率网络的压缩视频超分辨率方法,将待处理低分辨率视频输入本实施例的孪生超分辨率网络,获得超分辨率视频;

请见图1和图4,本实施例的孪生超分辨率网络,由两支并行设置超分辨率网络组成;本实施例的超分辨率网络,包括编码器网络和上采样模块;本实施例的编码器网络,指的是图1所示网络中除了上采样操作之外的网络结构,它由两类卷积层和若干pfrb模块组成;第一类卷积层以输入连续三帧图像的中心帧为输入,每帧大小为64

×

64

×

3,该卷积层将其大小转换为batchsize

×

64

×

64

×

80的特征图,第二类卷积层以除中心帧外其他的补充帧作为输入,输入数据大小为batchsize

×

64

×

64

×

6,卷积层将这样的数据转换为batchsize

×

64

×

64

×

80的特征图,最后,将这两个特征同上一轮上采样前的超分结果一起,输入连续的pfrb模块中;两种输入对应的两个编码器网络共享一个权重;其中,batchsize为梯度优化的批量样本数,本实施例取值16.。

14.本实施例的pfrb模块,采用resnet的基本框架,数据先被输入到三个大小为3

×

3的卷积层中,这三个卷积层的输入输出通道数均为80,记输出为x1,然后对该卷积层的输出进行拼接,再使用一个1

×

1的卷积层将总通道数240变换为80,并且将得到的结果分别和x1中的三个结果进行拼接,得到的结果记为x2,最后,将x2中的三个结果分别输入到三个卷积层中,将输入数据的通道数压缩为80,然后将得到的三个结果与最初输入的三个结果对应加和,得到最终的结果;其中,各卷积层之间均使用leakyrelu激活函数来引入非线性关系,使模型的表述能力更强;本实施例的上采样模块,目的是对输入数据进行上采样以达到超分的目的。上采样模块输入数据的大小为batchsize

×3×

64

×

64

×

80,首先经过一个3

×

3的卷积层,将数据通道数240转换为80,继续输入卷积层中,将通道数80转换为48;使用pytorch中的pixelshuffle函数对数据进行尺度为2的上采样,通道数压缩为12;得到的结果再经过一个卷积层处理,最后使用pixelshuffle函数进行一次尺度为2的上采样;总体来说,一共进行了尺度为4的上采样,实现了超分过程,输出的超分数据的尺寸为batchsize

×3×

256

×

256

×

3,本实施例中batchsize设置为16。

15.请见图2,本实施例的孪生超分辨率网络,是训练好的孪生超分辨率网络;其训练过程包括以下步骤:步骤1:针对包括若干高分辨率连续帧的原始数据集,将原始数据集中视频进行m-jpeg压缩并且bicubic下采样处理得到低分辨率的压缩图像,记为压缩视频;将原始数据集中视频进行高斯模糊并且bicubic下采样处理得到传统低质量图像,记为bd视频;本实施例中使用的原始数据集名称为mm522,其中包含522个各种类型的视频;本实施例对选择的原始数据集使用python pillow库中的函数读取视频,并使用m-jepg的格式写入,得到压缩后的视频,最后使用matlab中的imresize函数对视频进行bicubic下采样。

16.步骤2:利用编码器网络对输入的视频进行初步的特征提取,对于输入的5维视频数据,编码网络输出一个4维特征,通过leakyrelu激活函数处理4维特征,主要目的是引入非线性的函数关系,并且约束提取的两个特征之间的损失;步骤3:分别将提取到的特征送入上采样模块中继续进行超分,输出一个相比于输入长宽放大四倍的视频;分别约束两个输出和真值之间的关系,使其尽可能靠近,做为压缩视频样本和正样本的距离;记超分后的残差、真值视频与压缩视频的差这两者的距离为压缩视频样本与负样本之间的距离,需要在设定范围内尽可能大;

本实施例中,得到bd视频和压缩视频的超分结果,并且将两者与真值做约束,得到损失dis

positive

;;其中,y

bd

指bd视频超分后的结果,y

compress

指压缩视频超分后的结果,gt指真实值,ε表示一个常量,在实验中设置为1e-4,作用是维持损失数值的稳定;将dis

positive

记为压缩视频样本和正样本的距离;考虑负样本以及跟压缩视频样本与负样本的距离,将压缩视频与bd压缩视频做差,得到负样本,记为x

nega

;计算负样本和压缩视频样本的距离dis

negative

;;其中, m(x

nega

)、x

nega

分别表示负样本输入模型后得到的超分结果和负样本本身,这里使用的是的形式。

17.步骤4:计算总损失,使用反向传播梯度的方式对本实施例的孪生超分辨率网络进行训练;循环执行步骤1-4,将本实施例的孪生超分辨率网络训练到收敛,得到训练好的孪生超分辨率网络。

18.本实施例根据步骤3中计算得到的压缩视频样本与正样本之间的距离dis

positive

和压缩视频样本与负样本之间的距离dis

negative

,计算最终的损失;;其中,margin为超参数,用来设定两特征距离之间的间隔,本实施例中设置为0.2;计算出损失后,使用adam优化器对本实施例的孪生超分辨率网络进行反向传播并优化。

19.本实施例的超分辨率网络是先行者网络与后继者网络相结合的运算框架,先行者网络与后继者网络的结构完全相同,即编码器网络与上采样网络的组合。先行与后继概念描述的是数据在模型中的运算方式,详细如图3所示,先行者网络与后继者网络的结构相同,先行者网络的作用是通过“先行”提取在时间序列中处于待恢复帧之后的所有帧的信息,作为后继者最终超分的参考,图中hts指后继者产生的中间结果;htp指先行者产生的中间结果;先行者与后继者是同一模型结构,图示架构主要体现了数据输入网络中的处理方式。

20.本实施例使用该训练策略在mm522训练集训练并在vid4测试集上进行测试,测试指标为psnr/ssim得到结果如下: calendarcityfoliagewalkavg压缩视频超分22.12/0.694925.55/0.673924.37/0.618627.85/0.837624.97/0.7062

本实验首先在生成训练数据集方面,不同于传统模型针对高斯模糊后的样本进行训练,本实验将原始高质量视频进行m-jpeg格式的压缩。然后,将压缩版本和非压缩版本两类数据输入到孪生网络中,孪生网络设计为一个编码器和上采样模块的组合。最后,从四个方面约束模型的训练,两类视频经编码器提取到的特征应该尽可能靠近;两类视频的超分结果和真实值共同构成了一个三元组,三元组内元素互为正样本;负样本则是压缩数据与传统降质之间的残差超分的结果。对于calendar视频得到的主观结果如图4所示,可以看

出,通过这样对比学习的方式,模型能够最大限度地学习到对压缩视频超分需要的特征参数,获得更精细的超分辨率重建结果。

21.应当理解的是,上述针对较佳实施例的描述较为详细,并不能因此而认为是对本发明专利保护范围的限制,本领域的普通技术人员在本发明的启示下,在不脱离本发明权利要求所保护的范围情况下,还可以做出替换或变形,均落入本发明的保护范围之内,本发明的请求保护范围应以所附权利要求为准。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。