基于transformer的大模型知识图谱表示方法

技术领域

1.本发明属于知识图谱和机器学习领域,具体涉及基于transformer的大模型知识图谱表示方法。

背景技术:

2.transformer模型在包括自然语言处理、计算机视觉和图形挖掘在内的许多领域都取得了非凡的表现。然而,当涉及到知识图谱表示领域的时候,基于平移距离的模型(比如transe、transh等将关系知识嵌入向量空间,然后通过对这些向量使用预定义的score function来优化目标对象)基于主导地位,但是当前的模型想把所有的信息都编码到一个向量中是非常困难的,当前有几个工作是利用图上下文信息和图神经网络(gnn)或者基于注意力的模型来学习实体关系的表示。然而,这些方法在浅层网络架构的表达能力上仍然受到限制。

3.知识图谱补全任务是知识图谱表示中的重要应用,具体地,针对知识图谱补全任务:给定关系图谱g=(e,r),图谱由节点集合e={e1,e2,e3,

…

}和关系集合r={r1,r2,r3,

…

}组成。图的结构可以由一个邻接矩阵a∈{0,1}

|v|

×

|v|

,v表示图中的节点个数。如果两个相邻节点之间存在路径邻接矩阵中的元素a[i,j]的值就为1,否则就为0。在知识图谱补全任务中,一个三元组表示为其中为头实体,为关系,为尾实体。假设使用ν

mask

来表示三元组中缺失的那一部分。为了简单起见,可以考虑尾实体的连接任务。则知识图谱补全的任务就是学习一个映射其中的标签就是缺失了的尾实体关系的预测也同样可以用相同的方式,用符号ν

mask

来代替

[0004]

利用transformer模型对知识图谱进行学习时,transformer模型足够的深,但在图领域还没有达到与之相匹配的性能。现有的方法要么是利用非常复杂的score function函数比如传统的transe和rotate等,例如现有文献rotate:knowledge graph embedding by relational rotation in complex space公开的rotate模型,再例如现有文献translating embeddings for modeling multi-relational data公开的transe模型,要么就是依赖于文本的外部知识,未能充分捕捉到知识图谱内在的语义信息和结构信息。

技术实现要素:

[0005]

鉴于上述,本发明的目的是提供一种基于transformer的大模型知识图谱表示方法,能给充分捕获知识图谱中的结构信息以及上下文语义信息。并采用掩码的方式作为知识图谱表示学习,提升知识图谱表示学习的准确性,进而提升知识图谱补全的能力。

[0006]

为实现上述发明目的,实施例提供的基于transformer的大模型知识图谱表示方法,包括以下步骤:

[0007]

步骤1,从知识图谱随机采样包含中心三元组的子图,将子图中非三元组的实体节点和实体节点之间的关系均作为上下文节点,将中心三元组与对应的上下文节点序列化以

得子图序列,同时构建子图序列的邻接矩阵,对子图序列中的中心三元组中任意节点掩码,得到掩码子图序列;

[0008]

步骤2,利用transformer提取掩码子图序列中节点的嵌入表示,提取时,以邻接矩阵的多维幂次方作为结构信息,并将结构信息的编码向量添加到transformer的注意力机制中,以得到掩码节点的嵌入表示;

[0009]

步骤3,利用分类器对掩码节点的嵌入表示进行词义预测,以得到词义预测结果;

[0010]

步骤4,根据词义预测结果与候选节点的词义真值构建监督损失,同时基于正负样本采样构建一致性正则化损失,并基于监督损失一致性正则化损失优化transformer和分类器的参数;

[0011]

步骤5,针对待补全的知识图谱,利用参数优化的transformer和分类器的参数预测缺失节点的词义预测结果,利用该词义预测结果进行知识图谱的补全。

[0012]

优选地,子图序列表示为其中,表示中心三元组,分别表示头实体节点、头实体和尾实体之间的关系节点、尾实体节点,ν1,ν2,ν3,

…

,νn均为上下文节点,将中心三元组中任意节点掩码处理后,得到掩码子图序列x

mask

,假设被掩码节点为尾实体节点,则掩码子图序列x

mask

表示为:

[0013][0014]

优选地,利用transformer提取掩码子图序列中节点的嵌入表示时,采用注意力机制计算注意力权重时,通过以下方式添加结构信息的编码向量:

[0015][0016][0017]

其中,α

ij

表示根据第i个隐藏向量和第j个隐藏向量hj计算的注意力权重,wq和wk表示注意力机制中q通道和k通道中线性变换的权重矩阵,d表示特征向量的维度,φ(i,j)表示结构信息的编码向量值,f

structure

(

·

)表示线性编码操作,分别表示归一化邻接矩阵的一次方,二次方,

…

,幂次方,m为可调参数,取值为1-5。

[0018]

优选地,构建的监督损失表示为:

[0019][0020]

其中,字符c代表候选节点集合,其中包括了实体节点以及关系节点,字符s表示为知识图谱中的特定采样子图,表示被采样的掩码子图序列,表示候选节点的真值标签,表示掩码子图序列关于候选节点的词义预测结果。

[0021]

优选地,构建的一致性正则化损失表示为:

[0022][0023]

其中,c

t

和c

t-1

是前后两个epoch中输入正样本中掩码节点的嵌入表示,cj表示采样负样本掩码节点的嵌入表示,sim(

·

)代表余弦相似度,τ是一个超参数,负样本是与正样本不同的指其他中心三元组的掩码子图序列。

[0024]

优选地,所述掩码子图序列被输入至transformer之前需要经过向量初始化,具体过程表示为:

[0025]h′

=h z

semantic

[0026]

其中,h表示对序列中单个词的随机初始化,z

semantic

表示利用预训练语言模型对单个词的语义嵌入向量,h

′

表示单个词的最终向量初始化。

[0027]

优选地,步骤5中,接收待补全的知识图谱,从知识图谱中提取包含待补全三元组的子图,并构建子图序列和对应的邻接矩阵后,利用参数优化的transformer提取缺失节点的嵌入表示,利用分类器对缺失节点的嵌入表示进行词义预测,以得到词义预测结果,依据词义预测结果对三元组中的缺失内容进行补全。

[0028]

优选地,在进行知识图谱补全时,构建包含缺失三元组的k个子图序列及对应的邻接矩阵,并预测对应的k个缺失节点的嵌入表示,然后对多个嵌入表示进行合并,得到合并嵌入表示,利用分类器对合并嵌入表示进行词义预测,得到词义预测结果;其中,合并嵌入表示hk表示第k个子图序列中缺失节点的嵌入表示。

[0029]

与现有技术相比,本发明具有的有益效果至少包括:

[0030]

1、能给有效利用图的结构特征,不再使用传统的基于score function的方式,用transformer模型解决知识图谱补全任务。

[0031]

2、采用这种结构特征的方式,效果优于transe。

附图说明

[0032]

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图做简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动前提下,还可以根据这些附图获得其他附图。

[0033]

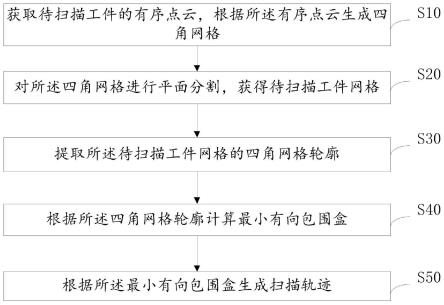

图1是实施例提供的基于transformer的大模型知识图谱表示方法的流程图;

[0034]

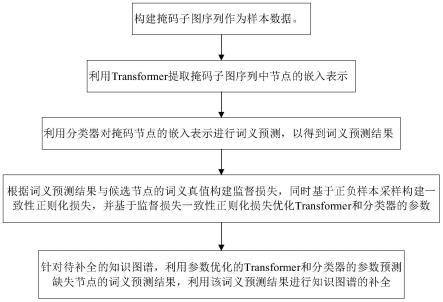

图2是实施例提供的基于transformer的大模型的结构示意图。

具体实施方式

[0035]

为使本发明的目的、技术方案及优点更加清楚明白,以下结合附图及实施例对本发明进行进一步的详细说明。应当理解,此处所描述的具体实施方式仅仅用以解释本发明,并不限定本发明的保护范围。

[0036]

如图1所示,实施例提供的基于transformer的大模型知识图谱表示方法,包括以下步骤:

[0037]

步骤1,构建掩码子图序列作为样本数据。

[0038]

实施例中,知识图谱往往非常庞大,整个知识图谱无法直接全部放入transformer中去。为了减缓这种限制,采用triplet2seq构建三元组子图,将三元组子图作为序列的输入来编码局部的信息结构。采样的包含中心三元组的子图表示为其中,表示中心三元组,分别表示头实体节点、头实体和尾实体之间的关系节点、尾实体节点,ν1,ν2,ν3,

…

,νn均为上下文节点,表示上下文信息context,将子图中非三元组的实体节点和实体节点之间的关系均作为上下文节点,如图2所示,实体节点用大圆圈表示,关系节点用小圆圈表示,在采样时,给定提前定义好的最大节点个数d,通过对中心三元组周围的m个邻居节点进行采样,来构建三元组子图。这样做,具有以下有益效果:

[0039]

(1)transformer不能获取到全知识图谱的注意力attention,因为计算的复杂度是n代表序列的长度。因此充分利用有效地抽样策略在一个大的关系知识图谱上是有利的;

[0040]

(2)知识图谱构建任务是基于三元组的,因此选择每个三元组作为中心节点,然后随机抽样周边节点来作为上下文。这一策略使得结构化的三元组在训练中更加有效,并且增强了训练任务和下游任务之间的一致性;

[0041]

(3)知识图谱的关系通常是密集的,丰富的。由于transformer的序列长度是有限的,训练中的问题是无法对每个三元组的整个图进行采样。需要使用动态采样的策略来捕获整个局部的结构信息,在训练的每个epoch中从相同的中心三元组周围采样都有可能是不相同的。

[0042]

在得到三元组子图序列后,需要随机屏蔽输入的特定token,然后去预测这些被屏蔽的token。对于子图序列将中心三元组中任意节点掩码处理,随机遮掩中心三元组中的token,具体来说也就是和关系节点会被随机mask,得到掩码子图序列x

mask

,假设被掩码节点为尾实体节点,则掩码子图序列x

mask

表示为:

[0043][0044]

由于三元组图的独特结构,每次只随机替换一个“屏蔽”标记以更好地整合上下文信息。

[0045]

实施例中,还根据三元组子图虚了构建邻接矩阵a,将这个邻接矩阵归一化后能够得到归一化邻接矩阵该的m幂次方得到的邻居邻接矩阵幂保持节点对之间的空间关系,用于表示步长为m的节点对之间的路径个数。

[0046]

步骤2,利用transformer提取掩码子图序列中节点的嵌入表示。

[0047]

实施例中,掩码子图序列被输入至transformer之前,需要经过向量初始化。实施例用语义的编码作为输入,将语义编码作为图transformer的附加信号。具体地说,开发了一种语义编码,它为每个节点分配一个预训练的语义嵌入向量。由于语义编码应用于每个节点,只需将其添加到节点特征作为输入,表示为:

[0048]h′

=h z

semantic

[0049]

其中,h表示对序列中单个词的随机初始化,z

semantic

表示利用预训练语言模型对单个词的语义嵌入向量,h

′

表示单个词的最终向量初始化。

[0050]

通过在输入中使用语义嵌入向量,注意力机制可以捕获查询和键中的语义重要性信号。因此transformer可以同时捕获注意力机制中的语义相关性和节点重要性。

[0051]

实施例中,利用transformer提取节点的嵌入表示时,以邻接矩阵的多维幂次方作为结构信息,并将结构信息的编码向量添加到transformer的注意力机制中,以得到掩码节点的嵌入表示。具体地,在注意力机制中,输入的序列向量通过q(query)、k(key)、v(value)三个通道的线性变换得到对应的三个矩阵,然后通过以下方式添加结构信息的编码向量:

[0052][0053][0054]

其中,α

ij

表示根据第i个隐藏向量和第j个隐藏向量hj计算的注意力权重,wq和wk表示注意力机制中q通道和k通道中线性变换的权重矩阵,d表示特征向量维度,φ(i,j)表示结构信息的编码向量值,f

structure

(

·

)表示线性编码操作,分别表示归一化邻接矩阵的一次方,二次方,

…

,幂次方,m为可调参数,取值为1-5。

[0055]

该α

ij

经过softmax之后,与v通道的矩阵通过矩阵点乘(matmul)得到掩码节点的嵌入向量。

[0056]

步骤3,利用分类器对掩码节点的嵌入表示进行词义预测,以得到词义预测结果。

[0057]

实施例中,分类器可以采用mlp实现语义预测分类。

[0058]

步骤4,根据词义预测结果与候选节点的词义真值构建监督损失,同时基于正负样本采样构建一致性正则化损失,并基于监督损失一致性正则化损失优化transformer和分类器的参数。

[0059]

实施例中,给定抽样的已经mask掉的节点序列目标是预测出被mask掉的token,也就是所以transformer的loss定义如下:

[0060][0061]

其中,字符c代表候选节点集合,其中包括了实体节点以及关系节点,字符s表示为知识图谱中的特定采样子图,表示被采样的掩码子图序列,表示候选节点的真值标签,表示掩码子图序列关于候选节点的词义预测结果。

[0062]

实施例中,为了克服同一三元组采样子图不一致性的问题,还引入了动态采样过程中上下文对比的策略。在epoch中给定子图序列的隐层表示h,目标是最小化同一三元组不同上下文之间的不同。具体见一致性正则化损失l

contextual

,表示为:

[0063]

[0064]

其中,c

t

和c

t-1

是前后两个epoch中输入正样本中掩码节点的嵌入表示,cj表示采样负样本掩码节点的嵌入表示,sim(

·

)代表余弦相似度,τ是一个超参数,负样本是与正样本不同的指其他中心三元组的掩码子图序列。

[0065]

基于以上监督损失和一致性正则化损失,构建的总损失l

overall

为:

[0066]

l

overall

=l

mkm

λl

contextual

[0067]

其中,λ表示调节比例。利用该总损失l

overall

优化transformer和分类器的参数,缩小同一中心三元组之间的差异,并增大不同中心三元组之间的差异。

[0068]

步骤5,针对待补全的知识图谱,利用参数优化的transformer和分类器的参数预测缺失节点的词义预测结果,利用该词义预测结果进行知识图谱的补全。

[0069]

掩码知识建模是一种通用的策略,可以增强上下文编码的过程。然而,当进行连接预测的时候,挑战在于预测掩码令牌的未知结构,可能会导致严重的标签泄露问题。为了弥补训练和测试场景之间的差距,将删除预测实体的上下文并确保公平比较。具体地,接收待补全的知识图谱,从知识图谱中提取包含待补全三元组,并构建待补全三元组序列,并非是包含待补全三元组的子图,即将子图中的上下文信息删除,仅仅保留待补全三元组,同时构建待补全三元组的邻接矩阵后,利用参数优化的transformer提取缺失节点的嵌入表示,利用分类器对缺失节点的嵌入表示进行词义预测,以得到词义预测结果,依据词义预测结果对三元组中的缺失内容进行补全。

[0070]

实施例中,为了增加预测的准确性,在进行知识图谱补全时,构建包含缺失三元组的k个子图序列及对应的邻接矩阵,并预测对应的k个缺失节点的嵌入表示,然后对多个嵌入表示进行合并,得到合并嵌入表示,利用分类器对合并嵌入表示进行词义预测,得到词义预测结果;其中,合并嵌入表示hk表示第k个子图序列中缺失节点的嵌入表示。

[0071]

上述实施例提供的基于transformer的大模型知识图谱表示方法,相比较传统的基于平移距离的模型,不再使用构造复杂的score function,让模型变得简单直接,另外,不需要引入额外的节点信息,能够有效地捕捉知识图谱内部的语义信息以及结构信息,进而提升了补全的准确性。

[0072]

上述实施例提供了一种基于transformer的大模型知识图谱表示方法,用于知识图谱的缺失补全,具体地应用到电商领域,在电商知识图谱中实体表示用户、商品等,关系表示用户与商品之间的购买关系,用户和用户之间的相识关系,以及用户和商品之间的商品维度关系、品类维度关系,其中,商品维度关系包含了相似商品关系以及商品描述关系,品类维度关系包含商品所属类目的层级关系,基于transformer的大模型知识图谱表示方法中的步骤1-步骤5来预测电商知识图谱中新用户或商品,利用新用户或商品补全电商知识图谱。

[0073]

上述实施例提供的一种基于transformer的大模型知识图谱表示方法也可以用于生物医疗领域中蛋白质知识图谱的补全。在蛋白质知识图谱中,实体表示蛋白质、蛋白质功能,关系表示蛋白质与蛋白质功能之前的连接关系,表示蛋白质是否具有相应的蛋白质功能,还表示蛋白质与蛋白质之间的相互作用,基于transformer的大模型知识图谱表示方法中的步骤1-步骤5来预测新蛋白质或蛋白质功能,利用新蛋白质或蛋白质功能补全电商知

识图谱。

[0074]

以上所述的具体实施方式对本发明的技术方案和有益效果进行了详细说明,应理解的是以上所述仅为本发明的最优选实施例,并不用于限制本发明,凡在本发明的原则范围内所做的任何修改、补充和等同替换等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。