1.本发明涉及分层联邦学习训练预测模型领域。

背景技术:

2.2017年,谷歌提出了联邦学习的概念,并提出了一种联邦平均算法,使参与模型训练的各方(称为用户或客户端)协同训练深度学习模型,用户无需把数据上传到数据中心,保护了用户的隐私。联邦学习的基本过程是,用户从云服务器下载全局模型,在本地训练后,将模型权重上传到服务器进行模型聚合。重复该过程,直到模型达到所需的精度。这被称为基于云的联邦学习模型。在基于云的联邦学习架构中,参与联邦学习的用户数量可达数百万,提供了深度学习所需的海量数据。然而,由于网络拥塞等原因,导致客户端与云服务器的通信速度缓慢且结果不可预测,整个训练过程效率低下。随着边缘计算平台的出现,研究人员开始研究基于边缘的联邦学习模型。在该模型中,相邻的边缘服务器充当参数服务器,而边缘服务器通信范围内的客户端则协同训练深度学习模型。与基于云的联邦学习模型相比,基于边缘的联邦学习模型中的参数服务器被放置在离客户端最近的边缘,例如,可以使用基站充当参数服务器。此时,计算的延迟与边缘参数服务器的通信延迟相当,可以在计算开销和通信开销之间寻求更好的权衡。但是,在基于边缘的联邦学习中,每个边缘服务器可以访问的客户端数量有限,参与训练的数据量较少,训练的模型精度较低。

3.2019年,有研究人员提出了“云服务器-边缘服务器-客户端”三层架构的分层联邦学习模型,充分利用基于云的联邦学习和基于边缘的联邦学习模型的优点,不仅减少了通信开销,而且提高了模型精度。分层联邦学习实现分布式训练主要包含三个步骤:1)客户端用本地数据训练并更新局部模型;2)边缘服务器聚合客户端训练的局部模型;3)云服务器进一步聚合边缘服务器上传的全局模型。最终,在云服务器中得到一个全局模型。与基于云的联邦学习相比,分层联邦学习在每轮训练中,边缘服务器增加了一个模型聚合的步骤,可以显著减少与云服务器的通信开销,并辅以高效的客户端边缘更新,从而大幅减少运行时间和本地迭代次数。另一方面,与基于边缘的联邦学习相比,分层联邦学习使用更多数据训练模型,训练的模型优于基于边缘的联邦学习。

4.现有的分层联邦学习方法受到数据异质性的影响,当客户端的数据呈现非独立同分布时表现不佳,原因是一个统一的全局模型无法很好的概括所有非独立同分布数据特征。

技术实现要素:

5.为了解决现有的分层联邦学习方法在客户端数据是非独立同分布时表现不佳的问题,本发明提出了一种分层联邦学习的个性化方法,通过为每个边缘服务器训练一个个性化模型来提高预测模型的性能。

6.本发明所采用的技术方案是:在每个边缘服务器上维护一个本地模型、一个全局模型、一个混合参数、一组可学习的标准化参数。本地模型、混合参数以及标准化参数只参

与客户端和边缘服务器这两层的训练和聚合,以体现边缘服务器下的客户端数据的本地知识。全局模型不仅参与客户端和边缘服务器的训练和聚合,还要上传到云服务器进行相似度聚合,以体现全局数据知识。本发明方法共迭代训练k轮,其中每一轮的训练包括五个步骤。

7.第一步:边缘服务器层和客户端对参数进行t次的更新,而每次更新又包括以下五个步骤。

8.1.1:边缘服务器将本地模型、全局模型、混合参数以及标准化参数发给其连接的客户端;

9.1.2:客户端用标准化参数对自己的本地数据进行标准化;

10.1.3:客户端用标准化后的数据训练并更新本地模型、全局模型、混合参数以及标准化参数;

11.1.4:客户端将更新后的本地模型、全局模型、混合参数和标准化参数上传到其连接的边缘服务器;

12.1.5:边缘服务器对收到的本地模型、全局模型、混合参数以及标准化参数进行平均聚合。

13.第二步:边缘服务器将聚合的全局模型上传至云服务器。

14.第三步:云服务器进行相似度聚合。云服务器为每个边缘服务器聚合一个个性的模型,使用tanimoto系数计算模型之间的相似度,相似度大的模型设置更大的权重,突出了相似模型在聚合模型中的作用。

15.第四步:云服务器将聚合后的全局模型发给对应的边缘服务器。

16.第五步:边缘服务器混合全局模型和本地模型,将混合后的模型以及标准化参数作为自己的个性化模型。

17.本发明的有益效果是:首先我们目标是为每个边缘服务器得到个性化模型,边缘服务器连接的客户端共同训练一个个性化模型,这可以解决传统联邦学习中模型过拟合问题。其次,本发明将本地模型和全局模型混合后的模型以及标准化参数作为每个边缘服务器的个性化模型,实现了每个边缘服务器在保留本地数据知识的同时学习到全局知识,进而实现了个性化。而且,云服务器采用相似度聚合来为每个边缘服务器聚合一个个性化的模型,提高了云服务器聚合模型的可用性。最后,通过额外维护可学习的标准化参数,不仅可以提高个性化程度,而且标准化参数本身具有提高收敛速度的作用。

附图说明

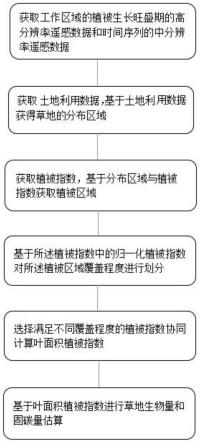

18.下面将结合附图及实施例对本发明作进一步说明,附图中:图1说明了本发明的训练过程。序号

①

表示训练过程的第一步,即边缘服务器层和客户端训练t次。1.1,1.2,1.3,1.4,1.5分别是第一步的五个子步骤。序号

②

表示第二步,即边缘服务器把聚合的全局模型上传到云服务器。序号

③

表示第三步,云服务器用相似度聚合方法聚合各个边缘服务器上传的模型,为每个边缘服务器聚合一个个性化的模型。序号

④

表示第四步,云服务器把聚合的个性化模型下发给相应的边缘服务器。序号

⑤

表示第五步,边缘服务器混合本地模型和云服务器下发的模型,得到本轮的个性化模型。上述过程共经过k轮,边缘服务器得到最终的个性化模型,该边缘服务器下连接的所有客户端共享最终的个性化模型。

具体实施方式

19.考虑一个分层联邦学习框架,他有一个云服务器,云服务器下连接l个边缘服务器,用e

l

(1≤l≤l)表示某个边缘服务器,e

l

下连接m

l

个客户端,用c

l,i

表示连接在e

l

下的第i个客户端,1≤i≤m

l

。d

l,i

表示c

l,i

本地的数据集。假设同一边缘服务器下的客户端的数据是独立同分布的,而不同边缘服务器下的客户端的数据是非独立同分布的。这是现实世界应用中的一个常见假设,地理位置相近的用户连接到同一个边缘服务器,他们的数据集有相似的数据分布,而地理位置相距较远的用户,连接到不同的边缘服务器,他们的数据集有不同的数据分布。例如,假设一个大规模的森林监测系统有一个云服务器,它由不同区域的多个子系统组成,每个子系统有一个边缘服务器。同一地区的数据是独立同分布的。然而,由于气候和环境的差异,不同地理位置的子系统所收集的数据是非独立同分布的。

20.边缘服务器e

l

维护一个全局模型w

l

、一个本地模型v

l

、一个混合参数α

l

、一组可学习的标准化参数γ

l

、β

l

。记e

l

的第k轮的训练是把的第k轮的训练是把更新为当k=1,即第一轮训练开始前,e

l

初始化全局模型本地模型混合参数标准化参数第k轮的过程如下:

21.第一步:e

l

和其连接的客户端训练次,得到第t(1≤t≤t)次的训练是把第t(1≤t≤t)次的训练是把训练更新为当t=1时,为第t次的训练过程如下。

22.1.1:e

l

将发给其客户端。

23.1.2:c

l,i

使用参数和标准化本地数据集d

l,i

,得到即:

[0024][0025][0026]

其中,e(d

l,i

)和var(d

l,i

)分别代表d

l,i

的均值和方差,∈是一个很小的超参数,防止分母为0,是标准化过程的中间结果。

[0027]

1.3:c

l,i

使用训练即:

[0028][0029][0030]

[0031][0032][0033]

其中η是学习率,是梯度,f是损失函数,采用的方法是梯度下降法。

[0034]

1.4:c

l,i

将上传至e

l

。

[0035]

1.5:e

l

进行平均聚合,得到即:

[0036][0037][0038][0039][0040][0041]

其中,|d

l,i

|表示客户端c

l,i

上的数据数量,|d

l

|表示e

l

下所有客户端的数据总的数量。

[0042]

第二步:第一步完成后,e

l

得到此时此时是第k轮的最终结果,所以用分别表示。e

l

将上传至云服务器。

[0043]

第三步:云服务器进行相似度聚合,即:

[0044][0045][0046]

其中tan()是tanimoto系数,用来衡量模型之间的相似度,tanimoto系数的计算方法是:

[0047][0048]

第四步:云服务器将下发给对应的边缘服务器。

[0049]

第五步:e

l

将收到的和自己的通过混合,即:

[0050][0051]el

将和标准化参数作为自己本轮的个性化模型。

[0052]

以上是本发明的具体实施过程,通过这个过程我们在分层联邦学习上实现了模型个性化,并且将个性化模型部署在边缘服务器端可以解决模型过拟合的问题。此外,在个性化方法中,我们使用了标准化参数,提高了模型的精度和收敛速度,在云服务器使用相似度聚合,进一步提高了个性化模型的精度。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。