1.本公开内容涉及用于车辆中一般障碍检测的基于传感器融合的俯视三维(3d)纹理表示。

背景技术:

2.车辆(例如,汽车、卡车、建筑设备、农场设备、自动化工厂设备)越来越多地包括传感器来获取关于车辆及其环境的信息。关于车辆周围环境的信息有助于自主或半自主操作。示例性的半自主操作包括自动制动、自适应巡航控制和碰撞避免。提供关于车辆周围环境的信息的示例性传感器包括无线电探测和测距(雷达)系统、光探测和测距(激光雷达)系统和照相机。虽然使用一个或多个传感器的对象检测通常需要识别对象的类型(例如,汽车),但是一般障碍检测指的是检测一般(未识别的)结构,换句话说,是识别没有任何对象的自由空间。自由空间的识别有助于确定车辆可以行驶的位置。因此,期望为车辆中的一般障碍检测提供基于传感器融合的俯视3d纹理表示。

技术实现要素:

3.在一个示例性实施例中,车辆中的系统包括第一传感器,以从第一视场获得第一传感器数据并提供第一俯视特征表示。该系统还包括第二传感器,以从与第一视场重叠的第二视场获得第二传感器数据,并提供第二俯视特征表示。处理电路实现神经网络,并基于第一俯视特征表示和第二俯视特征表示提供俯视三维纹理表示。俯视三维纹理表示用于控制车辆的操作。

4.除了这里描述的一个或多个特征之外,第一传感器是照相机,第一传感器数据是二维图像。

5.除了这里描述的一个或多个特征之外,第二传感器是激光雷达系统,并且第二传感器数据是三维的。

6.除了这里描述的一个或多个特征之外,第二传感器是雷达系统,并且第二传感器数据是三维的。

7.除了本文描述的一个或多个特征之外,第一神经网络基于第一传感器数据提供第一俯视特征表示,第二神经网络基于第二传感器数据提供第二俯视特征表示。

8.除了这里描述的一个或多个特征之外,处理电路融合第一俯视特征表示和第二俯视特征表示,以使用第三神经网络获得融合的俯视特征表示。

9.除了这里描述的一个或多个特征之外,处理电路将融合的俯视特征表示转换到极坐标系统,以获得融合的俯视三维纹理表示。俯视三维纹理表示的每个纹理用两个或更多个属性的值编码。

10.除了本文描述的一个或多个特征之外,处理电路使用神经网络基于融合的俯视三维纹理表示来执行一般障碍检测。

11.除了本文描述的一个或多个特征之外,两个或多个属性包括基于一般障碍检测所检测到的对象的距离和对象的高度。

12.除了本文描述的一个或多个特征之外,两个或多个属性包括基于一般障碍检测而检测到的对象的类型、外观或颜色。

13.在另一示例性实施例中,一种方法包括基于来自车辆中第一传感器的第一视野的第一传感器数据获得第一俯视特征表示。该方法还包括基于来自车辆中第二传感器的第二传感器数据获得第二俯视特征表示,该第二传感器具有与第一视野重叠的第二视野。实施神经网络以基于第一俯视特征表示和第二俯视特征表示来提供俯视三维纹理表示。俯视三维纹理表示用于控制车辆的操作。

14.除了这里描述的一个或多个特征之外,第一传感器是照相机,第一传感器数据是二维图像。

15.除了这里描述的一个或多个特征之外,第二传感器是激光雷达系统,并且第二传感器数据是三维的。

16.除了这里描述的一个或多个特征之外,第二传感器是雷达系统,并且第二传感器数据是三维的。

17.除了本文描述的一个或多个特征之外,该方法还包括使用第一神经网络提供基于第一传感器数据的第一俯视特征表示,以及使用第二神经网络提供基于第二传感器数据的第二俯视特征表示。

18.除了本文描述的一个或多个特征之外,该方法还包括使用处理电路融合第一俯视特征表示和第二俯视特征表示,以使用第三神经网络获得融合的俯视特征表示。

19.除了这里描述的一个或多个特征之外,该方法还包括使用处理电路将融合的俯视特征表示转换到极坐标系统,以获得融合的俯视三维纹理表示,俯视三维纹理表示的每个纹理用两个或更多个属性的值编码。

20.除了本文描述的一个或多个特征之外,该方法还包括使用处理电路,基于使用神经网络的融合俯视三维纹理表示来执行一般障碍检测。

21.除了本文描述的一个或多个特征之外,两个或多个属性包括基于一般障碍检测的对象的距离和对象的高度。

22.除了本文描述的一个或多个特征之外,两个或多个属性包括基于一般障碍检测而检测到的对象的类型、外观或颜色。

23.当结合附图时,从以下详细描述中,本公开的上述特征和优点以及其他特征和优点将变得显而易见。

附图说明

24.其他特征、优点和细节仅通过示例的方式出现在以下详细描述中,详细描述参考附图,其中:

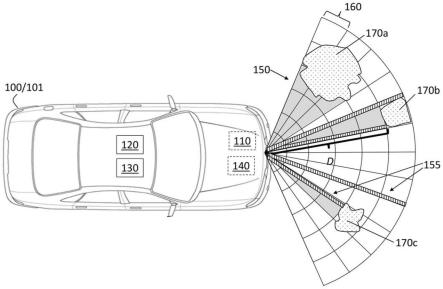

25.图1是获得用于一般障碍检测的基于传感器融合的俯视三维纹理表示的车辆的框图;和

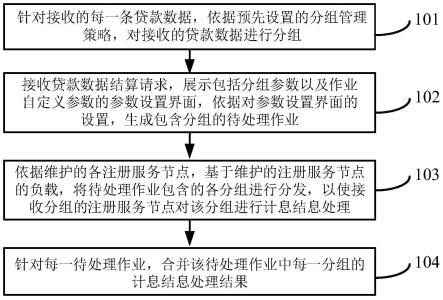

26.图2是根据一个或多个实施例的获得用于车辆中的一般障碍检测的基于传感器融合的俯视三维纹理表示的方法的流程图。

具体实施方式

27.以下描述本质上仅是示例性的,并不旨在限制本公开、其应用或用途。应当理解,在所有附图中,相应的附图标记表示相同或相应的部件和特征。

28.如前所述,传感器提供关于车辆周围环境的信息,并促进车辆的自主或半自主操作。该信息可替代地或附加地用于向驾驶员提供警告。还应注意的是,一般障碍检测是指出于识别车辆可能穿越的自由空间(即,没有任何对象的区域)的目的,检测被视为一般结构的任何结构和类别的道路障碍物。现有方法包括使用基于摄像机(照相机)图像的纹理表示来进行一般的障碍检测。根据该方法,每个像素表示图像(例如,红绿蓝(rgb)图像)中的一列,并且每个像素的长度与图像底部和图像中的障碍物之间或者没有任何障碍物的图像区域中的图像顶部之间的像素数成比例。因此,像素的长度表示二维(2d)图像平面上从相机位置到给定障碍物的自由空间。因为该表示不包括关于任何障碍物的结构和/或外观的任何在先假设,所以它非常适合于一般的障碍检测。然而,2d像素表示不传达任何3d或深度信息。此外,虽然相机图像提供了高的空间分辨率,但是其他传感器(例如,激光雷达系统)更精确,并且提供额外的3d信息。

29.本文详细描述的系统和方法的实施例涉及用于车辆中一般障碍检测的基于传感器融合的俯视3d纹理表示。从利用两个或更多个传感器(例如,照相机、雷达系统、激光雷达系统)获得的数据中提取特征,然后将其转换成俯视图表示(即,鸟瞰图)。然后将变换后的特征融合在一起,以俯视图的形式表示来自所有传感器的聚集特征。从每个传感器到俯视图的信息转换促进了传感器不可知的方法并且允许融合任意数量的传感器。融合特征的俯视图表示被转换为极坐标系统。这种转换产生了一种始于极坐标系统中心(例如,车辆上的某个点)的stixel表示。更具体地,基于提供三维信息的一个或多个融合传感器,这种转换产生指示(即,编码有)诸如距离和高度的属性的俯视三维纹理表示。该纹理表示使一般的障碍检测变得简单明了,正如所详述的那样。

30.根据示例性实施例,图1是车辆100的框图,该车辆100获得用于一般障碍检测的基于传感器融合的俯视3d纹理表示150。图1所示的示例性车辆100是汽车101。车辆100被示为包括照相机110、激光雷达系统120和雷达系统130。车辆100中传感器的数量和位置不受示例性图示的限制。车辆100还包括控制器140,控制器140可以从一个或多个传感器获得信息,以控制车辆100操作的一个方面。控制器140包括处理电路,该处理电路可以包括专用集成电路(asic)、电子电路、执行一个或多个软件或固件程序的处理器(共享、专用或群组)和存储器、组合逻辑电路和/或提供所述功能的其他合适的部件。

31.根据一个或多个实施例,控制器140获得基于传感器融合的俯视3d纹理表示150,以执行一般障碍检测。出于解释的目的,示出了示例性俯视3d纹理表示150的各方面。示例性俯视3d纹理表示150有助于检测对象170a、170b和170c(统称为170),如这里详细描述的。在图1中,指示了组成俯视纹理表示150的一些像素155。如详细描述的,俯视3d纹理表示150在极坐标系统中。如前所述,纹理表示是指在每个纹理155中编码的信息。例如,由纹理155所遇到的对象170的距离d和对象170的高度(对象170离车辆100最近的点)可以是被编码的属性。指示了到示例性对象170b的示例性纹理155的长度。如所指示的,从极坐标系统的中心(例如,车辆100的前格栅的中心)开始的纹理155的长度指示距离d,其是从车辆100到对象170的距离。指示了俯视纹理表示150的每个角度切片160。每个角度切片160与基于构成

角度切片160的纹理155的信息向量相关联。

32.如详细描述的,俯视3d纹理表示150的特征是到对象170的距离(即,距离d)被编码为从车辆100(例如,前格栅的中心,其作为极坐标系统的中心)到对象170的纹理155的长度。其他属性(例如,对象170的高度)也被编码。因此,出于确定车辆100可能行驶到哪里的目的的一般障碍检测由俯视3d纹理表示150直接进行。同样详细地,俯视3d纹理表示150的另一个特征是融合由两个或更多个传感器提供的数据。例如,与激光雷达系统120或雷达系统130相比,相机110提供相对较高的空间分辨率,但是深度感知较差,但是激光雷达系统120或雷达系统130提供三维精确测量。例如,相机110与激光雷达系统120或雷达系统130的融合为相机110的空间分辨率提供了来自激光雷达系统120或雷达系统130的精度和附加信息(例如,对象170的高度和距离)。

33.图2是根据一个或多个实施例的获得用于车辆100中的一般障碍检测的基于传感器融合的俯视3d纹理表示150的方法200的流程图。在框205,从第一传感器获得数据指的是获得第一传感器数据。根据示例性实施例,第一传感器可以是相机110,并且第一传感器数据可以是用相机110获得的二维图像。在框210,从第二传感器获得数据指的是获得第二传感器数据。根据示例性实施例,第二传感器可以是激光雷达系统120,并且第二传感器数据可以是激光雷达点云。根据替代实施例或附加实施例,第二传感器或附加传感器可以是雷达系统130,并且第二传感器数据或附加传感器数据可以是雷达点云。

34.在框215,处理第一传感器数据产生俯视特征表示,出于解释目的,该俯视特征表示被称为第一俯视特征表示。该处理可以由已知的卷积神经网络来执行,该卷积神经网络在神经网络的每个卷积级从第一传感器数据(例如,由摄像机110提供的前瞻图像)中提取特征,并将这些特征转换成鸟瞰图(即,俯视图)表示。可以以端到端的方式训练神经网络。从第一传感器数据获得的所得第一俯视特征表示可以在欧几里得坐标系中。

35.在框220,处理第二传感器数据产生俯视特征表示,出于解释目的,该俯视特征表示被称为第二俯视特征表示。该处理可以类似于参照框215讨论的处理来执行。也就是说,以端到端方式训练的已知卷积神经网络可以从第二传感器数据(例如,激光雷达点云或雷达点云)中提取特征,并将提取的特征转换成鸟瞰(即,俯视)表示。像第一俯视特征表示一样,第二俯视特征表示可以在欧几里德坐标系中。如前所述,雷达点云可以被附加地而不是交替地变换。

36.在框230,融合俯视特征表示是指执行第一俯视特征表示(来自框215)和第二俯视特征表示(来自框220)的融合。如果可用,还可以融合附加的俯视特征表示。该融合可以由神经网络来执行。由于第一俯视特征表示、第二俯视特征表示以及其他可用的俯视特征表示都位于相同的(欧几里得)坐标系中,因此融合是直接的,并且与传感器无关。也就是说,执行融合的神经网络的架构不需要基于被融合的传感器的位置和视野来修改或定制,因为在执行融合的处理点,来自所有传感器的特征表示被转换成相同的俯视欧几里德格式。在框240,该过程包括将融合的俯视特征表示转换到极坐标系统。车辆100(例如,前格栅的中心)可以是极坐标系统的中心。框240处的过程的结果是便于一般障碍检测的基于传感器融合的俯视3d纹理表示150。

37.然后,在框250,使用作用于在框240获得的俯视3d纹理表示150的神经网络来执行一般障碍检测。深度卷积神经网络可用于基于纹理155识别对象170的位置、到每个对象170

的距离、每个对象170的高度以及其他属性(例如,类型、颜色、外观)。如前所述,对象170被检测为一般结构(即,障碍物)。在框250处使用的神经网络的训练期间,关于每个对象170的地面实况数据由纹理表示来注释,该纹理表示将对象检测分类任务推广到与道路相交的任何障碍物。障碍物可以是静态的或动态的,有界的或无界的,以及任何类型和种类。如前所述,每个纹理155表示指示(即,编码有)属性,例如从极坐标系统的中心到遇到的对象170的距离d以及对象170在纹理170遇到它的位置处的高度。

38.同样如前所述,极坐标系统便于将视场划分成角度切片160。因此,表示对象160的角切片160指示相对于车辆100的角位置。同样如前所述,每个角度片160与基于嵌入在角度片160内的每个纹理155中的属性的信息向量相关联。在纹理表示中编码的示例性属性包括距离d和高度,以及在角度切片160内检测到的对象170的类型、外观和颜色。由俯视3d纹理表示150促进的一般对象检测导致车辆100和对象170之间的自由空间的指示。此外,没有对象170(即,具有自由空间)的角切片160基于俯视纹理表示150是明显的。

39.在框260处,该过程包括基于一般障碍检测来控制车辆操作,该一般障碍检测基于俯视3d纹理表示150。由俯视3d纹理表示150促进的一般障碍检测允许车辆控制器140知道每个对象170的位置、范围和高度,并且还可以另外指示其他属性。结果,例如,控制器140可以在不包括任何对象170的自由空间内执行路径确定,或者在到达任何对象170之前执行自主制动。

40.虽然已经参考示例性实施例描述了上述公开,但是本领域技术人员将理解,在不脱离其范围的情况下,可以进行各种改变并且等同物可以替代其元件。此外,在不脱离本公开的实质范围的情况下,可以进行许多修改以使特定的情况或材料适应本公开的教导。因此,意图是本公开不限于所公开的特定实施例,而是将包括落入其范围内的所有实施例。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。