1.本发明涉及遥感场景分类技术,特别是一种高置信局部特征与全局特征学习的图片分类方法及系统。

背景技术:

2.遥感场景分类属于图片分类的一个方向,其旨在通过算法为场景图片贴上语义标签,是计算机视觉领域标志性任务之一,近年来在计算机视觉、模式识别中都是热点研究领域。针对遥感图像的场景分类对于地理信息系统测绘、农业、交通规划和导航等各种民用应用具有重要意义。由于遥感图像空间覆盖范围广,图像中的物体通常包含众多,导致类间相似性高、类内差异性大、尺度差异性大问题。上述因素使得在遥感图像场景分类成为一项具有挑战性的任务。

3.随着深度学习的快速发展,许多基于深度学习的遥感图像分类方法已经被提出。遥感场景图像与通常从水平视角拍摄的自然图像不同,遥感场景图像通常是鸟瞰图,这意味着图像中总是包含不同类型的地物,复杂的语义信息增加了场景分类的难度。penatti等人[penatti o ab,nogueira k,dos santos j a.do deep features generalize from everyday objects to remote sensing and aerial scenes domains?[c]//proceedings of the ieee conference on computer vision and pattern recognition workshops.2015:44-51.]研究了预训练卷积神经网络在遥感场景分类中的泛化能力。nogueira k等人[nogueira k,penatti o a b,dos santos ja.towards better exploiting convolutional neural networks for remote sensing scene classification[j].pattern recognition,2017,61:539-556.]为了提高分类精度,基于不同的卷积神经网络模型使用了四种不同的策略对遥感场景进行分类。最终得出结论:通过微调的方式得到的效果最佳。陈亚当等人[一种基于resnet50结合注意力机制和特征金字塔的图像分类方法[p].中国专利:cn114494805a,2022-05-13.]采用通道和空间注意力融合机制,关注目标的细节信息,并运用金字塔层三分类器的优化算法,各特征层全连接后分类处理,并为每个类别输出一个概率值;取概率值最大的分类结果作为最终的输出预测值。该方法提升resnet-50特征提取效果,注重了局部特征与全局特征的结合,实现了较好的分类结果,但是对于局部特征的选取,没有较好的选择机制。

技术实现要素:

[0004]

本发明的目的在于提出一种高置信局部特征与全局特征学习的图片分类方法及系统,充分考虑局部特征与全局特征聚合对分类任务的影响,能够有效处理类间相似性高、类内差异性大、尺度差异性大的图像分类问题,且分类性能优异。

[0005]

实现本发明目的的技术解决方案为:第一方面,本发明提供一种高置信局部特征与全局特征学习的图片分类方法,包括以下步骤:

[0006]

第一步,采用数据预处理和深度分离卷积模块构成的深度网络,提取图像特征;

[0007]

第二步,将第一步深度分离卷积特征学习模块提取的特征作为输入,利用深度卷积操作构建三层金字塔结构,提取多尺度的深层特征;

[0008]

第三步,在多尺度的深层特征上,根据不同的尺度,采用不同步长的滑动窗口,并对多尺度特征区域采取非极大值抑制减少区域冗余,生成一个表示多尺度特征区域列表,提取指定数量的候选局部感兴趣区域作为高置信局部感兴趣判别与特征学习模块的输入;

[0009]

第四步,将局部感兴趣区域特征的尺寸规范到同一标准,再通过深度分离卷积特征学习模块,计算每个区域为类属标签的概率作为置信值,输出置信值列表;依据该置信值,采取排序一致性损失函数调整网络训练,对候选局部感兴趣特征区域列表重新排序,使其与置信值列表排序一致,提取前m个高置信局部感兴趣区域;

[0010]

第五步,将提取的m个高置信局部感兴趣区域,通过池化操作调整成与上下文特征一致尺寸的张量,并与上下文特征相拼接,进行特征聚合;

[0011]

第六步,将高置信局部感兴趣特征与全局上下文特征聚合后的特征,连结全连接层及softmax分类器进行最终分类。

[0012]

第二方面,本发明提供一种高置信局部特征与全局特征学习的图片分类系统,包括:

[0013]

深度分离卷积特征学习模块,采用深度分离卷积层的堆叠形式,嵌套下采样层,并通过预训练进行特征提取;

[0014]

多尺度特征学习模块,采用三个不同尺度的卷积,提取多尺度特征,并构成特征张量;

[0015]

候选局部感兴趣区域生成模块,采用不同步长的滑动窗口和非最大抑制方法去除冗余区域,生成候选局部感兴趣区域;

[0016]

高置信局部感兴趣区域判别与特征学习模块,计算局部感兴趣候选区域属于类属标签的概率作为置信值,依据置信值构造排序一致性损失函数训练网络,并进行候选局部感兴趣区域排序,判别高置信感兴趣区域;

[0017]

特征聚合模块,将提取的高置信局部感兴趣区域特征与全局特征聚合,得到特征拼接张量;

[0018]

分类模块,根据聚合的特征,进行最终图片分类。

[0019]

第三方面,本发明提供一种计算机可读存储介质,其上存储有计算机程序,该程序被处理器执行时实现第一方面所述的方法的步骤。

[0020]

第四方面,本发明提供一种计算机程序产品,包括计算机程序,该计算机程序被处理器执行时实现第一方面所述的方法的步骤。

[0021]

本发明与现有技术相比,其显著特点在于:(1)采取通过堆叠深度可分离卷积层并嵌入下采样层构建网络,通过预训练方式进行特征提取,提取特征更为丰富;(2)多尺度信息特征提取模块,该模块构建金字塔结构,获取不同空间尺度的特征,提取的多尺度特征张量更为准确;(3)采取非极大值抑制损失,可以去除冗余;(4)通过高置信局部感兴趣判别与特征学习模块,构建排序一致性损失函数,判别高置信局部感兴趣特征,加强了局部有效信息的获取,并与上下文的特征相聚合,能够有效处理分类问题,提高小样本图片的分类精度。

[0022]

下面结合附图对本发明作进一步详细描述。

附图说明

[0023]

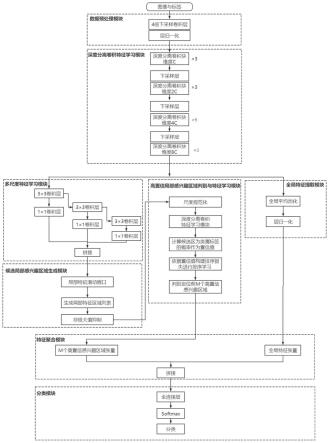

图1是本发明方法的结构图。

[0024]

图2是深度分离卷积块结构图。

[0025]

图3是深度分离卷积模块的下采样结构图。

[0026]

图4是候选局部感兴趣区域生成模块结构图。

[0027]

图5是本发明方法对aid30分类混淆矩阵图。

[0028]

图6是本发明方法对nwpu-resisc45分类混淆矩阵图。

具体实施方式

[0029]

相较背景技术中现有方法,本发明提出一种高置信局部特征与全局特征学习的图片分类方法及系统,应用预训练的卷积网络做为特征提取器,结合金字塔目标识别结构,构造具多尺度和纵横比的滑动窗口获得局部感兴趣区域特征图,通过高置信局部感兴趣区域判别与特征学习模块,定位高置信局部区域,再将提取的高置信局部感兴趣特征图与上下文语义聚合,送入卷积网络特征提取器,进行最终分类,从而提升分类的准确性。

[0030]

下面结合图1,详细说明本发明的实施过程。

[0031]

一种高置信局部特征与全局特征学习的图片分类方法,包括以下步骤:

[0032]

第一步,采用数据预处理和深度分离卷积模块构成的深度网络,提取图像特征,包含深度分离卷积、下采样和激活函数等特征提取操作,具体过程为:

[0033]

(1)对原始图像进行数据增强,裁剪成224

×

224的尺寸,以0.5的概率随机水平翻转图像,再将图像数据转换为标准正太分布mean=[0.485,0.456,0.406],std=[0.229,0.224,0.225],标准化的公式如下:

[0034]

input[channel]=(input[channel]-mean[channel])/std(channel)

[0035]

对图像224

×

224

×

3,通过卷积核大小为4*4,卷积个数为96,步长为4的卷积层,并进行层归一化,实现4倍下采样操作,图像调整为56

×

56

×

96,其中96为特征维度。

[0036]

(2)一个深度分离卷积块的组成如下:

[0037]

如图2,首先是卷积核大小为7*7,步长为1,填充为3的深度可分离卷积层,并连接层归一化;然后是卷积核为1*1的卷积层,并连接高斯误差线性单元激活函数(gelu)实现升维;再经过卷积核为1*1的卷积层,并连接通道缩放以及随机通道丢失恢复初始维度,与初始特征张量相加,作为最终输出。

[0038]

(3)下采样层的组成如下:

[0039]

如图3,首先通过层归一化,再连接一个核为2*2,步长为2的卷积层,实现2倍下采样。

[0040]

(4)共进行四个阶段的深度分离卷积块的堆叠,每两个阶段的堆叠之间嵌入一个下采样层。第一个阶段,深度分离卷积块堆叠3次,输出尺寸为56

×

56

×

96;经过一个下采样层,进入第二阶段,深度分离卷积块堆叠3次,输出尺寸为28

×

28

×

192;经过下采样层,进入第三阶段,深度分离卷积块堆叠9次,输出尺寸为14

×

14

×

384;经过下采样层,进入第四阶段,深度分离卷积块堆叠3次,输出尺寸为7

×7×

768。

[0041]

此步骤的输出作为多尺度特征学习模块的输入以及全局特征提取模块的输入。

[0042]

第二步,将第一步深度分离卷积特征学习模块提取的特征作为输入,利用深度卷

积操作构建三层金字塔结构,提取多尺度的深层特征,如图4,具体过程为:

[0043]

(1)对输入的特征,先通过核大小为3*3,步长为1,卷积核个数128的卷积层,获得7

×7×

128尺寸,感受野为3

×

3的第一层特征图。

[0044]

(2)将7

×7×

128尺寸的特征图,再通过核大小为3*3,步长为2的卷积层,获得14

×

14

×

128尺寸,感受野为5

×

5的第二层特征图。

[0045]

(3)将7

×7×

128尺寸的特征图,再通过核大小为3*3,步长为2的卷积,获得28

×

28

×

128尺寸,感受野为9

×

9的第三层特征图。

[0046]

(4)三层特征图再分别经过1*1的卷积层,实现横向连接并获得前景信息量分数。

[0047]

第三步,在多尺度的深层特征上,根据不同的尺度,采用不同步长的滑动窗口,并对多尺度特征区域采取非极大值抑制减少区域冗余,生成一个表示多尺度特征区域列表,提取指定数量的候选局部感兴趣区域作为高置信局部感兴趣判别与特征学习模块的输入,其具体过程为:

[0048]

(1)依据多尺度特征学习模块生成的多尺度特征层,分配不同步长的滑动窗口,为每个像素点分别设置像素面积为482,962,1922,步长分别对应32、64、128,宽高比为1/1,3/2,2/3的9类区域框,其中1种像素面积对应生成3个宽高比区域框,3种像素面积共生成9类区域框,并映射到特征图的相应位置,生成一个特定数量的局部感兴趣特征区域信息量列表。

[0049]

(2)根据信息量采用非极大值抑制,去除重复区域框。先对(1)步骤输出的指定数量的局部感兴趣特征区域信息量列表l进行信息量排序,取出信息量最大的区域框,存入最终保留列表d中;计算l中其余区域框与当前区域框的iou,当二者iou大于固定阈值u时删除。如此筛选,直至保留前6个局部感兴趣区域{r1,r2...r6}以及对应的信息为{i1,i2...i6}存最终保留列表d中。iou表示同一目标的当前区域框和其他区域框的交并比,定义为:

[0050][0051]

其中,area(

·

)表示集合的面积计算算子,bi和bj表示两个不同的区域框。

[0052]

第四步,将局部感兴趣区域特征的尺寸规范到同一标准,再通过深度分离卷积特征学习模块,计算每个区域为类属标签的概率作为置信值,输出置信值列表。依据该置信值,采取排序一致性损失函数调整网络训练,对候选局部感兴趣特征区域列表重新排序,使其与置信值列表排序一致,提取前m个高置信局部感兴趣区域,其具体过程为:

[0053]

(1)将m个区域{r1,r2...r6}利用双线性插值法进行上采样,转成224

×

224的尺寸,通过数据预处理和深度分离卷积模块,计算每个局部感兴趣区域为真实值类别的概率作为置信值,置信度{c1,c2...c6}。同时通过最小化每个类属标签和置信值之间的交叉熵损失,以及计算全局图片x的交叉损失函数,进行该步骤的优化:

[0054][0055]

其中c(

·

)为置信值计算函数,公式第一部分为所有区域的交叉损失之和,第二部分是整张图片的交叉熵损失。

[0056]

(2)根据(1)中每个感兴趣区域的置信度{c1,c2...c6},以及候选局部感兴趣区域中m个感兴趣区域的信息量,构建排序一致性损失函数。该损失函数具体规则如下,设信息

量排序为{i1,i2...i6},当is>ii并且cs>ci时,对应标签为0,当输入的为相反对即is<ii并且cs>ci时,对应标签为1。排序一致性损失函数定义如下:

[0057][0058]

其中f(

·

)采用的是合页损失函数:f(x)=max{1-x,0}。

[0059]

(3)通过(2)排序一致性损失函数,训练网络,指导候选局部感兴趣特征区域列表重新排序,使其与置信值列排序一致,提取前6个高置信局部感兴趣区域。

[0060]

第五步,将提取的6个高置信局部感兴趣区域,通过池化操作调整成与上下文特征一致尺寸的张量,并与上下文特征相拼接,进行特征聚合。其具体过程为:

[0061]

(1)将高置信局部感兴趣判别与特征学习模块的输出{r1,r2...r6}都调整成224

×

224

×

786。

[0062]

(2)将第一步的输出,作为全局特征提取的输入,经过全局平均池化和层归一化操作后,作为上下文特征输出。

[0063]

(3)将(1)的高置信局部特征与(2)的上下文特征进行聚合,作为分类模块的输入。

[0064]

第六步,将高置信感兴趣局部特征与全局特征聚合后的特征,连结全连接层及softmax分类器进行最终分类。其具体过程为:

[0065]

(1)第五步的输出作为输入,连接全连接层。

[0066]

(2)在(1)的输出后,连接一个softmax分类器,预测最后的分类结果。

[0067]

基于同样的构思,本发明还提供一种高置信局部特征与全局特征学习的图片分类系统,包括:

[0068]

深度分离卷积特征学习模块,采用深度分离卷积层的堆叠形式,嵌套下采样层,并通过预训练进行特征提取;

[0069]

多尺度特征学习模块,采用三个不同尺度的卷积,提取多尺度特征,并构成特征张量;

[0070]

候选局部感兴趣区域生成模块,采用不同步长的滑动窗口和非最大抑制方法去除冗余区域,生成候选局部感兴趣区域;

[0071]

高置信局部感兴趣区域判别与特征学习模块,计算局部感兴趣候选区域属于类属标签的概率作为置信值,依据置信值构造排序一致性损失函数训练网络,并进行候选局部感兴趣区域排序,判别高置信感兴趣区域;

[0072]

特征聚合模块,将提取的高置信局部感兴趣区域特征与全局特征聚合,得到特征拼接张量;

[0073]

分类模块,根据聚合的特征,进行最终图片分类。

[0074]

上述各模块的具体实现方式与前述图片分类方法的第一~第六步内容对应,此处不再赘述。

[0075]

进一步的,本发明还提供一种计算机可读存储介质,其上存储有计算机程序,该程序被处理器执行时实现前述图片分类方法的步骤。

[0076]

进一步的,本发明还提供一种计算机程序产品,包括计算机程序,该计算机程序被处理器执行时实现前述图片分类方法的步骤。

[0077]

本发明充分建立了多尺度局部感兴趣高置信的排序遴选机制,并有效综合了全局

上下文特征信息,采取预训练的网络进行特征提取,增强了特征学习能力,能够有效处理类间相似性高、类内差异性大的分类问题,提高了小样本图片的分类精度和分类速度。

[0078]

本发明的效果可通过以下仿真实验进一步说明:

[0079]

仿真条件

[0080]

仿真实验采用两组光学遥感图像数据:aid数据集和nwpu-resisc45数据集。aid数据集的所有图像均来武汉大学和华中科技大学发布,总包含30类场景图像,每一类大概220-420张,共10000张,按照50%的训练比例。nwpu-resisc45数据集的所有图像由西北工业大学创建的,该数据集包含31,500个图像,涵盖45个场景类,每个类有700个图像。数据覆盖全球100多个国家和地区,规模较大。除了空间分辨率较低的岛屿、湖泊、山地等,大多数场景类别的空间分辨率从0.2~30m不等。同时该数据集考虑了不同天气、季节、光照等自然条件的影响,在背景、遮挡等方面有丰富的图像变化。按照20%的训练比例,训练集和测试集分别包含6300和25200张图像,图像大256

×

256像素。实验中,将aid、nwpu-resisc45数据集的所有图像都调整为224*224大小。两组实验以总体分类精度为评价指标。此外,对比方法包括:基础的卷积神经网络,如:alexnet、googlenet、vgg_16在基础卷积神经网络上采用“词袋”方法(bag of color features)、多尺度特征聚合的方式的(self-attention-based deep feature fusion,saff)、胶囊网络(capsnet),以及不结合高置信局部特征的深度分离卷积特征学习网络。

[0081]

实验中深度分离卷积特征学习网络优化器采用adam优化器,初始学习率为0.001,60个时期后除以10,动量和权重衰减分别为0.9和1e-4。此外,网络在aid的前50个时期和nwpu-resisc45的前50个时期内训练模型,其他网络超参数配置总结在表1中。仿真实验均在linux操作系统下采用python3.8 pytorch1.8 cuda11.2完成。

[0082]

表1网络超参数配置

[0083]

[0084][0085]

仿真实验结果分析

[0086]

表2-表3为本发明方法对nwpu-resisc45与aid数据集进行仿真实验的分类准确度(%)。

[0087]

表2不同方法对aid数据集的分类结果

[0088][0089]

表3不同方法对nwpu-resisc45数据集的分类结果

[0090]

[0091][0092]

从实验结果来看,通过使用本发明方法可以明显提升两个数据集的分类准确度。在aid数据集上,本发明方法的分类准确度为95.70

±

0.17%,通过本发明方法获得的分类混淆图如图5所示。相比于其他方法,本发明方法对篮球场和学校这两个尺度变化较大的类具有较好的分类效果,这得益于本发明结合的区域信息提取模块,该模块能够更加准确地提取多尺度特征信息。在nwpu-resisc45数据集上,本发明方法的平均精度为91.93

±

0.18%,通过本发明方法获得的分类混淆图如图6所示。相比于其他方法,本发明方法能够得到更好的分类结果,主要得益于深度可分离卷积神经网络的特征提取和高置信局部区域特征与全局特征的结合。上述结果充分表明了本发明方法能够有效地学习遥感图像的特征信息,具有较高的分类性能。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。