1.本发明属于目标检测与像素级跟踪与轨迹预测技术领域,尤其涉及一种面向视觉特征非连续性干扰的船舶图像航迹提取方法。

背景技术:

2.自进入21世纪以来,船舶运输业蓬勃发展,有关水面船舶检测的研究起步较早,用于水面船舶检测的方法分为以下几种:基于卫星遥感图像的水面船舶检测方法,其图像覆盖的海洋面积较为广泛,包含目标众多,但是图像分辨率低且立体感差,船舶在图像中的相对尺寸太小,很难获得船舶的精确定位坐标。基于孔径合成雷达图像的水面船舶检测方法,孔径合成雷达能够在能见度极低的天气下获得高分辨率雷达图像,但其不具有丰富的光谱信息,对于船舶检测来说效果较差。基于红外图像的水面船舶检测方法,不受环境亮度影响,红外图像检测在夜晚、大雾天气下也可以获得目标的位置,但红外图像分辨率低,且海洋表面的不均匀气流会导致温度变化,对红外成像产生干扰导致影响检测。基于可见光图像的水面船舶检测方法,其图像光谱信息丰富,易于判别目标间的差异,且成本低廉,与其他图像相比,在港口监控或近海水面船舶检测中可见光图像优势更加明显。但基于可见光图像的近海水面船舶检测的方法获得的船舶轨迹常常因为遮挡或者船舶图像表征变化,导致不能认识到船舶在相邻图像帧的时空关联性。在遮挡条件下的船舶检测效果不尽人意,特别在面对多运动船舶目标时得到的船舶检测效果不佳,误检、漏检现象较为严重。

3.近年来,船舶的自主航行越来越受重视,而在自动避撞技术方面是船舶自主航行安全不可或缺的一部分,实际场景中,障碍物检测船舶自主航行的安全性产生了巨大影响。海面船舶分割有助于船舶自主航行成功躲避障碍物,因此将海面船舶分割引入船舶轨迹提取就显得很有必要。

4.基于bytetrack算法的多目标跟踪模型是经典的多目标跟踪算法之一。可以方便快捷的将bytetrack算法应用至船舶轨迹提取。然而,船载监控视频中背景成像因素复杂,特别是视觉特征非连续性场景下,船舶的目标检测效果有较大的偏差,会降低跟踪效果,增加跟踪匹配的难度。导致了基于bytetrack船舶跟踪算法的轨迹提取方法存在一定的局限性。

5.因此,亟需提出了一种面向视觉特征非连续性干扰的船舶图像航迹提取方法,以应对船舶视觉特征非连续性场景下多目标船舶轨迹提取的挑战。

技术实现要素:

6.为解决上述技术问题,本发明提出了一种面向视觉特征非连续性干扰的船舶图像航迹提取方法,使用deepsnake(第一部分)与yolox作为检测算法,deepsnake(第二部分)作为分割算法,改进的bytetrack算法作为跟踪算法,建立了实例分割加跟踪的轨迹提取框架,结合船舶运动特性改进bytetrack算法结构,使用数据融合方法提高检测算法的船舶检测效果,使用改进的bytetrack算法,在船舶视觉特征非连续性场景下能获得较好的轨迹提

取效果,为港航交通安全提供保障与技术支持。

7.为实现上述目的,本发明提供了一种面向视觉特征非连续性干扰的船舶图像航迹提取方法,包括:

8.采集船舶图像,所述船舶图像包括:船舶被遮挡的场景图像和船舶未被遮挡的场景图像;

9.根据deepsnake模型和yolox模型,对所述船舶图像进行检测,获取图像序列中的船舶位置;

10.将所述船舶位置与所述deepsnake模型的检测结果输入至所述deepsnake模型中,获取所述船舶的外表轮廓;

11.基于所述外表轮廓与所述船舶位置对所述船舶进行轨迹跟踪,获取所述船舶在图像序列中的运动轨迹。

12.可选地,根据所述deepsnake模型对所述船舶图像进行检测前包括:

13.对所述船舶图像进行线性插值处理,对线性插值处理后的所述船舶图像进行像素归一化操作。

14.可选地,获取图像序列中的船舶位置包括:

15.利用所述deepsnake模型对所述船舶图像进行特征提取,获得船舶特征图,并根据所述船舶特征图获取所述船舶的第一初步船舶位置群;

16.根据所述yolox模型对所述船舶图像进行检测,获取所述船舶的第二初步船舶位置群;

17.基于所述第一初步船舶位置群与所述第二初步船舶位置群,获取所述船舶位置。

18.可选地,对所述第一初步船舶位置群与所述第二初步船舶位置群进行融合包括:

19.对所述第二初步船舶位置群进行极大值抑制处理,获取第三初步船舶位置群;

20.对所述第一初步船舶位置群与所述第三初步船舶位置群取交集,获取第一确定船舶位置群;

21.将未在所述交集中的所述第三初步船舶位置群的探测框的置信度,与预设最低置信度进行对比,将大于所述预设最低置信度的所述探测框进行保留,获得第二确定船舶位置群;

22.利用所述第三初步船舶位置群对所述第一确定船舶位置群和所述第二确定船舶位置群,进行交并比处理,获取第三确定船舶位置群;

23.将所述第一确定船舶位置群、第二确定船舶位置群和第三确定船舶位置群进行融合。

24.可选地,获取所述船舶的外表轮廓包括:

25.将所述船舶位置映射至所述船舶特征图上进行结合,利用所述deepsnake模型对映射结合结果进行轮廓提取,获得所述外表轮廓。

26.可选地,获取所述船舶在图像序列中的运动轨迹包括:

27.引入所述外表轮廓改进bytetrack多目标跟踪算法,对所述船舶位置进行轨迹跟踪,获取初步运动轨迹;其中,所述初步运动轨迹中包括:跟踪成功的轨迹和未跟踪成功的轨迹;所述初步运动轨迹中船舶运动状态的表达式为:

28.29.式中,x和y表示船舶位置的中心坐标,a为船舶图像高度与宽度的比值,h为船舶图像的高度,分别表示对应参数的一阶导数;

30.判断所述未跟踪成功的轨迹中船舶的外表轮廓是否被遮挡,若被遮挡,则采用卡尔曼滤波对所述未跟踪成功的轨迹进行提取;

31.将提取后的轨迹与所述跟踪成功的轨迹进行结合,获得完整的所述运动轨迹。

32.可选地,获取初步运动轨迹包括:

33.利用所述船舶位置所在的图像序列中的第一帧位置检测值对卡尔曼滤波器进行初始化;

34.利用所述卡尔曼滤波器对所述船舶位置进行预测与更新,获取所述船舶在所述图像序列中每一帧的位置预测值和对应的外表轮廓位置;

35.对所述图像序列中每一帧的位置预测值和对应的外表轮廓位置进行id匹配,获取所述初步运动轨迹。

36.可选地,利用所述卡尔曼滤波器对所述船舶位置进行预测与更新包括:

37.基于所述船舶位置中上一帧位置检测值,利用所述卡尔曼滤波器预测所述船舶位置中下一帧位置预测值;所述下一帧位置预测值的表达式为:

[0038][0039]

其中,pi为船舶的上一帧位置检测值,为由卡尔曼滤波器输出的下一帧位置预测值,a为状态转移矩阵;

[0040]

获取所述下一帧位置预测值的误差协方差矩阵;所述误差协方差矩阵的表达式为:

[0041][0042]

其中,为船舶下一帧位置预测值的误差协方差矩阵,li为船舶上一帧位置检测值的误差协方差矩阵,q为过程激励噪声的协方差矩阵,t为矩阵理论中的转置符号;

[0043]

获取下一帧位置检测值的卡尔曼增益;所述卡尔曼增益的表达式为:

[0044][0045]

式中,k

i 1

为卡尔曼增益,r为噪声矩阵,h为测量矩阵;

[0046]

根据所述误差协方差矩阵与所述卡尔曼增益对所述下一帧位置预测值进行更新;更新后的下一帧位置预测值的表达式为:

[0047][0048][0049]

其中,p

i 1

为更新后船舶的下一帧位置预测值,l

i 1

为更新后船舶在下一帧的误差协方差矩阵,x

i 1

为船舶的下一帧位置检测值,i为单位矩阵。

[0050]

可选地,对所述图像序列中每一帧的位置预测值和对应的外表轮廓位置进行id匹配包括:

[0051]

将图像序列中所述船舶位置的全部检测值根据预设阈值分为高分探测框和低分探测框;

[0052]

对所述高分探测框进行第一id匹配,获取匹配成功的预测值和检测值matcheda、没匹配成功的预测值utracka、没匹配成功的检测值udeta;所述第一id匹配的表达式为:

[0053][0054]

其中,α为图像序列中每一帧的船舶外表轮廓位置检测值,β为图像序列中每一帧的船舶外表轮廓位置预测值,iou(α,β)为船舶外表轮廓位置检测值和船舶外表轮廓位置预测值之间的交并比距离;

[0055]

对所述低分探测框进行第二id匹配,获取此阶段匹配成功的预测值和检测值matchedb、没匹配成功的预测值utrackb、没匹配成功的检测值udetb;所述第二id匹配的表达式为:

[0056][0057]

其中,θ为图像序列中低分探测框的船舶外观位置检测值,γ为图像序列中船舶外观位置预测值,iou(θ,γ)为低分探测框的船舶外观位置检测值和utracka船舶外观位置预测值之间的交并比距离;

[0058]

将udeta与不确定态的跟踪器进行外观位置交并比距离匹配,获得此阶段匹配成功的预测值和检测值matchedc、没匹配成功的预测值utrackc、没匹配成功的检测值udetc;

[0059]

将matcheda、matchedb、matchedc匹配上的位置信息作为对应的跟踪器的观测值,做卡尔曼算法更新;对于utrackb记为lost态跟踪器;将utrackc和udetb进行删除;将udetc确定为新的id,将新的id视为在图像序列中首次出现的船舶,创建新的船舶运动轨迹,结合首次出现的船舶的位置检测值对卡尔曼滤波器重新进行初始化,重新利用所述卡尔曼滤波器对所述船舶位置进行预测与更新。

[0060]

可选地,判断所述未跟踪成功的轨迹中船舶的外表轮廓是否被遮挡包括:

[0061]

对所述lost态跟踪器,根据其历史的外表轮廓信息与matcheda、matchedb、matchedc的外表轮廓信息进行交并比距离的匈牙利算法,判断是否存在遮挡,若被遮挡则标记为block态跟踪器,否则依然为所述lost态跟踪器;

[0062]

采用卡尔曼算法对所述未跟踪成功的轨迹进行提取包括:

[0063]

对所述block态跟踪器,根据其被跟踪上的帧数调整卡尔曼的置信程度,跟踪帧数m小于n帧的block态跟踪器,将得到对应的跟踪器的卡尔曼预测的和分别乘得到新的进行卡尔曼更新,其中,n为人为设定的帧数值,m为程序认为船舶目标被跟踪上的帧数,跟踪器每次与船舶检测框匹配成功,m都会加一,当n≥m时,会被赋值为1。

[0064]

与现有技术相比,本发明具有如下优点和技术效果:

[0065]

(1)融合并改进了deepsnake、yolox与bytetrack两种算法,得到更好的船舶检测效果、船舶分割效果和船舶跟踪效果,提出了一种面向视觉特征非连续性干扰的船舶图像航迹提取方法,在船舶视觉特征非连续性的复杂场景下进行高精度船舶轨迹提取和分析。

[0066]

(2)本发明中对deepsnake与yolox两个算法进行了融合,首先将yolox检测算法得到的船舶位置与deepsnake目标检测算法得到的船舶位置进行数据融合;其次将融合结果映射回deepsnake算法得到的特征图,进行船舶轮廓回归。同样地,本发明也对bytetrack多目标跟踪算法进行了改进,引入被遮挡态的判断,同时进一步利用卡尔曼算法得到更加精准的船舶轨迹,既提升了从船载监控视频数据中提取船舶航行轨迹的精度,同时也提升了在复杂海况场景下的鲁棒性。

附图说明

[0067]

构成本技术的一部分的附图用来提供对本技术的进一步理解,本技术的示意性实施例及其说明用于解释本技术,并不构成对本技术的不当限定。在附图中:

[0068]

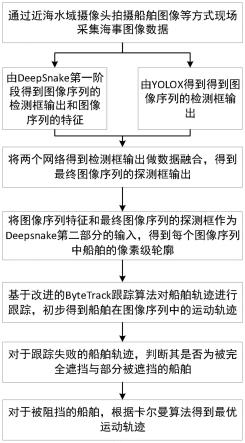

图1为本发明实施例的船舶图像航迹提取方法流程示意图;

[0069]

图2为本发明实施例的船舶图像航迹提取方法的船舶检测框架图;

[0070]

图3为本发明实施例的船舶外表轮廓提取网络结构示意图;

[0071]

图4为本发明实施例的船舶轨迹提取框架图;

[0072]

图5为本发明实施例的船舶检测结果示意图;

[0073]

图6为本发明实施例的船舶轨迹示意图。

具体实施方式

[0074]

需要说明的是,在不冲突的情况下,本技术中的实施例及实施例中的特征可以相互组合。下面将参考附图并结合实施例来详细说明本技术。

[0075]

需要说明的是,在附图的流程图示出的步骤可以在诸如一组计算机可执行指令的计算机系统中执行,并且,虽然在流程图中示出了逻辑顺序,但是在某些情况下,可以以不同于此处的顺序执行所示出或描述的步骤。

[0076]

实施例

[0077]

本实施例提供了一种面向视觉特征非连续性干扰的船舶图像航迹提取方法,包括:

[0078]

采集船舶图像,所述船舶图像包括船舶被遮挡的场景图像和船舶未被遮挡的场景图像;

[0079]

根据deepsnake模型和yolox模型,对所述船舶图像进行检测,获取图像序列中的船舶位置,使用的船舶图像是由船舶视频所得,按照视频中出现的图像顺序(帧数),依次获取图像,即可得到图像序列;

[0080]

将所述船舶位置与所述deepsnake模型的检测结果输入至所述yolox模型中,获取所述船舶的外表轮廓;

[0081]

基于所述外表轮廓与所述船舶位置对所述船舶进行轨迹跟踪,获取所述船舶在图像序列中的运动轨迹。

[0082]

进一步地,获取图像序列中的船舶位置包括:

[0083]

利用所述deepsnake模型对所述船舶图像进行特征提取,获得图像序列船舶特征图,并根据所述图像序列船舶特征图获取所述船舶的第一初步船舶位置群;根据所述yolox模型对所述船舶图像进行检测,获取所述船舶的第二初步船舶位置群;对所述第一初步船

舶位置群与所述第二初步船舶位置群进行融合,获取所述船舶位置。

[0084]

进一步地,获取所述船舶的外表轮廓包括:

[0085]

将所述船舶位置映射至所述图像序列船舶特征图上进行结合,利用所述deepsnake模型对映射结合结果进行轮廓提取,获得所述外表轮廓。

[0086]

进一步地,获取所述船舶在图像序列中的运动轨迹包括:

[0087]

引入所述外表轮廓改进bytetrack多目标跟踪算法,对所述船舶位置进行轨迹跟踪,获取初步运动轨迹;其中,所述初步运动轨迹中包括:跟踪成功的轨迹和未跟踪成功的轨迹;所述初步运动轨迹中船舶运动状态的表达式为:

[0088][0089]

式中,x和y表示船舶位置的中心坐标,a为船舶图像高度与宽度的比值,h为船舶图像的高度,分别表示对应参数的一阶导数;

[0090]

判断所述未跟踪成功的轨迹中船舶的外表轮廓是否被遮挡,若被遮挡,则采用卡尔曼算法对所述未跟踪成功的轨迹进行提取;

[0091]

将提取后的轨迹与所述跟踪成功的轨迹进行结合,获得完整的所述运动轨迹。

[0092]

进一步地,获取初步运动轨迹包括:

[0093]

利用所述船舶位置所在的图像序列中的第一帧位置检测值对卡尔曼滤波器进行初始化;

[0094]

利用所述卡尔曼滤波器对所述船舶位置进行预测与更新,获取所述船舶在所述图像序列中每一帧的位置预测值和对应的外表轮廓位置;

[0095]

对所述图像序列中每一帧的位置预测值和对应的外表轮廓位置进行id匹配,获取所述初步运动轨迹。

[0096]

具体地,本实施例提供一种面向视觉特征非连续性干扰的船舶图像航迹提取方法,如图1所示主要包含以下步骤:

[0097]

(1)通过近海水域摄像头拍摄船舶图像等方式现场采集海事有关船舶遮挡场景图像数据;

[0098]

通过在近海水域船载摄像头拍摄海事有关船舶遮挡场景图像,与航运公司合作获取船舶航行记录,由海事监管部门提供船载监控视频等方式采集有关船舶遮挡场景图像。

[0099]

(2)基于deepsnake实例分割算法和yolox目标检测算法对输入的海事监控视频进行船舶检测;

[0100]

(2.1)使用deepsnake船舶检测前先对图像数据做规范化预处理:

[0101]

首先基于线性插值,将图片调整至合适大小的图片,保证长和宽能够被32整除(为后期探测框能映射回特征图):

[0102]

inputw=(imgw|310 1

[0103]

inputh=(imgh|31) 1

[0104]

式中,imgw和imgh表示原始图片的宽和高,inputw和inputh表示输入给网络的图片大小。

[0105]

其次对船舶图像像素进行归一化操作,保证所有的维度上数据都在一个变化幅度范围内。

[0106]

(2.2)使用deepsnake第一部分centernet网络提取船舶特征并预测图像序列中的初步船舶位置群1;

[0107]

(2.3)使用yolox检测算法预测图像序列中的初步船舶位置群2;

[0108]

(3)将两个算法得到的船舶检测结果进行融合处理,尽可能去除误检和漏检,得到图像序列中的船舶探测框最终输出,即船舶在图像序列中的当前位置;

[0109]

(3.1)对yolox检测算法得到的船舶位置群2做非极大值抑制处理,去除大部分误检内容,得到较好的船舶位置群3;

[0110]

(3.2)对centernet网络得到的船舶位置群1和船舶位置群3取交集,保证低分却有效的的船舶探测框得以保留,记做确定的船舶位置群1;

[0111]

(3.3)对于船舶位置群3剩下的船舶位置群中,保留大于最低置信度min

score

的探测框,记为确定的船舶位置群2;其中最低置信度为人为设定值,可以根据经验获取,如果充分相信目标检测的结果,可以设置得低一些;

[0112]

(3.4)首先将船舶位置群3对确定的船舶位置群1和确定的船舶位置群2探测框的分数低于min

score

的船舶分数score=score min

score

,便于后期处理,然后用船舶位置群3对确定的船舶位置群1和确定的船舶位置群2做补集,具体先做交并比(iou)对比,把没有与确定态的船舶重叠的探测框作为确定船舶位置群3,得以减少漏检;最终结合三个确定船舶位置群,得到最终确定的图像序列船舶位置。

[0113]

(4)将融合后的船舶探测框结果与deepsnake实例分割算法得到的船舶特征共同输入到deepsnake实例分割算法的轮廓回归网络得到船舶的外表轮廓;

[0114]

将最终确定的图像序列船舶位置映射至(2.2)所得到的图像序列船舶特征图上的位置,然后将图像序列船舶特征和对应的船舶位置传给deepsnake的第二部分轮廓回归网络,得到船舶的外观轮廓。

[0115]

(5)利用船舶的外表轮廓和船舶的位置检测值,基于改进的bytetrack多目标跟踪算法对船舶进行轨迹跟踪,初步得到船舶在图像序列中的运动轨迹;其中,改进的bytetrack多目标跟踪算法为引入外表轮廓信息;判断未跟踪成功的轨迹中船舶的外表轮廓是否被遮挡,若被遮挡,则采用卡尔曼滤波对未跟踪成功的轨迹进行提取;

[0116]

(5.1)基于卡尔曼滤波对船舶运动状态进行建模,结合图像序列中第一帧船舶位置的检测值对卡尔曼滤波器进行初始化,描述船舶运动状态的表达式如下:

[0117][0118]

式中,x和y表示船舶位置的中心坐标,a为船舶图像高度与宽度的比值,h为船舶图像的高度,分别表示对应参数的一阶导数;

[0119]

(5.2)基于图像序列中上一帧的船舶位置检测值,依次利用卡尔曼滤波生成在图像序列中下一帧的船舶位置预测值,同时结合船舶在下一帧的位置检测值以更新船舶的位置预测值;

[0120]

基于卡尔曼滤波对船舶位置进行预测与更新的过程如下;

[0121]

首先,根据船舶在图像序列中上一帧的位置检测值,预测船舶在下一帧的位置预测值,其表达式如下:

[0122]

[0123]

式中,pi表示船舶在上一帧的位置检测值,则表示由卡尔曼滤波器输出下一帧的位置预测值,a为状态转移矩阵;

[0124]

其次,计算船舶在图像序列中下一帧的位置预测值的误差协方差矩阵,其表达式如下:

[0125][0126]

式中,表示船舶在下一帧的位置预测值的误差协方差矩阵,li表示船舶在上一帧的位置检测值的误差协方差矩阵,q为过程激励噪声的协方差矩阵;

[0127]

再次,根据船舶在图像序列中下一帧的位置检测值,计算卡尔曼增益,其表达式如下:

[0128]ki 1

=l

i 1ht

(hl

i 1ht

r)-1

[0129]

式中,k

i 1

表示卡尔曼增益,r表示噪声矩阵,h表示测量矩阵;

[0130]

最后,对船舶在图像序列中下一帧的位置预测值进行更新,其表达式如下:

[0131][0132][0133]

式中,p

i 1

表示更新后船舶在下一帧的位置预测值,l

i 1

表示更新后船舶在下一帧的误差协方差矩阵,x

i 1

为船舶在下一帧的位置检测值,i为单位矩阵;

[0134]

(5.3)基于卡尔曼滤波器得到图像序列中每一帧的船舶位置预测值和预测船舶的外观轮廓位置,外观轮廓位置推测过程(外观轮廓 历史位置的中心与预测中心的差值);

[0135]

(5.4)根据基于卡尔曼滤波器得到图像序列中每一帧的船舶位置预测值和外观轮廓位置预测值,进行id匹配:

[0136]

(5.4.1)将图像序列船舶位置检测值有分数分为高分探测框h

socre

和低分探测框l

score

,分开处理;根据提前设置的阈值进行划分;

[0137]

(5.4.2)对于h

score

进行第一次id匹配,采取基于外观轮廓的交并比(iou)距离的匈牙利算法进行第一次匹配,其表达式如下:

[0138][0139]

式中,α表示图像序列中每一帧的船舶外观轮廓位置检测值,β表示图像序列中每一帧的船舶外观轮廓位置预测值,iou(α,β)表示船舶外观轮廓位置检测值和船舶外观轮廓位置预测值之间的交并比(iou)距离。然后根据匈牙利算法进行匹配,此步会得到matcheda、utracka和udeta分别表示匹配成功的预测值和检测值、没匹配成功的预测值和没匹配成功的检测值。

[0140]

(5.4.3)对于l

score

进行第二次id匹配,采取基于位置信息的交并比(iou)距离的匈牙利算法进行第二次匹配,其表达式如下:

[0141][0142]

式中,θ表示图像序列中l

score

船舶外观位置检测值,γ表示图像序列中由(5.4.2)

得到的utracka船舶外观位置预测值,iou(θ,γ)表示l

score

船舶外观位置检测值和utracka船舶外观位置预测值之间的交并比(iou)距离。然后利用匈牙利算法得到matchedb、utrackb和udetb,分别表示此阶段匹配成功的预测值和检测值、没匹配成功的预测值和没匹配成功的检测值。

[0143]

(5.4.4)对于(5.4.3)所得到的udeta将与不确定态的跟踪器(到当前帧为止,只被检测到一次的高分探测框)进行外观位置交并比(iou)距离匹配,得到matchedc、utrackc和udetc,分别表示此阶段匹配成功的预测值和检测值、没匹配成功的预测值和没匹配成功的检测值。

[0144]

(5.4.5)对于之前的匹配结果做整合,matched

a、b、c

匹配上的位置信息作为对应的跟踪器的观测值,做卡尔曼算法更新;对于utrackb记为lost态跟踪器;对于utrackc和udetb将进行删除;对于udetc将确定为新的id,将其视为在图像序列中首次出现的船舶,创建新的船舶运动轨迹,结合该船舶位置检测值对卡尔曼滤波器重新进行初始化,返回上述步骤(5.1);

[0145]

(6)对于没有跟踪成功的船舶,基于交并比(iou)距离和由(5)得到的外表轮廓,进行是否被船舶遮挡的判断;

[0146]

对由(5.4.5)得到的lost态跟踪器,根据其历史的外观轮廓信息与(5.4.5)中matched

a、b、c

外观轮廓信息进行交并比(iou)距离的匈牙利算法,进行是否遮挡判断。如果被遮挡记为block态,否则依然为lost态。

[0147]

(7)对于被遮挡的船舶,采用卡尔曼算法进一步提取得到完整的船舶运动轨迹。

[0148]

由(6)得到的block态跟踪器,根据其被跟踪上的帧数调整卡尔曼的置信程度,跟踪帧数m小于n帧的block态跟踪器,将(5.3)得到对应的跟踪器的卡尔曼预测的和分别乘得到新的进行卡尔曼更新,此处n为人为设定的帧数值,m为程序认为船舶目标被跟踪上的帧数,跟踪器每次与船舶检测框匹配成功,m都会加一,当n≥m时,会被赋值为1。

[0149]

下面对本发明的一个具体应用例进行详细介绍:

[0150]

本实施例的一种面向视觉特征非连续性干扰的船舶图像航迹提取方法在服务器上进行实现,其操作系统为ubuntu 20.04os,cpu为intel(r)xeon(r)gold 6230r,gpu为nvidia quadro rtxa5000,实验平台使用python 3.7版本部署实验程序。

[0151]

本实施例包含了3个船舶视觉特征非连续性场景,分别为(1)无遮挡过渡到部分遮挡,再过渡到无遮挡的场景;(2)无遮挡过渡到全部遮挡的场景;(3)无遮挡过渡到全部遮挡,过渡到无遮挡的场景;并分别标记为场景1、场景2、场景3,船载监控视频的详细信息如表1不同海况下拍摄的船载监控视频信息所示。

[0152]

表1

[0153]

[0154][0155]

为了量化评价本发明所提出的面向复杂海况的船舶轨迹提取方法,在以上3种不同的海况场景下进行实验,并将detectors实例分割算法与不同多目标跟踪算法(bytetrack、deepsort)结合进行对比,采用mota、idf1、idr、idp等评价指标。实验中为每个目标船舶赋予一个跟踪id,用于最终提取船舶航行的运动轨迹。其中,mota表示多目标船舶跟踪的精度;idp表示船舶跟踪id的识别精确度;idr表示船舶跟踪id的识别召回率;idf1代表船舶跟踪id的平均数比率,其计算公式如下所示:

[0156][0157][0158][0159][0160]

式中,fn表示船舶跟踪id丢失的次数,fp表示船舶跟踪id错误的次数,φ表示船舶跟踪id跳变的次数,t表示跟踪船舶id正确的理想次数,tp表示船舶跟踪id正确的实际次数。

[0161]

表2

[0162][0163][0164]

场景一为无遮挡过渡到部分遮挡,再过渡到无遮挡的条件,该场景中船舶的运动状态变化较大,还有浪花干扰的情况下,并且在监控画面中海天线附近存在大量目标船舶。根据实验结果,由表2在场景一中不同算法提取船舶轨迹的性能表现可知,本发明所提出的船舶轨迹提取方法得到了较好的船舶跟踪效果,在mota指标上相比其他方法提高了很多,比较其他指标也都优于其他算法。

[0165]

表3

[0166][0167]

场景二为无遮挡过渡到全部遮挡的场景的条件,在该场景中一艘小型船舶与另一艘大型船舶相向而行,出现会遇情况。根据实验结果,由表3在场景二中不同算法提取船舶轨迹的性能表现可知,在本发明所提出的船舶轨迹提取方法得到了较好的船舶跟踪效果,能够较为准确地提取被遮挡的船舶的运动轨迹,在mota指标上相比其他方法提高了很多,比较其他指标也都优于其他算法。

[0168]

表4

[0169][0170]

场景三为无遮挡过渡到全部遮挡的场景的条件,在该场景中一艘小型船舶与另一艘大型船舶相向而行,出现会遇情况。根据实验结果,由表4在场景三中不同算法提取船舶轨迹的性能表现可知,在本发明所提出的船舶轨迹提取方法得到了较好的船舶跟踪效果,能够在船舶被遮挡回到未被遮挡时,不发生id的变更,比较其他指标也都优于其他算法。

[0171]

本发明提出了一种面向视觉特征非连续性干扰的船舶图像航迹提取方法,其总体框架可分为3个小框架。

[0172]

首先是基于deepsnake与yolox的船舶检测部分,如图2所示,通过近海水域摄像头拍摄船舶图像等方式现场采集海事图像数据;基于deepsnake实例分割算法第一阶段的目标检测部分和yolox目标检测算法分别对输入的海事监控视频进行船舶检测,此步骤会由deepsnake实例分割算法第一阶段的目标检测部分得到船舶检测结果1和船舶图像特征,由yolox目标检测算法得到船舶检测结果2;将两个算法得到的检测结果进行融合处理,会得到如图5所示的最终船舶检测结果;

[0173]

其次是基于deepsnake轮廓提取网络部分,如图3所示,该部分会将基于deepsnake与yolox的船舶检测部分得到的最终船舶检测结果和船舶图像特征作为输入,依次经过骨干网络部分、融合部分和预测部分会得到船舶的外观轮廓信息;

[0174]

最后为基于改进bytetrack船舶跟踪部分,如图4所示,将检测部分得到船舶检测

目标和轮廓提取网络部分特岛的船舶外观轮廓信息作为输入;将其拆分为高分检测框和低分检测框;首先对高分检测框与之前得到的轨迹预测得到的船舶目标进行关联1操作,此步骤如(5.4.2)所述;其次是进行关联2操作,此步骤如(5.4.3)所述;再次是进行关联3操作,此步骤(5.4.4)所述;对于关联3匹配失败的船舶检测结果,为其创建新的轨迹,对于关联3匹配失败的船舶位置预测值,终止其运动轨迹;将三个关联步骤所得到的匹配成功的结果和新生成的轨迹融合,便能得到初步的船舶运动轨迹;对于关联2匹配失败的船舶位置预测值,会与初步船舶运动轨迹进行遮挡态的判断,如果是被遮挡的船舶,会根据卡尔曼预测值作为船舶检测值,进行卡尔曼更新,进一步得到最终的船舶航行轨迹如图6所示。本发明提供的方法具有较好的跟踪性能,在船舶视觉特征丢失的复杂海况场景下能获得良好的像素级船舶轨迹提取效果,为船舶自主航行决策提供安全保障和技术支持。

[0175]

以上,仅为本技术较佳的具体实施方式,但本技术的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本技术揭露的技术范围内,可轻易想到的变化或替换,都应涵盖在本技术的保护范围之内。因此,本技术的保护范围应该以权利要求的保护范围为准。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。