1.本发明属于图像处理和深度学习技术领域,具体涉及一种基于孪生网络和中心位置估计的目标模板图匹配定位方法。

背景技术:

2.目标模板图匹配定位是指预先给定目标的模板图,通过特征提取、相似性度量、最大相似位置搜索等步骤,在成像设备获取的实时图中精确定位出模板图中心对应的位置。它是计算机视觉和目标识别领域中的一项基础技术,在遥感、医学图像处理、视频监控、成像制导等多种任务中有着广泛的应用。在具体应用中,由于实时图和模板图获取的成像设备不同,拍摄时间、拍摄视角、光照条件等获取条件不同,实时图与目标模板图之间往往存在异源、旋转、视角、噪声等较大差异,这给目标模板图的精确定位带来了巨大挑战。

3.barbara zitova

′

和jan flusser发表的论文“image registration methods:a survey”(image and vision computing,2003,21(11):977-1000)将模板图匹配定位任务分为四个要素,即特征提取、相似性度量、搜索空间和搜索方法。传统目标模板匹配定位方法提取的特征是手工设计特征,采用简单的相似性度量,导致特征提取与相似性度量能力较弱,难以应对上述问题的挑战。另外,传统方法的搜索空间是平移、尺度、旋转等维度的耦合,搜索到的匹配位置容易陷入局部最优值,导致目标模板图定位不准确甚至定位错误。深度学习所具有的强大的特征提取与利用能力为提升目标模板图匹配定位性能提供了新的技术途径。qiang ren等发表的论文“a robust and accurate end-to-end template matching method based on the siamese network”(ieee geoscience and remote sensing letters,2022.01,19:1-5)提出一种基于孪生网络的端到端模板匹配方法,该方法将模板匹配任务作为模板分类和位置回归进行处理,提高了模板匹配定位应对异源、旋转、视角、噪声等较大差异的鲁棒性。但该方法在模板图定位时采用了矩形定位框密集预测的方法,即对模板图中心位置的定位是通过对模板边界框的预测间接实现的,导致模板图的定位精度和鲁棒性仍然受到异源、尺度、视角差异等因素的影响。

技术实现要素:

4.针对现有目标模板图匹配定位方法存在的问题,本发明提供了一种基于深度孪生网络和中心位置估计的目标模板图匹配定位方法,该方法借助于深度孪生网络强大的特征提取与表征能力,以及模板图中心位置估计网络的高精度,能有效提高复杂情况下目标模板图匹配定位的准确性和鲁棒性。

5.为实现上述目的,本发明提供了如下方案,一种基于深度孪生网络和中心位置估计的目标模板图匹配定位方法,包括如下步骤:

6.s1构建目标模板图匹配定位网络

7.所述目标模板图匹配定位网络由特征提取孪生网络、深度相关卷积网络和中心位置估计网络三个部分依次级联构成,输入为模板图t和实时图s,其中t和s的尺寸分别为m

×

m和n

×

n,m、n均为正整数且n>m;输出为单通道的热力图p

hm

,记其尺寸为mh×

mh,mh为正整数,热力图上某坐标处的热力值越大,说明该坐标是模板图中心在实时图上位置的可能性越大。具体如下:

8.s1.1构建特征提取孪生网络,提取输入模板图和实时图的特征信息

9.所述特征提取孪生网络由两个参数共享、结构相同的卷积神经网络级联构成,分别以模板图t和实时图s作为输入,输出为模板图特征图f(t)和实时图特征图f(s),其中f(t)的尺寸为m1×

m1×

d,f(s)的尺寸为n1×

n1×

d,其中m1表示f(t)的长度和宽度、n1表示f(s)的长度和宽度、d表示通道数,m1、n1、d均为正整数。

10.所述卷积神经网络是在标准resnet网络(he k.,zhang x.,ren s.,sun j.deep residual learning for image recognition[c]//ieee conference on computer vision&pattern recognition.ieee computer society,2016.)基础上修改得到,所做的具体修改如下:

[0011]

(1)在标准的resnet网络的第三、四、五层增加3

×

3卷积,实现特征降维,得到的特征图分别记为和

[0012]

(2)对特征图进行3

×

3反卷积,得到的特征图拼接在特征图后,然后对拼接得到的特征图进行3

×

3卷积,得到特征图

[0013]

(3)对特征图进行3

×

3反卷积,得到的特征图拼接在特征图后,得到最终的输出:模板图特征图f(t)和实时图特征图f(s)。

[0014]

s1.2利用深度相关卷积网络,将提取到的模板图特征图f(t)和实时图特征图f(s)进行融合

[0015]

所述深度相关卷积网络以s1.1中提取到的模板图特征图f(t)和实时图特征图f(s)作为输入,以f(t)作为卷积核与f(s)进行深度相关卷积运算,输出为二者融合之后的相关特征图f

fusion

,其尺寸为(m1 1)

×

(m1 1)

×

d;

[0016]

s1.3构建中心位置估计网络,计算单通道热力图

[0017]

所述中心位置估计网络由三个3

×

3反卷积层和一个3

×

3卷积层级联构成,其中:每个3

×

3反卷积层的通道数为d、步长为s,s为正整数;3

×

3卷积层的通道数为d,步长为1。

[0018]

该中心位置估计网络以s1.2中融合后的相关特征图f

fusion

作为输入,输出为单通道热力图p

hm

,尺寸为mh×

mh,mh=m1·

s3。记p

x,y

为热力图p

hm

上(x,y)位置处的热力值,1≤x,y≤mh,则p

x,y

的取值范围为[0,1]。

[0019]

s2训练目标模板图匹配定位网络

[0020]

s2.1制作训练图像集

[0021]

s2.1.1针对房屋、道路、桥梁、车辆、舰船、飞机等各种类型的目标,在不同时间段用可见光相机和红外相机分别从不同距离、不同视角、不同位置处拍摄,获得大量图像;

[0022]

s2.1.2从采集的图像中制作n

train

对由模板图和实时图组成的图像对,其中n

train

≥40000。具体制作方法为:在某张图像中剪切包含某目标的图像块,缩放成m

×

m大小,选做模板图,m为正整数;在其它图像中剪切包含同一目标的图像块,将图像块缩放成n

×

n大小,选做实时图,n为正整数。

[0023]

s2.1.3将制作的n

train

对图像作为训练图像集。

[0024]

从上述训练图像集制作过程可以看出,模板图与实时图之间存在异源、尺度、旋

转、视角等显著差异。

[0025]

s2.2标定训练图像集

[0026]

在标定所述训练图像集中的由模板图和实时图组成的图像对时,首先需要标定出模板图中心在实时图上的坐标c

ref

=(x

ref

,y

ref

),然后将其映射到热力图上的坐标(x

hm

,y

hm

),即计算模板图中心在热力图上的对应位置,具体计算方法为

[0027][0028]

其中表示向下取整操作。

[0029]

在获得模板图中心在热力图上的对应坐标后,接下来生成这对训练样本对应的热力图标签区别于直接将正样本记为“1”、负样本记为“0”的标定方法,本步骤采用高斯核加权的方式来标定热力图,目的是为了控制负样本在损失函数中所占比重,减轻正负样本不平衡造成的影响,具体标定方法如下:

[0030][0031]

其中:表示在热力图标签的(x,y)位置处具体标定的热力值,x、y的取值范围为[1,mh];σ

p

是一个与模板图大小相关的超参数,本发明取计算所有(x,y)位置的热力值,得到针对该训练样本标定的热力图标签

[0032]

s2.3设计损失函数

[0033]

设计训练所使用的损失函数如下:

[0034][0035]

其中:p

x,y

表示利用s1中目标模板图匹配定位网络计算出的模板图中心位于实时图(x,y)位置处的热力值(置信度),表示s2.2中为训练样本标定的热力图在位置(x,y)处的热力值,α和β是可调整的超参数,本发明中取α=2,β=4。

[0036]

s2.4利用s2.1采集的训练图像集和s2.2标定后的训练图像集,使用随机梯度下降(sgd)(lecun y,boser b,denker j s,et al.backpropagation applied to handwritten zip code recognition[j].neural computation,1989,1(4):541-551.)法进行网络训练,即通过最小化s2.3中设计的损失函数,得到训练好的目标模板图匹配定位网络模型。

[0037]

s3应用训练好的目标模板图匹配定位网络模型进行目标模板图匹配定位

[0038]

具体流程如下:

[0039]

s3.1将待匹配定位的模板图t(大小m

×

m)和实时图s(大小n

×

n)输入s2.4中训练好的目标模板图匹配定位网络模型;

[0040]

s3.2通过该目标模板图匹配定位网络模型计算输出热力图p

hm

;

[0041]

s3.3寻找热力图p

hm

上的极大值,记极大值点的坐标记为(x

max

,y

max

);

[0042]

s3.4将(x

max

,y

max

)代入如下公式,定位出目标模板图中心在实时图上的位置(u,v):

[0043][0044]

与传统模板匹配方法相比,本发明提供的基于孪生网络和中心位置估计的目标模板图匹配定位方法,能够充分利用深度孪生网络强大的特征提取与表征能力以及中心位置估计网络的高精度定位能力,在涵盖异源、尺度、旋转、视角等大差异的训练图像集基础上,通过训练得到应对上述复杂差异的目标模板图匹配定位网络模型,具体实施示例表明本方法具有良好的鲁棒性和定位准确性。

附图说明

[0045]

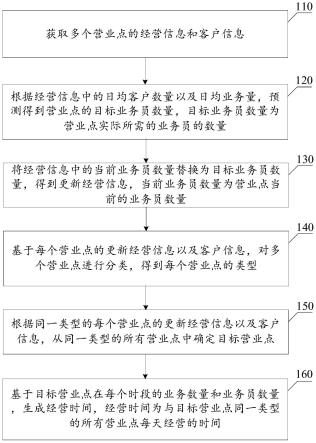

图1为本发明所提出的一种基于孪生网络和中心位置估计的目标模板图匹配定位方法的网络结构示意图;

[0046]

图2为本发明所设计的基于resnet18的新型特征提取网络结构示意图;

[0047]

图3为本发明训练图像集中的模板图和实时图示例;

[0048]

图4为本发明提供的一些模板匹配结果。

具体实施方式

[0049]

下面结合附图和具体实施例对本发明进行进一步说明。

[0050]

本发明提供的基于孪生网络和中心位置估计的目标模板图匹配定位方法,包括以下步骤:

[0051]

s1构建目标模板图匹配定位网络

[0052]

所述目标模板图匹配定位网络由特征提取孪生网络、深度相关卷积网络和中心位置估计网络三个部分依次级联构成。图1为整个网络的具体结构示意图。实施实例中,该网络输入为127

×

127大小的模板图t和255

×

255大小的实时图s;输出为尺寸为129

×

129大小的单通道热力图。

[0053]

s1.1构建特征提取孪生网络,提取输入模板图和实时图的特征信息

[0054]

所述特征提取孪生网络由两个参数共享、结构相同的卷积神经网络级联构成,分别以模板图t和实时图s作为输入,输出为模板图特征图f(t)和实时图特征图f(s)。实施示例中m1=16,n1=32,d=128,即:f(t)的尺寸为16

×

16

×

128,f(s)的尺寸为32

×

32

×

128。

[0055]

如图2所示,所述卷积神经网络是在标准resnet网络基础上修改得到,所做的具体修改如下:

[0056]

(1)在标准的resnet网络的第三、四、五层增加3

×

3卷积,实现特征降维,得到的特征图分别记为和

[0057]

(2)对特征图进行3

×

3反卷积,得到的特征图拼接在特征图后,然后对拼接得到的特征图进行3

×

3卷积,得到特征图

[0058]

(3)对特征图进行3

×

3反卷积,得到的特征图拼接在特征图后,得到

最终的输出:模板图特征图f(t)和实时图特征图f(s)。

[0059]

实施实例中选择resnet 18网络,3

×

3卷积的通道数为128、步长为1,3

×

3反卷积的通道数为128、步长为2。

[0060]

s1.2利用深度相关卷积网络,将提取到的模板图特征图f(t)和实时图特征图f(s)进行融合

[0061]

所述深度相关卷积操作的输入是f(t)和f(s),将f(t)作为卷积核与f(s)进行深度卷积运算,输出为二者融合之后的相关特征图f

fusion

。实施实例中f

fusion

的尺寸为17

×

17

×

128。

[0062]

s1.3构建中心位置估计网络,计算热力图

[0063]

所述中心位置估计网络由三个3

×

3反卷积层和一个3

×

3卷积层级联构成,输入为f

fusion

,输出为单通道热力图p

hm

。实施实例中每个3

×

3反卷积层的通道数为128、步长为2,3

×

3卷积层的通道数为128、步长为1,输出p

hm

的尺寸为129

×

129。

[0064]

s2训练目标模板图匹配定位网络

[0065]

s2.1制作训练图像集

[0066]

本实施实例使用大疆m300无人机携带禅思h20云台相机,从空中拍摄地面的可见光照片和红外照片,按照前文步骤s2.1提供的方法制作40000对模板图和实时图作为训练图像集,模板图和实时图的尺寸分别为127

×

127和255

×

255像素。

[0067]

s2.2标定训练图像集

[0068]

s2.1.1针对每对训练样本,标定出模板图中心在实时图上的坐标c

ref

=(x

ref

,y

ref

);

[0069]

s2.1.2计算模板图中心在热力图上的对应位置,实施实例中计算方法为

[0070][0071]

其中表示向下取整操作。

[0072]

s2.1.3在获得模板图中心在热力图上的对应坐标后,接下来生成这对训练样本对应的热力图标签实施实例中上每个(x,y)位置处标定的热力值计算如下:

[0073][0074]

其中,1≤x,y≤129,是一个与模板图大小相关的超参数。

[0075]

s2.3设计损失函数

[0076]

设计训练所使用的损失函数如下:

[0077][0078]

其中:p

x,y

表示利用s1中目标模板图匹配定位网络计算出的模板图中心位于实时

图(x,y)位置处的热力值(置信度),表示s2.2中为训练样本标定的热力图在位置(x,y)处的热力值,α和β是可调整的超参数,本实施实例中取α=2,β=4。

[0079]

s2.4利用采集的训练图像集和标定的数据,使用随机梯度下降(sgd)(法进行网络训练,即通过最小化s2.3中设计的损失函数,得到训练好的目标模板图匹配定位网络模型。实施实例中对模型训练时,batch_size设置为128(gpu数量为4,每个gpu上加载32对图像),参数momentum和weight_decay分别设置为0.9和0.001。模型共训练20个epochs,在前5个epochs中,学习率从0.001等间隔增大到到0.005,在后15个epochs中,学习率从0.005等对数间隔衰减到0.0005。

[0080]

s3应用训练好的目标模板图匹配定位网络模型,进行目标模板图匹配定位

[0081]

具体流程如下:

[0082]

s3.1将待匹配定位的模板图t(大小127

×

127)和实时图s(大小256

×

256)输入s2.4中训练好的的目标模板图匹配定位网络模型;

[0083]

s3.2通过该目标模板图匹配定位网络模型计算输出热力图p

hm

;

[0084]

s3.3寻找热力图p

hm

上的极大值,记极大值点的坐标记为(x

max

,y

max

);

[0085]

s3.4将(x

max

,y

max

)代入如下公式,定位出目标模板图中心在实时图上的位置(u,v):

[0086][0087]

为对本发明提供的模板匹配方法进行定性评估,本实施实例中使用大疆m300无人机携带禅思h20云台相机,从空中拍摄地面的可见光照片和红外照片,制作350对由模板图与实时图组成的图像对,构建测试数据集,记作hard350。测试数据集中模板图与实时图之间存在旋转、视角、遮挡、异源(可见光与红外)等较大差异,且没有出现在训练集中。本实施实例中使用基于中心误差定义的平均中心误差(mce)和匹配成功率(sr)作为评价指标,其中sr2表示的是将中心误差小于2像素定义为匹配成功时得到的匹配成功率。

[0088]

表1给出的是本发明提供的方法与现有的一些典型模板匹配方法在测试数据集上的对比结果,其中典型代表算法包括归一化互相关(ncc)、归一化互信息(nmi)、基于sift的图像匹配算法和基于hog(histogram of oriented gridients)的图像匹配算法,表中ours表示本发明提供的方法。从表1的结果对比中可以看出:相较于传统的模板匹配方法,本发明提供的方法能够大幅度提高复杂环境下模板匹配的准确性和鲁棒性。

[0089]

表1不同方法在easy150和hard350数据集上的测试结果

[0090][0091]

图4给出的是使用本发明提供的方法在异源、视角差异、旋转差异以及尺度差异干扰下得到的一些目标模板图匹配定位结果。从图中可以看到,本发明所提供的目标模板图匹配定位方法在复杂挑战情况下依然具有良好的性能。

[0092]

综上,本发明提供的基于孪生网络和中心位置估计的目标模板图匹配定位方法,

在复杂挑战情况下具有良好的目标模板图匹配定位准确性和鲁棒性。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。