1.本发明属于图像处理的技术领域,具体涉及一种基于灾后无人机遥感影像的建筑物损毁分类方法。

背景技术:

2.作为最具破坏性的自然灾害之一,地震会对建筑造成严重的损毁。快速、准确的评估建筑物的损毁情况对政府的应急响应和救援开展具有重要的意义,利用遥感影像能够获得受灾区域丰富的时空信息,因此,可以对受灾区域的建筑物进行大范围、低成本、快速的损毁评估。

3.卷积神经网络具有强大的特征学习和推理能力,在图像处理任务上表现出了强大的性能,因此,cnn被广泛用于建筑物的损毁评估研究,根据使用的影像数量,可以将建筑物损毁评估方法划分为单一时相方法和双时相方法。

4.双时空方法分别从灾前和灾后图像中提取特征,然后确定建筑物的位置和受损程度。由于双时相方法采用了灾前灾后的影像,具有较高的评估精度,然而由于受到双时相影像的收集的影响,双时相评估方法的实用性相对较低。

5.单一时相方法仅使用灾后的影像进行评估,因此,单一时相方法受到的制约相对较少,但是该方法忽略了建筑物损毁特征的提取对评估精度的影响。在灾后图像中,建筑物的形状和纹理发生了明显的变化。然而,区分轻微损坏和严重损坏是一项具有挑战性的任务,因为它们具有相似的特征,例如,建筑物的损毁特征主要表现在屋顶,只是损坏的区域不同,因此,有必要聚集类似的特征,以加强对不同程度的建筑物损坏的辨别。此外,建筑物周围的纹理和空间信息也可以为评估提供必要的辅助信息。急需一种通过探索图像中全局特征和背景特征之间关系的分类模型来更加精确的对建筑物的损坏等级进行分类。

技术实现要素:

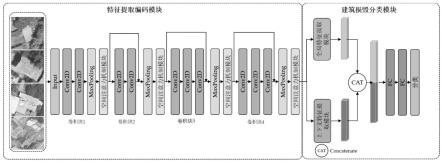

6.针对目前灾害应急反应和损失评估都是将受损建筑分为两类:受损和完好,这不足以满足实际需求的问题,我们提出了一个新型的卷积神经网络建筑破坏分类网络(ebdc-net),用于基于灾后航空图像的建筑破坏评估,该网络由一个特征编码模块和分类模块构成,其中特征编码模块用于提取建筑物损坏的语义信息,并结合空间注意力机构提高区分不同损坏程度的能力,而分类模块则结合全局和上下文特征来提高建筑物损毁等级分类的准确性。该网络的性能在一个公共数据集上进行了评估,并在震后无人机(uav)图像的数据集上进行了大规模的损害评估,实验结果表明,该方法可以有效地对不同损坏程度的建筑物进行分类,当建筑物的损坏程度被分为两类、三类和四类时,总体分类准确率分别为94.44%、85.53%和77.49%。

7.本发明可通过以下技术方案实现:

8.一种基于灾后无人机遥感影像的建筑物损毁分类方法,包括以下步骤:

9.步骤一、获取灾后的无人机遥感影像,并进行预处理;

10.步骤二、建立建筑物破坏分类网络模型并进行训练;

11.所述建筑物破坏分类网络模型包括特征编码模块和分类模块,所述特征编码模块包括依次连接的带有注意力机制的多个卷积块,用于对无人机遥感影像进行特征编码,获取特征编码图,

12.所述分类模块包括全局特征提取模块、上下文特征提取模块和分类器,所述全局特征提取模块用于对特征编码图进行全局特征提取,所述上下文特征提取模块用于对特征编码图进行上下文特征提取,所述分类器用于对融合了全局特征、上下文特征的图像特征进行分类;

13.步骤三、用训练好的建筑物破坏分类网络模型对获取灾后的无人机遥感影像进行损毁分类识别。

14.进一步,所述上下文特征提取模块采用lstm网络,先对特征编码图进行均匀分块,以单个块为元素,将特征编码图转换为特征序列,再将所述特征序列输入lstm网络进行上下文特征提取。

15.进一步,记特征编码图为f∈rc

×h×w,其中,c、h、w分别代表特征编码图f的通道、高度和宽度,在特征序列生成时,将特征编码图f划分为h

×

w个块,每个块对应原始灾后无人机遥感影像中一个局部区域的特征,然后将这h

×

w个块按照从左到右、从上到下的顺序生成一个特征序列v=[x1,x2,

···

,xk]∈rc,其中k=h

×

w,每个xk对应一个块的特征。

[0016]

进一步,所述全局特征提取模块采用全局平均池化层提取特征编码图的全局特征,将得到全局特征和上下文特征输入concatenate层进行有效连接得到融合特征,再将融合特征输入两个全连接层后,经过softmax函数处理获得建筑物的损毁类别。

[0017]

进一步,所述卷积块设置有四个,依次记为第一卷积块、第二卷积块、第三卷积块和第四卷积块,

[0018]

所述第一卷积块、第二卷积块均包括依次连接的两个卷积层、最大池化层和注意力机制模块,其中第二卷积块的两个卷积层还通过残差模块连接;

[0019]

所述第三卷积块、第四卷积块均包括依次连接的三个卷积层、最大池化层和注意力机制模块,其中的三个卷积层均还通过残差模块连接。

[0020]

进一步,所述注意力机制模块采用sam空间注意力机制,

[0021]

首先,所述注意力机构模块以卷积提取的特征图fa∈rc×h×w为输入,其中,c、h、w分别代表特征图fa的通道、高度和宽度,分别经过三个卷积层得到两个新的特征图fb、fc和fd,其中,特征图fd和fa具有相同的形状,

[0022]

将特征图fb、fc均重塑尺寸为其中n=h

×

w,随后将特征图fb和fc进行矩阵相乘生成一个特征图fs′

∈rn×n,再特征图fs′

被送入softmax层并生成空间注权重映射fs∈rn×n,

[0023]

其次,将特征图fd和空间注意力权值特征映射fs进行矩阵相乘,并将结果重塑尺寸为rc×h×e,最后将重塑后的结果与一个可训练的尺度系数α相乘并与特征图fa进行求和运算得到最终的特征图fe。

[0024]

本发明有益的技术效果在于:

[0025]

1)本发明使用灾后无人机航空影像数据,能够满足快速评估房屋灾损的分类的需

求。

[0026]

2)针对不同损毁等级之间差异小、损毁特征分散的特点,使用空间注意力机制聚集影像中相似的特征,增强网络的特征表示能力,结合全局特征和纹理特征提高模型对建筑物周围纹理信息和空间结构的区分能力。

[0027]

3)将评估结果可视化,直观展示建筑物的损毁分布。

附图说明

[0028]

图1为本发明的总体结构示意图;

[0029]

图2为本发明的空间注意力机制模块的结构示意图;

[0030]

图3为本发明的序列特征生成示意图;

[0031]

图4为本发明的上下文特征处理过程示意图;

[0032]

图5为本发明的建筑物灾害损毁评估结果示意图。

具体实施方式

[0033]

下面结合附图及较佳实施例详细说明本发明的具体实施方式。

[0034]

如图1所示,本发明提供了一种基于灾后无人机遥感影像的建筑物损毁分类方法,构建了一个包含特征编码模块和分类模块的新颖的卷积神经网络作为建筑物破坏分类网络模型ebdc-net,其中特征编码模块进行建筑物损毁特征提取时,首先利用残差连接降低网络优化的难度,缓解梯度消失和梯度爆炸问题,其次,利用空间注意力机制聚集相似的特征,增强网络的特征表示能力,提高对建筑物不同损毁等级的区分能力;在分类模块中,为了充分利用建筑物本身和其周围场景信息,首先利用全局特征提取模块提取影像的全局特征,其次利用上下文特征提取模块提取影像的上下文特征即纹理特征,最后,融合全局特征和纹理特征提高建筑物损毁等级分类的准确性。具体如下:

[0035]

步骤一、获取灾后的无人机遥感影像,并进行预处理;

[0036]

步骤二、建立建筑物破坏分类网络模型并进行训练;

[0037]

从灾后航空图像中提取有效的特征有助于确定建筑物受损程度。如图1所示,本发明的建筑物破坏分类网络模型包括特征编码模块和分类模块,其中特征编码模块包括依次连接的带有注意力机制的多个卷积块,用于对无人机遥感影像进行特征编码,获取特征编码图。

[0038]

该卷积块设置有四个,依次记为第一卷积块、第二卷积块、第三卷积块和第四卷积块,具体可以根据分类精度等实际情况而定,该第一卷积块、第二卷积块均包括依次连接的两个卷积层、最大池化层和注意力机制模块,其中第二卷积块的两个卷积层还通过残差模块连接,每个卷积层均采用内核为3的2d卷积;该第三卷积块、第四卷积块均包括依次连接的三个卷积层、最大池化层和注意力机制模块,其中的三个卷积层均还通过残差模块连接,每个卷积层也均采用内核为3的2d卷积。

[0039]

在卷积操作后都有一个最大池化层的下采样操作,此外,由于本发明中输入的影像的尺寸较小,随着网络的加深,特征丢失严重,而残差连接的结构可以降低优化难度,并且能够训练更深层的网络,因此在后三个卷积块中加入了残差连接来缓解特征提取时的梯度消失和梯度爆炸问题,即再第二至四卷积块中将多个卷积层的原始输入和最终输出做残

差处理后再输入最大池化层。

[0040]

尽管卷积块能够提取不同层次的语义信息,然而,在灾后的遥感影像中,轻微损毁和严重损毁的建筑物其损毁特征分散地分布在影像的不同区域且损坏特征在影像中占有的比例较小,导致影像中不同损毁类别之间的类内方差较大。为了增强网络的特征表示能力,获得更好的分类精度,在每个卷积块的最后引入了一种注意力机制如sam空间注意力机制模块,sam自适应地探索影像中不同位置特征之间的相似性,整合任意尺度相似的特征,增加不同损毁等级之间的类内一致性,并抑制了不必要的信息和噪声。

[0041]

如图2所示,空间注意力机制接收卷积提取的特征图fa∈rc×h×w,其中c、h、w分别代表特征图fa的通道、高和宽。首先,特征图fa作为输入,分别经过两个卷积层(内核=1),得到两个新的特征图fb和fc,这两个卷积层的输出通道为c/8,其次将fb、fc重塑尺寸即reshape为其中n=h

×

w,随后将特征图fb和fc进行矩阵相乘生成一个新的特征图fs′

∈rn×n,最后,ebdc-netfs′

被送入softmax层并生成空间注权重图fs∈rn×n。

[0042][0043]

其中,用来衡量空间中任意两个位置特征之间的影响,两个位置的特征表示越接近说明它们之间的相关性越强,的值越大。

[0044]

在获得空间注意力权值特征图后,再将特征图fa喂入一个新的卷积层中,生成一个新的特征图fd,其中,特征图fd和fa具有相同的形状。在和空间注意力权值特征图fs与特征图fd之间进行矩阵相乘,并将结果重塑尺寸为rc×h×w,最后将重塑尺寸后的结果与一个可训练的尺度系数α相乘并与特征图fa进行求和运算得到最终的特征图fe,α初始化为0。

[0045][0046]

根据公式2,每个位置的值是由fs中的值作为加权对原始特征进行加权融合得到,因此,sam有选择地聚合相似地语义特征,提高了不同损毁等级之间的类内紧凑性和语义一致性,使得网络能够更好的区分不同损毁等级的建筑物。

[0047]

该分类模块包括全局特征提取模块、上下文特征提取模块和分类器,其中全局特征提取模块用于对特征编码图进行全局特征提取,上下文特征提取模块用于对特征编码图进行上下文特征提取,该分类器用于对融合了全局特征、上下文特征的图像特征进行分类。

[0048]

在使用灾后的无人机影像进行建筑物损毁等级分类时,仅关注建筑物本身的特征不足以准确的区分其损毁等级。由于建筑物周围的场景能够为损毁评估提供关键线索,如果根据影像中的全局信息和上下文的依赖关系可能会对最终的损毁分类结果会有所改善,因此,我们在如图1所示的建筑物破坏分类网络模型设计了两个并行的模块分别捕获影像中的全局特征和上下文特征依赖关系。

[0049]

具体而言,首先,特征编码模块提取的特征图f作为分类模块的输入,将特征图f分别喂入全局特征提取模块gfe、上下文特征提取模块cfe中,在全局特征提取模块gfe中使用全局平均池化层提取影像的全局特征fg,在上下文特征提取模块cfe中,采用lstm层用来提

取影像中的上下文特征f

l

,先对特征编码图进行均匀分块,以单个块为元素,将特征编码图转换为特征序列,再将特征序列中的各个元素输入lstm网络进行上下文特征f

l

提取。具体如下:

[0050]

lstm作为一种深度回归神经网络,能够处理记忆序列信息的长期关系。在许多遥感影像分类研究中利用lstm提取影像中的空间和光谱特征,在本发明中,lstm被用来探索不同区域特征序列之间的上下文依赖关系,其中特征序列的生成是学习上下文特征依赖关系的关键。如图3所示,记特征编码图为f∈rc×h×w,其中,c、h、w分别代表特征编码图f的通道、高度和宽度,在特征序列生成时,将特征编码图f划分为h

×

w个块,每个块对应原始灾后无人机遥感影像中一个局部区域的特征,然后将这h

×

w个块按照从左到右、从上到下的顺序生成一个特征序列v=[x1,x2,

···

,xk]∈rc,其中k=h

×

w,每个xk对应一个块的特征,然后将特征序列中每个c维特征向量xk依次喂入lstm进行上下文特征提取。

[0051]

如图4所示,lstm有三个输入:当前特征序列的输入值xk、上一特征序列的输出值h

k-1

和它的单元状态c

k-1

;lstm有两个输出:当前序列特征的输出值hk和中间的单元状态ck。遗忘门fk结合h

k-1

和xk决定上一特征序列的单元状态c

k-1

有多少保留到当前特征序列中,输入门o

k-结合h

k-1

和xk决定当前特征序列的输入有多少保存到新的单元状态ck中,输出门ok结合当前特征序列的单元状态ck对当前输出值hk进行控制。基于这些部分,存储单元和输出可以通过以下方式计算:

[0052]fk

=σ(wf·

[h

k-1

,xk] bf)

ꢀꢀꢀ

(3)

[0053]

ik=σ(wi·

[h

k-1

,xk] bi)

ꢀꢀꢀ

(4)

[0054][0055][0056]

ok=σ(wo·

[h

k-1

,xk] bo)

ꢀꢀꢀ

(7)

[0057][0058]

其中,σ代表sigmoid函数,

′°′

是点积运算符,wf、wi、wc、wo和bf、bi、bc、bo是可学习的权重。

[0059]

最后一个c维特征向量的输出状态作为上下文特征f

l

来描述影像中的上下文特征依赖关系。在上下文特征提取模块中,堆叠了两个lstm层,输出维度设置为256。

[0060]

在得到全局特征fg和上下文特征f

l

后,将两种特征喂入concatenate层进行有效连接得到融合特征f

fusion

,然后将融合特征f

fusion

喂入两个维度为256的全连接层中,值得注意的是,为了避免过拟合,采用了dropout策略,最后,经过softmax函数处理获得建筑物的损毁类别。

[0061]ffusion

=[fg,f

l

]

ꢀꢀꢀ

(9)

[0062]

步骤三、用训练好的建筑物破坏分类网络模型对获取灾后的无人机遥感影像进行损毁分类识别。

[0063]

为了验证本发明的建筑物损毁分类方法的可行性,我们进行了如下实验:

[0064]

使用震后无人机航空影像训练网络,包括三个地点的震后航空影像,第一个是发生在2010年4月14日发生在中国青海省玉树县的7.1级地震的震后航空影像,第二个是2014年8月3日发生在中国云南省鲁甸县的6.5级地震的震后航空影像,第三个是2021年5月21日

发生在中国云南省漾濞县的6.4级地震的震后无人机影像,该数据集将建筑物损毁划分为四个不同损毁类别:完好、轻微损坏、严重损坏和倒塌,分类结果如图5所示。

[0065]

将数据集按照8:1:1划分为训练集、验证集、测试集训练网络,采用sgd优化器,训练100个epoch,学习率为0.0001。将训练好的网络使用测试集验证模型的精度,采用accuracy、kappa、mse评估网络的分类精度。

[0066]

通过与其他三种建筑物损毁分类方法相比,我们发现本发明提出的方法具有最佳的性能,所有的三个评价指标都表现出了最好的精度,对于一张5474

×

3648大小的影像,处理时间约为19s。具体如下表所示。

[0067][0068]

总之,本发明提出了一个基于cnn的网络来对建筑物损坏进行精细分类。在建筑物破坏分类网络模型ebdc-net的特征编码模块中利用空间注意机制聚集图像中的相似特征,以获得更好的特征表示,提高网络对不同损坏类别的区分能力。此外,全局特征信息和上下文特征信息在分类网络中被结合起来,以提高网络对建筑物周围的纹理信息和空间结构的区分能力。在鲁甸地震数据集上的实验表明,ebdc-net可以有效的对建筑物损毁进行精细化评估,当建筑物的损坏分为两类、三类和四类时,总体分类精度分别为94.44%、85.53%和77.49%。结合玉树数据集,探讨了历史数据在建筑物损毁精细化评估中的作用,当鲁甸数据集上训练的网络被玉树数据集微调后,建筑物损坏评估的分类精度在分为两类、三类、四类时分别为95.86%,80.02%,68.33%,在地震发生后,将历史数据训练的模型使用少量新的数据进行微调有助于建筑物损毁的精细化评估。另外,结合漾濞数据集进行了大范围的损毁评估实验。结果表明,ebdc-net能够应用于震后的大范围建筑物损毁评估中。

[0069]

以上所述,以上实施例仅用以说明本发明的技术方案,而非对其限制;尽管参照前述实施例对本发明进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本发明各实施例技术方案的精神和范围。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。