技术特征:

1.一种强化学习方法的奖励函数,其特征在于,包括四个子函数,定义超调量为σ=θ

l_max-θ

l_cmd

;θ

l_max

为负载在运动过程中达到的最大值,θ

l_cmd

为期望的负载命令值;则总的奖励函数为四个子函数的累计,即:r(s,a)=w1r(δθ

l

) w2r(σ) w3r(δθ

m

) w4r(m

in

);式中,w

i

代表第i项奖励函数的权重,其中,r(δθ

l

)为位置相关的奖励函数,其采用指数衰减与线性函数的组合,即指数衰减之后紧接线性函数,其函数形式如下,其中,θ1为人为设定的一个伺服电机初始偏转角度值,r(σ)为为对超调量σ的惩罚,其函数形式如下:其中,σ1为人为设定的一个伺服电机初始偏转角度值,r(δθ

m

)为电机位置的奖励,其形式与负载端的位置奖励相同;r(m

in

)为输入扭矩的惩罚,其函数形式如下:r(m

in

)=-|m

in

|*r(δθ),其中,|m

in

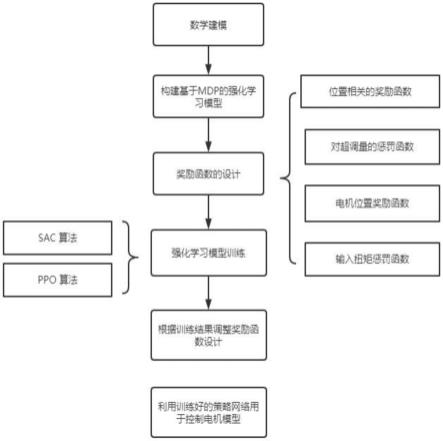

|为电机输入扭矩。2.一种振动抑制强化学习算法,采用如权利要求1所示的奖励函数,其特征在于,还包括以下步骤:步骤一:数学建模搭建被控对象的线性离散化数学模型,据牛顿第二定律、扭转胡克定律,将机器人单关节电机负载模型抽象为两个刚体、两个旋转副及一个扭簧相连接的力学模型并分别建立动力学响应方程及变形方程,其动力学响应方程及变形方程分别为:

其中,物理量m表示扭矩,j表示转动惯量,α表示角加速度,b表示旋转阻尼,ω表示角速度,θ表示角度,物理量的下角标分别表示所对应的物体,其中下角标m代表电机,ml代表联轴器,l代表载荷,特别的,m

in

代表输入扭矩,k

ml

表示联轴器的等效扭转刚度;步骤二:构建基于mdp的强化学习模型,从而将伺服驱控的位置控制问题转换为强化学习问题定义状态s

t

=(θ

m

,θ

′

m

),θ

m

为电机高速端的位置,θ

′

m

为电机高速端的速度,动作a

t

为输入扭矩m

in

,收益r

t

为当前步骤获得的奖励;单次采样的轨迹定义为τ=(s1,a1,r1,

…

s

t

,a

t

,r

t

,

…

,s

t

,a

t

,r

t

),其发生的概率为:该条轨迹的回报定义为:式中,γ为折扣因子,γ∈(0,1],强化学习的目标就是最大限度地提高长期收益,也就是最大化期望回报,期望回报的定义为即求取行动策略网络的参数θ,根据该参数下的行动策略进行采样得到的轨迹,期望回报值最大,所以优化问题变为:上式优化问题中最重要的函数为r(s

t

,a

t

),也即当前状态动作的奖励函数,它决定强化学习的学习目标,决定训练过程是否能够收敛;

步骤三:奖励函数的设计定义超调量为σ=θ

l_max-θ

l_cmd

,θ

l_max

为负载在运动过程中达到的最大值,θ

l_cmd

为期望的负载命令值;总的奖励函数为四个成分的累计,即:r(s,a)=w1r(δθ1) w2r(σ) w3r(δθ

m

) w4r(m

in

);式中,w

i

代表第i项奖励函数的权重,其中,r(δθ

l

)位置相关的奖励函数,其采用指数衰减与线性函数的组合,即指数衰减之后紧接线性函数,其函数形式如下,其中,θ1为人为设定的一个伺服电机初始偏转角度值,r(σ)对超调量σ的惩罚,其函数形式如下:其中,σ1为人为设定的一个伺服电机初始偏转角度值,r(δθ

m

)为电机位置的奖励,其形式与负载端的位置奖励相同;r(m

in

)为输入扭矩的惩罚,其函数形式如下:r(m

in

)=-|m

in

|*r(δθ);步骤四:强化学习模型训练;使用强化学习中sac算法或者ppo算法来求解该优化问题;步骤五:根据强化学习模型训练结果调整奖励函数设计步骤四训练出行动策略网络后,将其用于电机模型,查看轨迹特性是否满足伺服驱控的控制性能需求,如果满足,则结束整个流程,获得的行动策略网络为满足控制需求的控制策略;如果不满足控制需求,则需要调整奖励函数的设计,重新用sac算法或者ppo算法训练该过程,直至满足需求;步骤六:利用训练好的策略网络用于控制电机模型使用动作策略网络用于真实控制时,需要将正态映射网络的标准差设置为0;使用第五步中训练获取的回报最高的行动策略网络π

θ

(a

t

|s

t

)。3.根据权利要求2所述的一种振动抑制强化学习算法,其特征在于,所述步骤四中,sac算法包括以下步骤:1)初始化策略π网络参数θ,q函数网络参数φ

1,2

,初始化经验池将q参数赋值给目标q网络参数φ

targ,1

←

φ1,φ

targ,2

←

φ2;2)观测状态s,并从策略选择动作a~π

θ

(

·

|s),在环境中执行该动作,并观测下一时刻的状态s',收益r,及结束标志d,将状态转移对(s,a,r,s',d)存储到经验池中,如果s'为结束状态,则重置环境;3)采集了k步状态对后,进行l次如下更新步骤4)-步骤8):4)从经验池随机采集一组状态转移对组成b={(s,a,r,s

′

,d)},

5)计算q函数的目标值:6)使用单步梯度下降更新q函数的权值参数,其梯度值为:7)使用单步梯度上升更新策略网络的权值参数,其梯度值为其中,为从π

θ

(

·

|s)采样的值,它通过重参数化技巧使得对θ可导8)更新目标网络参数φ

tar,i

←

ρφ

tar,i

(1-ρ)φ

i

,for i=1,29)重复步骤2)至步骤8)直到收敛。4.根据权利要求2所述的一种振动抑制强化学习算法,其特征在于,所述步骤四中,ppo算法包括以下步骤:1)定义actor行动策略网络π

θ

(a

t

|s

t

),代表在状态s

t

下采取动作的a

t

的概率分布;critic状态价值评估网络代表状态s

t

下的状态价值,actor输出at,critic输出v(st);强化学习的最终优化的目标为使用sgd来优化ppo算法中的策略目标为:的策略目标为:其中,ε为一个参数系数,代表示新的行动策略与旧的行动策略之间的差异变化为状态(s,a)下的优势函数;2)初始化行动策略网络π

θ

(a

t

|s

t

)状态价值评估网络中的网络参数;3)采用多线程并行技术,每个线程使用域随机化设置j

l

、b

ml

、k

ml

、θ

tar

,确定当前线程使用的仿真使用的环境,总共设置n个环境;4)在每个线程中,从初始状态s0开始,行动策略网络π

θ

(a

t

|s

t

)不断根据当前状态s

t

选取动作a

t

(使用正态映射来保持动作的探索性),作用于环境获得下一时刻的状态s

t 1

,不断重复该过程直到该线程中的轨迹结束;形成单次采样的一整条轨迹τ=(s0,a0,r0,s1,a1,r1,

…

s

t

,a

t

,r

t

,

…

,s

t

,a

t

,r

t

),总共采集n条长度为t的轨迹;5)将每个线程中生成的轨迹组合成(s

t

,a

t

,r

t

)经验池;对经验池中的每一个状态s

t

,计

算当前状态的状态价值6)根据经验池中的数据和当前的状态价值函数估计每个状态动作对(s

t

,a

t

)的优势值为7)通过最大化ppo-clip目标来更新策略,策略优化的梯度方向为式中,i代表第i条轨迹,一共采样n条轨迹,t代表当前时刻使用策略梯度上升更新行动策略网络π

θ

(a

t

|s

t

)中的网络参数来优化参数其中α为更新步长,α具体使用adam算法来获得;8)根据最小均方误差原则来回归拟合状态价值函数,其目标定义为其中,v(s

t

)为求取的新的状态真值,使用梯度下降法来更新状态价值网络中的网络参数φ;9)不断重复3)~8)的过程,直到训练次数满足一定的条件终止训练。

技术总结

本发明公开了一种强化学习方法的奖励函数,包括位置相关的奖励函数r(Δθ1)、对超调量σ的惩罚r(σ)、电机位置的奖励r(Δθ

技术研发人员:熊欣欣 郑军 杨庆研

受保护的技术使用者:聚时科技(上海)有限公司

技术研发日:2022.09.16

技术公布日:2022/11/11

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。