1.本技术涉及通信技术领域,尤其涉及一种无线资源分配方法、适应通信环境动态变化的机器学习模型训练及推理方法、装置、网络侧设备和存储介质。

背景技术:

2.无线通信技术旨在提供更高的数据传输速率和多样的无线接口,以保证所有用户实现连续的无缝连接,但是,现有终端的电池容量远远落后于那些丰富的多媒体业务和多模多标准的服务所需要的电池容量,因此,高能效的传输,又被广泛称为绿色通信,吸引了越来越多人的关注。

3.正交频分复用多址接入(orthogonal frequency division multiple access,ofdma)技术是未来宽带无线网络采用的主流多址接入方案之一,例如第三代合作伙伴计划(the third generation partnership project,3gpp),长期演进(long term evolution,lte)等。然而,如何对ofdma网络资源进行合理分配以增强整个网络的性能,成为亟待解决的问题。

技术实现要素:

4.本技术提出的无线资源分配方法、适应通信环境动态变化的机器学习模型训练及推理方法、装置、网络侧设备和存储介质,可以将ofdma网络资源合理地分配给不同的用户,从而可以增强整个网络的性能。

5.根据本技术的第一方面,提供了一种无线资源分配方法,包括:

6.获取动态环境中当前时刻的大尺度信道增益和所述当前时刻的小尺度信道增益;

7.获取小尺度信道增益目标值,并获取上一时刻求解器的参数;所述参数包括用户宽带、乘子和功率神经网络参数;

8.根据所述当前时刻的大尺度信道增益、所述上一时刻求解器的参数和所述小尺度信道增益目标值在线训练迭代器,以更新当前时刻求解器的参数;

9.根据所述当前时刻求解器的参数和所述当前时刻的小尺度信道增益,进行资源分配。

10.在本技术一些实施例中,所述获取小尺度信道增益目标值,包括:

11.从离线环境中获取小尺度信道增益,并将从所述离线环境中获取的小尺度信道增益作为所述小尺度信道增益目标值。

12.在本技术一些实施例中,所述根据所述当前时刻的大尺度信道增益、所述上一时刻求解器的参数和所述小尺度信道增益目标值在线训练迭代器,以更新当前时刻求解器的参数,包括:

13.根据所述当前时刻的大尺度信道增益计算相应的梯度;

14.将所述上一时刻求解器的参数作为当前时刻迭代器的初始值;

15.根据所述相应的梯度和所述小尺度信道增益目标值,对所述当前时刻迭代器进行

n次迭代;

16.将所述当前时刻迭代器经过所述n次迭代后得到的参数作为所述当前时刻求解器的参数。

17.在本技术实施例中,所述迭代器的公式表示如下:

[0018][0019][0020][0021]

其中是拉格朗日函数在第t次迭代数值实现,是拉格朗日函数在第t次迭代数值实现,是第k个用户的可达速率在第t次迭代的第n个实现,nb是批数据大小,k为所述用户的数量,为所述第k个用户的有效带宽,θk为可求常数,eg是对小尺度信道增益取期望,ω(t)是所述功率神经网络在第t次迭代的参数,ω(t 1)是所述功率神经网络在第t 1次迭代的参数,φ(t)为第t次迭代的学习率,为矢量微分算符,wk为所述第k个用户的宽带,wk(t)是所述第k个用户在第t次迭代的宽带,wk(t 1)是所述第k个用户在第t 1次迭代的宽带,λk为所述第k个用户的长期约束乘子,λk(t)为所述第k个用户在第t次迭代的长期约束乘子,λk(t 1)为所述第k个用户的在第t 1次迭代的长期约束乘子。

[0022]

在本技术一些实施例中,所述根据所述当前时刻求解器的参数和所述当前时刻的小尺度信道增益,进行资源分配,包括:

[0023]

根据所述当前时刻求解器的参数之中的功率神经网络参数和所述当前时刻的小尺度信道增益,获取每个用户在所述当前时刻的功率;

[0024]

将所述当前时刻求解器的参数之中的用户宽带确定为所述每个用户在所述当前时刻的宽带;

[0025]

根据所述每个用户在所述当前时刻的带宽和功率进行资源分配。

[0026]

在本技术一些实施例中,所述迭代器首次进行在线训练时所使用的模型为离线预训练好的迭代器模型;其中,所述离线预训练好的迭代器模型之中的参数作为在对所述迭代器首次进行在线训练时所述求解器的初始参数。

[0027]

根据本技术的第二方面,提供了一种适应通信环境动态变化的机器学习模型训练及推理方法,包括:

[0028]

获取离线环境中的慢变参数和快变参数;

[0029]

采用无监督深度学习技术、所述离线环境中的慢变参数和快变参数对预设的迭代器模型进行预训练;

[0030]

获取动态环境中当前时刻的慢变参数和所述当前时刻的快变参数;

[0031]

根据所述动态环境中当前时刻的慢变参数、上一时刻求解器的参数和所述离线环境中的快变参数在线训练迭代器,以更新当前时刻求解器的参数;其中,所述迭代器首次进

行在线训练时所使用的模型为离线预训练好的迭代器模型,所述离线预训练好的迭代器模型之中的参数作为在对所述迭代器首次进行在线训练时所述求解器的初始参数;

[0032]

根据所述当前时刻求解器的参数和所述当前时刻的快变参数进行实时推理。

[0033]

根据本技术的第三方面,提供了一种网络侧设备,包括存储器、收发机和处理器;其中,

[0034]

所述存储器,用于存储计算机程序;所述收发机,用于在所述处理器的控制下收发数据;所述处理器,用于读取所述存储器中的计算机程序并执行以下操作:

[0035]

获取动态环境中当前时刻的大尺度信道增益和所述当前时刻的小尺度信道增益;

[0036]

获取小尺度信道增益目标值,并获取上一时刻求解器的参数;所述参数包括用户宽带、乘子和功率神经网络参数;

[0037]

根据所述当前时刻的大尺度信道增益、所述上一时刻求解器的参数和所述小尺度信道增益目标值在线训练迭代器,以更新当前时刻求解器的参数;

[0038]

根据所述当前时刻求解器的参数和所述当前时刻的小尺度信道增益,进行资源分配。

[0039]

在本技术一些实施例中,所述获取小尺度信道增益目标值,包括:

[0040]

从离线环境中获取小尺度信道增益,并将从所述离线环境中获取的小尺度信道增益作为所述小尺度信道增益目标值。

[0041]

在本技术一些实施例中,所述根据所述当前时刻的大尺度信道增益、所述上一时刻求解器的参数和所述小尺度信道增益目标值在线训练迭代器,以更新当前时刻求解器的参数,包括:

[0042]

根据所述当前时刻的大尺度信道增益计算相应的梯度;

[0043]

将所述上一时刻求解器的参数作为当前时刻迭代器的初始值;

[0044]

根据所述相应的梯度和所述小尺度信道增益目标值,对所述当前时刻迭代器进行n次迭代;

[0045]

将所述当前时刻迭代器经过所述n次迭代后得到的参数作为所述当前时刻求解器的参数。

[0046]

在本技术实施例中,所述迭代器的公式表示如下:

[0047][0048][0049][0050]

其中是拉格朗日函数在第t次迭代数值实现,是拉格朗日函数在第t次迭代数值实现,是第k个用户的可达速率在第t次迭代的第n个实现,nb是批数据大小,k为所述用户的数量,为所述第k个用户的有效带宽,θk为可求常数,eg是对小尺度信道增益取期望,ω(t)是所述功率神经网络在第t次迭代

的参数,ω(t 1)是所述功率神经网络在第t 1次迭代的参数,φ(t)为第t次迭代的学习率,为矢量微分算符,wk为所述第k个用户的宽带,wk(t)是所述第k个用户在第t次迭代的宽带,wk(t 1)是所述第k个用户在第t 1次迭代的宽带,λk为所述第k个用户的长期约束乘子,λk(t)为所述第k个用户在第t次迭代的长期约束乘子,λk(t 1)为所述第k个用户的在第t 1次迭代的长期约束乘子。

[0051]

在本技术一些实施例中,所述根据所述当前时刻求解器的参数和所述当前时刻的小尺度信道增益,进行资源分配,包括:

[0052]

根据所述当前时刻求解器的参数之中的功率神经网络参数和所述当前时刻的小尺度信道增益,获取每个用户在所述当前时刻的功率;

[0053]

将所述当前时刻求解器的参数之中的用户宽带确定为所述每个用户在所述当前时刻的宽带;

[0054]

根据所述每个用户在所述当前时刻的带宽和功率进行资源分配。

[0055]

在本技术一些实施例中,所述迭代器首次进行在线训练时所使用的模型为离线预训练好的迭代器模型;其中,所述离线预训练好的迭代器模型之中的参数作为在对所述迭代器首次进行在线训练时所述求解器的初始参数。

[0056]

根据本技术的第四方面,提供了一种网络侧设备,包括存储器、收发机和处理器;其中,

[0057]

所述存储器,用于存储计算机程序;所述收发机,用于在所述处理器的控制下收发数据;所述处理器,用于读取所述存储器中的计算机程序并执行以下操作:

[0058]

获取离线环境中的慢变参数和快变参数;

[0059]

采用无监督深度学习技术、所述离线环境中的慢变参数和快变参数对预设的迭代器模型进行预训练;

[0060]

获取动态环境中当前时刻的慢变参数和所述当前时刻的快变参数;

[0061]

根据所述动态环境中当前时刻的慢变参数、上一时刻求解器的参数和所述离线环境中的快变参数在线训练迭代器,以更新当前时刻求解器的参数;其中,所述迭代器首次进行在线训练时所使用的模型为离线预训练好的迭代器模型,所述离线预训练好的迭代器模型之中的参数作为在对所述迭代器首次进行在线训练时所述求解器的初始参数;

[0062]

根据所述当前时刻求解器的参数和所述当前时刻的快变参数进行实时推理。

[0063]

根据本技术的第五方面,提供了一种无线资源分配装置,包括:

[0064]

第一获取单元,用于获取动态环境中当前时刻的大尺度信道增益和所述当前时刻的小尺度信道增益;

[0065]

第二获取单元,用于获取小尺度信道增益目标值;

[0066]

第三获取单元,用于获取上一时刻求解器的参数;所述参数包括用户宽带、乘子和功率神经网络参数;

[0067]

在线训练单元,用于根据所述当前时刻的大尺度信道增益、所述上一时刻求解器的参数和所述小尺度信道增益目标值在线训练迭代器,以更新当前时刻求解器的参数;

[0068]

资源分配单元,用于根据所述当前时刻求解器的参数和所述当前时刻的小尺度信道增益,进行资源分配。

[0069]

在本技术一些实施例中,所述第二获取单元具体用于:从离线环境中获取小尺度

信道增益,并将从所述离线环境中获取的小尺度信道增益作为所述小尺度信道增益目标值。

[0070]

在本技术一些实施例中,所述在线训练单元具体用于:根据所述当前时刻的大尺度信道增益计算相应的梯度;将所述上一时刻求解器的参数作为当前时刻迭代器的初始值;根据所述相应的梯度和所述小尺度信道增益目标值,对所述当前时刻迭代器进行n次迭代;将所述当前时刻迭代器经过所述n次迭代后得到的参数作为所述当前时刻求解器的参数。

[0071]

在本技术实施例中,所述迭代器的公式表示如下:

[0072][0073][0074][0075]

其中是拉格朗日函数在第t次迭代数值实现,是拉格朗日函数在第t次迭代数值实现,是第k个用户的可达速率在第t次迭代的第n个实现,nb是批数据大小,k为所述用户的数量,为所述第k个用户的有效带宽,θk为可求常数,eg是对小尺度信道增益取期望,ω(t)是所述功率神经网络在第t次迭代的参数,ω(t 1)是所述功率神经网络在第t 1次迭代的参数,φ(t)为第t次迭代的学习率,为矢量微分算符,wk为所述第k个用户的宽带,wk(t)是所述第k个用户在第t次迭代的宽带,wk(t 1)是所述第k个用户在第t 1次迭代的宽带,λk为所述第k个用户的长期约束乘子,λk(t)为所述第k个用户在第t次迭代的长期约束乘子,λk(t 1)为所述第k个用户的在第t 1次迭代的长期约束乘子。

[0076]

在本技术一些实施例中,所述资源分配单元具体用于:根据所述当前时刻求解器的参数之中的功率神经网络参数和所述当前时刻的小尺度信道增益,获取每个用户在所述当前时刻的功率;将所述当前时刻求解器的参数之中的用户宽带确定为所述每个用户在所述当前时刻的宽带;根据所述每个用户在所述当前时刻的带宽和功率进行资源分配。

[0077]

在本技术一些实施例中,所述迭代器首次进行在线训练时所使用的模型为离线预训练好的迭代器模型;其中,所述离线预训练好的迭代器模型之中的参数作为在对所述迭代器首次进行在线训练时所述求解器的初始参数。

[0078]

根据本技术的第六方面,提供了一种适应通信环境动态变化的机器学习模型训练及推理装置,包括:

[0079]

第一获取单元,用于获取离线环境中的慢变参数和快变参数;

[0080]

预训练单元,用于采用无监督深度学习技术、所述离线环境中的慢变参数和快变参数对预设的迭代器模型进行预训练;

[0081]

第二获取单元,用于获取动态环境中当前时刻的慢变参数和所述当前时刻的快变参数;

[0082]

在线训练单元,用于根据所述动态环境中当前时刻的慢变参数、上一时刻求解器的参数和所述离线环境中的快变参数在线训练迭代器,以更新当前时刻求解器的参数;其中,所述迭代器首次进行在线训练时所使用的模型为离线预训练好的迭代器模型,所述离线预训练好的迭代器模型之中的参数作为在对所述迭代器首次进行在线训练时所述求解器的初始参数;

[0083]

推理单元,用于根据所述当前时刻求解器的参数和所述当前时刻的快变参数进行实时推理。

[0084]

根据本技术的第七方面,提供了一种处理器可读存储介质,所述处理器可读存储介质存储有计算机程序,所述计算机程序用于使所述处理器执行本技术第一方面所述的无线资源分配方法,或者,执行本技术第二方面所述的适应通信环境动态变化的机器学习模型训练及推理方法。

[0085]

根据本技术实施例的技术方案,通过获取动态环境中当前时刻的大尺度信道增益和所述当前时刻的小尺度信道增益,并获取小尺度信道增益目标值,并获取上一时刻求解器的参数,根据所述当前时刻的大尺度信道增益、所述上一时刻求解器的参数和所述小尺度信道增益目标值在线训练迭代器,以更新当前时刻求解器的参数,以及根据所述当前时刻求解器的参数和所述当前时刻的小尺度信道增益,进行资源分配,可以将ofdma网络资源合理地分配给不同的用户,从而可以增强整个网络的性能。另外,本技术在对迭代器进行在线训练时只需要对环境参数中的小尺度信道增益进行学习,对大尺度信道增益进行跟踪,使得在线训练中的神经网络结构相较于离线训练更为简单,实时决策速度更快,并且对环境有着更强的适应能力。

附图说明

[0086]

本技术上述的和/或附加的方面和优点从下面结合附图对实施例的描述中将变得明显和容易理解,其中:

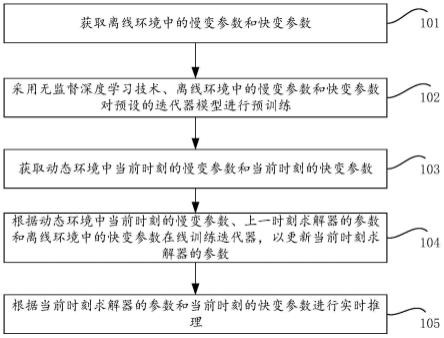

[0087]

图1为本技术实施例提供的一种适应通信环境动态变化的机器学习模型训练及推理方法的流程图。

[0088]

图2为根据本技术实施例提供的在线训练方法的实施流程图。

[0089]

图3为根据本技术实施例的在o-ran架构中在线训练的实施流程图。

[0090]

图4为本技术实施例提供的信道变化和帧结构的时间尺度的示意图。

[0091]

图5为本技术实施例提供的用于urllc的实时资源分配的实施流程图。

[0092]

图6为本技术实施例提供的一种无线资源分配方法的流程图。

[0093]

图7是根据本技术实施例提供的一种网络侧设备的结构框图。

[0094]

图8是本技术实施例提供的一种无线资源分配装置的结构框图。

[0095]

图9是本技术实施例提供的一种适应通信环境动态变化的机器学习模型训练及推理装置的结构框图。

具体实施方式

[0096]

本发明实施例中术语“和/或”,描述关联对象的关联关系,表示可以存在三种关系,例如,a和/或b,可以表示:单独存在a,同时存在a和b,单独存在b这三种情况。字符“/”一

般表示前后关联对象是一种“或”的关系。

[0097]

本技术实施例中术语“多个”是指两个或两个以上,其它量词与之类似。

[0098]

下面将结合本技术实施例中的附图,对本技术实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本技术一部分实施例,并不是全部的实施例。基于本技术中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本技术保护的范围。

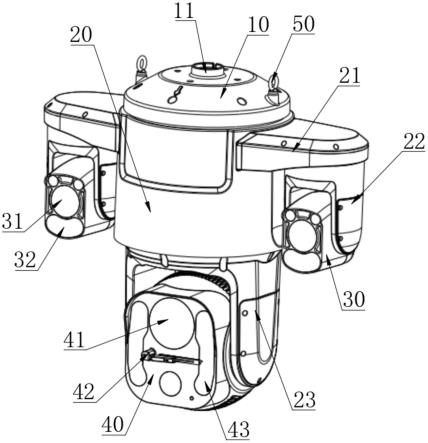

[0099]

本技术实施例涉及的网络侧设备,可以是基站,该基站可以包括多个为终端提供服务的小区。根据具体应用场合不同,基站又可以称为接入点,或者可以是接入网中在空中接口上通过一个或duoge扇区与无线终端设备通信的设备,或者其它名称。网络侧设备可用于将收到的空中帧与网际协议(internet protocol,ip)分组进行相互更换,作为无线终端设备与接入网的其余部分之间的路由器,其中接入网的其余部分可包括网际协议(ip)通信网络。网络侧设备还可协调对空中接口的属性管理。例如,本技术实施例涉及的网络侧设备可以是全球移动通信系统(global system for mobile communications,gsm)或码分多址接入(code division multiple access,cdma)中的网络侧设备(base transceiver station,bts),也可以是带宽码分多址接入(wide-band code division multiple access,wcdma)中的网络侧设备(nodeb),还可以是长期演进(long term evolution,lte)系统中的演进型网络侧设备(evolutional node b,enb或e-nodeb)、5g网络架构(next generation system)中的5g基站(gnb),也可以是家庭演进基站(home evolved node b,henb)、中继节点(relay node)、家庭基站(femto)、微微基站(pico)等,本技术实施例中并不限定。在一些网络结构中,网络侧设备可以包括集中单元(centralized unit,cu)节点和分布单元(distributed unit,du)节点,集中单元和分布单元也可以地理上分开布置。

[0100]

需要说明的是,无线资源分配属于无线通信中的复杂优化问题。面对无线通信中的复杂优化问题,传统优化方法难以在短时间内(如1毫秒)得到准确的优化结果。为克服这一困难有研究者提出利用神经网络学习优化结果的方法来快速得到优化结果。该方法针对参数优化问题,通过传统优化方法在多种环境状态下离线求解优化问题,并利用监督学习训练神经网络拟合环境状态与优化结果间的关系,最终将充分训练的神经网络用于在线决策,根据实际环境实时给出优化结果。对于包括泛函优化问题在内的等难以利用传统优化方法求解的问题,则可以利用无监督学习进行训练。然而,受限于xunlji的规模及训练时间,神经网络对于环境变化的泛化能量有限,当实际环境与训练环境有显著差异时,神经网络无法提供可靠的结果。

[0101]

基于上述问题,本技术以无监督深度学习方法为例设计了一种基于迁移学习的机器学习架构,即提出了一种能够适应通信环境动态变化的机器学习模型训练及推理方法,将离线学习和在线学习相结合,既可以应用于o-ran的机器学习,也可以应用于其他系统的机器学习。如图1所示,本技术实施例的适应通信环境动态变化的机器学习模型训练及推理方法应用于网络侧设备,可以包括如下步骤。

[0102]

在步骤s101中,获取离线环境中的慢变参数和快变参数。

[0103]

在步骤s102中,采用无监督深度学习技术、离线环境中的慢变参数和快变参数对预设的迭代器模型进行预训练。

[0104]

在步骤s103中,获取动态环境中当前时刻的慢变参数和当前时刻的快变参数。

[0105]

在步骤s104中,根据动态环境中当前时刻的慢变参数、上一时刻求解器的参数和离线环境中的快变参数在线训练迭代器,以更新当前时刻求解器的参数。

[0106]

其中,在本技术实施例中,迭代器首次进行在线训练时所使用的模型为离线预训练好的迭代器模型,离线预训练好的迭代器模型之中的参数作为在对迭代器首次进行在线训练时求解器的初始参数。

[0107]

在步骤s105中,根据当前时刻求解器的参数和当前时刻的快变参数进行实时推理。

[0108]

下面将结合图2和图3详细描述本技术实施例的适应通信环境动态变化的机器学习模型训练及推理方法的实现过程。首先需要说明的是,如图2所示,本技术实施例的适应通信环境动态变化的机器学习模型训练及推理方法主要包括以下三个步骤:

[0109]

1、离线预训练:通过无监督学习的方法进行预训练,训练数据来自离线的环境。此处离线的环境指在非实时的条件下提前获得并储存的数据集,从而得到初始化的求解器(其中,该求解器可理解为优化参数)以及迭代器模型,并将求解器以及迭代器模型下载至在线训练平台。

[0110]

2、在线训练:跟踪动态环境中的慢变参数,基于迁移学习的思路,将前一时刻求解器中的参数作为当前时刻迭代器的初始值。输入一个取自动态环境的慢变参数到迭代器中,同时使用离线环境中的快变参数迭代,来更新求解器中的参数。

[0111]

3、ml推理模型:使用在线训练之后的迭代器模型,并利用更新好的求解器的结果,并基于当前的慢变参数和快变参数来进行实时推理(如实时资源分配)。

[0112]

在本技术一些实施例中,当本方法被应用于o-ran(open ran)架构中,预训练这一部分可以在非实时无线接入网控制器(non real time ran intelligent controller,non-rt ric)实现,在线跟踪和ml模型推理这两部分可以在近实时无线接入网控制器(near realtime ran intelligent controller,near-rt ric)中实现。

[0113]

需要说明的是,在进行机器学习模型训练之前,需要先定义问题模型。例如,考虑一个一般的最小化长期损失且最大化收益,同时满足长期约束及短期约束的资源优化问题,形式如下:

[0114][0115][0116]

g(x,f(θq),θq,θs)≤0#(1b)

[0117]

该问题为泛函优化问题,其中f(θq)为依赖于快变参数θq的控制函数,x为不依赖于θq的决策矢量,两者的优化结果均受慢变参数θs影响。j,c和g分别为长期目标、长期约束和短期约束对应的评价指标,均依赖于策略x和f(θq)以及参数θq和θs。简洁起见,后文的表示中均省略三个评价指标的自变量。

[0118]

在离线预训练阶段,对于任意给定的慢变参数θs,为解决问题(1),本技术采用了无监督深度学习方法。首先,通过引入拉格朗日乘子,含约束的原始问题(1)可转化为如下形式的主对偶问题:

[0119]

[0120]

s.t.λ≥0,μ(θq)≥0#(2a)

[0121]

其中,λ是长期约束的乘子矢量,μ(θq)是瞬时约束的乘子函数。为将待定函数转化至参数空间进行求解,利用神经网络对控制函数f(θq)和乘子函数μ(θq)进行参数化:

[0122][0123]

其中可以选择relu,softplus等函数作为输出层的激活函数以保证其输出结果非负。

[0124]

随后将拉格朗日函数l作为损失函数,利用随机梯度下降来优化变量x,训练策略网络参数ωf,利用随机梯度上升优化乘子λ训练乘子网络参数ω

μ

:

[0125][0126][0127][0128][0129]

其中[]

=max{z,0},是拉格朗日函数在第t步迭代的数值实现。训练得到的网络即可根据动态变化的θq实时给出决策结果,但当θs发生变化时,则需重新训练。

[0130]

对于o-ran系统,如图3所示,在non-rt ric上进行离线训练,训练数据来自o1接口,包括快变参数和慢变参数。离线训练好的模型通过o1接口下载至near-rt ric作为迭代模型,同时离线训练得到的优化的参数作为求解器初始参数通过o1接口发送给near-rt ric。

[0131]

在实施流程的第一步中,通过离线训练方法进行预训练,求解器参数包括优化变量x,乘子λ,以及神经网络参数ωf和ω

μ

。

[0132]

在实施流程的第二步中,将动态环境参数划分为快变参数和慢变参数,以信道增益为例,将一段时间t

l

内的信道采样取平均作为这段时间的慢变参数,而将这段时间内所有的采样减去平均值作为快变参数,即:

[0133][0134]

θ

qi

=θ

i-θs[0135]

其中,n表示t

l

内总的采样点数,θi表示第i个信道采样,θ

qi

表示第i个快变参数。慢变参数将用于在线训练的迭代过程,而这里的快变参数将用于实时决策。

[0136]

在本技术中,根据上述式(3a-3d)进行迭代,每次迭代都是根据当前对动态环境中的慢变参数θs的最新观测进行的。例如对于第l次观测,θs的取值记为将代入到中并计算相应的梯度,随后利用快变参数进行n次迭代。由于在上述问题模型中,决定f(θq)这种映射关系的是θq的分布,而不是具体的某个θq的值,所以这里用于迭代的快变参数不需要是实时采样的,可以是来自于离线环境中的数据。采用离线快变参数而不是在线快

变参数进行迭代的原因是在线学习时,能够得到的动态环境的快变参数的样本是有限的;一方面,只用使用有限的实时样本,不能有效地拟合快变参数的整体分布,从而不能保证学习的性能。另一方面,如果等待采集足够多的快变参数样本,需要等待较长的时间,不能满足在线学习的需求。因此,本技术采用离线环境的快变参数,可以根据分布直接生成足够的样本,也不需要等待过长的时间,因此采用离线的样本可以在兼顾学习性能和实时性需求。

[0137]

对于第(l 1)次观测,θs由变为本技术基于迁移学习的思想,由于θs变化缓慢,相邻观测间差异较小,此时新环境下的最优策略和原环境下的最优策略往往相差不大,因而可以将上一次优化和训练得到的参数作为新环境中策略优化的初值,即

[0138]

x

l 1

(1)=x

l

(n)

[0139][0140]

λ

l 1

(1)=λ

l

(n)

[0141][0142]

由此,在每轮训练中仅需通过少量迭代来对先前的策略进行修正,得到当前时刻的最优网络参数和最优解,从而达到在线跟踪的目的。

[0143]

对于o-ran系统,离线训练所得的求解器和迭代器模型通过o1接口下载到near-rt ric来进行在线训练。在线训练的迭代器模型的输入数据包括从o1接口获取的离线环境的快变参数、从e2接口获取的动态环境的慢变参数以及前一时刻求解器中的参数(作为当前时刻迭代器的初始值)。而每次在线训练的迭代器所获得求解器的参数可以作为下一次在线训练的求解器的初值。

[0144]

在线的迭代器迭代由式(3a-3d)决定,迭代初值来自式(4);而离线预训练方法的迭代器迭代由式(3a-3d)决定,迭代初值是随机的。

[0145]

在实施流程的第三步中,本技术基于当前环境参数θs下得到的来对f(θq)进行实时推理,并基于迭代关系式(3a)实时更新优化变量x。对于o-ran系统,实时推理的模型来自迭代关系式(3a),该模型的输入参数为来自e2的动态环境中的慢变参数和快变参数。其中,对于首次在线训练,其参数需要通过第一步的预训练来初始化。

[0146]

在本技术中,快变参数作为神经网络的输入进行泛化,慢变参数可通过在线训练动态跟踪。这样一方面可以简化在线无监督学习的神经网络结构,另一方面可以很好地适应环境变化。

[0147]

由此可见,本技术基于无监督深度学习以及迁移学习,提供了一种能够适应通信环境动态变化的机器学习模型训练及推理方法,充分利用了离线环境和动态环境中的快慢参数的特点以及迭代器,来重新构造o-ran的机器学习模型在线训练系统。利用实时场景下前后时刻的时间相关性,将上一个时刻中神经网络参数的最优解作为下一时刻神经网络的初始值,这极大地减少了每一次训练的迭代次数。这样既可以在线跟踪慢变参数的动态变化,也可以根据当前的快变参数进行实时决策,从而保证了模型的泛化性能和实时性能。并且除非离线训练的机器学习模型进行了更改,否则离线训练结束后无须将机器学习模型下载至在线训练系统,而只需下载离线训练的相关参数即可,从而提高了整个训练系统的效率。

[0148]

可以理解,传统的o-ran的ml模型如果用于实时场景,一种方法是将离线模型直接用于在线模式进行在线训练和推理,在环境变化时,重新从头训练模型,这带来了巨大的训练复杂度,很难满足实时性要求。另一种方法是尽可能多的离线学习环境参数,但是这会使得神经网络的规模和结构变大,从而导致训练困难和决策时间过长等问题。相比于上述传统的离线训练方法,本技术的在线训练只需要对环境参数中的快变参数进行学习,dui慢变参数进行跟踪,这使得在线训练方法中的神经网络结构相较于离线训练更为简单,实时决策速度更快,并且对环境有着更强的适应能力。

[0149]

本技术提供了一种无线资源分配的实例,考虑一个面向超可靠低延时(ultra reliable low latency communication,urllc)服务的正交频分多址(orthogonal frequency division multiple access,ofdma)下行链路。一个小区内有一个最大发射功率为p

max

的基站,配有n

t

个天线,服务k个单天线用户。

[0150]

本实例中的时间尺度划分如图4所示:小尺度信道增益的相关时间为ts,每个ts又被划分为多个帧结构,每个帧的长度为tf,为了满足urllc苛刻的延时需求考虑了跳频技术,这样每帧间的小尺度信道增益是独立的,上行传输和下行传输在一个帧间完成,其中下行传输时间为τ,另外假定大尺度信道增益在t

l

内近似不变。

[0151]

在urllc中,由于传输时间很短,导致信道编码的码长较短,不能忽略解码错误对可靠性的影响,因此本技术考虑了有限块长体制下可达到的速率。在准静态平坦衰落信道中,当信道状态信息在发射端与接收端都已知时,第k个用户的可达速率(以数据包/帧为单位)可以通过下式估算得到:

[0152][0153]

其中是第k个用户的解码错误概率,αk和gk是第k个用户的大尺度信道增益和小尺度信道增益,n0为噪声单边功率谱密度,是高斯q函数的倒数,vk是表示信道色散的参数,当信噪比较大时,vk≈1。

[0154]

为了利用多用户分集,本技术根据所有用户的小尺度信道增益g={g1,g2,

…

,gk}来分配每个用户的传输功率。同时为了减少计算复杂度,假定带宽的分配结果只依赖于大尺度信道增益α。结合前述的时间尺度说明,此处g为快变参数,α为慢变参数。本技术的优化目标是在满足urllc的qos需求下,使得总用户带宽最少,优化的变量是基站分配给每个用户的带宽和功率:

[0155][0156][0157][0158]

上式中(5a)是通过引入有效容量与有效带宽来表征urllc的qos需求的约束

关系,不等式的左边是有效容量的表达式,θk是一个可求常数,是对小尺度信道增益取期望。另外当考虑数据包的到达过程是一个泊松过程时,其中ak是k个用户的平均包到达率。(5a)是一个长期的约束,表示在t

l

时间内,用户的延时性和可靠性需要满足的限制。而(5b)是一个短期约束,表示在每个tf内需要满足最大功率限制以及非负性限制。

[0159]

在上述两个时间尺度的制约下,问题(5)变成了一个泛函优化问题,用传统的优化算法(如凸优化)难以解决。本技术将分别基于离线学习优化方法和在线训练方法来求解这个问题。

[0160]

在离线训练阶段,先通过引入拉格朗日乘子,将含约束的原始问题(5转化为如下形式的对偶问题:

[0161][0162]

s.t.pk(g)≥0,wk≥0,h(g)≥0,λk≥0

ꢀꢀꢀ

(6)

[0163]

其中λk是第k个用户的长期约束乘子,h(g)是瞬时约束的乘子函数。利用神经网络对功率函数p(g)和乘子函数h(g)进行参数化估计:

[0164][0165]

在本实例中,选择神经网络的输出层为softmax,这样(5b)的最大功率限制实际上可以自动满足,此时就没有必要再对h(g)进行参数化。

[0166]

针对每一个固定的慢变参数α,可以基于下式来迭代求解最优的资源分配:

[0167][0168][0169][0170]

其中其中是第k个用户的可达速率在第t次迭代的第n个实现,nb是批数据大小。注意当α改变时,需要从头开始利用(7)式来重新迭代求解问题(6)。

[0171]

在在线训练阶段,基站端执行实时资源分配的流程如图5所示:

[0172]

1、基站通过离线训练的方法进行预训练来初始化求解器,求解器参数包括用户带宽乘子以及功率神经网络其中n0表示无监督学习的迭代次数,n0>>n。

[0173]

2、跟踪动态环境中的大尺度信道增益。其中,同样利用(7)式进行求解,不同的是每次求解都是根据当前对α的最新观测进行的。对于第l时刻的观测,α的取值记为α

l

,将α=

α

l

代入到中并计算相应的梯度,随后根据(7)式进行n次迭代。对于第(l 1)时刻的观测,α由α

l

变为α

l 1

。因α变化缓慢,相邻观测间差异较小,此时新环境下的最优策略和原环境下的最优策略往往相差不大,因而可以将先前优化和训练得到的参数作为新环境中策略优化的初值,即:

[0174]wl 1

(1)=w

l

(n)

[0175][0176]

λ

l 1

(1)=λ

l

(n)#(8)

[0177]

由此,在每轮训练中仅需通过少量迭代来对先前的策略进行修正,得到当前时刻的最优网络参数和最优解,从而达到在线跟踪的目的。输入一个大尺度信道增益到迭代器中,同时利用n个/批小尺度信道增益迭代n次,用来更新当前时刻l 1求解器中的参数,注意此处用于迭代的小尺度信道增益不需要是实时采样的,可以是来自于离线环境中的数据。

[0178]

3、基站利用当前时刻l 1的求解器,基于当前时刻的小尺度信道增益g

l 1

来进行实时资源分配。

[0179]

举例而言,如图6所示,本技术实施例的无线资源分配方法应用于网络侧设备,可包括以下步骤。

[0180]

在步骤s601中,获取动态环境中当前时刻的大尺度信道增益和当前时刻的小尺度信道增益。

[0181]

在步骤s602中,获取小尺度信道增益目标值,并获取上一时刻求解器的参数;参数包括用户宽带、乘子和功率神经网络参数。

[0182]

在本技术实施例中,可从离线环境中获取小尺度信道增益,并将从离线环境中获取的小尺度信道增益作为小尺度信道增益目标值。也就是说,在对迭代器进行在线训练时所使用的小尺度信道增益不需要是实时采样的,可以是来自于离线环境中的数据。由此,通过采用离线环境中的小尺度信道增益,可以根据分布直接生成足够的样本,也不需要等待过长的时间,因此采用离线的样本可以在兼顾学习性能和实时性需求。

[0183]

在步骤s603中,根据当前时刻的大尺度信道增益、上一时刻求解器的参数和小尺度信道增益目标值在线训练迭代器,以更新当前时刻求解器的参数。

[0184]

在本技术一些实施例中,可根据当前时刻的大尺度信道增益计算相应的梯度;将上一时刻求解器的参数作为当前时刻迭代器的初始值;根据相应的梯度和小尺度信道增益目标值,对当前时刻迭代器进行n次迭代;将当前时刻迭代器经过n次迭代后得到的参数作为当前时刻求解器的参数。其中,该迭代器的公式表示可如下式:

[0185][0186][0187][0188]

其中是拉格朗日函数在第t次迭代数值实现,

是第k个用户的可达速率在第t次迭代的第n个实现,nb是批数据大小,k为用户的数量,为第k个用户的有效带宽,θk为可求常数,eg是对小尺度信道增益取期望,ω(t)是功率神经网络在第t次迭代的参数,ω(t 1)是功率神经网络在第t 1次迭代的参数,φ(t)为第t次迭代的学习率,为矢量微分算符,wk为第k个用户的宽带,wk(t)是第k个用户在第t次迭代的宽带,wk(t 1)是第k个用户在第t 1次迭代的宽带,λk为第k个用户的长期约束乘子,λk(t)为第k个用户在第t次迭代的长期约束乘子,λk(t 1)为第k个用户的在第t 1次迭代的长期约束乘子。

[0189]

需要说明的是,迭代器首次进行在线训练时所使用的模型为离线预训练好的迭代器模型;其中,离线预训练好的迭代器模型之中的参数作为在对迭代器首次进行在线训练时求解器的初始参数。

[0190]

在步骤s604中,根据当前时刻求解器的参数和当前时刻的小尺度信道增益,进行资源分配。

[0191]

例如,如图5所示,在根据当前时刻的大尺度信道增益α

l 1

、上一时刻求解器的参数(即ω

l

、w

kl

、λ

kl

)和小尺度信道增益目标值(即离线环境中的小尺度信道增益g)对迭代器进行在线训练,以更新当前时刻l 1求解器的参数(即ω

l 1

、w

kl 1

、λ

kl 1

)之后,可根据当前时刻l 1求解器的参数之中的功率神经网络参数ω

l 1

和当前时刻l 1的小尺度信道增益g

l 1

,利用功率计算公式计算每个用户在当前时刻的功率。将当前时刻l 1求解器的参数之中的用户宽带w

kl 1

确定为每个用户在当前时刻l 1的宽带。根据每个用户在当前时刻l 1的带宽和功率进行资源分配。

[0192]

综上所述,本技术实施例的无线资源分配方法,通过获取动态环境中当前时刻的大尺度信道增益和所述当前时刻的小尺度信道增益,并获取小尺度信道增益目标值,并获取上一时刻求解器的参数,根据所述当前时刻的大尺度信道增益、所述上一时刻求解器的参数和所述小尺度信道增益目标值在线训练迭代器,以更新当前时刻求解器的参数,以及根据所述当前时刻求解器的参数和所述当前时刻的小尺度信道增益,进行资源分配,可以将ofdma网络资源合理地分配给不同的用户,从而可以增强整个网络的性能。另外,本技术在对迭代器进行在线训练时只需要对环境参数中的小尺度信道增益进行学习,对大尺度信道增益进行跟踪,使得在线训练中的神经网络结构相较于离线训练更为简单,实时决策速度更快,并且对环境有着更强的适应能力。

[0193]

图7是根据本技术实施例提供的一种网络侧设备的结构框图。如图7所示,该网络侧设备可以包括:存储器701、收发机702和处理器703,通过总线接口实现数据的传输。

[0194]

其中,存储器701,用于存储计算机程序;

[0195]

收发机702,用于在处理器703的控制下收发数据;收发机702可以是多个元件,即包括发送机和接收机,提供用于在传输介质上与各种其他装置通信的单元,这些传输介质包括无线信道、有线信道、光缆等传输介质;

[0196]

处理器703,用于读取存储器中的计算机程序并执行对应的操作。处理器703可以是中央处埋器(cpu)、专用集成电路(application specific integrated circuit,asic)、现场可编程门阵列(field-programmable gate array,fpga)或复杂可编程逻辑器件

(complex programmable logic device,cpld),处理器也可以采用多核架构。

[0197]

在本技术实施例中,处理器703读取存储其中的计算机程序并执行以下操作:

[0198]

s701’,获取动态环境中当前时刻的大尺度信道增益和当前时刻的小尺度信道增益;

[0199]

s702’,获取小尺度信道增益目标值,并获取上一时刻求解器的参数;参数包括用户宽带、乘子和功率神经网络参数;

[0200]

在本技术实施例中,可从从离线环境中获取小尺度信道增益,并将从离线环境中获取的小尺度信道增益作为小尺度信道增益目标值。

[0201]

s703’,根据当前时刻的大尺度信道增益、上一时刻求解器的参数和小尺度信道增益目标值在线训练迭代器,以更新当前时刻求解器的参数;

[0202]

在一些实施例中,根据当前时刻的大尺度信道增益计算相应的梯度;将上一时刻求解器的参数作为当前时刻迭代器的初始值;根据相应的梯度和小尺度信道增益目标值,对当前时刻迭代器进行n次迭代;将当前时刻迭代器经过n次迭代后得到的参数作为当前时刻求解器的参数。

[0203]

在本技术实施例中,迭代器的公式表示如下:

[0204][0205][0206][0207]

其中是拉格朗日函数在第t次迭代数值实现,是拉格朗日函数在第t次迭代数值实现,是第k个用户的可达速率在第t次迭代的第n个实现,nb是批数据大小,k为用户的数量,为第k个用户的有效带宽,θk为可求常数,eg是对小尺度信道增益取期望,ω(t)是功率神经网络在第t次迭代的参数,ω(t 1)是功率神经网络在第t 1次迭代的参数,φ(t)为第t次迭代的学习率,为矢量微分算符,wk为第k个用户的宽带,wk(t)是第k个用户在第t次迭代的宽带,wk(t 1)是第k个用户在第t 1次迭代的宽带,λk为第k个用户的长期约束乘子,λk(t)为第k个用户在第t次迭代的长期约束乘子,λk(t 1)为第k个用户的在第t 1次迭代的长期约束乘子。

[0208]

需要说明的是,在本技术实施例中,迭代器首次进行在线训练时所使用的模型为离线预训练好的迭代器模型;其中,离线预训练好的迭代器模型之中的参数作为在对迭代器首次进行在线训练时求解器的初始参数。

[0209]

s704’,根据当前时刻求解器的参数和当前时刻的小尺度信道增益,进行资源分配。

[0210]

在一些实施例中,可根据当前时刻求解器的参数之中的功率神经网络参数和当前时刻的小尺度信道增益,获取每个用户在当前时刻的功率;将当前时刻求解器的参数之中的用户宽带确定为每个用户在当前时刻的宽带;根据每个用户在当前时刻的带宽和功率进

行资源分配。

[0211]

本技术实施例的网络侧设备,通过获取动态环境中当前时刻的大尺度信道增益和所述当前时刻的小尺度信道增益,并获取小尺度信道增益目标值,并获取上一时刻求解器的参数,根据所述当前时刻的大尺度信道增益、所述上一时刻求解器的参数和所述小尺度信道增益目标值在线训练迭代器,以更新当前时刻求解器的参数,以及根据所述当前时刻求解器的参数和所述当前时刻的小尺度信道增益,进行资源分配,可以将ofdma网络资源合理地分配给不同的用户,从而可以增强整个网络的性能。另外,本技术在对迭代器进行在线训练时只需要对环境参数中的小尺度信道增益进行学习,对大尺度信道增益进行跟踪,使得在线训练中的神经网络结构相较于离线训练更为简单,实时决策速度更快,并且对环境有着更强的适应能力。

[0212]

在本技术的其他实施例中,处理器703读取存储其中的计算机程序并执行以下操作:

[0213]

s71’,获取离线环境中的慢变参数和快变参数;

[0214]

s72’,采用无监督深度学习技术、所述离线环境中的慢变参数和快变参数对预设的迭代器模型进行预训练;

[0215]

s73’,获取动态环境中当前时刻的慢变参数和所述当前时刻的快变参数;

[0216]

s74’,根据所述动态环境中当前时刻的慢变参数、上一时刻求解器的参数和所述离线环境中的快变参数在线训练迭代器,以更新当前时刻求解器的参数;其中,所述迭代器首次进行在线训练时所使用的模型为离线预训练好的迭代器模型,所述离线预训练好的迭代器模型之中的参数作为在对所述迭代器首次进行在线训练时所述求解器的初始参数;

[0217]

s75’,根据所述当前时刻求解器的参数和所述当前时刻的快变参数进行实时推理。

[0218]

在此需要说明的是,本发明实施例提供的上述网络侧设备能够实现上述方法实施例所实现的所有方法步骤,且能达到相同的技术效果,在此不再对本实施例中与方法实施例相同的部分及有益效果进行具体赘述。

[0219]

根据本技术实施例的网络侧设备,利用实时场景下前后时刻的时间相关性,将上一个时刻中神经网络参数的最优解作为下一时刻神经网络的初始值,这极大地减少了每一次训练的迭代次数。这样既可以在线跟踪慢变参数的动态变化,也可以根据当前的快变参数进行实时决策,从而保证了模型的泛化性能和实时性能。并且除非离线训练的机器学习模型进行了更改,否则离线训练结束后无须将机器学习模型下载至在线训练系统,而只需下载离线训练的相关参数即可,从而提高了整个训练系统的效率。相比于上述传统的离线训练方法,本技术的在线训练只需要对环境参数中的快变参数进行学习,dui慢变参数进行跟踪,这使得在线训练方法中的神经网络结构相较于离线训练更为简单,实时决策速度更快,并且对环境有着更强的适应能力。

[0220]

图8是本技术实施例提供的一种无线资源分配装置的结构框图。如图8所示,该无线资源分配装置800可以包括:第一获取单元801、第二获取单元802、第三获取单元803、在线训练单元804和资源分配单元805。

[0221]

具体地,第一获取单元801用于获取动态环境中当前时刻的大尺度信道增益和当前时刻的小尺度信道增益;

[0222]

第二获取单元802用于获取小尺度信道增益目标值;在本技术一些实施例中,第二获取单元802具体用于:从离线环境中获取小尺度信道增益,并将从离线环境中获取的小尺度信道增益作为小尺度信道增益目标值。

[0223]

第三获取单元803用于获取上一时刻求解器的参数;参数包括用户宽带、乘子和功率神经网络参数;

[0224]

在线训练单元804用于根据当前时刻的大尺度信道增益、上一时刻求解器的参数和小尺度信道增益目标值在线训练迭代器,以更新当前时刻求解器的参数;

[0225]

在本技术一些实施例中,在线训练单元804具体用于:根据当前时刻的大尺度信道增益计算相应的梯度;将上一时刻求解器的参数作为当前时刻迭代器的初始值;根据相应的梯度和小尺度信道增益目标值,对当前时刻迭代器进行n次迭代;将当前时刻迭代器经过n次迭代后得到的参数作为当前时刻求解器的参数。

[0226]

在本技术实施例中,迭代器的公式表示如下:

[0227][0228][0229][0230]

其中是拉格朗日函数在第t次迭代数值实现,是拉格朗日函数在第t次迭代数值实现,是第k个用户的可达速率在第t次迭代的第n个实现,nb是批数据大小,k为用户的数量,为第k个用户的有效带宽,θk为可求常数,eg是对小尺度信道增益取期望,ω(t)是功率神经网络在第t次迭代的参数,ω(t 1)是功率神经网络在第t 1次迭代的参数,φ(t)为第t次迭代的学习率,为矢量微分算符,wk为第k个用户的宽带,wk(t)是第k个用户在第t次迭代的宽带,wk(t 1)是第k个用户在第t 1次迭代的宽带,λk为第k个用户的长期约束乘子,λk(t)为第k个用户在第t次迭代的长期约束乘子,λk(t 1)为第k个用户的在第t 1次迭代的长期约束乘子。

[0231]

资源分配单元805用于根据当前时刻求解器的参数和当前时刻的小尺度信道增益,进行资源分配。在本技术一些实施例中,资源分配单元具体用于:根据当前时刻求解器的参数之中的功率神经网络参数和当前时刻的小尺度信道增益,获取每个用户在当前时刻的功率;将当前时刻求解器的参数之中的用户宽带确定为每个用户在当前时刻的宽带;根据每个用户在当前时刻的带宽和功率进行资源分配。

[0232]

需要说明的是,在本技术一些实施例中,迭代器首次进行在线训练时所使用的模型为离线预训练好的迭代器模型;其中,离线预训练好的迭代器模型之中的参数作为在对迭代器首次进行在线训练时求解器的初始参数。

[0233]

需要说明的是,本技术实施例中对单元的划分是示意性的,仅仅为一种逻辑功能划分,实际实现时可以有另外的划分方式。另外,在本技术各个实施例中的各功能单元可以集成在一个处理单元中,也可以是各个单元单独物理存在,也可以两个或两个以上单元集

成在一个单元中。上述集成的单元既可以采用硬件的形式实现,也可以采用软件功能单元的形式实现。

[0234]

所述集成的单元如果以软件功能单元的形式实现并作为独立的产品销售或使用时,可以存储在一个处理器可读取存储介质中。基于这样的理解,本技术的技术方案本质上或者说对现有技术做出贡献的部分或者该技术方案的全部或部分可以以软件产品的形式体现出来,该计算机软件产品存储在一个存储介质中,包括若干指令用以使得一台计算机设备(可以是个人计算机,服务器,或者网络设备等)或处理器(processor)执行本技术各个实施例所述方法的全部或部分步骤。而前述的存储介质包括:u盘、移动硬盘、只读存储器(read-only memory,rom)、随机存取存储器(random access memory,ram)、磁碟或者光盘等各种可以存储程序代码的介质。

[0235]

在此需要说明的是,本发明实施例提供的上述装置,能够实现上述方法实施例所实现的所有方法步骤,且能够达到相同的技术效果,在此不再对本实施例中与方法实施例相同的部分及有益效果进行具体赘述。

[0236]

图9是本技术实施例提供的一种适应通信环境动态变化的机器学习模型训练及推理装置的结构框图。如图9所述,该机器学习模型训练及推理装置900可以包括:第一获取单元901、预训练单元902、第二获取单元903、在线训练单元904和推理单元905。

[0237]

具体地,第一获取单元901用于获取离线环境中的慢变参数和快变参数。

[0238]

预训练单元902用于采用无监督深度学习技术、离线环境中的慢变参数和快变参数对预设的迭代器模型进行预训练

[0239]

第二获取单元903用于获取动态环境中当前时刻的慢变参数和当前时刻的快变参数。

[0240]

在线训练单元904用于根据动态环境中当前时刻的慢变参数、上一时刻求解器的参数和离线环境中的快变参数在线训练迭代器,以更新当前时刻求解器的参数;其中,迭代器首次进行在线训练时所使用的模型为离线预训练好的迭代器模型,离线预训练好的迭代器模型之中的参数作为在对迭代器首次进行在线训练时求解器的初始参数。

[0241]

推理单元905用于根据当前时刻求解器的参数和当前时刻的快变参数进行实时推理。

[0242]

需要说明的是,本技术实施例中对单元的划分是示意性的,仅仅为一种逻辑功能划分,实际实现时可以有另外的划分方式。另外,在本技术各个实施例中的各功能单元可以集成在一个处理单元中,也可以是各个单元单独物理存在,也可以两个或两个以上单元集成在一个单元中。上述集成的单元既可以采用硬件的形式实现,也可以采用软件功能单元的形式实现。

[0243]

所述集成的单元如果以软件功能单元的形式实现并作为独立的产品销售或使用时,可以存储在一个处理器可读取存储介质中。基于这样的理解,本技术的技术方案本质上或者说对现有技术做出贡献的部分或者该技术方案的全部或部分可以以软件产品的形式体现出来,该计算机软件产品存储在一个存储介质中,包括若干指令用以使得一台计算机设备(可以是个人计算机,服务器,或者网络设备等)或处理器(processor)执行本技术各个实施例所述方法的全部或部分步骤。而前述的存储介质包括:u盘、移动硬盘、只读存储器(read-only memory,rom)、随机存取存储器(random access memory,ram)、磁碟或者光盘

等各种可以存储程序代码的介质。

[0244]

在此需要说明的是,本发明实施例提供的上述装置,能够实现上述方法实施例所实现的所有方法步骤,且能够达到相同的技术效果,在此不再对本实施例中与方法实施例相同的部分及有益效果进行具体赘述。

[0245]

在示例性实施例中,还提供了一种处理器可读存储介质,例如网络侧设备中的处理器可读存储介质存储有计算机程序,计算机程序用于使所述处理器执行以完成上述方法。例如,所述存储介质可以是rom、随机存取存储器(ram)、cd-rom、磁带、软盘和光数据存储设备等。

[0246]

在示例性实施例中,还提供了一种包括计算机程序的计算机程序产品,例如,该计算机程序在被网络侧设备的处理器执行时可完成上述方法。

[0247]

本领域技术人员在考虑说明书及实践这里公开的发明后,将容易想到本技术的其它实施方案。本技术旨在涵盖本技术的任何变型、用途或者适应性变化,这些变型、用途或者适应性变化遵循本技术的一般性原理并包括本技术未公开的本技术领域中的公知常识或惯用技术手段。说明书和实施例仅被视为示例性的,本技术的真正范围和精神由下面的权利要求指出。

[0248]

应当理解的是,本技术并不局限于上面已经描述并在附图中示出的精确结构,并且可以在不脱离其范围进行各种修改和改变。本技术的范围仅由所附的权利要求来限制。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。