技术特征:

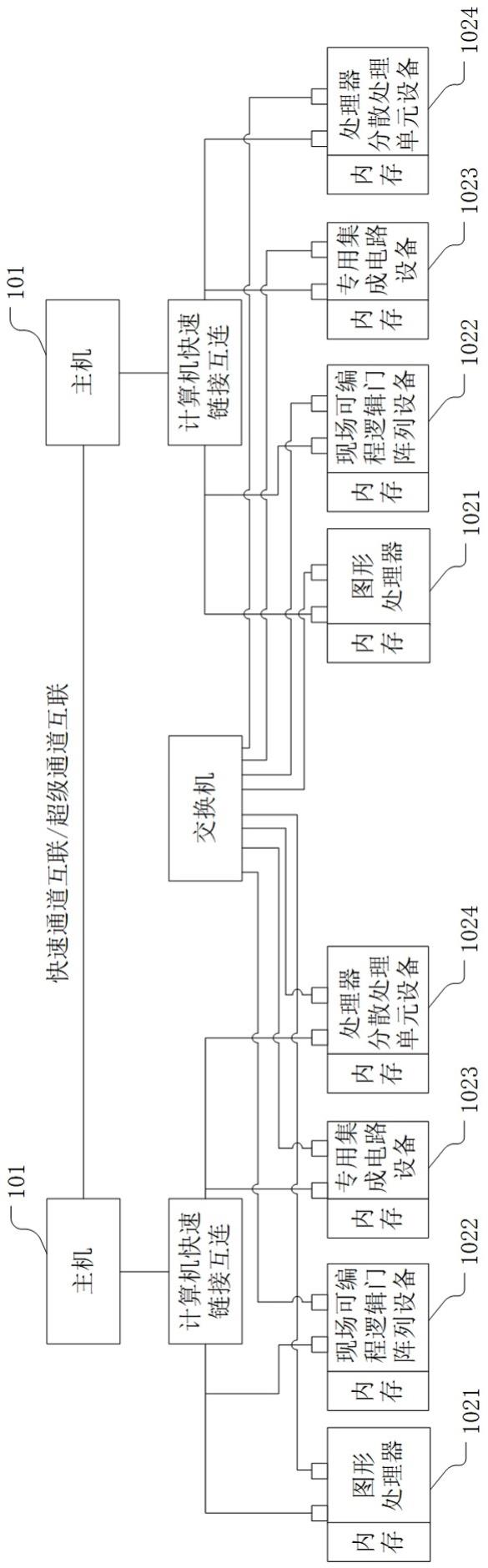

1.一种分布式训练系统,其特征在于,包括:主机,多个异构计算设备;其中,所述主机与所述异构计算设备之间,以及所述异构计算设备之间,均基于计算机快速链接协议建立了计算机快速链接;所述主机用于将模型训练任务划分为子任务,基于计算机快速链接将所述子任务的训练数据分配至各所述异构计算设备;所述异构计算设备用于执行被分配的所述子任务,并输出计算结果以更新所述模型训练任务的目标模型的模型参数。2.根据权利要求1所述的分布式训练系统,其特征在于,所述主机将模型训练任务划分为子任务,基于计算机快速链接将所述子任务的训练数据分配至各所述异构计算设备,具体为:所述主机根据各所述异构计算设备的类型将所述模型训练任务划分为所述子任务,并按照所述异构计算设备的类型分配所述子任务。3.根据权利要求2所述的分布式训练系统,其特征在于,所述主机根据各所述异构计算设备的类型将所述模型训练任务划分为所述子任务,并按照所述异构计算设备的类型分配所述子任务,具体为:将所述目标模型的全连接层对应的所述子任务分配至图形处理器,将所述目标模型的卷积层对应的所述子任务分配至现场可编程逻辑门阵列设备,将所述目标模型的激活层对应的所述子任务分配至专用集成电路设备和/或处理器分散处理单元设备。4.根据权利要求1所述的分布式训练系统,其特征在于,所述异构计算设备执行被分配的所述子任务,并输出计算结果以更新所述模型训练任务的目标模型的模型参数,具体为:所述异构计算设备执行被分配的所述子任务,并将得到的计算结果进行cholesky分解得到的矩阵发送至另一所述异构计算设备或所述主机以更新模型参数。5.根据权利要求1所述的分布式训练系统,其特征在于,所述主机将模型训练任务划分为子任务,基于计算机快速链接将所述子任务的训练数据分配至各所述异构计算设备,具体包括:所述主机将所述目标模型的初始模型加载至各所述异构计算设备;所述主机将所述目标模型的训练数据集拆分为多组小批量数据;所述主机将所述小批量数据分发至各所述异构计算设备;所述异构计算设备执行被分配的所述子任务,并输出计算结果以更新所述模型训练任务的目标模型的模型参数,具体为:所述异构计算设备执行所述子任务后输出当前迭代次数对应的训练参数,并将所述训练参数在各所述异构计算设备之间执行全规约操作以合并训练参数,以利用合并后的训练参数更新所述目标模型。6.根据权利要求5所述的分布式训练系统,其特征在于,所述异构计算设备执行所述子任务后输出当前迭代次数对应的训练参数,并将所述训练参数在各所述异构计算设备之间执行全规约操作以合并训练参数,以利用合并后的训练参数更新所述目标模型,具体为:所述异构计算设备执行所述子任务后并得到当前迭代次数对应的训练参数后,当接收到所述主机在检测到各所述异构计算设备均完成当前迭代次数的计算后发出的全规约命令后,在各所述异构计算设备之间执行全规约操作以合并训练参数,以利用合并后的训练

参数更新所述目标模型。7.根据权利要求5所述的分布式训练系统,其特征在于,所述异构计算设备执行所述子任务后输出当前迭代次数对应的训练参数,并将所述训练参数在各所述异构计算设备之间执行全规约操作以合并训练参数,以利用合并后的训练参数更新所述目标模型,具体包括:在第t次迭代计算中,所述异构计算设备将接收到的小批量数据输入模型,根据模型输出值与数据标签建立所述目标模型的损失函数并进行反向传播,计算得到小批量数据的梯度;所述异构计算设备根据等式计算得到梯度的第一历史滑动平均值;所述异构计算设备根据等式计算得到梯度与第一历史滑动平均值的差值的第二历史滑动平均值;所述异构计算设备根据等式计算得到第一历史滑动平均值的偏置校正值;在各所述异构计算设备之间对偏置校正值执行全规约操作,得到合并后的偏置校正值;所述异构计算设备在第二历史滑动平均值和在第t-1次迭代计算中求得的较大值中选择较大值;在各所述异构计算设备之间对较大值执行全规约操作,得到合并后的第二历史滑动平均值;根据等式更新所述目标模型的结果参数;其中,为数据,、为衰减系数,为的次方,为的次方,为迭代前进步长,为第t-1次迭代计算中求得的第一历史滑动平均值,为第t-1次迭代计算中求得的结果参数。8.一种分布式训练方法,其特征在于,包括:预先基于计算机快速链接协议搭建主机与异构计算设备之间的计算机快速链接以及

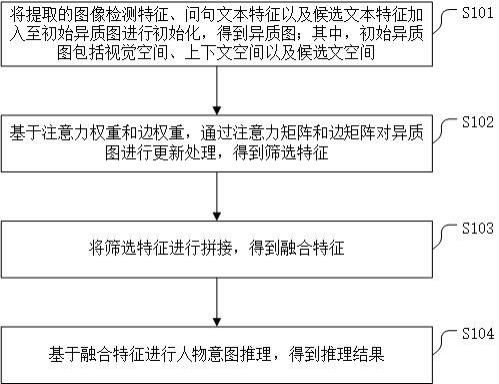

各所述异构计算设备之间的计算机快速链接;将模型训练任务划分为子任务,基于计算机快速链接将所述子任务的训练数据分配至各所述异构计算设备,以使所述异构计算设备执行被分配的所述子任务并输出计算结果以更新所述模型训练任务的目标模型的模型参数。9.根据权利要求8所述的分布式训练方法,其特征在于,所述将模型训练任务划分为子任务,基于计算机快速链接将所述子任务的训练数据分配至各所述异构计算设备,具体为:根据各所述异构计算设备的类型将所述模型训练任务划分为所述子任务,并按照所述异构计算设备的类型分配所述子任务。10.根据权利要求9所述的分布式训练方法,其特征在于,所述根据各所述异构计算设备的类型将所述模型训练任务划分为所述子任务,并按照所述异构计算设备的类型分配所述子任务,具体为:将所述目标模型的全连接层对应的所述子任务分配至图形处理器,将所述目标模型的卷积层对应的所述子任务分配至现场可编程逻辑门阵列设备,将所述目标模型的激活层对应的所述子任务分配至专用集成电路设备和/或处理器分散处理单元设备。11.根据权利要求8所述的分布式训练方法,其特征在于,所述异构计算设备执行被分配的所述子任务并输出计算结果以更新所述模型训练任务的目标模型的模型参数,具体为:所述异构计算设备执行被分配的所述子任务,并将得到的计算结果进行cholesky分解得到的矩阵发送至另一所述异构计算设备或所述主机以更新模型参数。12.根据权利要求8所述的分布式训练方法,其特征在于,所述将模型训练任务划分为子任务,基于计算机快速链接将所述子任务的训练数据分配至各所述异构计算设备,具体包括:将所述目标模型的初始模型加载至各所述异构计算设备;将所述目标模型的训练数据集拆分为多组小批量数据;将所述小批量数据分发至各所述异构计算设备;所述异构计算设备执行被分配的所述子任务并输出计算结果以更新所述模型训练任务的目标模型的模型参数,具体为:所述异构计算设备执行所述子任务后输出当前迭代次数对应的训练参数,并将所述训练参数在各所述异构计算设备之间执行全规约操作以合并训练参数,以利用合并后的训练参数更新所述目标模型。13.根据权利要求12所述的分布式训练方法,其特征在于,所述异构计算设备执行所述子任务后输出当前迭代次数对应的训练参数,并将所述训练参数在各所述异构计算设备之间执行全规约操作以合并训练参数,以利用合并后的训练参数更新所述目标模型,具体为:所述异构计算设备执行所述子任务后并得到当前迭代次数对应的训练参数后,当接收到所述主机在检测到各所述异构计算设备均完成当前迭代次数的计算后发出的全规约命令后,在各所述异构计算设备之间执行全规约操作以合并训练参数,以利用合并后的训练参数更新所述目标模型。14.根据权利要求12所述的分布式训练方法,其特征在于,所述异构计算设备执行所述子任务后输出当前迭代次数对应的训练参数,并将所述训练参数在各所述异构计算设备之

间执行全规约操作以合并训练参数,以利用合并后的训练参数更新所述目标模型,具体包括:在第t次迭代计算中,所述异构计算设备将接收到的小批量数据输入模型,根据模型输出值与数据标签建立所述目标模型的损失函数并进行反向传播,计算得到小批量数据的梯度;所述异构计算设备根据等式计算得到梯度的第一历史滑动平均值;所述异构计算设备根据等式计算得到梯度与第一历史滑动平均值的差值的第二历史滑动平均值;所述异构计算设备根据等式计算得到第一历史滑动平均值的偏置校正值;在各所述异构计算设备之间对偏置校正值执行全规约操作,得到合并后的偏置校正值;所述异构计算设备在第二历史滑动平均值和在第t-1次迭代计算中求得的较大值中选择较大值;在各所述异构计算设备之间对较大值执行全规约操作,得到合并后的第二历史滑动平均值;根据等式更新所述目标模型的结果参数;其中,为数据,、为衰减系数,为的次方,为的次方,为迭代前进步长,为第t-1次迭代计算中求得的第一历史滑动平均值,为第t-1次迭代计算中求得的结果参数。15.一种分布式训练装置,其特征在于,包括:部署单元,用于预先基于计算机快速链接协议搭建主机与异构计算设备之间的计算机快速链接以及各所述异构计算设备之间的计算机快速链接;控制单元,用于将模型训练任务划分为子任务,基于计算机快速链接将所述子任务的

训练数据分配至各所述异构计算设备,以使所述异构计算设备执行被分配的所述子任务并输出计算结果以更新所述模型训练任务的目标模型的模型参数。16.一种分布式训练设备,其特征在于,包括:存储器,用于存储计算机程序;处理器,用于执行所述计算机程序,所述计算机程序被所述处理器执行时实现如权利要求8至14任意一项所述分布式训练方法的步骤。17.一种可读存储介质,其上存储有计算机程序,其特征在于,所述计算机程序被处理器执行时实现如权利要求8至14任意一项所述分布式训练方法的步骤。

技术总结

本申请适用于计算机技术领域,具体公开了一种分布式训练系统、方法、装置、设备及可读存储介质,通过在主机与异构计算设备之间,以及异构计算设备之间,均基于计算机快速链接协议建立计算机快速链接,由主机将模型训练任务划分为子任务,基于计算机快速链接将子任务的训练数据分配至各异构计算设备执行分布式训练任务,打通了异构计算设备之间的通信延迟屏障,实现了多个异构计算设备之间的内存一致性,显著缩短了数据传输路径,增加了数据传输带宽,降低了异构计算设备之间的数据交互延迟,能够基于不同异构计算设备的特性对训练任务进行针对性处理,对于大规模深度学习模型的训练提供了坚实的硬件基础。训练提供了坚实的硬件基础。训练提供了坚实的硬件基础。

技术研发人员:邱志勇 郭振华 赵雅倩 李仁刚

受保护的技术使用者:浪潮电子信息产业股份有限公司

技术研发日:2022.10.12

技术公布日:2022/11/8

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。