1.公开了与音频对象的表示和渲染有关的实施例。

背景技术:

2.近年来,空间音频场景的基于对象的表示和渲染已成为沉浸式音频系统、格式和标准的共同特征。在基于对象的音频表示中,音频场景的至少一部分由一个或多个单独音频对象来表示,每个音频对象位于空间中的指定位置。每个单独音频对象通常被表示为具有关联位置(并且通常是附加类型)元数据的单声道音频信号。

3.在扩展现实(xr)(例如,虚拟现实(vr)、增强现实(ar)和混合现实(mr))应用中,通常使用双耳渲染处理通过耳机将基于对象的音频场景渲染给用户。

4.在最直接的基于对象的渲染场景中,通过分别双耳渲染每个单独音频对象将音频场景渲染给用户。这涉及将单独音频对象信号中的每一个与对应于每个单独音频对象的相对于用户的方向的合适头部相关传递函数(hrtf)滤波器对进行卷积。因此,如果音频场景由n个音频对象组成,则必须实时执行2

×

n个卷积以产生音频场景。对于包含许多音频对象的音频场景,这将导致音频场景渲染器的计算负载很大,并且需要发送的音频信号数量增加。

5.此外,如果音频场景中音频对象的位置动态改变,则可能还需要在hrtf滤波器之间进行实时插值,以获得用于音频对象的更新位置的合适滤波器。当用户旋转他们的头部使得音频对象的位置相对于用户改变时,实时插值也可能是必要的。在这种场景中,需要跟踪头部取向来影响音频渲染。

6.因此,基于对象的场景中包括的单独音频对象的直接双耳渲染可能需要过多的计算能力,尤其是在涉及实时渲染包含许多音频对象的场景的用例中。已经开发了各种解决方案来降低渲染包含许多对象的基于对象的音频场景的复杂度。

7.限制计算负载的一种方式是对场景中可以同时活动的音频对象的最大数量设置限制。例如,对于若干个复杂度级别,音频配置文件(例如,mpeg-h 3d音频低复杂度配置文件)可以指定在任何时间可能存在于一致内容流中的音频对象的最大数量。

8.处理渲染复杂度问题的另一方式是使用对音频对象的间接双耳渲染。在间接双耳渲染中,在实际双耳渲染之前执行中间预渲染步骤。例如,在mpeg-h 3d音频渲染器中,所有音频对象首先被预渲染为静态的、预定义的虚拟扬声器配置,并且在第一次预渲染之后,将所得虚拟扬声器信号双耳渲染给用户。在间接双耳渲染方法中,不是直接双耳渲染n个对象,而是首先将n个对象渲染到m个虚拟扬声器上,并然后将m个虚拟扬声器双耳渲染给用户。当m小于n时,间接双耳渲染方法导致降低的渲染复杂度,忽略了预渲染步骤的复杂度,其通常小于双耳渲染的复杂度。

9.在间接双耳渲染方法的变体中,可以执行将单独对象预渲染为以用户的收听位置为中心的较高阶环绕声(hoa)表示,并且在单独音频对象的预渲染之后,将中间hoa表示双耳渲染给用户。这种预渲染的示例在美国专利no.9,961,475中进行了描述。

10.另一种降低渲染多个音频对象的复杂度的方式是采用某种形式的聚类来减少要被渲染的音频对象的数量。例如,一些聚类算法可以用于基于某个标准(例如,单独对象彼此的空间接近度)将单独音频对象中的全部或一些分配给一个或多个组(即,集群)。与位于同一组(集群)中的音频对象相对应的音频信号被组合成聚类对象信号,并且与对应于未分组的单独对象的音频信号一起被双耳渲染给用户。该聚类可能导致聚类对象和非聚类单独音频对象的总数小于非聚类单独音频对象的原始数量。这导致降低的渲染复杂度,忽略了聚类并组合信号的复杂度,这些复杂度与双耳渲染的复杂度相比通常很小。

11.例如,如参考文献[2]中所述,一些聚类方法仅组合位于给定的彼此的空间接近度内的对象(“基于连接性的聚类”)。在这些聚类方法中,定义了所得聚类之间的最小距离,但所得的聚类数量取决于场景中单独对象的空间分布,因此可能会随着时间以不受控制的方式改变。

[0012]

其他聚类方法将所有单独音频对象组合成给定较少数量的聚类(“k均值聚类”),例如,如以下文献中所述的,s.miyabe、k.masatoki、h.saruwatari、k.shikano、t.nomura,“temporal quantization of spatial information using directional clustering for multichannel audio coding”,ieee,2009年10月。可用doi:10.1109/aspaa.2009.5346519。在这些方法中,定义了所得集群的数量,但所得集群之间的最小距离取决于场景中包括的单独音频对象的静态或动态空间分布。

[0013]

在一些聚类方法中,在聚类过程中考虑了附加感知性质。例如,给定包括单独音频对象的音频场景的总上下文(例如,其他音频对象的位置、电平和频谱特性)的情况下,在实际或假定收听位置处被认为在感知上不重要的单独音频对象可以不被考虑。

[0014]

例如,美国专利no.9,805,725描述了一种系统,其中,在第一步骤中,通过确定用于改变每个对象相对于实际或假定收听位置的位置的感知阈值来分析基于对象的音频场景。在第二步骤中,将根据该分析确定位于同一感知空间区域内的对象被分配给公共集群。对于每个集群,基于感知方面(例如,单独音频对象相对于实际或假定收听位置的部分响度)来确定感知主导对象或感知质心位置。在第三步中,将音频场景中包括的所有单独音频对象分配给一个或多个所标识的集群。在最后的渲染步骤中,将每个所得集群都处理并渲染为位于集群的所标识的感知主导源或感知质心的位置的常规点状音频对象。聚类对象的信号是被分配给聚类对象的单独音频对象的信号的混合。可选地,单独音频对象也可以与固定的“声道床”音频声道(即,与固定的多声道扬声器布局相对应的音频声道)合并。

技术实现要素:

[0015]

如上所述,存在旨在降低表示并渲染包含许多音频对象的基于对象的音频场景的复杂度的若干种解决方案。然而,这些解决方案具有显著的缺点。

[0016]

对音频对象的数量设置硬性限制

[0017]

通过对可以同时存在于音频场景中的对象的最大数量设置硬性限制来降低表示和渲染的复杂度,这限制了内容创建者的创作自由并要求内容创建者管理他们在任何给定时间使用的音频对象的数量。这种限制方法对于对同时包含在音频场景中的音频对象的数量设置固定上限可能很有用,系统可以在某个解码器配置中接受该固定上限(例如,如mpeg-h中所使用的方式),但它对于表示或渲染音频对象的复杂度的灵活(并且可能是动态

processing to audio and acoustics)中所述的)一致的特定性质。

[0027]

因此,聚类技术具有一些与预渲染技术相同的缺点。在上述聚类技术中,将与收听位置无关的对象表示转换为以听者为中心的最佳点表示,其中单独对象的空间信息被“冻结”为单声道聚类对象信号,因此每次用户位置或对象位置改变时都需要重新进行聚类(并且,在多听者场景中,需要为每个单独听者进行聚类)。

[0028]

本公开提供了一种解决方案,该解决方案降低了基于对象的音频场景的渲染和/或传输复杂度,而没有上述缺点。

[0029]

在一些实施例中,提供了一种用于表示并渲染包含许多音频对象的基于对象的音频场景的高效方法。该方法保留了原始的基于对象的场景的空间信息的本质,并允许空间信息基本上独立于任何(实际或假定的)收听位置。

[0030]

在一些实施例中,选择基于对象的音频场景中包括的音频对象集群,并将其转换为复合空间音频对象,其中,相对于音频对象集群内的参考位置来执行该转换。然后将复合空间音频对象作为所选音频对象集群的空间表示渲染给用户。以这种方式,复合空间音频对象独立于任何实际或假定的收听位置。

[0031]

根据一些实施例,提供了一种用于表示音频对象集群的方法。该方法包括:获得标识音频对象集群内的参考位置的参考位置信息,并且使用所获得的参考位置信息将音频对象集群转换为复合空间音频对象。独立于任何用户的任何收听位置来执行将音频对象集群转换为复合空间音频对象。

[0032]

在一些实施例中,该装置包括计算机可读存储介质;以及处理电路,耦接到计算机可读存储介质,其中,处理电路被配置为使该装置执行本文所述的方法。

[0033]

与单独地(双耳)渲染每个音频对象的相关技术相比,本公开的一些实施例提供了高度降低的渲染复杂度,尤其是在具有许多音频对象的场景中。此外,在转换步骤在编码器侧被执行的那些实施例中,可以高度降低要发送给解码器侧的音频数据量(即,可以实现更低复杂度的场景表示)。此外,与使用对象的聚类和/或对象的以听者为中心的预渲染来获得简化的场景表示的相关技术相比,本公开的实施例提供了通过将音频对象集群转换为空间音频对象(与单声道聚类对象和/或静态预定义声道床相反)来保留原始的基于对象的场景的更多空间信息的优点。

[0034]

实施例还提供了通过相对于集群内的参考位置执行对象集群的空间转换来维持场景的原始的基于对象的表示的以源为中心的(即,类对象的)性质的优点,而不是执行相对于特定(实际或假定的)听者位置的空间转换,因此保持该表示基本上独立于任何特定(实际或假定的)收听位置。当用户和/或对象在场景内移动时,保持该表示基本上独立于任何特定收听位置能够实现更高效的渲染适配。此外,保持表示基本上独立于任何特定收听位置能够在渲染中实现额外程度的艺术控制(例如,将旋转、平移或空间拓宽技术应用于表示音频对象集群的复合空间音频对象)。此外,通过保持表示基本上独立于任何特定收听位置,能够在多用户场景中实现更高效的渲染。

附图说明

[0035]

本文中所包含并形成说明书一部分的附图示出了各种实施例。

[0036]

图1是根据一些实施例的表示并渲染多个音频对象的过程。

[0037]

图2示出了示例性的基于对象的音频场景。

[0038]

图3示出了示例性虚拟麦克风设置。

[0039]

图4示出了根据一些实施例的平移技术。

[0040]

图5a至图5c以及图6示出了根据一些实施例的不同配置。

[0041]

图7示出了根据一些实施例的系统。

[0042]

图8a和图8b示出了根据一些实施例的系统。

[0043]

图9是根据一些实施例的过程。

[0044]

图10示出了根据一些实施例的装置。

具体实施例

[0045]

图1示出了根据一些实施例的表示并渲染多个音频对象的过程150。该方法可以从步骤s152开始。

[0046]

步骤s152包括形成音频对象集群——即,选择要被分组在一起的音频对象。

[0047]

在形成音频对象集群之后,在步骤s154中,在保留集群中包括的音频对象的相对空间位置信息的同时,将音频对象集群转换为表示音频对象集群的复合空间音频对象。相对于音频对象集群内的参考位置执行该转换。有利地,以这种方式,该转换独立于任何收听位置。

[0048]

在将音频对象集群转换为复合空间音频对象之后,在步骤s156中,在取决于参考位置的虚拟位置处渲染复合空间音频对象。可以双耳渲染复合空间音频对象。

[0049]

1.第一步骤(步骤s152):形成集群

[0050]

在一个实施例中,应该或可以被组合用于渲染的音频对象可以在编码器侧例如被内容制作者、内容制造平台/应用、或编码器预先选择。

[0051]

该选择可以基于聚类分析算法,该算法至少使用基于对象的音频场景中包含的单独音频对象的空间位置作为输入数据。例如,位于彼此相距一定距离内的音频对象可以被包括在集群中。

[0052]

图2示出了包含多个音频对象(例如,对象204至209)的示例性的基于对象的音频场景200。如图2所示,在音频场景200中,聚类分析算法得出这样的结论:基于单独音频对象的空间位置,位于椭圆边界202内的对象(即,对象204至208)可以被视为一个集群。

[0053]

聚类分析中所使用的距离度量可以是绝对(例如,欧几里得)距离,或者它可以是相对于某个参考位置(例如,场景的原点)的相对(例如,角度)距离。

[0054]

存在许多已知的可以用于执行基于位置的聚类分析的聚类算法。这种算法的示例在https://en.wikipedia.org/wiki/cluster_analysis中进行了描述。

[0055]

可以通过聚类分析算法中所使用的聚类标准的特定选择来控制聚类的数量。例如,如果聚类标准是位于彼此相距小于欧几里得距离(dcluster)的音频对象应该被聚类(即,被包括在同一聚类中),则可以通过改变dcluster的值来控制聚类的数量。

[0056]

当dcluster的值较大时,位于彼此相距较大空间范围内的音频对象将被聚类,从而产生较重的聚类。另一方面,如果dcluster的值较小,则仅彼此靠近的音频对象被聚类,从而产生较轻的聚类。

[0057]

在一些实施例中,可以控制聚类过程使得不超过某个最大数量的音频对象或音频

信号被渲染。在这种实施例中,可以基于所得音频对象或信号的最大数量自适应地或迭代地设置聚类标准(例如,dcluster)。

[0058]

如上所述,可以根据音频对象之间的最小距离或根据在聚类之后所得音频对象或信号的最大数量来设置期望的聚类,并且可以相应地选择并配置合适的聚类算法。

[0059]

在其中存在从渲染器(又名“解码器”)返回到音频对象源(例如,编码器)的通信的媒体流用例中,是否应用聚类和/或应用多少聚类的决定可以通过考虑渲染器中可用的计算资源来确定。例如,当用信号通知在渲染器处有足够的计算资源可用于对所有对象进行单独渲染时,聚类分析过程可以决定根本不应用聚类,使得在所渲染场景中维持最大空间精度。但是,如果在某个时刻用信号通知资源太有限而无法进行完整的单独对象渲染,则聚类分析过程会标识一个或多个将在渲染之前被转换的对象集群,集群的数量取决于可用资源。通常,渲染器中可用处理资源的数量越少,要被应用的聚类的数量就越大。

[0060]

聚类可以是动态的。换言之,聚类可以作为场景变化的结果而随时间变化。例如,如果场景包含移动对象,则单独对象可能移入和移出集群,或者在一些情况下,该聚类甚至可能完全改变。

[0061]

在一些实施例中,在解码器侧(或者由解码器/渲染器或由用户应用)选择要转换的音频对象集群。

[0062]

在选择音频对象集群时,可以考虑感知因素。例如,空间、时间和/或频率掩蔽性质可以用于标识可以在没有明显(或可接受的)感知结果的情况下组合的音频对象。美国专利no.9,805,725中描述了这种以感知为动机的聚类分析策略的示例。

[0063]

除了空间和感知性质之外,音频对象的其他性质可以用于选择可以被组合用于渲染的音频对象。例如,可以选择与场景中的相同视觉对象相关的音频对象或在场景中共享一些共同语义含义的对象以进行组合。在一些情况下,该选择甚至可以例如由内容创建者手动完成。

[0064]

步骤s152的结果是标识可以在渲染中被组合的音频对象。例如,步骤s152的输出是元数据,例如,分配给特定群集中包括的所有音频对象的特定群集标识符。

[0065]

2.第二步骤(s154):将音频对象集群转换为复合空间音频对象

[0066]

在步骤s154中,将音频对象集群在空间上转换为复合空间音频对象,该复合空间音频对象表示该集群中包括的音频对象的空间集合。相对于位于该集群内的参考位置执行转换。

[0067]

从转换所得的复合空间音频对象是单个空间实体,因为它可以作为单个单元(如传统音频对象)被渲染和操纵。然而,与常规音频对象相比,复合空间音频对象包含多个音频信号,这些音频信号一起捕获由复合空间音频对象表示的多个单独音频对象的相对空间信息。

[0068]

空间转换过程还为复合空间音频对象生成对应的元数据(例如,指定复合空间音频对象的位置的位置元数据以及指定复合空间音频对象的空间范围的空间范围元数据)。在参考文献[6]和参考文献[7]中描述了不同类型的复合空间音频对象。

[0069]

为了降低包含许多音频对象的场景的渲染复杂度,空间转换过程通常(但不一定)将产生复合空间音频对象,该复合空间音频对象包含数量小于它所表示的单独音频对象的数量的音频信号。在这种情况下,转换过程也可以被称为“空间缩混”。应当注意,术语“空间

缩混”也可以指上述更一般的“空间转换”。

[0070]

在相关技术中,空间转换过程使用听者的位置作为参考位置来生成空间缩混,其产生了仅对特定收听位置和音频对象的特定空间构象有效的以听者为中心的“最佳点”缩混。

[0071]

相反,如本文所述,相对于位于已选择进行组合的音频对象集群内的参考位置执行空间转换。相对于集群内的参考位置执行空间转换允许转换基本上独立于用户的(虚拟)收听位置。这允许空间转换在响应于场景内的用户和/或音频对象的位置变化而更新渲染的方面更高效,并且能够将所转换的集群作为单个空间实体(即,空间音频对象)灵活操纵。可以使用若干种方法来生成空间上缩混的空间对象。

[0072]

2-1.转换为hoa空间音频对象

[0073]

在一个实施例中,可以将在步骤s152中标识的单独音频对象集群相对于集群内的参考位置在空间上转换为单个球面谐波(hoa)表示。可以使用任何已知的方法来导出球面谐波表示。

[0074]

导出球面谐波表示的一种方法是将单独音频对象的源场直接扩展为它们在参考位置处的球面谐波表示,并然后对它们的对应球面谐波系数求和。参考位置处的球面谐波扩展由于点源位于而是:

[0075][0076]

其中,s(ω)是源信号,并且k=ω/c是波数。

[0077]

同时,参考位置处声场的球面谐波分解的一般表达式是:

[0078][0079]

其中,是处声场的球面谐波系数。上面所公开的两个表达式在以下文献中进行了描述,m.poletti,“three-dimensional surround sound systems based on spherical harmonics”,j.audio.eng.soc.53(11),2005。

[0080]

使上述两个表达式相等,由于源位置处的点源而产生的声场的球面谐波系数由以下给出:

[0081][0082]

表示参考位置处由于l个对象产生的总声场的球面谐波系数集然后从对相应系数求和得出:

[0083][0084]

参考位置处由于l个单独对象的总压力pl然后由下式给出:

[0085][0086]

在实际实现中,系数集可以在最大阶数n处被截断,该最大阶数n取决于所得空间音频对象的期望空间分辨率(即,想要保留原始对象的空间分布的多少空间细节)。对于三维球面谐波表示,这会产生每个频率仓(bin)的(n 1)2个系数。如果采用具有索引i从1运行到(n十1)2的球面谐波分量的单个索引,则表示由l个对象引起的总声场的截断球面谐波系数集可以用矩阵表示法写成其中是包含l个对象源信号的源信号向量s1(ω),a是单独源对象的源信号归一化球面谐波系数的(n 1)2×

l矩阵,并且是包含所得(n 1)2个系数(所有频率为ω)的向量。

[0087]

单独对象集群到单个球面谐波表示的空间转换可以被解释并实现为对原始对象源信号的滤波操作,其中,滤波器完全由对象的位置定义。

[0088]

在空间音频对象的所得空间分辨率足以与常规立体声录音相媲美的用例中,则最大阶数n可以设置为1,在这种情况下,每个频率仓存在4个系数。这意味着只要集群中存在超过4个对象,就可以实现降低的复杂度(随着对象的数量的增加,复杂度降低),而对象集群的最重要的空间性质仍然保留。

[0089]

在期望更准确地保留集群的原始空间性质的用例中,可以选择n的更高值,从而导致例如对于n=3每个频率仓16个系数。

[0090]

注意,如果最大阶数n设置为0,则每个单独对象的每个频率仓仅存在一个系数,其由下式给出(使用球面汉克尔函数和球面谐波函数的零阶性质):

[0091][0092]

参考位置处由于l个单独源对象引起的总压力然后从下式得出(使用球面贝塞尔函数和球面谐波函数的零阶性质):

[0093][0094]

从这个方程可以得出这样的结论,零阶转换所得的表示是与位置无关的压力,该压力是坐标系的原点处各个压力的简单相加。因此,如果参考位置被选择为原点,则零阶转换的结果实际上是所有单独源对象相对于参考位置的单声道缩混。

[0095]

球面谐波表示的最大阶数可以(动态地)适配于要缩混的音频对象集群的空间复

杂度和/或系统能力(例如,关于传输带宽、渲染器能力、可用处理资源等)。

[0096]

可以在将对象集群转换为球面谐波表示时完成最大阶数的这种适配。附加地或备选地,通过将该表示截断到该较低阶数(例如,以(临时)削减处理要求),渲染器可以决定使用比转换中所使用的最大阶数低的最大阶数来渲染球面谐波表示。因此,即使将集群转换为较高阶球面谐波表示,渲染器也可以选择仅使用前几个谐波。

[0097]

经由包括源字段扩展中的球面汉克尔函数hn,上述空间转换考虑单独对象到参考位置的距离。

[0098]

由于这个球面汉克尔函数的实时评估成本有些高,因此在某些用例中,推导出上述表达式的成本较低的近似值可能很有吸引力,尽管应该认识到,当单独源的位置在集群内改变时,仅需要对该函数进行评估(当听者的位置改变时,或者当对象集群在场景中作为单元被平移或旋转时,不需要评估)。

[0099]

如果仍然期望,可以通过假设单独对象远离参考位置来获得实施例的简化版本,从而导致每个单独音频对象的源场由平面波而不是球面波来近似。在这种情况下,单独对象的所得球面谐波系数的表达式简化为:

[0100][0101]

这种近似的不期望效果是丢失了由于单独对象的不同距离引起的相对增益和相位信息。在参考位置处,可以通过添加缩放项和相位项来恢复该信息,该缩放项和相位项是从单独对象到参考位置的距离的函数,根据下式:

[0102][0103]

其中,rs是对象到参考位置的距离,并且φ(ω)是频率为ω时的相对相位,其是距离rs的直接函数。这种校正后的简化表示在参考位置处是正确的,但在其他位置处并不完全正确。这不是一个真正的问题,因为主要焦点是参考位置的表示。

[0104]

本领域的技术人员将知道如何针对集群中的所有对象位于同一2d平面内的二维情况导出如上所提供的类似方程。在这种情况下,对于集群的n阶表示,仅需(2n 1)个系数,使得例如3阶表示仅需要7个系数。

[0105]

因此,在2d情况下,可以使用更少的系数(与3d相比)获得期望空间分辨率,使得球面谐波表示在集群中的较少数量的对象处已经高效(或者,等价地,给定数量的系数导致更高的空间分辨率)。

[0106]

用于由于任意数量的单独音频对象而在参考位置获得总球面谐波表示的另一种方法是从以参考位置为中心的虚拟hoa麦克风设置的信号导出总球面谐波系数,例如,如以下文献中所描述的,m.poletti,“three-dimensional surround sound systems based on spherical harmonics”,j.audio.eng.soc.53(11),2005以及j.meyer&g.elko,“a highly scalable spherical microphone array based on orthonormal decomposition of the sound field”,proc.ieee int-conf.on acoustics,speech and signal processing,vol.2.,2002。本质上,这意味着在参考位置周围的(通常)球面表面上对由于所有点源产生的声场进行采样,之后在球体的原点(即,参考位置)处将所采样的声场转换为球面谐波系数。数学上与上述直接扩展方法有些不同,但本领域技术人员将意识到所得表示本质上是

相同的。

[0107]

对于空间转换,从本实施例得到的空间音频对象表示的一些优点是:(1)它完全独立于任何收听位置(与现有技术解决方案形成鲜明对比),因此无论用户位置如何变化,它都保持有效;(2)这也意味着同一表示可以用于位于不同位置处的多个听者;(3)它从集群中沿着所有方向的单独源对象平等地捕获空间信息,包括它们的距离信息(如果使用实施例的非简化版本)在内;(4)它实际上是一个独立空间实体,该独立空间实体可以在场景中作为单个单元移动(平移和旋转),而不需要对该表示进行任何改变;(5)如果集群内对象的相对位置改变,则滤波器矩阵可以容易地被更新以反映变化。

[0108]

该实施例可能合适的用例的示例是位于该场景中某个有界区域的人群、舞台上的音乐家乐队、合唱团等。

[0109]

2-2.使用虚拟麦克风配置进行转换

[0110]

用于在空间上将音频对象集群缩混成单个空间音频对象的另一实施例使用位于音频对象集群内的参考位置处的虚拟麦克风设置。

[0111]

图3示出了位于单独音频对象302集群内的示例性虚拟麦克风设置300。如图3所示,虚拟麦克风设置300的参考位置可以是集群内的中心位置(例如,集群的几何质心)。

[0112]

使用集群中的单独音频对象302的元数据(例如,位置元数据和/或增益元数据),对象302可以被缩混到虚拟麦克风设置,从而产生虚拟麦克风信号,就好像对象的声音由虚拟麦克风设置记录。

[0113]

虚拟麦克风设置可以是二维(2d)或三维(3d)虚拟麦克风阵列。具体地,虚拟麦克风阵列可以是虚拟立体声麦克风设置的在正交方向上的虚拟交叉阵列。虚拟麦克风阵列可以产生多个缩混信号,具体地,表示在正交方向上的虚拟立体声麦克风的立体声缩混信号。在一些实施例中,可以使用备选的虚拟麦克风阵列(例如,球面或四面体阵列)并且可以使用已知技术从这些虚拟麦克风阵列中导出正交立体声缩混信号。

[0114]

与在虚拟扬声器配置上使用某种形式的预渲染的技术相比,该实施例提供了空间缩混独立于用户位置的优点。这意味着当用户位置在场景内改变时不需要重新进行空间缩混,这与每当用户位置改变时需要新的空间缩混的其他解决方案相反。

[0115]

当对象集群在场景内作为一个整体移动或旋转时,存在同样的优点,因为这种变化可以被视为相当于用户位置相对于集群的变化。

[0116]

虚拟麦克风设置可以是单个虚拟立体声麦克风设置并且空间缩混可以是单个立体声缩混。因此,复合空间音频对象的所得表示可以是立体声信号加上对应的元数据,其中元数据至少包括虚拟麦克风设置的参考位置(例如,虚拟麦克风之间的中点的坐标),例如,如参考文献[7]中所述。在这种情况下,应选择单个虚拟立体声麦克风设置的参考取向,使得该参考取向表示体验该场景的用户的最常见(例如,默认)的观察方向。

[0117]

与使用2d或3d虚拟麦克风阵列相比,这种简化在一定程度上限制了使缩混集群的空间渲染适配用户位置变化的灵活性。但是,在许多用例中,它可以提供高度降低的复杂度和合理保留原始单独对象集群的主要空间性质的有吸引力的组合。

[0118]

参考文献[7]描述了允许适配该实施例的单个虚拟立体声麦克风信号的空间渲染,使得仍然可以获得对用户位置变化的合理适配。

[0119]

当使用这些方法时,根据该实施例的空间缩混表示具有第一实施例(即hoa空间对

象实施例)所提供的一些相同优点(例如,基本上独立于收听位置并且适合于不同位置的多个听者)。

[0120]

为了在空间缩混中适当地保持集群内对象的相对增益,可以将权重应用于单独对象,该权重补偿它们到虚拟麦克风设置的参考位置的相应距离。在使用定向(例如,心形)虚拟麦克风的情况下,这些权重也可以对此进行补偿。

[0121]

这在图3中进行了示出,图3是图2中指示的所选对象集群的缩放。在图3中,用于生成空间缩混的空间对象的虚拟麦克风阵列设置被放置在集群内。

[0122]

如果与单独音频对象1、2和3相关联的增益(在对象元数据中指示)为g1、g2和g3,由于三个对象到虚拟麦克风设置的距离不同,所得空间缩混信号中的这三个对象的信号电平之间的关系被以不适当的方式修改。例如,如果对象1比对象2更靠近虚拟麦克风设置,则在所得缩混中它将更响亮。类似地,如果对象2比对象3更靠近虚拟麦克风设置,则对象2将比对象3更响亮,该对象3位于距三个对象的麦克风最远距离处。为了反映这种差异,可以将补偿增益应用于空间缩混过程中的对象。具体地,如果从对象到虚拟麦克风设置的名义中心的距离分别为d1、d2和d3,则与这些距离成反比的补偿增益可以应用于缩混。

[0123]

类似补偿增益可以应用于补偿由不均匀的虚拟麦克风方向性图案导致的电平平衡修改。

[0124]

2-3.使用平移技术生成空间缩混

[0125]

在另一实施例中,例如通过空间缩混的声道之间的每个单独音频对象的单声道信号的强度平移,集群中包括的音频对象被直接放置在缩混的空间轴(例如,左右轴、前后轴和上下轴)上。

[0126]

给定集群内的参考位置和空间缩混的参考空间轴,根据所选集群中的音频对象在轴上相对于参考位置的相应投射位置沿着每个轴平移它们,如图4所示。在平移中,保留单独音频对象的增益。因此,该实施例消除了对第二步骤(即,步骤s154)的第二实施例中所需的补偿增益的需要。

[0127]

为了能够在任何收听位置渲染具有正确空间范围的缩混空间音频对象,为任何缩混对象找到的最大投射距离的值可以作为元数据被包括在缩混集群中,并将在渲染中用作参考。在图4所示的示例中,最大投射距离对应于“l”的值。

[0128]

为了有效利用缩混信号的信息容量,可以进行平移,使得到参考位置的最大投射距离的音频对象总是被平移到缩混信号的最左或最右(或分别最上/最下、最前/最后)侧,这取决于它在哪一侧。换言之,平移函数被归一化。如上所述,由于空间范围信息被包括在空间音频对象中,因此可以从已经以这种方式被归一化的缩混重构“正确的”空间范围。

[0129]

在该实施例的进一步改进中,可以针对轴的每一侧(即,左右、上下、前后)分别进行平移的归一化,以最大限度地利用立体声缩混信号的信息容量在这种情况下,缩混信号的两侧的最大投射距离的值(在示例中为“l”和“r”的值)将作为元数据被包括在缩混空间音频对象中。

[0130]

2-4.使用外部球面谐波扩展进行转换

[0131]

在执行空间转换过程的第一实施例中,将所选音频对象转换为hoa空间音频对象导致球面谐波表示,其描述了在集群内的参考位置处的单独音频对象的传入声场,就好像参考位置处的虚拟hoa麦克风已经记录了该声场。

[0132]

然而,原则上,该表示仅在参考位置周围的特定体积内有效。这意味着需要附加转换步骤来最终将所得空间音频对象渲染给位于该体积之外的任意位置的听者。例如参考文献[6]中描述了从内部hoa表示到外部有效空间表示的这种转换的示例。

[0133]

如参考文献[10]中所述,互补的外部球面谐波表示可以描述位于球体内部的一个或多个声源的传出声场,在该球体的表面处(虚拟地)对声场进行采样。所得表示原则上仅在球形采样体积之外有效。

[0134]

在该表示中将单独音频对象转换为空间音频对象的优点在于,它可以直接用于将所得空间音频对象渲染给位于任意外部收听位置的听者,而无需在hoa空间音频对象的情况下所需的附加转换。

[0135]

3.第三步骤(步骤s156):将空间缩混音频对象集群(即,复合空间音频对象)(双耳)渲染给用户

[0136]

通过使用作为复合空间音频对象的表示的一部分的元数据(例如,位置元数据和/或空间范围元数据),可以将复合空间音频对象渲染为位于空间中所定义的虚拟位置并具有所定义的空间范围。复合空间音频对象的虚拟位置可以以绝对术语(即,相对于虚拟场景的坐标系)或相对于用户的位置来定义。

[0137]

在一个实施例中,复合空间音频对象的虚拟位置与转换步骤中所使用的参考位置相同(例如,转换为球面谐波表示的参考点或用于生成空间缩混的虚拟麦克风阵列设置的参考位置)。

[0138]

渲染可以是通过耳机的双耳渲染。

[0139]

在所生成的复合空间音频对象具有球面谐波(hoa)表示的情况下,存在将空间音频对象渲染给位于由空间音频对象表示的对象集群外部某处的听者的不同方法,例如,如参考文献[6]中所述。

[0140]

在所生成的复合空间音频对象由(例如,由步骤s154的第二实施例和第三实施例生成的)一个或多个立体声音频信号和元数据组成的情况下,可能存在渲染该特定类型的空间音频对象的不同方法,例如,如参考文献[7]中所述。

[0141]

将所选音频对象的集合表示为空间音频对象的一个优点是,它允许在渲染步骤中对作为单个空间实体的空间音频对象进行各种高效类型的操作。例如,可以将空间加宽技术应用于空间音频对象以改变其感知的空间范围。可以使用的这种空间扩展技术的示例在参考文献[7]中进行了描述。

[0142]

这种空间扩展技术也可以用于以非常高效的方式使渲染适配场景配置的变化(例如,当用户更接近空间音频对象时)。此外,它可以向内容创建者提供一种新的、非常高效且易于使用的艺术工具,用于在场景中控制复杂空间音频元素的空间范围。

[0143]

通过将所选音频对象集群表示为复合空间音频对象来启用的进一步渲染阶段操纵包括改变空间音频对象的位置、取向、增益和/或频率包络。

[0144]

如上所述,根据一些实施例渲染音频对象集群的方法能够在多用户场景中实现更高效且更灵活的渲染,其中,多个用户同时正在体验相同的虚拟场景,可能还知道彼此在场景内的存在。在这种用例中,通常可以使用相同的空间音频对象向所有用户高效地渲染所选音频对象的空间集群,而在渲染步骤中仅需要进行较小的适配以优化每个单独用户的渲染。

[0145]

4.在源侧(也称为编码器侧)与渲染器侧(也称为解码器侧或用户侧)之间分配第一步骤(步骤s152-集群选择步骤)和第二步骤(步骤s154-空间转换步骤)。

[0146]

可以在编码器侧或解码器侧执行第一步骤(即,形成集群的步骤)。类似地,只要在第一步骤之后执行第二步骤(即,当在解码器侧执行第一步骤时,不能在编码器侧执行第二步骤),就可以在编码器侧或解码器侧执行第二步骤(即,将所选音频对象集群转换为复合空间音频对象的步骤)。

[0147]

可以设想在编码器侧和解码器侧之间分配第一步骤和第二步骤的各种配置,并且每种配置具有可能对不同类型的用例特别感兴趣的特定特征。

[0148]

在图5a所示的配置中,在编码器侧(其可以包括实际的编码器、内容创作应用和/或游戏引擎)执行第一步骤和第二步骤两者。在一个实施例中,在编码器侧执行第一步骤和第二步骤,而无需解码器侧的任何参与(即,编码器侧独立于解码器侧执行这些步骤)。让编码器侧执行第一步骤和第二步骤的优点在于,它通常导致要传输到解码器侧并在解码器侧被渲染的较少(少得多的)音频数据(即,更少的音频信号)。

[0149]

在编码器侧执行的音频对象的聚类可以是静态的,或者可以是动态的,这取决于源自编码器侧的场景复合的变化(例如,作为内容创作过程的结果)。

[0150]

图5b示出了另一种配置,其中解码器侧系统向编码器侧系统发送指导在编码器侧执行的集群选择和空间转换的信息。图5b所示的配置尤其是在实时单播流传输场景中有用。

[0151]

在一个示例中,解码器侧系统向编码器侧系统发送关于可用于音频对象渲染的计算资源量的信息、关于解码器侧系统当前可以渲染的音频对象或音频信号的最大数量的信息、和/或关于需要应用的聚类数量的信息。然后,编码器侧系统使用从解码器侧接收到的信息来执行适当的聚类和空间转换。与图5a所示的配置相比,图5b所示的配置提供了这样的附加优点,即在编码器侧执行的第一步骤(即,聚类)和第二步骤(即,转换)可以适配于解码器侧系统的状况(静态或动态)。

[0152]

在另一示例中,解码器侧系统向编码器侧系统发送关于源自解码器侧(例如,作为用户交互的结果)的场景复合的变化的信息,并且可以取决于场景复合的变化来动态改变编码器侧的聚类。

[0153]

图5c示出了在编码器侧系统执行聚类而在解码器侧系统执行转换的配置。在图5c所示的配置中,编码器侧系统插入到提供给解码侧元数据的比特流中,该解码侧元数据通知解码器侧系统:如果需要或期望,哪些对象可以被组合以用于渲染。这种对象可以例如在比特流中用公共标识符来标记,该公共标识符附加到已经被选择为属于同一集群的所有单独对象。例如,在一个实施例中,集群中包括的每个音频对象包括元数据(例如,《objectsource》数据结构),并且对于集群中包括的每个音频对象,音频对象的元数据数据被修改为包括标识该集群的集群标识符。

[0154]

图5c所示的配置提供了允许渲染器根据需要配置并适配聚类和/或转换的优点(例如,响应于可用计算资源的本地变化或音频场景复杂度(例如,场景中活跃的对象和其他音频元素的数量)的变化)。在一对多流传输场景中,这允许每个单独渲染器系统独立优化其渲染,同时仍然使用公共比特流中包含的公共聚类信息。

[0155]

如上所述,在一些实施例中,在解码器侧执行聚类和转换两者。该实施例的优点在

于,不需要改变编码器侧系统或传输格式,并且渲染器可以完全控制整个过程。

[0156]

图6示出了这样的配置,其中,在编码器侧系统与解码器侧系统之间提供中间网络节点,并且网络节点执行聚类和/或转换。让中间网络节点执行聚类和/或转换的原因之一是,在一些情况下,解码器侧系统与编码器侧系统之间的延迟可能太大以致无法基于关于从解码器侧接收到的用户交互的信息在编码器侧上执行动态集群选择和空间转换。

[0157]

可以选择中间节点使得其在物理上更靠近解码器侧,以减少延迟。中间节点可以是放置在与用户相同的区域中的服务器(例如,移动边缘节点)。一个编码器侧系统可以服务于若干个中间节点,而这些中间节点继而可以服务于一个或若干个解码器侧系统。在一些情况下,相同的对象选择和相同的空间转换可以被若干个客户端重复使用,因此减少了预渲染所需的总工作量。

[0158]

5.复合空间音频对象的元数据

[0159]

在一些实施例中,集群中包括的每个音频对象包括音频信号(例如,单声道音频信号)和对应的元数据,该对应的元数据包括指示音频对象在xr场景中的位置的位置信息。元数据可以包括其他信息,例如增益信息。基于集群的转换所形成的复合空间音频对象包括多个音频信号和对应的元数据。在一个实施例中,复合空间音频对象的元数据包括标识复合空间音频对象在xr场景中的位置的位置信息、以及标识复合空间音频对象的空间范围的空间范围信息。

[0160]

复合空间音频对象的空间范围是对复合空间音频对象在至少一个维度上的大小或形状的描述。由于复合空间音频对象的表示以源为中心,因此也可以以源为中心的方式来定义(例如,根据集群中包括的两个音频对象之间在一维或多个维上的最大距离来指定)空间范围。备选地,空间范围可以根据相对于与听者无关的参考位置(例如,场景坐标系的原点)的角度宽度来指定,或者可以例如通过顶点集指定为网格结构。

[0161]

5-1.复合空间音频对象的位置

[0162]

复合空间音频对象的位置可以是形成复合空间音频对象的集群的几何中心(例如,质心)。集群的几何中心可以至少使用单独音频对象的位置来导出(它也可以使用单独音频对象的增益来导出)。可以用于查找音频对象集群的几何中心的算法的示例在位于en.wikipedia.org/wiki/centroid的网页中进行了描述。

[0163]

在一些实施例中,从集群中包括的单独音频对象的位置(或其每个位置由每个音频对象的增益加权的位置)的算术平均值导出复合空间音频对象的位置。在使用单独音频对象的加权位置来导出复合空间音频对象的位置的情况下,所导出位置类似于位于en.wikipedia.org/wiki/center_of_mass的网页中所描述的“质量的中心”概念。

[0164]

可以以不同方式导出复合空间音频对象的位置。例如,可以通过拟合在集群中包括所选音频对象的最小球体或正多边形(或具有中心的其他形式)来导出位置。在这种情况下,所拟合球体或多边形的中心可以对应于该位置。

[0165]

5-2.复合空间音频对象的空间范围

[0166]

在一个实施例中,可以通过在三个(或两个、或一个)空间维度中的每个空间维度上找到集群中包括的任何两个对象之间的最大距离来导出复合空间音频对象的空间范围。例如,可以绘制包括所有单独音频对象的最小鞋盒形状、矩形(在2d中)或线(在1d中),其中该形状的大小沿着参考坐标系的维度取向。在这种情况下,空间范围可以由表示形状在不

同维度上的大小的三个(或两个、或一个)数字来定义。

[0167]

在该实施例的改进版本中,可以确定包括所有单独音频对象的绝对最小的鞋盒形状(或矩形,或线),其中该形状的3d取向作为附加自由度。用于找到最小鞋盒形状的优化算法是广泛可用的,并且所拟合盒子相对于场景坐标系的取向可以被包括为复合空间音频对象的空间范围元数据的一部分。

[0168]

在其他实施例中,通过拟合包括集群中所包括的所有单独音频对象的最小球体来导出复合空间音频对象的空间范围。该球体可以以(如上所述导出的)复合空间音频对象的位置为中心,并且该球体的半径可以由位于距该位置最大距离处的单独音频对象确定。这样,复合空间音频对象的空间范围将围绕该位置对称,并完全由球体的半径指定。

[0169]

在其他实施例中,通过找到包括集群中所包括的所有单独音频对象的绝对最小可能球体来导出复合空间音频对象的空间范围,其中所拟合球体的中心不一定与复合空间音频对象的位置相同。以这种方式找到的球体将小于以该位置为中心的最小球体的大小,或具有与以该位置为中心的最小球体相同的大小。在该实施例中,复合空间音频对象的空间范围由所拟合球体的半径和中心位置来定义和指定。

[0170]

在其他实施例中,可以使用包括集群中所包括的所有单独音频对象的最小椭球体。在该实施例中,复合空间音频对象的空间范围由(i)椭球体沿着三个轴的大小和(ii)它的主轴的取向来定义和指定。椭球体可以以复合空间音频对象的位置为中心。备选地,可以拟合绝对最小椭球体,在这种情况下,所拟合椭球体的中心位置被包括为空间范围元数据的一部分。

[0171]

即使圆形和椭球体用作用于确定复合空间音频对象的空间范围的示例性几何形状,也可以使用任何其他形状(例如,圆柱)。例如,包括集群中所包括的所有单独音频对象的最小简单多边形形状可以用于确定空间范围。在这种情况下,空间范围可以被定义为网格结构,其通常在元数据中被指定为顶点集。

[0172]

在上述方法中,所导出空间范围形状相对于复合空间音频对象的所导出位置的位置可以针对每个维度被指定为(并且包括在元数据中)相对于该位置的偏移量。

[0173]

5-3.元数据的示例

[0174]

《对象源》

[0175]

该元数据可以用于描述单独音频对象的特性以及复合空间音频对象的特性。音频对象(单独音频对象或复合空间音频对象)的元数据可以包括各种属性(例如,“id”、“位置”和/或增益)。属性“id”标识单独音频对象或复合空间音频对象。属性“位置”标识音频对象的位置。“增益”属性标识音频对象的增益。在一些实施例中,单独音频对象的元数据还可以包括标识单独对象所属的集群(如果有的话)的“clusterid”属性。在一些实施例中,复合空间音频对象的元数据还可以包括标识复合空间音频对象的(如上所述)空间范围的“范围”属性,其以上述任何方式指定。

[0176]

《hoa源》

[0177]

该元数据可用于描述由球面谐波表示所表示的复合空间音频对象。元数据可以包括各种属性(例如,“位置”、“范围”、“表示”和“过渡距离(transitiondistance)”)。“位置”和“范围”属性可以再次对应于复合空间对象的位置和范围。属性“表示”定义该表示是来自位于空间采样区域外部(内部表示)的源还是来自空间采样区域内部(外部表示)的源。属性“过渡距离”确定其中听者在外部表示与内部表示之间过渡的区域。

[0178]

6.示例实现

[0179]

图7示出了用于为xr场景产生声音的示例系统700。系统700包括控制器701、用于修改音频信号751和752的信号修改器702、左扬声器704和右扬声器705。虽然图7中示出了两个音频信号和两个扬声器,但这仅是为了说明的目的,并且不以任何方式限制本公开的实施例。

[0180]

控制器701可以被配置为接收一个或多个参数并且触发修改器702和703以基于接收到的参数对左音频信号751和右音频信号752执行修改(例如,增加或减少音量水平)。接收到的参数是(1)关于听者的位置(例如,到音频源的方向和距离)的信息753和(2)关于音频源的元数据754,如上所述。

[0181]

在本公开的一些实施例中,信息753可以从图8a所示的xr系统800中包括的一个或多个传感器提供。如图8a所示,xr系统800被配置为由用户佩戴。如图8b所示,xr系统800可以包括取向感测单元801、位置感测单元802、以及与系统800的控制器851耦接的处理单元803。取向感测单元801被配置为检测听者的取向的变化,并将关于检测到的变化的信息提供给处理单元803。在一些实施例中,在给定由取向感测单元801检测到的取向的检测变化的情况下,处理单元803确定绝对取向(相对于某个坐标系)。也可能存在用于确定取向和位置的不同系统,例如,使用灯塔跟踪器(激光雷达)的系统。在一个实施例中,在给定取向的检测变化的情况下,取向感测单元801可以确定绝对取向(相对于某个坐标系)。在这种情况下,处理单元803可以简单地复用来自取向感测单元801的绝对取向数据和来自位置感测单元802的绝对位置数据。在一些实施例中,取向感测单元801可以包括一个或多个加速度计和/或一个或多个陀螺仪。

[0182]

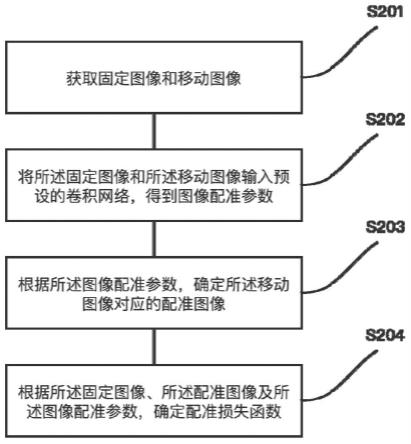

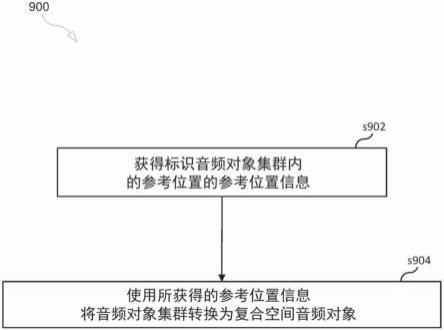

图9是示出了用于表示音频对象集群的过程900的流程图。流程900可以从步骤s902开始。

[0183]

步骤s902包括获得标识音频对象集群内的参考位置的参考位置信息。

[0184]

步骤s904包括使用所获得的参考位置信息将音频对象集群转换为复合空间音频对象。可以独立于任何用户的任何收听位置来执行将音频对象集群转换为复合空间音频对象。

[0185]

在一些实施例中,复合空间音频对象表示音频对象集群,并保存音频对象集群中包括的音频对象的相对空间定位信息。

[0186]

在一些实施例中,过程900还包括:对于音频对象集群中包括的每个音频对象,获得该音频对象的音频对象元数据,并基于所获得的音频对象元数据来生成该复合空间音频对象的音频对象元数据。

[0187]

在一些实施例中,使用音频对象集群中包括的每个音频对象的所获得的音频对象元数据来获得参考位置信息。

[0188]

在一些实施例中,复合空间音频对象的元数据包括标识复合空间音频对象的位置的位置信息、和/或标识复合空间音频对象的空间范围的空间范围信息。

[0189]

在一些实施例中,复合空间音频对象的空间范围包括音频对象集群的维度、和/或音频对象集群内的两个最外面的音频对象之间的距离。

[0190]

在一些实施例中,复合空间音频对象的位置是参考位置。

[0191]

在一些实施例中,参考位置是音频对象集群的几何中心。

[0192]

在一些实施例中,过程900还包括从m个音频对象的集合中标识音频对象集群。音频对象集群可以由n个音频对象组成,其中,n小于或等于m。

[0193]

在一些实施例中,标识音频对象集群由第一设备来执行,并且将音频对象集群转换为复合空间音频对象由第二设备来执行。该方法还可以包括将用于标识音频对象集群中包括的音频对象的信息从第一设备发送给第二设备。

[0194]

在一些实施例中,将用于标识音频对象集群中包括的音频对象的信息从第一设备发送给第二设备包括将i)音频对象集群中包括的第一音频对象的第一音频对象元数据和ii)音频对象集群中包括的第二音频对象的第二音频对象元数据从第一设备发送给第二设备。第一音频对象元数据可以包括标识音频对象集群的集群标识符(例如,clusterid=1),并且第二音频对象元数据也包括集群标识符(即,clusterid=1),从而指示两个音频对象是同一集群的成员。

[0195]

在一些实施例中,从m个音频对象的集合中标识音频对象集群包括确定m个音频对象的集合中包括的第一音频对象与m个音频对象的集合中包括的第二音频对象之间的距离,并且如果所确定的距离小于阈值距离,则包括音频对象集群中的第一音频对象和第二音频对象。

[0196]

在一些实施例中,从m个音频对象的集合中标识音频对象集群是基于(1)关于解码器处可用的计算资源的信息或(2)场景变化信息中的至少一种。

[0197]

在一些实施例中,音频对象集群由o个音频对象组成,o个音频对象中的每一个与单个音频信号相关联,并且复合空间音频对象与不超过p个音频信号相关联,其中,p小于o。

[0198]

在一些实施例中,复合空间音频对象是音频对象集群的球面谐波表示。

[0199]

在一些实施例中,复合空间音频对象是音频对象集群的多声道立体声表示。

[0200]

在一些实施例中,将音频对象集群转换为复合空间音频对象包括使用位于参考位置的虚拟麦克风阵列或虚拟麦克风在空间上转换音频对象。

[0201]

在一些实施例中,过程900还可包括使用标识复合空间音频对象的位置的位置信息和/或标识复合空间音频对象的空间范围的空间范围信息来渲染复合空间音频对象。

[0202]

图10是根据一些实施例的用于执行本文公开的方法的装置1000的框图。上面讨论的编码器、解码器和网络节点中的任何一种可以使用装置1000来实现。如图10所示,装置1000可以包括:处理电路(pc)1002,该处理电路(pc)1002可以包括一个或多个处理器(p)1055(例如,通用微处理器和/或一个或多个其他处理器,例如专用集成电路(asic)、现场可编程门阵列(fpga)等),这些处理器可以共置于单个外壳或单个数据中心中,或者可以在地理上分布(即,装置1000可以是分布式计算装置);至少一个网络接口1048,该网络接口1048包括发射器(tx)1045和接收器(rx)1047,用于使装置1000能够向连接到网络110(例如,互联网协议(ip)网络)的其他节点发送数据以及从其接收数据,网络接口1048(直接地或间接地)连接到该网络110(例如,网络接口1048可以无线连接到网络110,在这种情况下,网络接口1048连接到天线布置);以及存储单元(又名“数据存储系统”)1008,其可以包括一个或多个非易失性存储设备和/或一个或多个易失性存储设备。在pc 1002包括可编程处理器的实施例中,可以提供计算机程序产品(cpp)1041。cpp 1041包括存储计算机程序(cp)1043的计算机可读介质(crm)1042,该计算机程序(cp)1043包括计算机可读指令(cri)1044。crm1042

可以是非暂时性计算机可读介质,例如磁介质(例如,硬盘)、光学介质、存储器设备(例如,随机存取存储器、闪存)等。在一些实施例中,计算机程序1043的cri1044被配置为使得当由pc1002执行时,cri使装置1000执行本文所描述的步骤(例如,本文参考流程图描述的步骤)。在其他实施例中,装置1000可被配置为在不需要代码的情况下执行本文所描述的步骤。即,例如,pc1002可以仅由一个或多个asic组成。因此,本文描述的实施例的特征可以以硬件和/或软件方式来实现。

[0203]

尽管本文描述了各种实施例,但应当理解,它们仅以示例而非限制的方式提出。因此,本公开的广度和范围不应受到上述示例性实施例中任何一个的限制。此外,上述要素以其所有可能变型进行的任意组合都涵盖在本公开中,除非另有指示或以其他方式和上下文明确冲突。

[0204]

附加地,尽管上文描述并附图中示出的处理被示为一系列步骤,但其仅用于说明目的。因此,可以想到可增加一些步骤、可省略一些步骤,可重排步骤顺序,以及可并行执行一些步骤。

[0205]

参考文献

[0206]

[1]iso/iec23008-3:2019,“information technology-high efficiencycoding and media delivery in heterogeneous environments-part3:3d audio”。

[0207]

[2]en.wikipedia.org/wiki/cluster_analysis

[0208]

[3]us patent 9961475。

[0209]

[4]s.miyabe et al.,

‘

temporal quantization of spatial information using directional clustering for multichannel audio coding’,2009ieee workshop on applications of signal processing to audio and acoustics。

[0210]

[5]us9805725,“object clustering for rendering object-based audio content based on perceptual criteria”[0211]

[6]international patent application no.pct/ep2019/086876(attorney docket no.p76779)。

[0212]

[7]international patent application no.pct/ep2019/086877(attorney docket no.p76758)。

[0213]

[8]m.poletti,“three-dimensional surround sound systems based on spherical harmonics”,j.audio.eng.soc.53(11),2005。

[0214]

[9]j.meyer&g.elko,“a highly scalable spherical microphone array based on orthonormal decomposition of the sound field”,proc.ieee int-conf.on acoustics,speech and signal processing,vol.2.,2002。

[0215]

[10]j.daniel et al.,“further investigations of high order ambisonics and wavefield synthesisfor holophonic sound imaging”,aes convention paper 5788,2003。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。