1.本发明涉及一种视觉-语言跨模态学习技术领域,尤其涉及一种基于模态定制协同注意力交互的时序语言定位方法及装置。

背景技术:

2.随着多媒体和网络技术的迅猛发展,海量的视频数据呈现快速的几何式增长,时序行为定位已成为视频理解领域一个重要且亟待解决的问题。基于视觉单模态的时序行为定位任务预定义有限数量的行为类别,然而,在真实的开放环境中行为复杂多样,预定义的行为集合难以满足开放环境的需要。因此,有学者于2017年提出时序语言定位任务,该任务以一种非常自然的方式满足开放环境下目标视频片段时序定位的需要。时序语言定位任务给定视频中某时序片段的相应文本描述作为查询,对视频中该时序片段的起始和结束时间点进行定位。鉴于时序语言定位技术在智能视频监控、海量短视频内容检索与生产以及人机交互等领域具有广阔的应用前景,该技术在工业界和学术界均已引起广泛关注。

3.由于异构的视频模态和文本模态之间存在显著的语义鸿沟,如何有效实现该两种模态的跨模态语义对齐是时序语言定位任务的核心难点和挑战。现有时序语言定位方法在算法框架上主要分为四个模块,即视频编码模块、查询编码模块、跨模态交互模块以及定位模块。根据定位模块,现有时序语言定位方法主要分为基于候选提名的方法、免候选提名的方法以及基于强化学习的方法。目前主流的基于候选提名的方法采用端到端的方式预测各预定义候选片段的置信度;免候选提名的方法包含两种子类,其中,第一子类方法为直接预测各帧作为目标片段起始(或结束)时间点的概率分布,第二子类方法对目标视频片段的时序位置进行直接回归,本发明所设计的定位模块属于该第二子类;基于强化学习的方法将时序语言定位任务建模为序列决策问题。

4.近期各类跨模态对齐问题广泛采用两种类型的跨模态transformer架构,分别为配备合并注意力(merged attention)的transformer架构和配备协同注意力(co-attention)的transformer架构。考虑到配备合并注意力的标准transformer架构对不同模态序列表征进行统一输入和无差异跨模态建模,目前一些时序语言定位方法对配备合并注意力的标准transformer架构进行参数解耦,提升跨模态语义对齐精度。然而,针对时序语言定位任务目前尚未有方法尝试采用配备协同注意力的transformer架构。此外,目前流行的视觉-语言transformer架构初始为多模态预训练任务设计,多模态预训练任务一般收集成对的已剪辑视频片段和相应已语义对齐的文本描述构建训练数据集,然而,处理时序语言定位任务时若直接继承用于多模态预训练的transformer架构,没有充分考虑时序语言定位任务的特性,即时序语言定位任务的数据为成对的未剪辑长视频和语义未对齐的文本描述。

5.为此,本发明设计了一种基于模态定制协同注意力交互的时序语言定位方法及装置,用于解决上述技术问题。

技术实现要素:

6.本发明的目的在于提供一种基于模态定制协同注意力交互的时序语言定位方法及装置,解决了现有技术中如何提升视觉-语言跨模态对齐精度以及时序语言定位性能的问题。

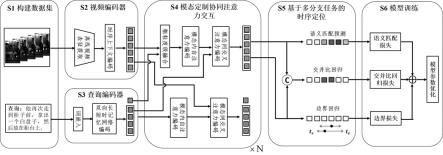

7.本发明采用的技术方案如下:一种基于模态定制协同注意力交互的时序语言定位方法,包括以下步骤:步骤s1:获取成对的未剪辑视频-文本查询数据,构建时序语言定位任务的训练数据集和测试数据集,所述训练数据集中每样本由成对的未剪辑视频-文本查询以及目标视频片段相应的起始和结束时间标注组成,所述测试数据集仅由未提供目标视频片段时间标注的成对的未剪辑视频-文本查询样本组成;步骤s2:基于所述时序语言定位任务中的每对未剪辑视频-文本查询数据,对未修剪视频通过视频编码器提取视频表征v;步骤s3:基于所述时序语言定位任务中的每对未剪辑视频-文本查询数据,对文本查询数据通过查询编码器提取单词级查询表征w和句子级查询表征qs,所述单词级查询表征w和所述句子级查询表征qs组合得到多粒度查询表征q;步骤s4:将所述视频表征v和所述多粒度查询表征q共同输入模态定制协同注意力交互模块,获取视频-文本跨模态融合后已语义对齐视频表征;步骤s5:根据跨模态融合后的已语义对齐视频表征,采用包含稠密时序边界回归、语义匹配分数预测以及交并比回归的多分支任务,分别获得每一帧处的目标片段时序边界回归值、语义匹配分数和时序交并比回归值;步骤s6:对步骤s2-步骤s5所组成的基于模态定制协同注意力交互的时序语言定位模型,利用所述训练数据集进行训练,训练所采用的损失函数由边界损失、语义匹配损失和交并比回归损失三项组成,并使用优化器进行模型参数的更新,得到训练好的基于模态定制协同注意力交互的时序语言定位模型;步骤s7:利用所述测试数据集对训练好的基于模态定制协同注意力交互的时序语言定位模型进行测试,将所得到的具有最高置信度值的目标片段时序边界回归值作为所述测试数据集的时序语言定位结果。

8.进一步地,所述步骤s2具体包括以下子步骤:步骤s21:利用视频编码器中视觉预训练模型以离线方式对未剪辑视频-文本查询数据中的未剪辑视频提取视频帧表征并均匀地采样t帧;步骤s22:将t帧视频帧表征通过视频编码器中若干配备残差连接的一维卷积块,获取序列长度为t且特征维度为d的一组视频表征;步骤s23:将所述一组视频表征通过视频编码器中若干自注意力块,构建全局上下文时序依赖建模的视频表征v。

9.进一步地,所述步骤s3具体包括以下子步骤:步骤s31:利用查询编码器中预训练词嵌入模型对未剪辑视频-文本查询数据中的文本查询数据提取每个单词相应的词嵌入向量,获取词嵌入向量序列;步骤s32:通过查询编码器中多层的双向长短时记忆网络对所述词嵌入向量序列进行上下文编码,获得总单词数为l且特征维度为d的单词级查询表征w;

步骤s33:将所述单词级查询表征中最后一个单词的前向隐状态向量和第一个单词的后向隐状态向量进行拼接,获得句子级查询表征qs;步骤s34:所述单词级查询表征w和所述句子级查询表征qs组合得到多粒度查询表征q。

10.进一步地,所述步骤s4具体为:将所述视频表征v和所述多粒度查询表征q作为模态定制协同注意力交互模块的输入,依次经过所述模态定制协同注意力交互模块中的若干层模态定制的双流协同注意力交互层进行跨模态融合,得到对应层输出的视频表征和多粒度查询表征,最后一层模态定制的双流协同注意力交互层输出的视频表征作为已语义对齐视频表征。

11.进一步地,所述模态定制的双流协同注意力交互层包括视频流的多粒度协同注意力交互和查询流的标准协同注意力交互,具体实施过程为:视频流的多粒度协同注意力交互:将前一模态定制的双流协同注意力交互层输出的视频表征和多粒度查询表征作为输入,采用哈达玛乘积将所述视频表征和所述多粒度查询表征中的句子级查询表征进行粗粒度融合,得到背景帧表征抑制的视频表征,将所述背景帧表征抑制的视频表征采用一块多头自注意力块进行模态内时序上下文建模,得到视频表征;再次将所述视频表征作为查询,将所述多粒度查询表征中的单词级查询表征作为键和值,采用一块多头交叉注意力块进行模态间的跨模态对齐;最后采用两层的前馈网络得到第层模态定制的双流协同注意力交互层的视频表征输出;查询流的标准协同注意力交互:将前一模态定制的双流协同注意力交互层输出的视频表征和多粒度查询表征作为输入,将所述多粒度查询表征采用一块多头自注意力块进行模态内时序上下文建模,得到多粒度查询表征;将所述多粒度查询表征作为查询,将所述视频表征作为键和值,采用一块多头交叉注意力块进行模态间的跨模态对齐;最后采用两层的前馈网络得到第层模态定制的双流协同注意力交互层的多粒度查询表征输出。

12.进一步地,所述步骤s5具体包括以下子步骤:步骤s51:稠密时序边界回归任务:将所述已语义对齐视频表征作为稠密时序边界回归任务的输入,采用两层的一维卷积,经过第一层一维卷积后得到稠密时序边界回归的输出表征,且最后一层一维卷积用sigmoid函数激活,在视频每一帧处稠密回归当前帧到目标视频片段的起始和结束时间点的归一化距离,获得每一帧处的目标片段时序边界回归值;步骤s52:语义匹配分数预测任务:将所述已语义对齐视频表征作为语义匹配分数预测任务的输入,采用两层的一维卷积,经过第一层一维卷积后得到语义匹配分数预测的

输出表征,且最后一层一维卷积不激活,获得每一帧处的语义匹配分数;步骤s53:时序交并比回归任务:将所述稠密时序边界回归任务的输出表征和所述语义匹配分数预测任务的输出表征沿着通道维进行拼接,得到的拼接表征作为交并比回归任务的输入,采用三层的一维卷积且最后一层用sigmoid函数激活,获得每一帧处所回归目标片段与标注目标片段的时序交并比回归值。

13.进一步地,所述步骤s6具体包括以下子步骤:步骤s61:将所述训练数据集作为输入,通过步骤s2-步骤s5所组成的基于模态定制协同注意力交互的时序语言定位模型,得到每一帧的目标片段时序边界回归值、语义匹配分数和时序交并比回归值;步骤s62:计算边界损失:计算所述步骤s61中得到的每一帧所述目标片段时序边界回归值与相应目标片段时序边界标注值的平滑损失,作为每一帧的第一边界损失;计算步骤步骤s61中得到的每一帧所述目标片段时序边界回归值与相应目标片段时序边界标注值的时序交并比,并将所述时序交并比取负值,作为每一帧的第二边界损失;将每一帧的所述第一边界损失和所述第二边界损失求和作为每一帧边界损失,计算所述训练数据集中所标注目标视频片段内所有视频帧的边界损失平均值,作为模型训练的边界损失;步骤s63:计算语义匹配损失:将所述步骤s61中得到的每一帧所述语义匹配分数沿着时序维度依次进行softmax操作、取对数操作以及取负值操作,得到每一帧视频帧相应的语义匹配损失,计算所述训练数据集中所标注目标视频片段内所有视频帧的语义匹配损失平均值,作为模型训练的语义匹配损失;步骤s64:计算时序交并比回归损失:将所述步骤s61中得到的每一帧所述目标片段时序边界回归值与标注目标片段的时序交并比作为时序交并比目标值,计算每一帧所述时序交并比目标值与所述步骤s61中得到的每一帧所述时序交并比回归值的绝对差值,并计算所述绝对差值在所述训练数据集中所有视频帧的平均值,作为模型训练的时序交并比回归损失;步骤s65:将所述模型训练的边界损失、所述模型训练的语义匹配损失以及所述模型训练的时序交并比回归损失的加权和作为模型训练的总损失,并使用优化器进行模型参数的更新,经过预设次数迭代训练,得到训练好的基于模态定制协同注意力交互的时序语言定位模型。

14.进一步地,所述步骤s7具体包括以下子步骤:步骤s71:将所述测试数据集作为训练好的基于模态定制协同注意力交互的时序语言定位模型的输入,获得所述测试数据集每一帧处的目标片段时序边界回归值、语义匹配分数和时序交并比回归值,将得到的语义匹配分数经过sigmoid函数处理,得到归一化语义匹配分数;步骤s72:将所述归一化语义匹配分数与所述步骤s71中得到的所述时序交并比回归值在每一帧处相乘,所得的乘积作为每一帧处目标片段时序边界回归值的置信度值;步骤s73:选择具有最高置信度值的目标片段时序边界回归值作为所述测试数据集的时序语言定位结果。

15.本发明还提供一种基于模态定制协同注意力交互的时序语言定位装置,包括存储器和一个或多个处理器,所述存储器中存储有可执行代码,所述一个或多个处理器执行所述可执行代码时,用于实现上述任一项所述的基于模态定制协同注意力交互的时序语言定位方法。

16.本发明还提供一种计算机可读存储介质,其上存储有程序,该程序被处理器执行时,实现上述任一项所述的基于模态定制协同注意力交互的时序语言定位方法。

17.本发明的有益效果是:本发明采用跨模态transformer架构作为基础架构进行视觉-语言跨模态交互,并将配备协同注意力的transformer架构用于时序语言定位任务;本发明设计了一种模态定制的双流协同注意力交互层,用于并行的视频流的多粒度协同注意力交互和查询流的标准协同注意力交互;此外,本发明以免候选提名的方式基于采用包含稠密时序边界回归、语义匹配分数预测以及交并比回归的多分支任务预测文本查询相应的目标视频片段时序位置,本发明方法实现简单,可显著提升时序语言定位任务性能。

附图说明

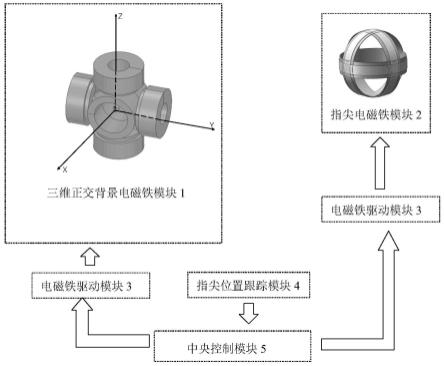

18.图1为本发明时序语言定位任务示例图;图2为本发明一种基于模态定制协同注意力交互的时序语言定位的流程框架图;图3为本发明一种基于模态定制协同注意力交互的时序语言定位方法的流程示意图;图4为本发明一种基于模态定制协同注意力交互的时序语言定位装置的结构示意图。

具体实施方式

19.以下对至少一个示例性实施例的描述实际上仅仅是说明性的,决不作为对本发明及其应用或使用的任何限制。基于本发明中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

20.参见图1,在收集的tacos烹饪视频数据集上基于pytorch框架进行具体的实验和评测。其中,本实验实施中性能评测采用“r@n, iou=m”评测准则,每对未剪辑视频-文本查询数据测试样本,若置信度值最高的n个预测片段与真实标注的交并比最大值若大于m则认为该查询被正确定位,该评测准则表示评测数据集中被正确定位的查询所占百分比。给定成对的未修剪视频x和未修剪视频x中某个时序片段的文本查询数据s,本发明一种基于模态定制协同注意力交互的时序语言定位的流程框架如图2所示。首先,通过视频编码器对未修剪视频x进行编码,得到视频表征v;其次,通过查询编码器对文本查询数据s进行编码,得到多粒度查询表征q;再次,将视频表征v和多粒度查询表征q作为输入,通过若干层的模态定制的双流协同注意力交互层进行跨模态融合,得到跨模态融合后的视频表征;最后,将跨模态融合后已语义对齐视频表征作为输入,通过多分支任务(包含稠密时序边界回归、语义匹配分数预测以及交并比回归)预测文本查询相应的目标视频片段的时序语言定位结果。在训练阶段,使用已构建的训练数据集对本发明的模型进行训练,训练该模型所采用的损失函数由边界损失、语义匹配损失和交并比回归损失三项组成。

21.参见图3,一种基于模态定制协同注意力交互的时序语言定位方法,包括以下步

骤:步骤s1:获取成对的未剪辑视频-文本查询数据,构建时序语言定位任务的训练数据集和测试数据集,所述训练数据集中每样本由成对的未剪辑视频-文本查询以及目标视频片段相应的起始和结束时间标注组成,所述测试数据集仅由未提供目标视频片段时间标注的成对的未剪辑视频-文本查询样本组成;tacos数据集收集127个平均时长约7分钟的视频,获取成对的未剪辑烹饪视频-文本查询数据,每视频包含若干时序片段相应的文本查询数据,构建时序语言定位任务的训练数据集和测试数据集,所述训练数据集中每样本由成对的未剪辑视频-文本查询以及目标视频片段相应的起始和结束时间标注组成,样本总数为10146;所述测试数据集仅由未提供目标视频片段时间标注的成对的未剪辑视频-文本查询样本组成,样本总数为4083。

22.步骤s2:基于所述时序语言定位任务中的每对未剪辑视频-文本查询数据,对未修剪视频通过视频编码器提取视频表征v;步骤s21:利用视频编码器中视觉预训练模型以离线方式对未剪辑视频-文本查询数据中的未剪辑视频提取视频帧表征并均匀地采样t帧;使用预训练的c3d网络模型以离线方式提取视频帧表征,将视频均匀采样为256帧;步骤s22:将t帧视频帧表征通过视频编码器中若干配备残差连接的一维卷积块,获取序列长度为t且特征维度为d的一组视频表征;将256帧视频经过一个配备残差连接的一维卷积块,获取一组序列长度为256且特征维度为512的视频表征;步骤s23:将所述一组视频表征通过视频编码器中若干自注意力块,构建全局上下文时序依赖建模的视频表征v;对视频表征通过两个多头自注意力块构建全局上下文时序依赖建模的视频表征,v

t

为视频第t帧的表征,自注意力头数为8。

23.步骤s3:基于所述时序语言定位任务中的每对未剪辑视频-文本查询数据,对文本查询数据通过查询编码器提取单词级查询表征w和句子级查询表征qs,所述单词级查询表征w和所述句子级查询表征qs组合得到多粒度查询表征q;步骤s31:利用查询编码器中预训练词嵌入模型对未剪辑视频-文本查询数据中的文本查询数据提取每个单词相应的词嵌入向量,获取词嵌入向量序列;使用预训练的glove词嵌入模型获取文本查询数据中每个单词相应的词嵌入向量,获得一组总单词数为l且特征维度为300的词嵌入向量序列;步骤s32:通过查询编码器中多层的双向长短时记忆网络对所述词嵌入向量序列进行上下文编码,获得总单词数为l且特征维度为d的单词级查询表征w;通过两层的双向长短时记忆网络对词嵌入向量序列进行上下文编码,获得一组总单词数为l且特征维度为512的单词级查询表征;步骤s33:将所述单词级查询表征中最后一个单词的前向隐状态向量和第一个单词的后向隐状态向量进行拼接,获得句子级查询表征qs;

将所述单词级查询表征中最后一个单词的前向隐状态向量和第一个单词的后向隐状态向量进行拼接,获得句子级查询表征qs。该计算过程可表示为:。该计算过程可表示为:其中,为前向隐状态向量和后向隐状态向量的拼接。

24.步骤s34:所述单词级查询表征w和所述句子级查询表征qs组合得到多粒度查询表征q,其中,;步骤s4:将所述视频表征v和所述多粒度查询表征q共同输入模态定制协同注意力交互模块,获取视频-文本跨模态融合后已语义对齐视频表征;将所述视频表征v和所述多粒度查询表征q作为模态定制协同注意力交互模块的输入,依次经过所述模态定制协同注意力交互模块中的若干层模态定制的双流协同注意力交互层进行跨模态融合,得到对应层输出的视频表征和多粒度查询表征,最后一层模态定制的双流协同注意力交互层输出的视频表征作为已语义对齐视频表征。

25.所述模态定制的双流协同注意力交互层包括视频流的多粒度协同注意力交互和查询流的标准协同注意力交互,具体实施过程为:视频流的多粒度协同注意力交互:将前一模态定制的双流协同注意力交互层输出的视频表征和多粒度查询表征作为输入,其中,,采用哈达玛乘积将所述视频表征和所述多粒度查询表征中的句子级查询表征进行粗粒度融合,得到背景帧表征抑制的视频表征,将所述背景帧表征抑制的视频表征采用一块多头自注意力块(msa)进行模态内时序上下文建模,得到视频表征;再次将所述视频表征作为查询,将所述多粒度查询表征中的单词级查询表征作为键和值,采用一块多头交叉注意力块(mca)进行模态间的跨模态对齐;最后采用两层的前馈网络(ffn)得到第层模态定制的双流协同注意力交互层的视频表征输出;计算过程可表示为:计算过程可表示为:计算过程可表示为:其中,ln表示层归一化,自注意力块和交叉注意力块的头数均为8。

26.查询流的标准协同注意力交互:将前一模态定制的双流协同注意力交互层输出的视频表征和多粒度查询表征作为输入,其中,,将所述多粒度查询表征采用一块多头自注意力块(msa)进行模态内时序上下文建模,得到多粒度查询表征;将所述多粒度查询表征作为查询,将所述视频表征作为键和值,采用一块多头交叉注意力块(mca)进行模态间的跨模态对齐;最后采用两层的前馈网络(ffn)

得到第层模态定制的双流协同注意力交互层的多粒度查询表征输出;计算过程可表示为:计算过程可表示为:计算过程可表示为:步骤s5:根据跨模态融合后的已语义对齐视频表征,采用包含稠密时序边界回归、语义匹配分数预测以及交并比回归的多分支任务,分别获得每一帧处的目标片段时序边界回归值、语义匹配分数和时序交并比回归值;步骤s51:稠密时序边界回归任务:将所述已语义对齐视频表征作为稠密时序边界回归任务的输入,采用两层的一维卷积,经过第一层一维卷积后得到稠密时序边界回归的输出表征,且最后一层一维卷积用sigmoid函数激活,在视频每一帧处稠密回归当前帧到目标视频片段的起始和结束时间点的归一化距离,获得每一帧处的目标片段时序边界回归值;步骤s52:语义匹配分数预测任务:将所述已语义对齐视频表征作为语义匹配分数预测任务的输入,采用两层的一维卷积,经过第一层一维卷积后得到语义匹配分数预测的输出表征,且最后一层一维卷积不激活,获得每一帧处的语义匹配分数;步骤s53:时序交并比回归任务:将所述稠密时序边界回归任务的输出表征和所述语义匹配分数预测任务的输出表征沿着通道维进行拼接,得到的拼接表征作为交并比回归任务的输入,采用三层的一维卷积且最后一层用sigmoid函数激活,获得每一帧处所回归目标片段与标注目标片段的时序交并比回归值。

27.步骤s6:对步骤s2-步骤s5所组成的基于模态定制协同注意力交互的时序语言定位模型,利用所述训练数据集进行训练,训练所采用的损失函数由边界损失、语义匹配损失和交并比回归损失三项组成,并使用优化器进行模型参数的更新,得到训练好的基于模态定制协同注意力交互的时序语言定位模型;步骤s61:将所述训练数据集作为输入,通过步骤s2-步骤s5所组成的基于模态定制协同注意力交互的时序语言定位模型,得到每一帧的目标片段时序边界回归值、语义匹配分数和时序交并比回归值;步骤s62:计算边界损失:计算所述步骤s61中得到的每一帧所述目标片段时序边界回归值与相应目标片段时序边界标注值的平滑损失,作为每一帧的第一边界损失;计算步骤步骤s61中得到的每一帧所述目标片段时序边界回归值与相应目标片段时序边界标注值的时序交并比,并将所述时序交并比取负值,作为每一帧的第二边界损失;将每一帧的所述第一边界损失和所述第二边界损失求和作为每一帧边界损失,计算所述训练数据集中所标注目标视频片段内所有视频帧的边界损失平均值,作为模型训练的边界损失;

具体计算过程可表示为:,其中,表示平滑损失函数,表示交并比操作,指示函数用于指明第t帧是否位于所标注目标片段内,为所标注目标片段内总视频帧数;步骤s63:计算语义匹配损失:将所述步骤s61中得到的每一帧所述语义匹配分数沿着时序维度依次进行softmax操作、取对数操作以及取负值操作,得到每一帧视频帧相应的语义匹配损失,计算所述训练数据集中所标注目标视频片段内所有视频帧的语义匹配损失平均值,作为模型训练的语义匹配损失;具体计算过程可表示为:,其中,表示第t帧相应的语义匹配分数;步骤s64:计算时序交并比回归损失:将所述步骤s61中得到的每一帧所述目标片段时序边界回归值与标注目标片段的时序交并比作为时序交并比目标值,计算每一帧所述时序交并比目标值与所述步骤s61中得到的每一帧所述时序交并比回归值的绝对差值,并计算所述绝对差值在所述训练数据集中所有视频帧的平均值,作为模型训练的时序交并比回归损失;具体计算过程可表示为:,其中,表示第t帧处的时序交并比回归值,表示第t帧处的时序交并比目标值;步骤s65:将所述模型训练的边界损失、所述模型训练的语义匹配损失以及所述模型训练的时序交并比回归损失的加权和作为模型训练的总损失,即,权值和分别设置为1.0;并使用adam优化器进行模型参数的更新,学习率固定为0.0004,且每个批处理训练样本数量为100,经过预设次数迭代训练,得到训练好的基于模态定制协同注意力交互的时序语言定位模型。

28.步骤s7:利用所述测试数据集对训练好的基于模态定制协同注意力交互的时序语言定位模型进行测试,将所得到的具有最高置信度值的目标片段时序边界回归值作为所述测试数据集的时序语言定位结果。

29.步骤s71:将所述测试数据集作为训练好的基于模态定制协同注意力交互的时序语言定位模型的输入,获得所述测试数据集每一帧处的目标片段时序边界回归值、语义匹配分数和时序交并比回归值,将得到的语义匹配分数经过sigmoid函数处理,得到归一化语义匹配分数;步骤s72:将所述归一化语义匹配分数与所述步骤s71中得到的所述时序交并比回归值在每一帧处相乘,所得的乘积作为每一帧处目标片段时序边界回归值的置信度值;步骤s73:选择具有最高置信度值的目标片段时序边界回归值作为所述测试数据集的时序语言定位结果。

30.本发明方法实施例与其它现有代表性时序语言定位方法的实施例在tacos测试数

据集上进行评测,采用“r@n, iou=m”的评测准则,这里n=1,m={0.1, 0.3, 0.5}。评测结果如表1所示,可发现本发明方法在三种评测子指标下一致优于其它代表性方法,该实施例验证了本发明方法的有效性。

31.表1 评测结果与前述一种基于模态定制协同注意力交互的时序语言定位方法的实施例相对应,本发明还提供了一种基于模态定制协同注意力交互的时序语言定位装置的实施例。

32.参见图4,本发明实施例提供的一种基于模态定制协同注意力交互的时序语言定位装置,包括存储器和一个或多个处理器,所述存储器中存储有可执行代码,所述一个或多个处理器执行所述可执行代码时,用于实现上述实施例中的一种基于模态定制协同注意力交互的时序语言定位方法。

33.本发明一种基于模态定制协同注意力交互的时序语言定位装置的实施例可以应用在任意具备数据处理能力的设备上,该任意具备数据处理能力的设备可以为诸如计算机等设备或装置。装置实施例可以通过软件实现,也可以通过硬件或者软硬件结合的方式实现。以软件实现为例,作为一个逻辑意义上的装置,是通过其所在任意具备数据处理能力的设备的处理器将非易失性存储器中对应的计算机程序指令读取到内存中运行形成的。从硬件层面而言,如图4所示,为本发明一种基于模态定制协同注意力交互的时序语言定位装置所在任意具备数据处理能力的设备的一种硬件结构图,除了图4所示的处理器、内存、网络接口、以及非易失性存储器之外,实施例中装置所在的任意具备数据处理能力的设备通常根据该任意具备数据处理能力的设备的实际功能,还可以包括其他硬件,对此不再赘述。

34.上述装置中各个单元的功能和作用的实现过程具体详见上述方法中对应步骤的实现过程,在此不再赘述。

35.对于装置实施例而言,由于其基本对应于方法实施例,所以相关之处参见方法实施例的部分说明即可。以上所描述的装置实施例仅仅是示意性的,其中所述作为分离部件说明的单元可以是或者也可以不是物理上分开的,作为单元显示的部件可以是或者也可以不是物理单元,即可以位于一个地方,或者也可以分布到多个网络单元上。可以根据实际的需要选择其中的部分或者全部模块来实现本发明方案的目的。本领域普通技术人员在不付出创造性劳动的情况下,即可以理解并实施。

36.本发明实施例还提供一种计算机可读存储介质,其上存储有程序,该程序被处理

器执行时,实现上述实施例中的一种基于模态定制协同注意力交互的时序语言定位方法。

37.所述计算机可读存储介质可以是前述任一实施例所述的任意具备数据处理能力的设备的内部存储单元,例如硬盘或内存。所述计算机可读存储介质也可以是任意具备数据处理能力的设备的外部存储设备,例如所述设备上配备的插接式硬盘、智能存储卡(smart media card,smc)、sd卡、闪存卡(flash card)等。进一步的,所述计算机可读存储介质还可以既包括任意具备数据处理能力的设备的内部存储单元也包括外部存储设备。所述计算机可读存储介质用于存储所述计算机程序以及所述任意具备数据处理能力的设备所需的其他程序和数据,还可以用于暂时地存储已经输出或者将要输出的数据。

38.以上所述仅为本发明的优选实施例而已,并不用于限制本发明,对于本领域的技术人员来说,本发明可以有各种更改和变化。凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。