一种基于端到端神经网络的极端稀疏视角ct重建方法

技术领域

1.本发明涉及一种ct图像重建方法,具体涉及一种基于端到端神经网络的极端稀疏视角ct重建方法。

背景技术:

2.ct是一种使用x射线、γ射线等对物体进行断面扫描的成像方式,得益于x射线、γ射线等具有穿透物体的特性,ct成像可以无实际创伤地直接获取人体内部组织的影像信息,其具有扫描时间快、成像清晰和物体内部可视化的特点,广泛应用于临床医学诊断和工业无损检测中。然而在实际情况中想要获取高清晰度的ct图像时通常需要利用重复或高剂量的射线光源对物体进行扫描,这会导致患者长时间暴露在x射线下,从而可能引起其代谢异常,甚至诱发癌症。其中一种可以有效的解决上述问题方法就是减少ct设备环绕扫描的视角数量,进行稀疏视角ct重建,但当光源扫描物体时旋转的视角没有达到其重建所需的满视角时,重建的ct图像会产生条状伪影,并且随着视角的减少其产生的条状伪影情况越严重。目前,已被广泛研究的稀疏视角ct重建算法可以分为传统的基于压缩感知的迭代重建算法以及基于深度学习的重建算法。其中迭代重建算法需要重建建立多个投影与反投影过程,大大增加了算法的计算成本和时间,并且其约束的正则项与平衡参数需要通过大量的人工实验选择得到,使其在实际应用中大大受限。而基于深度学习的重建算法,通常只使用传统的卷积模块提取图像局部特征难以更好地去除全局伪影信息,或者利用卷积神经网络取代迭代重建中的部分子问题的迭代求解更新过程,以加快求解速度,但其本质上其仍需要建立多个投影与反投影过程,仍不可避免巨大计算的时间复杂度。

技术实现要素:

3.本发明的目的在于克服现在技术的不足,提供一种基于端到端神经网络的极端稀疏视角ct重建方法,所述的ct重建算法可实现直接对极端稀疏视角的正弦图进行重建,能够重建更多全局细节信息与边缘信息同时具备更佳的实时性。

4.本发明解决上述技术问题的技术方案是:

5.一种基于端到端神经网络的极端稀疏视角ct重建方法,包括以下步骤:

6.(s1)、使用ct成像系统中的探测器以间隔相同的角度旋转均匀欠采样采集对应视角的强度数据(正弦图)放入图像集a中并采集对应的满视角正弦图;

7.(s2)、利用双线性插值方法对缺失视角的数据进行插值填补,得到初始满视角的正弦图图像集b;

8.(s3)、将图像集b中的图像放入训练好的正弦图恢复网络中,得到优化后的正弦图图像集c;

9.(s4)、基于pytorch中搭建的可求导的fbp算法将图像集c中的优化后的正弦图初始重建为ct图像集d;

10.(s5)、将ct图像集d放入训练好的双流特征融合恢复网络中,得到优化后的ct图

像。

11.根据权利要求1所述的基于端到端神经网络的极端稀疏视角ct重建方法,其特征在于,在步骤(s5)中,双流特征融合恢复网络的构建与双域端到端网络的训练包括以下步骤:

12.(s5-1)、利用fbp算法对s1中的采集的满视角的正弦图放进图像集after中,并将满视角的正弦图重建后的ct图像放入图像集label中;

13.(s5-2)、构建一个用于提升ct图像质量的双流特征融合恢复网络,然后联合s2中的双线性插值方法、s3中的正弦图恢复网络与s4的fbp模块组成一个双域端到端神经网络,其中投影域中的网络为正弦图恢复网络,ct图像域中的网络为双流特征融合恢复网络。

14.(s5-3)、将(s1)中的极端稀疏视角正弦图a作为双域端到端神经网络的输入,计算网络最终输出ct图像与图像集label之间的损失函数值,同时计算投影域中正弦图恢复网络的输出与(s3-1)中的图像集after之间的损失函数值,将两者损失函数反向传播更新网络权重与参数,训练的优化器为adam,当达到设定的训练轮次时时停止更新双域网络的权重和偏置参数,得到训练完备的正弦图恢复网络和双流特征融合恢复网络。

15.优选的,在步骤(s5-3)中,其极端稀疏视角数可以为平行x光ct重建中所需满角度180个的1/10、1/30、1/60。

16.优选的,在步骤(s5-3)中,所述的双流特征融合恢复网络包括两个子网络,分别为图像恢复子网络与边缘增强子网络,网络最终通过一个特征融合层融合两者输出的特征,随后通过卷积对融合的特征进行通道降维得到最后的ct图像。

17.优选的,正弦图恢复网络与图像恢复子网络结构相同,包括浅层特征提取层、深层特征提取层,与2

×

2最大池化下采样层,亚像素卷积上采样层,其中所述的浅层特征提取层由3

×

3卷积块,批量归一化层和relu激活函数(cbr)组成;所述的深层特征提取层由一个栅栏型transformer构成,其由卷积核大小为3

×

3的深度可分离卷积、gelu激活函数、栅栏形状的自注意力机制块组成,所述的栅栏形状自注意力机制通过3个可深度分离卷积计算输入特征图中行列交错轴区域中的q、k、v值,随后通过标准的transformer的msa计算方式利用softmax函数联合q、k、v值计算特征图对应区域中的自适应权重;所述的像素卷积上采样层由卷积核大小为3

×

3卷积层、批量归一化层、relu激活函数、像素随机打乱层组成,所述的像素随机打乱层通过卷积扩展特征图通道,随后将扩展通道的特征图随机分配至空间维度,以扩展特征图空间分辨率,网络下采样通道数分别为64、128、256、512与1024,上采样通道数与下采样相反。

18.优选的,根据权利要求4所述的基于端到端神经网络的极端稀疏视角ct重建方法,其特征在于,边缘增强子网络包括拉普拉斯边缘加权卷积块、多尺度卷积块、通道注意力层,下采样2

×

2最大池化层、亚像素卷积上采样层,其中所述的拉普拉斯边缘加权卷积块由一个卷积核大小为3

×

3的初始化权重为计算八方向梯度的拉普拉斯边缘检测算子模板的卷积层、像素加权点乘层组成,其通过将卷积的输出边缘特征与原始输入的初始重建ct图像进行像素逐点相乘得到加权的边缘信息;所述的多尺度卷积块由是通过不同大小的卷积层对特征图进行卷积得到不同尺度的特征信息来实现的(卷积核大小包括1

×

1、3

×

3和5

×

5);所述的通道注意力层由自适应最大池化层、卷积核大小为3

×

3的卷积层、sigmoid激活函数与像素点与像素加权点乘层组成,该子网络下采样通道数分别为32、64、128、256与

512,上采样通道数与下采样相反。

19.优选的,训练双域网络的损失函数包括4个,分别为如下:正弦图恢复网络损失函数loss

sino

由均方差损失函数构成;双域特征融合网络函数loss

img

由均方差损失函数、多尺度结构相似度损失函数与基于高斯拉普拉斯核的边缘损失函数。多尺度损失函数为:

[0020][0021]

其中ε

p

,εg分别表示重建ct图像与标签ct图像的均值,σ

p

,σg分别表示重建ct图像与标签ct图像的标准差,σ

pg

则表示两者的协方差,βm,γm参数用于平衡两个参数项的占比值,c1,c2为常数,防止等式的除数为0。基于高斯拉普拉斯算子构建的边缘损失函数为:

[0022][0023]

其中m为总像素点,下标i为卷积输出图像的像素位置;*为二维离散卷积运算;f(x,y),f

gt

(x,y)分别为双流特征融合恢复网络输出与ct标签图像;

[0024][0025]

为二阶导的高斯核。既计算两者卷积后的特征图之间的l1范数的均值作为损失函数值。均方差损失函数为:

[0026][0027]

最后网络的损失函数为:

[0028]

loss=loss

mse(sino)

loss

mse(img)

0.2

×

loss

edge(img)

0.1

×

loss

mssim(img)

ꢀꢀꢀ

(10)

[0029]

本发明与现有技术相比具有以下的有益效果:

[0030]

1、本发明的基于端到端神经网络的极端稀疏视角ct重建方法将transformer中的自注意力机制引入到用于正弦图恢复网络与ct图像恢复的双流特征融合网络中,相比于先前的只使用传统的卷积提取图像中局部的特征信息的ct重建算法,在本发明的方法中结合了卷积块与transformer增强网络同时提取全局与局部特征的能力,以捕获更加丰富的上下特征块之间关系,提高网络抑制全局伪影、二次伪影与恢复细节结构的能力。

[0031]

2、本发明的基于端到端神经网络的极端稀疏视角ct重建方法同时在双流特征融合恢复网络中基于拉普拉斯边缘检测算子构建了一个边缘加权卷积模块,并且结合多尺度卷积块与通道注意力机制进一步优化得到的加权边缘特征信息,最后通过与结合了transformer的图像恢复子网络输出的特征信息在维度上进行融合,网络在恢复主体结构的同时增强其边缘结构信息的恢复,进一步提高图像的视觉感官。

[0032]

3、本发明的基于端到端神经网络的极端稀疏视角ct重建方法在构建损失函数时除了使用均方差损失函数外,还利用了多尺度损失函数约束重建的图像同时基于高斯拉普拉斯算子构建了边缘损失函数,进一步提升重建的边缘效果。

附图说明

[0033]

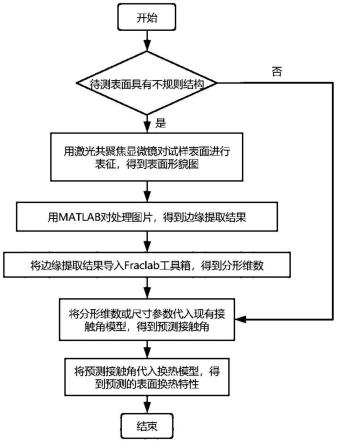

图1为本发明的基于端到端神经网络的极端稀疏视角的ct重建方法流程图。

[0034]

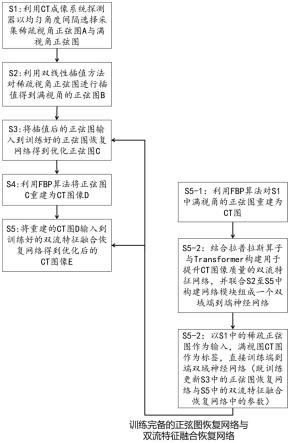

图2为本发明的基于端到端神经网络的极端稀疏视角的ct重建方法中双流特征融合恢复网络,包括边缘增强子网络与图像恢复子网络。

[0035]

图3为本发明的基于端到端神经网络的极端稀疏视角的ct重建方法的训练与具体测试执行案例流程示意图。

具体实施方式

[0036]

下面结合实施例对本发明作进一步详细的描述,但本发明的实施方式不限于此。

[0037]

参见图1,本发明的基于端到端神经网络的极端稀疏视角的ct重建方法包括以下步骤:

[0038]

(s1)、使用ct成像系统中的探测器以均匀角度间隔旋转欠采样采集对应视角的强度数据(正弦图)放入图像集a中并采集对应的满视角正弦图,其图像分辨率大小为(180

×

n)

×

320,其中n为稀疏倍数;

[0039]

(s2)、利用双线性插值方法对缺失视角的数据进行插值填补,得到初始满视角的正弦图图像集b;

[0040]

(s3)、将图像集b中的图像放入训练好的正弦图恢复网络中,得到优化后的正弦图图像集c;

[0041]

(s4)、利用fbp算法将图像集c中的满视角正弦图初始重建为ct图像集d,重建后图像分辨率大小为256

×

256;

[0042]

(s5)、将ct图像集d放入训练好的双流特征融合恢复网络中,得到优化后的ct图像。

[0043]

参见图1,在步骤(s5)中,双流特征融合恢复网络的构建包括以下步骤:

[0044]

(s5-1)、利用fbp算法对s1中的采集的满视角的正弦图放进图像集after中,并将满视角的正弦图重建后的ct图像放入图像集label中;

[0045]

(s5-2)、构建一个用于提升ct图像质量的双流特征融合恢复网络,然后联合s2中的双线性插值方法、s3中的正弦图恢复网络与s4的fbp模块组成一个双域端到端神经网络,其中投影域中的网络为正弦图恢复网络,ct图像域中的网络为双流特征融合恢复网络。

[0046]

(s5-3)、将(s1)中的极端稀疏视角正弦图a作为双域端到端神经网络的输入,计算网络最终输出ct图像与图像集label之间的损失函数值,同时计算投影域中正弦图恢复网络的输出与(s3-1)中的图像集after之间的损失函数值,将两者损失函数反向传播更新网络权重与参数,训练的优化器为adam,当达到设定的训练轮次时时停止更新双域网络的权重和偏置参数,得到训练完备的正弦图恢复网络和双流特征融合恢复网络。

[0047]

对于在极端稀疏视角(如6个或3个)条件下重建ct图像,得到的图像几乎仅剩下交错的全局条状伪影信息,传统的用于图像恢复的全卷积网络在面对具有全局特性的特征信息与一些较小的微弱特征时,网络难以将这些特征表征出来,全局伪影特征超过了其本身网络卷积块的感受野,从而不能较好地抑制图像中的全局伪影以及二次伪影现象,导致恢复的图像结构相似度并不好,清晰度较低并且图像仍携带着微弱的条状伪影。同时基于传统的全卷积神经网络用于ct重建时缺乏对图像边缘信息的关注,并且同时传统的卷积模块很难单独只提取图像的边缘特征信息,导致重建的ct图像边缘效果并不强。

[0048]

为此,参见图2本实施例改进的正弦图恢复网络与图像恢复子网络结构包括浅层

特征提取层、深层特征提取层,与下采样2

×

2最大池化层,亚像素卷积上采样层,其中所述的浅层特征提取层由3

×

3卷积块,批量归一化层和relu激活函数(cbr)组成;所述的深层特征提取层由一个栅栏型transformer构成,其由卷积核大小为3

×

3的深度可分离卷积、gelu激活函数、栅栏形状的自注意力机制块组成,所述的栅栏形状自注意力机制通过3个可深度分离卷积计算输入特征图中行列交错轴区域中的q、k、v值,随后通过标准的transformer的msa计算方式利用softmax函数联合q、k、v值计算特征图对应区域中的自适应权重;所述的像素卷积上采样层由卷积核大小为3

×

3卷积层、批量归一化层、relu激活函数、像素随机打乱层(pixel shuffle)组成,通过卷积扩展特征图通道,随后将扩展通道的特征图随机分配至像素空间,以取代传统上采样中的卷积转置卷积与插值,网络下采样通道数分别为64、128、256、512与1024,上采样通道数与下采样相反。

[0049]

参见图2,本实施例的构建的边缘增强子网络包括拉普拉斯边缘加权卷积块(laplacian_conv)、多尺度卷积块(msc)、通道注意力层(se),下采样2

×

2最大池化层、亚像素卷积上采样层,其中所述的拉普拉斯边缘加权卷积块由一个卷积核大小为3

×

3的初始化权重为计算八方向梯度的拉普拉斯边缘检测算子模板的卷积层、像素加权点乘层组成,其通过将卷积的输出边缘特征与原始输入的初始重建ct图像进行像素逐点相乘得到加权的边缘信息;所述的多尺度卷积块由是通过不同大小的卷积层对特征图进行卷积得到不同尺度的特征信息来实现的(卷积核大小包括1

×

1、3

×

3和5

×

5);所述的通道注意力层由自适应最大池化层、卷积核大小为3

×

3的卷积层、sigmoid激活函数与像素点与像素加权点乘层组成,其通过压缩空间的方式学习每个通道的自适应权重占比从而让网络关注更加重要的通道信息,该子网络下采样通道数分别为32、64、128、256与512,上采样通道数与下采样相反。

[0050]

通过上述设置,利用transformer关联特征图的主体图像全局特性,同时利用拉普拉斯卷积块与多尺度通道注意力模块结合进一步增强不同尺度的语义边缘信息并对其进行融合,可以在恢复的图像基础上进一步加强边缘结构的恢复。

[0051]

另外,训练网络的损失函数包括4个,分别为如下:正弦图恢复网络损失函数loss

sino

由均方差损失函数构成;双域特征融合网络函数loss

img

由均方差损失函数、多尺度结构相似度损失函数与基于高斯拉普拉斯算子的边缘损失函数。多尺度损失函数为:

[0052][0053]

其中ε

p

,εg分别表示重建ct图像与标签ct图像的均值,σ

p

,σg分别表示重建ct图像与标签ct图像的标准差,σ

pg

则表示两者的协方差,βm,γm参数用于平衡两个参数项的占比值,c1,c2为常数,防止等式的除数为0。基于高斯拉普拉斯算子构建的边缘损失函数为:

[0054][0055]

其中m为总像素点,下标i为卷积输出图像的像素位置;*为二维离散卷积运算;f(x,y),f

gt

(x,y)分别为双流特征融合恢复网络输出与ct标签图像。而

[0056]

[0057]

为二阶导的高斯核。既计算两者卷积后的特征图之间的l1范数的均值作为损失函数值。均方差损失函数为:

[0058][0059]

最后网络的损失函数为:

[0060]

loss=loss

mse(sino)

loss

mse(img)

0.2

×

loss

edge(img)

0.1

×

loss

mssim(img)

ꢀꢀ

(15)

[0061]

参见图3,以下则以具体案例对本发明的ct重建方法进行阐述:

[0062]

首先通过ct设备对物体采集对应角度的稀疏视角正弦图数据,并将稀疏视角的正弦图数据放入图像集a中;使用双线性插值方法对图像集a的图像缺失视角的数据进行插值,得到插值后的正弦图放入图像集b中;随后将图像集b中的图像放入到训练好的正弦图恢复网络中得到优化后的正弦图数据图像集c;然后利用fbp算法对图像集c中的正弦图进行重建得到ct图像集d;最后将图像集d中的初始重建ct图像放入训练好的双流特征融合恢复网络得到优化后的ct图像;而训练过程则基于正弦图损失(loss

sino

)与ct图像损失(loss

img

)联合训练双域网络。

[0063]

上述为本发明较佳的实施方式,但本发明的实施方式并不受上述内容的限制,其他的任何未背离本发明的精神实质与原理下所作的改变、修饰、替代、组合、简化,均应为等效的置换方式,都包含在本发明的保护范围之内。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。