1.本发明属于智能交通、智慧高速研究领域,具体涉及一种基于深度学习融合模型的车辆颜色识别方法。

背景技术:

2.随着不停车收费技术的大范围普及,对车辆信息感知提出了新的要求,车辆信息感知正朝着将车辆号牌、品牌、颜色、类型等特征融为一体的车辆全息属性感知方向发展。与车辆号牌识别相比,当前对车辆颜色识别领域的研究较少,且车辆颜色作为车辆的基本属性,其占比大,不易遮挡修改,对图像质量不敏感。可以在很大程度上弥补车牌识别的不足。

3.在颜色识别研究中,传统机器学习方法依赖特征工程,计算效率低,难以应用于实际智能系统。而深度学习通过自适应提取特征,降低了计算复杂性,同时具有更强的泛化能力。融合网络通过结合各个单模型的结构特性,弥补单一模型的缺陷,融合各模型优势,可以大幅提升模型综合性能。因此,本发明提出了一种基于深度学习融合模型的车辆颜色识别方法。

技术实现要素:

4.发明目的:为了克服现有技术中存在的不足,提供一种基于深度学习融合模型的车辆颜色识别方法,其采用yuv-fm-retinex算法进行图像预处理,并利用深度融合神经网络有效地对车辆颜色进行识别和分类,可对高速公路场景中的车辆信息感知提供技术支持。

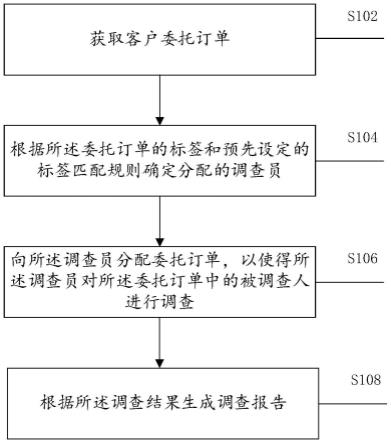

5.技术方案:为实现上述目的,本发明提供一种基于深度学习融合模型的车辆颜色识别方法,包括如下步骤:

6.s1:构建高速公路车脸图像数据集;

7.s2:对高速公路车脸图像数据集进行yuv-fm-retinex图像增强;

8.s3:构建基于深度学习的车辆颜色识别模型vcr-vgg16,获取一维特征向量fv;

9.s4:构建基于深度学习的车辆颜色识别模型vcr-xception,获取一维特征向量f

x

;

10.s5:构建基于深度学习的车辆颜色识别模型vcr-densenet201,获取一维特征向量fd;

11.s6:将特征向量fv、f

x

、fd融合,构建基于深度学习车辆颜色识别融合模型vcr-fdcnn,进行车辆颜色识别。

12.进一步的,所述步骤s1中构建高速公路车脸图像数据集的具体方法如下:

13.s1-1:收集高速公路车脸图像7200幅,包括黑色、白色、红色、黄色、蓝色、绿色6个颜色类别,小汽车、大巴车、卡车3种车型,构建高速公路车脸图像数据集。其中每种车型各2400幅,图像包含不同时段不同光线条件的变化;

14.s1-2:各模型训练前,随机抽取图像数据作为训练集、验证集和测试集。

15.进一步的,所述步骤s2中对高速公路车脸图像数据进行yuv-fm-retinex图像增强的具体步骤如下:

16.s2-1:切换yuv颜色空间,将rgb颜色空间内的原始图像转化到yuv颜色空间;

17.s2-2:分离通道,分离yuv颜色空间图像,得到亮度分量y与色度分量u、v;

18.s2-3:fm-retinex增强,仅对亮度分量y进行fm-retinex算法增强;

19.s2-4:通道融合,将增强后的亮度通道y与色度通道u、v融合;

20.s2-5:切换rgb颜色空间,将yuv颜色空间内的图像转换回rgb颜色空间;

21.s2-6:亮度归一化,调整图像各通道灰度值归一化,再同比恢复至(0,225)区间。

22.进一步的,所述步骤s2-3中fm-retinex算法增强的具体内容为:

23.①

将y通道像素值由整数域转到对数域,并整体加1:

24.y'(x,y)=log(1 y(x,y))

25.②

针对分辨率m

×

n的图像,设距当前像素点最远两比较点距离为x:

26.x=2

p

27.p=fix[log

2 min(m,n)-1]

[0028]

③

若x》0,则令:

[0029][0030]

若x《0,则令:

[0031][0032]

④

每结束上一步计算,改变比较点间距:

[0033]

x=-x/2

[0034]

⑤

当|x|《1时,得到最终输出结果数组r

n 1

(x,y),进行线性拉伸:

[0035][0036]

其中,max和min分别表示r

n 1

(x,y)的最大和最小值。

[0037]

进一步的,所述步骤s2-6中灰度值归一化的具体内容为:

[0038][0039]

其中,g(x,y)、g

′

(x,y)分别为归一化前、归一化后的灰度值;max、min分别为原始图像灰度的最大值和最小值。

[0040]

进一步的,所述步骤s3中构建基于深度学习的车辆颜色识别模型vcr-vgg16,获取一维特征向量fv的具体方法为:在vgg16模型的基础上,增加全局平均池化层、丢弃率为0.5的dropout层和全连接层,网络识别种类分为黑色、白色、红色、黄色、蓝色、绿色6类,得到基于深度学习的vcr-vgg16车辆颜色识别模型,训练完成后删除末尾的全连接层与dropout层,最后输出1

×1×

512的一维特征向量fv。

[0041]

进一步的,所述步骤s4中构建基于深度学习的车辆颜色识别模型vcr-xception,获取一维特征向量f

x

的具体方法为:在xception模型的基础上,增加全局平均池化层、dropout层和全连接层,网络识别种类分为黑色、白色、红色、黄色、蓝色、绿色6类,得到基于

深度学习的vcr-xception车辆颜色识别模型,训练完成后删除全连接层与dropout层,得到1

×1×

2048的一维特征向量f

x

。

[0042]

进一步的,所述步骤s5中构建基于深度学习的车辆颜色识别模型vcr-densenet201,获取一维特征向量fd的具体方法为:在densenet201模型的基础上,增加全局平均池化层、dropout层和全连接层,网络识别种类分为黑色、白色、红色、黄色、蓝色、绿色6类,得到基于深度学习的vcr-densenet201车辆颜色识别模型,训练完成后删除全连接层与dropout层,得到1

×1×

1920的一维特征向量fd。

[0043]

进一步的,所述步骤s6中将特征向量fv、f

x

、fd融合,构建基于深度学习车辆颜色识别融合模型vcr-fdcnn的具体方法为:对于vcr-vgg16、vcr-xception、vcr-densenet201三个模型,去除原结构全连接层与dropout层,提取到特征向量fv、f

x

和fd,将得到的一维特征向量并联融合得到1

×1×

4480的特征,然后将合并后的一维特征向量作为输入,重新训练全连接层,并再次加入dropout层防止过拟合,最后得到融合模型vcr-fdcnn。

[0044]

有益效果:本发明与现有技术相比,基于深度学习技术实现了对车辆颜色的自动识别,提高了识别精度、模型稳定性与泛化能力,可对高速公路场景的车辆信息感知提供技术支持。

附图说明

[0045]

图1为yuv-fm-retinex算法流程图。

[0046]

图2为vcr-fdcnn模型结构示意图。

具体实施方式

[0047]

下面结合附图和具体实施例,进一步阐明本发明。

[0048]

本发明提供一种基于深度学习的车辆颜色识别方法,包括以下步骤:

[0049]

s1:构建高速公路车脸图像数据集,其具体为:

[0050]

s1-1:收集高速公路车脸图像7200幅,包括黑色、白色、红色、黄色、蓝色、绿色6个颜色类别,小汽车、大巴车、卡车3种车型,构建高速公路车脸图像数据集。其中每种车型各2400幅,图像包含清晨、白天、黄昏、夜间等不同时段和晴天、雨天、雾天等不同光线条件的变化,数据集构成如表1所示;

[0051]

表1车脸图像数据集构成

[0052] 黑色白色红色黄色蓝色绿色合计小汽车6004004003184001662284大巴车04004004414005172158卡车6004004004414005172758合计1200120012001200120012007200

[0053]

s1-2:各模型训练前,按照4:1:1的比例随机抽取图像数据作为训练集、验证集和测试集。

[0054]

s2:对高速公路车脸图像数据集进行yuv-fm-retinex图像增强,其具体为:

[0055]

s2-1:切换yuv颜色空间:将rgb颜色空间内的初始图像转化到yuv颜色空间;

[0056]

s2-2:分离通道:分离yuv颜色空间图像,得到亮度分量y与色度分量u、v;

[0057]

s2-3:fm-retinex增强:仅对亮度分量y进行fm-retinex算法增强:

[0058]

①

将y通道像素值由整数域转到对数域,并整体加1:

[0059]

y'(x,y)=log(1 y(x,y))

[0060]

②

针对分辨率m

×

n的图像,设距当前像素点最远两比较点距离为x:

[0061]

x=2

p

[0062]

p=fix[log

2 min(m,n)-1]

[0063]

③

若x》0,则令:

[0064][0065]

若x《0,则令:

[0066][0067]

④

每结束上一步计算,改变比较点间距:

[0068]

x=-x/2

[0069]

⑤

当|x|《1时,得到最终输出结果数组r

n 1

(x,y),线性拉伸得:

[0070][0071]

其中,max和min分别表示r

n 1

(x,y)的最大和最小值。

[0072]

s2-4:通道融合:将增强后的亮度通道y与色度通道u、v融合;

[0073]

s2-5:切换rgb颜色空间:将yuv颜色空间内的图像转换回rgb颜色空间;

[0074]

s2-6:亮度归一化:调整图像各通道灰度值归一化,再同比恢复至(0,225)区间:

[0075]

令各通道灰度值:

[0076][0077]

其中,g(x,y)、g

′

(x,y)分别为归一化前、归一化后的灰度值;max、min分别为原始图像灰度的最大值和最小值。再同比扩大到(0,225)得亮度归一化结果。

[0078]

s3:构建基于深度学习的车辆颜色识别模型vcr-vgg16,获取一维特征向量fv:在经典卷积神经网络vgg16模型的基础上,依次增加全局平均池化层、丢弃率为0.5的dropout层和全连接层,设置模型输出使网络识别种类分为黑色、白色、红色、黄色、蓝色、绿色6类,通过训练得到基于深度学习的vcr-vgg16车辆颜色识别模型,训练完成后删除网络末尾的全连接层与dropout层,得到输出为1

×1×

512的一维特征向量fv。

[0079]

s4:构建基于深度学习的车辆颜色识别模型vcr-xception,获取一维特征向量f

x

:在经典卷积神经网络xception模型的基础上,依次增加全局平均池化层、dropout层和全连接层,设置模型输出使网络识别种类分为黑色、白色、红色、黄色、蓝色、绿色6类,通过训练得到基于深度学习的vcr-xception车辆颜色识别模型,训练完成后删除全连接层与dropout层,得到输出为1

×1×

2048的一维特征向量f

x

。

[0080]

s5:构建基于深度学习的车辆颜色识别模型vcr-densenet201,获取一维特征向量fd:在经典卷积神经网络densenet201模型的基础上,依次增加全局平均池化层、dropout层和全连接层,设置模型输出使网络识别种类分为黑色、白色、红色、黄色、蓝色、绿色6类,通

过训练得到基于深度学习的vcr-densenet201车辆颜色识别模型,训练完成后删除全连接层与dropout层,得到输出为1

×1×

1920的一维特征向量fd。

[0081]

s6:将特征向量fv、f

x

、fd融合,构建基于深度学习车辆颜色识别融合模型vcr-fdcnn,对车辆颜色进行识别:vcr-vgg16、vcr-xception、vcr-densenet201三个车辆颜色识别模型采用并联融合规则,形成vcr-fdcnn车辆颜色识别模型如图2所示。对于vcr-vgg16、vcr-xception、vcr-densenet201三个模型,完成模型训练后去除原结构全连接层与dropout层,提取到特征向量fv、f

x

和fd,将得到的一维特征向量进行并联,融合成尺寸为1

×1×

4480的新一维特征向量,然后将合并后的一维特征向量作为输入,再次加入丢弃率为0.5的dropout层防止过拟合,重新训练全连接层,最后得到融合模型vcr-fdcnn,输出黑色、白色、红色、黄色、蓝色、绿色6种识别结果。

[0082]

为验证yuv-fm-retinex增强算法的优越性,本案例进行了对比实验。基于7200幅高速公路车脸图像,按4:1:1划分训练集、验证集和测试集,分别使用原图、亮度归一化、切换lab颜色空间、直方图均衡、yuv-fm-retinex算法进行图像预处理,并训练神经网络,得到测试集上召回率如表2所示。可以看出使用yuv-fm-retinex算法后模型测试结果明显优于其他预处理方法,尤其和原图对比召回率明显提高。表明yuv-fm-retinex增强算法能够有效处理图像,减少不同光线和时段对图像的干扰。

[0083]

表2预处理方法对比

[0084] 黑色白色红色黄色蓝色绿色平均召回率原图969798.595.596.59796.75亮度归一化9796.598.596.596.59797.00切换lab颜色空间979698.59697.597.597.08直方图均衡9899.598.59795.59497.08yuv-fm-retinex算法99979998.598.596.598.08

[0085]

为验证融合模型(vcr-fdcnn)的优越性,同样进行了对比实验。基于7200幅高速公路场景中车脸图像,按4:1:1的比例划分训练集、验证集和测试集,使用yuv-fm-retinex算法进行图像预处理,分别训练vcr-vgg16、vcr-xception、vcr-densenet201、vcr-fdcnn四个车辆颜色识别模型,对比分析不同模型的精度,结果如表3所示。可以看出融合模型(vcr-fdcnn)的车辆颜色识别率在训练集、验证集上高达100%和99.5%,明显高于其他单一模型;同时相比单一模型,融合模型在单网络基础上的训练速度极快。

[0086]

表3融合模型对比

[0087] vgg16xceptiondensenet201fdcnn-vtr训练精度99.5599.8100100验证精度98.6799.399.0899.5训练耗时44s/epoch40s/epoch42s/epoch0.56s/epoch

[0088]

为了进一步表明vcr-fdcnn模型的有效性,本案例统计了测试集识别结果的混淆矩阵,如表4所示。结果表明fdcnn-vcr融合模型对车辆颜色的识别性能较好,六种颜色的测试集识别准确率均不低于98.5%,平均识别准确率达99.50%。

[0089]

表4vcr-fdcnn融合模型混淆矩阵

[0090] 黑色白色红色黄色蓝色绿色黑色99.50%00.50%000白色0100%0000红色0099.50%000黄色00099.50%01.00%蓝色0000.50%100%0.50%绿色0.50%000098.50%

[0091]

本发明方案所公开的技术手段不仅限于上述实施方式所公开的技术手段,还包括由以上技术特征任意组合所组成的技术方案。应当指出,对于本技术领域的普通技术人员来说,在不脱离本发明原理的前提下,还可以做出若干改进和润饰,这些改进和润饰也视为本发明的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。