1.本发明涉及深度学习实例分割图像处理领域,具体是一种基于深度学习牙齿目标实例分割及其智能预览的方法。

背景技术:

2.实例分割一直以来都是深度学习中的一个热点,物体实例分割技术在计算机视觉中是基础而又具有挑战性的;由于其广泛的应用场景和研究价值,该技术在学术界和工业界均引起了越来越多的关注;目前主流的物体实例分割方法可以分成两大类别:基于roi的自上而下的方法(如mask r-cnn)和基于逐像素聚类、自下而上的方法,这些方法虽然成功但面临着多阶段、多超参数、分割结果不够精细等问题;几个深度学习方法的区别,目标检测(objectdetection)不仅需要提供图像中物体的类别,还需要提供物体的位置 (bounding box);语义分割(semantic segmentation)需要预测出输入图像的每一个像素点属于哪一类的标签;实例分割(instance segmentation) 在语义分割的基础上,还需要区分出同一类不同的个体;对于语义分割 (semantic segmentation),希望分割精度(segmentation accuracy)和分割效率(segmentation efficiency)都达到一个比较好的程度;好的分割精度主要表现在定位的精确和物体类别识别的准确;好的分割效率指的是在可接受的内存/存储的情况下,时间达到实时;用于分割的目标检测器的重要组成部分之一是良好的特征表示(good feature representation),它在目标检测中起着至关重要的作用;以前,有一些手工设计的特征,如sift,hog等;目前大都是使用cnn来提取特征,基于cnn的检测器,如rcnn,faster rcnn和 yolo等,通常使用最多的cnn层作为物体的表示;不过存在一个问题,就是物体的尺度变化很大,这对检测任务是一个难点,解决这个问题的其中一个方法是使用图像金字塔(pyramid of images),但是这个方法比较耗资源和耗时。

3.许多计算机视觉任务需要对图像进行智能分割,以理解图像中的内容,并使每个部分的分析更加容易;图像分割技术使用计算机视觉深度学习模型来理解图像的每个像素所代表的真实物体,这在十年前是无法想象的;图像分割有助于确定目标之间的关系,以及目标在图像中的上下文;实例分割已成为机器视觉研究中比较重要、复杂和具有挑战性的领域之一;为了预测对象类标签和特定于像素的对象实例掩码,它对各种图像中出现的对象实例的不同类进行本地化;实例分割的目的主要是帮助机器人,自动驾驶,监视等;深度学习主流方法,目标检测或定位是数字图像从粗到细的一个渐进过程,它不仅提供了图像对象的类,还提供了已分类图像中对象的位置,位置以边框或中心的形式给出;语义分割通过对输入图像中每个像素的标签进行预测,给出了较好的推理,每个像素都根据其所在的对象类进行标记;为了进一步发展,实例分割为属于同一类的对象的单独实例提供了不同的标签;因此实例分割可以定义为同时解决目标检测问题和语义分割问题的技术。

4.在深度学习流行之前,之前的技术依赖于自下而上的生成掩模建议;随后被具有更高效结构的新技术所取代,如rcnn;尽管rcnn在分割精度上有一定的提高,但训练是一个基于多阶段的管道,这是缓慢的,很难优化,因为训练每个阶段需要分开;在cnn的每张图像

中,每个方案都需要提取特征,这就分别导致了存储、时间和检测尺度的问题;测试也很慢,因为需要提取cnn 的特征;随后又出现了fast rcnn和faster rcnn,解决了它的问题;基于掩膜的技术,在这方面最成功的技术之一是mask rcnn,使用相对简单的maskpredictor扩展了更快的r-cnn检测算法,mask rcnn易于训练,具有更好的泛化能力,只会给更快的r-cnn增加很小的计算开销;前者运行速度为5帧/秒,基于mask r-cnn的实例分割方法在最近的实例分割挑战中显示了良好的结果;基于标签像素跟踪聚类方法,对图像的每个像素进行分类标记,接下来是使用聚类算法将像素分组到对象实例中;该方法受益于语义分割,可以预测高分辨率的对象掩模;与分割检测跟踪技术相比,标签像素跟踪聚类方法在经常使用的基准上精度较低;由于像素标记需要密集的计算,通常需要更多的计算能力。

5.mask r-cnn,一个相对简单和灵活的实例分割模型;该模型通过目标检测进行了实例分割,同时生成了高质量的掩模;通常faster r-cnn有一个用于识别物体边界框的分支;mask r-cnn并行添加了一个对象掩模预测分支作为改进;masklab改进了faster r-cnn,并产生两个额外的输出,即语义分割和实例中心方向;faster r-cnn给出的预测框将具有不同尺度的对象实例带入一个标准尺度,然后masklab在每个预测框内同时使用语义分割和方向预测进行前景和背景分割;为了区分不同语义类别的对象,采用了对分类数据进行像素级编码的语义分割预测方法,该技术消除了重复的背景编码;此外方向预测还被用于具有共同语义标签的对象实例的分离;non-local neuralnetworks,这个非局部神经网络可以说是图像里面attention的鼻祖,它是第一篇把注意力机制应用到图像领域,随后就有了大家熟悉的senet、sknet、 gcnet、residual attention network、cam、bam等等;非局部意味着是一种滤波技术,它计算图像中所有像素的加权平均值;在这样做的时候,它允许在一个基于路径外观相似度的位置上,远距离像素对滤波响应做出贡献;这一想法是由块匹配3d(bm3d)(block-matching 3d)相继发展起来的;长期依赖已通过图形模型来建模,例如条件随机场(crf),crf中的平均场推理可以转化为递归网络,然后可以进行训练;与机器翻译中使用的自我注意方法有关,自我关注胶囊通过观察所有位置,然后在嵌入空间内取其加权平均值,计算出序列中某个位置的响应,自注意可以看作是一种非局部均值,因此可以将机器翻译中的自注意与机器视觉中适用于图像和视频问题的一般非局部过滤操作联系起来;路径聚合网络(panet),提出了一种用于实例分割任务的基本框架,旨在提高信息的流动;改进了深层网络的特征层次,在底层使用与定位相关的特定信号,这个过程称为自底向上路径增强,它使得底层和深层网络顶层特征之间的信息路径更短;还提出了一种被称为自适应特性池的技术,它将特征网格和所有层次的特征联系起来;由于这种技术,在每一级特征的相关信息流到后续子网络用于产生建议;一个备用的分支段捕获各种提议视图,以增强生成掩码的预测;混合任务级联,最佳级联实例分割的关键是最大限度地利用对象检测和对象实例分割之间的反向关系;混合任务级联或htc与传统级联在两个重要方面有所不同;首先htc并没有对这两个任务进行层叠处理,而是以组合的方式分多个阶段进行处理;其次它使用一个完全卷积的片段来提供空间上下文,这有助于区分前景和嘈杂的背景;作者称 htc能够学习更多有用的功能,通过整合功能,这些功能是互补的,逐步与每个阶段;gcnet,由非局部网络建模的全局上下文对于整个图像的不同查询位置几乎是相同的,利用这一发现创建了一个基于独立查询公式的简单网络;提出的网络保持了非局部网络的准确性,但用更少的计算开销;gcnet的设计在结构上类似于挤压激发网络(senet),用

一个三步的通用模型来建模全球上下文;在通用模型内部,已经设计了一个更有效的实例化,称为全局上下文 (gc)块,该块是轻量级的,能够高效地建模全局上下文;轻量级的事实允许设计者在网络的多个层之间应用它,从而构建一个全局上下文网络(gcnet); mask scoring r-cnn,在mask r-cnn上增加了一个额外的mask head模块,学习mask-iou一致的mask分数;mask r-cnn与maskiou head结合,结合实例特征和预测的mask,这种安排用于预测输入掩模和ground truth掩模之间的损失。

6.实例分割目的是将输入图像中的目标检测出来,并且对目标的每个像素分配类别标签,实例分割能够对前景语义类别相同的不同实例进行区分,这是它与语义分割的最大区别,相比语义分割,实例分割发展较晚,因此实例分割模型主要基于深度学习技术,但它也是图像分割一个重要的组成部分;随着深度学习的发展,实例分割相继出现了sds(simultaneous detectionand segmentation)、deepmask、multipath network等方法,分割精度和效率逐渐得到提升;实例分割可以定义为同时解决目标检测问题和语义分割问题的技术;instance segmentation(实例分割)比起检测,需要得到物体更精确的边界信息;比起语义分割,需要区分不同的物体个体,所以说它要解决的问题是检测(object detection)和语义分割(semantic segmentation) 综合的问题;实例分割(instance segmentation)是视觉经典四个任务(分类、定位、检测和分割)中相对最难的一个,它既具备语义分割(semanticsegmentation)的特点,需要做到像素层面上的分类,也具备目标检测(objectdetection)的一部分特点,即需要定位出不同实例,即使它们是同一种类。因此,实例分割的研究长期以来都有着两条线,分别是自下而上的基于语义分割的方法和自上而下的基于检测的方法,这两种方法都属于两阶段的方法;一、自上而下的实例分割方法:思路是:首先通过目标检测的方法找出实例所在的区域(bounding box),再在检测框内进行语义分割,每个分割结果都作为一个不同的实例输出;自上而下的密集实例分割的开山鼻祖是deepmask,它通过滑动窗口的方法,在每个空间区域上都预测一个mask proposal。这个方法存在以下三个缺点:1.mask与特征的联系(局部一致性)丢失了,如 deepmask中使用全连接网络去提取mask;2.特征的提取表示是冗余的,如 deepmask对每个前景特征都会去提取一次mask;3.下采样(使用步长大于1 的卷积)导致的位置信息丢失;二、自下而上的实例分割方法:思路是:首先进行像素级别的语义分割,再通过聚类、度量学习等手段区分不同的实例,这种方法虽然保持了更好的低层特征(细节信息和位置信息),但也存在以下缺点:1.对密集分割的质量要求很高,会导致非最优的分割;2.泛化能力较差,无法应对类别多的复杂场景;3.后处理方法繁琐;单阶段实例分割(singleshot instance segmentation),这方面工作其实也是受到了单阶段目标检测研究的影响,因此也有两种思路,一种是受one-stage,anchor-based检测模型如yolo,retinanet启发,代表作有yolact和solo;一种是受anchor-free 检测模型如fcos启发,代表作有polarmask和adaptis;实例分割两个趋势:一个是yolcat,rdsnet,blendmask(retinanet,fcos,polarmask发展而来) 单阶段基于硬编码(embedding)的实例分割;另一个是solo(fcis)区分位置信息的方式。

7.医学图像分割已引起广泛关注,因为它在生物医学图像分析中很重要,好的实例分割结果可以辅助医生判断,进一步提升患者体验;许多研究人员在实例分割领域取得了一定的进展,但是这些方法的应用具有一定局限性,对于非限定条件下的实例分割方法仍

存在一些问题和难点,所以解决由于几何变换问题、遮挡问题、图像退化问题、小物体分割问题等因素造成的实例分割精度较低的问题仍然是十分重要且具有实际意义的研究内容,在实际设计和使用中仍面临许多问题,主要体现在以下几个方面:

8.(1)基于卷积神经网络架构在视觉任务上已被证实非常成功,cnn强大的归纳偏置使得样本高效学习成为可能,但代价是可能会降低性能上限;而视觉transformer(如vit)依赖于更加灵活的自注意力层,最近在一些视觉任务上性能已经超过了cnn,但vit对样本的需求量更大;如何取长补短,克服了cnn和transformer本身的一些局限性是其中一个有待解决的问题。

9.(2)深层的神经网络一般有更大的感受野,对姿态,形变,光照等更具有鲁棒性,但是分辨率(resolution)比较低,细节也丢失了;浅层的神经网络的感受野比较窄,细节比较丰富,分辨率比较大,但缺少了语义上的信息;因此,如果一个物体比较小时,它的细节在浅层的cnn层中会更少,同样的细节在深层网络中几乎会消失;解决这个问题的方法使用混合模型同时利用卷积与自注意力的特性,取得优于纯注意力模型的效果,有效的结合全局和局部信息,将全局信息聚合(更大的感受野)和局部(小的感受野)信息聚合有效的结合在一起;此外深度可分离卷积结构相比普通卷积拥有更少的参数以及更小的flops,但通常无法充分利用现有的一些加速器,虽然理论上计算量很小,但实际使用起来并没有想象中那么快。,因此,针对上述问题亟需改进针对现有技术的不足,本发明公开了一种基于深度学习牙齿目标实例分割及其智能预览的方法,以解决上述问题。

技术实现要素:

10.本发明的目的在于提供一种基于深度学习牙齿目标实例分割及其智能预览的方法,它提供了一种方便和高效的信息化医疗空间,并依托深度学习技术,实现牙科医疗模型快捷和精准的图形化视觉效果。

11.为解决上述问题,本发明采用如下的技术方案:

12.一种基于深度学习牙齿目标实例分割有监督学习方法,其特征在于,包括以下几个步骤:

13.步骤1、准备单张视频帧或图像的牙齿目标分割训练数据与测试数据;

14.步骤2、利用手机和摄像头采集图像数据;

15.步骤3、视频帧或手机图像实例分割模型网络架构设计;

16.步骤4、训练:训练配置从基线模型到最终模型基本一致,在自己数据上训练n(总训练代数)代并进行n代的warm-up,训练初始warm-up把学习率设置得很小,随着训练的进行,学习率逐渐上升,最终达到正常训练的学习率;随着训练的进行,神经网络希望逐渐减小学习率(learning rate decay),训练完成时learning rate降为0;优化器为sgd,初始学习率为η,cosine 学习机制,weight decay设置为0.0005,momentum设置为0.9,batch视硬件设备而定;神经网络输入端选定mosaic、cmbn和sat自对抗训;所述cmbn只在每个batch内部使用cbn的方法,如果每个batch被分割为一个mini batch,则其效果与bn一致;若分割为多个mini batch,则与cbn类似,只是把mini batch 当作batch进行计算,其区别在于权重更新时间点不同,同一个batch内权重参数一样,因此计算不需要进行补偿;随机初始化各层的连接权值w和偏置b, 神经网络选定激活函数为mish,mish非单调且平滑;确定好以上

各个参数之后将标注图像按批次输入网络模型的体系结构神经网络,通过预测模块预测一个和目标对应的掩码,进行最后的卷积输出结果;

17.步骤5、模型使用:获取摄像头图像或者手机图像,模型输出即为每个牙齿实例分割目标包围框的大小与牙齿实例目标的标签;

18.步骤6、模型迭代:搜集一批新的数据,让模型去分割这一批数据,将实例分割结果划分为两大类有框图像和无框图像,有框图像又分为真正目标图像和误报目标图像,无框图像又可分为未检测目标的图像和图像中本来就没有目标的图像,其中将误报目标图像作为负样本,将含有牙齿目标但未实例分割到的图像作为训练样本,随后这些没检测到目标图像进行数据标注和数据增强,然后在原有模型的基础上在训练出一个新的模型,测试模型效果检查精度是否达标,如果新的模型未达标加入新的数据并对网络调整参数训练,如果模型精度已经达到要求并且在目前训练数据下最优时停止训练,循环这个步骤以达到模型适合实际环境中样本的复杂度。

19.作为发明的优选方案,所述步骤2中图像采集人员使用手机和摄像头采集目标图像主要分为左侧面数据图像、正面数据图像和右侧面数据图像,图像采集人员尽量搜集不同人员、不同光照、不同角度的牙齿数据,数据采集完成之后利用labelme工具对采集的数据进行标注,根据不同的神经网络训练标签数据要求将标签数据转化相应的格式,此外训练数据按总数据的80%比例作为训练数据,测试数据按总数据的20%比例作为测试数据。

20.作为发明的优选方案,所述步骤3中模型网络总体架构框架由以下几个部分组成:一个3*3卷积,3个ind_tra模块、3个dwind_tra模块和实例分割预测头部;3*3卷积进行一次特征提取并进行一次降采样,是宽和高变为输入的二分之一,同时还可以降低了ind_tra模块中con_transformer的参数量(相较于原图);ind_tra模块:一路是旁路连接分支,另外一路是一个常规3*3卷积,紧接着串联一个con_transformer,其后是一个逐点卷积,最后是一个具有结构化dropblock;所述ind_tra模块中的3*3卷积第一个模块通道数不变,第二个和第三个通道数扩张为原来的四倍。

21.作为发明的优选方案,所述步骤3.1中所述ind_tra模块中 con_transformer可以使卷积有效学习大尺度图像中抽象和低分辨率的特征图,全局自注意力又可以处理和汇总特征图中包含的信息,使全局信息聚合和局部信息聚合有效的结合,深层的神经网络一般有更大的感受视野,对姿态,形变,光照等更具有鲁棒性,但是分辨率比较低,细节也丢失了;浅层的神经网络的感受野比较窄,细节比较丰富,分辨率比较大,但缺少了语义上的信息;所述con_transformer有效的缓和了一个物体比较小时,它的细节在浅层的cnn层中会更少,同样的细节在深层网络中几乎会消失的问题;所述dropblock:在一个特征图中,删除连续的特征单元像素(使其block失活),这样可以有效的删除语义信息(丢失的语义信息无法从它相邻的像素单元中获取,因为它相邻的单元也失活了),迫使剩余的像素单元学习更多的语义信息,防止过拟合。

22.作为发明的优选方案,所述步骤3.1中的ind_tra模块,则它是有效的结合全局和局部信息,将全局信息聚合和局部信息聚合有效的结合在一起构造一个搞笑的神经网络模块;此外深度可分离卷积结构相比普通卷积拥有更少的参数以及更小的flops,但通常无法充分利用现有的一些加速器,虽然理论上计算量很小,但实际使用起来并没有想象中那么快,模块中并没有使用深度可分离卷积;con_transformer将位置编码当成空间注意力来处

理,嵌入两个可学习的向量rh和rw(横纵两个维度的空间注意力),rh和rw指的是高度和宽度的相对位置编码,然后将相加融合后的空间向量于q相乘得到文本位置(引入了空间先验),将文本位置和注意力得分特征(q和k相乘的结果) 相加得到空间敏感的相似性特征,使得con_transformer中的多头部自注意力关注合适区域,更容易收敛;con_transformer整体操作流程:输入特征x,利用wq、wk和wv矩阵对输入的特征进行矩阵相乘得到q、k和v,q和k相乘得到特征注意力得分特征图,q和位置编码相乘得到文本位置,所述位置编码是横纵两个维度的空间注意力相加得到的,即相对位置编码的高和宽相加得到的,文本位置和注意力得分特征(q和k相乘的结果)相加得到空间敏感的相似性特征,空间敏感的相似性特征通过softmax计算每一个相似性特征关注的比重,基于特征关注比例提取特征得到特征z,即v和特征关注比例相乘得到。

23.作为发明的优选方案,所述步骤3.1中的dwind_tra模块的设计原则就是克服cnn和transformer的局限性,使设计的模块兼具两者优点;在视觉任务上非常成功的cnn依赖于架构本身内置的两个归纳偏置:局部相关性:邻近的像素是相关的;权重共享:图像的不同部分都以相同的方式处理,无论它们的绝对位置如何。

24.作为发明的优选方案,所述步骤3.1中ind_transformer是在vit的基础上,将一些自注意力层用门控位置自注意力层替代,gpsa层涉及位置信息,因此在最后一个gpsa层之后,类token(特征向量)会与隐藏表征联系到一起,使用卷积归纳偏置进行初始化,模块可以在必要时学会忽略这些偏置;自注意力是注意力的一种特殊情况,其中序列与其自身匹配,以提取其各部分之间的语义依赖关系,多头自注意力层则是并行使用多个自注意力头,以允许学习不同类型的相互依赖性;每个注意力头使用可训练的嵌入vpos,相对位置编码rij仅取决于像素i和j之间的距离,用二维向量δij表示;gpsa 中最特别的就是aij的求法;在上文提到了,当q=k=0时,注意力头的输出才类似于卷积;而σ是sigmoid函数,当λ趋于无穷时,σ(λ)趋于1,q*k 部分的系数就会趋于0,达到卷积的效果;但为了防止λ一直远大于1,所以每个注意力头的初始值均设为1,然后在不断的训练过程中,模型自行调整每个位置的λ,在注意力图和卷积之间做均衡和取舍。

25.作为发明的优选方案,所述步骤4中模型训练中在硬件满足要求的情况下使用多个显卡,训练所用的深度学习框架为pytorch,pytorch的多gpu(显卡)并行处理机制是,首先将模型加载到主gpu上,然后再将模型复制到各个指定的从gpu中,然后将输入数据按batch(批次)维度进行划分,具体来说就是每个gpu分配到的数据batch数量是总输入数据的batch除以指定 gpu个数;每个gpu将针对各自的输入数据独立进行forward(前向传播) 计算,最后将各个gpu的loss(损失)进行求和,再用反向传播更新单个gpu 上的模型参数,再将更新后的模型参数复制到剩余指定的gpu中,这样就完成了一次迭代计算;确定以上神经网络参数之后,输入处理后的数据,反复迭代直到神经网络输出层误差达到预设精度要求或训练次数达到最大迭代次数,结束训练,保存网络结构和参数,得到训练好的神经网络模型。

26.一种基于深度学习牙齿目标实例分割智能预览的方法,所述方法的详细流程为算法服务包监听到有任务请求,随后加载实例分割模型对输入的图像进行预测,最后经过前端在智能预览显示结果。

27.相比于现有技术,本发明的优点在于:

28.本方案的分割结果能够辅助医生判断,进一步提升患者体验;所述方法由三部分组成:图像输入、实例分割处理、分割结果输出;图像输入后,模型使用高效骨干网络提取图像特征,然后通过实例分割模型进行处理,模型中可以先通过目标检测判定目标实例的位置和类别,然后在所选定区域位置进行分割,或者先执行语义分割任务,再区分不同的实例,最后输出实例分割结果;上面所述方法为牙科医疗提供了一种方便和高效的信息化医疗空间,并依托深度学习技术,实现牙科医疗模型快捷和精准的图形化视觉效果。

附图说明

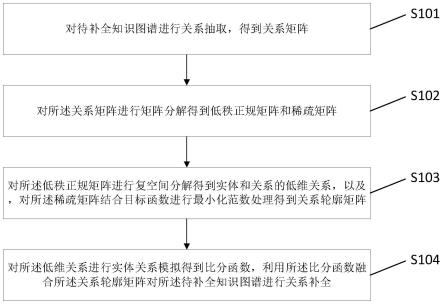

29.图1为本发明的牙齿实例分割展示流程框图。

30.图2为本发明的实例分割神经网络架构图。

31.图3为本发明的ind_tra模块结构图。

32.图4为本发明的con_transformer操作流程图。

33.图5为本发明的dwind_tra模块结构图。

34.图6为本发明的ind_transformer结构图。

35.图7为本发明的gpsa结构图。

具体实施方式

36.下面将结合本发明实施例中的附图对本发明实施例中的技术方案进行清楚、完整地描述。显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例,基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

37.在本发明的描述中,需要说明的是,术语“上”、“下”、“内”、“外”、“顶 /底端”等指示的方位或位置关系为基于附图所示的方位或位置关系,仅是为了便于描述本发明和简化描述,而不是指示或暗示所指的装置或元件必须具有特定的方位、以特定的方位构造和操作,因此不能理解为对本发明的限制。此外,术语“第一”、“第二”仅用于描述目的,而不能理解为指示或暗示相对重要性。

38.在本发明的描述中,需要说明的是,除非另有明确的规定和限定,术语“安装”、“设置有”、“套设/接”、“连接”等,应做广义理解,例如“连接”,可以是固定连接,也可以是可拆卸连接,或一体地连接;可以是机械连接,也可以是电连接;可以是直接相连,也可以通过中间媒介间接相连,可以是两个元件内部的连通。对于本领域的普通技术人员而言,可以具体情况理解上述术语在本发明中的具体含义。

39.实施例:

40.请参阅图1-7,本发明公开了一种基于深度学习牙齿目标实例分割及其智能预览的方法,分割结果辅助医生判断,进一步提升患者体验;所述方法由三部分组成:图像输入、实例分割处理、分割结果输出;图像输入后,模型使用高效骨干网络提取图像特征,然后通过实例分割模型进行处理,模型中可以先通过目标检测判定目标实例的位置和类别,然后在所选定区域位置进行分割,或者先执行语义分割任务,再区分不同的实例,最后输出实例分割结果;上面所述方法为牙科医疗提供了一种方便和高效的信息化医疗空间,并依托深度学习技术,实现牙科医疗模型快捷和精准的图形化视觉效果,下面结合附图对本发明的

具体实施方式做详细的说明。

41.步骤1:本发明为实地应用提供了一种基于深度学习牙齿目标实例分割及其智能预览的方法,它适用于如图1所示的应用流程,本发明所述应用为视频或者图像中牙齿实例分割及其图形化视觉显示系统,包括实例分割算法、图像采集设备和智能显示设备;所述方法是通过摄像头或手机拍摄的图像,加载牙齿实例分割算法并检测出结果,最后将结果在智能设备上显示;需要说明的是,本发明实地应用中提供过的方法还可以进一步的扩展到其他合适的应用环境中,而不限于图1所示的应用环境,在实际的应用过程中,该应用环境还可以包括医院中的各种病理显示或者诊所牙科的辅助显示。

42.步骤2:单张视频帧或图像的牙齿目标分割训练数据与测试数据准备:

43.步骤2.1手机和摄像头图像数据采集:图像采集人员使用手机和摄像头采集目标图像主要分为左侧面数据图像、正面数据图像和右侧面数据图像,图像采集人员尽量搜集不同人员、不同光照、不同角度的牙齿数据,数据采集完成之后利用labelme工具对采集的数据进行标注,根据不同的神经网络训练标签数据要求将标签数据转化相应的格式,此外训练数据按总数据的80%比例作为训练数据,测试数据按总数据的20%比例作为测试数据。

44.步骤3视频帧或手机图像实例分割模型网络架构设计:

45.步骤3.1模型网络总体架构如图2所示,框架由以下几个部分组成:一个3*3卷积,3个ind_tra模块、3个dwind_tra模块和实例分割预测头部;3*3 卷积进行一次特征提取并进行一次降采样,是宽和高变为输入的二分之一,同时还可以降低了ind_tra模块中con_transformer的参数量(相较于原图); ind_tra模块:一路是旁路连接分支,另外一路是一个常规3*3卷积,紧接着串联一个con_transformer,其后是一个逐点卷积,最后是一个具有结构化 dropblock;所述ind_tra模块中的3*3卷积第一个模块通道数不变,第二个和第三个通道数扩张为原来的四倍;所述ind_tra模块中con_transformer可以使卷积有效学习大尺度图像中抽象和低分辨率的特征图,全局自注意力又可以处理和汇总特征图中包含的信息,使全局信息聚合和局部信息聚合有效的结合,深层的神经网络一般有更大的感受野,对姿态,形变,光照等更具有鲁棒性,但是分辨率比较低,细节也丢失了;浅层的神经网络的感受野比较窄,细节比较丰富,分辨率比较大,但缺少了语义上的信息;所述 con_transformer有效的缓和了一个物体比较小时,它的细节在浅层的cnn层中会更少,同样的细节在深层网络中几乎会消失的问题;所述dropblock:在一个特征图中,删除连续的特征单元像素(使其block失活),这样可以有效的删除语义信息(丢失的语义信息无法从它相邻的像素单元中获取,因为它相邻的单元也失活了),迫使剩余的像素单元学习更多的语义信息,防止过拟合;其优势在于:1.可以丢弃更多的语义信息,2.训练出来的网络鲁棒性更强,3.可以学到更多空间上的分步表示;网络浅层中使用深度可分离卷积速度会是网络变慢,虽然深度可分离卷积结构相比普通卷积拥有更少的参数以及更小的flops,但通常无法充分利用现有的一些加速器(虽然理论上计算量很小,但实际使用起来并没有想象中那么快),为了更好的利用移动端或服务端的加速器,在ind_tra模块中不使用深度可分离卷积;如果将所有阶段都替换成ind_tra模块结构会明显增加参数数量以及flops,训练速度也会降低;所以后面三个模块使用了dwind_tra模块,一个分支是旁路链接,另外一个分支是首先利用逐点卷积进行通道扩张,然后利用3*3的深度可分离卷积进行局部特征提取,随后利

用ind_transformer进行全局特征提取,紧接着是一个逐点卷积进行特征融合和特征通道降维,最后进行一个dropblock;cnn (卷积神经网络)强大的归纳偏置使得即使使用非常少的数据也能实现高性能,但当存在大量数据时,这些归纳偏置就可能会限制模型;相比之下, transformer具有最小的归纳偏置,这说明在小数据设置下是存在限制的,但同时这种灵活性让transformer在大数据上性能优于cnn;ind_transformer能够克服上面的局限性,兼具两者的优点;同时ind_transformer允许模型自行决定是否要保持卷积,门控位置自注意力(gated positionalself-attention,gpsa)的位置自注意力形式,其模型学习门控参数λ,该参数用于平衡基于内容的自注意力和卷积初始化位置自注意力;最后实例分割预测头部预测出输入图像的每一个像素点属于哪一类的标签,并且再哪一类的基础上,还需要区分出同一类不同的个体,实例分割预测头部的损失函数使用softmax_with_cross_entropy。

46.步骤3.2在步骤3.1中如图3所示,神网网络架构中的ind_tra模块,则它是有效的结合全局和局部信息,将全局信息聚合和局部信息聚合有效的结合在一起构造一个搞笑的神经网络模块;此外深度可分离卷积结构相比普通卷积拥有更少的参数以及更小的flops,但通常无法充分利用现有的一些加速器,虽然理论上计算量很小,但实际使用起来并没有想象中那么快,如图3 所示模块中并没有使用深度可分离卷积;如图4所示con_transformer,它将位置编码当成空间注意力来处理,嵌入两个可学习的向量rh和rw(横纵两个维度的空间注意力),rh和rw指的是高度和宽度的相对位置编码,然后将相加融合后的空间向量于q相乘得到文本位置(引入了空间先验),将文本位置和注意力得分特征(q和k相乘的结果)相加得到空间敏感的相似性特征,使得 con_transformer中的多头部自注意力关注合适区域,更容易收敛; con_transformer整体操作流程:输入特征x,利用wq、wk和wv矩阵对输入的特征进行矩阵相乘得到q、k和v,q和k相乘得到特征注意力得分特征图,q和位置编码相乘得到文本位置,所述位置编码是横纵两个维度的空间注意力相加得到的,即相对位置编码的高和宽相加得到的,文本位置和注意力得分特征(q和k相乘的结果)相加得到空间敏感的相似性特征,空间敏感的相似性特征通过softmax计算每一个相似性特征关注的比重,基于特征关注比例提取特征得到特征z,即v和特征关注比例相乘得到。

47.步骤3.3在步骤3.1中dwind_tra模块如图5所示,dwind_tra模块设计原则就是克服cnn和transformer的局限性,使设计的模块兼具两者优点;在视觉任务上非常成功的cnn依赖于架构本身内置的两个归纳偏置:局部相关性:邻近的像素是相关的;权重共享:图像的不同部分都以相同的方式处理,无论它们的绝对位置如何;ind_transformer如图6所示,它是在vit的基础上,将一些自注意力层用门控位置自注意力层替代,gpsa层涉及位置信息,因此在最后一个gpsa层之后,类token(特征向量)会与隐藏表征联系到一起,使用卷积归纳偏置进行初始化,模块可以在必要时学会忽略这些偏置;自注意力是注意力的一种特殊情况,其中序列与其自身匹配,以提取其各部分之间的语义依赖关系,多头自注意力层则是并行使用多个自注意力头,以允许学习不同类型的相互依赖性;每个注意力头使用可训练的嵌入vpos,相对位置编码rij仅取决于像素i和j之间的距离,用二维向量δij表示;gpsa中最特别的就是aij的求法。在上文提到了,当q=k=0时,注意力头的输出才类似于卷积。而σ是sigmoid函数,当λ趋于无穷时,σ(λ)趋于1,q*k部分的系数就会趋于0,达到卷积的效果;但为了防止λ一直远大于1,所以每个注意力头的初始值均设为1,然后在不断的训练过

程中,模型自行调整每个位置的λ,在注意力图和卷积之间做均衡和取舍。

48.步骤3.4:训练:训练配置从基线模型到最终模型基本一致,在自己数据上训练n(总训练代数)代并进行n代的warm-up,训练初始warm-up把学习率设置得很小,随着训练的进行,学习率逐渐上升,最终达到正常训练的学习率,这个阶段就是warm-up的核心阶段,随着训练的进行,神经网络希望逐渐减小学习率(learning rate decay),训练完成时learning rate降为0;优化器为sgd,初始学习率为η,cosine学习机制,weight decay设置为0.0005, momentum设置为0.9,batch视硬件设备而定;神经网络输入端选定mosaic、 cmbn和sat自对抗训;所述cmbn只在每个batch内部使用cbn的方法,如果每个 batch被分割为一个mini batch,则其效果与bn一致;若分割为多个minibatch,则与cbn类似,只是把mini batch当作batch进行计算,其区别在于权重更新时间点不同,同一个batch内权重参数一样,因此计算不需要进行补偿;随机初始化各层的连接权值w和偏置b,神经网络选定激活函数为mish,mish非单调且平滑;确定好以上各个参数之后将标注图像按批次输入网络模型的体系结构神经网络,通过预测模块预测一个和目标对应的掩码,进行最后的卷积输出结果。

49.模型训练中在硬件满足要求的情况下使用多个显卡,训练所用的深度学习框架为pytorch,pytorch的多gpu(显卡)并行处理机制是,首先将模型加载到主gpu上,然后再将模型复制到各个指定的从gpu中,然后将输入数据按 batch(批次)维度进行划分,具体来说就是每个gpu分配到的数据batch数量是总输入数据的batch除以指定gpu个数;每个gpu将针对各自的输入数据独立进行forward(前向传播)计算,最后将各个gpu的loss(损失)进行求和,再用反向传播更新单个gpu上的模型参数,再将更新后的模型参数复制到剩余指定的gpu中,这样就完成了一次迭代计算;确定以上神经网络参数之后,输入处理后的数据,反复迭代直到神经网络输出层误差达到预设精度要求或训练次数达到最大迭代次数,结束训练,保存网络结构和参数,得到训练好的神经网络模型。

50.步骤3.5:模型使用:获取摄像头图像或者手机图像,模型输出即为每个牙齿实例分割目标包围框的大小与牙齿实例目标的标签。

51.步骤3.6:模型迭代:搜集一批新的数据,让模型去分割这一批数据,将实例分割结果划分为两大类有框图像和无框图像,有框图像又分为真正目标图像和误报目标图像,无框图像又可分为未检测目标的图像和图像中本来就没有目标的图像,其中将误报目标图像作为负样本,将含有牙齿目标但未实例分割到的图像作为训练样本,随后这些没检测到目标图像进行数据标注和数据增强,然后在原有模型的基础上在训练出一个新的模型,测试模型效果检查精度是否达标,如果新的模型未达标加入新的数据并对网络调整参数训练,如果模型精度已经达到要求并且在目前训练数据下最优时停止训练,循环这个步骤以达到模型适合实际环境中样本的复杂度。

52.步骤4:所述一种基于深度学习牙齿目标实例分割及其智能预览的方法,所述方法的详细流程为算法服务包监听到有任务请求,随后加载实例分割模型对输入的图像进行预测,最后经过前端在智能预览显示结果。

53.一种基于深度学习牙齿目标实例分割智能预览的方法,所述方法的详细流程为算法服务包监听到有任务请求,随后加载实例分割模型对输入的图像进行预测,最后经过前端在智能预览显示结果。

54.技术效果:本发明公开了一种基于深度学习牙齿目标实例分割及其智能预览的方法,分割结果辅助医生判断,进一步提升患者体验;所述方法由三部分组成:图像输入、实例分割处理、分割结果输出;图像输入后,模型使用高效骨干网络提取图像特征,然后通过实例分割模型进行处理,模型中可以先通过目标检测判定目标实例的位置和类别,然后在所选定区域位置进行分割,或者先执行语义分割任务,再区分不同的实例,最后输出实例分割结果;上面所述方法为牙科医疗提供了一种方便和高效的信息化医疗空间,并依托深度学习技术,实现牙科医疗模型快捷和精准的图形化视觉效果。其技术关键在于:

55.(1)ind_tra模块中con_transformer可以使卷积有效学习大尺度图像中抽象和低分辨率的特征图,全局自注意力又可以处理和汇总特征图中包含的信息,使全局信息聚合和局部信息聚合有效的结合,深层的神经网络一般有更大的感受野,对姿态,形变,光照等更具有鲁棒性,但是分辨率比较低,细节也丢失了;浅层的神经网络的感受野比较窄,细节比较丰富,分辨率比较大,但缺少了语义上的信息;所述con_transformer有效的缓和了一个物体比较小时,它的细节在浅层的cnn层中会更少,同样的细节在深层网络中几乎会消失的问题;

56.(2)dropblock:在一个特征图中,删除连续的特征单元像素(使其block 失活),这样可以有效的删除语义信息(丢失的语义信息无法从它相邻的像素单元中获取,因为它相邻的单元也失活了),迫使剩余的像素单元学习更多的语义信息,防止过拟合;其优势在于:1.可以丢弃更多的语义信息,2.训练出来的网络鲁棒性更强,3.可以学到更多空间上的分步表示;

57.(3)cnn(卷积神经网络)强大的归纳偏置使得即使使用非常少的数据也能实现高性能,但当存在大量数据时,这些归纳偏置就可能会限制模型;相比之下,transformer具有最小的归纳偏置,这说明在小数据设置下是存在限制的,但同时这种灵活性让transformer在大数据上性能优于cnn; ind_transformer能够克服上面的局限性,兼具两者的优点;

58.(4)依据神经网络实例分割的结果,分割结果辅助医生判断,进一步提升患者体验。

59.以上所述,仅为本发明较佳的具体实施方式,但本发明的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本发明揭露的技术范围内,根据本发明的技术方案及其改进构思加以等同替换或改变,都应涵盖在本发明的保护范围内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。