1.本发明属于行为识别领域,具体涉及一种基于三维卷积的时空特征多层次融合的行为识别方法。

背景技术:

2.目前计算机视觉技术已经被广泛应用到我们的日常生活中,深度学习技术的发展也在逐渐解决了计算机视觉中的种种问题。计算机视觉作为一项跨学科的领域,研究如何从数字图像或者视频中获得高级的理解,使用计算机来代替人眼实现对目标物体的识别、追踪以及其他视觉问题,使得计算机在某些方面胜于人眼的图像处理能力。视频理解作为计算机视觉中的重要方向,其任务之一就是理解人类的行为,在视频中识别人类行为的任务被称为视频动作理解,比如常见的弹琴,骑车,打球等。从人眼对视频中的行为识别经验不难发现,决定一个视频中的行为类别主要由视频的空间特点和时间变化决定。当视频中出现明显的空间特点,比如弹琴行为中,视频中一定会有琴这一目标。如果根据单张视频帧进行识别,就会忽略该行为的连续性,行为识别任务退化成图像分类任务,虽然对于某些特殊行为,比如打球,图像分类任务也会有效。但是对于大部分行为而言,视频帧之间的时间特征对于识别该行为而言是必不可少的,比如跑步和原地跳这种在时间变化下才能表现出区分性的运动,如果忽略时间特征,将很难区分。因此对视频中提取到的时空特征的综合表现能力最终决定了深度学习模型的行为识别能力。

3.目前,基于这两类特征信息,最常用的框架是双流卷积网络,将空间信息流和时间信息流分开学习,最后将两者进行融合,这种方法改进了传统方法中仅对时间或者空间特征提取的问题。在双流卷积网络提出后,其难点之一在于所需要的计算是密集型的且存储要求高,不利于大规模训练或实时的部署。人们开始寻找可替代的方法,一些研究人员认为可以将时间信息作为的另一个维度,同时输入到网络中进行特征提取,此时卷积网络便由二维转变为三维,也可以实现网络的端到端,简化训练过程。随着硬件的发展,计算机的计算能力也越来越强,直接训练3d网络也逐渐容易,计算量对于计算机硬件也不再是最大的难题,采用3d卷积网络作为主干网络也成为现实。但是基于双流卷积的行为识别网络模型仍旧普遍存在两个问题:由于视频是由有序图像帧组成的,但是不同行为下,视频的时间维度和空间维度表现出来的重要性却不相同,如果将时间特征和空间特征以同样的权重组合利用分类器分类,必然会导致两者不平衡,从而影响分类结果。另外,目前对于时间特征提取的许多方案,都无法同时提取到时间上的大目标和小目标,比如正常人的慢跑行为可能被误认为行走,两种行为目标的节奏变化在时间上的区分性并不明显,因此提取时间特征的时候要同时兼顾全局时间特征和局部时间特征。

技术实现要素:

4.针对以上现有技术中存在的不足之处,本发明的目的在于,提供一种基于三维卷积的时空特征多层次融合的行为识别方法,该方法将三维卷积的时空特征多层次融合的双

流网络用于视频行为识别,均衡了视频中时间特征和空间特征的重要性,并且解决了时间特征提取过程中容易忽略行为视觉节奏而引起的行为难以区分的问题,从而最终有效提高了视频行为识别的准确率。

5.为了实现上述任务,本发明采取如下的技术解决方案:

6.一种基于三维卷积的时空特征多层次融合的行为识别方法,其特征在于,包括如下步骤:

7.s1:采用包含多种动作类和多视频段的kinetic400公开数据集作为实验数据集,从数据集中的各个视频片段等间隔的取出部分帧分别作为时空特征双流卷积网络中时间特征提取网络和空间特征提取网络的输入;

8.s2:构建基于时间和空间的双流网络,包括帧抽取模块、时间特征提取网络、空间特征提取网络和多层次特征融合模块;

9.时间特征提取网络和空间特征提取网络的结构包括多阶段的卷积层,全局池化层以及全连接层和softmax层,其中,全局池化层和全连接层构成分类器,softmax层用来对识别结果的归一化;

10.时间特征提取网络用于提取整段视频包含行为的多层次时间特征信息;空间特征提取网络用于提取整段视频包含行为的多层次空间特征信息,多层次特征融合模块用于进行多层次的特征融合,分类器用于对融合后的特征进行给出行为预测的结果;

11.在时间特征提取网络和空间特征提取网络的后面阶段将提取到的不同层次的特征作为多层次特征融合模块的输入;

12.s3:多层次特征融合模块针对不同层次的时间特征图和空间特征图进行采样操作,对特征图进行维度对齐,然后分别在时间和空间特征内部进行上下两方向上的特征融合,增强和丰富各个层次上的特征语义表达,接着将空间融合后的特征和时间融合后的特征进一步全融合,最终获得该视频下不同层次时空特征融合后的行为特征;将该特征输入到分类器中分类;

13.s4:在分类器中,输入特征经过全局平均池化和级联的操作,最后放入全连接层中对视频中的行为进行分类。

14.具体地,所述的时间特征提取网络和空间特征提取网络采用的backbone网络为3d resnet50。

15.进一步地,从数据集提供的行为视频段中等间距采样64帧默认代表整个视频段,然后再分别等间距取32帧和4帧,分别对应于时间特征提取网络和空间特征提取网络两个网络通道中的输入进行特征提取。

16.优选地,所述多层次融合时间特征和空间特征包括:

17.所述时间特征提取网络和空间特征提取网络会将最后两个阶段提取到的不同层次的时间特征和空间特征都馈入多层次特征融合模块,两个层次对应不同的感受野;多层次特征融合模块中,先对空间特征中两个层次上的特征做空间维度上的下采样对齐语义操作,接着对时间维度采样,除行为分类的分类损失函数之外,对齐模块增加额外的损失函数保证对齐维度后特征的有效性;空间特征内部进行两个层次特征融合时候,对时间维度上高维的特征进行下采样,对时间维度上低维的特征进行上采样,时间维度保持一致后,采用自下而上和自上而下相结合的融合方式融合不同方向上的空间特征;并对时间特征做与空

间特征相同的操作和融合处理;最后再将多层次融合后的时间特征和空间特征再进行全融合。

18.本发明的基于三维卷积的时空特征多层次融合的行为识别方法,使用双流网络分别提取视频中行为的时间特征和空间特征,扩大视频中空间和时间维度上的感受野,有效保留视频中的视觉节奏,采用多层次特征融合方式平衡时间和空间特征,而非对时空特征简单拼接,增强特征之间的辨别力和区分性,从而提高了视频行为识别的准确率。

附图说明

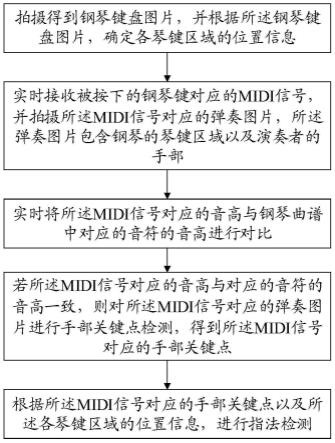

19.图1为本发明提出的行为识别方法的时空特征双流网络结构示意图。

20.图2为多层次特征融合模块结构示意图。

21.图3为针对提取到的特征图处理的具体示意图。

22.图4为特征自上而下和自下而上的融合方式示意图。

23.图5为时间和空间特征全融合方式示意图。

24.下面将结合附图和具体实例,对本发明的作进一步详细的说明:

具体实施方式

25.本技术的设计思路是,根据研究表明,对于人眼来说,黑白图片蕴含的信息往往没有rbg三通道的图片所蕴含的信息丰富,图片蕴含的信息往往没有视频充分,所以往往多维的数据包含更加详细和深入的有用信息,这一现象无论在常识中还是在理论里都是成立的。因此,可以对图片进行多维的分解将会得到更加深层次的特征。在2d的卷积网络中,通常来说,对于图片的特征提取,只需要将图片在足够多的通道上进行分解,那么图片的富含空间信息的特征将会很容易被提取出来这一思路在对图片的特征提取中很常见,由于视频是由多帧的图片组成,同样,在视频中这一思路也很容易考虑到。所以,为了获取视频中富含空间特征的信息,设计空间特征提取层就是为了提取视频中的空间信息,例如打篮球的行为必然在多数视频帧中会出现篮球和运动员,首先将这些简单的易于提取的特征在空间特征提取网络中进行提取。

26.其次,视频的时间特征同样重要,如果仅仅只采用对空间特征的提取,那么视频的行为识别就会变成基于单张图像的行为识别。尽管特征提取网络的越来越复杂,但是,基于视频的行为识别难点之一还是对视频时间特征的提取。对于这一问题,设计了时间特征提取的框架,设计在时间上的分辨率,即尽可能将多帧视频帧放入时间特征提取层。由于所使用的卷积核是三维的卷积核,在时间特征提取层中,还可以降低对视频帧在多通道上的空间特征提取,既可以降低网络的复杂度还可以使提取的特征更偏向于时间的特征。基于上述原因,本技术采用了双流的网络框架。

27.但是,仅仅将空间特征提取框架和时间特征提取框架中的特征进行简单的拼接作为整个视频的特征,也存在很多问题。例如,不同的行为下行为的表现侧重点不同,对于跑步和走路的区别更多的时间的特征,而对于游泳和打球,更多的差别是在于场景信息的特征差异。因此,需要均衡空间特征和时间特征对最后分类结果的影响。

28.本技术设计采用三维卷积,在三维卷积神经网络中,宏观上,尽管可以根据设置固定的通道数和时间分辨率提取到时空特征,但是却无法在不同感受野上将时间和空间区域

的特征全部考虑进网络。因为浅层网络(下层网络)感受野小,只能感受到纹理等细粒度的特征,在此小目标的特征和大目标特征在这些层的特征比例分布还算均衡,还能被损失函数识别,因此能被识别出来。但是在深层网络(上层网络),感受野大,能综合更多的语义信息,小目标在此这层特征表达能力不足或者特征数量不足,导致和大目标特征信息比例严重失衡,无法被损失函数识别。在时间特征提取层中,浅层网络感受野小,只能感受到快节奏的动作行为,随着网络深度的增加,其时间特征感受野也会增加,更容易感受到慢节奏。

29.因此,借鉴特征金字塔网络的思想,本技术的设计不仅在空间特征提取网络上采用了特征金字塔网络来在聚合不同感受野中的空间信息,同时在时间特征提取网络上也采用了特征金字塔来聚合各种视觉节奏的信息。最后使用多层次特征融合模块均衡地融合两部分特征。

30.本实施例给出一种基于三维卷积的时空特征多层次融合的行为识别方法,包括如下步骤:

31.s1:采用包含多种动作类和多视频段的kinetic400公开数据集作为实验数据集,从数据集中的各个视频片段等间隔的取出部分帧分别作为时空特征双流网络中时间特征提取网络和空间特征提取网络的输入;

32.s2:s2:构建基于时间和空间的双流网络,包括帧抽取模块、时间特征提取网络、空间特征提取网络和多层次特征融合模块;

33.时间特征提取网络和空间特征提取网络的结构包括多阶段的卷积层,全局池化层以及全连接层和softmax层,其中,全局池化层和全连接层构成分类器,softmax层用来对识别结果的归一化;

34.时间特征提取网络用于提取整段视频包含行为的多层次时间特征信息;空间特征提取网络用于提取整段视频包含行为的多层次空间特征信息,多层次特征融合模块用于进行多层次的特征融合,分类器用于对融合后的特征进行给出行为预测的结果;

35.在时间特征提取网络和空间特征提取网络的后面阶段将提取到的不同层次的特征作为多层次特征融合模块的输入;

36.s3:多层次特征融合模块针对不同层次的时间特征图和空间特征图进行采样操作,对特征图进行维度对齐,然后分别在时间和空间特征内部进行上下两方向上的特征融合,增强和丰富各个层次上的特征语义表达,接着将空间融合后的特征和时间融合后的特征进一步全融合,最终获得该视频下不同层次时空特征融合后的行为特征。将该特征输入到分类器中分类。

37.s4:在分类器中,输入特征经过全局平均池化和级联的操作,最后放入全连接层中对视频中的行为进行分类。

38.以下是具体的实施过程:

39.s1:获取实验数据集,对数据做预处理。

40.采用公开数据集kinetic400作为实验数据集,该数据集kinetic400专注于视频中的人类行为。数据类别包括:人的如绘画、喝酒、大笑、打拳;人与人之间的行为,如拥抱、握手;人与对象的行为,如打开礼物,修剪草坪,洗碗。有些行为是细粒度的,需要时间推理来区分,例如不同类型的游泳。还有一些需要更多地强调物体来区分,例如演奏不同类型的乐器。该数据集有400个人类行为类,每个类有400个甚至更多的片段,每个片段来自一个独一

无二的视频,总共有24万个视频。

41.s1.1:首先对视频段进行帧采样,鉴于相邻的视频帧之间的相似度非常高,全部将其输入到网络会造成冗余度过高并且网络计算困难的问题。由于不同的视频长度不一样,方法使用64帧作为默认整段视频的长度,将64帧视频帧代表整个视频作为网络的输入帧。

42.s1.2:在64个视频帧中,分别等间隔取n

tefn

帧和n

sefn

帧,分别作为时间特征提取网络和空间特征提取网络的输入。其中sfen表示空间特征提取网络(temporal feature extraction network),tfen表示时间特征提取网络(spatial feature extraction network)。

43.s2:构建基于时间和空间的双流网络,包括帧抽取模块、时间特征提取网络、空间特征提取网络和多层次特征融合模块;并对视频数据做时间和空间的特征提取。

44.时间特征提取网络和空间特征提取网络的结构包括多阶段的卷积层,全局池化层以及全连接层和softmax层,其中,全局池化层和全连接层构成分类器,softmax层用来对识别结果的归一化;

45.时间特征提取网络用于提取整段视频包含行为的多层次时间特征信息;空间特征提取网络用于提取整段视频包含行为的多层次空间特征信息,多层次特征融合模块用于进行多层次的特征融合,分类器用于对融合后的特征进行给出行为预测的结果;

46.在时间特征提取网络和空间特征提取网络的后面阶段将提取到的不同层次的特征作为多层次特征融合模块的输入;

47.s2.1:时间特征提取网络和空间特征提取网络的结构,每个都包含conv1,pool1,res2,res3,res4,res5等多个阶段。采用3d resnet 50作为网络的backbone。接着是多层次特征融合模块,最后是分类器作为预测模块。网络模型示意如图1所示。

48.s2.2:时间特征提取网络学习时间维度上的信息,通过减少通道数来使网络的复杂度变得较小,将其通道数设为c

tefn

。

49.s2.3:空间特征提取网络用来捕获空间的语义信息,由于通道上的维度是充足的,通道数设为c

sefn

。并且空间中的语义和连续的视频帧中细粒度特征变化缓慢,对应空间特征提取网络输入的视频帧率不需要很高。

50.将α设为速率比,α=n

tefn

/n

sefn

,将β设为通道数比,β=c

tefn

/c

sefn

。设置n

tefn

帧的值为32,n

sefn

帧的值为4。每一帧图像对应的大小为224

×

224像素,通道为3。本实施例中,对应设置的α=8,β=1/8。

51.s2.4:每个视频段输入时间特征提取网络和空间特征提取网络对应的数据尺寸分别为32

×

2242和4

×

2242,视频数据经过了conv1,pool1,res2,res3,在时间特征提取网络和空间特征网络得到的特征大小分别为4

×

282,32

×

282。

52.s2.5:逐步经过res4和res5提取,将res4和res5提取到的两个层次的时间和空间特征输入到多层次特征融合模块进行特征融合。

53.s3:多层次特征模块融合时空多层次特征,优先会对时间和空间网络内部多层次特征做对齐,之后做时间或者空间内部不同层次上下两个方向的特征融合,最后进行时空特征的全融合。具体分为以下三个步骤:

54.(1)对齐操作

55.由于特征图是经过不同层的卷积后获取的,不同层的卷积核大小通道维度都不一

致,得到的特征图大小也不同。进行融合前先对特征图维度上进行对齐,包括空间维度和时间维度。如图3所示。

56.对特征下采样对齐空间语义,采用卷积操作对齐空间维度。

57.对空间维度对齐后的特征在时间维度上进行采样操作。

58.(2)层次融合

59.经过空间维度对齐和时间维度采样后,特征有了明显的变化。为了对特征充分地融合,对时间或者空间特征内中不同层次的对齐后的特征进行融合。

60.对齐之后特征图在空间维度上大小一致,但是由于不同层的特征在时间维度的采样率不同,时间维度可能不一致。因此,如果低维特征图融合高维特征图的特征,需要对高维的特征进行在时间维度进行下采样,再相加;如果高维特征图融合低维特征图的特征,需要对低维的特征进行在时间维度进行上采样,再相加。

61.在不同方向上的特征聚合,使用自上而下与自下而上相结合的融合方式,增强和丰富每一个层次特征的表示。融合方式如图4所示。

62.(3)全融合

63.得到时间层次融合和空间层次融合之后的特征,采用全融合的方式代替全连接进一步进行特征全融合,对特征进行了充分的利用。考虑到将处理之后的时空特征直接拼接,会出现特征明细那不均衡的问题,将其作为整段视频的特征放入分类器其中进行分类,则会影响最终的行为识别准确率。方法将高时间维度的特征再次下采样,再与其他特征在通道维度上连接。如图5所示。

64.s4:根据得到融合之后的时空特征进行行为分类,得出识别的预测结果。

65.s4.1:连接之后的特征馈入到分类器中,分类器是由全局池化层和全连接层组成。

66.s4.2:将经过时间特征提取网络和空间特征提取网络提取的特征放入全局池化中进行池化操作。

67.s4.3:池化之后接着全连接,最后softmax函数用来对行为识别的结果归一化,从而得出行为分类的预测值。

68.对应于步骤s3中的特征对齐操作,为了保证融合过程中维度对齐操作后特征的有效性,为每一个对齐模块增加增加了一个损失函数以及分类器行为分类的交叉熵损失,整体的最后损失函数可以表示为:

[0069][0070]

其中,是交叉熵损失函数作为分类损失,表示第i个辅助损失函数,λi是平衡系数。

[0071]

为了验证本实施例的基于三维卷积的时空特征多层次融合的行为识别方法的有效性,申请日进行如下实验与对比分析:

[0072]

实验中,使用kinetic400公开数据集作为训练集和测试集,分别用于网络模型的训练和测试。训练集视频的行为类别数量为400个,视频总数为234584个。在测试集上进行测试,测试集视频总数为19760。

[0073]

1、实验环境搭建说明如下:

[0074]

采用python深度学习框架pytorch实现时空特征金字塔网络,实验设备运行内存为48gb,操作系统为ubnuntu20.04.3lts,设备具有三张型号为rtx2080ti的显卡,显卡显存12g。其中实验环境依赖包有:torch,numpy,mmcv,torchvision,matplotlib,numpy,opencv-contrib-python,pillow等。

[0075]

2、网络模型训练

[0076]

模型训练过程中,进行了如下设置:单gpu处理8个视频,实验所采用的设备有三张显卡,则batchsize即为24个视频,一个epoch会有219864个视频作为训练集,则训练集剩余14720个视频作为验证集,一般训练一个epoch需要约170min。模型优化器设置为sgd,学习率0.01,moment为0.09,weight_decay为0.0001。

[0077]

模型训练的主要流程包括如下:

[0078]

(1)初始化模型的输入:主要输入数据集,数据集一般为视频,初始化训练总次数e,当前训练次数t,空间特征提取网络的输入帧的数量f,以及时间特征提取网络输入视频帧数与空间特征提取网络的输入帧的比例α,训练视频组数batchsize。

[0079]

(2)采帧:对于每一段视频数据,首先等时间间隔取64帧,再等时间间隔分别取f帧和αf帧,每次输入batchsize段视频。

[0080]

(3)训练模型:当数据输入到时间特征提取网络和空间特征提取网络中,多层特征融合模块将其输出的特征进行融合,融合之后的特征馈入分类器中进行分类,并得出分类损失loss

class

和特征采样后的损失loss

alignment

,根据这两个loss函数反向传播,更新网络模型参数。

[0081]

具体过程可表示为如下:

[0082][0083]

其中,sfen表示空间特征提取网络(temporal feature extraction network),tfen表示时间特征提取网络(spatial feature extraction network),mlem表示多层特征提取模块(multi-level extraction module)。

[0084]

loss由两部分构成,一个用于分类,计算分类的loss,进行反向传播以更新网络中的参数。另一个用于调整对齐模块的网络参数,计算对齐的loss,进行反向传播主要可以更新对齐模块中的参数。

[0085]

3、网络性能评估

[0086]

采用的评价指标为top-1准确率和top-5准确率,本文简称为top-1和top-5。top-1

是选网络输出的准确率向量中数值最大的作为预测结果,若预测结果与真实标签一致,即分类是正确的,则预测正确,否则预测错误;

[0087]

top-5是选网络输出的准确率向量中数值最大前五个数值的作为预测结果,若预测结果中存在与真实标签一致,即分类正确,则预测正确,否则预测错误。

[0088]

与近几年常见的行为模型对比如下:

[0089]

method数据top 1top 5r(2 1)d光流 视频73.990.9i3d光流 视频71.690.0s3d视频69.489.1eco视频70.089.4artnet视频69.288.3tsn视频70.689.4resnet3d-101视频62.883.9slowfast视频74.4391.57ours视频74.9391.80

[0090]

对比实验结果中显示,r(2 1)d和i3d尽管同时使用光流数据和视频数据进行特征提取,在top5上分别达到了90.9和90.0的准确率,然而仍低于slowfast以及方法提出的时空特征双流网络,这就说明利用三维卷积对视频的时间特征的提取能力甚至优于二维卷积对光流图中的时间特征,证明方法采用基于三维卷积进行特征提取的正确性。

[0091]

对比中,resnet3d-101直接对视频进行时间特征提取,结果显示尽管对视频的时间特征的提取可以达到一定的准确率,其准确率明显低于使用backbone网络为resnet3d 50的双流网络,这也说明了同时对视频提取的时间和空间特征处理的优越性。

[0092]

方法提出的网络对比同样使用双流结构的slowfast,对应的网络在准确率方面也有所提高,这是由于slowfast在提取特征之后采用直接连接的方式来融合时空特征,而采用了多层次特征融合模块,不仅将时间特征和空间特征进行了融合,还深层次和上一层的特征进行了融合,丰富了不同层次的特征表示,将不同层次时空特征得到了充分利用,对视频的空间和时间感受野更大,印证了方法提出的多层特征融合模块的有效性。

[0093]

4、结论

[0094]

本实施例给出的基于三维卷积的时空特征多层次融合的行为识别方法,其特点在于,基于三维卷积时空特征多层次融合的行为识别网络提取了视频中行为的时间和空间的多层次深度特征,并分别进行时空特征内部多层次特征融合和时空特征间的全融合。经实验对比验证了对于行为识别任务而言,使用融合的时间和空间多层次特征可以最终提高行为识别的准确率。

[0095]

最后需要指出的是,以上阐述的实施例仅用于对本技术的技术方案进行说明和理解,本发明并不限于上述实施例。本领域的普通技术人员应当理解:在本技术的技术方案中,可以对技术特征进行修改、替换或者添加,这些简单的修改、替换或者添加应属于本技术的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。