1.本技术涉及人工智能技术领域,尤其涉及一种视频处理方法、机器学习模型训练方法及相关装置、设备。

背景技术:

2.近年来,一种视频化信息流形式风靡全球,相比于以文本进行信息传播的传统方式,视频化信息流具有信息量更丰富、浏览方式更便捷且更具冲击力等优势。

3.一般,视频的来源除了专业视频编辑人员外,更多来自于自媒体,例如快手、抖音等日常小视频上经常进行视频发布的各大主播。与文本信息相比,自媒体发布的小视频内容更丰富、形式更多样,因此,如何采用一种有效的方式理解视频的主题就成为了一个技术的难点。对于小视频,我们希望通过一系列标签(tags)来对视频信息进行概括,以便于定位视频的主题,从而有助于上层业务方完成视频内容的分发。

4.对于小视频标签的标注,大家往往会分别从文本的角度或者视觉的角度来对小视频进行标签标注。然而,仅仅依赖视觉信息或者文本信息对小视频进行标签标注,存在标注不准确的问题。

技术实现要素:

5.本技术实施例提供了一种视频处理方法、机器学习模型训练方法及相关装置、设备,可以提高视频信息和文本信息的融合程度,使得两者相互补充,提高视频的标签识别的准确度,以便于更好地理解视频的主题。

6.本技术实施例第一方面公开了一种视频处理方法,所述方法包括:从待处理视频中提取特征,得到视频特征向量;从待处理文本提取特征,得到文本特征向量;所述待处理文本与所述待处理视频相对应;将所述文本特征向量与所述视频特征向量进行拼接,得到多模态特征向量;将所述多模态特征向量进行特征融合,得到融合特征向量;基于所述融合特征向量对所述待处理视频进行分类,得到所述待处理视频的标签。

7.通过该方法,服务器可以更好的融合视频信息和文本信息,使得两者相互补充,提高视频的标签识别的准确度,以便于更好地理解视频的主题。其中,利用文本信息可以有效地将模型识别从感知层面提升到认知层面,从而得到与视频主题最相关的标签。

8.结合第一方面,在一种可能的实现中,所述待处理视频包括n张图像,所述视频特征向量包括n个图像特征向量,所述n个图像特征向量与所述n张图像一一对应,n为正整数;所述从待处理视频中提取特征,得到视频特征向量,包括:

9.从所述n张图像中分别提取特征,得到所述n个图像特征向量。

10.结合第一方面,在一种可能的实现中,所述将所述文本特征向量与所述视频特征向量进行拼接,得到多模态特征向量,包括:

11.将所述n个图像特征向量分别依次与所述文本特征向量进行拼接,所述多模态特征向量一行或一列包括一个图像特征向量和所述文本特征向量。

12.结合第一方面,在另一种可能的实现中,所述待处理文本包括多条文本,所述从待处理文本提取特征,得到文本特征向量,还包括:从所述多条文本中分别提取的特征,得到多个文本特征向量,所述文本特征向量与所述文本一一对应;

13.所述将所述文本特征向量与所述视频特征向量进行拼接,得到多模态特征向量,包括:

14.将所述n个图像特征向量中的每一个图像特征向量与所述每一个图像特征向量对应的文本特征向量进行拼接,所述多模态特征向量一行或一列包括一个图像的图像特征向量和所述一个图像对应的文本的文本特征向量。

15.结合第一方面,在一种可能的实现中,所述将所述多模态特征向量进行特征融合,得到融合特征向量,包括:

16.将所述多模态特征向量输入到融合模块,得到融合特征向量;

17.所述融合模块包括至少一层卷积层和与至少一层池化层;其中,

18.所述第一卷积层用于提取输入的数据的特征,所述池化层用于对输入的数据进行采样。

19.该方法通过卷积神经网络对视频特征向量和文本特征向量进行特征融合,可以有效地提高视频信息和文本信息的信息融合程度,发挥了多模态信息互补的优势,提高视频的标签识别的准确度。

20.结合第一方面,在一种可能的实现中,所述基于所述融合特征向量对所述待处理视频进行分类,得到所述待处理视频的标签,包括:

21.将所述融合特征向量输入到分类模块,得到所述待处理视频的标签;

22.所述分类模块包括至少一层全连接层。

23.结合第一方面,在一种可能的实现中,所述视频特征向量是通过第一模型提取得到的,所述文本特征向量是通过第二模型提取得到的;训练数据包括样本视频、所述样本视频对应的样本文本和所述样本视频的标签,其中:

24.所述第一模型、所述第二模型、所述融合模块和所述分类模块是基于所述训练数据联合训练得到的;或,所述第一模型、所述融合模块和所述分类模块是基于训练数据联合训练得到的;或,所述第二模型、所述融合模块和所述分类模块是基于训练数据联合训练得到的;或,所述融合模块和所述分类模块是基于训练数据联合训练得到的。

25.结合第一方面,在一种可能的实现中,所述从待处理文本提取特征,得到文本特征向量包括:

26.对所述待处理文本进行分词,得到所述待处理文本的多个词语;

27.将所述多个词语分别进行向量转换,得到所述多个词语分别对应的词向量;

28.将所述多个词语分别对应的词向量输入到第一模型,得到文本特征向量;所述第一模型用于提取输入的数据的特征。

29.其中,所述待检测文本包括所述待处理视频的主题信息、标题信息、字幕信息、分类信息中的至少一种。

30.本技术实施例第二方面公开了一种机器学习模型训练方法,所述模型包括:将样本视频输入第一模型,得到视频特征向量;

31.将样本文本输入第二模型,得到文本特征向量;所述待处理文本与所述待处理视

频相对应;

32.将所述文本特征向量与所述视频特征向量进行拼接,得到多模态特征向量;

33.将所述多模态特征向量输入到融合模块,得到融合特征向量;

34.将所述融合特征向量输入到分类模块,得到所述样本视频的预测标签;

35.基于所述样本视频的预测标签与标注标签之间的误差调节所述融合模块和所述分类模块的模型参数。

36.结合第二方面,在一种可能的实现中,所述基于所述样本视频的预测标签与标注标签之间的误差调节所述融合模块和所述分类模块的模型参数,包括:

37.基于所述样本视频的预测标签与标注标签之间的误差调节所述第一模型、所述第二模型、所述融合模块和所述分类模块的模型参数;

38.或,

39.基于所述样本视频的预测标签与标注标签之间的误差调节所述第一模型、所述融合模块和所述分类模块的模型参数;

40.或,

41.基于所述样本视频的预测标签与标注标签之间的误差调节所述第二模型、所述融合模块和所述分类模块的模型参数;

42.或,

43.基于所述样本视频的预测标签与标注标签之间的误差调节所述融合模块和所述分类模块的模型参数。

44.结合第二方面,在一种可能的实现中,所述将样本视频输入第一模型,得到视频特征向量;所述样本视频包括n张图像,所述视频特征向量包括n个图像特征向量,所述n个图像特征向量与所述n张图像一一对应,包括:

45.将n张图像输入第一模型,得到所述n个图像特征向量。

46.结合第二方面,在一种可能的实现中,所述融合特征向量包括:至少一层第一卷积层和与至少一层第一池化层;其中,

47.所述第一卷积层用于提取输入的数据的特征,所述池化层用于对输入的数据进行采样。

48.本技术实施例第三方面公开了一种视频处理装置,所述装置包括:第一信息提取模块,用于从待处理视频中提取特征,得到视频特征向量;

49.第二信息提取模块,用于从待处理文本提取特征,得到文本特征向量;所述待处理文本与所述待处理视频相对应;

50.多模态特征模块,用于将所述文本特征向量与所述视频特征向量进行拼接,得到多模态特征向量;

51.融合模块,用于将所述多模态特征向量进行特征融合,得到融合特征向量;

52.分类模块,用于基于所述融合特征向量对所述待处理视频进行分类,得到所述待处理视频的标签。

53.本技术实施例第四方面公开了一种机器学习模型训练装置,所述装置包括:

54.第一获取模块,用于将样本视频输入第一模型,得到视频特征向量;

55.第二获取模块,用于将样本文本输入第二模型,得到文本特征向量;所述待处理文

本与所述待处理视频相对应;

56.第二多模态特征模块,用于将所述文本特征向量与所述视频特征向量进行拼接,得到多模态特征向量;

57.第二融合模块,用于将所述多模态特征向量输入到融合模块,得到融合特征向量;

58.第二分类模块,用于将所述融合特征向量输入到分类模块,得到所述样本视频的预测标签;

59.信息处理模块,用于基于所述样本视频的预测标签与标注标签之间的误差调节所述融合模块和所述分类模块的模型参数。

60.本技术实施例第五方面公开了一种计算机设备,所述计算机设备包括:处理器和存储器;

61.所述处理器与存储器相连,其中,所述存储器用于存储计算机程序,所述处理器用于调用所述计算机程序,以使得所述计算机设备执行权利要求1-8任一项所述的方法。

62.本技术实施例第六方面公开了一种计算机可读存储介质,所述计算机可读存储介质存储有计算机程序,所述计算机程序包括程序指令,所述程序指令当被处理器执行时使所述处理器执行上述第一方面的方法。

63.本技术实施例第七方面公开了一种计算机程序产品或计算机程序,所述计算机程序产品或计算机程序包括计算机指令,所述计算机指令存储在计算机可读存储介质中。服务器的处理器从计算机可读存储介质读取所述计算机指令,处理器执行所述计算机指令,使得所述服务器执行上述第一方面的方法。

附图说明

64.为了更清楚地说明本技术实施例技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图是本技术的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

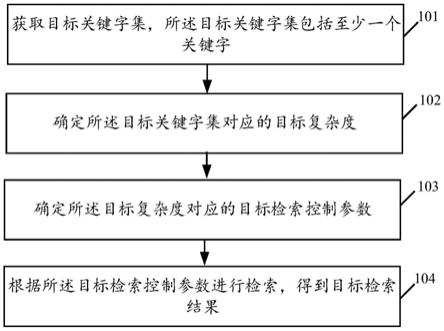

65.图1是本技术实施例提供的一种视频处理系统100的架构示意图;

66.图2是本技术实施例提供的一种基于视频处理装置或电子设备的结构示意图;

67.图3a是本技术实施例提供的一种机器学习模型训练方法的流程示意图;

68.图3b是本技术实施例提供的一种基于样本视频集和样本数据集训练机器学习模型的流程示意图;

69.图3c是本技术实施例提供的一种获得文本特征向量方法的流程示意图;

70.图4a是本技术实施例提供的一种视频特征向量和文本特征向量拼接方法的示意图;

71.图4b是本技术实施例提供的另一种视频特征向量和文本特征向量拼接方法的示意图;

72.图5是本技术实施例提供的两种融合模块的结构示意图;

73.图6a和图6b是本技术实施例提供的一种视频处理方法的流程示意图;

74.图7是本技术实施例提供的一种视频处理装置的结构示意图;

75.图8是本技术实施例提供的一种机器学习模型训练装置的结构示意图。

具体实施方式

76.下面将结合本技术实施例中的附图,对本技术实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例是本技术一部分实施例,而不是全部的实施例。基于本技术中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本技术保护的范围。

77.首先对本技术实施例涉及的技术术语进行介绍:

78.(1)人工智能

79.应理解,人工智能(artificial intelligence,ai)是利用数字计算机或者数字计算机控制的机器模拟、延伸和扩展人的智能,感知环境、获取知识并使用知识获得最佳结果的理论、方法、技术及应用系统。换句话说,人工智能是计算机科学的一个综合技术,它企图了解智能的实质,并生产出一种新的能以人类智能相似的方式做出反应的智能机器。人工智能也就是研究各种智能机器的设计原理与实现方法,使机器具有感知、推理与决策的功能。

80.人工智能技术是一门综合学科,涉及领域广泛,既有硬件层面的技术也有软件层面的技术。人工智能基础技术一般包括如传感器、专用人工智能芯片、云计算、分布式存储、大数据处理技术、操作/交互系统、机电一体化等技术。人工智能软件技术主要包括计算机视觉技术、语音处理技术、自然语言处理技术以及机器学习/深度学习等几大方向。

81.其中,本技术实施例提供的方案主要涉及人工智能的自然语言处理(nature language processing,nlp)技术与机器学习(machine learning,ml)技术。

82.其中,自然语言处理(nature language processing)是计算机科学领域与人工智能领域中的一个重要方向。它研究能实现人与计算机之间用自然语言进行有效通信的各种理论和方法。自然语言处理是一门融语言学、计算机科学、数学于一体的科学。因此,这一领域的研究将涉及自然语言,即人们日常使用的语言,所以它与语言学的研究有着密切的联系。自然语言处理技术通常包括文本处理、语义理解、机器翻译、机器人问答、知识图谱等技术。

83.其中,机器学习(machine learning)是一门多领域交叉学科,涉及概率论、统计学、逼近论、凸分析、算法复杂度理论等多门学科。专门研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能。机器学习是人工智能的核心,是使计算机具有智能的根本途径,其应用遍及人工智能的各个领域。机器学习和深度学习通常包括人工神经网络、置信网络、强化学习、迁移学习、归纳学习等技术。

84.随着人工智能技术研究和进步,人工智能技术在多个领域展开研究和应用,例如常见的智能家居、智能穿戴设备、虚拟助理、智能音箱、智能营销、无人驾驶、自动驾驶、无人机、机器人、智能医疗、智能客服等,相信随着技术的发展,人工智能技术将在更多的领域得到应用,并发挥越来越重要的价值。

85.(2)模态、多模态融合、多模态机器学习

86.模态(modality):每一种信息的来源或者形式,都可以称为一种模态。例如,人有触觉,听觉,视觉,嗅觉;信息的媒介,有语音、视频、文字等;多种多样的传感器,如雷达、红外、加速度计等。以上的每一种都可以称为一种模态。同时,模态也可以有非常广泛的定义,

比如可以把两种不同的语言当做是两种模态,甚至在两种不同情况下采集到的数据集,亦可认为是两种模态。

87.多模态融合(multimodal fusion)负责联合多个模态的信息,进行目标预测(分类或者回归)。

88.多模态机器学习(multimodal machine learning,mmml),旨在通过机器学习的方法实现处理和理解多源模态信息的能力。

89.(3)神经网络

90.神经网络(neural network,nn):人工神经网络(artificial neural network,ann),简称神经网络或类神经网络,在机器学习和认知科学领域,是一种模仿生物神经网络(动物的中枢神经系统,特别是大脑)的结构和功能的数学模型或计算模型,用于对函数进行估计或近似。

91.①

语言模型训练方法

92.语言模型训练方法(bidirectional encoder representations from transformers,bert):一种利用海量文本的训练方法,被广泛用于多种自然语言处理任务,如文本分类、文本匹配、机器阅读理解等。

93.②

模型参数

94.模型参数:是使用通用变量来建立函数和变量之间关系的一个数量。在人工神经网络中,模型参数通常是实数矩阵。

95.③

模型训练

96.模型训练:对图像数据集进行多分类学习。该模型可采用tensor flow、torch等深度学习框架进行构建,使用cnn等神经网络层的多层结合组成多分类模型。模型的输入为图像经过opencv等工具读取形成的三通道或原通道矩阵,模型输出为多分类概率,通过softmax等算法最终输出网页类别。在训练时,模型通过交叉熵等目标函数向正确趋势逼近。

97.④

卷积神经网络

98.卷积神经网络(convolutional neural networks,cnn)是一类包含卷积计算且具有深度结构的前馈神经网络(feed forward neural networks),是深度学习(deeplearning)的代表算法之一。卷积神经网络具有表征学习(representation learning)能力,能够按其阶层结构对输入信息进行平移不变分类(shift-invariantclassification)。

99.⑤

循环神经网络

100.循环神经网络(recurrent neural network,rnn)是一类用于处理序列数据的神经网络。它与其他神经网络的不同是,rnn可以更好的去处理序列的信息,即认准了前后的输入之间存在关系。在nlp中,去理解一整句话,孤立的理解组成这句话的词显然是不够的,我们需要整体的处理由这些词连接起来的整个序列。

101.⑥

长短期记忆网络

102.长短时记忆神经网络(long short term networks,lstms)是一种能够捕捉长时依赖的特殊循环神经网络。是专门设计用来避免长时依赖问题的。长时间的记住信息已经成为了它的默认行为,不需要专门去学习。

103.⑦

双向注意力神经网络

104.双向注意力神经网络(bidirectional encoder representation from transformers,bert)的模型架构基于多层双向转换解码,因为解码器decoder是不能获要预测的信息的,模型的主要创新点都在预训练pre-traing方法上,即用了masked lm和next sentence prediction两种方法分别捕捉词语和句子级别的特征。

105.其中“双向”表示模型在处理某一个词时,它能同时利用前面的词和后面的词两部分信息,这种“双向”的来源在于bert与传统语言模型不同,它不是在所有前面词的条件下预测最可能的当前词,而是随机遮掩一些词,并利用所有没被遮掩的词进行预测。

106.⑧

深度残差网络

107.深度残差网络(deep residual network,resnet)采用跳跃结构作为网络的基本结构,可以克服由于网络深度加深而产生的学习效率变低,准确率无法有效提升的问题(也称为网络退化)。通过在一个浅层网络基础上叠加y=x的层(称identity mappings,恒等映射),可以让网络随深度增加而不退化。

108.⑨

编码器-解码器

109.编码器-解码器结构是机器翻译技术常用的网络结构。由编码器和解码器两部分组成,编码器将输入的文本转换为一系列能够表达输入文本特征的上下文向量,解码器接收编码器输出的结果作为自己的输入,输出对应的另一种语言的文本序列。

110.现有技术中,无论是基于文本进行主题标签预测还是基于视频内容进行实体标签预测,两个模块都是独立进行的,忽略了视觉信息和文本信息的互补的特性。很显然,在主题标签的分类上,视觉信息对文本信息起着补充作用,视觉信息提供的更多是感知层面的信息,文本信息更偏向性认知层面。

111.本技术实施例提供的方案涉及人工智能的视频处理技术,具体通过如下实施例进行说明:本技术实施例提供一种视频处理方法、机器学习模型训练方法及相关装置、设备,该方法包括:从待处理视频中提取特征,得到视频特征向量。从待处理文本提取特征,得到文本特征向量;其中,待处理文本与待处理视频相对应。将文本特征向量与视频特征向量进行拼接,得到多模态特征向量。将多模态特征向量进行特征融合,得到融合特征向量。基于融合特征向量对待处理视频进行分类,得到待处理视频的标签。

112.通过该方法可以提高视频信息和文本信息的融合程度,使得两者相互补充,提高视频的标签识别的准确度,以便于更好地理解视频的主题。

113.请参阅图1,图1是本技术实施例提供的一种视频处理系统100的架构示意图,该系统可以包括:服务器200、网络300和终端400(以终端400-1和终端400-2为例),其中,终端400(以终端400-1和终端400-2为例)通过网络300连接服务器200,网络300可以是广域网或者局域网,又或者是二者的组合。

114.终端400-1归属于网络视频的发布者,用于向视频处理系统100的后台服务器,即服务器200上传包含视频文本信息的待处理视频,以通过服务器200将待处理视频发布给网络300上的其他终端,如终端400-2。

115.服务器200为视频处理系统100的后台服务器,归属于视频处理系统100的管理者,用于接收终端400-1上传的待处理视频,存储在数据库500中。并对待处理视频进行图像特征提取处理,得到待处理视频对应的视频特征向量;对待处理视频的待处理文本进行文本

特征提取处理,得到待处理文本对应的文本特征向量;将视频特征向量与文本特征向量进行拼接得到待处理视频对应的多模态融合特征向量;对多模态融合特征向量进行特征融合,得到融合特征向量;基于融合特征向量,对待处理视频进行分类,得到待处理视频的标签。进而,服务器200可以在网络视频平台上利用待处理视频的标签对待处理视频进行展示和推荐。

116.终端400-2可以通过网络视频平台100的客户端应用410访问网络视频平台100,在客户端应用410上显示视频,并通过客户端应用410对待处理视频进行如点击,收藏等操作,相应地在客户端应用410上播放或收藏视频。

117.在一些实施例中,服务器200可以是独立的物理服务器,也可以是多个物理服务器构成的服务器集群或者分布式系统,还可以是提供云服务、云数据库、云计算、云函数、云存储、网络服务、云通信、中间件服务、域名服务、安全服务、cdn、以及大数据和人工智能平台等基础云计算服务的云服务器。终端400可以是智能手机、平板电脑、笔记本电脑、台式计算机、智能音箱、智能手表等,但并不局限于此。终端以及服务器可以通过有线或无线通信方式进行直接或间接地连接,本技术实施例中不做限制。

118.在本技术实施例中,机器学习模型训练的服务器和视频处理的服务器可以相同,也可以不同,本技术对此不作限制。

119.终端400包括但不限于手机、电脑、智能语音交互设备、智能家电、车载终端等,也可以为笔记本电脑,平板电脑,台式计算机,便携式音乐播放器,个人数字助理,专用消息设备,便携式游戏设备等各种类型的终端,也可以实施为服务器。

120.参见图2,图2是本技术实施例提供的视频处理装置或电子设备的结构示意图,该视频处理装置可以为上述图1中的服务器200或终端400,包括:至少一个处理器210、存储器220、至少一个网络接口230和用户接口240。服务器200中的各个组件通过总线系统250耦合在一起。可理解,总线系统250用于实现这些组件之间的连接通信。总线系统250除包括数据总线之外,还包括电源总线、控制总线和状态信号总线。但是为了清楚说明起见,在图2中将各种总线都标为总线系统250。

121.可以理解的是,本技术实施例示意的结构并不构成对视频处理装置或电子设备的具体限定。在本技术另一些实施例中,视频处理装置或电子设备可以包括比图示更多或更少的部件,或者组合某些部件,或者拆分某些部件,或者不同的部件布置。图示的部件可以以硬件,软件或软件和硬件的组合实现。

122.处理器210可以是一种集成电路芯片,具有信号的处理能力,例如通用处理器、数字信号处理器(digital signal processor,dsp),或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件等,其中,通用处理器可以是微处理器或者任何常规的处理器等。

123.存储器220可以是可移除的,不可移除的或其组合。示例性的硬件设备包括固态存储器,硬盘驱动器,光盘驱动器等。存储器220可选地包括在物理位置上远离处理器210的一个或多个存储设备。

124.存储器220包括易失性存储器或非易失性存储器,也可包括易失性和非易失性存储器两者。非易失性存储器可以是只读存储器(read only memory,rom),易失性存储器可以是随机存取存储器,(random access memory,ram)。本技术实施例描述的存储器220旨在

包括任意适合类型的存储器。

125.在一些实施例中,存储器220能够存储数据以支持各种操作,这些数据的示例包括程序、模块和数据结构或者其子集或超集,下面示例性说明。

126.操作系统221,包括用于处理各种基本系统服务和执行硬件相关任务的系统程序,例如框架层、核心库层、驱动层等,用于实现各种基础业务以及处理基于硬件的任务;

127.网络通信模块222,用于经由一个或多个(有线或无线)网络接口230到达其他计算设备,示例性的网络接口230包括:蓝牙、无线相容性认证(wifi)、和通用串行总线(universal serial bus,usb)等;

128.呈现模块223,用于经由一个或多个与用户接口240相关联的输出装置241(例如,显示屏、扬声器等)使得能够呈现信息(例如,用于操作外围设备和显示内容和信息的用户接口);

129.输入处理模块224,用于对通过一个或多个输入装置242输入或互动进行检测以及翻译所检测的输入或互动。

130.图2示出了存储在存储器220中的模型和模块,其可以是程序和插件等形式的软件,包括以下软件模块:第一模型2251、第二模型2252、多模态特征模块2253、融合模块2254和分类模块2255,这些模块是逻辑上的,因此根据所实现的功能可以进行任意的组合或进一步拆分。

131.第一模型2251,用于从待处理视频中提取特征,得到视频特征向量。

132.第二模型2252,用于从待处理文本提取特征,得到文本特征向量;所述待处理文本与所述待处理视频相对应。

133.多模态特征模块2253,用于将所述文本特征向量与所述视频特征向量进行拼接,得到多模态特征向量。

134.融合模块2254,用于将所述多模态向量矩阵进行特征融合,得到融合特征向量。

135.分类模块2255,用于基于所述融合特征向量对所述待处理视频进行分类,得到所述待处理视频的标签。

136.用户接口240包括使得能够呈现媒体内容的一个或多个输出装置241,包括一个或多个扬声器和/或一个或多个视觉显示屏。用户接口240还包括一个或多个输入装置242,包括有助于对象输入的用户接口部件,比如键盘、鼠标、麦克风、触屏显示屏、摄像头、其他输入按钮和控件。

137.在另一些实施例中,本技术实施例提供的模块或模型等可以采用硬件方式实现,作为示例,本技术实施例提供的装置可以是采用硬件译码处理器形式的处理器,其被编程以执行本技术实施例提供的视频处理方法,例如,硬件译码处理器形式的处理器可以采用一个或多个应用专用集成电路(application specific integrated circuit,asic)、dsp、可编程逻辑器件(programmable logic device,pld)、复杂可编程逻辑器件(complex programmable logic device,cpld)、现场可编程门阵列(field-programmable gate array,fpga)或其他电子元件。

138.将结合本技术实施例提供的服务器的示例性应用和实施,说明本技术实施例提供的视频处理方法。

139.实施例一

140.下面介绍本技术实施例涉及的一种机器学习模型的训练方法。

141.实施例一介绍本技术实施例涉及的一种机器学习模型的训练方法。该机器学习方法可以由图1和图2中的服务器200来实现。

142.具体地,如图3a示例性所示,为机器学习模型训练方法的流程示意图,该方法可以包括但不限于如下部分或全部步骤:

143.s301:基于样本视频集,获取样本数据集。

144.样本视频集可以包括一个或多个样本视频。

145.样本视频可以来自于图1中的网络视频的发布者终端400-1,网络视频的发布者可以是专业视频编辑人员,也可以是自媒体,例如快手、抖音等日常小视频上经常进行视频发布的各大主播。

146.样本数据集,也可以称为训练数据集,包括一个或多个样本数据,每一个样本数据可以包括但不限于如下的一种或结合:样本视频的标签、样本视频对应的样本文本、样本视频、样本视频对应的音频信息等。在一些实施例中,样本数据(sample)包括样本视频对应的样本文本(text)、样本视频(image)和样本视频的标注标签(lable)。样本数据集中的每一个样本数据的格式如下:

147.sample

148.={“text”:听说吃肉可以上热搜,我也试试,“image”:url,“lable”:

149.[猪蹄,美女,美食]}

[0150]

其中,“url”指获取样本视频的地址,基于该地址,可以获取到样本视频。

[0151]

s302:基于样本视频集和样本数据集训练机器学习模型。

[0152]

具体地,如图3b示例性所示,s302可以包括s3021-s3026中的部分或全部步骤:

[0153]

s3021:将样本数据中的样本视频输入第一模型,得到视频特征向量。

[0154]

在一些实施例中,可以将整个样本视频输入至用于提取视频模态特征的第一模型,进行特征提取,得到视频特征向量。该视频特征向量也可以称为视频模态特征。

[0155]

在另一些实施例中,也可以从样本视频中选取n张图像,将n张图像输入至第一模型,进行特征提取,得到n个图像特征向量,该n个图像特征向量与n张图像一一对应。在该实施例中,样本视频包括n张图像,视频特征向量包括n个图像特征向量,n为正整数。

[0156]

本技术实施例对从样本视频中选取n张图像的方法不作限制,下面以其中的一种方法为例进行介绍。

[0157]

可以将该样本视频划分为一个或多个视频片段,根据一定的时间间隔从一个或多个视频片段的每一个视频片段中选取至少一张图像;至少一张图像组成一个图像集合;一个图像集合对应一个视频片段;一个或多个图像集合包括n张图像。

[0158]

在一些实施例中,第一模型可以是深度残差网络(deep residual network,resnet)。服务器可以基于resnet,获得视频特征向量,resnet可以在网络深度增加的过程中,有效提升模型训练的准确率。具体地,在本技术实施例中以样本视频为选取的n张图像为例。本技术也可以通过其它网络模型,例如循环神经网络、长短期记忆网络,获得视频特征向量,对此不作限制。

[0159]

该resnet可以包括至少一层卷积层和至少一层池化层,该卷积层用于提取输入的数据的特征;池化层用于对输入的数据进行采样。卷积层和池化层均包括激活函数。

[0160]

在本技术实施例中,卷积层可以用于提取输入的n张图像的初始特征。具体地,第一步,将n张图像进行向量转换,得到n个图像向量,n个图像向量可以组合为一个图像向量矩阵;第二步,将该图像向量矩阵输入至卷积层,使用卷积核与图像向量矩阵进行卷积运算,也就是将图像向量矩阵和卷积核作内积运算,得到图像向量矩阵对应的卷积结果;接下来,基于激活函数对卷积结果进行非线性变换,并且加上偏置向量,得到初始特征向量;第三步,将初始特征向量输入至池化层,可以对初始特征向量进行特征采样;然后,基于激活函数对卷积结果进行非线性变换,并且加上偏置向量,得到视频特征向量。视频(image)通过resnet152提取的视频特征向量v

img

可以表示为:

[0161]vimg

=resnet152(image)

[0162]

s3022:将样本视频对应的样本文本输入第二模型,得到文本特征向量。

[0163]

在本技术实施例中,样本文本包括样本视频的主题信息、标题信息、字幕信息、分类信息等中的至少一种。

[0164]

下面介绍如何得到文本特征向量:

[0165]

具体地,如图3c示例性所示,s3022可以包括s30221-s30223中的部分或全部步骤:

[0166]

s30221:对样本文本进行分词,得到样本文本的多个词语。

[0167]

s30222:将多个词语分别进行向量转换,得到该多个词语分别对应的词向量。

[0168]

s30223:将多个词语分别对应的词向量输入至用于提取文本模态特征的第二模型,得到文本特征向量;该文本特征向量也可以称为文本模态特征。

[0169]

第二模型用于提取输入的文本的特征,该特征也称为文本模态特征,在本技术实施例中,第二模型用于提取样本文本的特征。由第二模型获得文本特征向量的方法可以参见s3021中由第一模型获得视频特征向量的方法,这里不再赘述。在本技术实施例中,第二模型可以是双向注意力神经网络模型(bidirectional encoder representation from transformers,bert),也可以是其它网络模型,本技术对此不作限制。文本(text)通过bert提取的文本特征向量v

text

可以表示为:

[0170]vtext

=bert(text)

[0171]

s3023:将文本特征向量与视频特征向量进行拼接,得到多模态特征向量。

[0172]

如图4a所示,在一些实施例中,样本文本包括一条文本,该一条文本对应一个文本特征向量,视频特征向量包括n个图像特征向量。可以将n个图像特征向量分别依次与文本特征向量进行拼接,得到的多模态特征向量一行或一列包括一个图像特征向量和文本特征向量。n张图像的多模态特征向量分别表示为:

[0173][0174][0175][0176]

…

[0177][0178]

其中,n个图像特征向量分别表示为文本特征向量表示为v

text

。

[0179]

例如,该视频特征向量为一个n1×

1024的特征向量矩阵,文本特征向量为一个包含768个元素的一维向量,可以将文本特征向量依次直接拼接在每一个图像特征向量的后面或者前面,形成的n1×

(1024 768)的特征向量矩阵,即为多模态特征向量。

[0180]

如图4b所示,在另一些实施例中,样本文本包括多条文本,可以从多条文本中分别提取特征,得到多个文本特征向量,文本特征向量与文本一一对应。可以将n个图像特征向量中的每一个图像特征向量与每一个图像特征向量对应的文本特征向量进行拼接,得到的多模态特征向量一行或一列包括一个图像的图像特征向量和一个图像对应的文本的文本特征向量。

[0181]

这里以m个文本特征向量为例,m个文本特征向量与n个图像特征向量存在对应关系。例如,图像特征向量包括n个图像特征向量,文本特征向量包括m个文本特征向量,n和m均为正整数,两者可以相等,也可以不相等。当m=n时,文本特征向量与图像特征向量一一对应。其中,在一种可能的实现中,第一个图像特征向量与第一个文本特征向量相对应;第二个图像特征向量与第二个文本特征向量相对应;第三个图像特征向量与第三个文本特征向量相对应;在这种情况下,服务器可以将第一个文本特征向量拼接在第一个图像特征向量的后面或者前面,将第二个文本特征向量拼接在第二个图像特征向量的后面或者前面,以此类推,将n个图像特征向量分别和与之对应的文本特征向量进行拼接,形成多模态特征向量。n张图像和m个文本的多模态特征向量分别表示为:

[0182][0183][0184][0185]

…

[0186][0187]

其中,n个图像特征向量分别表示为m个文本特征向量表示为

[0188]

应理解,还可以通过其它方式对图片特征向量和文本特征向量进行拼接,本技术对此不作限制。

[0189]

s3024:将多模态特征向量输入到融合模块,得到融合特征向量。

[0190]

在一些实施例中,服务器可以将样本视频的多模态特征向量输入到融合模块,得到融合特征向量。该融合模块可以是卷积神经网络,如图5所示,图5为融合模块的结构示意图。该卷积网络可以包括至少一层卷积层和至少一层池化层。该卷积层用于提取多模态特征向量的特征,得到初始特征向量,该池化层用于对初始特征向量进行采样,得到更精确的融合特征向量。卷积层和池化层均包括激活函数。

[0191]

具体地,服务器将该多模态特征向量输入至卷积层,使用卷积核与多模态特征向量进行卷积运算,也就是将多模态特征向量和卷积核作内积运算,得到多模态特征向量对应的卷积结果;接下来,基于激活函数对卷积结果进行非线性变换,并且加上偏置向量,得到初始特征向量;第三步,将初始特征向量输入至池化层,可以对初始特征向量进行特征采

样;然后,基于激活函数对卷积结果进行非线性变换,并且加上偏置向量,得到融合特征向量。

[0192]

在另一些实施例中,服务器也可以通过其他方式得到融合特征向量,融合模块也可以为循环神经网络,深度残差网络等其它网路模型。本技术对此不作限制。

[0193]

s3025:将融合特征向量输入到分类模块,得到样本视频的预测标签。

[0194]

在一些实施例中,该分类模块可以包括至少一层全连接层,该全连接层可以对样本进行分类,以便得到样本视频的预测标签。另外,该全连接层可以包括激活函数,激活函数包括权重矩阵和偏置常量。

[0195]

具体地,服务器可以将融合特征向量输入至全连接层,基于激活函数的权重矩阵和偏置向量,对融合特征向量进行非线性变换,再通过归一化,得到样本视频属于各个标签的概率,即预测标签。

[0196]

s3026:基于样本视频的预测标签与样本视频的标签之间的误差调节初始机器学习模型的模型参数。

[0197]

在实现1中,该初始机器学习模型包括第一模型、第二模型、融合模块和分类模块。基于样本视频的预测标签与样本视频的标注标签之间的误差调节第一模型、第二模型、融合模块和分类模块的模型参数。

[0198]

示例性地,构造用于表示样本视频的预测标签与样本视频的标注标签之间的误差的损失函数,通过梯度下降法迭代计算损失,当损失满足模型收敛条件时,输出最终的机器学习模型。

[0199]

在实现2中,该初始机器学习模型包括第一模型、融合模块和分类模块。训练时,可以基于样本视频的预测标签与样本视频的标注标签之间的误差调节第一模型、融合模块和分类模块的模型参数。

[0200]

在该实施例中,第二模型可以是预训练的双向注意力神经网络bert,也可以是其它的网络模型,例如长短时记忆神经网络、深度残差网络等。

[0201]

例如,第二模型用于获得文本特征向量,在训练第二模型的过程中采用的样本数据集可以包括一个或多个样本数据,一个样本数据可以包括样本文本和样本文本的标注标签。将样本文本输入到文本分类模型,得到该样本文本的预测标签。其中,该文本分类模型包括第二模型和第一分类单元,其中,第二模型用于提取输入样本文本的特征,得到其文本特征向量;第一分类单元用于基于样本文本的文本特征向量预测样本文本的标签。训练的方法是,基于样本文本预测标签和标注标签的误差调节文本分类模型的模型参数。进而,可以训练得到的文本分类模型中的第二模型,用于提取文本的文本特征向量。

[0202]

在实现3中,该初始机器学习模型包括第二模型、融合模块和分类模块。训练时,可以基于样本视频的预测标签与样本视频的标签之间的误差调节第二模型、融合模块和分类模块的模型参数。

[0203]

在该实施例中,第一模型可以是预训练的深度残差网络resnet,也可以是其它的网络模型,例如长短时记忆神经网络。

[0204]

示例性地,第一模型用于获得视频特征向量,在训练第一模型的过程中采用的样本数据集可以包括一个或多个样本数据,一个样本数据可以包括样本视频和样本视频的标注标签。将样本视频输入到视频分类模型,得到该样本视频的预测标签。其中,该文本分类

模型包括第一模型和第二分类单元,其中,第一模型用于提取输入样本视频的特征,得到其视频特征向量;第二分类单元用于基于样本视频的视频特征向量预测样本视频的标签。训练的方法是,基于样本视频预测标签和标注标签的误差调节视频分类模型的模型参数。进而,可以训练得到的视频分类模型中的第一模型,用于提取视频的视频特征向量。

[0205]

实现4,该初始机器学习模型也可以仅包括融合模块和分类模块。训练时,可以基于样本视频的预测标签与样本视频的标签之间的误差调节融合模块和分类模块的模型参数。此时,第一模型和第二模型均为预先训练得到的,可参见上述实现2和实现3中的第一模型和第二模型,这里不再赘述。

[0206]

上述通过训练后的机器学习模型可以应用于视频的分类,以预测视频的标签,具体可参见下述实施例二中相关描述。

[0207]

实施例二

[0208]

下面介绍本技术实施例涉及的一种视频处理方法。

[0209]

在一些实施例中,本技术实施例提供的一种视频处理方法可以由图1和图2中的服务器200或终端400来实现。

[0210]

在本技术实施例中,以执行主体为服务器200为例。

[0211]

具体地,如图6a和图6b示例性所示,为视频处理方法的流程示意图,该方法可以包括但不限于如下部分或全部步骤:

[0212]

s601:服务器从待处理视频中提取特征,得到视频特征向量。

[0213]

待处理视频可以来自于图1中的网络视频的发布者终端400-1,网络视频的发布者可以是专业视频编辑人员,也可以是在自媒体,平台上发布视频的各大主播。

[0214]

在一些实施例中,可以将整个待处理视频输入至第一模型,即视频模态特征提取模块进行特征提取,得到视频特征向量。第一模型的训练方法可以参见上述实施例一中的相关描述,这里不再赘述。

[0215]

在另一些实施例中,也可以从待处理视频中选取n张图像,将n张图像输入至第一模型,即视频模态特征提取模块,进行特征提取,得到n个图像特征向量,该n个图像特征向量与n张图像一一对应。在该实施例中,样本视频包括n张图像,视频特征向量包括n个图像特征向量,n为正整数。第一模型的训练方法可以参见上述实施例一中的相关描述,这里不再赘述。

[0216]

本技术实施例对从待处理视频中选取n张图像的方法不作限制,下面以其中的一种方法为例进行介绍。

[0217]

可以将该待处理视频划分为一个或多个视频片段,根据一定的时间间隔从一个或多个视频片段的每一个视频片段中选取至少一张图像;至少一张图像组成一个图像集合;一个图像集合对应一个视频片段;一个或多个图像集合包括n张图像。

[0218]

在一些实施例中,第一模型可以是深度残差网络(deep residual network,resnet)。服务器可以基于resnet,获得视频特征向量,resnet可以在网络深度增加的过程中,有效提升模型训练的准确率。具体地,在本技术实施例中以待处理视频为选取的n张图像为例。本技术也可以通过其它网络模型获得视频特征向量,对此不作限制。

[0219]

服务器可以将该n张图像输入至resnet中,该resnet可以包括至少一层卷积层和至少一层池化层,该卷积层用于提取输入的数据的特征;池化层用于对输入的数据进行采

样。卷积层和池化层均包括激活函数。

[0220]

在本技术实施例中,卷积层可以用于提取输入的n张图像的初始特征。具体地,第一步,将n张图像进行向量转换,得到n个图像向量,n个图像向量可以组合为一个图像向量矩阵。第二步,将该图像向量矩阵输入至卷积层,使用卷积核与图像向量矩阵进行卷积运算,也就是将图像向量矩阵和卷积核作内积运算,得到图像向量矩阵对应的卷积结果。接下来,基于激活函数对卷积结果进行非线性变换,并且加上偏置向量,得到初始特征向量。第三步,将初始特征向量输入至池化层,可以对初始特征向量进行特征采样。然后,基于激活函数对卷积结果进行非线性变换,并且加上偏置向量,得到视频特征向量。

[0221]

s602:服务器从待处理文本提取特征,得到文本特征向量;待处理文本与待处理视频相对应。

[0222]

在本技术实施例中,待处理文本包括待处理视频的主题信息、标题信息、字幕信息、分类信息中的至少一种。

[0223]

关于如何获得文本特征向量可以参见实施例一中从样本视频中得到文本特征向量的相关描述,这里不再赘述。

[0224]

第二模型的训练方法可以参见上述实施例一中的相关描述,这里不再赘述。

[0225]

第二模型用于提取输入的数据的特征,在本技术实施例中,第二模型用于提取样本文本的特征。由第二模型获得文本特征向量的方法可以参见s601中由第一模型获得视频特征向量的方法,这里不再赘述。在本技术实施例中,第二模型可以是双向注意力神经网络模型(bidirectional encoder representation from transformers,bert),也可以是其它网络模型,本技术对此不作限制。

[0226]

s603:服务器将文本特征向量与视频特征向量进行拼接,得到多模态特征向量。

[0227]

在一些实施例中,待处理文本包括一条文本,该一条文本对应一个文本特征向量,视频特征向量包括n个图像特征向量。可以将n个图像特征向量分别依次与文本特征向量进行拼接,得到的多模态特征向量一行或一列包括一个图像特征向量和文本特征向量。

[0228]

例如,该视频特征向量为一个n2×

1024的特征向量矩阵,文本特征向量为一个包含768个元素的一维向量,可以将文本特征向量依次直接拼接在每一个图像特征向量的后面或者前面,形成的n2×

(1024 768)的特征向量矩阵,即为多模态特征向量。

[0229]

在另一些实施例中,待处理文本包括多条文本,可以从多条文本中分别提取特征,得到多个文本特征向量,文本特征向量与文本一一对应。可以将n个图像特征向量中的每一个图像特征向量与每一个图像特征向量对应的文本特征向量进行拼接,得到的多模态特征向量一行或一列包括一个图像的图像特征向量和一个图像对应的文本的文本特征向量。

[0230]

这里以m个文本特征向量为例,m个文本特征向量与n个图像特征向量存在对应关系。例如,图像特征向量包括n个图像特征向量,文本特征向量包括m个文本特征向量,n和m均为正整数,两者可以相等,也可以不相等。当m=n时,文本特征向量与图像特征向量一一对应。其中,在一种可能的实现中,第一个图像特征向量与第一个文本特征向量相对应;第二个图像特征向量与第二个文本特征向量相对应;第三个图像特征向量与第三个文本特征向量相对应。在这种情况下,服务器可以将第一个文本特征向量拼接在第一个图像特征向量的后面或者前面;将第二个文本特征向量拼接在第二个图像特征向量的后面或者前面;以此类推,将n个图像特征向量分别和与之对应的文本特征向量进行拼接,形成多模态特征

向量。

[0231]

应理解,还可以通过其它方式对图片特征向量和文本特征向量进行拼接,本技术对此不作限制。

[0232]

s604:服务器将多模态特征向量进行特征融合,得到融合特征向量。

[0233]

在一些实施例中,服务器可以将多模态特征向量输入到融合模块,得到融合特征向量。融合模块的训练方法可以参见上述实施例一中的相关描述,这里不再赘述。

[0234]

该融合模块可以是卷积神经网络,该卷积网络可以包括至少一层卷积层和至少一层池化层。该卷积层用于提取多模态特征向量的特征,得到初始特征向量,该池化层用于对初始特征向量进行采样,得到更精确的融合特征向量。卷积层和池化层均包括激活函数。

[0235]

具体地,服务器将该多模态特征向量输入至卷积层,使用卷积核与多模态特征向量进行卷积运算,也就是将多模态特征向量和卷积核作内积运算,得到多模态特征向量对应的卷积结果。接下来,基于激活函数对卷积结果进行非线性变换,并且加上偏置向量,得到初始特征向量。第三步,将初始特征向量输入至池化层,可以对初始特征向量进行特征采样。然后,基于激活函数对卷积结果进行非线性变换,并且加上偏置向量,得到融合特征向量。

[0236]

在另一些实施例中,服务器也可以通过其他方式得到融合特征向量,融合模块也可以为循环神经网络,深度残差网络等其它网路模型。本技术对此不作限制。

[0237]

s605:服务器基于融合特征向量对待处理视频进行分类,得到待处理视频的标签。

[0238]

在一些实施例中,服务器可以将融合特征向量输入至分类模块,得到待处理视频的标签。该分类模块可以包括至少一层全连接层,该全连接层可以对待处理行分类,以便得到待处理视频的标签。另外,该全连接层包括激活函数,激活函数包括权重矩阵和偏置常量。分类模块的训练方法可以参见上述实施例一中的相关描述,这里不再赘述。

[0239]

具体地,服务器可以将融合特征向量输入至全连接层,基于激活函数的权重矩阵和偏置向量,对融合特征向量进行非线性变换,得到融合特征向量中的每个特征的预测分数。当每个特征的预测分数大于第一阈值时,将该特征标记为主要特征,例如,第一阈值可以取60分;接下来,将主要特征进行归一化,得到待处理视频中每个特征为待处理视频的标签的预测概率,当该特征的预测概率大于第二阈值时,可以将该特征确定为待处理视频的标签,例如,第二阈值可以取0.5分。

[0240]

例如,融合特征向量中包含“猪蹄、美女、美食、桌子、水杯”五个特征,其中,该五个特征的预测分数分别为80分,60分,70分,50分,40分。若第一阈值为60分,在将五个特征的预测分数分别和第一阈值对比后,可以确定猪蹄、美食、美女为主要特征,其中,三个主要特征的预测概率分别为0.8、0.7、0.6;若第二阈值为0.5,在将三个主要特征的预测概率分别和第二阈值对比后,可以确定猪蹄、美食、美女为待处理视频的标签。

[0241]

应理解,实施例一和实施例二中的n和m可以不同。

[0242]

本技术实施例提供的该视频处理方法,可以通过融合多模态信息,获得待处理视频的标签,在本技术实施例中,以视频信息和文本信息为例。通过该视频处理方法获得待处理视频的标签,可以实现以下三个技术效果:

[0243]

(1)通过融合多模态信息,可以充分发挥各模态信息互补的优势。

[0244]

(2)利用文本信息可以有效将模型识别从感知层面提升到认知层面,从而更好地

对视频标签进行排序,得出与视频内容主旨最相关的标签。

[0245]

(3)基于卷积操作,对多模态信息包含的特征进行特征融合,可以达到强化图文信息交互的目的。

[0246]

进一步地,请参见图7,图7是本技术实施例提供的一种视频处理装置的结构示意图。其中,该视频处理装置可以包括:第一信息提取模块10、第二信息提取模块20、多模态特征模块30、融合模块40、分类模块50。

[0247]

第一信息提取模块10,用于从待处理视频中提取特征,得到视频特征向量;

[0248]

第二信息提取模块20,用于从待处理文本提取特征,得到文本特征向量;所述待处理文本与所述待处理视频相对应;

[0249]

多模态特征模块30,用于将所述文本特征向量与所述视频特征向量进行拼接,得到多模态特征向量;

[0250]

融合模块40,用于将所述多模态特征向量进行特征融合,得到融合特征向量;

[0251]

分类模块50,用于基于所述融合特征向量对所述待处理视频进行分类,得到所述待处理视频的标签。

[0252]

在一些实施例中,第一信息提取模块10,可以用于从所述n张图像中分别提取特征,得到所述n个图像特征向量。

[0253]

在一些实施例中,多模态特征模块30,用于将所述n个图像特征向量分别依次与所述文本特征向量进行拼接,所述多模态特征向量一行或一列包括一个图像特征向量和所述文本特征向量。

[0254]

在另一些实施例中,第二信息提取模块20,可以用于从所述多条文本中分别提取特征,得到多个文本特征向量,所述文本特征向量与所述文本一一对应。其中,所述待处理文本包括多条文本。

[0255]

多模态特征模块30,还可以用于将所述n个图像特征向量中的每一个图像特征向量与所述每一个图像特征向量对应的文本特征向量进行拼接,所述多模态特征向量一行或一列包括一个图像的图像特征向量和所述一个图像对应的文本的文本特征向量。

[0256]

融合模块40,可以用于将所述多模态特征向量输入到融合模块,得到融合特征向量。

[0257]

所述融合模块包括至少一层第一卷积层和与至少一层第一池化层;其中,

[0258]

所述第一卷积层用于提取输入的数据的特征,所述池化层用于对输入的数据进行采样。

[0259]

分类模块50,可以用于将所述融合特征向量输入到分类模块,得到所述待处理视频的标签;所述分类模块包括至少一层第一全连接层。

[0260]

第二信息提取模块20,可以用于对所述待处理文本进行分词,得到所述待处理文本的多个词语;

[0261]

将所述多个词语分别进行向量转换,得到所述多个词语分别对应的词向量;

[0262]

将所述多个词语分别对应的词向量输入到第一模型,得到文本特征向量;

[0263]

所述文本特征向量包括所述多个词语分别对应的词向量;

[0264]

所述第一模型用于提取输入的数据的特征。

[0265]

其中,所述待检测文本包括视频主题信息、视频标题信息、视频字幕信息、视频分

类信息中的至少一种。

[0266]

请参见图8,图8是本技术实施例提供的一种机器学习模型训练装置的结构示意图。其中,该视频处理装置可以包括:第一获取模块10、第二获取模块20、第二多模态特征模块30、第二融合模块40、第二分类模块50、信息处理模块60。

[0267]

第一获取模块10,可以用于将样本视频输入第一模型,得到视频特征向量.

[0268]

第二获取模块20,可以用于将样本文本输入第二模型,得到文本特征向量;所述待处理文本与所述待处理视频相对应。

[0269]

第二多模态特征模块30,可以用于将所述文本特征向量与所述视频特征向量进行拼接,得到多模态特征向量。

[0270]

第二融合模块40,可以用于将所述多模态特征向量输入到融合模块,得到融合特征向量。

[0271]

第二分类模块50,可以用于将所述融合特征向量输入到分类模块,得到所述样本视频的预测标签。

[0272]

信息处理模块60,可以用于基于所述样本视频的预测标签与标注标签之间的误差调节所述融合模块和所述分类模块的模型参数。具体地,可以分为以下三种情况:

[0273]

基于所述样本视频的预测标签与标注标签之间的误差调节所述第一模型、所述第二模型、所述融合模块和所述分类模块的模型参数;

[0274]

或,

[0275]

基于所述样本视频的预测标签与标注标签之间的误差调节所述第一模型、所述融合模块和所述分类模块的模型参数;

[0276]

或,

[0277]

基于所述样本视频的预测标签与标注标签之间的误差调节所述第二模型、所述融合模块和所述分类模块的模型参数;

[0278]

或,

[0279]

基于所述样本视频的预测标签与标注标签之间的误差调节所述融合模块和所述分类模块的模型参数。

[0280]

本技术实施例还提供了一种计算机存储介质,该计算机存储介质中存储有程序指令,所述程序执行时可包括如实施例一或实施例二中的方法的部分或全部步骤。

[0281]

可以理解的是,在本技术的具体实施方式中,涉及到样本视频、样本文本、待处理视频、待处理文本等相关的数据,在本技术以上实施例运用到具体产品或技术中时,需要获得用户许可或者同意,且相关数据的收集、使用和处理需要遵守相关国家和地区的相关法律法规和标准。

[0282]

需要说明的是,对于前述的各个方法实施例,为了简单描述,故将其都表述为一系列的动作组合,但是本领域技术人员应该知悉,本技术并不受所描述的动作顺序的限制,因为依据本技术,某一些步骤可以采用其他顺序或者同时进行。其次,本领域技术人员也应该知悉,说明书中所描述的实施例均属于优选实施例,所涉及的动作和模块并不一定是本技术所必须的。

[0283]

本领域普通技术人员可以理解上述实施例的各种方法中的全部或部分步骤是可以通过程序来指令相关的硬件来完成,该程序可以存储于一计算机可读存储介质中,存储

介质可以包括:闪存盘、只读存储器(read-only memory,rom)、随机存取器(random access memory,ram)、磁盘或光盘等。

[0284]

本技术实施例还提供了一种计算机程序产品或计算机程序,该计算机程序产品或计算机程序包括计算机指令,该计算机指令存储在计算机可读存储介质中。服务器的处理器从计算机可读存储介质读取该计算机指令,处理器执行该计算机指令,使得该服务器执行上述各方法的实施例中所执行的步骤。

[0285]

以上对本技术实施例所提供的一种视频处理方法、机器学习模型训练方法及相关装置、设备进行了详细介绍,本文中应用了具体个例对本技术的原理及实施方式进行了阐述,以上实施例的说明只是用于帮助理解本技术的方法及其核心思想;同时,对于本领域的一般技术人员,依据本技术的思想,在具体实施方式及应用范围上均会有改变之处,综上所述,本说明书内容不应理解为对本技术的限制。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。