1.本发明涉及信息检索技术领域,尤其涉及一种神经网络训练方法、图片分类方法及图片分类系统。

背景技术:

2.深度学习是从数据中学习的一种技术,目前在业界得到广泛的应用,基于深度学习的图片分类具有较高的准确率。

3.深度学习之所以强大,是因为其可以从数据中能够学习到特征,从而挖掘新的规律,但深度学习也有其局限性,只适用于其在和训练集的数据里相似特征的,当同样的深度学习网络或者模型应用在新的领域时候,还得需要重新进行训练或者调整。也就是说迁移到新的领域或者当出现的新图片,此在原来训练集中都没有出现过的领域则识别不出来。

4.为了解决深度学习的局限性,目前的unsupervised domain adaptation(uda)领域自适应是一种提升不同领域图片分类准确率的算法。但目前uda只能是一种领域迁移到另外一种领域,属于一对一的迁移,此外业界也有提出一对多迁移的尝试,但准确率并不理想。

技术实现要素:

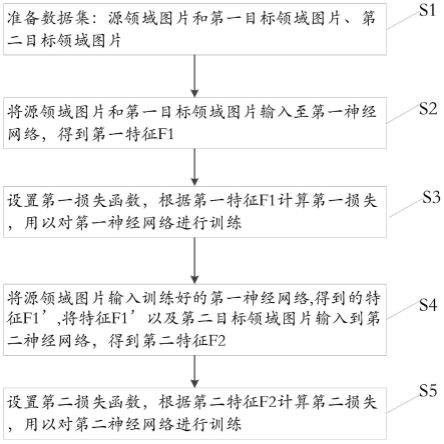

5.本发明为解决现有技术中存在的技术问题,提出一种神经网络训练方法,包括步骤:

6.s1:准备数据集:源领域图片和第一目标领域图片、第二目标领域图片;

7.s2:将源领域图片和第一目标领域图片输入至第一神经网络,得到第一特征f1;

8.s3:设置第一损失函数,根据第一特征f1计算第一损失,用以对第一神经网络进行训练;

9.s4:将源领域图片输入训练好的第一神经网络,得到的特征f1’,将特征f1’以及第二目标领域图片输入到第二神经网络,得到第二特征f2;

10.s5:设置第二损失函数,根据第二特征f2计算第二损失,用以对第二神经网络进行训练。

11.进一步地,还包括步骤s6:训练第三神经网络,其方法为:

12.准备源领域图片和第三目标领域图片;

13.将源领域图片输入至训练得到的第一神经网络和第二神经网络,得到第二特征f2’;

14.将特征f2’以及第三目标领域图片输入到第三神经网络,计算第三神经网络的损失值并进行训练。

15.进一步地,所述第一神经网络为densenet。

16.进一步地,所述第二神经网络为densenet。

17.进一步地,第一损失函数为mmd损失和ce损失加权求和,其中:

18.mmd损失为源域和第一目标域特征求得;

19.ce损失为源域图片和第一目标域图片交叉熵之和。

20.进一步地,第二损失函数为mmd损失和ce损失加权求和,其中:

21.mmd损失为源域和第二目标域特征求得;

22.ce损失为源域图片和第二目标域图片交叉熵之和。

23.本发明还提供一种图片分类方法,包括步骤:

24.接收输入的图片;

25.神经网络模型对图片进行分析并分类;

26.返回输出结果,

27.所述神经网络为所述神经网络训练方法得到的神经网络模型。

28.本发明还提供一种图片分类系统,包括交互单元、处理模块,其中:

29.交互单元用以接收输入的图片;

30.处理模块用以对输入的图片进行处理并向交互单元返回分类结果,

31.所述神经网络为所述神经网络训练方法得到的神经网络模型。

32.本发明还提供一种计算机可读存储介质,所述存储介质中存储有指令或者程序,所述指令或者程序由处理器加载并执行如所述的图片分类方法。

33.本发明还提供一种电子设备,包括:处理器、存储介质和总线,所述存储介质存储有所述处理器可执行的机器可读指令,当电子设备运行时,所述处理器与所述存储介质之间通过总线通信,所述处理器执行所述机器可读指令,以执行所述的图片分类方法。

34.本发明公开的方法和系统中所述模块,在实际应用中,即可以在一台目标服务器上部署多个模块,也可以每一模块独立部署在不同的目标服务器上,特别的,根据需要,为了提供更强大的计算处理能力,也可以根据需要将模块部署到集群目标服务器上。

35.由此可见,本发明能够实现一对多的领域迁移,能够有效解决解决领域漂移问题,使得目标领域能够取得更好的学习效果也即一种源领域迁移到多种目标领域的图片分类的技术方案。

36.为了对本发明有更清楚全面的了解,下面结合附图,对本发明的具体实施方式进行详细描述。

附图说明

37.为了更清楚地说明本技术实施例中的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍。显而易见地,下面描述中的附图仅仅是本技术的一些实施例,对于本领域技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

38.图1为本技术实施例的神经网络训练方法流程示意图。

39.图2为本技术实施例的神经网络训练的结构示意图。

具体实施方式

40.本文提出的技术方案,实现一对多的领域迁移,能够有效解决领域漂移问题,使得目标领域能够取得更好的学习效果也即一种源领域迁移到多种目标领域的图片分类的技

术方案。

41.本技术所述的领域,泛指在迁移学习技术中的概念中,即把一个领域(即源领域)的知识,迁移到另外一个领域(即目标领域)。也包括不同的场景下的图片,比如灯光较强时候拍的图片是一种领域,灯光较弱又是另外一种领域。

42.本技术首先训练使用源领域图片和第一个目标领域图片训练第一个神经网络,从而可以实现第一目标领域的知识迁移,即能对第一目标领域图片的识别和分类。

43.然后再用训练好的第一神经网络作为源领域图片的输入,以及第二目标领域图片一起训练第二神经网络,又实现对第二目标图片的识别和分类。

44.基于上述训练好的第一神经网络、第二神经网络和新的目标图片(即第三目标图片)一起训练一个新的神经网络(即第三神经网络),从而又可以对第三目标图片(也即另外一个新领域的目标图片)进行识别和分类。

45.此外,作为变化的实施例方式,还可以根据第二神经网络的损失函数进行训练第二神经网络的时候,也可以同时训练(更新)第一神经网络的。

46.如此不断迭代,可以不断地迁移到另一个新的目标领域,从而实现一对多的领域迁移。

47.请参阅图1以及图2,本技术针对现有技术的技术缺陷,公开一种神经网络训练方法,包括步骤:

48.s1:准备数据集:源领域图片和第一目标领域图片、第二目标领域图片;

49.s2:将源领域图片和第一目标领域图片输入至第一神经网络,得到第一特征f1;

50.s3:设置第一损失函数,根据第一特征f1计算第一损失,用以对第一神经网络进行训练;

51.s4:将源领域图片输入训练好的第一神经网络,得到的特征f1’,将特征f1’以及第二目标领域图片输入到第二神经网络,得到第二特征f2;

52.s5:设置第二损失函数,根据第二特征f2计算第二损失l2,用以对第二神经网络进行训练。

53.此外,基于训练第一神经网络、第二神经网络的基础上,还包括步骤s6:训练第三神经网络,其方法为:

54.准备第三目标领域图片;

55.将源领域图片输入至训练得到的第一神经网络和第二神经网络,得到第二特征f’;

56.将特征f2’以及第三目标领域图片输入到第三神经网络,计算第三神经网络的损失值并进行训练。

57.作为优选的实施方式,上述第一神经网络、第二神经网络、第三神经网络可以使用相同的网络结构模型,比如densenet,也可以根据需要,使用不同的神经网络对应在不同的目标领域图片上使用。

58.作为优选的实施方式,第一神经网络所设置的第一损失函数为mmd损失和ce损失加权求和,其中:

59.mmd损失为源域和第一目标域特征求得;

60.ce损失为源域图片和第一目标域图片交叉熵之和。

61.作为一种优选的实施方式,第一损失函数的公式可以表示为:

62.l1=l

mmd

γl

ce

63.其中,γ为加权系数。

64.第二神经网络、第三神经网络也可以使用和第一神经网络一样的损失函数,也可以根据实际情况,选择其他的损失函数来做训练。

65.基于上述实施例,本技术还提供一种图片分类方法,包括步骤:

66.接收输入的图片;

67.神经网络模型对图片进行分析并分类;

68.返回输出结果,

69.所述神经网络为上述实施例神经网络训练方法得到的神经网络模型。

70.相应地,基于上述实施例,本技术还提供一种图片分类系统,包括交互单元、处理模块,其中:

71.交互单元用以接收输入的图片;

72.处理模块用以对输入的图片进行处理并向交互单元返回分类结果,

73.所述处理模块为上述实施例神经网络训练方法得到的神经网络模型。

74.本技术实施例还提供一种计算机可读存储介质,所述存储介质中存储有指令或者程序,所述指令或者程序由处理器加载并执行如所述的图片分类方法。

75.本技术实施例还提供一种电子设备,包括:处理器、存储介质和总线,所述存储介质存储有所述处理器可执行的机器可读指令,当电子设备运行时,所述处理器与所述存储介质之间通过总线通信,所述处理器执行所述机器可读指令,以执行如所述的图片分类方法。

76.需要说明的是,本领域普通技术人员可以理解上述实施例的各种方法中的全部或部分步骤是可以通过计算机程序来指令相关的硬件来完成,所述计算机程序可以存储于计算机可读存储介质中,所述存储介质可以包括但不限于:只读存储器(rom,read only memory)、随机存取存储器(ram,random access memory)、磁盘或光盘等。

77.对所公开的实施例的上述说明,使本领域专业技术人员能够实现或使用本发明。对这些实施例的多种修改对本领域的专业技术人员来说将是显而易见的,本文中所定义的一般原理可以在不脱离本发明的精神或范围的情况下,在其它实施例中实现。因此,本发明将不会被限制于本文所示的这些实施例,而是要符合与本文所公开的原理和新颖特点相一致的最宽的范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。