1.本发明涉及一种推定车辆的当前位置的车辆位置推定装置。

背景技术:

2.作为这种装置,以往已知有基于由gps接收器取得的车辆的当前位置和地图信息,推定车辆在地图上的当前位置的装置。这样的装置例如记载于专利文献1中。在专利文献1记载的装置中,从由车载相机取得的车辆周围的拍摄图像中确定可能存在道路标志的区域,基于所确定的区域的图像计算车辆相对于道路标志的相对位置,使用该计算结果推定车辆在地图信息中的当前位置。

3.然而,针对每一道路标志,道路标志所设置的高度、位置不同,因此如专利文献1中记载的装置那样,要是确定了可能存在道路标志的区域,难以精确地推定车辆在地图信息中的当前位置。

4.现有技术文献

5.专利文献

6.专利文献1:日本特开2017-9554号公报(jp2017-9554a)。

技术实现要素:

7.本发明的一技术方案的车辆位置推定装置,具备:检测器,其搭载于车辆,检测车辆的周围;识别部,其识别根据由检测器取得的检测数据确定的检测区域中所包含的移动物体;区域划分部,其将根据由检测器取得的检测数据确定的检测区域划分为包括移动物体的第1区域和不包括移动物体的第2区域;特征点提取部,其从第2区域提取检测数据的特征点;以及处理执行部,其基于由特征点提取部提取出的特征点中的与第2区域相对应的特征点执行规定的处理。处理执行部执行使用由特征点提取部提取出的特征点制作点云地图的处理和基于由检测器取得的检测数据随着时间经过的位置变化推定车辆的位置的处理中的至少一种处理。

附图说明

8.本发明的目的、特征以及优点,通过与附图相关的以下实施方式的说明进一步阐明。

9.图1是示出应用本发明的实施方式的车辆控制系统的自动驾驶车辆的行驶系统的概略构成的图。

10.图2是概略地示出本发明的实施方式的车辆控制系统的整体构成的框图。

11.图3是示出本发明的实施方式的由车辆自带的相机取得的拍摄图像的一例的图。

12.图4是示出本实施方式的车辆的车辆位置推定装置的主要部分构成的框图。

13.图5是示出由图4的控制器的cpu执行的处理的一例的流程图。

14.图6是示出用于说明包括移动物体的矩形区域的图。

具体实施方式

15.以下参照图1~图6对本发明的实施方式进行说明。本发明的实施方式的车辆控制系统应用在具有自动驾驶功能的车辆(自动驾驶车辆)。图1是示出应用本实施方式的车辆控制系统的自动驾驶车辆100(有时简称为车辆或自车辆)的行驶系统的概略构成的图。车辆100不仅能够在不需要驾驶员进行驾驶操作的自动驾驶模式下行驶,还能够在通过驾驶员的驾驶操作的手动驾驶模式下行驶。需要说明的是,在本实施方式中,将不需要加速操作、制动操作以及转向的全部操作的驾驶模式称为自动驾驶模式。

16.如图1所示,车辆100具有发动机1和变速器2。发动机1是将经由节气门阀11所供给的吸入空气和从喷射器12喷射出的燃料以适当的比例混合并由火花塞等点火而使它们燃烧,由此产生旋转动力的内燃机(例如汽油发动机)。需要说明的是,还能够使用柴油发动机等各种发动机来代替汽油发动机。吸入空气量由节气门阀11来调节,节气门阀11的开度由利用电信号而工作的节气门用执行器的驱动来变更。节气门阀11的开度和从喷射器12喷射出的燃料的喷射量(喷射时期、喷射时间)由控制器40(图2)来控制。

17.变速器2设置于发动机1与驱动轮3之间的动力传递路径上,使来自发动机1的旋转变速且转换来自发动机1的转矩而输出。在变速器2变速后的旋转传递至驱动轮3,由此车辆100行驶。需要说明的是,还能够代替发动机1或在发动机1的基础上设置作为驱动源的行驶用马达,将车辆100构成为电动汽车、混合动力汽车。

18.变速器2例如为能够对应多个挡位阶段性地变更变速比的有级变速器。需要说明的是,还能够使用能够无级地变更变速比的无级变速器作为变速器2。还可以将来自发动机1的动力经由变矩器输入到变速器2,省略图示。变速器2具备例如牙嵌式离合器、摩擦离合器等接合元件21,液压控制装置22控制油从液压源向接合元件21的流动,由此能够变更变速器2的挡位。液压控制装置22具有由电信号驱动的控制阀,根据控制阀的驱动变更压力油向接合元件21的流动,由此能够设定适当的挡位。

19.图2是概略地示出本实施方式的车辆控制系统10的整体构成的框图。如图2所示,车辆控制系统10主要具有控制器40以及分别与控制器40电连接的外部传感器组31、内部传感器组32、输入/输出装置33、定位传感器34、地图数据库35、导航装置36、通信单元37、行驶用的执行器ac。

20.外部传感器组31是检测车辆100的周边信息、即外部状况的多个传感器的总称。例如外部传感器组31包括测定从车辆100到周边的障碍物的距离的激光雷达和检测车辆100的周边的其他车辆、障碍物等的雷达。例如外部传感器组31还包括相机、麦克风(以下简称为麦克)等,相机搭载于车辆100,具有ccd、cmos等摄像元件,拍摄车辆100的周边(前方、后方以及侧方),麦克风输入来自车辆100的周边的声音的信号。由外部传感器组31检测出的信号和输入到外部传感器组31的信号被发送至控制器40。

21.内部传感器组32是检测车辆100的行驶状态、车内的状态的多个传感器的总称。例如内部传感器组32包括:检测车辆100的车速的车速传感器、分别检测车辆100的前后方向的加速度和左右方向的加速度(横向加速度)的加速度传感器、检测发动机1的转速的发动机转速传感器、检测车辆100的重心绕铅垂轴旋转的旋转角速度的横摆角速度传感器、检测节气门阀11的开度(节气门开度)的节气门开度传感器等。检测手动驾驶模式下的驾驶员的驾驶操作、例如对加速踏板的操作、对制动踏板的操作、对转向的操作等的传感器也包括在

内部传感器组32中。内部传感器组32的检测信号被发送至控制器40。

22.输入/输出装置33是从驾驶员输入指令、向驾驶员输出信息的装置的总称。例如输入/输出装置33包括供驾驶员通过对操作构件的操作来输入各种指令的各种开关、供驾驶员通过语音输入指令的麦克、借助显示图像向驾驶员提供信息的显示部、通过语音向驾驶员提供信息的扬声器等。各种开关包括指示自动驾驶模式和手动驾驶模式中的一者的手动/自动切换开关(sw)。

23.手动/自动切换开关例如构成为供驾驶员能够进行手动操作的开关,根据开关操作输出向使自动驾驶功能有效化的自动驾驶模式或使自动驾驶功能无效化的手动驾驶模式切换的指令。无论对手动/自动切换开关的操作如何,在规定的行驶条件成立时,都能够指示从手动驾驶模式向自动驾驶模式切换或从自动驾驶模式向手动驾驶模式切换。即,还能够通过手动/自动切换开关自动地进行切换,自动地而非手动地进行模式切换。

24.定位传感器34例如为gps传感器,接收从gps卫星发送出的定位信号,基于接收到的信号测定车辆100的绝对位置(纬度、经度等)。需要说明的是,定位传感器34不仅包括gps传感器,还包括利用从准天顶轨道卫星发送出的电波进行定位的传感器。来自定位传感器34的信号(示出测定结果的信号)被发送至控制器40。

25.地图数据库35是存储在导航装置36中使用的一般性地图信息的装置,例如由硬盘构成。地图信息中包括:道路的位置信息、道路形状(曲率等)的信息、交叉路口、岔路口的位置信息。另外,存储于地图数据库35中的地图信息与存储于控制器40的存储部42中的高精度地图信息不同。

26.导航装置36是搜索到达由驾驶员输入的目的地的道路上的目标路线并进行沿目标路线的引导的装置。通过输入/输出装置33进行目的地的输入和沿目标路线的引导。基于由定位传感器34测定出的车辆100的当前位置和存储于地图数据库35中的地图信息来计算目标路线。

27.通信单元37利用包括互联网线路等无线通信网的网络与未图示的各种服务器进行通信,定期或者在任意时机从服务器取得地图信息和交通信息等。所取得的地图信息被输出到地图数据库35、存储部42,地图信息被更新。所取得的交通信息包括交通拥堵信息、信号从红变绿的剩余时间等的信号信息。

28.执行器ac是用于使与车辆100的行驶动作有关的各种设备工作的设备。执行器ac包括图1所示的调整发动机1的节气门阀11的开度(节气门开度)的节气门用执行器、控制油向接合元件21的流动,变更变速器2的挡位的变速用执行器、使制动装置工作的制动用执行器以及驱动转向装置的转向用执行器等。

29.控制器40由电子控制单元(ecu)构成。另外,能够将发动机控制用ecu、变速器控制用ecu等功能不同的多个ecu分开设置,但方便起见,图2中示出控制器40作为这些ecu的集合。控制器40包含具有cpu(中央处理器)等运算部41、rom(只读存储器)、ram(随机存取存储器)、硬盘等存储部42以及未图示的其他外围电路的计算机而构成。

30.在存储部42中存储包括车道的中央位置信息、车道位置的边界信息等高精度的详细地图信息(以下称为高精度地图信息)。更具体而言,存储道路信息、交通管制信息、住所信息、设施信息、电话号码信息等作为地图信息。道路信息中包括:表示高速道路、收费道路、国道等道路类别的信息、道路的车道数、各车道的宽度、道路的坡度、道路的三维坐标位

置、车道的拐弯处的曲率、车道的汇合点和分岔点的位置、道路标志、有无中央分离带等信息。交通管制信息中包括:车道因施工等被限制行驶或者禁止通行的信息等。在存储部42中还存储作为变速动作的基准的换挡图(变速线图)、各种控制的程序以及在程序中使用的阈值等信息。

31.运算部41具有自车位置识别部43、外界识别部44、行动计划生成部45、行驶控制部46作为与自动行驶有关的功能性构成。

32.自车位置识别部43基于由定位传感器34接收到的车辆100的位置信息和地图数据库35的地图信息来识别地图上的车辆100的位置(自车位置)。另外,自车位置识别部43也可以使用存储于存储部42中的地图信息(建筑物的形状等信息)和外部传感器组31检测出的车辆100的周边信息来识别自车位置,由此能够高精度地识别自车位置。例如,自车位置识别部43能够使用存储于存储部42中的地图信息和由外部传感器组31的相机拍摄的车辆100的周围的图像数据(以下称为拍摄图像数据或简称为拍摄图像)识别自车位置。还有,在能够用设置在道路上、道路旁边的外部的传感器测定自车位置时,也能够通过借助通信单元37与该传感器进行通信,高精度地识别自车位置。

33.外界识别部44基于来自激光雷达、雷达、相机等外部传感器组31的信号识别车辆100的周围的外部状况。例如识别在车辆100的周边行驶的周边车辆(前方车辆、后方车辆)的位置、速度、加速度、在车辆100的周围停车或驻车着的周边车辆的位置以及其他物体的位置、状态等。其他物体包括:标志、信号机、道路的边界线、停止线、建筑物、栏杆、电线杆、广告牌、行人、自行车等。其他物体的状态包括:信号机的颜色(红、绿、黄)、行人、自行车的移动速度、朝向等。

34.行动计划生成部45例如基于由导航装置36计算出的目标路线、由自车位置识别部43识别出的自车位置、由外界识别部44识别出的外部状况,生成从当前时间点开始经过规定时间为止的车辆100的行驶轨迹(目标轨迹)。当目标路径上存在作为目标轨迹的候补的多个轨迹时,行动计划生成部45从中选择遵守法律且满足高效、安全地行驶等基准的最佳轨迹,并将所选择的轨迹作为目标轨迹。然后,行动计划生成部45生成与所生成的目标轨迹相对应的行动计划。

35.行动计划中包括在从当前时间点开始经过规定时间t(例如5秒)为止的期间内,每单位时间δt(例如0.1秒)设定的行驶计划数据,即与每单位时间δt的时刻相对应地设定的行驶计划数据。行驶计划数据包括每单位时间的车辆100的位置数据和车辆状态的数据。位置数据是例如示出道路上的二维坐标位置的目标点的数据,车辆状态的数据是表示车速的车速数据和表示车辆100的朝向的方向数据等。行驶计划每单位时间被更新。

36.行动计划生成部45通过将从当前时间点开始经过规定时间t为止的每单位时间δt的位置数据按照时间顺序连接起来,生成目标轨迹。此时,基于目标轨迹上的每单位时间δt的各目标点的车速(目标车速),计算每单位时间δt的加速度(目标加速度)。即,行动计划生成部45计算目标车速和目标加速度。另外,还可以由行驶控制部46计算目标加速度。

37.行动计划生成部45在生成目标轨迹时首先决定行驶方式。具体而言,决定跟随前方车辆的跟随行驶、用于超越前方车辆的超车行驶、变更行驶车道的车道变更行驶、与高速道路、收费道路的主干线汇合的汇合行驶、不偏离行驶车道而保持车道的车道保持行驶、定速行驶、减速行驶或加速行驶等行驶方式。然后基于行驶方式生成目标轨迹。

38.行驶控制部46对各执行器ac进行控制,以使在自动驾驶模式下车辆100沿着由行动计划生成部45生成的目标轨迹行驶。即,分别对节气门用执行器、变速用执行器、制动用执行器以及转向用执行器等进行控制,以使车辆100通过每单位时间的目标点p。

39.更具体而言,行驶控制部46考虑到在自动驾驶模式下由道路坡度等决定的行驶阻力,计算用于获取由行动计划生成部45计算出的每单位时间的目标加速度的要求驱动力。然后,例如对执行器ac进行反馈控制,以使由内部传感器组32检测出的实际加速度成为目标加速度。即,以车辆100以目标车速和目标加速度行驶的方式控制执行器ac。另外,在手动驾驶模式下,行驶控制部46根据由内部传感器组32取得的来自驾驶员的行驶指令(加速器开度等)对各执行器ac进行控制。

40.然而,自车位置识别部43在使用由外部传感器组31的相机取得的车辆100的周围的拍摄图像识别车辆100的位置时,基于以车辆100的周围的物体为基准的相对的位置关系推定自车位置。但是,有时由相机31a取得的拍摄图像包括在前方行驶的车辆等移动的物体(以下称为移动物体)。图3是示出本实施方式的由相机31a取得的拍摄图像的一例的图。图3的拍摄图像im是由在左侧通行的单侧2车道的道路行驶的车辆100的相机31a取得的车辆100的前方的拍摄图像。关于图中的粗线bd1、bd2、bd3以及正方形的区域fp将在后面叙述。在拍摄图像im中作为被摄体包括在车辆100的前方行驶的车辆v1、v2、v3。此时,当以车辆v1、v2、v3那样的移动物体为基准推定自车位置时,有可能使自车位置的推定精度下降。因此,在本实施方式中,为了解决这样的问题,如下构成车辆控制系统10。

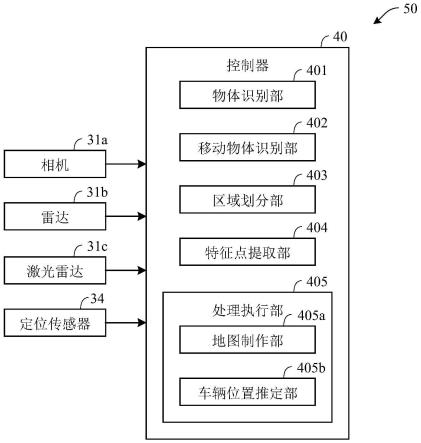

41.图4是示出本实施方式的车辆100的车辆位置推定装置50的主要部分构成的框图。该车辆位置推定装置50为推定车辆100的当前位置的装置,构成图2的车辆控制系统10的一部分。

42.如图4所示,车辆位置推定装置50具备控制器40和与控制器40连接的相机31a、雷达31b、激光雷达31c、定位传感器34。向控制器40输入包括相机31a、雷达31b以及激光雷达31c的外部传感器组31的检测信号(检测数据)、内部传感器组32的检测信号(检测数据)以及来自定位传感器34的信号(数据)。

43.相机31a搭载于车辆100,拍摄车辆100的周围。相机31a例如为由多台相机构成的立体相机。相机31a将拍摄所获取的拍摄图像数据向控制器40输出。雷达31b搭载于车辆100,通过照射电磁波并检测反射波来检测车辆100的周边的其他车辆、障碍物等。雷达31b将检测值(检测数据)向控制器40输出。激光雷达31c搭载于车辆100,测定对应车辆100的全方位的照射光的散射光,从而检测从车辆100到周边的障碍物的距离。激光雷达31c将检测值(检测数据)向控制器40输出。

44.控制器40具有物体识别部401、移动物体识别部402、区域划分部403、特征点提取部404、处理执行部405,作为功能性构成。需要说明的是,以下为了简化说明,以控制器40使用由相机31a取得的拍摄图像(动态图像的帧图像)推定车辆100的车辆的当前位置的情况为例,但控制器40也能够使用对由雷达31b和激光雷达31c取得的检测数据进行图像处理所得到的图像(时间序列的图像),与使用相机31a的拍摄图像的情况相同地推定车辆100的当前位置。还有,控制器40还能够使用由雷达31b和激光雷达31c取得的检测数据(三维点云数据),基于三维点云数据随着时间经过的位置变化来推定车辆100的当前位置。那时,控制器40从由雷达31b和激光雷达31c取得的三维点云数据识别三维空间上的移动物体,用立方

体、轮廓面(曲面)对识别出的移动物体的区域进行划分,将包含于所划分的区域中的点云从三维点云数据中去除后,进行车辆100的当前位置的推定。

45.物体识别部401从对由相机31a取得的检测数据进行图像处理所得到的图像(拍摄图像)中识别被摄体(物体)。需要说明的是,相机31a能够取得车辆100的周围(前方、后方以及侧方)的拍摄图像,但以下为了简化说明,使用车辆100的前方的拍摄图像进行说明。

46.物体识别部401从由相机31a取得的拍摄图像中,根据每一像素的亮度、颜色信息提取边缘,根据提取出的边缘的信息(以下称为边缘信息)提取物体的轮廓。边缘信息中包括示出拍摄图像内中的边缘的位置(坐标)、宽度等的信息。这样,物体识别部401识别拍摄图像中所包含的物体。在图3的拍摄图像im中,车辆v1、v2、v3、建筑物bl1、bl2、道路标志sn、信号机sg、路缘石cu由物体识别部401识别出。需要说明的是,物体识别部401还可以使用其他方法识别拍摄图像中所包含的物体。

47.移动物体识别部402基于由物体识别部401识别出的各物体的区域信息,从各物体中识别移动物体。区域信息为能够确定包括物体在内的区域的信息,为示出该区域的拍摄图像内的位置(坐标)、区域内的各像素的像素值的信息。在图3的拍摄图像im中,行驶中的车辆v1、v2、v3被识别为移动物体。在这里,对移动物体识别部402的处理进行说明。需要说明的是,以下将拍摄图像的当前的帧称为n帧(第n帧),将n帧的前一帧称为n-1帧。

48.首先,移动物体识别部402对从n帧的图像中取得的各物体的区域信息和从n-1帧的图像中取得的各物体的区域信息进行匹配。更详细而言,移动物体识别部402基于n帧的图像内的各物体的区域信息(像素值)和n-1帧的图像内的各物体的区域信息(像素值),从n帧的图像中识别与n-1帧的图像内的各物体相对应的物体。然后,移动物体识别部402求得所识别出的物体的帧间(n帧与n-1帧之间)的移动量和移动方向。还有,移动物体识别部402基于根据内部传感器组32的传感器检测出的车辆100的车速、舵角求得车辆100的移动量和移动方向。移动物体识别部402将帧间的移动量和移动方向与车辆100的移动量和移动方向不对应的物体识别为移动物体。更详细而言,移动物体识别部402在基于物体的帧间的移动量和移动方向推定出的车辆100的移动量和移动方向的值(推定値)与基于车辆100的车速、舵角求得的车辆100的移动量和移动方向的值(计算值)存在规定程度以上的不同时,将该物体识别为移动物体。例如在推定値与计算值之间的差为车速传感器等各种传感器的测定误差以上时,判定为推定値与计算值存在规定程度以上的不同。需要说明的是,物体识别部401和移动物体识别部402构成例如图2的外界识别部44的一部分。

49.区域划分部403将由相机31a取得的拍摄图像的区域划分为包含由移动物体识别部402识别出的移动物体的区域(以下称为第1区域)和不包含移动物体的区域(以下称为第2区域)。更详细而言,区域划分部403以由物体识别部401提取出的移动物体的轮廓成为第1区域和第2区域的边界的方式划分第1区域和第2区域。图3中的粗线bd1、bd2、bd3示意性地示出了划分第1区域和第2区域的边界。

50.特征点提取部404从第2区域提取特征点。特征点为图像中的特征性部分,例如为边缘的交点(建筑物的角、道路标志的角)等。图3中的各个正方形的区域fp示意性地表示从拍摄图像im提取的特征点。需要说明的是,特征点提取部404还可以在提取了由相机31a取得的拍摄图像的特征点之后,通过除去第1区域中所包含的特征点,来提取第2区域中所包含的特征点。提取特征点可以使用orb(oriented fast and rotated brief)等任意特征点

提取方法。还有,特征点提取部404还可以使用由物体识别部401提取出的边缘的信息提取特征点。

51.处理执行部405基于由特征点提取部404提取出的特征点执行规定的处理。规定的处理包括使用由特征点提取部404提取出的特征点制作环境地图的处理(以下称为地图制作处理)和基于在由相机31a取得的拍摄图像上的由特征点提取部404提取出的特征点随着时间经过的位置变化推定车辆的位置的处理(以下称为车辆位置推定处理)。环境地图为将由特征点提取部404提取出的特征点绘制了的三维点云地图的信息。

52.处理执行部405具有执行上述地图制作处理的地图制作部405a和执行上述车辆位置推定处理的车辆位置推定部405b。地图制作部405a将由特征点提取部404提取出的特征点的位置坐标(在拍摄图像的坐标系所表示的值)转换成在环境地图的坐标系中所表示的值,绘制成环境地图。需要说明的是,地图制作部405a还可以基于所制作的环境地图更新存储于存储部42中的高精度地图信息。

53.车辆位置推定部405b计算由特征点提取部404提取的特征点的帧间(n帧与n-1帧之间)的移动量和移动方向。具体而言,车辆位置推定部405b从n帧中分别检测与n-1帧中的各特征点相对应的特征点,基于各特征点在n-1帧中的位置和在n帧中的位置求得各特征点的帧间的移动量和移动方向。

54.车辆位置推定部405b将表示各特征点的移动量和移动方向的值(在拍摄图像的坐标系中所表示的值)转换成在环境地图的坐标系中所表示的值。需要说明的是,因为由特征点提取部404提取出的特征点为移动物体以外的物体,即静止物体的特征点,所以坐标转换后的各特征点的移动量和移动方向与环境地图上的车辆100(相机31a)的移动量和移动方向相对应。通过从作为环境地图上的基准的地点累计该移动量和移动方向,车辆位置推定部405b推定环境地图上的车辆100的位置。需要说明的是,车辆位置推定部405b构成例如图2的自车位置识别部43的一部分。还有,地图制作部405a的地图制作处理和车辆位置推定部405b的车辆位置推定处理按照slam(simultaneous localization and mapping)算法同时进行。需要说明的是,车辆位置推定部405b还可以将表示各特征点的移动量和移动方向的值(在拍摄图像的坐标系中表示的值)变更成存储于存储部42的高精度地图信息的坐标系中所表示的值,推定高精度地图信息中的车辆100的位置。还有,可以在处理执行部405进行地图制作部405a的地图制作处理和车辆位置推定部405b的车辆位置推定处理中的至少一种处理。

55.图5是示出按照预先存储的程序在图4的控制器40的cpu执行的处理的一例的流程图。该流程图所示的处理例如当控制器40接通电源时开始,每当从相机31a输入拍摄图像时反复进行。需要说明的是,拍摄图像是动态图像,是以帧为单位从相机31a输入。

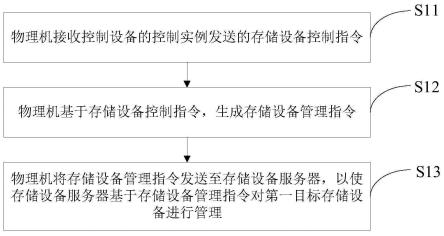

56.首先,在步骤s11中,根据从相机31a输入的拍摄图像(动态图像的帧图像)识别物体。在步骤s12中,判定在步骤s11中识别出的物体中是否存在移动物体。

57.当步骤s12为肯定(s12:是)时进入步骤s13。需要说明的是,在步骤s11中识别出多个物体时,在步骤s12中对各物体进行是否为移动物体的判定,当即使识别出只有1个移动物体时也进入步骤s13。在步骤s13中,将在步骤s11中取得的帧图像的区域划分为包括移动物体的第1区域和不包括移动物体的第2区域,并从第2区域提取特征点。当步骤s12为否定(s12:否)时,在步骤s14中,从在步骤s11中取得的帧图像的全区域提取特征点。在步骤s15

中,计算在步骤s14中提取出的特征点的帧间的移动量和移动方向。更详细而言,示出帧间的移动量和移动方向的移动矢量。在步骤s13或s14中提取出了多个特征点时,计算各特征点的帧间的移动量和移动方向。

58.在步骤s16中,环境地图上绘制在步骤s13或s14中提取出的特征点。通过在车辆100行驶着时反复执行图5所示的处理,制作车辆100行驶的道路周边的环境地图。在步骤s17中,推定车辆100的当前位置。更详细而言,基于在步骤s15中计算出的各特征点的移动量和移动方向,更新环境地图上的车辆100的当前位置。

59.采用本发明的实施方式能够起到如下的作用效果。

60.(1)车辆位置推定装置50具备:检测器(例如相机31a),其搭载于车辆100,检测车辆100的周围;移动物体识别部402,其识别根据由相机31a取得的检测数据确定的检测区域中所包含的移动物体;区域划分部403,其将根据由相机31a取得的检测数据确定的检测区域划分为包括移动物体的第1区域和不包括移动物体的第2区域;特征点提取部404,其从第2区域提取检测数据的特征点;以及处理执行部405,其基于由特征点提取部404提取出的特征点中的与第2区域相对应的特征点执行规定的处理。处理执行部405执行使用由特征点提取部404提取出的特征点制作点云地图的处理和基于由相机31a取得的检测数据随着时间经过的位置变化推定车辆100的位置的处理中的至少一种处理。

61.由此,基于与图像中所包含的道路标志等静止物体(图3的建筑物bl1、bl2、道路标志sn、信号机sg、路缘石cu等)的位置关系推定车辆的当前位置,因此能够精确地推定车辆的当前位置。

62.(2)物体识别部401从对由相机31a取得的检测数据进行图像处理得到的图像提取移动物体的轮廓。区域划分部403以由物体识别部401提取出的移动物体的轮廓成为第1区域和第2区域的边界的方式划分第1区域和第2区域。由此,能够精确地从图像的特征点中除去与移动物体相对应的特征点,能够进一步提高车辆的当前位置的推定精度。

63.(3)当由移动物体识别部402识别出多个移动物体时,区域划分部403在根据由相机31a取得的检测数据确定的检测区域中,将不包含在与多个移动物体各自相对应的第1区域的任何一个的区域划分为第2区域。由此在例如由相机31a取得的拍摄图像中包括多个移动物体时,也能够精确地从拍摄图像的特征点中去除与各移动物体相对应的特征点,能够精确地推定车辆的当前位置。

64.需要说明的是,在上述实施方式中,移动物体识别部402使用由相机31a取得的当前的图像(帧图像)和过去的图像(帧图像)来识别移动物体,但识别部的构成不限于以上所述。识别部还可以使用用于识别图像内的移动物体的学习模型从由相机31a取得的当前的图像识别移动物体。上述学习模型通过将例如拍摄在道路行驶中的车辆的周围而得到的图像数据作为训练数据进行机器学习而生成,预先存储于存储部42。需要说明的是,识别部还可以对移动物体的识别结果进行评价,并基于该评价结果更新存储于存储部42的学习模型。还有,识别部还可以利用机器学习以外的与人工智能(ai:artificial intelligence)相关的技术识别移动物体。

65.还有,在上述实施方式中,物体识别部401从由相机31a取得的拍摄图像提取边缘,基于所提取出的边缘的信息提取拍摄图像中所包含的物体的轮廓,但轮廓提取部的构成不限于以上所述。例如轮廓提取部还可以利用通过机器学习构建的学习模型,从相机31a的拍

摄图像中提取物体的轮廓。还有,物体识别部401还可以利用与机器学习以外的人工智能相关的技术提取物体的轮廓。

66.还有,上述实施方式中,区域划分部403以由物体识别部401提取出的移动物体的轮廓成为第1区域和第2区域的边界的方式划分第1区域和第2区域,但区域划分部的构成不限于以上所述。区域划分部还可以将包括移动物体在内的矩形区域的内侧划分为第1区域,将包括移动物体在内的矩形区域的外侧划分为第2区域。图6是示出被划分为第1区域和第2区域的拍摄图像im的其他例的图。图中的用粗线描绘的框rg1、rg2、rg3表示与作为移动物体的车辆v1、v2、v3相对应的矩形区域。在图6所示的例子中,通过区域划分部403将框rg1、rg2、rg3的内侧的区域划分为第1区域,将拍摄图像im的区域中的除第1区域以外的区域划分为第2区域。由此,与将移动物体的轮廓作为边界划分第1区域和第2区域的情况相比较,能够以较小的处理负荷划分第1区域和第2区域。因此,在相机31a的拍摄图像中包括多个移动物体的情况下也能够容易地划分第1区域和第2区域。需要说明的是,在图6中用矩形的框rg1、rg2、rg3划分第1区域,但还可以用矩形以外的形状的框来划分第1区域。

67.还有,上述实施方式中,移动物体识别部402在由物体识别部401识别出的各物体中,将帧间(当前帧与相对于当前帧在过去的时间点取得的帧之间)的移动量和移动方向与从车辆100的过去的时间点到当前为止的移动量和移动方向不对应的物体识别了移动物体。但是,移动物体识别部402还可以利用使用了机器学习等的图像分割技术,以像素为单位从由相机31a取得的拍摄图像提取与移动物体相对应的区域(像素)。并且,区域划分部403还可以将由移动物体识别部402识别出的与移动物体相对应的像素(像素组)划分为第1区域,将其以外的像素(像素组)划分为第2区域。

68.还有,上述实施方式中,移动物体识别部402使用当前帧(n帧)的图像和相对于当前帧在前一帧(n-1帧)的图像识别了移动物体。但是,移动物体识别部402只要使用相对于当前帧在过去的时间点取得的帧的图像来识别移动物体,就可以使用相对于当前帧在规定帧数前的帧的图像来检测移动物体。即,可以对从相机31a输入的动态图像,每隔规定数m(》1)的帧执行图5所示的处理。在该情况下,基于所要求的环境地图的精度、位置推定的精度等来决定执行图5所示的处理的帧间隔。采用该构成,在不需要使控制器40的处理负荷不必要地增大的情况下,能够以所希望的精度实施环境地图的生成、自车位置的推定。

69.还有,移动物体识别部402还可以基于当前的帧图像和与当前的帧图像连续取得的规定时间内的过去的帧图像,识别当前的帧图像中所包含的移动物体。由此,因为在相机31a的拍摄图像中,在拍摄图像中仅映照不足规定时间的被摄体、即暂时映照的被摄体(鸟等)不被识别为移动物体,所以能够更适当地从拍摄图像的特征点中提取用于推定车辆的当前位置的特征点。

70.还有,上述实施方式中,相机31a检测车辆100的周围,但检测器的构成不限于以上所述。检测器还可以是雷达31b、激光雷达31c等除相机31a以外的检测器。另外,在上述实施方式中,将车辆位置推定装置50应用在了自动驾驶车辆的车辆控制系统,但车辆位置推定装置50也能够应用于自动驾驶车辆以外的车辆。在例如具备adas(advanced driver-assistance systems)的手动驾驶车辆也能够应用车辆位置推定装置50。

71.以上说明归根结底为一例,只要不破坏本发明的特征,上述实施方式和变形例就不限定本发明。既能够将上述实施方式与变形例的一个或多个任意组合,也能够将变形例

彼此进行组合。

72.采用本发明,能够精确地推定地图信息中的车辆的当前位置。

73.上文结合优选实施方式对本发明进行了说明,本领域技术人员应理解为能够在不脱离后述权利要求书的公开范围的情况下进行各种修改和变更。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。