1.本发明属于地图构建技术领域,具体涉及一种动态机器人在动态场景中的定位和地图构建方法。

背景技术:

2.基于自主导航技术,机器人在国防、航空、工业以及生活领域中都发挥了重要作用,而自主导航的前提是得知当前机器人位置以及周围环境,slam(simultaneous localization and mapping),也称为cml(concurrent mapping and localization),即时定位与地图构建,或并发建图与定位,正是实现这个过程的关键技术。

3.而现有技术中关于即时定位与地图构建,大多数是在静态环境中执行,当环境中存在移动物体时,或者是动态场景下,会导致定位的不准确,另外,在相机被遮挡过多或机器人运动过快的情况下,会导致现有技术无法跟踪到足够的特征点,最终导致整个即时定位与地图构建失效,现有技术中也存在将slam技术与其他传感器数据融合的方法来提升其鲁棒性,但这些方法存在融合复杂,计算量大,处理速度慢的问题。

4.因此,如何提高动态机器人在动态场景中的定位和地图构建的准确性,同时减少其计算量,提高处理速度,是本领域技术人员有待解决的技术问题。

技术实现要素:

5.本发明的目的是为了提高动态机器人在动态场景中的定位和地图构建的准确性,提出了一种动态机器人在动态场景中的定位和地图构建方法。

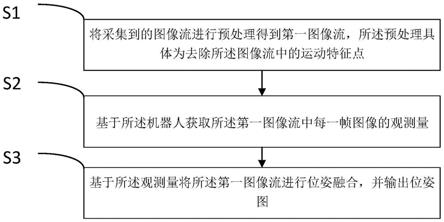

6.本发明的技术方案为:一种动态机器人在动态场景中的定位和地图构建方法,所述方法包括以下步骤:

7.s1、将采集到的图像流进行预处理得到第一图像流,所述预处理具体为去除所述图像流中的运动特征点;

8.s2、基于所述机器人获取所述第一图像流中每一帧图像的观测量;

9.s3、基于所述观测量将所述第一图像流进行位姿融合,并输出位姿图。

10.进一步地,所述步骤s1具体包括以下分步骤:

11.s11、提取出所述图像流中每一帧图像的特征点,同时还基于先验动态物体确定出所述图像流中先验特征点;

12.s12、将所述图像流中每一帧图像的特征点中对应的先验特征点删除。

13.进一步地,所述步骤s11中的提取出所述图像流中每一帧图像的特征点具体包括以下分步骤:

14.s111、确定出所述图像流中每一帧图像的采样尺度金字塔;

15.s112、通过多个流操作队列确定出所述采样尺度金字塔中每一层图像中的所有fast角点;

16.s113、确定出每一个fast角点的描述子;

17.s114、将每一个fast角点和对应的描述子进行组合并作为所述特征点。

18.进一步地,所述观测量具体为所述动态机器人的角速度、角度、所述机器人的左轮速度、所述机器人的右轮速度、所述动态机器人在其所在平面上的横轴上的平移值和所述动态机器人在其所在平面上的纵轴上的平移值。

19.进一步地,所述步骤s3具体包括以下分步骤:

20.s31、将每一帧图像的观测量输入到预设滤波器中;

21.s32、基于所述预设滤波器和所述观测量确定出每一帧图像对应的位姿图,并将所述位姿图进行输出。

22.进一步地,所述步骤s32还包括检测当前位姿图是否有回环边,若是,则根据所述回环边对上一帧图像对应的位姿图进行回环纠正,若否,则继续确定下一帧图像对应的位姿图。

23.进一步地,所述步骤s32中基于所述预设滤波器和所述观测量确定出每一帧图像对应的位姿图还包括通过所述预设滤波器为所述观测量分配权重。

24.与现有技术相比,本发明具备如下有益效果:

25.本发明提供一种动态机器人在动态场景中的定位和地图构建方法,包括:先将采集到的图像流进行预处理得到第一图像流,所述预处理具体为去除所述图像流中的运动特征点;然后基于所述机器人获取所述第一图像流中每一帧图像的观测量;最后基于所述观测量将所述第一图像流进行位姿融合,并输出位姿图,其中预处理具体为,先提取出所述图像流中每一帧图像的特征点,同时还基于先验动态物体确定出所述图像流中先验特征点;然后将所述图像流中每一帧图像的特征点中对应的先验特征点删除,提高动态机器人在动态场景中的定位和地图构建的准确性,同时减少其计算量,提高其处理速度。

附图说明

26.图1所示为本发明实施例提供的一种fpga异态逻辑修复方法的流程示意图。

具体实施方式

27.下面将结合本技术实施例中的附图,对本技术实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本技术一部分实施例,而不是全部的实施例。基于本技术中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其他实施例,都属于本技术保护的范围。

28.本技术提出了一种动态机器人在动态场景中的定位和地图构建方法,用于提高动态机器人在动态场景中的定位和地图构建的准确性。

29.如图1所述为本技术实施例提出的一种动态机器人在动态场景中的定位和地图构建方法的流程示意图,该方法包括以下步骤:

30.步骤s1、将采集到的图像流进行预处理得到第一图像流,所述预处理具体为去除所述图像流中的运动特征点。

31.具体的,本技术的方案是在基于特征点的实时单目slam系统中进行,该系统在大规模、小规模以及室内外的环境均可进行,且该系统在剧烈运动的情况下鲁棒性较高,支持宽基线的闭环检测和重定位,还包括全自动初始化,

32.在本技术实施例中,所述步骤s1具体包括以下分步骤:

33.s11、提取出所述图像流中每一帧图像的特征点,同时还基于先验动态物体确定出所述图像流中先验特征点;

34.s12、将所述图像流中每一帧图像的特征点中对应的先验特征点删除。

35.具体的,图像流是一种特殊类型的流,应用程序可以显示图像流中所需的图片,但典型的实现是显示每张图片,直到下一张图片交付,如幻灯片放映。

36.基于现实场景中的大多数动态物体是人、车、动物等这个特性,可先检测出图像流中这些先验物体,然后将位于图像流中对应的特征点进行删除,本步骤中,图像流会同时经过两条路径,一路检测出先验动态物体并给出该物体在图像中的坐标信息,另一路提取出所述图像流中每一帧图像的特征点,然后将所述图像流中每一帧图像的特征点中对应的先验特征点删除,这里能过滤掉绝大多数动态物体的影响。

37.而对于小部分不是先验动态物体对应的动态特征点,可利用动态特征点不满足极线几何约束的特点,将离极线e距离过远的点进行筛除。

38.在本技术实施例中,所述步骤s11中的提取出所述图像流中每一帧图像的特征点具体包括以下分步骤:

39.s111、确定出所述图像流中每一帧图像的采样尺度金字塔;

40.s112、通过多个流操作队列确定出所述采样尺度金字塔中每一层图像中的所有fast角点;

41.s113、确定出每一个fast角点的描述子;

42.s114、将每一个fast角点和对应的描述子进行组合并作为所述特征点。

43.具体的,多个流操作队列具体为两个流操作队列,流操作队列也即gpu操作队列,并且该队列中的操作将以指定的顺序执行,一个流操作队列用于计算fast角点的位置,另一个流操作队列用于计算对应fast角点的方向,这是为了保证fast角点的旋转不变性,fast角点为:若某像素与其周围邻域内大于预设数量的像素点的灰度值相差较大时,则该像素点即为fast角点,而使用流技术能够确保在gpu进行计算时能够将数据传回cpu,节省后续拷贝的时间耗时。

44.另外,采样尺度金字塔具体为8层,其是为了将图像中大的运动物体和小的运动物体均识别出,而描述子则是fast角点附近随机选取若干点对,将这些点对的灰度值的大小,组合成一个二进制串,并将这个二进制串作为该fast角点的特征描述子。

45.步骤s2、基于所述机器人获取所述第一图像流中每一帧图像的观测量。

46.在本技术实施例中,所述观测量具体为所述动态机器人的角速度、角度、所述机器人的左轮速度、所述机器人的右轮速度、所述动态机器人在其所在平面上的横轴上的平移值和所述动态机器人在其所在平面上的纵轴上的平移值。

47.具体的,为了解决曝光过度、场景光线极暗等相机失效导致建图的不确定性,我们引入了多传感器融合方法。我们选用了卡尔曼滤波的松耦合方式实现实时输入参数种类和数量成规律的周期变化,可大大增强耦合效率与频率,所述动态机器人的角速度、角度可通过陀螺仪进行确定,所述机器人的左轮速度、所述机器人的右轮速度可通过轮式里程计进行确定,确定出上述四个量之后便可通过姿态估计之后确定出所述动态机器人在其所在平面上的横轴上的平移值和所述动态机器人在其所在平面上的纵轴上的平移值,最终得到所

述观测量

48.步骤s3、基于所述观测量将所述第一图像流进行位姿融合,并输出位姿图。

49.在本技术实施例中,所述步骤s3具体包括以下分步骤:

50.s31、将每一帧图像的观测量输入到预设滤波器中;

51.s32、基于所述预设滤波器和所述观测量确定出每一帧图像对应的位姿图,并将所述位姿图进行输出。

52.具体的,本技术中的预设滤波器为卡尔曼滤波器,本领域技术人员还可根据实际情况灵活设置其他滤波器,预设滤波器收到观测值后,会定时地对滤波器进行更新,一路对运动模型中给的状态向量进行纠正,一路输出融合后的位姿,运动模型和状态向量都是卡尔曼滤波器中具体的矩阵,状态向量记录了机器人对世界坐标系的角度,线速度和角速度随时间变化的物理量,运动模型是针对本专利的情况而把整个运动设定为常速度模型,这样能够使角速度和线速度在预测阶段保持不变,在修正阶段用卡尔曼滤波调整从而更新系统状态量。

53.在本技术实施例中,所述步骤s32还包括检测当前位姿图是否有回环边,若是,则根据所述回环边对上一帧图像对应的位姿图进行回环纠正,若否,则继续确定下一帧图像对应的位姿图。

54.具体的,位姿图的构建由两部分组成,一个是预设滤波器出来的增量边,另一个是回环检测模块检测出来的回环边,一旦检测到回环边,则对上一帧图像对应的位姿图进行回环纠正,经过回环纠正之后,能够使得轨迹漂移误差明显下降,回环边就是位姿图构建时机器人转了一圈回到原点时的差量边。

55.在本技术实施例中,所述步骤s32中基于所述预设滤波器和所述观测量确定出每一帧图像对应的位姿图还包括通过所述预设滤波器为所述观测量分配权重。

56.具体的,位移则分短距离和长距离,机器人在经过较长距离,轮式里程计不可信任,里程计的权重会设置较小,也即所述机器人的左轮速度、所述机器人的右轮速度的权重会较小。机器人在短距离运动时,由于仍具有较高精度,选择平均权重策略,本领域技术人员可根据实际情况进行权重分配。

57.本领域的普通技术人员将会意识到,这里所述的实施例是为了帮助读者理解本发明的原理,应被理解为本发明的保护范围并不局限于这样的特别陈述和实施例。本领域的普通技术人员可以根据本发明公开的这些技术启示做出各种不脱离本发明实质的其它各种具体变形和组合,这些变形和组合仍然在本发明的保护范围内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。