1.本发明属于计算机视觉以及语音识别技术领域,具体涉及一种基于跨模态自监督学习的主动说话人识别方法。

背景技术:

2.主动说话人识别是视频分析算法中的一个重要组成部分,该任务通过分析微小的面部运动和相应的语音波形,在一组可能的候选人中识别出主动说话者。主动说话人识别是大量后续任务的必要基础,比如说话人分类、会议视频重定位、语音增强和人机交互等应用,主要依据视频帧中的人物面部特征和当前音频中人物声音特征的相似程度来区分识别。若人物面部特征和人物声音特征的相似度超过特定阈值,则当前声音由该人物发出,并称其为主动说话人,反之则为非主动说话人。

3.近年来,随着深度学习的不断发展,尤其是卷积神经网络在目标识别上的优异表现,使得越来越多的目标识别任务能够实现高效自动化。一些研究已将卷积神经网络应用于主动说话人识别的任务中。

4.然而,目前的主动说话人识别模型对数据标注的依赖性较强,仅仅利用人工标注的正负图像样本进行训练。在现实情况中,由于网络社交平台的兴起,网络上大量的视频内容可以作为实验数据,但人力资源有限无法标注,一般的主动说话人识别模型无法利用这些天然可用的数据样本。与此同时,由于拍摄仪器、光照、技术等原因,可能出现人工难以辨别主动说话人的视频图像,如人物面部过小、人脸模糊或人脸密集等较难辨认的图像,一般的主动说话人识别模型很难在这些样本上具有强泛化与高精度的识别表现。

技术实现要素:

5.本发明是为解决上述问题而进行的,目的在于提供一种无需人工标注且能够对识别难度相对较大的图像完成精确识别的主动说话人识别方法,本发明采用了如下技术方案:

6.本发明提供了一种基于跨模态自监督学习的主动说话人识别方法,其特征在于,包括以下步骤:

7.步骤s1,利用训练数据对主动说话人识别模型进行跨模态自监督学习,获得合适的模型参数;

8.步骤s2,将待测视频输入训练完成的所述主动说话人识别模型,得到所述待测视频的主动说话人识别结果,

9.其中,步骤s2中,主动说话人识别模型通过如下步骤进行识别:

10.步骤s2-1,提取所述待测视频的视觉特征和听觉特征,并基于所述视觉特征和所述听觉特征计算所述待测视频中每帧图像的注意力图;

11.步骤s2-2,采用光流法融合所述注意力图,提取每帧所述注意力图的密度光流值,并将所述密度光流值进行链接,得到光流轨迹,并对所述光流轨迹上的注意力得分进行平

均;

12.步骤s2-3,寻找所述注意力图中的峰值点,并采用非极大值抑制法去除干扰项;

13.步骤s2-4,将找到的所述峰值点沿所述光流轨迹反向投影到每帧所述图像,从而定位各帧所述图像中的人脸位置;

14.步骤s2-5,计算所述人脸位置的所述视觉特征和所述听觉特征的余弦相似度,当该余弦相似度大于预定的阈值时,判定所述人脸位置对应于主动说话人。

15.本发明提供的基于跨模态自监督学习的主动说话人识别方法,还可以具有这样的技术特征,其中,步骤s1中,利用视频的同步性特征构建所述训练数据。

16.本发明提供的基于跨模态自监督学习的主动说话人识别方法,还可以具有这样的技术特征,其中,将所述视频中连续的n帧图像和对应的音频信号组成正样本对,将所述视频中连续的n帧图像和偏移t秒后的音频信号组成负样本对。

17.本发明提供的基于跨模态自监督学习的主动说话人识别方法,还可以具有这样的技术特征,其中,所述主动说话人识别模型包括依次设置的输入层、特征提取模块、光流法整合注意力层、寻找峰值点层、非极大值抑制层、峰值点反向投影层、相似度计算层以及归一化层,所述特征提取模块包括视觉子模块以及听觉子模块,分别用于提取所述待测视频的所述视觉特征和所述听觉特征。

18.本发明提供的基于跨模态自监督学习的主动说话人识别方法,还可以具有这样的技术特征,其中,步骤s2-1包括以下子步骤:

19.步骤s2-1-1,将所述连续的n帧图像依次输入所述视觉子模块,获取每帧图像的所述视觉特征;

20.步骤s2-1-2,将对应的所述音频信号依次输入所述听觉子模块,获取对应的所述听觉特征;

21.步骤s2-1-3,计算所述视觉特征和对应的所述听觉特征的余弦相似度,得到每帧图像的所述注意力图。

22.本发明提供的基于跨模态自监督学习的主动说话人识别方法,还可以具有这样的技术特征,其中,步骤s2-3中,所述主动说话人识别模型检测空间局部极大值在时间聚合上的同步映射,并以降序排列,从而选择出所述峰值点,同时每次都抑制在ρ

×

ρ大小的区域内的所述峰值点。

23.本发明提供的基于跨模态自监督学习的主动说话人识别方法,还可以具有这样的技术特征,其中,步骤s2-4中,在沿所述光流轨迹反向投影的过程中,同时检测ρ

×

ρ大小的区域内是否有所述峰值点,如果存在所述峰值点,则以该峰值点作为反向投影的轨迹。

24.本发明提供的基于跨模态自监督学习的主动说话人识别方法,还可以具有这样的技术特征,其中,所述主动说话人识别模型为以vgg-m模型为骨干的神经网络模型。

25.发明作用与效果

26.根据本发明的基于跨模态自监督学习的主动说话人识别方法,因为通过利用视频的同步性特征来自动划分正负样本对用于训练,所以使得模型能够在无需人工标注的情况下利用数据集训练至合适的参数,进一步,采用光流法追踪像素点在时间维度上的运动轨迹,通过计算轨迹上的注意力值的平均值可以得到整合后的注意力图,在整合后的注意力图上寻找注意力峰值的同时对其周围的区域进行非极大值抑制,因此能够方便且准确地获

取到单帧注意力图上的人脸位置,通过沿着光流的轨迹反向投影,即可准确获得原图中每一帧图片的人脸位置,通过利用人脸所在位置的图像特征可以计算其与音频信号的余弦相似度,使用预定的特定阈值过滤,从而获得了能够对主动说话人图像以及非主动说话人图像同时进行高精度识别的主动说话人识别模型。根据本发明提供的基于跨模态自监督学习的主动说话人识别方法,能够无需人工标注即可通过主动说话人识别模型高效地训练和检测视频中的主动说话者,具有强泛化和高精度的优势。

附图说明

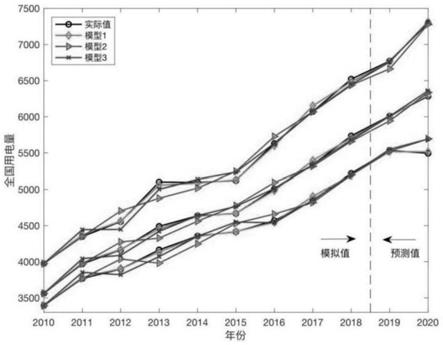

27.图1是本发明实施例中基于跨模态自监督学习的主动说话人识别方法的流程图;

28.图2是本发明实施例中主动说话人识别模型的特征提取模块的结构示意图;

29.图3是本发明实施例中主动说话人识别模型进行识别的流程图;

30.图4是本发明实施例中主动说话人识别结果的示意图。

具体实施方式

31.为了使本发明实现的技术手段、创作特征、达成目的与功效易于明白了解,以下结合实施例及附图对本发明的基于跨模态自监督学习的主动说话人识别方法作具体阐述。

32.《实施例》

33.本实施例中,基于跨模态自监督学习的主动说话人识别方法通过一台计算机运行,该计算机需要一张显卡进行gpu加速从而完成模型的训练过程,训练完成的主动说话人识别方法的模型以及视频识别过程以可执行代码的形式存储在计算机中。

34.本实施例中,采用的训练数据集从youtube平台下载视频得到,包括训练集和验证集。其中,训练集包含231部好莱坞影片,从每段视频中提取超过15分钟的片段,用于模型训练;验证集包含66部好莱坞影片,从每段视频中提取超过15分钟的片段,用于模型效果的检验。

35.图1是本实施例中基于跨模态自监督学习的主动说话人识别方法的流程图。

36.如图1所示,基于跨模态自监督学习的主动说话人识别方法具体包括以下步骤:

37.步骤s1,利用待训练数据对主动说话人识别模型进行跨模态自监督学习,获得合适的模型参数,也即得到训练完成的主动说话人识别模型。

38.本实施例中,主动说话人识别模型包括依次设置的输入层、特征提取模块、光流法整合注意力层、寻找峰值点层、非极大值抑制层、峰值点反向投影层、相似度计算层以及归一化层。其中,各层包含有不同的模型参数,这些模型参数在构建时为随机设置。

39.图2是本实施例中主动说话人识别模型特征提取模块的结构示意图。

40.如图2所示,特征提取模块包括视频子模块和音频子模块,其中,视频子模块包括依次设置的输入层i1、卷积层c1-0、卷积层c1-1、最大池化层m1-0、卷积层c1-2、卷积层c1-3、卷积层c1-4、卷积层c1-5、最大池化层m1-1、全连接层f1-0、全连接层f1-1,音频子模块包括依次设置的输入层i2、卷积层c2-0、最大池化层m2-0、卷积层c2-1、最大池化层m2-1、卷积层c2-2、卷积层c2-3、卷积层c2-4、最大池化层m2-2、卷积层c2-5、全连接层f2-0、全连接层f2-1。特征提取模块的具体结构和设置如下:

41.(1)输入层i1,用于输入视频画面,经过尺寸调整、帧率调整、视频帧分组等视频预

处理操作,得到尺寸为t

×h×w×

3的视频帧;

42.(2)卷积层c1-0,卷积核大小为5

×7×

7,滑动步长为(1,2,2),输出为(t-4)

×

(h/2)

×

(w/2)

×

64;

43.(3)卷积层c1-1,卷积核大小为5

×

5,滑动步长为(2,2),输出为(t-4)

×

(h/4)

×

(w/4)

×

128;

44.(4)最大池化层m1-0,池化大小为3

×

3,滑动步长为(2,2),输出为(t-4)

×

(h/8)

×

(w/8)

×

128;

45.(5)卷积层c1-2,卷积核大小为3

×

3,滑动步长为(1,1),输出为(t-4)

×

(h/8)

×

(w/8)

×

256;

46.(6)卷积层c1-3,卷积核大小为3

×

3,滑动步长为(1,1),输出为(t-4)

×

(h/8)

×

(w/8)

×

256;

47.(7)卷积层c1-4,卷积核大小为3

×

3,滑动步长为(1,1),输出为(t-4)

×

(h/8)

×

(w/8)

×

256;

48.(8)卷积层c1-5,卷积核大小为5

×

5,滑动步长为(1,1),输出为(t-4)

×

(h/8)

×

(w/8)

×

512;

49.(9)最大池化层m1-1,池化大小为3

×

3,滑动步长为(2,2),输出为(t-4)

×

(h/16)

×

(w/16)

×

512;

50.(10)全连接层f1-0,进行矩阵变换,输出为(t-4)

×

(h/16)

×

(w/16)

×

512;

51.(11)全连接层f1-1,进行矩阵变换,输出为(t-4)

×

(h/16)

×

(w/16)

×

1024;

52.(12)输入层i2,用于输入音频序列,经过短时傅里叶变换等音频预处理操作,得到尺寸为4t

×

80

×

1的梅尔频谱图;

53.(13)卷积层c2-0,卷积核大小为3

×

3,滑动步长为(1,2),输出为4t

×

40

×

64;

54.(14)最大池化层m2-0,卷积核大小为3

×

1,滑动步长为(1,2),输出为4t

×

19

×

64;

55.(15)卷积层c2-1,池化大小为3

×

3,滑动步长为(1,1),输出为4t

×

19

×

192;

56.(16)最大池化层m2-1,卷积核大小为3

×

3,滑动步长为(2,2),输出为2t

×9×

192;

57.(17)卷积层c2-2,卷积核大小为3

×

3,滑动步长为(1,1),输出为2t

×9×

256;

58.(18)卷积层c2-3,卷积核大小为3

×

3,滑动步长为(1,1),输出为2t

×9×

256;

59.(19)卷积层c2-4,池化大小为3

×

3,滑动步长为(1,1),输出为2t

×9×

256;

60.(20)最大池化层m2-2,池化大小为3

×

3,滑动步长为(2,2),输出为t

×4×

256;

61.(21)卷积层c2-5,池化大小为4

×

4,滑动步长为(1,1),输出为(t-4)

×1×

512;

62.(22)全连接层f2-0,进行矩阵变换,输出为(t-4)

×1×

512;

63.(23)全连接层f2-1,进行矩阵变换,输出为(t-4)

×1×

1024;

64.上述主动说话人识别模型特征提取模块中,每一个卷积层之后都做批量归一化操作。

65.本实施例中,利用视频的同步性特征来自动构建大量训练数据,具体地,将视频中连续的n帧图像和其相对应的音频信号共同形成正样本对,将视频中连续的n帧图像和其偏移t秒后的音频信号共同形成负样本对,因此,利用视频本身的同步性特征即可自动生成正负样本对,无需人工标注。随后,利用这些正负样本对来训练模型参数,从而得到训练完成的模型,由于采用正负样本进行训练,因此训练完成的模型能够同时对主动说话人以及非

主动说话人进行识别。

66.步骤s2,将待测视频输入训练完成的主动说话人识别模型,得到待测视频的主动说话人识别结果。

67.本实施例中,主动说话人识别模型为预先通过模型训练步骤训练获得并存储在计算机中,计算机可以通过可执行代码调用该模型并同时批量处理多段视频,得到并输出每段视频的主动说话人识别结果。

68.本实施例中,主动说话人识别模型的输出维数为二维,分别表示视频中的待预测人物被识别为主动说话人和非主动说话人的概率得分,若主动说话人得分大于非主动说话人得分则判断该待预测人物的主动说话人识别结果为说话,反之,则该主动说话人识别结果为不说话。

69.图3是本实施例中主动说话人识别模型进行识别的流程图。

70.如图3所示,步骤s2中,训练完成的主动说话人识别模型在预测阶段的识别、检测过程具体包括以下子步骤:

71.步骤s2-1,分别计算待测视频中每一帧图片的注意力图。

72.步骤s2-1具体包括以下子步骤:

73.步骤s2-1-1,将连续的n帧图像依次输入视觉子模块,从而获取每帧图像的视觉特征图,该视觉特征图包含有多个视觉特征向量。

74.步骤s2-1-2,将对应的音频信号依次输入听觉子模块,从而获取对应的听觉特征图,该听觉特征图包含有多个听觉特征向量。

75.步骤s2-1-3,对每帧图像,计算对应的视觉特征向量和听觉特征向量的余弦相似度,从而得到每帧图像的注意力图。

76.本实施例中,计算注意力图的模型以卷积神经网络vgg-m模型为骨干,利用现有的深度学习框架pytorch完成模型的搭建。同时,该模型采用三维卷积来处理视频图像,对于一维的声音信号,先求其对应的梅尔频谱图,然后在梅尔频谱图上使用二维卷积提取特征。

77.将训练集中的各个训练图像依次输入构建好的主动说话人识别特征提取模型并进行一次迭代。迭代后,采用最后一层的模型参数分别计算出损失误差,然后将计算得到的损失误差反向传播,从而更新模型参数。重复迭代至达到训练完成条件,得到训练完成的主动说话人识别特征提取模型,通过该模型,可以计算视频中每帧图像的注意力图。

78.步骤s2-2,采用光流法整合注意力图,提取每一帧注意力图的密度光流值,并将密度光流值进行链接,得到光流轨迹,对光流轨迹上的注意力得分进行平均,从而使得注意力图中各像素点的注意力得分更加平滑。

79.本实施例中,为了使模型对人物运动的变化更加稳健,采用光流法沿时间整合注意力图,任何跟踪方法都可以用来代替光流法,在本实施例中,为便于进行说明,直接采用光流法。

80.步骤s2-3,寻找注意力图中的峰值点,并采用非极大值抑制法来去除干扰项。

81.本实施例中,为了获得离散的视听对象,该模型检测空间局部极大值在时间聚合上的同步映射,并以降序排列,通过简单地选择峰值点,同时每次都抑制在ρ

×

ρ大小的正方形框中的峰值点,所选的峰值点可以看作是明显的视听对象。

82.步骤s2-4,将寻找到的峰值点根据光流轨迹反向投影到各帧图像,定位各帧图像

中的人脸位置。

83.本实施例中,声源已经被分组成不同的视听对象,因此可以为每一个对象提取特征向量,以便在最后的主动说话人检测中使用。在提取这些特征之前,首先先确定声源在每一帧中的位置。一个简单的策略是在整个视频中遵循物体的光流轨迹,然而这些轨迹是不精确的,可能不完全对应于声源的位置。因此,在沿着光流轨迹反向投影的过程中,同时检测ρ

×

ρ大小的区域内是否有峰值点,如果存在峰值点,则以该峰值点作为反向投影的轨迹。

84.步骤s2-5,计算人脸特征(即人脸位置区域的图像的视觉特征)和听觉特征的余弦相似度,当该余弦相似度大于预定的阈值时,则判定该人脸位置对应于主动说话人,否则则判定为非主动说话人。

85.在步骤s2-4中,主动说话人识别模型已经追踪到每一帧中的声源位置,然后从视觉特征图中选择相应声源位置处的听觉特征向量,计算该视觉特征向量和相应的听觉特征向量的余弦相似度,通过一个简单的阈值判断,即可定位主动说话人。

86.图4是本实施例中主动说话人识别结果的示意图,其中,左边的方框所标记的是主动说话人,右边的方框所标记的是非主动说话人,两个方框采用不同的颜色进行标示。

87.将最终得到的主动说话人识别模型在验证集上进行验证,实验结果显示,对于66好莱坞影片中的1500000张视频帧,主动说话人识别模型的识别准确率达到95%,即模型几乎能够完全正确地识别视频中的主动说话人。最终的主动说话人识别模型能够以较高的准确度识别视频中的主动说话人与非主动说话人。

88.本实施例中,主动说话人识别模型学习到的是微小的面部运动和相应的语音波形间的关系,根据这一特征来进行主动说话人的识别,因此能够达到很高的识别精度。

89.实施例作用与效果

90.根据本实施例提供的基于跨模态自监督学习的主动说话人识别方法,基于跨模态自监督学习的主动说话人识别方法,因为通过利用视频的同步性特征来自动划分正负样本对用于训练,所以使得模型能够在无需人工标注的情况下利用数据集训练至合适的参数,进一步,采用光流法追踪像素点在时间维度上的运动轨迹,通过计算轨迹上的注意力值的平均值可以得到整合后的注意力图,在整合后的注意力图上寻找注意力峰值的同时对其周围以ρ为边长的正方形区域进行非极大值抑制,因此能够方便且准确地获取到单帧注意力图上的人脸位置,通过沿着光流的轨迹反向投影,即可准确获得原图中每一帧图片的人脸位置,通过利用人脸所在位置的图像特征可以计算其与音频信号的的余弦相似度,使用特定阈值过滤,从而获得了能够对主动说话人图像以及非主动说话人图像同时进行高精度识别的主动说话人识别模型。根据本发明实施例的基于跨模态自监督学习的主动说话人识别方法,能够无需人工标注即可通过主动说话人识别模型高效地训练和检测视频中的主动说话者,具有强泛化和高精度的优势。

91.另外,实施例中,由于主动说话人识别模型基于深度卷积神经网络vgg-m模型,因此能够表达图像的高层特征,有利于图像识别任务。同时,还由于主动说话人识别模型仅基于深度卷积神经网络vgg-m模型,因此模型结构简单,不需要使用模型混合、多任务训练以及度量学习等方法就能够完成主动说话人以及非主动说话人识别,所以,本实施例的模型构建快速方便,训练集也不需要过多人工标注就能够实现训练,因此训练过程可以快速完成,且训练消耗的人力资源也较少。

92.上述实施例仅用于举例说明本发明的具体实施方式,而本发明不限于上述实施例的描述范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。