基于特征匹配和位置匹配的sar图像与光学图像匹配方法

技术领域

1.本发明属于图像处理技术领域,特别是涉及一种基于特征匹配和位置匹配的sar图像与光学图像匹配方法。

背景技术:

2.在对地观测中,可以对光学和合成孔径雷达(sar)图像进行比较和分析,通过互补获得更有价值的信息。在图像配准、图像融合和变化检测等领域,sar图像与光学图像的特征匹配非常重要。但由于光学图像和合成孔径雷达图像的成像机理差异很大,很难匹配光学图像和sar图像的特征。而且散斑噪声在sar图像中广泛存在,会影响图像特征的性能,使其难以识别。此外沿着测距轴的距离依赖性和雷达信号波长的特性导致了合成孔径雷达图像的几何失真。

3.图像匹配方法可分为三类:基于区域的描述符匹配方法、手工特征描述符匹配方法和基于学习的特征描述符匹配方法。

4.基于区域的方法可以通过适当的面片相似性度量在像素级直接匹配图像。然而,视觉变化、光照变化和图像失真会误导相似性度量和匹配搜索。因此,这些方法通常只适用于以下情况:缩放、局部变形和小范围旋转。

5.专家和学者通常利用现有的知识推导并设计手工制作的特征描述符。对于非线性亮度变化,由于特征点周围梯度统计的多样性,sift特征点在主方向的计算中不可靠,这将产生较多的错误匹配点,导致错误配准或配准失败。近几十年来,出现了许多手工制作的特征描述符匹配方法,但由于非线性辐射差异,很难从光学和sar图像中提取足够数量的高质量特征。

6.与手工编制的描述符相比,基于学习的特征描述符可以发现隐藏在数据中的更有价值的信息,并具有更好的性能和特征描述能力。在许多类型的图像中,基于深度学习的特征描述符比传统的描述符在特征匹配中取得了更好的效果。然而,基于学习的特征描述符也面临许多困难。例如,深度学习方法通常需要从图像中提取大量特征,这些特征通常包含噪声和异常值。

技术实现要素:

7.本发明实施例的目的在于提供一种基于特征匹配和位置匹配的sar图像与光学图像匹配方法,以更好地解决sar图像和光学图像的特征匹配问题,具有更佳的匹配能力和匹配精准度,并且能够进一步实现sar图像和光学图像的位置匹配。

8.为解决上述技术问题,本发明所采用的技术方案是,一种基于特征匹配和位置匹配的sar图像与光学图像匹配方法,包括以下步骤:

9.s1:使用高斯差分算法对光学图像和sar图像进行初步关键点检测;

10.s2:根据检测到的光学图像和sar图像的关键点,提取周围的区域,重构为64

×

64像素的图像块;

11.s3:设计包含密集块和过渡层的深度卷积神经网络,并设计复合损失函数,通过对深度卷积神经网络的训练和运行,生成深度特征描述符;

12.s4:使用l2距离算法和深度特征描述符对光学图像和sar图像进行特征匹配,并对匹配点距离误差进行评估;

13.s5:通过二维高斯函数投票算法实现sar图像和光学图像的位置匹配。

14.进一步地,所述s1中高斯差分算法的函数为:

[0015][0016]

其中,和分别表示两幅图像的高斯滤波;x、y分别是预测点的水平坐标和垂直坐标,σ1、σ2是预测点的方差,e是自然常数。

[0017]

进一步地,所述s1中,初步关键点检测的方法为:

[0018]

在初步关键点检测中,需要检测图像中所有像素点的灰度值,如果像素的dog值是所有相邻像素点的最大值或最小值,则将其视为关键点。

[0019]

进一步地,所述s3中生成特征描述符的具体方法为:通过设计的深度卷积神经网络和损失函数,对深度卷积神经网络进行训练,训练完成后,将图像送入训练好的深度卷积神经网络中,从而生成256位的特征描述符;

[0020]

所述s2中重构的图像块作为s3中的深度卷积神经网络的训练数据。

[0021]

进一步地,所述s3中深度卷积神经网络由由三个密集块和两个过渡层组成,其中,密集块的函数公式为:

[0022]

xi=hi([x0,x1,

…

,x

i-1

])

[0023]

过渡层的函数公式为:

[0024]

xk=wk([x0″

,x1,

…

,x

k-1

]

[0025]

x

t

=w

t

*[x

0”,x1,

…

,xk]

[0026]

xu=wu*[x0′

,x

t

]

[0027]

其中,xi表示当前层的输出,hi()表示批量归一化、relu、池化和卷积操作的复合函数,*为卷积运算符,xk为第k层密集层的输出,x

t

为第一个过渡层的输出,x0经密集块分为两部分,表示为x0=[x0′

,x0″

],其中x0′

为未进入密集层的部分;x0是第0层神经网络特征的输出,x1是第1层神经网络特征的输出,xu为最终输出,w表示可训练的权重,x

i-1

表示前一层的输出,x

k-1

表示第k层的前一层的输出。

[0028]

进一步地,所述s3中的复合损失函数由hardl2损失函数和arcpatch损失函数组成,其中,hardl2损失函数为:

[0029][0030]

其中,oi表示光学描述子,sj表示sar描述子,代表和(oi,si)欧式距离最接近的前m个sar描述子非匹配描述符,代表和(oi,si)欧式距离最接近的前m个光学描述子非匹配描述符,d(oi,sj)表示oi和sj之间的距离,m表示本次实验取前m个最接近的描述符;i=1

…

n,j=1

…

n,i,j,k为描述子集合的下标,j≠i,k≠i;

[0031]

arcpatch损失函数为:

[0032][0033]

其中,b表示训练批次大小的值,s为常数,表示放大的倍数,cosθ

ii

表示正样本之间的距离,cosθ

ij

和cosθ

ji

表示负样本之间的距离,ij和ji分别表示光学图像和雷达图像的样本单位向量不同时的负样本情况,m为角裕度;

[0034]

复合损失函数为:

[0035]

loss=λ1l

hardl2

λ2l

arcpatch

[0036]

其中,λ1=1,p表示迭代次数。

[0037]

进一步地,所述s4中特征匹配的具体方法为,通过s3中生成的特征描述符,计算光学图像和sar图像的l2距离,如果光学图像和sar图像中对应的匹配点的距离误差小于2个像素,则将它们视为一对正确的匹配点;

[0038]

l2距离算法的函数公式为:

[0039][0040]

其中,oi和sj分别表示光学描述子、sar描述子。

[0041]

进一步地,所述s4中的评估方法为:

[0042]

使用xrmse表示匹配点水平距离的误差,yrmse表示匹配点垂直距离的误差,xyrmse表示匹配点像素距离的误差;所有误差测量的单位都是像素;三种误差的值越低,说明匹配精度越高;xrmse、yrmse和xyrmse的计算如下:

[0043][0044][0045][0046]

其中,表示sar图像中匹配点的坐标,表示光学图像中匹配点的坐标;n表示匹配点的总数。

[0047]

进一步地,所述s5中二维高斯函数投票算法具体为:

[0048]

首先,根据预测点的方差σ1、σ2以及预测点的数学期望μ1、μ2,每个候选位置的权重w

ij

可以表示为:

[0049]wij

=f(x,y) f(x,y)~n(μ1=3.5,σ1=7,σ2=7)

[0050]

其次,每个候选位置通过权重模板给光学图像的像素赋一定的权重,这些权重经过多轮累积后得到最终的投票值v

ij

,公式表示为:

[0051]vij

=∑w

ij

[0052]

最后,选择v

ij

值最大的位置坐标,即sar图像与光学图像位置匹配的最终结果。

[0053]

进一步地,所述二维高斯函数表示为:

[0054][0055]

其中,x、y分别是预测点的水平坐标和垂直坐标,σ1、σ2是预测点的方差,μ1、μ2是预测点的数学期望。

[0056]

本发明的有益效果是

[0057]

本发明解决了sar图像和光学图像的特征匹配问题,具有更佳的匹配能力和匹配精准度,并且能够进一步实现sar图像和光学图像的位置匹配,具有很高的实用价值。

附图说明

[0058]

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

[0059]

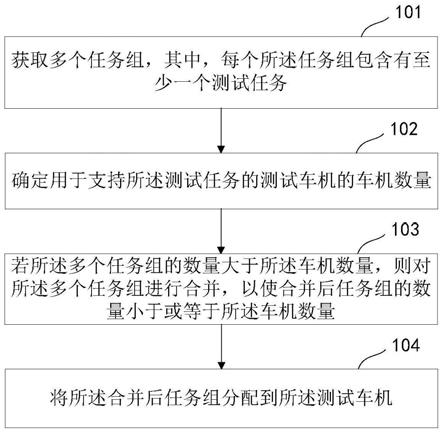

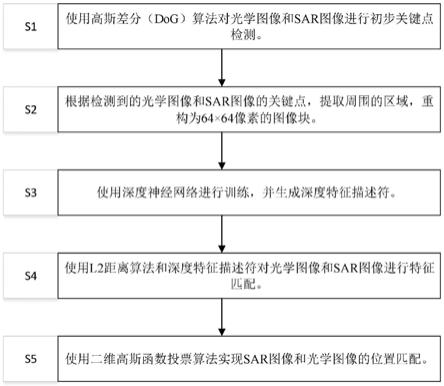

图1是本发明实施例的基于特征匹配和位置匹配的sar图像与光学图像匹配方法的流程图。

[0060]

图2是本发明实施例所取的尺寸大小不等的sar图像和光学图像示例图。

[0061]

图3是本发明实施例基于特征匹配和位置匹配的sar图像与光学图像匹配方法的总体架构图。

[0062]

图4是本发明实施例的深度神经网络结构图。

[0063]

图5是本发明实施例的hardl2算法的抽样原理图。

[0064]

图6是本发明实施例的arcpatch损失函数原理图。

[0065]

图7是本发明实施例的不同损失函数下,正负样本的分布图;其中,(a)是arcpatch损失函数下,正负样本的分布图,(b)是hardl2损失函数下,正负样本的分布图,(c)是cpatch hardl2损失函数下,正负样本的分布图。

[0066]

图8是本发明实施例的匹配率曲线图;其中,(a)是未添加噪声的数据集生成的错误匹配率-正确匹配率曲线,(b)是为未添加噪声的数据集生成的1-精确度-正确匹配率曲线。

[0067]

图9是本发明实施例对数据集添加噪声后的匹配率曲线图;(a)是添加高斯噪声和椒盐噪声的数据集生成的错误匹配率-正确匹配率曲线,(b)是添加高斯噪声和椒盐噪声的数据集生成的1-精确度-正确匹配率曲线。

[0068]

图10是本发明实施例位置匹配的候选坐标原理图。

[0069]

图11是本发明实施例的高斯权重模板及三维分布图;其中,(a)是本发明实施例的高斯权模板图,(b)是(a)的三维分布图。

[0070]

图12是本发明实施例的二维高斯函数投票算法原理及函数曲线图;其中,(a)是二维高斯函数投票算法原理图,(b)投票结果函数曲线图。

具体实施方式

[0071]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0072]

如图1-图3所示,本实施例公开了一种sar图像与光学图像匹配方法(matchosnet)并实现了特征匹配,其包括以下步骤:

[0073]

s1:使用高斯差分(dog)算法对光学图像和sar图像进行初步关键点检测。

[0074]

其中,高斯差分(dog)算法的函数为:

[0075][0076]

其中,和分别表示两幅图像的高斯滤波;x、y分别是预测点的水平坐标和垂直坐标,σ1、σ2是预测点的方差,e是自然常数。在初步的关键点检测中,本发明检测图像中所有像素点的灰度值。如果像素的dog值是所有相邻像素点的最大值或最小值,则可以将其视为关键点。

[0077]

s2:根据检测到的光学图像和sar图像的关键点,提取周围的区域,重构为64

×

64像素的图像块。

[0078]

本实施例根据检测到的光学图像和sar图像的关键点,提取周围的区域,并将其重构为64

×

64像素的图像块。这些重构的图像块可以作为深度卷积神经网络的训练数据,以解决光学图像和sar图像的尺寸差异问题。

[0079]

s3:设计了一个包含密集块和跨阶段部分网络(过渡层)的深度卷积神经网络,并设计了复合损失函数,通过对深度卷积神经网络的训练和运行,生成深度特征描述符。

[0080]

具体地,s3包括:

[0081]

s31:参见图4和表1,本发明设计了一个包含密集块和跨阶段部分网络的深度卷积网络。

[0082]

表1深度卷积网络详细描述表

[0083]

[0084][0085]

传统的卷积神经网络简单地将上层和下层连接起来,拟定当前层为第i层,当前层的输入是(i-1)层(即上一层)的输出。其公式可定义为:

[0086]

xi=hi(x

i-1

)

[0087]

其中,xi表示第i层的输出,hi()表示批量归一化、relu、池化和卷积等操作的复合函数。

[0088]

近年来有学者提出了resnet(残差网络),并在绕过非线性变换的基础上添加了一个跳过连接。resnet的公式可以表示为:

[0089]

xi=hi(x

i-1

) x

i-1

[0090]

随后densenet(密集连接网络)又被提出,并引入了从任何层到所有后续层的直接连接。densenet的公式可以表示为:

[0091]

xi=hi([x0,x1,

…

,x

i-1

])

[0092]

与传统的卷积网络和resnet相比,densenet可以获得更好的效果,因为它更有效地利用了特征,增强了特征的传输,减少了梯度消失,减少了参数的数量,可以作为密集块。

[0093]

最近又有学者提出了cspnet(交叉阶段网络),并引入了过渡层,以消除计算瓶颈,增强卷积网络的学习能力。cspnet的过渡层的公式可以表示为:

[0094]

xk=wk*[x0″

,x1,...,x

k-1

]

[0095]

x

t

=w

t

*[x

0”,x1,

…

,xk]

[0096]

xu=wu*[x0’

,x

t

]

[0097]

其中,*为卷积运算符,xk为第k层密集层的输出,x

t

为第一个过渡层的输出,x0经密集块分为两部分,表示为x0=[x0′

,x0″

],其中x0′

为未进入密集层的部分;x0是第0层神经网络特征的输出,x1是第1层神经网络特征的输出,xu为最终输出,w表示可训练的权重,x

i-1

表示前一层的输出,x

k-1

表示第k层的前一层的输出。

[0098]

cspnet保留了densenet的特征重用特征的优点,同时通过截断梯度流防止过度重复梯度信息,可以作为过渡层。

[0099]

如图4所示,本发明参考densenet与cspnet网络的连接方式,设计了一种适合于解决光学图像与sar图像特征匹配的深度卷积神经网络结构,所设计的深度卷积神经网络由三个密集块和两个过渡层组成。如表1所示,本发明设计的神经网络接受大小为64

×

64

×

1的数据,输出大小为256

×

256

×

1的最终结果。每个密集块包含9层,包括6个卷积层和3个连接层。每个过渡层包含一个卷积层和一个平均池化层,接收h

×w×

c(高

×

宽

×

通道数)的数据,导出的数据。分类层包含一个特殊的卷积层,其卷积核大小为8

×

8,可以将大小为8

×8×

21的数据转换为大小为256

×

256

×

1的输出数据。与其他方法相比,该网络具有更好的特征传递效果,能够生成理想的深度卷积描述符。

[0100]

s32:本发明通过数学推导与实践,设计了非常有效的复合损失函数。

[0101]

具体地,s32包括:

[0102]

s321:通过数学推导与实践,设计了hardl2损失函数。

[0103]

如图5所示,本发明设计了hardl2损失函数,在一个批次中,一共有n对匹配样本。对于每个正样本,生成2n-1个负样本,并使用l2距离公式选择与正样本距离最小的前m个负样本,以优化模型并获得强大的特征描述符。

[0104]

根据l2距离公式,计算大小为n

×

n的其中d(oi,sj)表示oi和sj之间的距离,oi表示光学描述子,sj表示sar描述子。

[0105]

设代表和(oi,si)欧式距离最接近的前m个sar描述子非匹配描述符,代表和(oi,si)欧式距离最接近的前m个光学描述子非匹配描述符,m表示本次实验取前m个最接近的描述符;i,j,k为描述子集合的下标,j≠i,k≠i,然后从描述符中形成三元组:

[0106]

本发明设计的hardl2损失函数的目标是最大化匹配描述符与最接近的m个非匹配描述符之间的距离,这些距离被输入到边际损失中:

[0107][0108]

其中l

hardl2

表示hardl2损失函数。

[0109]

s322:通过数学推导与实践,设计了arcpatch损失函数。

[0110]

在以前的分类问题中,很大一部分使用softmax(交叉熵损失函数)作为网络的损耗层。实验表明,softmax损失考虑了样本是否能够正确分类,而在扩大不同样本之间的类间距离和减少相似样本之间的类内距离的问题上存在较大的优化空间。

[0111]

arcface(人脸识别算法)方法提出了端面的角裕度损失。与其他损耗相比,弧面在收敛方面更为“紧凑”,这将同一类损耗压缩到更紧密的空间中,并且比其他损耗更密集,使得网络学习到的特征具有更明显的角度分布。

[0112]

arcface是一种用于人脸识别的损失函数,它最大化了角度空间中的分类边界,在处理分类问题上有很好的效果。但由于人脸匹配问题与关键点特征匹配问题存在较大差异,因此arcface损失函数在本项目中不适用。arcface最大化了分类边界,但是本发明所处

理的特征匹配问题没有任何分类信息。

[0113]

因此,如图6所示,本发明设计了一个新的损失函数arcpatch。与arcface方法不同,arcpatch没有中心向量矩阵,无法形成准确的类别数。根据特征匹配问题的样本匹配情况,设计了一种特殊的分类方法。对于每批样本,生成2批次-1类别以计算损失,其中包括正样本匹配类别和2批次-2负样本匹配类别。

[0114]

arcpatch算法使角空间中特征点的正样本和负样本之间的距离最大化,其总体公式如下:

[0115][0116]

其中,l

arcpatch

表示arcpatch损失函数,b表示一个批次大小的值;s为常数,表示将各距离放大的倍数,在本实施例中取30;cosθ

ii

表示正样本之间的距离,cosθ

ij

和cosθ

ji

表示负样本之间的距离,ij和ji分别表示光学图像和雷达图像的样本单位向量不同时的负样本情况。本发明在正样本和负样本之间添加了一个附加的角裕度m,增强了正样本和负样本之间的紧致性。

[0117]

s323:通过配置最合适的权重,设计了复合损失函数。

[0118]

本发明将最合适的权重分配给这两个损失函数,并将它们结合起来设计matchosnet的复合损失函数。损失函数可以表示为:

[0119]

loss=λ1l

,hardl2

λ2l

arcpatch

[0120]

通过大量实验,发现在训练过程中,先增大距离差,再增大角度差是最有效的。因此,本实施例设置λ1=1,p表示迭代次数。此外,如图7所示,在测试集上,复合损失函数比arcpatch损失函数和hardl2损失函数具有更明显的正负样本间的裕度。

[0121]

通过本发明设计的模型和损失函数,通过训练集对神经网络模型进行训练。模型训练完成后,将图像送入训练好的神经网络模型中,从而生成256位的特征描述符。特征描述符具有两个性质:不变性和区分力。不变性:即使图像被变换,描述符也不应该改变;区分力:每一个图像的描述符应该是高度唯一的,不同的图像具有不同的描述符。

[0122]

s4:使用l2距离算法和深度特征描述符对光学图像和sar图像进行特征匹配。

[0123]

本实施例通过s3中生成的特征描述符,计算光学图像和sar图像的l2距离,如果光学图像和sar图像中对应的匹配点的距离误差小于2个像素,则将它们视为一对正确的匹配点;

[0124]

l2距离算法的函数公式为:

[0125][0126]

oi和sj分别表示光学描述子、sar描述子。

[0127]

本实施例比较了本发明匹配方法(matchosnet)和其他三种优秀方法的有效性。

[0128]

sen1-2(地球遥感图像数据集)由schmitt等人于2017年在《the sen1-2 dataset for deep learning in sar-optical data fusion》提出。sen1-2比较了从全球所有地区和所有天气季节收集的282384个对应图像块。在本实施例中,使用了sen1-2数据集的夏季部分和冬季部分,分别有48158张图像和60104张图像。

[0129]

本实施例收集了大量中国地区的光学和sar图像,并将相应的光学和sar图像整理在一起。由于现实生活中sar图像的获取比光学图像的获取要困难得多,所以随机将sar图像分割为512*512,光学图像分割为包含sar图像内容的800*800。数据集分为六大类:港口、城区、水系、机场、岛屿和平原。整个数据集共有19.2万幅图像,其中光学图像9.6万幅,sar图像9.6万幅。该数据集每个类别分别有16000幅光学图像和16000幅sar图像。

[0130]

mishchuk等人在《working hard to know your neighbor’s margins:local descriptor learning loss》提出了最接近的正例和负例之间的距离方法(hardnet)。他们在文中提出的损失优于复杂正则化方法,最大化了一个批次中最接近的正样本和最接近的负样本之间的距离。

[0131]

balntas等人在《learning local feature descriptors with triplets and shallow convolutional neural networks》中实现了实现了三元组特征描述符方法(tfeat),并提议利用训练样本的三元组,以及困难负样本的三元组挖掘。实验表明,与其他方法相比,该方法取得了良好的效果,模型的网络结构复杂度较低,并且没有典型的计算超差。

[0132]

补丁匹配网络(matchnet)由han等人在《matchnet:unifying feature and metric learning forpatch-based matching》提出。作为一种基于补丁匹配的深度网络结构的新方法,与其他方法相比,使用更少的描述符却显著提高了结果。实验证明,与其他同类方法相比,matchnet具有很强的竞争力。作者认为,matchnet在不使用全连接层的情况下效果最好。因此,本实施例在对比实验中采用了无全连接层的matchnet,使对比实验客观、公正。

[0133]

具体地,s4包括:

[0134]

s41:对光学图像和sar图像实现分类。

[0135]

在测试数据集中,光学图像与sar图像被完全置乱,通过这一步的分类实验,可以证明matchosnet具有光学图像与sar图像一一对应的分类能力。

[0136]

表2在sen1-2 summer数据集上,本发明(matchosnet)与其他方法的分类性能对比

[0137]

模型auc指标(%)fpr80指标(%)hardnet0.98810.00075tfeat0.98590.10matchnet0.96250.05813matchosnet0.98990.0001

[0138]

表3在sarptical数据集上,本发明(matchosnet)与其他方法的分类性能对比

[0139]

模型auc指标(%)fpr80指标(%)hardnet0.95750.0445tfeat0.90040.1647matchnet0.90100.1594matchosnet0.98100.0168

[0140]

表2和表3中显示了曲线下面积(auc)和fpr 80(0.80真阳性召回点的假阳性率)的指标。曲线下面积的理想值为1。auc越大,网络性能越好。对于fpr80,数值越小,网络性能越好。fpr80的理想值为0。表2显示了从sen1-2 summer数据集(地球遥感夏季图像数据集)的

不同方法的性能。表3显示了从sarptical数据集(密集城区sar与光学影像联合分析的三维数据集)的不同方法的性能。如表2和表3所示,matchosnet在这两个数据集中的auc值最高,而fpr80值最低。它可以证明matchosnet在分类能力上非常有竞争力。

[0141]

s42:对光学图像和sar图像实现特征匹配,并对匹配结果进行评估。

[0142]

在特征匹配测试中,本发明评估了使用不同训练数据集(sen1-2 summer数据集、sen1-2 winter数据集(地球遥感冬季图像数据集)和我们收集的数据集)训练的不同方法的性能,以判断这两个补丁是否相互对应。这四种方法使用相同的数据集,在同一台服务器上以相同大小的批次进行训练,以确保实验的客观性和公平性。在实验测试中,如果光学图像和sar图像中对应的匹配点的距离误差小于2个像素,则将它们视为一对正确的匹配点。

[0143]

本发明利用高斯噪声和椒盐噪声等多种数据集计算sar光学的最终配准结果。实验通过对光学图像和sar图像的匹配结果进行计算,根据每对图像获得的真假匹配次数计算出一个判据。假设从参考图像和目标图像中分别选择检测到的关键点a和b,以及它们的描述符da和db。如果描述符da和db之间的距离小于阈值t,同时a和b经真实值标签(通信区域数据)验证为正确匹配,则a和b为真匹配。如果a和b不是真实值标签所确认的正确匹配,但是描述符da和db之间的距离小于t,那么a和b就是假匹配,反之亦然。

[0144]

真匹配率、假匹配率和精度算法的公式如下:

[0145][0146][0147][0148]

对于任何精度,描述符的最高召回率都是1。也就是说,曲线(错误匹配率-正确匹配率)和曲线(1-精确度-正确匹配率)都是越靠近在上边和左边,其算法的效率更高。如图8所示,(a)为未添加噪声的数据集生成的(错误匹配率-正确匹配率)曲线;(b)为未添加噪声的数据集生成的(1-精确度-正确匹配率)曲线。从图8可以看出,matchosnet方法在这两种测量指标上都表现得最好。

[0149]

如图9所示,(a)为添加高斯噪声和椒盐噪声的数据集生成的(错误匹配率-正确匹配率)曲线;(b)为添加高斯噪声和椒盐噪声的数据集生成的(1-精确度-正确匹配率)曲线。从图9可以得出,即便是在添加噪声后的复杂数据集上,matchosnet方法在这两种测量指标上也都表现得最好,进一步证明了matchosnet方法的优越性和健壮性。

[0150]

s43:对光学图像和sar图像实现特征点匹配,并对匹配点距离误差进行评估。

[0151]

为了验证匹配点的准确性,本发明检测了匹配点的距离误差,即在图像上使用xrmse表示匹配点水平距离的误差,yrmse表示匹配点垂直距离的误差,xyrmse表示匹配点像素距离的误差。所有误差测量的单位都是像素。xrmse、yrmse和xyrmse的功能计算如下:

[0152]

[0153][0154][0155]

其中,表示sar图像中匹配点的坐标,表示光学图像中匹配点的坐标。n表示匹配点的总数。

[0156]

表4 sen1-2_summer数据集上4种方法的正确匹配点的平均误差xrmse、yrmse、xyrmse。

[0157]

模型xrmseyrmsexyrmsehardnet1.30440.67930.7870tfeat1.33830.76160.7537matchnet1.34030.74520.7714matchosnet1.30330.74320.7415

[0158]

表5 sen1-2_winter数据集上4种方法的正确匹配点的平均误差xrmse、yrmse、xyrmse。

[0159][0160][0161]

表6本发明收集的数据集上4种方法的正确匹配点的平均误差xrmse、yrmse、xyrmse。

[0162]

模型xrmseyrmsexyrmsehardnet1.31520.76030.7368tfeat1.28380.74550.7489matchnet1.33710.77190.7444matchosnet1.31300.76560.7281

[0163]

表4、表5和表6分别显示了三个数据集中不同方法的平均误差xrmse、yrmse、xyrmse。xyrmse表示匹配点之间的平均像素误差,最能反映匹配的准确性和效果。显然,matchosnet在三个数据集中的平均误差xyrmse最低,其xrmse和yrmse也非常优秀。这表明matchosnet具有很高的特征匹配点精度和很强的特征匹配能力。

[0164]

实施例2

[0165]

本实施例公开了一种sar图像与光学图像匹配方法(matchosnet)并实现了位置匹配,其包括以下步骤:

[0166]

a.设计二维高斯分布的投票算法,实现sar图像和光学图像的位置匹配。

[0167]

每对特征点的匹配可以得到sar图像左上角像素在光学图像上的坐标。如图10所示,由于每组图像具有许多不同的特征匹配点,因此有可能获得多个候选位置坐标。

[0168]

采用二维高斯分布设计了位置匹配投票算法。x、y分别是预测点的水平坐标和垂直坐标,本发明的二维高斯函数可以表示为:

[0169][0170]

其中,σ1、σ2是预测点的方差,μ1、μ2是预测点的数学期望。

[0171]

如图11的(a)所示,本实施例设计了一个大小为7*7的高斯权模板,其三维分布如图11的(b)所示。设置μ1=3.5,μ2=3.5,σ1=7,σ2=7。每个位置的权重w

ij

可以表示为:

[0172]wij

=f(x,y)f(x,y)~n(μ1=3.5,μ2=3.5,σ1=7,σ2=7)

[0173]

如图12的(a)所示,每个候选位置可以通过权重模板给光学图像的像素赋一定的权重,这些权重经过多轮累积后得到最终的投票值v

ij

。公式可表示为:

[0174]vij

=∑w

ij

[0175]

函数的分布可以大致表示在图12的(b)中。最后,本发明选择v

ij

值最大的位置坐标,这就是sar图像与光学图像位置匹配的最终结果。

[0176]

b.通过大量实验,客观证明位置匹配的效果。

[0177]

表7不同数据集上matchosnet图像的平均误差xrmse、yrmse、xyrmse和正确位置匹配个数。

[0178][0179]

据我们所知,其他特征匹配方法未实现不同大小图像的位置匹配,因此这里本实施例只能用客观指标来分析本发明提出的方法的位置匹配效果。表7显示matchosnet的位置匹配错误以及在一批不同数据集中正确匹配的图像数。在sar图像与光学图像的位置匹配中,当图像位置匹配的距离误差小于5.0像素时,视为正确的位置匹配的图像。

[0180]

从表7中可以看出,matchosnet进行位置匹配时,sar图像与光学图像之间的距离误差很小,正确匹配的图像数量很大。结果表明,matchosnet能够很好地实现sar图像与光学图像之间的位置匹配,具有较大的实际应用价值。

[0181]

实施例3

[0182]

本实施例中,分别采用不同的深度卷积网络结构,对实施例一和实施例二中的特征匹配和位置匹配方法进行实验,从而验证本发明设计的网络结构的性能。

[0183]

表8使用不同深度卷积网络的方法的平均误差xrmse、yrmse、xyrmse和正确位置匹配的图片数。

[0184][0185]

通过比较不同模型的结果,验证了网络结构对特征检测模型的影响以及本发明设计的matchosnet结构的有效性。表8显示了matchosnet与其他两种方法的位置匹配结果。可以看出,matchosnet的xrmse、yrmse和xyrmse最低,批次中正确位置匹配的图像数量最多。以上实验证明,本发明matchosnet设计的网络体系结构在处理特征匹配和位置匹配问题上是非常有效的。

[0186]

实施例4

[0187]

本实施例中,分别采用不同的损失函数,对实施例一和实施例二中的特征匹配和位置匹配方法进行实验,从而验证本发明设计的损失函数的性能。

[0188]

表9使用不同损失函数的方法的平均误差xrmse、yrmse、xyrmse和正确位置匹配的图片数。

[0189][0190]

通过比较不同模型的结果,验证了损失函数对特征检测模型的影响。表9显示了matchosnet与其他两种方法的位置匹配结果。可以看出,matchosnet的xrmse、yrmse和xyrmse最低,批次中正确位置匹配的图像数量最多。以上实验证明了本发明matchosnet设计的损失函数在处理特征匹配和位置匹配问题时是非常有效的。

[0191]

本说明书中的各个实施例均采用相关的方式描述,各个实施例之间相同相似的部分互相参见即可,每个实施例重点说明的都是与其他实施例的不同之处。尤其,对于系统实施例而言,由于其基本相似于方法实施例,所以描述的比较简单,相关之处参见方法实施例的部分说明即可。

[0192]

以上所述仅为本发明的较佳实施例而已,并非用于限定本发明的保护范围。凡在本发明的精神和原则之内所作的任何修改、等同替换、改进等,均包含在本发明的保护范围内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。