1.本发明属于计算机应用领域,具体涉及一种案件笔录要素抽取方法。

背景技术:

2.案件笔录文本的要素提取目的是将笔录文本进行结构化,将笔录数据中被关注的要素进行抽取。目前,由于笔录文本数据结构复杂,信息量大,目前没有成熟的解决方案能够对笔录实现全文的自动要素提取分析,主流的算法是采用关键词库匹配、正则表达式、lstm crf模型等方式针对一小段案件文本片段进行要素提取。

3.随着大规模自然语言处理模型的发展与落地,bert等nlp模型已取代了传统的神经网络,实现了机器模型对文本数据的深层理解。上亿级别的模型参数量能够拟合人理解文本的过程,学习到文本内在的逻辑与表达。在要素提取任务上,bert crf模型能获得最优的效果,以bert模型产生的词向量能够精确地表征文本的含义,优于传统的词向量生成模式。

技术实现要素:

4.发明目的:本发明的目的在于提供一种案件笔录要素抽取方法。

5.技术方案:本发明所述的一种案件笔录要素抽取方法,该方法包括步骤如下:

6.(1)利用现有案件的人工笔录要素数据,构建序列标注数据集;

7.(2)对序列标注数据集内每条文本进行数据预处理后,用于对文本要素提取模型进行训练,获得用于对案件笔录要素提取的文本要素提取模型;

8.(3)在预测阶段,笔录文本预处理后输入已完成训练的文本要素提取模型,将文本数据进行序列标注后,对目标要素进行提取,完成案件笔录要素抽取。

9.优选的,步骤(1)中获取现有案件每条笔录文本对应的待抽取要素,并标记每种要素的类型,将每条笔录文本与其对应的要素文本进行匹配,利用bio 标注模式将笔录文本每一个字符打上对应的要素标签。

10.优选的,当笔录文本与其对应的要素文本进行匹配时,若存在若干要素文本与同一笔录文本匹配,则选取字符长度最长的要素文本与笔录文本完成匹配。

11.优选的,步骤(2)中文本要素提取模型包括longformer模型,预处理后的序列标注数据集内的笔录文本输入随机参数初始化的longformer模型中对模型进行预训练,用于使longformer模型学习笔录文本数据内的语言逻辑。

12.优选的,预训后的longformer模型的输出端与crf模型及输出大小为所有要素类别数量的全链接softmax层连接,形成用于判别每个位置要素类别的文本要素提取模型,将预处理后的要素标注数据输入文本要素提取模型对longformer 模型参数进行微调,直至模型损失满足设定要求。

13.优选的,对序列标注数据集内每条文本进行token编码处理,并对每一句文本进行截断和补零处理直至每一句文本的长度相同。

14.优选的,案件笔录文本包括若干问答文本结构,训练完成的文本要素提取模型对案件笔录要素进行抽取后,利用关联模型根据问题文本判断对应回答文本中抽取的要素类型是否与问题文本强相关,完成进行结果校验。

15.优选的,关联模型采用bert预训练模型,所述的bert预训练模型的训练步骤如下:

16.(a)针对数据集中的每篇笔录文本按照问和答的相关关键字进行分割,形成问题文本与回答文本集合,将每个回答文本中的要素文本进行抽取,判断对应的要素类型,形成要素类型集合,将要素类型与对应的问题文本组合拼接,形成标签为1的训练正样本;

17.(b)将每一个要素类型分别与两个随机问题文本配对拼接,去除其中的正样本,形成标签为0的训练负样本;

18.(c)将训练正样本与训练负样本随机乱序,输入bert预训练模型中进行微调训练,训练过程中,将bert预训练模型的输出叠加全连接网络,经过softmax 函数,输出标签为1或标签为0的分值,与真实的标签计算loss误差,利用梯度下降算法,更新模型权重,得到训练完成的bert预训练模型。

19.优选的,训练完成的bert预训练模型用于对文本要素提取模型的结果集进行校验,将抽取得到的各要素文本的要素类型与所在问句文本进行文本拼接,输入bert预训练模型,若bert预训练模型输出的匹配分值小于设定值,则在结果集中删除该要素文本。

20.进一步的,首先获取海量案件笔录文本,用于对longformer模型进行训练,案件笔录要素提取是一种序列标注任务,首先抽取每条现有笔录文本对应的地点、角色姓名、身份证号、住址、户籍地等待抽取要素,分别用英文字母标记每种要素的类型,例如将某一角色的姓名标记为“xyr_name”;再将笔录文本与要素文本进行匹配,用“bio标注”的方式,将笔录文本每一个字符打上对应的要素标签,若有两个要素文本都与同一段笔录文本匹配重合,采用最长字符匹配策略,以字符长度较长的要素文本为准。

21.进一步的,longformer模型预训练过程中,将笔录文本数据放入随机参数初始化的longformer模型中,进行mask lm和next sentence prediction两类任务的训练,对模型进行预训练,目的是让longformer模型学习到笔录数据的内在语言逻辑和表达。longformer模型采用的注意力头个数为12、隐层神经元维度为768,注意力窗口尺寸为512,transformer层数为12,最大句子长度为4096 个字符;通过滑动窗口注意力机制结合全局空洞注意力机制,能够有效地对笔录类长文本进行整体模型训练,克服传统的预训练模型的长度限制,能够契合笔录文本的业务场景。

22.将要素标注数据输入文本要素提取模型对longformer模型参数进行微调过程中,对之前longformer模型预训练得到的参数进行fine-tune微调,模型以交叉熵作为损失函数,学习率随时间动态递减,利用反向梯度下降算法优化模型中的参数,所述的要素标注数据为完成要素标注的文本数据,而预训练过程中的文本数据为单纯的笔录文本。

23.文本要素提取模型中longformer模型用于提取长文本序列的语义特征,将每一个token进行语义embedding处理;crf模型用于将每一个字符的embedding 向量转化为对每一个序列标签类型的预测,softmax层用于将模型对标签的预测多分类结果以概率的形式展现出来。

24.训练好的文本要素提取模型在预测阶段,将待提取要素的案件笔录文本输入文本要素提取模型进行序列标注,将打上“b_”开头标签的字符以及后面连续的“i_”开头标签的

字符进行抽取拼接,形成机器预测的笔录要素文本。

25.进一步的,针对案件笔录文本为一问一答的文本结构,考虑到问题文本与回答文本之间的关联性,利用问题文本与要素文本之间关联性,对文本要素提取模型的输出结果进行验证,利用训练好的bert预训练模型对问题文本与要素文本之间关联性进行预测。

26.在训练bert预训练模型时,问和答的相关关键字可以为“问:”和“答:”等;构建训练样本时,要素类型与问题文本配对拼接时中间以[sep]标记作为分割,构建的训练正样本表示问题与要素类型匹配;构建的训练负样本表示问题与要素类型不匹配。

[0027]

有益效果:本技术所述的技术方案中对文本要素提取模型进行两次训练,其中,第一次训练能够让文本要素提取模型学习到笔录文本数据的内在语言逻辑和表达,第二次微调能够让模型具有判别笔录文本中每一个位置要素类别的能力;训练完成的文本要素提取模型能够自动提取案件笔录文本中的要素,辅助用户实现智能化数据分析。

[0028]

进一步的,采用要素类型与提问文本之间的关联性,对文本要素提取模型的结果进行验证,极大提高了案件笔录文本要素抽取的准确率。

附图说明

[0029]

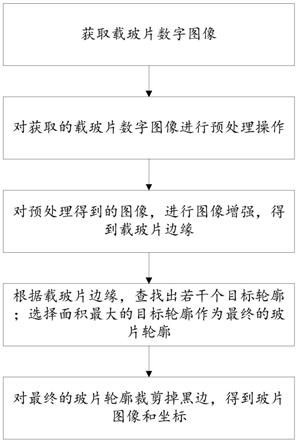

图1为本发明中案件笔录要素抽取方法的工作流程图;

具体实施方式

[0030]

下面结合附图和实施例对本发明的技术方案做进一步详细说明。

[0031]

一种案件笔录要素抽取方法,该种智能写作方法应用案件笔录文本要素提取业务中,如图1所示,具体步骤如下:

[0032]

步骤1,从笔录数据库中抽取历史每条笔录文本对应的地点、角色姓名、身份证号、住址、户籍地等待抽取要素,分别用英文字母标记每种要素的类型,本实施例中,将某一角色的姓名标记为“xyr_name”。将每一条笔录数据的笔录文本与各要素文本进行匹配,用“bio标注”的方式,将笔录文本每一个字符打上对应的要素标签。匹配过程中采取最长字符匹配策略,即若有两个要素文本都与同一段笔录文本匹配重合,以长的要素文本为准。

[0033]

步骤2,利用longformer模型配合crf模型构建文本要素提取模型;首先基于原始获得的案件笔录文本数据,对每一条文本数据进行token编码处理,并对每一句文本进行截断和补零处理,令每一句文本的长度相同;

[0034]

利用预处理后的案件笔录文本数据,对随机参数初始化的longformer模型进行mask lm和next sentence prediction两类任务的训练,完成对longformer 模型的预训练,使longformer模型学习到案件笔录数据的内在语言逻辑和表达。本实施例中,longformer模型采用的注意力头个数为12、隐层神经元维度为768,注意力窗口尺寸为512,transformer层数为12,最大句子长度为4096个字符。

[0035]

预训练后的longformer模型的输出端连接一个crf模型以及输出大小为所有要素类别数量的全链接softmax层形成待训练的文本要素提取模型,以判别文本中每一个位置的要素类别。将预处理后的要素标注数据输入待训练的文本要素提取模型,对longformer模型的参数进行fine-tune微调,直至文本要素提取模型满足设定要求。本实施例中,文本要素提取模型以交叉熵作为损失函数,学习率随时间动态递减,利用反向梯度下降算法优

化模型中的参数。

[0036]

步骤3,利用bert模型构造问题文本与要素文本关联性模型;由于案件笔录文本为一问一答的文本结构,问题文本与回答文本之间具有较强的关联性,因此根据问题文本能够判断对应回答文本中抽取的要素类型是否与问题文本强相关,进而完成文本要素提取模型的预测结果校验。

[0037]

本实施例中,关联性模型训练的具体步骤如下:

[0038]

步骤3.1,针对现有的的每篇笔录文本,按照关键字“问:”和“答:”将笔录文本进行分割,形成问题文本与回答文本集合;将每个回答文本中的要素文本进行抽取,判断对应的要素类型,形成要素类型集合,将要素类型与对应的问题文本组合拼接,中间以[sep]标记作为分割,形成训练正样本,样本对应的标签为1,表示问题与要素类型匹配;

[0039]

步骤3.2,将每一个要素类型分别与两个随机问题文本配对拼接,中间以[sep] 标记作为分割,去除其中的正样本,形成训练负样本,样本对应的标签为0,表示问题与要素类型不匹配;

[0040]

步骤3.3,将训练正样本与训练负样本随机乱序,输入bert模型中进行微调训练,训练过程中,在bert输出的[cls]位之后叠加全连接网络,经过softmax 函数,输出标签为1和标签为0的分值,与真实的标签计算loss误差,利用梯度下降算法,更新模型权重,直至bert模型收敛。

[0041]

步骤4,完成训练的文本要素提取模型在预测阶段,将待进行要素提取的文本进行预处理,并将预处理后的笔录文本输入文本要素提取模型,对输入的文本进行序列标注,将打上“b_”开头标签的字符以及后面连续的“i_”开头标签的字符进行抽取拼接,形成机器预测的笔录要素文本。

[0042]

将机器预测的笔录要素类型与所在问句文本进行文本拼接,中间以[sep]标记作为分割,输入bert模型,输出匹配分值,若分值小于0.6,则进行过滤;最终完成笔录文本的要素提取。

[0043]

综上,该方法中分两个阶段对文本要素提取模型进行训练,既能够让 longformer模型学习到文本数据的内在语言逻辑和表达,又能够对特定领域的文本数据进行针对性训练,使文本要素提取模型在指定领域的识别精准度极大升。进一步的,利用bert模型通过问句文本与要素类型的二分类任务,对 longformer的结果集进行校验,提高了要素抽取的准确率。该种案件笔录要素抽取方法能够快速、准确地对案件笔录文本数据进行要素抽取,综合准确率到达 90%以上,能够满足案件笔录类长文本的处理分析需求,辅助用户实现智能化数据分析。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。