1.本发明属于拼接图像篡改检测领域,特别是涉及一种基于注意力机制的拼接图像篡改检测方法及系统。

背景技术:

2.随着各种数码设备的飞速发展,数字图像在我们的生活中越来越常见,并且已经与我们的生活息息相关,各种各样的社交软件也加快了它们的传播。随之而来的还有图像处理软件,比如photoshop、美图秀秀等,修图软件的普及使得虚假图像越来越常见。这些虚假图像若被人恶意使用,则会对社会造成严重危害。

3.目前最常见的篡改方法有三种,拼接、复制粘贴和移除,其中复制粘贴和移除都是在一张图片上完成操作的,复制粘贴是从图像中复制一部分并粘贴到同一张图片的另一区域,移除是对图像中的某一区域进行消除操作,拼接是从一幅图像中选取某一块区域,将其粘贴至另一幅图像中。其中的拼接篡改方式是目前在图像篡改检测领域中的一大难点。

4.传统图像篡改检测算法通常依据图像自身的信息和物理特性,根据篡改引起的图像特性变化进行检测,如cfa差值算法,jpeg量化表算法,模式噪声估计算法等。这些算法在早期起到了一定的作用,有效地促进了该领域的发展,但传统算法的准确率普遍不算很高且鲁棒性较差,这使得很难将其有效、高效的应用于现实生活中以解决实际问题。近年来深度学习技术发展迅速,越来越多的研究者将深度学习技术应用到图像篡改检测领域。但现有的基于深度学习的目标检测算法还存在着一些问题:(1)对篡改内容的识别精度不高,速度较慢,且篡改区域定位的准确度较低。(2)图像中的篡改特征较难提取。(3)神经网络训练过程中的正、负样本不平衡。

技术实现要素:

5.本发明的目的是提供一种基于注意力机制的拼接图像篡改检测方法及系统,以解决目前的绝大部分拼接篡改检测模型检测速率较低,且效果一般的问题。

6.一方面为实现上述目的,本发明提供了一种基于注意力机制的拼接图像篡改检测方法,包括:

7.构建篡改拼接数据集和图像篡改检测模型,将所述篡改拼接数据集划分为训练集与测试集,将所述训练集中的篡改拼接图像输入所述图像篡改检测模型;

8.对所述篡改拼接图像提取篡改特征,获得特征图;

9.基于带有注意力机制的特征融合网络对所述特征图进行特征融合处理,获得最终特征图,基于所述最终特征图获得拼接图像篡改区域定位结果;

10.基于所述测试集对训练完成的图像篡改检测模型进行测试,测试完成后获得检测结果。

11.可选的,构建拼接篡改数据集的过程中包括:

12.s1.随机选取coco数据集中的一张图片并读取其中的真值目标及真值目标所在区

域;

13.s2.将所述真值目标及真值目标所在区域截取,并随机粘贴到其他图片中的随机区域,得到合成图像;

14.s3.重复s1-s2过程,直到将所述coco数据集中的所有图片均转化为所述合成图像,构成拼接篡改数据集。

15.可选的,构建所述图像篡改检测模型的过程中包括:

16.采用改进的yolov4模型构建所述图像篡改模型;

17.所述改进的yolov4模型中的损失函数采用了focal loss损失函数。

18.可选的,对所述篡改拼接图像提取篡改特征的过程中包括:

19.基于cspdarknet53特征提取网络提取出图像中的篡改特征,输出三个不同大小的特征图。

20.可选的,基于带有注意力机制的特征融合网络对所述特征图进行特征融合处理,获得最终特征图的过程中包括:

21.通过通道注意力使用平均池化与最大池化缩小所述特征图的空间信息;

22.基于共享全连接层得到通道特征图;

23.将所述通道特征图与所述特征图内积,获得第一特征图;

24.基于空间注意力对所述第一特征图进行处理,获得目标位置,基于上述目标位置获得所述最终特征图。

25.可选的,所述方法还包括对测试结果进行评估,评估指标选用平均精度ap对测试结果进行评估。

26.另一方面为实现上述目的,一种基于注意力机制的拼接图像篡改检测系统,包括:

27.数据集构建模块和图像篡改检测模型;

28.所述数据集构建模块用于构建拼接篡改数据集,所述拼接篡改数据集用于训练和测试所述图像篡改检测模型;

29.所述图像篡改检测模型用于检测待测图像中是否存在拼接图像篡改情况。

30.可选的,所述图像篡改检测模型包括特征提取模块和特征融合模块;

31.所述特征提取模块用于对待测图像提取篡改特征,获得特征图;

32.所述特征融合模块用于基于注意力机制对所述特征图进行特征融合处理,获得最终特征图,所述特征融合模块包括注意力机制模块;

33.所述图像篡改检测模型基于所述最终特征图检测待测图像中是否存在拼接图像篡改情况。

34.可选的,所述注意力机制模块包括通道注意力模块和空间注意力模块;

35.所述通道注意力模块用于对所述特征图进行处理,获得通道特征图;

36.所述空间注意力模块用于对所述通道特征图和所述特征图的内积进行空间注意力处理,获得最终特征图。

37.可选的,所述通道注意力模块包括缩小空间信息模块和共享全连接模块;

38.缩小空间信息模块用于对所述特征图进行平均池化和最大池化,缩小空间信息;

39.所述共享全连接模块用于对缩小空间信息的所述特征图进行处理,获得所述通道特征图。

40.本发明的技术效果为:

41.(1)在yolov4网络的颈部末端添加cbam注意力机制,以增强对图像中篡改特征的提取能力。

42.(2)将损失函数中的置信度损失替换为focal loss,通过减少简单样本的权重,使模型在进行篡改检测任务训练时,专注于困难的样本,并有效改善在训练过程中正负样本不平衡的问题。

43.(3)利用coco数据集制作coco合成拼接篡改数据集,以解决因数据集不足而导致的无法充分训练神经网络的问题。

附图说明

44.构成本技术的一部分的附图用来提供对本技术的进一步理解,本技术的示意性实施例及其说明用于解释本技术,并不构成对本技术的不当限定。在附图中:

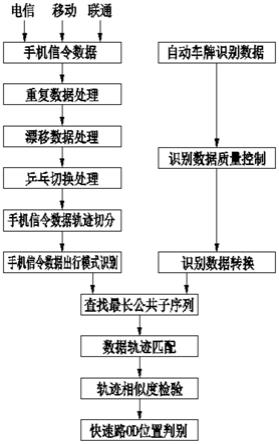

45.图1为本发明实施例中的一种基于注意力机制的拼接图像篡改监测方法流程图。

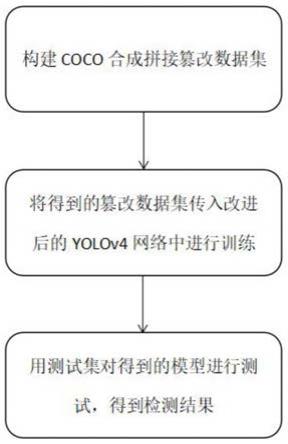

46.图2为本发明实施例中的改进后的yolov4结构示意图;

具体实施方式

47.需要说明的是,在不冲突的情况下,本技术中的实施例及实施例中的特征可以相互组合。下面将参考附图并结合实施例来详细说明本技术。

48.需要说明的是,在附图的流程图示出的步骤可以在诸如一组计算机可执行指令的计算机系统中执行,并且,虽然在流程图中示出了逻辑顺序,但是在某些情况下,可以以不同于此处的顺序执行所示出或描述的步骤。

49.实施例一

50.如图1所示,本实施例中提供一种基于注意力机制的拼接图像篡改检测方法,包括:

51.(1)使用coco数据集制作coco合成拼接篡改数据集,以实现篡改图像数据集的构建。

52.(2)采用coco合成数据集对改进后的yolov4模型进行训练,首先将训练集输入到篡改检测网络中,经过cspdarknet53特征提取网络提取出图像中的篡改特征,输出三个不同大小的特征图。

53.(3)特征图传入spp特征金字塔,进行最大池化操作。

54.(4)将池化后得到的特征图传入panet特征融合网络,在特征融合网络三个分支末端经过cbam注意力模块之后,得到三个尺度不同的融合特征,其中的注意力机制可以更加有效地获取图像中的局部篡改信息。经上述操作后得到训练模型。

55.(5)用测试集对训练得到的模型进行测试,得到检测结果。

56.其中合成拼接篡改数据集的构建流程具体如下:首先随机选取coco数据集中的一张图片并读取其中的真值目标及真值目标所在区域,将此区域截取并随机粘贴到其他图片中的随机区域,得到合成图像。修改原始xml文件中的边界框以及类别信息,得到合成图像的xml文件。对coco数据集中的所有图片执行上述流程,得到最终的coco合成拼接篡改数据集。其中包含annotations、imagesets和jpegimages三个文件夹。annotations用来存放xml

文件,jpegimages存放合成后的图片。通过此方法一共获得了11833张篡改图像,其中10771张用来进行训练,1072张用来测试。

57.本实施例评估指标选用平均精度ap(average precision)对测试结果进行评估。ap值即为pr曲线下的面积,pr曲线是以召回率和精确率构成的二维曲线。由于在该发明中目标类别只有“tamper”一种,所以map值即为ap值。ap的计算公式如下:

[0058][0059]

在合成拼接篡改数据集上进行训练后,与其他的图像篡改检测方法以及原始yolov4模型进行了对比实验,不同模型间的精度对比如表1所示。

[0060]

表1

[0061]

模型aprgb-n0.627rgb-e0.810fcr-cnn0.858yolov40.871本文模型0.914

[0062]

相比于其他的篡改检测模型以及原始yolov4,本文所提出的方法有着较为明显的改进。

[0063]

yolo系列算法属于单阶段目标检测算法,相比于两阶段算法,有着明显的速度优势。yolov4不仅速度快,在检测精度上也丝毫不逊色于两阶段目标检测模型。其网络结构如图2所示。它由cspdarknet53特征提取模块、sppnet、panet特征融合模块和yolo head输出层这几部分组成。其中的cspdarknet53是将darknet53与cspnet结合而获得的。相比于darknet53有着更强的学习能力,在不损失精度的情况下实现网络的轻量化。同时还在批归一化层后使用mish激活函数代替leaky relu激活函数,能够增强对目标的特征提取能力。网络颈部位于特征提取模块和输出层的中间部分,在网络的颈部使用了空间金字塔池化结构(spatial pyramid pooling,spp)和路径聚合网络(path aggregation network,panet),spp利用四个大小分别为1

×

1、5

×

5、9

×

9、13

×

13的最大池化层来进行处理,通过对不同大小的特征进行融合和最大池化,可有效改善待检测目标大小差异较大的情况。panet添加了从下到上的信息传输路径,对特征金字塔(feature pyramid network,fpn)进行了加强。yolo head用作最终的结果预测。

[0064]

在yolov4中,损失函数由置信度损失、分类损失和边界框回归损失三部分组成。相较于yolov3,其置信度损失和分类损失都没有变化,边界框回归损失则是使用ciou loss替换了mse loss,ciou loss相较于giou loss和diou loss,着重改进了矩形框的比例,对检测效果有了更进一步的改进。

[0065]

[0066][0067][0068][0069]

式中,m为在每个网格中生成的候选框数量,k2为网格总数量,表示目标存在于候选框中的含义值,表示目标不存在于候选框中的含义值,为实际置信度,ci为预测置信度,w

gt

与h

gt

为真实框的宽度与高度,λ

noobj

为不存在目标的候选框的权重,pi(c)为网格内目标为c类的真实概率,是预测的概率,α为权衡作用的参数,ν用来衡量长宽比一致性,d为欧几里德距离,c为对角线距离。

[0070]

在图像篡改检测任务中,要提取的特征与传统目标检测任务有所不同,所要提取的不是语义特征而是篡改特征,而yolov4模型对篡改特征的提取并不是特别的准确,使得在篡改任务中的表现不是很好。所以,本文在特征融合的三个分支末尾分别添加cbam注意力机制,使得输入图像在经过特征融合后,能够更加关注有用的篡改信息,同时抑制其它无用的信息,图2为改进后的yolov4网络结构。

[0071]

cbam模块由通道注意力模块与空间注意力模块共同组合而成,将特征图输入进cbam模块中后,首先经过通道注意力使用平均池化与最大池化缩小空间信息,再经过共享全连接层得到通道特征图。将该通道特征图与输入特征图内积后得到的特征图再经过空间注意力处理后,得到最后的特征图。通道注意力关注的是所要检测的目标内容,而空间注意力关注的则是目标位置。通道注意力与空间注意力的定义式如下:

[0072][0073][0074]

其中,f为输入特征,σ为sigmoid函数,mlp为多层感知器。

[0075]

图像篡改数据集中的每张图片的篡改目标是有限的,因此在传统目标检测任务中存在的正负样本不平衡问题在篡改检测任务中也同样存在。yolov4中的原始损失函数无法有效解决这类问题,所以本文将yolov4中的置信度损失替换成focal loss,focal loss能够改善正负样本不平衡以及使模型在训练过程中专注于困难的样本。focal loss定义如下:

[0076]

fl(p

t

)=-α

t

(1-p

t

)

γ

log(p

t

)

[0077][0078][0079]

其中,p为估计概率,α为权重因子,γ为聚焦参数。

[0080]

以上所述,仅为本技术较佳的具体实施方式,但本技术的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本技术揭露的技术范围内,可轻易想到的变化或替换,都应涵盖在本技术的保护范围之内。因此,本技术的保护范围应该以权利要求的保护范围为准。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。