1.本发明涉及自动驾驶目标检测技术领域,具体为一种适用于模态强弱变化的多模态目标检测方法及系统。

背景技术:

2.近年来,目标识别检测在人脸识别、图像识别、视频识别、自动驾驶等方面取得了令人瞩目的进展。目标识别检测在自动驾驶中尤为重要,通过检测识别道路上的交通参与物,对车辆的安全行驶、紧急避让等操作具有重要意义。

3.目前,目标识别检测中的多模态环境感知方式主要有三种:一、利用多个传感器获取各个模态数据,将各个模态数据在感知前进行叠加融合,又称前融合,这种多模态环境感知方式的缺点是:对传感器所得到的模态数据物理量间的联系要求较大,例如速度、转角等数据;二、分别针对各个模态数据设计神经网络,利用神经网络提取特征,得到所需要的局部特征与全局特征,并在特征层面对各个模态数据对应的模态特征进行叠加融合,又称中间融合,这种多模态环境感知方式的缺点是:对不同模态数据间的相互关系考虑不足,例如相机和毫米波雷达,在昏暗条件下,神经网络需要对比两个模态数据的强弱,并在输出感知结果中更着重于体现毫米波雷达;三、利用各个模态数据的感知结果进行逻辑上的的取舍,综合得到最终结果,又称后融合,这种多模态环境感知方式的缺点是:融合结果类似于取交集,尽量排除掉不可靠的因素。

4.在自动驾驶环境下,多个传感器获取到的各个模态数据之间可能并不存在着较强的依赖关系,但各个传感器得到的数据对于完成自动驾驶任务来说,是必不可少的,针对检测识别结果粗暴的取交集,会降低最终的检测识别效果;而利用神经网络提取各个模态数据,在特征层面进行叠加融合的过程中,忽视了极端场景下各个模态数据之间存在的相互关系,往往会造成漏检或错检。

技术实现要素:

5.本发明的目的在于提供一种适用于模态强弱变化的多模态目标检测方法及系统,以解决上述背景技术中提出的问题。

6.为实现上述目的,本发明提供如下技术方案:

7.一种适用于模态强弱变化的多模态目标检测方法,包括如下步骤:

8.s1、多模态信息的特征提取:选择大量的训练数据集,训练数据集中包含多种极端场景下的各个同一时空下不同维度的模态数据,针对不同维度的模态数据,利用对应的特征提取模块获得相应的模态特征张量;

9.s2、第一次模型训练:在稀疏编码的基础上,针对步骤s1中获得的不同维度的模态特征张量,取除通道外的模态特征张量的特征图尺度进行字典集训练,将字典集对应的字典集损失项纳入模型训练时的整体损失函数中,构建形成不考虑多模态数据间相互关系的第一融合检测网络模型,然后,对第一融合检测网络模型进行训练,第一融合检测网络模型

训练完成后,即可同时得到不同维度模态数据对应的完善的字典集;

10.s3、第二次模型训练:利用得到的完善的字典集,计算不同维度模态数据对应的模态稀疏度,由模态稀疏度计算得出叠加系数分配比例,构建形成考虑多模态数据间相互关系的第二融合检测网络模型,然后,对第二融合检测网络模型进行训练,在训练过程的特征融合阶段,根据叠加系数分配比例,对待融合的相关特征的权重加以校正,直至第二融合检测网络模型训练完成;

11.s4、检测应用:将实际驾驶场景中同一时空下不同维度的模态数据进行步骤s1的特征提取操作,得到相应的实时模态特征张量,将实时模态特征张量输入训练完成的第二融合检测网络模型,对交通参与物进行预测,第二融合检测网络模型输出得到最终的目标检测效果。

12.作为本发明进一步的方案,所述步骤s1中针对三维空间点云数据进行特征提取的过程为:首先,根据三维空间点云数据,利用体素分区、点云归组、vef特征编码得到点云稀疏张量;接着,通过三维卷积核对点云稀疏张量进行多次三维卷积操作,每次三维卷积操作均得到一个代表对应尺度的四维张量;

13.所述步骤s1中针对二维彩色图像数据进行特征提取的过程为:通过3*3的卷积核对二维彩色图像数据对应的图像张量进行多次卷积操作,将每次卷积操作的结果构建成一个类树状结构,将当前卷积操作结果的输出作为之后某次卷积操作的输入,构建跳跃链接,最终得到图像三维张量。

14.作为本发明进一步的方案,所述的三维空间点云数据的极端场景包括强光场景、烟雾场景、下雨场景或/和下雪场景;

15.所述的二维彩色图像数据的极端场景包括雨夜场景、雪夜场景、白天下雨场景或/和白天下雪场景。

16.作为本发明进一步的方案,所述步骤s2中第一融合检测网络模型包括3d目标检测模型、smoke任务网络、vsa提取模块、特征融合模块、精修模块和整体损失函数,第一次模型训练的具体步骤为:

17.s21、定义字典集和构建字典集损失项:在得到不同维度的模态特征张量后,依据稀疏编码定义,针对不同维度的模态特征张量分别定义对应的字典集,依据对应模态特征张量的通道数,进行取均值,构建对应的字典集损失项;

18.s22、构建前景点损失项以及3d包围框损失项:根据3d目标检测模型输出得到的粗略的3d包围框和训练数据集中的真值标签,计算得出前景点损失项和3d包围框损失项;

19.s23、构建关键点损失项:根据smoke任务网络得到的目标的2d关键点和所属种类,得到关键点损失项;

20.s24、构建置信度损失项与修正损失项:根据精修模块得到的置信度预测结果和边框修正参数,得到置信度损失项与修正损失项;

21.s25、构建形成不考虑多模态数据间相互关系的第一融合检测网络模型:第一融合检测网络模型的整体损失函数包括前景点损失项、3d包围框损失项、关键点损失项、置信度损失项、修正损失项和字典集损失项;

22.s26、进行第一融合检测网络模型的训练:利用步骤s1提取获得的模态特征张量对第一融合检测网络模型进行训练,当整体损失函数达到最小时,第一融合检测网络模型训

练完成;同时,字典集也训练完成,得到不同维度模态数据对应的完善的字典集。

23.作为本发明进一步的方案,所述步骤s3中第二融合检测网络模型包括完善的字典集、3d目标检测模型、smoke任务网络、vsa提取模块、特征融合模块、softmax函数、精修模块和整体损失函数,第二次模型训练的具体步骤为:

24.s31、利用得到的完善的字典集,计算不同维度模态数据对应的模态稀疏度,将不同维度模态数据对应的模态稀疏度组成一个向量,利用softmax函数将该向量映射到[0,1]空间,且和为1,得到不同维度模态数据对应的叠加系数分配比例;

[0025]

s32、构建前景点损失项以及3d包围框损失项:与步骤s22相同;

[0026]

s33、构建关键点损失项:与步骤s23相同;

[0027]

s34、构建置信度损失项与修正损失项:与步骤s24相同;

[0028]

s35、构建形成考虑多模态数据间相互关系的第二融合检测网络模型:第二融合检测网络模型的整体损失函数包括前景点损失项、3d包围框损失项、关键点损失项、置信度损失项和修正损失项;

[0029]

s36、进行第二融合检测网络模型的训练:利用步骤s1提取获得的模态特征张量对第二融合检测网络模型进行训练,当整体损失函数达到最小时,第二融合检测网络模型训练完成。

[0030]

作为本发明进一步的方案,所述的字典集包括用于与三维空间点云数据对应的三维字典集以及用于与二维彩色图像数据对应的二维字典集;字典集损失项也包括三维字典集损失项和二维字典集损失项。

[0031]

作为本发明进一步的方案,所述步骤s26中第一融合检测网络模型的具体训练过程为:

[0032]

s261、3d目标初步识别阶段:3d目标检测模型取步骤s1中最终输出的三维空间点云数据对应的四维张量,将该四维张量的投影鸟瞰图作为点云鸟瞰图张量,利用3d目标检测模型的分类分支确定点云鸟瞰图张量中目标的前景点,再利用3d目标检测模型的回归分支回归目标的2d鸟瞰图边框,忽略z轴向点云空间投影,得到粗略的3d包围框,将三维空间点云数据分割为目标的前景与背景;

[0033]

s262、确定3d中心点阶段:根据步骤s1中二维彩色图像数据对应的图像三维张量,利用smoke任务网络的关键点分支,输出得到在二维彩色图像数据中目标的2d关键点,结合相机内参,反推出目标的3d关键点;在三维空间点云数据中,按欧式距离法查找与3d关键点最贴近的点,将该点作为目标的3d中心点;

[0034]

s263、vsa提取阶段:利用vsa模块分别将步骤s1中点云稀疏张量和每次三维卷积操作得到的四维张量汇聚到3d中心点上,得到每个目标的3d中心点领域集,再通过max池化操作,得到3d中心点对应的体素特征,结合所有的体素特征,得到3d中心点的多层次体素特征;

[0035]

利用3d中心点对初始的三维空间点云数据进行vsa操作,得到全局特征,结合全局特征和多层次体素特征,得到二维模态数据相关特征;

[0036]

再将3d中心点投影至点云鸟瞰图上,并进行二项插值,得到鸟瞰图插值特征;

[0037]

s264、第一次特征融合阶段:特征融合模块对二维模态数据相关特征和鸟瞰图插值特征进行add操作,实现简单拼接,得到第一融合特征;

[0038]

s265、精修阶段:将第一融合特征和粗略的3d包围框输入精修模块,精修模块运算得到置信度预测结果和边框修正参数;

[0039]

s266、字典集训练完成阶段:重复步骤s261~s265,直至整体损失函数达到最小,第一融合检测网络模型训练完成,同时,字典集也训练完成,得到不同维度模态数据对应的完善的字典集。

[0040]

作为本发明进一步的方案,所述步骤s36中第二融合检测网络模型的具体训练过程为:

[0041]

s361、3d目标初步识别阶段:与步骤s261相同;

[0042]

s362、确定3d中心点阶段:与步骤s262相同;

[0043]

s363、vsa提取阶段:与步骤263相同;

[0044]

s364、第二次特征融合阶段:特征融合模块根据叠加系数分配比例,对二维模态数据相关特征和鸟瞰图插值特征进行融合拼接,得到第二融合特征;

[0045]

s365、精修阶段:将第二融合特征和粗略的3d包围框输入精修模块,精修模块运算得到置信度预测结果和边框修正参数;

[0046]

s366、第二融合检测网络模型训练完成阶段:重复步骤s361~s365,直至整体损失函数达到最小,第二融合检测网络模型训练完成。

[0047]

作为本发明进一步的方案,所述步骤s4中检测应用的具体过程为:

[0048]

s41、将实际驾驶场景中同一时空下不同维度的模态数据进行步骤s1的特征提取操作,得到相应的实时模态特征张量,将实时模态特征张量输入第二融合检测网络模型;

[0049]

s42、第二融合检测网络模型对交通参与物进行预测,由3d目标检测模型输出得到粗略的3d包围框,由精修模块输出得到置信度预测结果和边框修正参数;

[0050]

s43、综合粗略的3d包围框、置信度预测结果和边框修正参数这三个输出信息,将交通参与物用一个新的3d包围框将检测到的目标标识出来,并得到目标所属种类的概率,即为3d目标检测的结果。

[0051]

一种适用于模态强弱变化的多模态目标检测系统,包括:大量充分的训练数据集,训练数据集中包含多种极端场景下的各个同一时空下不同维度的模态数据;

[0052]

特征提取模块,用于对训练数据集中不同维度的模态数据进行特征提取,获得相应的模态特征张量;

[0053]

字典集,在稀疏编码的基础上,针对获得的不同维度的模态特征张量,取除通道外的特征图尺度进行字典集训练,第一融合检测网络模型训练完成后,得到不同维度模态数据对应的完善的字典集,通过完善的字典集计算不同维度模态数据对应的模态稀疏度;

[0054]

smoke任务网络,根据二维彩色图像数据对应的图像三维张量,利用smoke任务网络的关键点分支,输出得到在二维彩色图像数据中目标的2d关键点,结合相机内参,反推出目标的3d关键点;在三维空间点云数据中,按欧式距离法查找与3d关键点最贴近的点,将该点作为目标的3d中心点;

[0055]

vsa提取模块,对特征提取过程中每次三维卷积操作得到的模态特征张量进行vsa操作,得到结合3d中心点的多层次体素特征;

[0056]

利用3d中心点对初始的三维空间点云数据进行vsa操作,得到全局特征;

[0057]

将3d中心点投影至点云鸟瞰图上,并进行二项插值,得到鸟瞰图插值特征;

[0058]

结合全局特征和多层次体素特征,得到二维模态数据相关特征;

[0059]

特征融合模块,在进行第一融合检测网络模型训练过程中,用于对二维模态数据相关特征和鸟瞰图插值特征进行add操作,实现简单拼接,得到第一融合特征;

[0060]

在进行第二融合检测网络模型训练过程中,特征融合模块根据叠加系数分配比例,对二维模态数据相关特征和鸟瞰图插值特征进行融合拼接,得到第二融合特征;

[0061]

3d目标检测模型,取特征提取模块最终输出的三维空间点云数据对应的模态特征张量,将该模态特征张量的投影鸟瞰图作为点云鸟瞰图张量,输入3d目标检测模型,得到粗略的3d包围框;

[0062]

精修模块,用于结合融合特征和粗略的3d包围框,输出得到修正特征向量,修正特征向量用于置信度的预测和粗略的3d包围框的修正;

[0063]

整体损失函数,用于估量融合检测网络模型的预测值与真实值的不一致程度,当整体损失函数达到最小时,融合检测网络模型训练完成;

[0064]

在进行第一融合检测网络模型训练过程中,整体损失函数包括前景点损失项、3d包围框损失项、关键点损失项、置信度损失项、修正损失项、二维字典集损失项和三维字典集损失项;

[0065]

在进行第二融合检测网络模型训练过程中,整体损失函数包括前景点损失项、3d包围框损失项、关键点损失项、置信度损失项和修正损失项;softmax函数,在进行第二融合检测网络模型训练过程中,将不同维度模态数据对应的模态稀疏度组成一个向量,利用softmax函数将该向量映射到[0,1]空间,且和为1,得到不同维度模态数据对应的叠加系数分配比例。

[0066]

与现有技术相比,本发明的有益效果是:在第一次模型训练中,构建形成不考虑多模态数据间相互关系的融合检测网络模型,在稀疏编码的基础上,针对不同维度的模态特征张量,取除通道外的特征图尺度进行字典集训练,将字典集对应的字典集损失项纳入模型训练的整体损失函数中,当模型训练完成后,即可得到通道方向上的字典集;在第二次模型训练中,构建形成考虑多模态数据间相互关系的融合检测网络模型,利用得到的字典集计算对应的模态稀疏度,对融合阶段中多模态特征的权重加以校正,当模型训练完成后,即可用该模型进行实时检测识别,在极端场景下,最终的检测识别效果好,可有效避免对交通参与物的漏检或错检;

[0067]

本发明考虑了模态数据间的强弱关系,在极端情况下,即便部分传感器接收的模态数据不佳,无法获取足够多的有用信息,但在进行特征层融合阶段,也不会进行简单叠加,本发明在特征层融合阶段按照分配合理的权重系数进行特征融合,从而有效保证最终感知任务的有效性和鲁棒性;

[0068]

本发明通过合理有效的技术手段将不同模态数据间的强弱关系进行量化,通过稀疏编码集的数学表达来定义不同维度模态数据的模态稀疏度,进而在进行特征级融合时,加以充分考虑,以便提高最终的3d目标检测识别效果和精度;

[0069]

另外,相较于传统点云识别系统而言,本发明的目标检测系统通过识别检测出二维彩色图像数据中目标的2d关键点,以目标的2d关键点反推出目标的3d关键点,以3d关键点特征进行三维空间点云数据的精准筛选,可以大大节省运算参数和提高3d目标识别准确率。

附图说明

[0070]

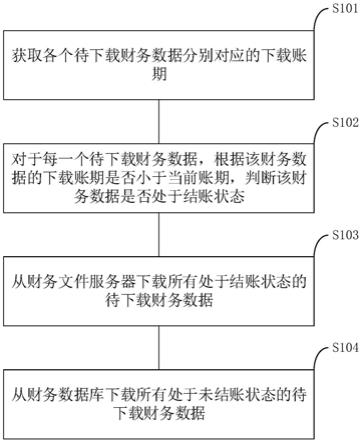

图1为一种适用于模态强弱变化的多模态目标检测系统在第一次模型训练时的连接框图;

[0071]

图2为一种适用于模态强弱变化的多模态目标检测系统在第一次模型训练时整体损失函数的框图;

[0072]

图3为一种适用于模态强弱变化的多模态目标检测方法中第一次模型训练的流程图片;

[0073]

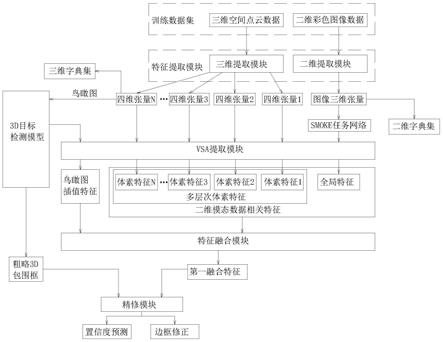

图4为一种适用于模态强弱变化的多模态目标检测系统在第二次模型训练时的连接框图;

[0074]

图5为一种适用于模态强弱变化的多模态目标检测系统在第二次模型训练时整体损失函数的框图;

[0075]

图6为一种适用于模态强弱变化的多模态目标检测方法中第二次模型训练的流程图片。

具体实施方式

[0076]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0077]

实施例:一种适用于模态强弱变化的多模态目标检测方法,包括如下步骤:

[0078]

s1、多模态信息的特征提取:选择大量的训练数据集,训练数据集中包含多种极端场景下的各个同一时空下不同维度的模态数据,针对不同维度的模态数据,利用对应的特征提取模块获得相应的模态特征张量;显然,训练数据集还应当包含一般场景下的模态数据和真值标签,该模态数据可以是由激光雷达获取的三维空间点云数据(如bin文件)、由相机拍摄获得的二维彩色图像数据(如rgb图像文件)等,

[0079]

具体地,所述步骤s1中针对三维空间点云数据进行特征提取的过程为:首先,根据三维空间点云数据,利用体素分区、点云归组、vef特征编码得到点云稀疏张量;接着,通过三维卷积核对点云稀疏张量进行多次三维卷积操作,每次三维卷积操作均得到一个代表对应尺度的四维张量;

[0080]

在本实施例中,三维空间点云数据反映到数学表达,即尺寸为(d,h,w)的张量,d、h、w分别表示了这一个点在空间坐标系中的长宽高。利用体素分区、点云归组、vef特征编码得到尺寸为(c’,d’,h’,w’)的点云稀疏张量,其中c’为三维空间点云数据的维度,d’、h’、w’分别为设置的体素块的长宽高。由于针对每个点进行分析计算的计算量过大,因此,采用体素法将三维空间点云划分为一个个大小相等的体素块形式,从而减少计算量。接着,使用三维卷积核对点云稀疏张量(c’,d’,h’,w’)进行卷积,与2d卷积的主要区别在于,三维卷积核滑动的空间维度可以很好的对3d空间中的对象特征进行提取,在本实施例中,经过三次卷积,可以得到代表不同尺度的三个四维张量。

[0081]

所述步骤s1中针对二维彩色图像数据进行特征提取的过程为:通过3*3的卷积核对二维彩色图像数据对应的图像张量进行多次卷积操作,将每次卷积操作的结果构建成一

个类树状结构,将当前卷积操作结果的输出作为之后某次卷积操作的输入,构建跳跃链接,最终得到图像三维张量。

[0082]

在本实施例中,二维彩色图像数据反映到数学表达,即尺寸为(h,w,3)的张量,h、w、3分别表示了这张图像的高、宽以及rgb三个通道。利用3*3的卷积核对二维彩色图像数据进行多次卷积操作,并将每次的结果构建成一个类树状结构。将当前卷积结果的输出作为之后某次卷积的输入,构建跳跃链接,可以更好地聚集网络的深度与宽度,最终得到了尺寸为(h/4,w/4,256)的图像三维张量。

[0083]

具体地,所述的三维空间点云数据的极端场景包括强光场景、烟雾场景、下雨场景或/和下雪场景等;

[0084]

所述的二维彩色图像数据的极端场景包括雨夜场景、雪夜场景、白天下雨场景或/和白天下雪场景等。

[0085]

s2、第一次模型训练:在稀疏编码的基础上,针对步骤s1中获得的不同维度的模态特征张量,取除通道外的模态特征张量的特征图尺度进行字典集训练,将字典集对应的字典集损失项纳入模型训练时的整体损失函数中,构建形成不考虑多模态数据间相互关系的第一融合检测网络模型,然后,对第一融合检测网络模型进行训练,第一融合检测网络模型训练完成后,即可同时得到不同维度模态数据对应的完善的字典集;

[0086]

具体地,所述步骤s2中第一融合检测网络模型包括3d目标检测模型、smoke任务网络、vsa提取模块、特征融合模块、精修模块和整体损失函数,第一次模型训练的具体步骤为:

[0087]

s21、定义字典集和构建字典集损失项:在得到不同维度的模态特征张量后,依据稀疏编码定义,针对不同维度的模态特征张量分别定义对应的字典集,依据对应模态特征张量的通道数,进行取均值,构建对应的字典集损失项;

[0088]

具体地,所述的字典集包括用于与三维空间点云数据对应的三维字典集以及用于与二维彩色图像数据对应的二维字典集;字典集损失项也包括三维字典集损失项和二维字典集损失项。

[0089]

在本实施例中,以图像三维张量为例,在得到(h/4,w/4,256)的图像三维张量后,依据稀疏编码定义,可以定义一组256二维字典集(h/4,w/4,256),其中,256通道中的一个通道输入y=(h/4,w/4)在对应字典集d=(h/4,k)下的系数矩阵x表示为(k,w/4),误差矩阵为r=y-dx,则最终的迭代训练目标为使得利用该字典集和对应系数张量还原的模态输入误差尽可能小,且系数矩阵尽可能稀疏,即尽可能的充分表示。依据图像三维张量的通道数,进行取均值,构建对应的二维字典集损失项;采用上述相同的原理,可以定义三维字典集,并构建对应的三维字典集损失项。

[0090]

s22、构建前景点损失项以及3d包围框损失项:根据3d目标检测模型输出得到的粗略的3d包围框和训练数据集中的真值标签,计算得出前景点损失项和3d包围框损失项;

[0091]

s23、构建关键点损失项:根据smoke任务网络得到的目标的2d关键点和所属种类,得到关键点损失项;

[0092]

s24、构建置信度损失项与修正损失项:根据精修模块得到的置信度预测结果和边框修正参数,得到置信度损失项与修正损失项;

[0093]

s25、构建形成不考虑多模态数据间相互关系的第一融合检测网络模型:第一融合

检测网络模型的整体损失函数包括前景点损失项、3d包围框损失项、关键点损失项、置信度损失项、修正损失项和字典集损失项;

[0094]

s26、进行第一融合检测网络模型的训练:利用步骤s1提取获得的模态特征张量对第一融合检测网络模型进行训练,当整体损失函数达到最小时,第一融合检测网络模型训练完成;同时,字典集也训练完成,得到不同维度模态数据对应的完善的字典集。

[0095]

在本实施例中,所述步骤s26中第一融合检测网络模型的具体训练过程为:

[0096]

s261、3d目标初步识别阶段:3d目标检测模型取步骤s1中最终输出的三维空间点云数据对应的四维张量,将该四维张量的投影鸟瞰图作为点云鸟瞰图张量,点云鸟瞰图张量尺寸为(h’,w’,128),利用3d目标检测模型的分类分支确定点云鸟瞰图张量中目标的前景点,再利用3d目标检测模型的回归分支回归目标的2d鸟瞰图边框,随后,忽略z轴向点云空间投影,得到粗略的3d包围框,将三维空间点云数据分割为目标的前景与背景;

[0097]

s262、确定3d中心点阶段:根据步骤s1中二维彩色图像数据对应的图像三维张量,利用smoke任务网络的关键点分支,输出得到在二维彩色图像数据中目标的2d关键点,结合相机内参,反推出目标的3d关键点,假设相机内参是k,2d关键点与3d关键点的映射公式为:

[0098][0099]

在三维空间点云数据中,按欧式距离法查找与3d关键点最贴近的点,将该点作为目标的3d中心点;

[0100]

s263、vsa提取阶段:利用vsa模块分别将步骤s1中点云稀疏张量和每次三维卷积操作得到的四维张量汇聚到3d中心点上,得到每个目标的3d中心点领域集,再通过一次max池化操作,得到3d中心点对应的体素特征f

i(pvk)

,

[0101]

其中,表示某体素块的c’维特征向量,pi为预测的3d中心点,为该体素特征中某个体素块的坐标;

[0102]

然后,结合所有的体素特征f

i(pvk)

,得到3d中心点的多层次体素特征f

i(pv)

,f

i(pv)

=[f

i(pv1)

,f

i(pv2)

,f

i(pv3)

,f

i(pv4)

],for i=1,...,n;

[0103]

利用3d中心点对初始的三维空间点云数据进行vsa操作,得到全局特征f

i(raw)

,结合全局特征f

i(raw)

和多层次体素特征f

i(pv)

,得到二维模态数据相关特征f

i(rgb)

=[f

i(raw)

,f

i(pv)

];

[0104]

再将3d中心点投影至点云鸟瞰图上,并进行二项插值,得到鸟瞰图插值特征f

i(bev)

,鸟瞰图插值特征与点云体素法关键点相关较密切;

[0105]

s264、第一次特征融合阶段:特征融合模块对二维模态数据相关特征和鸟瞰图插值特征进行add操作,实现简单拼接,得到第一融合特征;

[0106]

s265、精修阶段:将第一融合特征和粗略的3d包围框输入精修模块,在粗略的3d包围框中进行统一采样6

×6×

6个网格点,再设置可变半径,去聚合附近中心点的最终特征,以此规则化作为网格点的特征,通过多层感知机,再通过max池化,生成每个粗略的3d包围框对应的特征f

i(g)

,最后通过两层mlp网络,得到256维的特征向量,即得到置信度预测结果

和边框修正参数;

[0107]

s266、字典集训练完成阶段:重复步骤s261~s265,直至整体损失函数达到最小,第一融合检测网络模型训练完成,同时,字典集也训练完成,得到不同维度模态数据对应的完善的字典集。

[0108]

s3、第二次模型训练:利用得到的完善的字典集,计算不同维度模态数据对应的模态稀疏度,由模态稀疏度计算得出叠加系数分配比例,构建形成考虑多模态数据间相互关系的第二融合检测网络模型,然后,对第二融合检测网络模型进行训练,在训练过程的特征融合阶段,根据叠加系数分配比例,对待融合的相关特征的权重加以校正,直至第二融合检测网络模型训练完成;

[0109]

具体地,所述步骤s3中第二融合检测网络模型包括完善的字典集、3d目标检测模型、smoke任务网络、vsa提取模块、特征融合模块、softmax函数、精修模块和整体损失函数,第二次模型训练的具体步骤为:

[0110]

s31、利用得到的完善的字典集,计算不同维度模态数据对应的模态稀疏度,将不同维度模态数据对应的模态稀疏度组成一个向量,利用softmax函数将该向量映射到[0,1]空间,且和为1,得到不同维度模态数据对应的叠加系数分配比例;

[0111]

每个模态数据在经过步骤s2的训练后,都得到了属于自己的完善的字典集,之后提取的数据都可以利用对应的字典集和相应的系数矩阵来进行还原,虽然不是100%还原,但可以粗略体现该模态数据相对于第一阶段完备信息的充分程度。

[0112]

在本实施中,以二维字典集(h/4,w/4,256)为例,稀疏度的数学表达式即为系数矩阵(k,w/4)的f范数平方-矩阵元素绝对值的平方和与矩阵最大元素平方*k*w’的比值。

[0113]

由于不同维度的模态数据的特征张量通道数不同,因此,字典集的层数也不同,取其均值作为该模态特征张量输入信息的稀疏度。

[0114]

s32、构建前景点损失项以及3d包围框损失项:与步骤s22相同;

[0115]

s33、构建关键点损失项:与步骤s23相同;

[0116]

s34、构建置信度损失项与修正损失项:与步骤s24相同;

[0117]

s35、构建形成考虑多模态数据间相互关系的第二融合检测网络模型:第二融合检测网络模型的整体损失函数包括前景点损失项、3d包围框损失项、关键点损失项、置信度损失项和修正损失项;

[0118]

s36、进行第二融合检测网络模型的训练:利用步骤s1提取获得的模态特征张量对第二融合检测网络模型进行训练,当整体损失函数达到最小时,第二融合检测网络模型训练完成。

[0119]

在本实施中,所述步骤s36中第二融合检测网络模型的具体训练过程为:

[0120]

s361、3d目标初步识别阶段:与步骤s261相同;

[0121]

s362、确定3d中心点阶段:与步骤s262相同;

[0122]

s363、vsa提取阶段:与步骤263相同;

[0123]

s364、第二次特征融合阶段:特征融合模块根据叠加系数分配比例,对二维模态数据相关特征和鸟瞰图插值特征进行融合拼接,得到第二融合特征;

[0124]

s365、精修阶段:将第二融合特征和粗略的3d包围框输入精修模块,精修模块运算得到置信度预测结果和边框修正参数;

[0125]

s366、第二融合检测网络模型训练完成阶段:重复步骤s361~s365,直至整体损失函数达到最小,第二融合检测网络模型训练完成。

[0126]

s4、检测应用:将实际驾驶场景中同一时空下不同维度的模态数据进行步骤s1的特征提取操作,得到相应的实时模态特征张量,将实时模态特征张量输入训练完成的第二融合检测网络模型,对交通参与物进行预测,第二融合检测网络模型输出得到最终的目标检测效果。

[0127]

具体地,所述步骤s4中检测应用的具体过程为:

[0128]

s41、将实际驾驶场景中同一时空下不同维度的模态数据进行步骤s1的特征提取操作,得到相应的实时模态特征张量,将实时模态特征张量输入第二融合检测网络模型;

[0129]

s42、第二融合检测网络模型对交通参与物进行预测,由3d目标检测模型输出得到粗略的3d包围框,由精修模块输出得到置信度预测结果和边框修正参数;

[0130]

s43、综合粗略的3d包围框、置信度预测结果和边框修正参数这三个输出信息,将交通参与物用一个新的3d包围框将检测到的目标标识出来,并得到目标所属种类的概率,即为3d目标检测的结果。

[0131]

一种适用于模态强弱变化的多模态目标检测系统,包括:大量充分的训练数据集,训练数据集中包含多种极端场景下的各个同一时空下不同维度的模态数据;

[0132]

特征提取模块,用于对训练数据集中不同维度的模态数据进行特征提取,获得相应的模态特征张量;

[0133]

字典集,在稀疏编码的基础上,针对获得的不同维度的模态特征张量,取除通道外的特征图尺度进行字典集训练,第一融合检测网络模型训练完成后,得到不同维度模态数据对应的完善的字典集,通过完善的字典集计算不同维度模态数据对应的模态稀疏度;

[0134]

smoke任务网络,根据二维彩色图像数据对应的图像三维张量,利用smoke任务网络的关键点分支,输出得到在二维彩色图像数据中目标的2d关键点,结合相机内参,反推出目标的3d关键点;在三维空间点云数据中,按欧式距离法查找与3d关键点最贴近的点,将该点作为目标的3d中心点;

[0135]

vsa提取模块,对特征提取过程中每次三维卷积操作得到的模态特征张量进行vsa操作,得到结合3d中心点的多层次体素特征;

[0136]

利用3d中心点对初始的三维空间点云数据进行vsa操作,得到全局特征;

[0137]

将3d中心点投影至点云鸟瞰图上,并进行二项插值,得到鸟瞰图插值特征;

[0138]

结合全局特征和多层次体素特征,得到二维模态数据相关特征;

[0139]

特征融合模块,在进行第一融合检测网络模型训练过程中,用于对二维模态数据相关特征和鸟瞰图插值特征进行add操作,实现简单拼接,得到第一融合特征;

[0140]

在进行第二融合检测网络模型训练过程中,特征融合模块根据叠加系数分配比例,对二维模态数据相关特征和鸟瞰图插值特征进行融合拼接,得到第二融合特征;

[0141]

3d目标检测模型,取特征提取模块最终输出的三维空间点云数据对应的模态特征张量,将该模态特征张量的投影鸟瞰图作为点云鸟瞰图张量,输入3d目标检测模型,得到粗略的3d包围框;

[0142]

精修模块,用于结合融合特征(第一融合特征或第二融合特征)和粗略的3d包围框,输出得到修正特征向量,修正特征向量用于置信度的预测和粗略的3d包围框的修正;

[0143]

整体损失函数,用于估量融合检测网络模型的预测值与真实值的不一致程度,当整体损失函数达到最小时,融合检测网络模型训练完成;

[0144]

在进行第一融合检测网络模型训练过程中,整体损失函数包括前景点损失项、3d包围框损失项、关键点损失项、置信度损失项、修正损失项、二维字典集损失项和三维字典集损失项;

[0145]

在进行第二融合检测网络模型训练过程中,整体损失函数包括前景点损失项、3d包围框损失项、关键点损失项、置信度损失项和修正损失项;

[0146]

softmax函数,在进行第二融合检测网络模型训练过程中,将不同维度模态数据对应的模态稀疏度组成一个向量,利用softmax函数将该向量映射到[0,1]空间,且和为1,得到不同维度模态数据对应的叠加系数分配比例。

[0147]

本发明考虑了模态数据间的强弱关系,在极端情况下,即便部分传感器接收的模态数据不佳,无法获取足够多的有用信息,但在进行特征层融合阶段,也不会进行简单叠加,本发明在特征层融合阶段按照分配合理的权重系数进行特征融合,从而有效保证最终感知任务的有效性和鲁棒性;

[0148]

本发明通过合理有效的技术手段将不同模态数据间的强弱关系进行量化,通过稀疏编码集的数学表达来定义不同维度模态数据的模态稀疏度,进而在进行特征级融合时,加以充分考虑,以便提高最终的3d目标检测识别效果和精度;

[0149]

另外,相较于传统点云识别系统而言,本发明的目标检测系统通过识别检测出二维彩色图像数据中目标的2d关键点,以目标的2d关键点反推出目标的3d关键点,以3d关键点特征进行三维空间点云数据的精准筛选,可以大大节省运算参数和提高3d目标识别准确率。

[0150]

在本发明中,术语如“上”、“下”、“左”、“右”、“前”、“后”、“竖直”、“水平”、“侧”、“底”等指示的方位或/和位置关系为基于附图所示的方位或/和位置关系,只是为了便于叙述本发明各部件或/和元件结构关系而确定的关系词,并非特指本发明中任一部件或/和元件,不能理解为对本发明的限制。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。