1.本发明涉及自然语言处理领域,特别涉及一种降低语义识别计算量的方法、系统及存储介质。

背景技术:

2.近年来,预训练模型成为了自然语言处理(nlp)领域的新范式。预训练模型是一种迁移学习的应用,通过自监督学习从大规模数据中训练得到与具体任务无关的预训练模型,利用几乎无限的文本,学习输入句子的每一个词语单元的上下文相关的表示,从而隐式地学习通用的语法语义知识,并可通过微调的方式用在任何的下游任务上。

3.语言建模的核心是从大规模数据中自动捕获知识。知识分为显性知识和隐性知识。显性知识是能用文字和数字表达出来的,容易以硬数据的形式交流和共享,并且经编辑整理的程序或者普遍原则。隐性知识是高度个性而且难于格式化的知识,包括主观的理解、直觉和预感。传统nlp研究常常采用语言标注信息作为显性知识来增强语言表示,进而更好地在模型隐层中挖掘隐性知识,如向词嵌入表示(word embedding)中融合词性标注(pos)和命名实体(ner)的标注信息。在预训练模型时代,已有研究表明预训练模型依然处于欠拟合状态,有效地引入人类先验知识或常识有助于提升模型的语言理解和推理能力。

4.现有的一些方案通过语言学相关的任务来引导模型学习人类语言结构,包括语言表示层面和注意力架构层面。具体而言,前者将标注的词性标签、实体标签或语言角色标签等语言学信息通过词嵌入的方式融合到词语表示中,作为语言学标签的增强;后者通过句法结构解析,得到词和词之间的关系,构建关系矩阵,融合到注意力机制的权重里面。这两类方法均需要对模型架构进行修改,导致模型的计算量过大的问题。

技术实现要素:

5.为解决现有模型的计算量过大的问题,本发明提供了一种降低语义识别计算量的方法、系统及存储介质。

6.本发明解决技术问题的方案是提供一种降低语义识别计算量的方法,包括以下步骤:获取预训练模型;对预训练模型增加语言学训练目标成为最终训练模型;将待识别文本输入最终训练模型;输出待识别文本语义。

7.优选地,所述获取预训练模型的具体步骤包括:获取训练句子样本w,设立第一训练目标;将训练句子样本w拆分成子词序列,对训练句子样本w的子词序列进行随机覆盖以生成拓展句子样本w’;将所述拓展句子样本w’输入语言模型,得到编码后的上下文表示h,并通过第一训

练目标训练模型获得预训练模型。

8.优选地,对预训练模型增加语言学训练目标成为最终训练模型的具体步骤包括:将训练句子样本w标注词性和实体标签,并给预训练模型增加相应的语言学训练目标,即第二训练目标,将第一训练目标与第二训练目标结合对模型进行增强训练,获得最终训练模型。

9.优选地,所述第一训练目标为解析被覆盖的词语是什么,第二训练目标为让模型根据句子的上下文的表示h,预测相应的词性标签和实体标签概率。

10.优选地,通过自然语言处理工具对训练句子样本w进行词性标签和实体标签的标注。

11.优选地,所述第一训练目标设置为;所述第二训练目标设置为;,所述最终训练模型的训练目标设置为,其中为预训练模型的损失函数,与为词性标签和实体标签的预测损失函数,为第k个输入的句子,为拓展句子样本,为第i个词性标签,为第i个实体标签,和为预测其对应的语言学标签的概率。

12.优选地,通过损失函数作为训练目标,损失函数设置为交叉熵损失函数。

13.优选地,切分子词序列时记录每个词所切分后的子词元素及与其对应的词性标签和实体标签。

14.本发明为解决上述技术问题还提供一种降低语义识别计算量的系统,其特征在于:包括:训练模块,用于获取预训练模型,并对预训练模型增加语言学训练目标成为最终训练模型;输入模块,用于将待识别文本输入最终训练模型;输出模块,用于输出待识别文本语义。

15.本发明为解决上述技术问题还提供一种储存介质,包括计算机程序,该计算机程序被处理器执行时实现上述方法的步骤。

16.与现有技术相比,本发明的一种降低语义识别计算量的方法、系统及存储介质,具有以下优点:1、本发明的降低语义识别计算量的方法先获取预训练模型;对预训练模型增加语言学训练目标成为最终训练模型;将待识别文本输入最终训练模型;输出待识别文本语义。通过增加语言学训练目标的设计,使得无需改变模型的结构就能提升训练的精确性和模型的鲁棒性,同时还降低了模型的复杂程度,降低了模型的计算量,解决了现有技术模型的计算量过大的问题。

17.2、本发明的降低语义识别计算量的方法的获取预训练模型的具体步骤包括:获取训练句子样本w,设立第一训练目标,将训练句子样本w拆分成子词序列,对训练句子样本w的子词序列进行随机覆盖以生成拓展句子样本w’,将所述拓展句子样本w’输入语言模型,得到编码后的上下文表示h,并通过第一训练目标训练模型获得预训练模型。通过覆盖子词序列来训练模型,使得模型初步获得还原语义的能力。

18.3、本发明的降低语义识别计算量的方法对预训练模型增加语言学训练目标成为

最终训练模型的具体步骤包括:将训练句子样本w标注词性标签和实体标签,并给预训练模型增加相应的语言学训练目标即第二训练目标,将第一训练目标与第二训练目标结合对模型进行增强训练,获得最终训练模型。通过给训练模型增加第二训练目标的设计,使得不需要改变模型本身结构即可提升训练模型的准确性,从而降低了模型的计算量。

19.4、本发明的降低语义识别计算量的方法的第一训练目标为解析被覆盖的子词序列,第二训练目标为让模型根据句子的上下文的表示h,预测相应的词性标签和实体标签概率。通过在解析被覆盖的子词序列的基础上,再增加分析词性、实体标签等训练目标,从而使得同等资源的情况下训练出来的模型的精确性更高。

20.5、本发明的降低语义识别计算量的方法通过自然语言处理工具对训练句子样本w进行词性标签和实体标签的标注。对训练句子样本w进行词性标签和实体标签的标注,再通过训练模型解析被遮盖的子词序列词性标签和实体标签,使得模型获得更多的功能性。

21.6、本发明的降低语义识别计算量的方法的第一训练目标设置为;第二训练目标设置为;,最终训练模型的训练目标设置为,其中为预训练模型的损失函数,与为词性标签和实体标签的预测损失函数,为第k个输入的句子,为拓展句子样本,为第i个词性标签,为第i个实体标签,和为预测其对应的语言学标签的概率。通过增加第二训练目标,并将第二训练目标与第一训练目标结合作为最终训练模型的训练目标,可以使得训练模型在不更改其本身架构的前提下,获得额外的准确性和鲁棒性。

22.7、本发明的降低语义识别计算量的方法通过损失函数作为训练目标,损失函数设置为交叉熵损失函数。使用交叉熵损失函数作为损失函数,求导更简单,同时可以使模型训练的更快。

23.8、本发明的降低语义识别计算量的方法切分子词序列时记录每个词所切分后的子词元素及与其对应的词性标签和实体标签。在切分时记录子词元素及与其对应的词性标签和实体标签,在训练时即可将对应的子词元素打上标签,来判断训练的准确与否。

24.9、本发明还提供了一种降低语义识别计算量的系统,包括:训练模块,用于获取预训练模型,并对预训练模型增加语言学训练目标成为最终训练模型;输入模块,用于将待识别文本输入最终训练模型;输出模块,用于输出待识别文本语义。具有与上述方法相同的有益效果,此处不再赘述。

25.10、本发明还提供一种储存介质,包括计算机程序,该计算机程序被处理器执行时实现上述方法的步骤。具有与上述方法相同的有益效果,此处不再赘述。

26.【附图说明】为了更清楚地说明本发明实施例中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

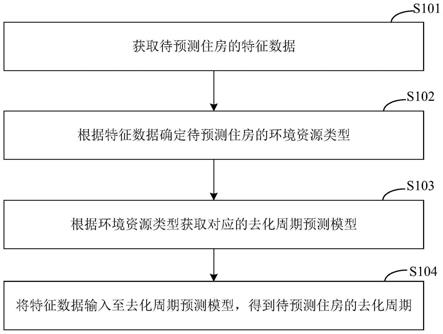

27.图1是本发明第一实施例提供的降低语义识别计算量的方法的步骤流程图。

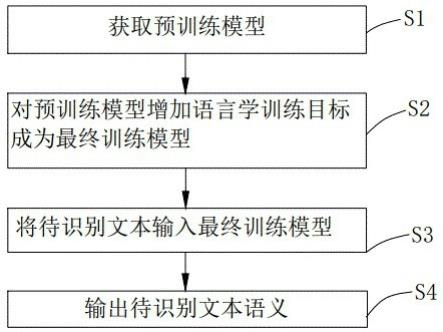

28.图2是本发明第一实施例提供的降低语义识别计算量的方法的详细步骤流程图

一。

29.图3是本发明第一实施例提供的降低语义识别计算量的方法的详细步骤流程图二。

30.图4是本发明第一实施例提供的示例的效果对比图。

31.图5是本发明第二实施例提供的降低语义识别计算量的系统的框图。

32.附图标识说明:300、降低语义识别计算量的系统;301、训练模块; 302、输入模块; 303、输出模块。

33.【具体实施方式】为了使本发明的目的,技术方案及优点更加清楚明白,以下结合附图及实施实例,对本发明进行进一步详细说明。应当理解,此处所描述的具体实施例仅仅用以解释本发明,并不用于限定本发明。

34.在本发明所提供的实施例中,应理解,“与a对应的b”表示b与a相关联,根据a可以确定b。但还应理解,根据a确定b并不意味着仅仅根据a确定b,还可以根据a和/或其他信息确定b。

35.应理解,说明书通篇中提到的“一个实施例”或“一实施例”意味着与实施例有关的特定特征、结构或特性包括在本发明的至少一个实施例中。因此,在整个说明书各处出现的“在一个实施例中”或“在一实施例中”未必一定指相同的实施例。此外,这些特定特征、结构或特性可以以任意适合的方式结合在一个或多个实施例中。本领域技术人员也应该知悉,说明书中所描述的实施例均属于可选实施例,所涉及的动作和模块并不一定是本发明所必须的。

36.在本发明的各种实施例中,应理解,上述各过程的序号的大小并不意味着执行顺序的必然先后,各过程的执行顺序应以其功能和内在逻辑确定,而不应对本发明实施例的实施过程构成任何限定。

37.在本发明的附图中的流程图和框图,图示了按照本技术各种实施例的系统、方法和计算机程序产品的可能实现的体系架构、功能和操作。在这点上,流程图或框图中的每个方框可以代表一个模块、程序段、或代码的一部分,该模块、程序段、或代码的一部分包含一个或多个用于实现规定的逻辑功能的可执行指令。也应当注意,在有些作为替换的实现方案中,方框中所标注的功能也可以不同于附图中所标注的顺序发生。例如,两个接连地表示的方框实际上可以基本并行地执行,它们有时也可以按相反的顺序执行,在此基于涉及的功能而确定。需要特别注意的是,框图和/或流程图中的每个方框、以及框图和/或流程图中的方框的组合,可以用执行规定的功能或操作的专用的基于硬件的系统来实现,或者可以用专用硬件与计算机指令的组合来实现。

38.请参阅图1,本发明第一实施例提供一种降低语义识别计算量的方法,包括以下步骤:s1:获取预训练模型;s2:对预训练模型增加语言学训练目标成为最终训练模型;s3:将待识别文本输入最终训练模型;s4:输出待识别文本语义。

39.通过增加语言学训练目标的设计,使得无需改变模型的结构就能提升训练的精确性和模型的鲁棒性,同时还降低了模型的复杂程度,降低了模型的计算量,解决了现有技术模型的计算量过大的问题。

40.进一步地,请参阅图2,获取预训练模型的具体步骤包括:s101:获取训练句子样本w,设立第一训练目标;s102:将训练句子样本w拆分成子词序列,对训练句子样本w的子词序列进行随机覆盖以生成拓展句子样本w’;s103:将所述拓展句子样本w’输入语言模型,得到编码后的上下文表示h,并通过第一训练目标训练模型获得预训练模型。

41.通过覆盖子词序列来训练模型,使得模型初步获得还原语义的能力。

42.进一步地,请参阅图3,对预训练模型增加语言学训练目标成为最终训练模型的具体步骤包括:s201:将训练句子样本w标注词性标签和实体标签,并给预训练模型增加相应的语言学训练目标即第二训练目标,将第一训练目标与第二训练目标结合对模型进行增强训练,获得最终训练模型。

43.通过给训练模型增加第二训练目标的设计,使得不需要改变模型本身结构即可提升训练模型的准确性,从而降低了模型的计算量。

44.具体地,第一训练目标为解析被覆盖的子词序列,第二训练目标为让模型根据句子的上下文的表示h,预测相应的词性标签和实体标签概率。通过在解析被覆盖的子词序列的基础上,再增加分析词性、实体标签等训练目标,从而使得同等资源的情况下训练出来的模型的精确性更高。

45.进一步地,本发明的降低语义识别计算量的方法通过自然语言处理工具对训练句子样本w进行词性标签和实体标签的标注。对训练句子样本w进行词性标签和实体标签的标注,再通过训练模型解析被遮盖的子词序列词性标签和实体标签,使得模型获得更多的功能性。

46.具体地,第一训练目标设置为;第二训练目标设置为;,最终训练模型的训练目标设置为,其中为预训练模型的损失函数,与为词性标签和实体标签的预测损失函数,为第k个输入的句子,为拓展句子样本,为第i个词性标签,为第i个实体标签,和为预测其对应的语言学标签的概率。

47.通过增加第二训练目标,并将第二训练目标与第一训练目标结合作为最终训练模型的训练目标,可以使得训练模型在不更改其本身架构的前提下,获得额外的准确性和鲁棒性。具体地,本发明的降低语义识别计算量的方法通过损失函数作为训练目标,损失函数设置为交叉熵损失函数。使用交叉熵损失函数作为损失函数,求导更简单,同时可以使模型训练的更快。

48.进一步地,本发明的降低语义识别计算量的方法切分子词序列时记录每个词所切

分后的子词元素及与其对应的词性标签和实体标签。在切分时记录子词元素及与其对应的词性标签和实体标签,在训练时即可将对应的子词元素打上标签,来判断训练的准确与否。

49.示例地,我们将roberta-wwm-ext模型作为基准模型,即预训练模型,用spacy工具得到输入的训练句子w的每个词所对应的词性标签和实体标签,分别记为p={t1,t2,

…

,tn}和e={e1,e2,

…

,en}进而得到相应的词性标签和实体标签序列。由于语言模型采用子词序列作为输入,在切分时记录每个词所切分后的子词元素。对于知识标注序列(词性标签和实体标签序列),将文本序列中的每个子词对应原始词所对应的标签序列,进而得到子词级别的标签序列。

50.为实现知识辅助预训练,根据语言模型编码后的文本隐层表示,预测每个词所对应的知识标签概率,与目标标签计算交叉熵损失。

51.在模型输出端,增加相应的语言学训练目标,即让模型根据句子的上下文的表示h,预测相应的词性标签和实体标签概率,记为和。

52.;,结合语言学增强的训练目标联合训练,记为。

53.将roberta-wwm-ext模型与加入语言学训练目标的模型对比。在chinese wikipedia, chinese news和common crawl等语料上预训练后,将训好的语言模型在中文clue评测平台的9个数据集上(开发集)验证性能。对比结果如图4所示,图4展示了知识增强模型与基准模型的性能对比,可见知识增强后的模型表现出了显著的性能提升。

54.示例性地,原始输入句子:thank you for inviting meto your party last week语言模型在预处理过程中采用特殊标记[mask]随机替换句子中的词语:thank you for [mask][mask] to your [mask] last week语言模型的训练目标为还原出[mask]标记所遮盖的词,常规模型的输出如下所示:{inviting, us, home} 对应3个[mask]标记所遮盖的内容即thank you for invitingus to your home last week由于语言模型的训练方式为交叉熵,即判断每个词与目标词是否完全匹配。由此可见,us和home都会被判断为错误预测。

[0055]

实际上,语言表达具有多样性,该模型预测结果回填到句子后,新的句子为符合语言表达逻辑的、与原始句子语义近似的规范句子,应判断为正确的预测。

[0056]

因此,本发明采用计算句子语义距离的方式,来衡量语义变化,即预测的句子语义与原始句子语义相似时,损失应越小,从而缓解以上问题。

[0057]

请参阅图5,本发明第二实施例提供了一种降低语义识别计算量的系统300,包括:训练模块301,用于获取预训练模型,并对预训练模型增加语言学训练目标成为最终训练模型;

输入模块302,用于将待识别文本输入最终训练模型;输出模块303,用于输出待识别文本语义。

[0058]

本发明第三实施例提供一种储存介质,包括计算机程序,该计算机程序被处理器执行时实现上述方法的步骤。具有与上述方法相同的有益效果,此处不再赘述。

[0059]

与现有技术相比,本发明的一种降低语义识别计算量的方法、系统及存储介质,具有以下优点:1、本发明的降低语义识别计算量的方法先获取预训练模型;对预训练模型增加语言学训练目标成为最终训练模型;将待识别文本输入最终训练模型;输出待识别文本语义。通过增加语言学训练目标的设计,使得无需改变模型的结构就能提升训练的精确性和模型的鲁棒性,同时还降低了模型的复杂程度,降低了模型的计算量,解决了现有技术模型的计算量过大的问题。

[0060]

2、本发明的降低语义识别计算量的方法的获取预训练模型的具体步骤包括:获取训练句子样本w,设立第一训练目标,将训练句子样本w拆分成子词序列,对训练句子样本w的子词序列进行随机覆盖以生成拓展句子样本w’,将所述拓展句子样本w’输入语言模型,得到编码后的上下文表示h,并通过第一训练目标训练模型获得预训练模型。通过覆盖子词序列来训练模型,使得模型初步获得还原语义的能力。

[0061]

3、本发明的降低语义识别计算量的方法对预训练模型增加语言学训练目标成为最终训练模型的具体步骤包括:将训练句子样本w标注词性标签和实体标签,并给预训练模型增加相应的语言学训练目标,即第二训练目标,将第一训练目标与第二训练目标结合对模型进行增强训练,获得最终训练模型。通过给训练模型增加第二训练目标的设计,使得不需要改变模型本身结构即可提升训练模型的准确性,从而降低了模型的计算量。

[0062]

4、本发明的降低语义识别计算量的方法的第一训练目标为解析被覆盖的子词序列,第二训练目标为让模型根据句子的上下文的表示h,预测相应的词性标签和实体标签概率。通过在解析被覆盖的子词序列的基础上,再增加分析词性、实体标签等训练目标,从而使得同等资源的情况下训练出来的模型的精确性更高。

[0063]

5、本发明的降低语义识别计算量的方法通过自然语言处理工具对训练句子样本w进行词性标签和实体标签的标注。对训练句子样本w进行词性标签和实体标签的标注,再通过训练模型解析被遮盖的子词序列词性标签和实体标签,使得模型获得更多的功能性。

[0064]

6、本发明的降低语义识别计算量的方法的第一训练目标设置为;第二训练目标设置为;,最终训练模型的训练目标设置为,其中为预训练模型的损失函数,与为词性标签和实体标签的预测损失函数,为第k个输入的句子,为拓展句子样本,为第i个词性标签,为第i个实体标签,和为预测其对应的语言学标签的概率。通过增加第二训练目标,并将第二训练目标与第一训练目标结合作为最终训练模型的训练目标,可以使得训练模型在不更改其本身架构的前提下,获得额外的准确性和鲁棒性。

[0065]

7、本发明的降低语义识别计算量的方法通过损失函数作为训练目标,损失函数设置为交叉熵损失函数。使用交叉熵损失函数作为损失函数,求导更简单,同时可以使模型训练的更快。

[0066]

8、本发明的降低语义识别计算量的方法切分子词序列时记录每个词所切分后的子词元素及与其对应的词性标签和实体标签。在切分时记录子词元素及与其对应的词性标签和实体标签,在训练时即可将对应的子词元素打上标签,来判断训练的准确与否。

[0067]

9、本发明还提供了一种降低语义识别计算量的系统,包括:训练模块,用于获取预训练模型,并对预训练模型增加语言学训练目标成为最终训练模型;输入模块,用于将待识别文本输入最终训练模型;输出模块,用于输出待识别文本语义。具有与上述方法相同的有益效果,此处不再赘述。

[0068]

10、本发明还提供一种储存介质,包括计算机程序,该计算机程序被处理器执行时实现上述方法的步骤。具有与上述方法相同的有益效果,此处不再赘述。

[0069]

以上对本发明实施例公开的一种降低语义识别计算量的方法、系统及存储介质进行了详细介绍,本文中应用了具体个例对本发明的原理及实施方式进行了阐述,以上实施例的说明只是用于帮助理解本发明的方法及其核心思想;同时,对于本领域的一般技术人员,依据本发明的思想,在具体实施方式及应用范围上均会有改变之处,综上所述,本说明书内容不应理解为对本发明的限制,凡在本发明的原则之内所作的任何修改,等同替换和改进等均应包含本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。