1.至少一个实施例涉及数据中心液体冷却系统。在至少一个实施例中,实现至少两个液体分配单元(ldu),用于在第一配置中将冷却剂同时供应到至少一个服务器托盘,并且用于在第二配置中替换所述至少两个ldu中的第一ldu,其中实现所述至少两个ldu中的第二ldu以将冷却剂供应到所述至少一个服务器托盘。

背景技术:

2.数据中心冷却系统使用风扇来使空气循环通过服务器组件。某些超级计算机或其他高容量计算机可使用水或除空气冷却系统之外的其他冷却系统来将热量从数据中心的服务器组件或机架吸走到数据中心外部的区域。冷却系统可包括数据中心区域(包括数据中心外部的区域)内的冷却器。数据中心外部的区域可以是包括冷却塔或其他外部热交换器的区域,该冷却塔或其他外部热交换器接收来自数据中心的经加热的冷却剂,并且在经冷却的冷却剂再循环回到数据中心中之前通过强制空气或其他装置将热量散发到环境(或外部冷却介质)。冷却器和冷却塔一起形成冷却设施。

附图说明

3.图1示出了经受在至少一个实施例中描述的改进的示例性数据中心冷却系统;

4.图2示出了根据至少一个实施例的与数据中心液体冷却系统的冗余液体冷却分配单元相关联的服务器级特征;

5.图3示出了根据至少一个实施例的与数据中心液体冷却系统的冗余液体冷却分配单元相关联的机架级特征;

6.图4示出了根据至少一个实施例的与数据中心液体冷却系统的冗余液体冷却分配单元相关联的数据中心级特征;

7.图5示出了根据至少一个实施例的与图2-4的数据中心液体冷却系统相关联的方法;

8.图6示出了根据至少一个实施例的分布式系统;

9.图7示出了根据至少一个实施例的示例性数据中心;

10.图8示出了根据至少一个实施例的客户端-服务器网络;

11.图9示出了根据至少一个实施例的计算机网络;

12.图10a示出了根据至少一个实施例的联网计算机系统;

13.图10b示出了根据至少一个实施例的联网计算机系统;

14.图10c示出了根据至少一个实施例的联网计算机系统;

15.图11示出了根据至少一个实施例的系统环境的一个或更多个组件,在该系统环境中,服务可被提供为第三方网络服务;

16.图12示出了根据至少一个实施例的云计算环境;

17.图13示出了根据至少一个实施例的由云计算环境提供的一组功能抽象层;

18.图14示出了根据至少一个实施例的在芯片级的超级计算机;

19.图15示出了根据至少一个实施例的在机架模块级处的超级计算机;

20.图16示出了根据至少一个实施例的在机架级处的超级计算机;

21.图17示出了根据至少一个实施例的在整个系统级的超级计算机;

22.图18a示出了根据至少一个实施例的推理和/或训练逻辑;

23.图18b示出了根据至少一个实施例的推理和/或训练逻辑;

24.图19示出了根据至少一个实施例的神经网络的训练和部署;

25.图20示出了根据至少一个实施例的网络系统的架构;

26.图21示出了根据至少一个实施例的网络系统的架构;

27.图22示出了根据至少一个实施例的控制平面协议栈;

28.图23示出了根据至少一个实施例的用户平面协议栈;

29.图24示出了根据至少一个实施例的核心网的组件;

30.图25示出了根据至少一个实施例的支持网络功能虚拟化(nfv)的系统的组件;

31.图26示出了根据至少一个实施例的处理系统;

32.图27示出了根据至少一个实施例的计算机系统;

33.图28示出了根据至少一个实施例的系统;

34.图29示出了根据至少一个实施例的示例性集成电路;

35.图30示出了根据至少一个实施例的计算系统;

36.图31示出了根据至少一个实施例的apu;

37.图32示出了根据至少一个实施例的cpu;

38.图33示出了根据至少一个实施例的示例性加速器集成切片;

39.图34a-34b示出了根据至少一个实施例的示例性图形处理器;

40.图35a示出了根据至少一个实施例的图形核心;

41.图35b示出了根据至少一个实施例的gpgpu;

42.图36a示出了根据至少一个实施例的并行处理器;

43.图36b示出了根据至少一个实施例的处理集群;

44.图36c示出了根据至少一个实施例的图形多处理器;

45.图37示出了根据至少一个实施例的编程平台的软件栈;

46.图38示出了根据至少一个实施例的图37的软件栈的cuda实现;

47.图39示出了根据至少一个实施例的图37的软件栈的rocm实现;

48.图40示出了根据至少一个实施例的图37的软件栈的opencl实现方式;

49.图41示出了根据至少一个实施例的由编程平台支持的软件;以及

50.图42示出了根据至少一个实施例的用于在图37-40的编程平台上执行的编译代码。

具体实施方式

51.在以下描述中,阐述了许多具体细节以提供对至少一个实施例的更透彻的理解。然而,对于本领域的技术人员将显而易见的是,可以在没有一个或更多个这些具体细节的情况下实践本发明构思。

52.在至少一个实施例中,鉴于由当今计算组件中的变化的计算负载引起的突然的高热需求,高密度服务器的空气冷却可能不是有效的或可能是无效的。在至少一个实施例中,由于需求经历变化或趋于不同的冷却需求的最小值到最大值之间的范围,所以必须使用适当的冷却系统以经济的方式满足这些需求。在至少一个实施例中,为了中等到高的冷却需求,可以使用液体冷却系统。在至少一个实施例中,不同的冷却需求还反映了数据中心的不同的热特征。在至少一个实施例中,从组件、服务器和机架生成的热量被累积地称为热特征或冷却需求,因为冷却需求必须完全解决热特征。在至少一个实施例中,冷却系统的热特征或冷却需求是所生成的热或与冷却系统相关联的组件、服务器或机架的冷却需求,并且可以是数据中心中的组件、服务器和机架的一部分。

53.在至少一个实施例中,公开了一种数据中心液体冷却系统。在至少一个实施例中,数据中心液体冷却系统解决了在能够从关联计算设备或数据中心设备(诸如图形处理单元(gpu)、交换机、双列直插式存储器模块(dimm)或中央处理单元(cpu))移除热量的特征中可能发生的潜在故障。此外,在至少一个实施例中,关联计算设备或数据中心设备可以是在其上具有一个或更多个gpu、交换机或cpu的处理卡。在至少一个实施例中,gpu、交换机和cpu中的每一个可以是计算设备的发热特征。在至少一个实施例中,gpu、cpu或交换机可以具有一个或更多个核心,并且每个核心可以是发热特征。在至少一个实施例中,本公开安装有冗余且可扩展的液体冷却分配单元(ldu),可提高通过冷板去除热量的可靠性。

54.在至少一个实施例中,鲁棒的且可扩展的数据中心液体冷却系统的设计和部署可能需要支持和能力来快速和安全地获得和服务主要的液体冷却组件或特征。在至少一个实施例中,机架歧管具有许多快速连接/断开连接器和液体管线软管。在至少一个实施例中,该机架歧管或其组成特征可以需要现场维修。在至少一个实施例中,这可能导致与机架歧管相关联的机架的停机时间。在至少一个实施例中,这个问题还可能要求立即获得短期内具有相同特征,并传递安全协议以移除安全数据中心中的组件的类似组件。

55.在至少一个实施例中,液体冷却单元(ldu)的现场可更换单元(fru)可以使用关联的支架安装在机架中,这些支架可以旨在用于机架歧管。在至少一个实施例中,fru ldu(也统称为ldu)可以与流量控制器相关联,用于从数据中心冷却分配单元(cdu)向机架中的一个或更多个液体冷却的服务器托盘或箱提供(诸如通过泵送或通过允许)冷却剂。在至少一个实施例中,每个服务器在其服务器歧管或液体管线中的输入/输出液体端口上具有两组。在至少一个实施例中,每个服务器具有代替机架歧管放置的两个fru ldu。在至少一个实施例中,不同于歧管,ldu与至少机架级流量控制器相关联,从而保持或隔离ldu内的冷却剂。在至少一个实施例中,这使得预加载的ldu能够用作对任何安装的ldu的替换。在至少一个实施例中,预加载的ldu具有与在辅助冷却回路中流动并且因此在安装并且经受替换的ldu中流动的相同的包含在其中的冷却剂。在至少一个实施例中,在一个或更多个配置中,fru ldu用于向液体冷却的服务器供应液体。在至少一个实施例中,在并行配置中,每个fru ldu满足一个或更多个冷却剂负载。

56.在至少一个实施例中,冷却剂负载可以由对能够由fru ldu输出的冷却剂施加的冷却需求(或需要)来表示。在至少一个实施例中,冷却剂负载可以由从fru ldu供应的冷却剂的最大流速或流量中的一个或更多个来表示,而不管冷却需求如何。在至少一个实施例中,冷却剂负载可以由从fru ldu供应的冷却剂的最大值来表示,而与冷却需求无关。在至

少一个实施例中,当与另一个fru ldu一起使用时,每个fru ldu可以适于根据为fru ldu设置的一个或更多个配置来供应不同的冷却剂负载。在至少一个实施例中,冷却剂负载可由服务器歧管、冷板和服务器托盘或箱内的冷却回路的关联入口管线和出口管线的最大入口和/或出口容量或能力来表示。在至少一个实施例中,冷却剂负载还可由冷板和服务器歧管的最大容量或能力来表示。在至少一个实施例中,多个最大容量或能力可以一起形成冷却剂负载。在至少一个实施例中,如果冷却剂用于一个服务器托盘,那么托盘中的冷板、其中的冷却回路、以及托盘的服务器歧管均有助于确定托盘的最大容量或能力。

57.在至少一个实施例中,在瓶颈情况下,托盘的最大容量或能力可以由该瓶颈告知,如对该冷却回路的入口管线或该托盘的冷板的限制。在至少一个实施例中,冷却剂负载不仅可以是能够从机架ldu输出的最大冷却剂,而且可以是能够由服务器托盘接收的最大冷却剂输入。在至少一个实施例中,无论能够输出还是能够输入,冷却剂负载表示能够由ldu输出的冷却剂,这是因为ldu能够供应冷却剂向接收侧的输出或者由冷却剂在接收侧的输入限制。

58.在至少一个实施例中,至少两个ldu的至少一个配置实现在至少两个ldu中的第一ldu上的满冷却剂负载,并且在至少两个ldu中的至少第二ldu上的至少一个部分冷却剂负载。在所述至少两个ldu的至少一个其他配置中,在替换所述至少两个ldu中的一个ldu的失败或其他原因的情况下,诸如满冷却剂负载ldu,使部分冷却剂负载ldu从部分冷却剂负载增加,以补偿先前提供满冷却剂负载的其他ldu的替换。在至少一个实施例中,满冷却剂负载ldu可随后与关联的液体管线或关联的服务器歧管断开连接并被替换。在至少一个实施例中,部分冷却剂负载ldu从未被用于全容量,除非其合作的ldu要被替换。在至少一个实施例中,本文的特征至少确保部分冷却剂负载ldu上的较少的磨损和撕裂,使其成为有效的备用或备份ldu。

59.在至少一个实施例中,不同的配置允许替换有缺陷的组件,同时允许来自备用或备份单元的液体被供应到液体冷却的服务器。在至少一个实施例中,备用或备份ldu可能需要被替换,并且这样的替换可在数据中心的发热组件上的工作负载最少的时间期间执行。在至少一个实施例中,这些配置还使得能够在不中断电力或服务的情况下连续操作液体冷却的服务器,同时用可热交换的fru ldu单元进行现场替换。

60.在至少一个实施例中,还可以在另一种配置中使用至少两个ldu,使得在替换至少两个ldu中的一个ldu的故障或其他原因的情况下,部分冷却剂负载ldu可以保持为备用或备份ldu。在至少一个实施例中,部分冷却剂负载ldu可被激活以变成满冷却剂负载ldu。在至少一个实施例中,先前的满冷却剂负载ldu可以被停用,并且从关联的液体管线或关联的服务器歧管断开连接并且被替换。

61.在至少一个实施例中,本公开使fru ldu能够将冷却剂从数据中心冷却分配单元(cdu)泵送或以其他方式使其循环(例如使用控制阀)到关联的液体冷却的服务器。在至少一个实施例中,在机架的冷却剂管线与机架内的服务器之间以冗余配置提供至少两个液体分配单元(ldu)。在至少一个实施例中,这使得能够对机架和服务器之间的冷却剂分配进行额外的控制,并且实现在机架和服务器之间的任何组件需要维修时冷却剂流量的冗余。在至少一个实施例中,虽然可以提供单数个机架歧管来将液体分配到服务器,但当机架歧管需要维护时,机架电子器件和机架管道系统必须被关闭并且必须整个替换。在至少一个实

施例中,本文中的冗余ldu引入在冷却剂管线与服务器或服务器托盘或箱之间的两个或更多个配置中操作的至少两个ldu。在至少一个实施例中,一个或更多个配置可接合两个ldu以供应冷却剂,直到热交换是必需的。在至少一个实施例中,至少两个ldu的配置通过将功能限制到一个ldu而另一个ldu被交换来实现热交换。

62.图1示出了具有冷却系统的示例性数据中心100,该冷却系统经受在至少一个实施例中描述的改进。在至少一个实施例中,数据中心100可以是具有机架110和辅助设备的一个或更多个空间102,用于在一个或更多个服务器托盘上容纳一个或更多个服务器。在至少一个实施例中,数据中心100由位于数据中心100外部的冷却塔104支持。在至少一个实施例中,冷却塔104通过作用于主冷却回路106而从数据中心100内散热。在至少一个实施例中,在主冷却回路106和第二或辅助冷却回路108之间使用冷却分配单元(cdu)112,以使得能够将热量从第二或辅助冷却回路108提取到主冷却回路106。在至少一个实施例中,在一方面,辅助冷却回路108可以根据需要自始至终访问进入服务器托盘中的不同管道。在至少一个实施例中,回路106、108被示出为线图,但普通技术人员将认识到,可以使用一个或更多个管道特征。在至少一个实施例中,柔性聚氯乙烯(pvc)管可以与关联的管道系统一起使用,以便使流体沿着回路106、108中的每一个移动。在至少一个实施例中,可以使用一个或更多个冷却剂泵来维持回路106、108内的压力差,以使得冷却剂能够根据不同位置(包括房间中、一个或更多个机架110中和/或机架110内的服务器箱或服务器托盘中)中的温度传感器移动。

63.在至少一个实施例中,主冷却回路106和辅助冷却回路108中的冷却剂可以至少是水和添加剂,例如乙二醇或丙二醇。在操作中,在至少一个实施例中,主冷却回路和辅助冷却回路中的每一个都具有它们自己的冷却剂。在至少一个实施例中,辅助冷却回路中的冷却剂可专用于服务器托盘或机架110中的组件的要求。在至少一个实施例中,cdu 112能够独立地或同时地对回路106、108中的冷却剂进行复杂控制。在至少一个实施例中,cdu可以适于控制流速,使得冷却剂被适当地分配,以吸取机架110内产生的热量。在至少一个实施例中,从辅助冷却回路108提供更多柔性管道114以进入每个服务器托盘并向电气和/或计算组件提供冷却剂。

64.在至少一个实施例中,电气和/或计算组件可互换地用来指代受益于本数据中心冷却系统的发热组件。在至少一个实施例中,形成辅助冷却回路108的一部分的管路(tubing)118可以被称为室(room)歧管。单独地,在至少一个实施例中,从管路118延伸的管路116也可以是辅助冷却回路108的一部分,但是可以称为行(row)歧管。在至少一个实施例中,管路114作为辅助冷却回路108的一部分进入机架,但是可以称为机架冷却歧管。在至少一个实施例中,行歧管116沿着数据中心100中的行延伸到所有机架。在至少一个实施例中,可通过本公开的至少一个实施例改进包括歧管118、116和114的辅助冷却回路108的管道。在至少一个实施例中,可以在数据中心102内的主冷却回路中提供冷却器120,以支持在冷却塔之前的冷却。在至少一个实施例中,在主控制回路中存在附加回路的程度上,本领域普通技术人员在阅读本公开时将认识到,这些附加回路提供机架外部和辅助冷却回路外部的冷却;并且可以与用于本发明的主冷却回路合在一起。

65.在至少一个实施例中,在操作中,机架110的服务器托盘内产生的热量可经由辅助冷却回路108的行歧管114的柔性管被传递到离开机架110的冷却剂。在至少一个实施例中,

来自cdu 112的用于冷却机架110的第二冷却剂(在辅助冷却回路108中)朝向机架110移动。在至少一个实施例中,来自cdu 112的第二冷却剂从具有管路118的室歧管的一侧经由行歧管116传递到机架110的一侧,并经由管路114通过服务器托盘的一侧。在至少一个实施例中,用过的或返回的第二冷却剂(或从计算组件带走热量的离开的第二冷却剂)从服务器托盘的另一侧离开(诸如在循环通过服务器托盘或通过服务器托盘上的组件之后进入用于服务器托盘的机架的左侧并离开机架的右侧)。在至少一个实施例中,离开服务器托盘或机架110的用过的第二冷却剂从管路114的不同侧(诸如出口侧)出来并且移动到行歧管116的平行的也是出口侧。在至少一个实施例中,用过的第二冷却剂从行歧管116在平行部分中移动到行歧管118,沿与进入的第二冷却剂(其也可以是更新的第二冷却剂)相反的方向行进,并且朝向cdu 112。

66.在至少一个实施例中,用过的第二冷却剂经由cdu 112与主冷却回路106中的主冷却剂交换其热量。在至少一个实施例中,用过的第二冷却剂被更新(诸如当与用过的第二冷却剂阶段的温度相比时相对冷却)并且准备好往回循环通过辅助冷却回路108到达计算组件。在至少一个实施例中,cdu 112中的各种流和温度控制特征使得能够控制从用过的第二冷却剂交换热量或者第二冷却剂流入和流出cdu 112。cdu 112还能够控制主冷却回路106中的主冷却剂的流动。

67.在至少一个实施例中,公开了一种数据中心冷却系统。在至少一个实施例中,系统可具有至少两个液体分配单元(ldu),用于将冷却剂供应至机架的服务器托盘。可使得至少两个ldu能够在第一配置中将冷却剂同时供应到至少一个服务器托盘。在至少一个实施例中,所述至少两个ldu还可能够用于在第二配置中替换所述至少两个ldu中的第一ldu,其中所述第二配置还使得所述至少两个ldu中的第二ldu能够将冷却剂供应到至少一个服务器托盘。在至少一个实施例中,包括泵或阀的流量控制器可用于调节至少两个ldu中的每一个ldu之间的流量。在至少一个实施例中,类似或容量变化的流量控制器可与服务器托盘关联地作用(诸如,在服务器托盘内,或与服务器歧管或与冷板关联地);与机架关联地(诸如与机架ldu关联地);或与行控制器关联地(诸如关于图4的数据中心级特征400所讨论的)。在至少一个实施例中,这些泵和这些阀可以具有机械组件和电气组件。在至少一个实施例中,对于电泵,从电组件提供信号,该电组件可以在该电泵内或远离该泵。在至少一个实施例中,该信号可以引起泵发动或改变速度以控制通过电泵的冷却剂的流速或流量。

68.在至少一个实施例中,针对多个电动泵或阀使能多个信号,这样使得可以跨该多个泵或阀实现成比例的流速或流量。在至少一个实施例中,信号可用于增加来自一个ldu的冷却剂流量,同时减少来自要替换的第二ldu的冷却剂流量。在至少一个实施例中,增大和减小是成比例相关的,使得当两个ldu从第一配置切换到第二配置时,同时接收冷却剂的计算设备或其他组件不感测冷却剂流的显著变化。在至少一个实施例中,该电泵本身具有机械组件,如马达、叶轮、叶片、刀片或抽吸特征,以便引起对该冷却剂的流速或流量的控制。在至少一个实施例中,根据讨论内的上下文,对流量控制器的引用可以指这些组件中的一个或更多个组件或整个泵或阀。

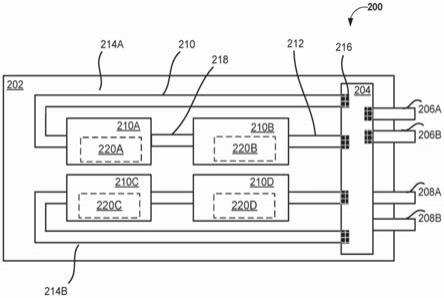

69.图2示出了根据至少一个实施例的与数据中心液体冷却系统的冗余液体冷却分配单元相关联的服务器级特征200。在至少一个实施例中,公开了一种数据中心冷却系统。在至少一个实施例中,服务器级特征200示出了服务器托盘或箱202,其具有与服务器托盘或

盒202相关联的一个或更多个冷板210a-d。在至少一个实施例中,一个或更多个冷板210a-d可以经由一个或更多个冷却回路214a、214b被供应冷却剂。在至少一个实施例中,可使冷却剂或其他冷却液体经由一个或更多个冷却回路214a、214b从服务器歧管204流动到一个或更多个冷板210a-d。在至少一个实施例中,即使因此引用服务器歧管204,具有流量控制器的服务器歧管可以是服务器歧管cdu。在至少一个实施例中,流量控制器使得能够对从服务器歧管cdu和/或到服务器歧管cdu的冷却剂进行流量控制,从而使服务器歧管cdu成为主动cdu型装置。在至少一个实施例中,具有用于一个或更多个冷却剂流的通道的被动服务器歧管可与冗余ldu一起使用。在至少一个实施例中,由于冗余ldu具有关联的机架级流量控制器,所以它们能够隔离ldu内的冷却剂,而不需要接合服务器歧管cdu 204的流量控制器。在至少一个实施例中,服务器歧管和服务器歧管cdu可以在本文中使用,除非以其他方式指示它们的不同特征。

70.在至少一个实施例中,服务器级特征200包括直接与具有服务器托盘或箱202的机架的至少两个液体分配单元(ldu)相关联的一个或更多个冷却回路214a、b。在至少一个实施例中,服务器级特征200包括一个或更多个冷却回路214a、b,所述一个或更多个冷却回路214a、b经由服务器歧管204与机架的至少两个液体分配单元(ldu)间接地相关联。在至少一个实施例中,服务器歧管204与服务器级流量控制器216相关联,以辅助一个或更多个回路214a、214b中的冷却剂的流速或流量。在至少一个实施例中,冷却剂从服务器托盘204流动通过回路214a的入口管线210、通过第一冷板210a、通过中间管线218和第二冷板210b,并且从出口管线212流出,并且回到服务器歧管204中。在至少一个实施例中,可以存在由服务器歧管204表示的入口服务器歧管和出口服务器歧管。在至少一个实施例中,歧管入口206a由第二歧管入口206b补充。在至少一个实施例中,歧管出口208a由第二歧管出口208b补充。

71.在至少一个实施例中,当一个或更多个冷板210a-d是旧式冷板时,则服务器级特征200的服务器歧管204可被安装以支持由冗余ldu提供的冗余。在至少一个实施例中,歧管入口206a和歧管出口206b支持冷却剂从机架ldu到服务器托盘或箱202的循环。在至少一个实施例中,歧管入口208a和歧管出口208b支持相同冷却剂或第二冷却剂的循环,第二冷却剂的源而不是其化学物质与第二机架ldu不同。在至少一个实施例中,歧管入口或出口可以被完全节流或打开以调节到冷板并且回到机架ldu的冷却剂的流速或流量。在至少一个实施例中,服务器级流量控制器216的提供使得能够控制反压和泄漏问题,反压和泄漏问题可能起因于将额外的冷却剂提供至服务器级特征200中的多个机架ldu配置。

72.在至少一个实施例中,为了支持机架ldu的替换,一种方法可包括:关闭与要替换的机架ldu相关联的歧管入口和出口。在至少一个实施例中,这避免了在至少一个实施例中空气泄漏或引入到服务器级特征200的冷却回路中。在至少一个实施例中,一个或更多个冷板210可以与需要冷却的计算或数据中心组件220a-d相关联。在至少一个实施例中,如果机架ldu直接连接到冷却回路214a、214b,则可能需要在冷板的端口处使用服务器级流量控制器来解决压力或泄漏问题。

73.图3示出了根据至少一个实施例的与数据中心液体冷却系统的冗余液体冷却分配单元相关联的机架级特征300。在至少一个实施例中,机架级特征300包括至少两个ldu 312、314,所述至少两个ldu 312、314可在第一配置中实现同时将冷却剂供应到至少一个服务器托盘。在至少一个实施例中,至少两个ldu 312、314可被悬挂在与数据中心的机架302

相关联的支架304、306上。在至少一个实施例中,至少两个ldu 312、314从作为辅助冷却回路的一部分的一个或更多个cdu接收冷却剂。在至少一个实施例中,cdu实现从辅助冷却回路到主冷却回路的热交换,所述主冷却回路退出数据中心到冷却设施,如关于图1所指出的。

74.在至少一个实施例中,至少两个ldu 312、314与一个或更多个服务器托盘308相关联。在至少一个实施例中,至少两个ldu 312、314经由相应的入口和出口管线318、320并发地服务于服务器托盘308。在至少一个实施例中,参考数字318、320被示出为各个管线,但可以包括机架ldu 312、314和服务器托盘或箱308之间的每侧上的对应的入口管线和出口管线。在至少一个实施例中,在第一配置中,第一机架ldu 312可向服务器托盘或箱308供应满冷却剂负载,而第二机架ldu 314可向同一服务器托盘或箱308供应部分冷却剂负载。在至少一个实施例中,通过机架ldu 312、314的冷却需求或能力表示的冷却剂负载可经由对一个或更多个机架级流量控制器316的控制来调整314。

75.在至少一个实施例中,一个或更多个机架级流量控制器可在相应机架ldu的入口或出口处。在至少一个实施例中,当服务器歧管与机架ldu一起使用时,歧管入口或出口(或两者)可与关联的机架ldu的机架级流量控制器耦接。在至少一个实施例中,通过控制一个或更多个机架级流量控制器316以使得一个ldu 312为满冷却剂负载而第二ldu 314为部分冷却剂负载,来实现至少两个ldu 312、314的第一配置。在至少一个实施例中,在至少两个ldu 312、314的第二配置中,通过控制一个或更多个机架级流量控制器316,保持第一或第二ldu 312、314中的一个是活动的以提供满的或至少部分的冷却剂流,而第一ldu 312或第二ldu 314中的第二ldu被停用,使得冷却剂不能流入或流出第一ldu或第二ldu中的第二ldu。在至少一个实施例中,此第二配置允许第一ldu或第二ldu中的第二ldu的热交换,而第一ldu或第二ldu中的第一ldu是活动的,并且服务器仍在正常操作(诸如具有在正常温度范围下操作的计算设备)内运行。

76.在至少一个实施例中,第一ldu 312或第二ldu 314中的第一ldu可通过激活第一ldu或第二ldu中的第二ldu以提供满冷却剂负载(或满足在正常温度范围下操作的计算设备的当前冷却需求所需的任何冷却剂负载)来替换。在至少一个实施例中,第一ldu 312或第二ldu 314中的第二ldu可被替换。在至少一个实施例中,实现替换ldu的该特征也表示第二配置。在至少一个实施例中,就部分冷却剂负载ldu发生故障且需要更换并且满冷却剂负载ldu已经接合的程度下,然后可以在发热组件上的工作负载减小之后进行热交换。在至少一个实施例中,进入的工作订单可被重定向到其他机架,并且不允许新的工作订单到需要替换两个ldu中的至少一个ldu的机架。

77.在至少一个实施例中,流量控制器用于指服务器级、机架级或行级流量控制器中的任一个。在至少一个实施例中,包括泵或阀的流量控制器可用于调节至少两个ldu中的每个ldu之间的流量。在至少一个实施例中,如在此通篇所提到的,这些泵和这些阀可以具有机械组件和电气组件。在至少一个实施例中,根据讨论内的上下文,提及流量控制器可以指这些组件中的一个或更多个组件或整个泵或阀。在至少一个实施例中,机架级流量控制器316可具有机械组件,并且来自机架302的配电单元(pdu)的电力可用于为流量控制器(在电子泵的情况下)供电。

78.在至少一个实施例中,公开了用于数据中心冷却系统的至少两个液体分配单元

(ldu)312、314。在至少一个实施例中,出于机架歧管的目的,至少两个ldu 312、314悬挂在与机架302相关联的托架304、306上。在至少一个实施例中,被提供用于机架歧管的这些支架可替代地用于悬挂ldu 312、314。在至少一个实施例中,至少两个ldu 312、314的第一配置使得冷却剂能够同时服务于至少一个服务器托盘308。在至少一个实施例中,至少两个ldu 312、314的第二配置使得能够替换至少两个ldu中的第一ldu 312,使得至少两个ldu中的第二ldu 314能够将冷却剂供应到至少一个服务器托盘308。

79.在至少一个实施例中,与至少两个ldu 312、314中的第二ldu 314相关联的机架级流量控制器316被缓慢地完全打开或激活至确定的能力或容量,以满足从至少两个ldu 312、314接收冷却剂的服务器托盘308的冷却需求。在至少一个实施例中,与至少两个ldu 312、314中的第一ldu 312相关联的机架级流量控制器316被缓慢关闭或停用,使得它们不会突然增加或减少由关联的计算组件生成的热量(诸如因为当至少两个ldu中的第一ldu 312被关闭时它们的冷却需求未被满足)。在至少一个实施例中,在关闭与至少两个ldu 312、314中的第一ldu 312相关联的所有机架级流量控制器316之后,则也关闭任何关联的服务器歧管入口和出口管线。在至少一个实施例中,未关联的服务器歧管入口管线和出口管线(未与至少两个ldu中的第一ldu 312相关联,但与至少两个ldu中的第二ldu 314相关联)可保持为初始配置或可打开更多,以在不存在并行冷却剂流的情况下针对较少冷却剂进行调整。

80.在至少一个实施例中,机架级流量控制器在至少两个ldu的第一配置或第二配置中控制从至少两个ldu中的一个或更多个ldu到至少一个服务器托盘的冷却剂。在至少一个实施例中,这使得单个机架中的不同服务器能够在ldu的第一配置中由机架的不同ldu服务,即使不同的ldu可被配置为允许从一个ldu服务两个不同的服务器的第二配置,而其他ldu被替换或可替换。在至少一个实施例中,数据中心液体冷却系统包括与至少两个ldu相关联的一个或更多个流控制器,其中所述一个或更多个流控制器是可选择的以实现用于所述至少两个ldu的第一配置和第二配置。在至少一个实施例中,如通篇所述,第一配置被实现以将冷却剂同时供应到至少一个服务器托盘,并且第二配置被实现以供应来自至少两个ldu中的第一ldu的冷却剂,其中至少两个ldu中的第二ldu被停用以实现其替换。

81.在至少一个实施例中,与两个ldu 312、314中的一个ldu(312)相关联的所有机架级流量控制器316可被停用或关闭,使得冷却剂不能流入或流出该一个ldu(312),而不管服务器级或行级流量控制器是打开还是关闭的。在至少一个实施例中,与两个ldu 312、314中的第二ldu(312)相关联的所有机架级流量控制器316可保持是活动的或可进一步接合以拾取(pick up)关闭或停用的ldu的负载。在至少一个实施例中,这仍表示用于至少两个ldu的第二配置,并且通过对机架级流量控制器316做出的选择来实现第二配置。在至少一个实施例中,在至少一个实施例中,对断言两个ldu 312、314上的一个或更多个配置的选择可以由执行存储在控制系统的存储器中的指令的至少一个处理器做出,该控制系统可以是如参见图18a所讨论的数据中心内的系统。在至少一个实施例中,至少一个处理器耦接到流量控制器316(诸如耦接到流量控制器的电子组件)。在至少一个实施例中,可从至少一个处理器对电子组件进行选择,以引起受影响的ldu的流量控制器的平稳关闭或停用,同时引起未受影响的ldu的流量控制器的进一步接合。在至少一个实施例中,来自至少一个处理器的平稳动作确保来自受影响的ldu的成比例改变相对于未受影响的ldu,使得由至少两个ldu冷却的

计算设备保持不知晓影响至少两个ldu的改变。

82.在至少一个实施例中,至少一个处理器中的每个处理器具有推理和/或训练逻辑1815,其可以包括但不限于代码和/或数据存储装置1801,用于存储前向和/或输出权重和/或输入/输出数据,和/或在一个或更多个实施例的各方面中用于配置被训练和/或用于推理的神经网络的神经元或层的其他参数。在至少一个实施例中,训练逻辑1815可以包括或被耦合到代码和/或数据存储装置1801,用于存储图形代码或其他软件,以控制要加载权重和/或其他参数信息的定时和/或顺序,以配置逻辑,包括整数和/或浮点单元(统称为算术逻辑单元(alu))。在至少一个实施例中,代码(诸如图代码)基于这样的代码所对应的神经网络的架构将权重或其他参数信息加载到处理器alu中。在至少一个实施例中,代码和/或数据存储装置1801存储神经网络的每个层的权重参数和/或输入/输出数据,该神经网络在使用一个或更多个实施例的各方面的训练和/或推理期间在输入/输出数据和/或权重参数的前向传播期间与一个或更多个实施例结合训练或使用。在至少一个实施例中,代码和/或数据存储装置1801的任何部分可与其他芯片上或芯片外数据存储装置一起包含,包括处理器的l1、l2或l3高速缓存存储器或系统存储器。

83.在至少一个实施例中,至少一个处理器的推理和/或训练逻辑1815是用于在服务器级、机架级和行级中的一个或更多个处控制流量控制器的建筑物管理系统(bms)的一部分。在至少一个实施例中,可将对机架的至少两个ldu从第一配置转换到第二配置的确定提供给推理和/或训练逻辑1815的一个或更多个神经网络,以使得一个或更多个神经网络推理出哪些流量控制器平滑地脱离以及哪些其他流量控制器平滑地接合。在至少一个实施例中,该一个或更多个神经网络被训练成通过来自关联的ldu的通过一个或更多个流量控制器的先前关联的流速或流量、以及在数据中心或计算设备中实现的所需冷却来做出推理。在至少一个实施例中,当数据中心或计算设备接收一定量的冷却剂以确保冷却时,将一个或更多个神经网络训练为识别将从至少两个ldu中的每一个ldu提供的某量的冷却剂。在至少一个实施例中,一个或更多个神经网络能够确定对流量控制器(诸如对与流量控制器相关联的电子组件)的选择,以使得冷却剂的量保持为为什么关闭ldu之一和增加来自其他ldu的流量所提供的量。

84.在至少一个实施例中,冷却剂分配单元(cdu)与主冷却回路和辅助冷却回路相关联,使得cdu可以冷却来自至少两个ldu的冷却剂。在至少一个实施例中,至少两个ldu中的第一ldu适于在任何时间供应部分冷却剂负载,至少两个ldu中的第二ldu用于供应冷却剂的满冷却剂负载。在至少一个实施例中,至少两个ldu中的第一ldu从来不是加载的ldu,并且其总是处于某种形式的备用或备份模式,而没有可使其需要在与在满冷却剂负载下供应冷却剂的主ldu同时替换的压力。

85.在至少一个实施例中,至少一个流量控制器与至少两个ldu中的第二ldu相关联,以在替换至少两个ldu中的第一ldu之前或之时,引起来自部分冷却剂负载的冷却剂负载的增加。在至少一个实施例中,本文引用的第一配置和第二配置将利用处于运行状态的相关联的计算设备来执行,并且其中由来自至少两个ldu中的至少第二ldu的冷却剂来执行对相关联的计算设备的冷却。在至少一个实施例中,所述至少两个ldu中的第一ldu和所述至少两个ldu中的第二ldu由不同的冷却剂源或不同的cdu供应。

86.在至少一个实施例中,提供一个或更多个支架以悬挂至少两个ldu。在至少一个实

施例中,与至少两个ldu相关联的流量控制器控制到至少一个服务器托盘的冷却剂的流量。在至少一个实施例中,这些可以是机架级流量控制器,并且可用于成比例地控制至少两个ldu之间的冷却剂流。在至少一个实施例中,冷却剂流的成比例控制确保了在管道中不存在突然的压力变化并且对于接收冷却剂的计算设备不存在突然的温度变化。在至少一个实施例中,服务器歧管cdu包括流量控制器。在至少一个实施例中,流量控制器与至少两个ldu相关联,以维持从至少两个ldu中的一个或更多个ldu到至少一个服务器托盘的冷却剂的流速。在至少一个实施例中,这允许每个服务器级流量控制器补偿流速和压力变化以及保留的ldu。在至少一个实施例中,流速包括由第一配置中的至少两个ldu中的一个或更多个ldu建立的第一流速。在至少一个实施例中,流速还包括,在至少一个实施例中,第二流速适于匹配来自处于第二配置中的至少两个ldu中的第二ldu的冷却剂的第一流速。

87.在至少一个实施例中,提供第三ldu以替换去除的ldu。在至少一个实施例中,至少两个ldu和第三ldu在安装时都是预加载的ldu。在至少一个实施例中,预加载的ldu具有加载的并且包含在其中的冷却剂。在至少一个实施例中,这使得ldu的快速安装能够降低对第二配置中的单数个ldu的依赖性,并且防止空气进入液体冷却系统,尤其是在ldu的热交换期间。在至少一个实施例中,这还可以防止对该管道放气的要求。在至少一个实施例中,该至少两个ldu和该第三ldu中的每一个与泄放阀或压力阀相关联。在至少一个实施例中,如果需要,可以在安装之后调整泄放阀或压力阀,以使得能够在安装相应的ldu之后至少从相应的ldu内泄放空气或释放压力,以替换至少两个ldu中的一个。

88.图4示出了根据至少一个实施例的与数据中心液体冷却系统的冗余液体冷却分配单元相关联的数据中心级特征400。在至少一个实施例中,数据中心级特征400包括具有机架404的数据中心机房402,所述机架404可以在提升的平台上。在至少一个实施例中,机架404经由行歧管410与cdu 406相关联。在至少一个实施例中,在每个机架404中,可存在与行歧管410相关联的和与行歧管410和机架ldu(诸如图3的ldu 312、314)之间的各个入口管线和/或出口管线相关联的各个行级流量控制器420。在至少一个实施例中,机架404中的每一个与一对入口管线416和出口管线418相关联。在至少一个实施例中,该对入口和出口管线416、418中的一个入口管线和出口管线(416)耦接至机架的第一机架ldu,以及所述该对入口和出口管线416、418中的第二入口管线和出口管线(418)耦接到同一机架的第二机架ldu。

89.在至少一个实施例中,与机架404的机架ldu相关联的行级流量控制器420在替换之前实现相关联的机架ldu的安全停用或关闭。在至少一个实施例中,首先停用或关闭服务器级流量控制器,接着是机架级流量控制器,然后是行级流量控制器。在至少一个实施例中,这使得能够遵循逐步压力和泄漏控制过程,以替换机架ldu,同时保持相关联的机架和相关联的服务器托盘运行。在至少一个实施例中,cdu 406经由它自己的与行歧管410相关联的冷却剂管线412、414来馈送和返回冷却剂。在至少一个实施例中,行歧管410、冷却剂管线412、414、机架入口和出口管线416、418、机架ldu(和相关联的管线)、服务器托盘或箱(和相关联的管线)和冷板形成辅助冷却回路的一部分。在至少一个实施例中,辅助冷却回路的冷却剂在cdu 406中与冷却管线422中的主冷却剂回路的主冷却剂交换热量。在至少一个实施例中,主冷却剂经由冷却设施408冷却。

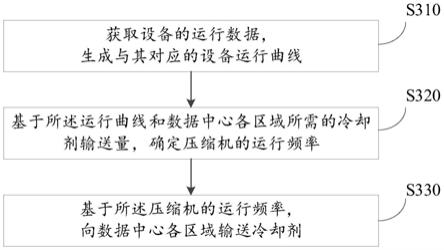

90.图5示出了根据至少一个实施例的与图2-4的数据中心液体冷却系统相关联的方

法。在至少一个实施例中,步骤502提供至少两个液体分配单元(ldu),用于将冷却剂供应至机架的服务器托盘。在至少一个实施例中,步骤504实现至少两个ldu的第一配置,用于将冷却剂同时供应至至少一个服务器托盘。在至少一个实施例中,这可通过在至少两个ldu的入口侧和出口侧调整来自至少两个ldu的并行机架级流量控制器,以允许冷却剂从至少两个ldu同时进入至少一个服务器托盘来实现。

91.在至少一个实施例中,步骤506实现至少两个ldu的第二配置。在第二配置中,至少两个ldu中的第一ldu是可替换的,至少两个ldu中的第二ldu在第二配置中将冷却剂供应至至少一个服务器托盘。在至少一个实施例中,这通过允许调整在所述至少两个ldu的入口侧和出口侧上的来自至少两个ldu的并行机架级流量控制器来实现,,以禁用从所述两个ldu中的所述至少第一ldu供应的冷却剂,同时继续来自所述两个ldu中的所述第二ldu的所述冷却剂。在至少一个实施例中,该第一配置和第二配置进一步由服务器级和行级流量控制器来支持,以便进一步降低压力、进一步防止空气泄漏到任何管道中、并且进一步防止流体泄漏出任何管道。

92.在至少一个实施例中,当存在替换至少两个ldu中的第一ldu的要求时,步骤508检查以查看至少两个ldu中的第二ldu是否可满足机架的关联服务器的冷却需求。在至少一个实施例中,当确定单个ldu(诸如,至少两个ldu中的第二ldu)能够单独提供冷却剂以满足机架的冷却需求时,然后使至少两个ldu中的第二ldu能够经由步骤510解决机架的全部冷却需求。在至少一个实施例中,至少两个ldu中的第一ldu被停用或关闭,使得其内的冷却剂被密封或包含并且不能流出并且不能流入另外的冷却剂。在至少一个实施例中,这表示至少两个ldu的第二配置。

93.在至少一个实施例中,当至少两个ldu中的第二ldu不能满足机架的冷却需求时,则可将机架的工作负载转移到不受影响的机架,直到在受影响的机架的第二配置中可支持冷却需求。在至少一个实施例中,这可以在至少一个实施例中在步骤506内执行。在至少一个实施例中,可以对至少两个ldu中的第一ldu的替换进行定时,使得冷却需求最小。在至少一个实施例中,这可从至少两个ldu的历史使用模式来确定。

94.在至少一个实施例中,方法500可包括用于确定替换至少两个ldu中的至少第一ldu的步骤,以及随后使用步骤504、506中的特征来调整与至少两个ldu中的第一ldu相关联的至少第一流量控制器及与至少两个ldu中的第二ldu相关联的至少第二流量控制器的步骤。在至少一个实施例中,调整使得冷却剂从至少两个ldu中的第二ldu流动。在至少一个实施例中,没有冷却剂从至少两个ldu中的第一ldu流动,使得至少两个ldu中的第一ldu是可替换的。在至少一个实施例中,方法500包括使若干流量控制器能够以至少两个ldu的第一配置或第二配置将冷却剂从至少两个ldu中的一个或更多个ldu传递到至少一个服务器托盘的步骤。在至少一个实施例中,第一组的多个流量控制器与至少两个ldu中的第一ldu的入口和出口相关联,且第二组的多个流量控制器与至少两个ldu中的第二ldu的入口和出口相关联。在至少一个实施例中,这允许来自一个机架ldu的冷却剂供应一个服务器托盘,并且允许来自另一个机架ldu的冷却剂供应另一个服务器托盘。在至少一个实施例中,当机架ldu中的一个将被改变时,则可从相同的机架ldu供应两个服务器托盘,这释放了将被改变的机架ldu。

95.在至少一个实施例中,方法500包括将冷却剂分配单元(cdu)与主冷却回路和辅助

冷却回路相关联的步骤,使得cdu可用于冷却来自至少两个ldu的冷却剂。在至少一个实施例中,可存在与同一冷却器设施相关联的多个cdu,并且多个cdu中的每一个与同一机架内的不同ldu相关联。这使得在ldu操作中能够进一步冗余。

96.在至少一个实施例中,方法500包括用于使得至少两个ldu中的第一ldu在任何时间供应由最多一半的能够由至少两个ldu中的第一ldu输出的冷却剂表示的部分冷却剂负载的步骤或子步骤。在至少一个实施例中,该步骤还包括实现从至少两个ldu中的第二ldu的冷却剂的满冷却剂负载。在至少一个实施例中,在至少两个ldu的第一配置中,两个ldu在某个水平上供应冷却剂。在至少一个实施例中,因为冷却需求不是由一个ldu做出的,所以可能是一个ldu不供应冷却剂的情况。在至少一个实施例中,一个ldu是活动的并且使其机架级流量控制器打开,而接收者服务器托盘或箱可以使其相应的服务器级流量控制器关闭或对于一个ldu是不活动的。在至少一个实施例中,一个ldu此时仍处于第一配置中,假设另一ldu用于供应冷却剂。在至少一个实施例中,当一个ldu使其流量控制器停用或关闭时,一个ldu和另一ldu仅处于第二配置中,使得无论接收方侧的相关联流量控制器是打开的还是活动的,所述一个ldu和另一ldu都不能供应冷却剂。

97.在至少一个实施例中,方法500包括用于在确定替换至少两个ldu中的第一ldu时或在替换至少两个ldu中的第一ldu之后使与至少两个ldu中的第二ldu相关联的至少一个流量控制器能够引起来自部分冷却剂负载的冷却剂负载增加的步骤或子步骤。在至少一个实施例中,该步骤发生在替换至少两个ldu中的第一ldu之前。在至少一个实施例中,该步骤同时发生,使得当至少两个ldu中的第二ldu进一步接合(以增加冷却剂负载)时,至少两个ldu中的第一ldu成比例地关闭。

98.在使用方法500的至少一个实施例中,第一配置和第二配置将利用处于运行状态中的相关联的计算设备来执行,并且利用由来自至少两个ldu中的至少第二ldu的冷却剂来执行对相关联的计算设备的冷却。在至少一个实施例中,这至少表示至少两个ldu中的至少第一ldu的热交换,而至少两个ldu中的第二ldu继续供应冷却剂。在至少一个实施例中,所述至少两个ldu中的第一ldu和所述至少两个ldu中的第二ldu由不同的冷却剂源或不同的cdu供应。在至少一个实施例中,图2中示出的不同的冷板和相关联的冷却回路可以被供应不同类型的冷却剂。在至少一个实施例中,cdu中的一个cdu可以与丙二醇和水组合冷却剂相关联,而cdu中的第二cdu可以与仅水冷却剂相关联。在至少一个实施例中,方法500包括使一个或更多个支架(如机架歧管支架)能够包括至少两个ldu的步骤。在至少一个实施例中,步骤还可包括使用与至少两个ldu关联的流量控制器控制到至少一个服务器托盘的冷却剂流。

99.在至少一个实施例中,方法500包括附加步骤或子步骤,以使得服务器歧管cdu能够包括流量控制器。在至少一个实施例中,更进一步的步骤包括使得流量控制器能够与至少两个ldu相关联,并且使得流量控制器能够维持从至少两个ldu中的一个或更多个到至少一个服务器托盘的冷却剂的流速。在至少一个实施例中,方法500使流速能够包括由第一配置中的至少两个ldu中的一个或更多个ldu建立的第一流速,以及适于匹配来自第二配置中的至少两个ldu中的第二ldu的冷却剂的第一流速的第二流速。在至少一个实施例中,在至少一个实施例中,这使得要求替换至少一个ldu的受影响的服务器中的冷却需求能够至少部分地基于被保留的ldu提供流速以补偿要被替换或正被替换的ldu从至少两个ldu中的被

保留的ldu被满足。

100.服务器和数据中心

101.以下附图阐述了但不限于可以用于实现至少一个实施例的基于示例性网络服务器和数据中心的系统。

102.图6示出了根据至少一个实施例的分布式系统600。在至少一个实施例中,分布式系统600包括一个或更多个客户端计算设备602、604、606和608,其被配置成在一个或更多个网络610上执行和操作客户端应用,诸如网络(web)浏览器、专有客户端和/或其变体。在至少一个实施例中,服务器612可以经由网络610与远程客户端计算设备602、604、606和608通信地耦合。

103.在至少一个实施例中,服务器612可适于运行一个或更多个服务或软件应用,诸如可管理跨多个数据中心的单点登录(sso)访问的会话活动的服务和应用。在至少一个实施例中,服务器612还可以提供其他服务,或者软件应用,其可以包括非虚拟和虚拟环境。在至少一个实施例中,这些服务可作为基于web的服务或云服务或在软件即服务(saas)模型下被提供给客户端计算设备602、604、606和/或608的用户。在至少一个实施例中,操作客户端计算设备602、604、606和/或608的用户又可以利用一个或更多个客户端应用来与服务器612交互以利用由这些组件提供的服务。

104.在至少一个实施例中,系统600的软件组件618、620和622在服务器612上实现。在至少一个实施例中,系统600的一个或更多个组件和/或由这些组件提供的服务也可由客户端计算设备602、604、606和/或608中的一个或更多个来实现。在至少一个实施例中,操作客户端计算设备的用户然后可以利用一个或更多个客户端应用来使用由这些组件提供的服务。在至少一个实施例中,这些组件可以用硬件、固件、软件或其组合来实现。应当理解,各种不同的系统配置是可能的,其可以不同于分布式系统600。因此,图6所示的实施例是用于实现实施例系统的分布式系统的至少一个实施例,并且不旨在是限制性的。

105.在至少一个实施例中,客户端计算设备602、604、606和/或608可以包括不同类型的计算系统。在至少一个实施例中,客户端计算设备可以包括便携式手持设备(例如,蜂窝电话、计算平板、个人数字助理(pda))或可穿戴设备(例如,google头戴式显示器),运行软件(如microsoft windows)和/或各种移动操作系统(诸如ios、windows phone、android、blackberry 10、palm os和/或其变体)。在至少一个实施例中,设备可以支持不同应用,诸如不同互联网相关的应用、电子邮件、短消息服务(sms)应用,并且可以使用各种其他通信协议。在至少一个实施例中,客户端计算设备还可以包括通用个人计算机,在至少一个实施例中,所述通用个人计算机包括运行各种版本的microsoftapple和/或linux操作系统的个人计算机和/或膝上型计算机。

106.在至少一个实施例中,客户端计算设备可以是运行各种可商购的或类似unix的操作系统中的任一种的工作站计算机,包括但不限于各种gnu/linux操作系统,诸如google chrome os。在至少一个实施例中,客户端计算设备还可以包括能够通过一个或更多个网络610进行通信的电子设备,诸如瘦客户端计算机、启用互联网的游戏系统(例如,具有或不具有手势输入设备的微软xbox游戏控制台)、和/或个人消息传递设备。尽

管图6中的分布式系统600被示为具有四个客户端计算设备,但可支持任何数量的客户端计算设备。其他设备(诸如具有传感器的设备等)可与服务器612交互。

107.在至少一个实施例中,分布式系统600中的网络610可以是能够使用各种可用协议中的任何协议来支持数据通信的任何类型的网络,包括但不限于tcp/ip(传输控制协议/互联网协议)、sna(系统网络架构)、ipx(互联网分组交换)、appletalk和/或其变体。在至少一个实施例中,网络610可以是局域网(lan),基于以太网的网络、令牌环、广域网、互联网、虚拟网络、虚拟专用网(vpn)、内联网、外联网、公共交换电话网络(pstn)、红外网络、无线网络(例如,在电气与电子协会(ieee)802.11协议组、和/或任何其他无线协议中的任一者下运行的网络),和/或这些和/或其他网络的任何组合。

108.在至少一个实施例中,服务器612可以由一个或更多个通用计算机、专用服务器计算机(在至少一个实施例中,包括pc(个人计算机)服务器、服务器、中程服务器、大型计算机、机架式服务器等)、服务器农场、服务器集群或任何其他适当的布置和/或组合组成。在至少一个实施例中,服务器612可包括运行虚拟操作系统的一个或更多个虚拟机或涉及虚拟化的其他计算架构。在至少一个实施例中,可以虚拟化一个或更多个灵活的逻辑存储设备池,以便为服务器维护虚拟存储设备。在至少一个实施例中,虚拟网络可由服务器612使用软件定义的网络来控制。在至少一个实施例中,服务器612可适于运行一个或更多个服务或软件应用。

109.在至少一个实施例中,服务器612可以运行任何操作系统,以及任何可商购的服务器操作系统。在至少一个实施例中,服务器612还可以运行各种附加服务器应用和/或中层应用中的任一种,包括http(超文本传输协议)服务器、ftp(文件传输协议)服务器、cgi(公共网关接口)服务器、服务器、数据库服务器和/或其变体。在至少一个实施例中,示例性数据库服务器包括但不限于从oracle、microsoft、sybase、ibm(国际商业机器)和/或其变体可商购的那些。

110.在至少一个实施例中,服务器612可包括一个或更多个应用,用于分析和合并从客户端计算设备602、604、606和608的用户接收的数据馈送和/或事件更新。在至少一个实施例中,数据馈送和/或事件更新可以包括但不限于,从一个或更多个第三方信息源和连续数据流接收的馈送、更新或实时更新,其可以包括与传感器数据应用、金融报价器、网络性能测量工具(例如,网络监视和业务管理应用)相关的实时事件,点击流分析工具、汽车交通监测和/或其变化。在至少一个实施例中,服务器612还可以包括用于经由客户端计算设备602、604、606和608的一个或更多个显示设备来显示数据馈送和/或实时事件的一个或更多个应用。

111.在至少一个实施例中,分布式系统600还可包括一个或更多个数据库614和616。在至少一个实施例中,数据库可提供用于存储信息(诸如用户交互信息、使用模式信息、适配规则信息和其他信息)的机制。在至少一个实施例中,数据库614和616可以驻留在各种位置中。在至少一个实施例中,数据库614和616中的一个或更多个可以驻留在服务器612本地(和/或驻留在服务器612中)的非暂态存储介质上。在至少一个实施例中,数据库614和616可以远离服务器612并且经由基于网络的连接或专用连接与服务器612通信。在至少一个实施例中,数据库614和616可以驻留在存储区域网络(san)中。在至少一个实施例中,用于执

行归属于服务器612的功能的任何必要的文件可以适当地本地存储在服务器612上和/或远程存储。在至少一个实施例中,数据库614和616可以包括关系数据库,诸如适于响应于sql格式化的命令而存储、更新和检索数据的数据库。

112.图7示出了根据至少一个实施例的示例性数据中心700。在至少一个实施例中,数据中心700包括但不限于数据中心基础设施层710、框架层720、软件层730和应用层740。

113.在至少一个实施例中,如图7所示,数据中心基础设施层710可以包括资源协调器712、分组的计算资源714和节点计算资源(“节点c.r.”)716(1)-716(n),其中“n”表示任何完整的正整数。在至少一个实施例中,节点c.r.716(1)-716(n)可以包括但不限于任意数量的中央处理单元(“cpu”)或其他处理器(包括加速器、现场可编程门阵列(“fpga”)、图形处理器等)、存储器设备(例如,动态只读存储器)、存储设备(例如,固态硬盘或磁盘驱动器)、网络输入/输出(“nw i/o”)设备、网络交换机、虚拟机(“vm”)、功率模块和冷却模块等。在至少一个实施例中,节点c.r.716(1)-716(n)中的一个或更多个节点c.r.可以是具有一个或更多个上述计算资源的服务器。

114.在至少一个实施例中,分组的计算资源714可以包括容纳在一个或更多个机架内的节点c.r.的单独分组(未示出),或者容纳在各个地理位置的数据中心内的许多机架(也未示出)。分组的计算资源714内的节点c.r.的单独分组可以包括可以被配置或分配为支持一个或更多个工作负载的分组的计算、网络、存储器或存储资源。在至少一个实施例中,可以将包括cpu或处理器的几个节点c.r.分组在一个或更多个机架内,以提供计算资源来支持一个或更多个工作负载。在至少一个实施例中,一个或更多个机架还可以包括任意数量的电源模块、冷却模块和网络交换机,以任意组合。

115.在至少一个实施例中,资源协调器712可以配置或以其他方式控制一个或更多个节点c.r.716(1)-716(n)和/或分组的计算资源714。在至少一个实施例中,资源协调器712可以包括用于数据中心700的软件设计基础结构(“sdi”)管理实体。在至少一个实施例中,资源协调器712可以包括硬件、软件或其某种组合。

116.在至少一个实施例中,如图7所示,框架层720包括但不限于作业调度器732、配置管理器734、资源管理器736和分布式文件系统738。在至少一个实施例中,框架层720可以包括支持软件层730的软件752和/或应用程序层740的一个或更多个应用程序742的框架。在至少一个实施例中,软件752或应用程序742可以分别包括基于web的服务软件或应用程序,例如由amazon web services、google cloud和microsoft azure提供的服务或应用程序。在至少一个实施例中,框架层720可以是但不限于一种免费和开放源软件网络应用框架,例如可以利用分布式文件系统738来进行大范围数据处理(例如“大数据”)的apache sparktm(以下称为“spark”)。在至少一个实施例中,作业调度器732可以包括spark驱动器,以促进对数据中心700的各个层所支持的工作负载进行调度。在至少一个实施例中,配置管理器734可以能够配置不同的层,例如软件层730和包括spark和用于支持大规模数据处理的分布式文件系统738的框架层720。在至少一个实施例中,资源管理器736能够管理映射到或分配用于支持分布式文件系统738和作业调度器732的集群或分组计算资源。在至少一个实施例中,集群或分组计算资源可以包括数据中心基础设施层710上的分组的计算资源714。在至少一个实施例中,资源管理器736可以与资源协调器712协调以管理这些映射的或分配的计算资源。

117.在至少一个实施例中,包括在软件层730中的软件752可以包括由节点c.r.716(1)-716(n)的至少一部分,分组计算资源714和/或框架层720的分布式文件系统738使用的软件。一种或更多种类型的软件可以包括但不限于internet网页搜索软件、电子邮件病毒扫描软件、数据库软件和流视频内容软件。

118.在至少一个实施例中,应用层740中包括的一个或更多个应用程序742可以包括由节点c.r.716(1)-716(n)的至少一部分、分组的计算资源714和/或框架层720的分布式文件系统738使用的一种或更多种类型的应用程序。一种或更多种类型的应用程序可以包括但不限于cuda应用程序、5g网络应用程序、人工智能应用程序、数据中心应用程序、和/或其变体。

119.在至少一个实施例中,配置管理器734、资源管理器736和资源协调器712中的任何一个可以基于以任何技术上可行的方式获取的任意数量和类型的数据来实现任意数量和类型的自我修改动作。在至少一个实施例中,自我修改动作可以减轻数据中心700的数据中心操作员做出可能不好的配置决定并且可以避免数据中心的未充分利用和/或执行差的部分。

120.图8示出了根据至少一个实施例的由互连的多个网络服务器计算机802形成的客户端-服务器网络804。在至少一个实施例中,每个网络服务器计算机802存储其他网络服务器计算机802和链接到广域网804中的客户端计算机806和网络808可访问的数据。在至少一个实施例中,当客户端计算机806和一个或更多个网络808与网络804连接和断开连接时,以及当一个或更多个干线服务器计算机802被添加到网络804或从网络804移除时,客户端-服务器网络804的配置可随时间改变。在至少一个实施例中,当客户端计算机806和网络808与网络服务器计算机802连接时,客户端-服务器网络包括这样的客户端计算机806和网络808。在至少一个实施例中,术语计算机包括能够接受数据、将规定的过程应用于数据以及提供过程的结果的任何设备或机器。

121.在至少一个实施例中,客户端-服务器网络804存储网络服务器计算机802、远程网络808和客户端计算机806可访问的信息。在至少一个实施例中,网络服务器计算机802由大型计算机、小型计算机和/或各自具有一个或更多个处理器的微型计算机形成。在至少一个实施例中,服务器计算机802通过有线和/或无线传输介质(诸如导线、光纤电缆)和/或微波传输介质、卫星传输介质或其他导电、光学或电磁波传输介质链接在一起。在至少一个实施例中,客户端计算机806通过类似的有线或无线传输介质访问网络服务器计算机802。在至少一个实施例中,客户端计算机806可以使用调制解调器和标准电话通信网络链接到客户端-服务器网络804中。在至少一个实施例中,替代性的运营商系统(如电缆和卫星通信系统)还可以用于链接到客户端-服务器网络804中。在至少一个实施例中,可以使用其他私有或时间共享的运营商系统。在至少一个实施例中,网络804是全球信息网络,诸如互联网。在至少一个实施例中,网络是使用与互联网类似的协议但具有添加的安全措施和受限的访问控制的私有内联网。在至少一个实施例中,网络804是使用专有通信协议的私有或半私有网络。

122.在至少一个实施例中,客户端计算机806是任何终端用户计算机,并且还可以是具有一个或更多个微处理器的大型计算机、小型计算机或微型计算机。在至少一个实施例中,服务器计算机802有时可用作访问另一服务器计算机802的客户端计算机。在至少一个实施

例中,远程网络808可以是局域网、通过用于互联网的独立服务提供商(isp)被添加到广域网中的网络、或通过具有固定的或随时间改变的配置的有线或无线传输介质互连的另一组计算机。在至少一个实施例中,客户端计算机806可以独立地或通过远程网络808链接到网络804中并且访问网络804。

123.图9示出了根据至少一个实施例的连接一个或更多个计算机器的计算机网络908。在至少一个实施例中,网络908可以是任何类型的电连接的计算机组,包括例如以下网络:互联网、内联网、局域网(lan)、广域网(wan)或这些网络类型的互连组合。在至少一个实施例中,网络908内的连接可以是远程调制解调器、以太网(ieee 802.3)、令牌环(ieee 802.5)、光纤分布式数据链路接口(fddi)、异步传输模式(atm)或任何其他通信协议。在至少一个实施例中,链接到网络的计算设备可以是台式机、服务器、便携式、手持式、机顶盒、个人数字助理(pda)、终端、或任何其他期望的类型或配置。在至少一个实施例中,取决于它们的功能性,网络连接的设备可以在处理能力、内部存储器和其他性能方面广泛地变化。

124.在至少一个实施例中,网络内的通信以及去往或来自连接到网络的计算设备的通信可以是有线或无线的。在至少一个实施例中,网络908可以至少部分地包括世界范围的公共互联网,其通常根据客户端-服务器模型根据传输控制协议/互联网协议(tcp/ip)规范连接多个用户。在至少一个实施例中,客户端-服务器网络是用于在两个计算机之间通信的主导模型。在至少一个实施例中,客户端计算机(“客户端”)向服务器计算机(“服务器”)发出一个或更多个命令。在至少一个实施例中,服务器通过访问可用网络资源并根据客户端命令向客户端返回信息来履行客户端命令。在至少一个实施例中,客户端计算机系统和驻留在网络服务器上的网络资源被分配网络地址,用于网络的元件之间的通信期间的识别。在至少一个实施例中,从其他网络连接的系统到服务器的通信将包括作为通信的一部分的相关服务器/网络资源的网络地址,使得数据/请求的适当目的地被识别为接收者。在至少一个实施例中,当网络908包括全球互联网时,网络地址是tcp/ip格式的ip地址,其可至少部分地将数据路由到电子邮件账户、网站或驻留在服务器上的其他互联网工具。在至少一个实施例中,驻留在网络服务器上的信息和服务可以通过域名(例如www.site.com)(其映射到网络服务器的ip地址)对客户端计算机的web浏览器可用。

125.在至少一个实施例中,多个客户端902、904和906经由相应的通信链路连接至网络908。在至少一个实施例中,这些客户端中的每一个可以经由任何期望形式的通信(诸如经由拨号调制解调器连接、电缆链路、数字用户线(dsl)、无线或卫星链路、或任何其他形式的通信)来访问网络908。在至少一个实施例中,每个客户端可以使用与网络908兼容的任何机器(例如,个人计算机(pc)、工作站、专用终端、个人数据助理(pda)或其他类似的设备)进行通信。在至少一个实施例中,客户端902、904和906可以位于或可以不位于相同的地理区域中。

126.在至少一个实施例中,多个服务器910、912和914连接到网络918以服务于与网络918通信的客户端。在至少一个实施例中,每个服务器通常是管理网络资源并对客户端命令作出响应的强大的计算机或设备。在至少一个实施例中,服务器包括存储程序指令和数据的计算机可读数据存储介质,诸如硬盘驱动器和ram存储器。在至少一个实施例中,服务器910、912、914运行响应于客户端命令的应用程序。在至少一个实施例中,服务器910可以运行用于响应对html页面的客户端请求的web服务器应用,并且还可以运行用于接收和路由

电子邮件的邮件服务器应用。在至少一个实施例中,在服务器910上还可以运行其他应用程序,诸如用于将音频/视频数据流式传输至客户端的ftp服务器或媒体服务器。在至少一个实施例中,不同的服务器可以专用于执行不同的任务。在至少一个实施例中,服务器910可以是为不同用户管理与网站相关的资源的专用web服务器,而服务器912可以专用于提供电子邮件(email)管理。在至少一个实施例中,其他服务器可以专用于媒体(音频、视频等)、文件传输协议(ftp)或通常通过网络可用或提供的任何两个或更多个服务的组合。在至少一个实施例中,每个服务器可以在与其他服务器的位置相同或不同的位置中。在至少一个实施例中,可存在为用户执行镜像任务的多个服务器,从而减轻拥塞或最小化定向到和来自单个服务器的流量。在至少一个实施例中,服务器910、912、914在维护和通过网络918递送第三方内容的业务中的web托管提供者的控制下。

127.在至少一个实施例中,web托管提供商向两个不同类型的客户端递送服务。在至少一个实施例中,可被称为浏览器的一种类型从服务器910、912、914请求内容,诸如网页、电子邮件消息、视频剪辑等。在至少一个实施例中,第二类型(其可以被称为用户)雇佣web托管提供商来维护网络资源(诸如网站)并使其可用于浏览器。在至少一个实施例中,用户与web托管提供商签订合同,以根据用户期望利用的服务器资源的量使存储器空间、处理器容量和通信带宽可用于他们期望的网络资源。

128.在至少一个实施例中,为了使web托管提供商为这两个客户端提供服务,必须适当地配置管理由服务器托管的网络资源的应用程序。在至少一个实施例中,程序配置过程涉及定义参数集,所述参数集至少部分地控制应用程序对浏览器请求的响应,并且还至少部分地定义特定用户可用的服务器资源。

129.在一个实施例中,内联网服务器916经由通信链路与网络908通信。在至少一个实施例中,内联网服务器916与服务器管理器918通信。在至少一个实施例中,服务器管理器918包括在服务器910、912、914中使用的应用程序配置参数的数据库。在至少一个实施例中,用户经由内联网916修改数据库920,并且服务器管理器918与服务器910、912、914交互以修改应用程序参数,使得它们匹配数据库的内容。在至少一个实施例中,用户通过经由计算机902连接到内联网916并且输入诸如用户名和密码之类的认证信息来登录到内联网916。

130.在至少一个实施例中,当用户希望登录新服务或修改现有服务时,内联网服务器916对用户进行认证并向用户提供允许用户访问特定应用程序的配置参数的交互式屏幕显示/控制面板。在至少一个实施例中,向用户呈现描述用户的网站或其他网络资源的配置的方面的多个可修改文本框。在至少一个实施例中,如果用户期望增加在服务器上为其网站保留的存储器空间,则向用户提供其中用户指定期望的存储器空间的字段。在至少一个实施例中,响应于接收到该信息,内联网服务器916更新数据库920。在至少一个实施例中,服务器管理器918将该信息转发到适当的服务器,并且在应用程序操作期间使用新的参数。在至少一个实施例中,内联网服务器916被配置为向用户提供对用户已与web托管服务提供商签订的托管网络资源(例如,网页、电子邮件、ftp站点、媒体站点等)的配置参数的访问。

131.图10a示出了根据至少一个实施例的联网计算机系统1000a。在至少一个实施例中,联网计算机系统1000a包括多个节点或个人计算机(“pc”)1002、1018、1020。在至少一个实施例中,个人计算机或节点1002包括处理器1014、存储器1016、摄像机1004、麦克风1006、

鼠标1008、扬声器1010和监视器1012。在至少一个实施例中,pc 1002、1018、1020可以各自运行例如给定公司内的内部网络的一个或更多个桌面服务器,或者可以是不限于特定环境的通用网络的服务器。在至少一个实施例中,网络的每pc节点有一个服务器,使得网络的每个pc节点表示具有特定网络url地址的特定网络服务器。在至少一个实施例中,每个服务器默认为该服务器的用户的默认网页,该默认网页本身可包含指向该服务器上该用户的进一步子页面、或者指向网络上的其他服务器或其他服务器上的页面的嵌入式url。

132.在至少一个实施例中,节点1002、1018、1020和网络的其他节点经由介质1022互连。在至少一个实施例中,介质1022可以是诸如综合服务数字网(“isdn”)的通信信道。在至少一个实施例中,联网计算机系统的各个节点可以通过各种通信介质连接,包括局域网(“lan”)、简易老式电话线(“pots”)(有时被称为公共交换电话网络(“pstn”))、和/或其变体。在至少一个实施例中,网络的各个节点还可以构成经由诸如互联网之类的网络互连的计算机系统用户。在至少一个实施例中,(在给定实例处从网络的特定节点运行的)网络上的每个服务器在网络内具有唯一地址或标识,该唯一地址或标识可以根据url指定。

133.在至少一个实施例中,多个多点会议单元(“mcu”)因此可以用于向会议系统的各个节点或“端点”和从会议系统的各个节点或“端点”传输数据。在至少一个实施例中,除了各种其他通信介质(诸如,通过互联网连接的节点)之外,节点和/或mcu可经由isdn链路或通过局域网(“lan”)互连。在至少一个实施例中,会议系统的节点通常可以直接连接到通信介质(诸如lan)或通过mcu连接,并且会议系统可以包括其他节点或元件,诸如路由器、服务器和/或其变体。

134.在至少一个实施例中,处理器1014是通用可编程处理器。在至少一个实施例中,联网计算机系统1000a的节点的处理器还可以是专用视频处理器。在至少一个实施例中,节点的不同外围设备和组件(诸如节点1002的那些)可以与其他节点的那些不同。在至少一个实施例中,节点1018和节点1020可以被配置为与节点1002相同或不同。在至少一个实施例中,除了pc系统之外,节点还可以在任何合适的计算机系统上实现。

135.图10b示出了根据至少一个实施例的联网计算机系统1000b。在至少一个实施例中,系统1000b示出了网络(诸如lan 1024),该网络可以用于互连可以彼此通信的各种节点。在至少一个实施例中,附接到lan1024的是多个节点,诸如pc节点1026、1028、1030。在至少一个实施例中,节点还可经由网络服务器或其他装置连接到lan。在至少一个实施例中,系统1000b包括其他类型的节点或元件,针对至少一个实施例,其包括路由器、服务器和节点。

136.图10c示出根据至少一个实施例的联网计算机系统1000c。在至少一个实施例中,系统1000c示出了具有跨主干通信网络(诸如互联网1032)的通信的www系统,主干通信网络可用于互连网络的各种节点。在至少一个实施例中,www是在互联网的顶部上操作的一组协议,并且允许图形界面系统在其上操作以便通过互联网访问信息。在至少一个实施例中,附接到www中的互联网1032的是多个节点,例如pc 1040、1042、1044。在至少一个实施例中,节点通过www http服务器(诸如服务器1034、1036)与www的其他节点对接。在至少一个实施例中,pc 1044可以是形成网络1032的节点的pc,并且pc 1044本身运行它的服务器1036,尽管为了说明的目的在图10c中单独地示出pc 1044和服务器1036。

137.在至少一个实施例中,www是一种分布式类型的应用程序,其特征为www http、www

的协议,它在互联网的传输控制协议/互联网协议(“tcp/ip”)的顶部上运行。在至少一个实施例中,www因此可以由在互联网上运行的一组协议(即,http)作为其“主干”来表征。

138.在至少一个实施例中,web浏览器是在兼容www类型的网络系统中在网络的节点上运行的应用程序,其允许特定服务器或节点的用户查看这样的信息,并因此允许用户搜索使用嵌入在从理解http的网络上的服务器可获得的文档或文件中的超文本链接链接在一起的图形和基于文本的文件。在至少一个实施例中,当用户使用诸如互联网之类的网络上的另一服务器来检索与第一节点相关联的第一服务器的给定网页时,所检索到的文档可具有嵌入在其中的不同超文本链接,并且在检索用户的本地创建页面的本地副本。在至少一个实施例中,当用户点击超文本链接时,与所选择的超文本链接相关的本地存储的信息通常足以允许用户的机器打开通过互联网到由超文本链接指示的服务器的连接。

139.在至少一个实施例中,多于一个用户可通过lan(诸如lan 1038,诸如关于www http服务器1034所示)耦合到每个http服务器。在至少一个实施例中,系统1000c还可以包括其他类型的节点或元件。在至少一个实施例中,www http服务器是在诸如pc的机器上运行的应用。在至少一个实施例中,每个用户可以被认为具有唯一的“服务器”,如关于pc 1044所示。在至少一个实施例中,服务器可以被认为是诸如www http服务器1034之类的服务器,该服务器为lan或多个节点或多个lan提供对网络的访问。在至少一个实施例中,存在多个用户,每个用户具有台式pc或网络的节点,每个台式pc潜在地为其用户建立服务器。在至少一个实施例中,每个服务器与特定网络地址或url相关联,当被访问时,该特定网络地址或url为该用户提供默认网页。在至少一个实施例中,网页可以包含进一步的链接(嵌入式url),其指向该服务器上的该用户的进一步的子页面,或者指向网络上的其他服务器或者指向网络上的其他服务器上的页面。

140.云计算和服务

141.以下附图阐述但不限于可以用于实现至少一个实施例的示例性的基于云的系统。

142.在至少一个实施例中,云计算是一种计算风格,其中动态可扩展和通常虚拟化的资源作为服务通过互联网来提供。在至少一个实施例中,用户不需要具有支持他们的技术基础设施的知识、技术基础设施的专业知识或对技术基础设施的控制,该技术基础设施可以被称为“在云中”。在至少一个实施例中,云计算将基础设施合并为服务、平台即服务、软件即服务、以及具有依赖于互联网的常见主题以满足用户的计算需求的其他变型。在至少一个实施例中,典型的云部署(诸如在私有云(例如,企业网络)中)或公共云(例如,互联网)中的数据中心(dc)可由数千个服务器(或可替代地,vm)、数百个以太网、光纤信道或以太网光纤信道(fcoe)端口、交换和存储基础设施等组成。在至少一个实施例中,云还可以由网络服务基础设施组成,如ipsec vpn集线器、防火墙、负载平衡器、广域网(wan)优化器等。在至少一个实施例中,远程订户可以通过经由vpn隧道(如ipsec vpn隧道)连接来安全地访问云应用和服务。

143.在至少一个实施例中,云计算是一种用于使能对可配置计算资源(例如,网络、服务器、存储装置、应用程序和服务)的共享池的方便、按需的网络访问的模型,所述可配置计算资源可以用最小的管理努力或服务提供商交互来快速配置和释放。

144.在至少一个实施例中,云计算的特征在于按需自助服务,其中消费者可根据需要自动地单方面供应计算能力,诸如服务器时间和网络存储,而无需与每个服务提供商的人

类互动。在至少一个实施例中,云计算的特征在于广泛的网络访问,其中能力在网络上可用并且通过标准机制来访问,所述标准机制促进由异构的瘦或厚客户端平台(例如,移动电话、膝上型计算机和pda)的使用。在至少一个实施例中,云计算的特征在于资源池,其中提供商的计算资源被池化以使用多租户模型服务于多个消费者,其中不同的物理和虚拟资源根据消费者需求被动态地签名和重新分配。在至少一个实施例中,存在位置独立性的感觉,因为消费者通常对所提供的资源的确切位置没有控制或知识,但可能能够在较高抽象级别(例如,国家、州或数据中心)指定位置。

145.在至少一个实施例中,资源包括存储、处理、存储器、网络带宽和虚拟机。在至少一个实施例中,云计算的特征在于快速弹性,其中能力可被快速且弹性地供应(在一些情况下是自动地),以快速缩小和快速释放以快速放大。在至少一个实施例中,对于消费者,可用于供应的能力通常显得不受限制并且可以在任何时间以任何数量购买。在至少一个实施例中,云计算由测量的服务来表征,其中云系统通过在适合于服务类型(例如,存储、处理、带宽和活动用户账户)的某种抽象级别处利用计量能力来自动地控制和优化资源使用。在至少一个实施例中,资源使用可以被监控、控制和报告,从而为所利用的服务的提供商和消费者两者提供透明度。

146.在至少一个实施例中,云计算可与各种服务相关联。在至少一个实施例中,云软件即服务(saas)可以指代提供给消费者的能力是使用在云基础设施上运行的提供商的应用的服务。在至少一个实施例中,应用可通过诸如web浏览器(例如,基于web的电子邮件)的瘦客户端接口从不同客户端设备访问。在至少一个实施例中,消费者不管理或控制包括网络、服务器、操作系统、存储或甚至各个应用能力的底层云基础结构,可能的例外是有限的用户特定的应用配置设置。

147.在至少一个实施例中,云平台即服务(paas)可以指这样的服务:其中提供给消费者的能力是将消费者创建或获取的应用程序部署到云基础设施上,这些应用程序是使用由提供商支持的编程语言和工具创建的。在至少一个实施例中,消费者不管理或控制包括网络、服务器、操作系统或存储的底层云基础结构,但是具有对所部署的应用程序以及可能的应用托管环境配置的控制。

148.在至少一个实施例中,云基础设施即服务(iaas)可以指这样的服务:其中向消费者提供的能力是提供处理、存储、网络和消费者能够部署和运行可包括操作系统和应用的任意软件的其他基本计算资源。在至少一个实施例中,消费者不管理或控制底层云基础设施,而是具有对操作系统、存储、所部署的应用程序的控制,以及对选择的联网组件(例如,主机防火墙)的可能有限的控制。

149.在至少一个实施例中,可以不同方式部署云计算。在至少一个实施例中,私有云可指仅针对组织操作的云基础设施。在至少一个实施例中,私有云可由组织或第三方管理,并且可存在于场所内或场所外。在至少一个实施例中,社区云可以指由若干组织共享并且支持具有共享关注(例如,任务、安全要求、策略和合规性考虑)的特定社区的云基础设施。在至少一个实施例中,社区云可由组织或第三方管理,并且可存在于场所内或场所外。在至少一个实施例中,公共云可以指代对一般公众或大型产业组可用并且由提供云服务的组织拥有的云基础设施。在至少一个实施例中,混合云可以指云基础设施是两个或更多个云(私有、社区或公共的)的组成部分,这些云仍然是唯一的实体,但是通过实现数据和应用便携

性的标准化或专有技术(例如,用于云之间的负载平衡的云突发)绑定在一起。在至少一个实施例中,云计算环境是面向服务的,其关注于无状态性、低耦合、模块性和语义互操作性。

150.图11示出根据至少一个实施例的系统环境1100的一个或更多个组件,其中服务可被提供为第三方网络服务。在至少一个实施例中,第三方网络可被称为云、云网络、云计算网络和/或其变体。在至少一个实施例中,系统环境1100包括一个或更多个客户端计算设备1104、1106和1108,客户端计算设备1104、1106和1108可被用户用来与提供第三方网络服务(其可被称为云计算服务)的第三方网络基础设施系统1102交互。在至少一个实施例中,第三方网络基础设施系统1102可包括一个或更多个计算机和/或服务器。

151.应了解,图11中所描绘的第三方网络基础设施系统1102可具有除了所描绘的那些组件之外的其他组件。进一步地,图11描绘了第三方网络基础设施系统的实施例。在至少一个实施例中,第三方网络基础设施系统1102可具有比图11中描绘的更多或更少的组件,可组合两个或更多个组件,或可具有不同的组件配置或布置。

152.在至少一个实施例中,客户端计算设备1104、1106和1108可被配置成操作客户端应用,诸如web浏览器,可由客户端计算设备的用户用来与第三方网络基础设施系统1102交互以使用由第三方网络基础设施系统1102提供的服务的专有客户端应用或一些其他应用。尽管示例性系统环境1100被示为具有三个客户端计算设备,但是可以支持任何数量的客户端计算设备。在至少一个实施例中,其他设备,诸如具有传感器的设备等,可与第三方网络基础设施系统1102交互。在至少一个实施例中,一个或更多个网络1110可以促进客户端计算设备1104、1106和1108与第三方网络基础设施系统1102之间的通信和数据交换。

153.在至少一个实施例中,由第三方网络基础设施系统1102提供的服务可包括按需可用于第三方网络基础设施系统的用户的服务的主机。在至少一个实施例中,还可以提供各种服务,包括但不限于在线数据存储和备份解决方案、基于web的电子邮件服务、托管的办公套件和文档协作服务、数据库管理和处理、管理的技术支持服务、和/或其变体。在至少一个实施例中,由第三方网络基础设施系统提供的服务可以动态地扩展以满足其用户的需要。

154.在至少一个实施例中,由第三方网络基础设施系统1102提供的服务的特定实例化可被称为“服务实例”。在至少一个实施例中,通常,经由通信网络(诸如互联网)从第三方网络服务提供商系统对用户可用的任何服务被称为“第三方网络服务”。在至少一个实施例中,在公共第三方网络环境中,组成第三方网络服务提供商系统的服务器和系统不同于客户自己的场所内服务器和系统。在至少一个实施例中,第三方网络服务提供商系统可以托管应用,并且用户可以经由通信网络(诸如互联网)按需订购和使用应用。

155.在至少一个实施例中,计算机网络第三方网络基础设施中的服务可包括对存储、托管数据库、托管网络服务器、软件应用或由第三方网络供应商提供给用户的其他服务的受保护的计算机网络访问。在至少一个实施例中,服务可包括通过互联网对第三方网络上的远程存储装置的密码保护的访问。在至少一个实施例中,服务可以包括基于网络服务的托管关系数据库和脚本语言中间件引擎,以便由联网开发者私人使用。在至少一个实施例中,服务可包括对托管在第三方网络供应商的网站上的电子邮件软件应用的访问。

156.在至少一个实施例中,第三方网络基础设施系统1102可包括以自助、基于订阅、可弹性扩展、可靠、高度可用和安全方式递送给客户的一套应用、中间件和数据库服务提供

物。在至少一个实施例中,第三方网络基础设施系统1102还可以提供“大数据”相关的计算和分析服务。在至少一个实施例中,术语“大数据”通常用于指可以由分析师和研究人员存储和操纵的极大数据集,以便使大量数据可视化、检测趋势、和/或以其他方式与数据交互。在至少一个实施例中,大数据和相关应用可以由基础设施系统在许多级别上和以不同规模托管和/或操纵。在至少一个实施例中,并行链接的数十个、数百个或数千个处理器可对此类数据起作用以便呈现该数据或模拟对数据或其所表示的内容的外力。在至少一个实施例中,这些数据集可涉及结构化数据(诸如在数据库中或以其他方式根据结构化模型组织的结构化数据)和/或非结构化数据(例如,电子邮件、图像、数据blob(二进制大对象)、网页、复杂事件处理)。在至少一个实施例中,通过利用实施例的能力来将更多(或更少)计算资源相对快速地聚焦到目标上,第三方网络基础设施系统可以更好地可用于基于来自企业、政府机构、研究组织、私人个人、想法相同的个人或组织的组、或其他实体的需求在大数据集上执行任务。

157.在至少一个实施例中,第三方网络基础设施系统1102可以被适配成自动地提供、管理和跟踪顾客对由第三方网络基础设施系统1102提供的服务的订阅。在至少一个实施例中,第三方网络基础设施系统1102可以经由不同的部署模型提供第三方网络服务。在至少一个实施例中,可在公共第三方网络模型下提供服务,其中第三方网络基础设施系统1102由销售第三方网络服务的组织拥有,并且使得服务可用于一般公众或不同的行业企业。在至少一个实施例中,可在私有第三方网络模型下提供服务,在该私有第三方网络模型中,第三方网络基础设施系统1102仅针对单个组织操作,并且可为组织内的一个或更多个实体提供服务。在至少一个实施例中,第三方网络服务也可在社区第三方网络模型下提供,其中第三方网络基础设施系统1102和第三方网络基础设施系统1102提供的服务由相关社区中的若干组织共享。在至少一个实施例中,也可在混合第三方网络模型下提供第三方网络服务,该混合第三方网络模型是两个或更多个不同模型的组合。

158.在至少一个实施例中,由第三方网络基础设施系统1102提供的服务可包括在软件即服务(saas)类别、平台即服务(paas)类别、基础设施即服务(iaas)类别或包括混合服务的其他服务类别下提供的一个或更多个服务。在至少一个实施例中,客户经由订阅订单可订购由第三方网络基础设施系统1102提供的一个或更多个服务。在至少一个实施例中,第三方网络基础设施系统1102然后执行处理以在客户的订阅订单中提供服务。

159.在至少一个实施例中,由第三方网络基础设施系统1102提供的服务可以包括但不限于应用服务、平台服务和基础设施服务。在至少一个实施例中,应用服务可由第三方网络基础设施系统经由saas平台提供。在至少一个实施例中,saas平台可被配置为提供属于saas类别的第三方网络服务。在至少一个实施例中,saas平台可以提供在集成开发和部署平台上构建并递送一套按需应用的能力。在至少一个实施例中,saas平台可以管理和控制用于提供saas服务的底层软件和基础设施。在至少一个实施例中,通过利用由saas平台提供的服务,客户可利用在第三方网络基础设施系统上执行的应用。在至少一个实施例中,客户可以获得应用服务,而不需要客户购买单独的许可证和支持。在至少一个实施例中,可提供各种不同的saas服务。在至少一个实施例中,这可以包括但不限于为大组织的销售性能管理、企业集成和商业灵活性提供解决方案的服务。

160.在至少一个实施例中,平台服务可由第三方网络基础设施系统1102经由paas平台

提供。在至少一个实施例中,paas平台可被配置为提供属于paas类别的第三方网络服务。在至少一个实施例中,平台服务可以包括但不限于使组织能够将现有应用合并在共享的公共架构上的服务,以及建立利用由平台提供的共享服务的新应用的能力。在至少一个实施例中,paas平台可以管理和控制用于提供paas服务的底层软件和基础设施。在至少一个实施例中,客户可获取由第三方网络基础设施系统1102提供的paas服务,而无需客户购买单独的许可证和支持。

161.在至少一个实施例中,通过利用由paas平台提供的服务,客户可采用由第三方网络基础设施系统支持的编程语言和工具,并且还控制所部署的服务。在至少一个实施例中,由第三方网络基础设施系统提供的平台服务可包括数据库第三方网络服务、中间件第三方网络服务和第三方网络服务。在至少一个实施例中,数据库第三方网络服务可支持共享服务部署模型,所述共享服务部署模型使组织能够汇聚数据库资源并以数据库第三方网络的形式向客户提供数据库即服务。在至少一个实施例中,在第三方网络基础设施系统中,中间件第三方网络服务可以为客户提供平台以开发和部署不同业务应用,并且第三方网络服务可以为客户提供平台以部署应用。

162.在至少一个实施例中,各种不同的基础设施服务可由第三方网络基础设施系统中的iaas平台提供。在至少一个实施例中,基础设施服务促进利用由saas平台和paas平台提供的服务的客户对底层计算资源(诸如存储、网络和其他基础计算资源)的管理和控制。

163.在至少一个实施例中,第三方网络基础设施系统1102还可包括用于提供用于向第三方网络基础设施系统的客户提供各种服务的资源的基础设施资源1130。在至少一个实施例中,基础设施资源1130可包括硬件(诸如服务器、存储和联网资源)的预集成和优化的组合,用于执行由paas平台和saas平台提供的服务和其他资源。

164.在至少一个实施例中,第三方网络基础设施系统1102中的资源可由多个用户共享并且按照需求动态地重新分配。在至少一个实施例中,可以向不同时区中的用户分配资源。在至少一个实施例中,第三方网络基础设施系统1102可以使得第一时区中的第一组用户能够利用第三方网络基础设施系统的资源持续指定小时数,并且随后使得能够将相同资源重新分配给位于不同时区中的另一组用户,从而使资源利用率最大化。

165.在至少一个实施例中,可提供由第三方网络基础设施系统1102的不同组件或模块共享的多个内部共享服务1132,用于实现由第三方网络基础设施系统1102提供服务。在至少一个实施例中,这些内部共享服务可包括但不限于安全和身份服务、集成服务、企业库服务、企业管理器服务、病毒扫描和白名单服务、高可用性、备份和恢复服务、用于使能第三方网络支持的服务、电子邮件服务、通知服务、文件传输服务和/或其变体。

166.在至少一个实施例中,第三方网络基础设施系统1102可在第三方网络基础设施系统中提供第三方网络服务(例如,saas、paas和iaas服务)的全面管理。在至少一个实施例中,第三方网络管理功能可包括用于供应、管理和跟踪由第三方网络基础设施系统1102接收的客户的订阅的能力和/或其变体。

167.在至少一个实施例中,如图11所示,第三方网络管理功能可以由一个或更多个模块提供,诸如订单管理模块1120、订单协调模块1122、订单供应模块1124、订单管理和监控模块1126和身份管理模块1128。在至少一个实施例中,这些模块可包括一个或更多个计算机和/或服务器或使用一个或更多个计算机和/或服务器来提供,所述一个或更多个计算机

和/或服务器可以是通用计算机、专用服务器计算机、服务器农场、服务器集群或任何其他适当的布置和/或组合。

168.在至少一个实施例中,在步骤1134,使用客户端设备(诸如客户端计算设备1104、1106或1108)的客户可通过请求由第三方网络基础设施系统1102提供的一个或更多个服务并对由第三方网络基础设施系统1102提供的一个或更多个服务的订阅下订单来与第三方网络基础设施系统1102交互。在至少一个实施例中,客户可访问第三方网络用户界面(ui),诸如第三方网络ui 1112、第三方网络ui 1114和/或第三方网络ui 1116,并经由这些ui进行订购订单。在至少一个实施例中,由第三方网络基础设施系统1102响应于客户下订单而接收的订单信息可包括识别客户和由第三方网络基础设施系统1102提供的、客户想要订阅的一个或更多个服务的信息。

169.在至少一个实施例中,在步骤1136,从客户接收的订单信息可存储在订单数据库1118中。在至少一个实施例中,如果这是新订单,则可以为订单创建新记录。在至少一个实施例中,订单数据库1118可以是由第三方网络基础设施系统1118操作的并且结合其他系统元件操作的若干数据库之一。

170.在至少一个实施例中,在步骤1138,可以将订单信息转发到订单管理模块1120,该订单管理模块可以被配置成执行与订单相关的计费和记账功能,诸如验证订单,并且在验证后,预订一订单。

171.在至少一个实施例中,在步骤1140,关于订单的信息可被传送到订单协调模块1122,该订单协调模块1122被配置为针对由客户下的订单协调服务和资源的供应。在至少一个实施例中,订单协调模块1122可以使用订单供应模块1124的服务进行供应。在至少一个实施例中,订单协调模块1122使得能够管理与每个订单相关联的业务过程,并且应用业务逻辑来确定订单是否应继续供应。

172.在至少一个实施例中,在步骤1142,当接收到新订阅的订单时,订单协调模块1122向订单供应模块1124发送分配资源和配置满足订阅订单所需的资源的请求。在至少一个实施例中,订单供应模块1124实现针对由客户订购的服务的资源分配。在至少一个实施例中,订单供应模块1124提供由第三方网络基础设施系统1100提供的第三方网络服务与用于供应用于提供所请求的服务的资源的物理实现层之间的抽象级别。在至少一个实施例中,这使得订单协调模块1122能够与实现细节隔离,诸如服务和资源实际上是实时供应的,还是预先供应的并且仅在请求时分配/指派。

173.在至少一个实施例中,在步骤1144,一旦服务和资源被供应,可以向订阅客户发送指示所请求的服务现在准备好使用的通知。在至少一个实施例中,信息(例如,链接)可以被发送到客户,其使客户能够开始使用所请求的服务。

174.在至少一个实施例中,在步骤1146,客户订阅的订单可由订单管理和监控模块1126管理和跟踪。在至少一个实施例中,订单管理和监控模块1126可以被配置成收集关于订阅服务的客户使用的使用统计。在至少一个实施例中,可以针对所使用的存储量、所传输的数据量、用户数量、以及系统上电时间和系统下电时间的量和/或其变化来收集统计。

175.在至少一个实施例中,第三方网络基础设施系统1100可包括身份管理模块1128,该身份管理模块1128被配置成提供身份服务,诸如第三方网络基础设施系统1100中的访问管理和授权服务。在至少一个实施例中,身份管理模块1128可控制关于希望利用由第三方

网络基础设施系统1102提供的服务的客户的信息。在至少一个实施例中,这样的信息可以包括认证这样的客户的身份的信息和描述那些客户被授权相对于各种系统资源(例如,文件、目录、应用、通信端口、存储器段等)执行哪些动作的信息。在至少一个实施例中,身份管理模块1128还可包括管理关于每个顾客的描述性信息以及关于可如何访问和修改该描述性信息和可由谁来访问和修改该描述性信息。

176.图12示出了根据至少一个实施例的云计算环境1202。在至少一个实施例中,云计算环境1202包括一个或更多个计算机系统/服务器1204,诸如个人数字助理(pda)或蜂窝电话1206a、台式计算机1206b、膝上型计算机1206c和/或汽车计算机系统1206n之类的计算设备与该一个或更多个计算机系统/服务器1204通信。在至少一个实施例中,这允许基础设施、平台和/或软件作为服务从云计算环境1202提供,以便不需要每个客户端单独地维护这样的资源。应当理解,图12中示出的计算设备1206a-n的类型旨在仅是说明性的,并且云计算环境1202可通过任何类型的网络和/或网络/可寻址连接(例如,使用web浏览器)与任何类型的计算机化设备通信。

177.在至少一个实施例中,可被表示为云计算节点的计算机系统/服务器1204可与许多其他通用或专用计算系统环境或配置一起操作。在至少一个实施例中,可以适合于与计算机系统/服务器1204一起使用的计算系统、环境和/或配置包括但不限于个人计算机系统、服务器计算机系统、瘦客户机、厚客户端、手持式或膝上型设备、多处理器系统、基于微处理器的系统、机顶盒、可编程消费电子产品,网络pc、小型计算机系统、大型计算机系统和包括任何上述系统或设备的分布式云计算环境,和/或其变体。

178.在至少一个实施例中,计算机系统/服务器1204可以在由计算机系统执行的计算机系统可执行指令(诸如程序模块)的一般上下文中描述。在至少一个实施例中,程序模块包括执行特定任务或实现特定抽象数据类型的例程、程序、对象、组件、逻辑、数据结构等。在至少一个实施例中,示例性计算机系统/服务器1204可以在分布式云计算环境中实践,其中任务由通过通信网络链接的远程处理设备来执行。在至少一个实施例中,在分布式云计算环境中,程序模块可位于包括存储器存储设备的本地和远程计算机系统存储介质两者中。

179.图13示出了根据至少一个实施例的由云计算环境1202(图12)提供的一组功能抽象层。应提前理解,图13中所示的组件、层和功能仅旨在是说明性的,并且组件、层和功能可以变化。

180.在至少一个实施例中,硬件和软件层1302包括硬件和软件组件。在至少一个实施例中,硬件组件包括大型机、基于各种risc(精简指令集计算机)架构的服务器、各种计算系统、超级计算系统、存储设备、网络、联网组件和/或其变体。在至少一个实施例中,软件组件包括网络应用服务器软件、各种应用服务器软件、各种数据库软件、和/或其变体。

181.在至少一个实施例中,虚拟化层1304提供抽象层,从该抽象层可以提供以下示例性虚拟实体:虚拟服务器、虚拟存储、虚拟网络(包括虚拟私有网络)、虚拟应用、虚拟客户端和/或其变体。

182.在至少一个实施例中,管理层1306提供各种功能。在至少一个实施例中,资源供应提供用于在云计算环境内执行任务的计算资源和其他资源的动态获取。在至少一个实施例中,计量(metering)提供了在云计算环境内利用资源时的使用跟踪,以及针对这些资源的

消耗的计费或发票。在至少一个实施例中,资源可以包括应用软件许可证。在至少一个实施例中,安全性为用户和任务提供身份验证,以及对数据和其他资源的保护。在至少一个实施例中,用户界面为用户和系统管理员两者提供对云计算环境的访问。在至少一个实施例中,服务水平管理提供云计算资源分配和管理,使得满足所需的服务水平。在至少一个实施例中,服务水平协议(sla)管理提供云计算资源的预布置和获取,根据sla预期对该云计算资源的未来需求。

183.在至少一个实施例中,工作负载层1308提供利用云计算环境的功能。在至少一个实施例中,可以从该层提供的工作负载和功能包括:地图和导航、软件开发和管理、教育服务、数据分析和处理、交易处理和服务递送。

184.超级计算

185.以下附图阐述了但不限于可以用于实现至少一个实施例的示例性的基于超级计算机的系统。

186.在至少一个实施例中,超级计算机可以指展现出显著并行性并且包括至少一个芯片的硬件系统,其中系统中的芯片通过网络互连并且被放置在分层组织的外壳中。在至少一个实施例中,用若干机架填充机房的大型硬件系统是超级计算机的至少一个实施例,每个机架包含若干板/机架模块,每个板/机架模块包含全部由可扩展网络互连的若干芯片。在至少一个实施例中,这种大型硬件系统的单个机架是超级计算机的至少一个其他实施例。在至少一个实施例中,展现出显著并行性并且包含若干硬件组件的单个芯片同样可以被认为是超级计算机,因为随着特征尺寸可能减小,可以结合在单个芯片中的硬件数量也可能增加。

187.图14示出了根据至少一个实施例的芯片级的超级计算机。在至少一个实施例中,在fpga或asic芯片内部,在被称为线程单元的有限状态机(1404)内执行主计算。在至少一个实施例中,任务和同步网络(1402)连接有限状态机并且被用于以正确的顺序分派线程和执行操作。在至少一个实施例中,使用存储器网络(1406,1410)来访问多级分区的片上高速缓存层级(1408,1412)。在至少一个实施例中,使用存储器控制器(1416)和片外存储器网络(1414)来访问片外存储器。在至少一个实施例中,当设计不适合于单个逻辑芯片时,i/o控制器(1418)用于跨芯片通信。

188.图15示出根据至少一个实施例的在机架模块级别的超级计算机。在至少一个实施例中,在机架模块内,存在连接至构成主加速器存储器的一个或更多个dram单元(1504)的多个fpga或asic芯片(1502)。在至少一个实施例中,每个fpga/asic芯片使用板上的宽总线用差分高速信令(1506)连接到其相邻的fpga/asic芯片。在至少一个实施例中,每个fpga/asic芯片还连接到至少一个高速串行通信电缆。

189.图16示出了根据至少一个实施例的机架级的超级计算机。图17示出了根据至少一个实施例的整个系统级的超级计算机。在至少一个实施例中,参见图16和图17,在机架中的机架模块之间并且跨整个系统的机架,使用高速串行光缆或铜电缆(1602,1702)来实现可扩展的、可能不完整的超立方体网络。在至少一个实施例中,加速器的fpga/asic芯片中的一个通过pci-express连接被连接到主机系统(1704)。在至少一个实施例中,主机系统包括应用的软件部分在其上运行的主机微处理器(1708)以及由与加速器上的存储器保持一致的一个或更多个主机存储器dram单元(1706)组成的存储器。在至少一个实施例中,主机系

统可以是机架之一上的单独模块,或可以与超级计算机的模块之一集成。在至少一个实施例中,立方体连接的循环拓扑提供通信链路以为大型超级计算机创建超立方体网络。在至少一个实施例中,机架模块上的小组fpga/asic芯片可充当单个超立方体节点,使得与单个芯片相比,每组的外部链路的总数增加。在至少一个实施例中,组包含机架模块上的芯片a、b、c和d,该机架模块具有连接环形组织中的a、b、c和d的内部宽差分总线。在至少一个实施例中,存在将机架模块连接到外部世界的12条串行通信电缆。在至少一个实施例中,机架模块上的芯片a连接至串行通信电缆0、1、2。在至少一个实施例中,芯片b连接至电缆3、4、5。在至少一个实施例中,芯片c连接至6、7、8。在至少一个实施例中,芯片d连接至9、10、11。在至少一个实施例中,构成机架模块的整个组{a,b,c,d}可以形成超级计算机系统内的超立方体节点,其中多达212=4096个机架模块(16384fpga/asic芯片)。在至少一个实施例中,为了使芯片a在组{a,b,c,d}的链路4上向外发送消息,必须首先用板上差分宽总线连接将消息路由到芯片b。在至少一个实施例中,在链路4上到达去往芯片a的组{a,b,c,d}(即,到达b)的消息也必须首先被路由到组{a,b,c,d}内部的正确目的地芯片(a)。在至少一个实施例中,还可以实现其他大小的并行超级计算机系统。

190.人工智能

191.以下附图阐述了但不限于可以用于实现至少一个实施例的示例性的基于人工智能的系统。

192.图18a示出了用于执行与一个或更多个实施例相关联的推理和/或训练操作的推理和/或训练逻辑1815。下面结合图18a和/或图18b提供关于推理和/或训练逻辑1815的细节。

193.在至少一个实施例中,推理和/或训练逻辑1815可以包括但不限于,代码和/或数据存储1801,用于存储前向和/或输出权重和/或输入/输出数据,和/或在一个或更多个实施例的各方面中用于配置被训练和/或用于推理的神经网络的神经元或层的其他参数。在至少一个实施例中,训练逻辑1815可以包括或被耦合到代码和/或数据存储1801,用于存储图形代码或其他软件以控制定时和/或顺序,其中将加载权重和/或其他参数信息来配置逻辑,包括整数和/或浮点单元(统称为算术逻辑单元(alu))。在至少一个实施例中,代码(诸如图代码)基于这样的代码所对应的神经网络的架构将权重或其他参数信息加载到处理器alu中。在至少一个实施例中,代码和/或数据存储1801存储神经网络的每个层的权重参数和/或输入/输出数据,该神经网络在使用一个或更多个实施例的各方面的训练和/或推理期间在输入/输出数据和/或权重参数的前向传播期间与一个或更多个实施例结合训练或使用。在至少一个实施例中,代码和/或数据存储1801的任何部分可与其他片上或片外数据存储装置一起被包括,包括处理器的l1、l2或l3高速缓存存储器或系统存储器。

194.在至少一个实施例中,代码和/或数据存储1801的任何部分可在一个或更多个处理器或其他硬件逻辑设备或电路内部或外部。在至少一个实施例中,代码和/或代码和/或数据存储1801可以是高速缓存存储器、动态随机可寻址存储器(“dram”)、静态随机可寻址存储器(“sram”)、非易失性存储器(例如,闪存)或其他存储装置。在至少一个实施例中,对代码和/或代码和/或数据存储1801是在处理器内部还是外部,在至少一个实施例中,或包括dram、sram、闪存或一些其他存储类型的选择,可以取决于片上相对于片外的可用存储,正在执行的训练和/或推理功能的延时要求、在神经网络的推理和/或训练中使用的数据的

批大小,或这些因素的一些组合。

195.在至少一个实施例中,推理和/或训练逻辑1815可以包括但不限于:代码和/或数据存储1805,用于存储与在一个或更多个实施例的各方面中被训练和/或用于推理的神经网络的神经元或层相对应的反向和/或输出权重和/或输入/输出数据。在至少一个实施例中,代码和/或数据存储1805存储神经网络的每一层的权重参数和/或输入/输出数据,该神经网络在使用一个或更多个实施例的各方面的训练和/或推理期间的输入/输出数据和/或权重参数的反后传播期间与一个或更多个实施例结合训练或使用。在至少一个实施例中,训练逻辑1815可以包括或被耦合到代码和/或数据存储1805,以存储图代码或其他软件来控制定时和/或顺序,其中将加载权重和/或其他参数信息以配置逻辑,包括整数和/或浮点单元(统称为算术逻辑单元(alu))。

196.在至少一个实施例中,代码(诸如图代码)使基于这样的代码所对应的神经网络的架构将权重或其他参数信息加载到处理器alu中。在至少一个实施例中,代码和/或数据存储1805的任何部分可与其他片上或片外数据存储包括在一起,包括处理器的l1、l2或l3高速缓存或系统存储器。在至少一个实施例中,代码和/或数据存储1805的任何部分可以在一个或更多个处理器或其他硬件逻辑设备或电路的内部或外部。在至少一个实施例中,代码和/或数据存储1805可以是高速缓存存储器、dram、sram、非易失性存储器(例如,闪存)或其他存储装置。在至少一个实施例中,对代码和/或数据存储1805是在处理器内部还是外部,在至少一个实施例中,或包括dram、sram、闪存或一些其他存储类型的选择,可以取决于片上相对于片外的可用存储,正在执行的训练和/或推理功能的延时要求、在神经网络的推理和/或训练中使用的数据的批大小,或这些因素的一些组合。

197.在至少一个实施例中,代码和/或数据存储1801和代码和/或数据存储1805可为单独的存储结构。在至少一个实施例中,代码和/或数据存储1801和代码和/或数据存储1805可以是组合的存储结构。在至少一个实施例中,代码和/或数据存储1801和代码和/或数据存储1805可部分组合且部分分离。在至少一个实施例中,代码和/或数据存储1801和代码和/或数据存储1805的任何部分可与其他片上或片外数据存储(包括处理器的l1、l2或l3高速缓存或系统存储器)包括在一起。

198.在至少一个实施例中,推理和/或训练逻辑1815可以包括但不限于,一个或更多个算术逻辑单元(“alu”)1810,包括整数和/或浮点单元,用于至少部分地基于训练和/或推理代码(例如,图形代码)或由训练和/或推理代码(例如,图形代码)指示来执行逻辑和/或数学运算,其结果可以产生存储在激活存储1820中的激活(例如,来自神经网络内的层或神经元的输出值),所述激活存储是存储在代码和/或数据存储1801和/或代码和/或数据存储1805中的输入/输出和/或权重参数数据的函数。在至少一个实施例中,根据响应于执行指令或其他代码、由alu 1810执行的线性代数和/或基于矩阵的数学来生成存储在激活存储1820中的激活,其中存储在代码和/或数据存储1805和/或数据存储1801中的权重值与其他值(诸如偏置值、梯度信息、动量值或其他参数或超参数)一起被用作操作数,该其他值中的任何或全部值可被存储在代码和/或数据存储1805或代码和/或数据存储1801或芯片上或芯片外的另一存储中。

199.在至少一个实施例中,一个或更多个alu 1810被包括在一个或更多个处理器或其他硬件逻辑器件或电路内,而在另一个实施例中,一个或更多个alu 1810可以在处理器或

使用它们的其他硬件逻辑器件或电路(例如,协处理器)的外部。在至少一个实施例中,alu 1810可以被包括在处理器的执行单元内或者以其他方式在可由处理器的执行单元可访问的alu库内,所述处理器的执行单元在同一处理器内或分布在不同类型的不同处理器(例如,中央处理单元、图形处理单元、固定功能单元等)之间。在至少一个实施例中,代码和/或数据存储1801、代码和/或数据存储1805、以及激活存储1820可以共享处理器或其他硬件逻辑器件或电路,而在另一个实施例中,它们可以在不同的处理器或其他硬件逻辑器件或电路中,或在相同和不同处理器或其他硬件逻辑器件或电路的某种组合中。在至少一个实施例中,激活存储1820的任何部分可以与其他片上或片外数据存储包括在一起,所述其他片上或片外数据存储包括处理器的l1、l2或l3高速缓存或系统存储器。此外,推理和/或训练代码可与处理器或其他硬件逻辑或电路可访问并使用处理器的获取、解码、调度、执行、引退(retirement)和/或其他逻辑电路来获取和/或处理的其他代码一起存储。

200.在至少一个实施例中,激活存储1820可以是高速缓存存储器、dram、sram、非易失性存储器(例如,闪存)或其他存储装置。在至少一个实施例中,激活存储1820可以完全或部分地在一个或更多个处理器或其他逻辑电路之内或外部。在至少一个实施例中,对激活存储1820是在处理器内部还是外部,在至少一个实施例中,或包括dram、sram、闪存或一些其他存储类型的选择,可以取决于片上相对于片外的可用存储,正在执行的训练和/或推理功能的延时要求、在神经网络的推理和/或训练中使用的数据的批大小,或这些因素的一些组合。

201.在至少一个实施例中,图18a中所示出的推理和/或训练逻辑1815可以与专用集成电路(“asic”)结合使用,诸如来自谷歌的处理单元、来自graphcore

tm

的推理处理单元(ipu)、或来自英特尔公司的(例如,“lake crest”)处理器。在至少一个实施例中,图18a中所示出的推理和/或训练逻辑1815可以结合中央处理单元(“cpu”)硬件、图形处理单元(“gpu”)硬件或其他硬件(如现场可编程门阵列(“fpga”))使用。

202.图18b示出了根据至少一个实施例的推理和/或训练逻辑1815。在至少一个实施例中,推理和/或训练逻辑1815可包括但不限于其中计算资源是专用的或以其他方式结合与神经网络内的一个或更多个神经元层相对应的权重值或其他信息排他地使用的硬件逻辑。在至少一个实施例中,图18b中所示出的推理和/或训练逻辑1815可以结合专用集成电路(asic)(如来自谷歌的处理单元、来自graphcore

tm

的推理处理单元(ipu)、或来自英特尔公司的(例如,“lake crest”)处理器来使用。在至少一个实施例中,图18b中示出的推理和/或训练逻辑1815可结合中央处理单元(cpu)硬件、图形处理单元(gpu)硬件或其他硬件(诸如现场可编程门阵列(fpga))使用。在至少一个实施例中,推理和/或训练逻辑1815包括但不限于代码和/或数据存储1801以及代码和/或数据存储1805,其可以用于存储代码(例如,图代码)、权重值和/或其他信息,包括偏置值、梯度信息、动量值和/或其他参数或超参数信息。在图18b中所说明的至少一个实施例中,代码和/或数据存储1801和代码和/或数据存储1805中的每一者分别与专用计算资源(例如,计算硬件1802和计算硬件1806)相关联。在至少一个实施例中,计算硬件1802和计算硬件1806中的每一个包括一个或更多个alu,该一个或更多个alu仅分别对存储在代码和/或数据存储1801和代码和/或数据存储1805中的信息执行数学函数(诸如线性代数函数),其结果被存储在激活存

储1820中。

203.在至少一个实施例中,每个代码和/或数据存储1801和1805以及相应的计算硬件1802和1806,分别对应于神经网络的不同层,使得来自代码和/或数据存储1801和计算硬件1802中的一个存储/计算对1801/1802的结果激活作为输入被提供给代码和/或数据存储1805和计算硬件1806中的下一个存储/计算对1805/1806,以便镜像神经网络的概念组织。在至少一个实施例中,存储/计算对1801/1802和1805/1806中的每一个可对应于多于一个神经网络层。在至少一个实施例中,在存储/计算对1801/1802和1805/1806之后或与存储/计算对1801/1802和1805/1806并行的附加存储/计算对(未示出)可被包括在推理和/或训练逻辑1815中。

204.图19示出根据至少一个实施例的深度神经网络的训练和部署。在至少一个实施例中,使用训练数据集1902来训练未经训练的神经网络1906。在至少一个实施例中,训练框架1904是pytorch框架,而在其他实施例中,训练框架1904是tensorflow、boost、caffe、microsoft cognitive toolkit/cntk、mxnet、chainer、keras、deeplearning4j或其他训练框架。在至少一个实施例中,训练框架1904对未经训练的神经网络1906进行训练,并使其能够使用本文中所描述的处理资源来训练以生成经训练的神经网络1908。在至少一个实施例中,权重可以随机选择或通过使用深度信念网络进行预训练来选择。在至少一个实施例中,训练可以以监督、部分监督或无监督的方式来执行。

205.在至少一个实施例中,使用监督学习来训练未经训练的神经网络1906,其中训练数据集1902包括与用于输入的期望输出配对的输入,或者其中训练数据集1902包括具有已知输出的输入,并且神经网络1906的输出被手动地分级。在至少一个实施例中,以监督方式来训练未经训练的神经网络1906,并且处理来自训练数据集1902的输入,并将结果输出与预期或期望输出的集合进行比较。在至少一个实施例中,然后误差被反向传播通过未经训练的神经网络1906。在至少一个实施例中,训练框架1904调整控制未经训练的神经网络1906的权重。在至少一个实施例中,训练框架1904包括用于监视未经训练的神经网络1906朝向模型(诸如经训练的神经网络1908)收敛多好的工具,该模型适于基于输入数据(诸如新数据集1912)来生成正确答案(诸如结果1914)。在至少一个实施例中,训练框架1904重复地训练未经训练的神经网络1906,同时使用损失函数和调整算法(诸如随机梯度下降)来调整权重以精炼未经训练的神经网络1906的输出。在至少一个实施例中,训练框架1904训练未经训练的神经网络1906,直到未经训练的神经网络1906实现所期望的准确度。在至少一个实施例中,经训练的神经网络1908然后可被部署以实现任何数量的机器学习操作。

206.在至少一个实施例中,使用无监督学习来训练未经训练的神经网络1906,其中未经训练的神经网络1906尝试使用未标记的数据来训练其自身。在至少一个实施例中,无监督学习训练数据集1902将包括输入数据而没有任何相关联的输出数据或“地面真值”数据。在至少一个实施例中,未经训练的神经网络1906可以学习训练数据集1902内的分组,并且可以确定各个输入如何与未经训练的数据集1902相关。在至少一个实施例中,无监督训练可被用于在经训练的神经网络1908中生成能够执行在减少新数据集1912的维度中有用的操作的自组织映射。在至少一个实施例中,无监督训练还可用于执行异常检测,其允许识别新数据集1912中偏离新数据集1912的正常模式的数据点。

207.在至少一个实施例中,可以使用半监督学习,半监督学习是其中在训练数据集

1902中包括标记数据和未标记数据的混合的技术。在至少一个实施例中,训练框架1904可被用于执行增量学习,诸如通过转移学习技术。在至少一个实施例中,增量学习使得经训练的神经网络1908能够适应新的数据集1912,而不会忘记在初始训练期间注入在经训练的神经网络1408内的知识。

208.5g网络

209.以下附图阐述了但不限于可以用于实现至少一个实施例的示例性基于5g网络的系统。

210.图20示出了根据至少一个实施例的网络的系统2000的架构。在至少一个实施例中,系统2000被示为包括用户设备(ue)2002和ue 2004。在至少一个实施例中,ue 2002和2004被示为智能电话(例如,可连接到一个或更多个蜂窝网络的手持触摸屏移动计算设备),但还可包括任何移动或非移动计算设备,诸如个人数字助理(pda)、寻呼机、膝上型计算机、台式计算机、无线手持设备或包括无线通信接口的任何计算设备。

211.在至少一个实施例中,ue 2002和ue 2004中的任何一个可包括物联网(iot)ue,该iot ue可包括为利用短暂ue连接的低功率iot应用设计的网络接入层。在至少一个实施例中,iot ue可利用诸如用于经由公共陆地移动网络(plmn)、基于邻近的服务(prose)或设备到设备(d2d)通信、传感器网络或iot网络与mtc服务器或设备交换数据的技术,诸如机器对机器(m2m)或机器类型通信(mtc)。在至少一个实施例中,m2m或mtc数据交换可以是机器发起的数据交换。在至少一个实施例中,iot网络描述互连iot ue,该iot ue可包括具有短寿命连接的可唯一标识的嵌入式计算设备(在互联网基础结构内)。在至少一个实施例中,iot ue可执行后台应用(例如,保活消息、状态更新等)以促进iot网络的连接。

212.在至少一个实施例中,ue 2002和ue 2004可以被配置为与无线电接入网(ran)2016连接(例如,通信地耦合)。在至少一个实施例中,ran2016在至少一个实施例中可以是演进的通用移动电信系统(umts)陆地无线电接入网络(e-utran)、nextgen ran(ng ran)或一些其他类型的ran。在至少一个实施例中,ue 2002和ue 2004分别利用连接2012和连接2014,每个连接包括物理通信接口或层。在至少一个实施例中,连接2012和2014被示为空中接口,用于实现通信耦合,并且可以与蜂窝通信协议一致,诸如全球移动通信系统(gsm)协议,码分多址(cdma)网络协议、即按即讲(ptt)协议、蜂窝ptt(poc)协议、通用移动电信系统(umts)协议、3gpp长期演进(lte)协议、第五代(5g)协议、新无线电(nr)协议及其变型。

213.在至少一个实施例中,ue 2002和2004还可经由prose接口2006直接交换通信数据。在至少一个实施例中,prose接口2006可替代地被称为边链路接口,其包括一个或更多个逻辑信道,包括但不限于物理边链路控制信道(pscch)、物理边链路共享信道(pssch)、物理边链路发现信道(psdch)和物理边链路广播信道(psbch)。

214.在至少一个实施例中,ue 2004被示为配置成经由连接2008接入接入点(ap)2010。在至少一个实施例中,连接2008可以包括本地无线连接,诸如与任何ieee 802.11协议一致的连接,其中ap 2010将包括无线保真路由器。在至少一个实施例中,ap 2010被示为连接到互联网而不连接到无线系统的核心网。

215.在至少一个实施例中,ran 2016可包括启用连接2012和2014的一个或更多个接入节点。在至少一个实施例中,这些接入节点(an)可被称为基站(bs)、nodeb、演进型nodeb(enb)、下一代nodeb(gnb)、ran节点等,并且可包括地面站(例如,地面接入点)或提供地理

区域(例如,小区)内的覆盖的卫星站。在至少一个实施例中,ran 2016可包括用于提供宏蜂窝小区的一个或更多个ran节点(例如,宏ran节点2018)和用于提供毫微微蜂窝小区或微微蜂窝小区(例如,与宏蜂窝小区相比具有较小覆盖区域、较小用户容量、或较高带宽的蜂窝小区)的一个或更多个ran节点(例如,低功率(lp)ran节点2020)。

216.在至少一个实施例中,ran节点2018和2020中的任一个可终止空中接口协议并且可以为ue 2002和2004的第一联系点。在至少一个实施例中,ran节点2018和2020中的任一个可实现ran 2016的各种逻辑功能,包括但不限于无线电网络控制器(rnc)功能,诸如无线电承载管理、上行链路和下行链路动态无线电资源管理和数据分组调度和移动性管理。

217.在至少一个实施例中,ue 2002和ue 2004可被配置为使用正交频分复用(ofdm)通信信号根据各种通信技术通过多载波通信信道彼此通信或者与ran节点2018和ran节点2020中的任一个通信,通信技术诸如但不限于正交频分多址(ofdma)通信技术(例如,用于下行链路通信)或单载波频分多址(sc-fdma)通信技术(例如,用于上行链路和prose或边链路通信),和/或其变体。在至少一个实施例中,ofdm信号可包括多个正交子载波。

218.在至少一个实施例中,下行链路资源网格可以用于从ran节点2018和2020中的任一个到ue 2002和2004的下行链路传输,而上行链路传输可以利用类似的技术。在至少一个实施例中,网格可以是称为资源网格或时频资源网格的时频网格,其是每个时隙中下行链路中的物理资源。在至少一个实施例中,这种时频平面表示是ofdm系统的常见实践,这使得其对于无线电资源分配来说是直观的。在至少一个实施例中,资源网格的每列和每行分别对应于一个ofdm符号和一个ofdm子载波。在至少一个实施例中,时域中的资源网格的持续时间对应于无线电帧中的一个时隙。在至少一个实施例中,资源网格中的最小时间-频率单元被表示为资源元素。在至少一个实施例中,每个资源网格包括多个资源块,其描述某些物理信道到资源元素的映射。在至少一个实施例中,每个资源块包括资源元素的集合。在至少一个实施例中,在频域中,这可以表示当前可以被分配的最小数量的资源。在至少一个实施例中,存在使用这样的资源块传送的若干不同的物理下行链路信道。

219.在至少一个实施例中,物理下行链路共享信道(pdsch)可以运载用户数据和更高层信令给ue 2002和2004。在至少一个实施例中,物理下行链路控制信道(pdcch)可运载关于与pdsch信道相关的传输格式和资源分配的信息等。在至少一个实施例中,其还可以向ue 2002和2004通知与上行链路共享信道有关的传输格式、资源分配和harq(混合自动重传请求)信息。在至少一个实施例中,通常,下行链路调度(将控制和共享信道资源块分配给小区内的ue 2002)可以在ran节点2018和2020中的任一个处基于从ue 2002和2004中的任一个反馈的信道质量信息来执行。在至少一个实施例中,下行链路资源分配信息可以在用于(例如分配给)ue 2002和2004中的每一个的pdcch上发送。

220.在至少一个实施例中,pdcch可以使用控制信道元素(cce)来传送控制信息。在至少一个实施例中,在被映射到资源元素之前,pdcch复值符号可以首先被组织成四元组,然后可以使用子块交织器对其进行置换以用于速率匹配。在至少一个实施例中,可以使用这些cce中的一个或更多个来传送每个pdcch,其中每个cce可以对应于被称为资源元素组(reg)的四个物理资源元素的九个集合。在至少一个实施例中,四个正交相移键控(qpsk)符号可以被映射到每个reg。在至少一个实施例中,取决于下行链路控制信息(dci)的大小和信道条件,可以使用一个或更多个cce来发送pdcch。在至少一个实施例中,可以有在lte中

定义的具有不同数目的cce的四个或更多个不同的pdcch格式(例如,聚合等级,l=1、2、4或8)。

221.在至少一个实施例中,使用pdsch资源的增强型物理下行链路控制信道(epdcch)可以用于控制信息传输。在至少一个实施例中,可以使用一个或更多个增强型控制信道元素(ecce)来发送epdcch。在至少一个实施例中,每个ecce可以对应于被称为增强型资源元素组(ereg)的四个物理资源元素的九个集合。在至少一个实施例中,ecce在一些情况下可以具有其他数目的ereg。

222.在至少一个实施例中,ran 2016被示为经由s1接口2022通信地耦合至核心网(cn)2038。在至少一个实施例中,cn 2038可以是演进的分组核心(epc)网络、nextgen分组核心(npc)网络或一些其他类型的cn。在至少一个实施例中,s1接口2022被分成两部分:s1-u接口2026,其运载ran节点2018和2020与服务网关(s-gw)2030之间的业务数据;以及s1-移动性管理实体(mme)接口2024,其为ran节点2018和2020与mme 2028之间的信令接口。

223.在至少一个实施例中,cn 2038包括mme 2028、s-gw 2030、分组数据网络(pdn)网关(p-gw)2034和归属订户服务器(hss)2032。在至少一个实施例中,mme 2028可以在功能上类似于传统服务通用分组无线电服务(gprs)支持节点(sgsn)的控制平面。在至少一个实施例中,mme 2028可以管理接入中的移动性方面,例如网关选择和跟踪区域列表管理。在至少一个实施例中,hss 2032可以包括用于网络用户的数据库,该数据库包括用于支持网络实体处理通信会话的订阅相关信息。在至少一个实施例中,cn 2038可以包括一个或更多个hss 2032,这取决于移动用户的数量、设备的容量、网络的组织等。在至少一个实施例中,hss 2032可以提供对路由/漫游、认证、授权、命名/寻址解析、位置依赖性等的支持。

224.在至少一个实施例中,s-gw 2030可以终止朝向ran 2016的s1接口2022,并且在ran 2016和cn 2038之间路由数据分组。在至少一个实施例中,s-gw 2030可以是用于ran间节点切换的本地移动性锚点,并且还可以提供用于3gpp间移动性的锚点。在至少一个实施例中,其他责任可以包括合法拦截、收费和一些策略强制执行。

225.在至少一个实施例中,p-gw 2034可以终止朝向pdn的sgi接口。在至少一个实施例中,p-gw 2034可以经由互联网协议(ip)接口2042在epc网络2038和外部网络(诸如包括应用服务器2040(或者称为应用功能(af))的网络)之间路由数据分组。在至少一个实施例中,应用服务器2040可以是采用核心网络(例如,umts分组服务(ps)域、lte ps数据服务等)提供使用ip承载资源的应用的元件。在至少一个实施例中,p-gw 2034被示出为经由ip通信接口2042通信地耦合到应用服务器2040。在至少一个实施例中,应用服务器2040还可被配置为经由cn 2038支持ue 2002和2004的一个或更多个通信服务(例如,互联网协议语音(voip)会话、ptt会话、群组通信会话、社交网络服务等)。

226.在至少一个实施例中,p-gw 2034还可以是用于策略实施和收费数据收集的节点。在至少一个实施例中,策略和计费执行功能(pcrf)2036是cn 2038的策略和计费控制元件。在至少一个实施例中,在非漫游场景中,在与ue的互联网协议连接性接入网络(ip-can)会话相关联的归属公共陆地移动网络(hplmn)中可以存在单个pcrf。在至少一个实施例中,在具有本地流量突破的漫游场景中,可存在与ue的ip-can会话相关联的两个pcrf:hplmn内的归属pcrf(h-pcrf)和受访公共陆地移动网络(vplmn)内的受访pcrf(v-pcrf)。在至少一个实施例中,pcrf 2036可以经由p-gw 2034通信地耦合到应用服务器2040。在至少一个实施

例中,应用服务器2040可以向pcrf 2036发信号,以指示新的服务流,并选择适当的服务质量(qos)和计费参数。在至少一个实施例中,pcrf 2036可以将这个规则供应到具有适当的业务流模板(tft)和标识符的qos类(qci)的策略和计费执行功能(pcef)(未示出),所述pcef开始由应用服务器2040指定的qos和计费。

227.图21示出了根据一些实施例的网络的系统2100的架构。在至少一个实施例中,系统2100被示为包括ue 2102、5g接入节点或ran节点(被示为(r)an节点2108),用户平面功能(被示出为upf 2104),数据网络(dn 2106),在至少一个实施例中,其可以是运营商服务、互联网接入或第三方服务、以及5g核心网络(5gc)(示为cn 2110)。

228.在至少一个实施例中,cn 2110包括认证服务器功能(ausf 2114);核心接入和移动性管理功能(amf 2112);会话管理功能(smf 2118);网络暴露功能(nef 2116);策略控制功能(pcf 2122);网络功能(nf)储存库功能(nrf 2120);统一数据管理(udm 2124);以及应用功能(af 2126)。在至少一个实施例中,cn 2110还可包括未示出的其他元件,诸如结构化数据存储网络功能(sdsf)、非结构化数据存储网络功能(udsf)及其变型。

229.在至少一个实施例中,upf 2104可充当rat内和rat间移动性的锚点、互连到dn 2106的外部pdu会话点、和支持多归属pdu会话的分支点。在至少一个实施例中,upf 2104还可以执行分组路由和转发、分组检查、实施策略规则的用户平面部分、合法拦截分组(up收集);业务使用报告、为用户平面执行qos处理(例如分组过滤、门控、ul/dl速率执行)、执行上行链路业务验证(例如,sdf到qos流映射)、上行链路和下行链路中的传输级分组标记、以及下行链路分组缓存和下行链路数据通知触发。在至少一个实施例中,upf 2104可包括上行链路分类器,用于支持将业务流路由到数据网络。在至少一个实施例中,dn 2106可表示各种网络运营商服务、互联网接入或第三方服务。

230.在至少一个实施例中,ausf 2114可以存储用于ue 2102的认证的数据,并且处理与认证相关的功能。在至少一个实施例中,ausf 2114可以促进用于各种接入类型的公共认证框架。

231.在至少一个实施例中,amf 2112可以负责注册管理(例如,用于注册ue 2102等)、连接管理、可达性管理、移动性管理、和amf相关事件的合法拦截、以及接入认证和授权。在至少一个实施例中,amf 2112可以为smf 2118提供sm消息的传输,并且充当用于路由sm消息的透明代理。在至少一个实施例中,amf 2112还可以提供ue 2102与sms功能(smsf)(图21未示出)之间的短消息服务(sms)消息的传输。在至少一个实施例中,amf 2112可以充当安全锚定功能(sea),其可以包括与ausf 2114和ue 2102的交互以及接收作为ue 2102认证过程的结果而建立的中间密钥。在至少一个实施例中,在使用基于usim的认证的情况下,amf 2112可以从ausf 2114检索安全材料。在至少一个实施例中,amf 2112还可以包括安全上下文管理(scm)功能,其从sea接收它用来导出接入网络专用密钥的密钥。此外,在至少一个实施例中,amf 2112可以是ran cp接口的终止点(n2参考点)、nas(ni)信令的终止点,并且执行nas加密和完整性保护。

232.在至少一个实施例中,amf 2112还可以支持通过n3互通功能(iwf)接口与ue 2102的nas信令。在至少一个实施例中,n3iwf可以用于提供对不受信实体的访问。在至少一个实施例中,n3iwf可以分别是控制平面和用户平面的n2和n3接口的终止点,因此,可针对pdu会话和qos处理来自smf和amf的n2信令,对ipsec和n3隧道的分组进行封装/解封装,在上行链

路中标记n3用户平面分组,并且考虑到与通过n2接收的这种标记相关联的qos要求,实施对应于n3分组标记的qos。在至少一个实施例中,n3iwf还可以在ue 2102和amf 2112之间中继上行链路和下行链路控制平面nas(ni)信令,并且在ue 2102和upf 2104之间中继上行链路和下行链路用户平面分组。在至少一个实施例中,n3iwf还提供用于与ue 2102的ipsec隧道建立的机制。

233.在至少一个实施例中,smf 2118可负责会话管理(例如,会话建立、修改和释放,包括upf和an节点之间的隧道保持);ue ip地址分配和管理(包括可选的授权);up功能的选择和控制;在upf处配置流量转向以将流量路由到合适的目的地;朝向策略控制功能的接口终止;策略强制执行和qos的控制部分;合法拦截(用于sm事件和到li系统的接口);nas消息的sm部分的终止;下行链路数据通知;an特定sm信息的发起者,其经由amf在n2上发送到an;确定会话的ssc模式。在至少一个实施例中,smf 2118可包括以下漫游功能:处理本地实施以应用qos slab(vplmn);收费数据收集和收费接口(vplmn);合法拦截(在vplmn中用于sm事件并且接口到li系统);支持与外部dn交互以传输用于由外部dn进行的pdu会话授权/认证的信令。

234.在至少一个实施例中,nef 2116可以提供用于安全地暴露由3gpp网络功能为第三方提供的服务和能力、内部暴露/重新暴露、应用功能(例如,af 2126)、边缘计算或雾计算系统等的装置。在至少一个实施例中,nef 2116可认证、授权和/或节流af。在至少一个实施例中,nef 2116还可以转换与af 2126交换的信息和与内部网络功能交换的信息。在至少一个实施例中,nef 2116可以在af服务标识符和内部5gc信息之间转换。在至少一个实施例中,nef 2116还可以基于其他网络功能的暴露的能力从其他网络功能(nf)接收信息。在至少一个实施例中,该信息可作为结构化数据存储在nef 2116处,或使用标准化接口存储在数据存储nf处。在至少一个实施例中,所存储的信息然后可由nef 2116重新暴露给其他nf和af,和/或用于其他目的,诸如分析。

235.在至少一个实施例中,nrf 2120可以支持服务发现功能,从nf实例接收nf发现请求,以及向nf实例提供所发现的nf实例的信息。在至少一个实施例中,nrf 2120还维护可用nf实例及其支持的服务的信息。

236.在至少一个实施例中,pcf 2122可向控制平面功能提供策略规则以实施它们,并且还可支持统一策略框架以管理网络行为。在至少一个实施例中,pcf 2122还可实现前端(fe),用于访问udm 2124的udr中与策略决策相关的订阅信息。

237.在至少一个实施例中,udm 2124可处理订阅相关信息以支持网络实体处理通信会话,并且可存储ue 2102的订阅数据。在至少一个实施例中,udm 2124可以包括两个部分,应用fe和用户数据存储库(udr)。在至少一个实施例中,udm可以包括udm fe,该udm fe负责处理凭证、位置管理、订阅管理等。在至少一个实施例中,若干不同前端可在不同交易中服务同一用户。在至少一个实施例中,udm-fe访问udr中存储的子订阅信息,并执行认证凭证处理;用户标识处理;接入授权;注册/移动性管理;以及订阅管理。在至少一个实施例中,udr可与pcf 2122交互。在至少一个实施例中,udm 2124还可支持sms管理,其中sms-fe实现如前所述的类似应用逻辑。

238.在至少一个实施例中,af 2126可以提供对业务路由的应用影响、对网络能力暴露(nce)的接入,以及与策略框架的交互以用于策略控制。在至少一个实施例中,nce可以是允

许5gc和af 2126经由nef 2116向彼此提供信息的机制,nef 2116可以用于边缘计算实现。在至少一个实施例中,网络运营商和第三方服务可被托管在ue 2102的附接接入点附近,以通过减少的端到端延时和传输网络上的负载来实现高效的服务递送。在至少一个实施例中,对于边缘计算实现,5gc可选择靠近ue 2102的upf2104,并经由n6接口执行从upf 2104到dn 2106的业务引导。在至少一个实施例中,这可以基于由af 2126提供的ue订阅数据、ue位置和信息。在至少一个实施例中,af 2126可以影响upf(重新)选择和业务路由。在至少一个实施例中,基于运营商部署,当af 2126被认为是受信实体时,网络运营商可以允许af 2126直接与相关nf交互。

239.在至少一个实施例中,cn 2110可以包括smsf,其可以负责sms订阅检查和验证,并且中继去往/来自ue 2102的sm消息到/来自其他实体,例如sms-gmsc/iwmsc/sms路由器。在至少一个实施例中,sms还可以与amf 2112和udm 2124交互,以用于ue 2102可用于sms传送的通知过程(例如,设置ue不可达标志,并且当ue 2102可用于sms时通知udm 2124)。

240.在至少一个实施例中,系统2100可以包括以下基于服务的接口:namf:amf展现的基于服务的接口;nsmf:smf展现的基于服务的接口;nnef:nef展现的基于服务的接口;npcf:pcf展现的基于服务的接口;nudm:udm展现的基于服务的接口;naf:af展现的基于服务的接口;nnrf:nrf展现的基于服务的接口;以及nausf:ausf展现的基于服务的接口。

241.在至少一个实施例中,系统2100可以包括以下参考点:n1:ue和amf之间的参考点;n2:(r)an和amf之间的参考点;n3:(r)an和upf之间的参考点;n4:smf和upf之间的参考点;以及n6:upf和数据网络之间的参考点。在至少一个实施例中,nf中的nf服务之间可能存在更多的参考点和/或基于服务的接口,然而,为清楚起见,这些接口和参考点已经被省略。在至少一个实施例中,ns参考点可以在pcf与af之间;n7参考点可以在pcf与smf之间;n11参考点在amf与smf之间等等。在至少一个实施例中,cn 2110可以包括nx接口,nx接口是mme和amf 2112之间的cn间接口,以便实现cn 2110和cn 7221之间的互通。

242.在至少一个实施例中,系统2100可包括多个ran节点(诸如(r)an节点2108),其中在连接到5gc 410的两个或更多个(r)an节点2108(例如,gnb)之间,在连接到cn 2110的(r)an节点2108(例如gnb)和enb(例如宏ran节点)之间,和/或在连接到cn 2110的两个enb之间定义xn接口。

243.在至少一个实施例中,xn接口可以包括xn用户平面(xn-u)接口和xn控制平面(xn-c)接口。在至少一个实施例中,xn-u可以提供用户平面pdu的无保证的递送,并且支持/提供数据转发和流控制功能。在至少一个实施例中,xn-c可提供管理和错误处理功能、管理xn-c接口的功能;对处于连接模式(例如,cm-connected)的ue 2102的移动性支持,其包括管理针对一个或更多个(r)an节点2108之间的连接模式的ue移动性的功能。在至少一个实施例中,移动性支持可包括从旧(源)服务(r)an节点2108到新(目标)服务(r)an节点2108的上下文传送;以及控制旧(源)服务(r)an节点2108至新(目标)服务(r)an节点2108之间的用户平面隧道。

244.在至少一个实施例中,xn-u的协议栈可以包括在互联网协议(ip)传输层上构建的传输网络层和在udp和/或一个或更多个ip层的顶部上用于承载用户平面pdu的gtp-u层。在至少一个实施例中,xn-c协议栈可以包括应用层信令协议(称为xn应用协议(xn-ap))和建立在sctp层上的传输网络层。在至少一个实施例中,sctp层可以在ip层的顶部上。在至少一

2028之间的控制平面的最高层。在至少一个实施例中,nas协议2212支持ue 2002的移动性和会话管理过程以建立和维持ue 2002与p-gw 2034之间的ip连接。

253.在至少一个实施例中,si应用协议(si-ap)层(si-ap层2222)可以支持si接口的功能并且包括基本过程(ep)。在至少一个实施例中,ep是ran 2016和cn 2028之间的交互单元。在至少一个实施例中,s1-ap层服务可以包括两个组:ue关联服务和非ue关联服务。在至少一个实施例中,这些服务执行功能,包括但不限于:e-utran无线电接入承载(e-rab)管理、ue能力指示、移动性、nas信令传输、ran信息管理(rim)和配置转移。

254.在至少一个实施例中,流控制传输协议(sctp)层(可替代地称为流控制传输协议/互联网协议(sctp/ip)层)(sctp层2220)可以部分地基于ip层2218所支持的ip协议来确保ran 2016与mme 2028之间的信令消息的可靠传递。在至少一个实施例中,l2层2216和l1层2214可以指由ran节点和mme用来交换信息的通信链路(例如,有线或无线)。

255.在至少一个实施例中,ran 2016和一个或更多个mme 2028可以利用s1-mme接口来经由包括l1层2214、l2层2216、ip层2218、sctp层2220和si-ap层2222的协议栈交换控制平面数据。

256.图23是根据至少一个实施例的用户平面协议栈的图示。在至少一个实施例中,用户平面2300被示为ue 2002、ran 2016、s-gw 2030和p-gw 2034之间的通信协议栈。在至少一个实施例中,用户平面2300可以利用与控制平面2200相同的协议层。在至少一个实施例中,ue 2002和ran 2016可以利用uu接口(例如,lte-uu接口)来经由包括phy层2202、mac层2204、rlc层2206、pdcp层2208的协议栈来交换用户平面数据。

257.在至少一个实施例中,用于用户平面的通用分组无线电服务(gprs)隧道协议(gtp-u)层(gtp-u层2304)可以用于在gprs核心网络内和在无线电接入网络和核心网络之间运载用户数据。在至少一个实施例中,所传输的用户数据可以是ipv4、ipv6或ppp格式中的任何格式的分组。在至少一个实施例中,udp和ip安全(udp/ip)层(udp/ip层2302)可以提供数据完整性的校验和、用于在源和目的地寻址不同功能的端口号、以及对所选数据流的加密和认证。在至少一个实施例中,ran 2016和s-gw 2030可以利用s1-u接口来经由包括l1层2214、l2层2216、udp/ip层2302和gtp-u层2304的协议栈来交换用户平面数据。在至少一个实施例中,s-gw 2030和p-gw 2034可以利用s5/s8a接口来经由包括l1层2214、l2层2216、udp/ip层2302和gtp-u层2304的协议栈交换用户平面数据。在至少一个实施例中,如以上关于图22所讨论的,nas协议支持ue 2002的移动性和会话管理过程以建立和维持ue 2002与p-gw 2034之间的ip连接。

258.图24示出了根据至少一个实施例的核心网络的组件2400。在至少一个实施例中,cn 2038的组件可以在一个物理节点或单独的物理节点中实现,所述单独的物理节点包括用于从机器可读介质或计算机可读介质(例如,非暂态机器可读存储介质)读取和执行指令的组件。在至少一个实施例中,网络功能虚拟化(nfv)用于经由存储在一个或更多个计算机可读存储介质(以下进一步详细描述)中的可执行指令来虚拟化任何或所有的上述网络节点功能。在至少一个实施例中,cn 2038的逻辑实例化可以被称为网络切片2402(例如,网络切片2402被示出为包括hss 2032、mme 2028和s-gw 2030)。在至少一个实施例中,cn 2038的一部分的逻辑实例化可以被称为网络子切片2404(例如,网络子切片2404被示出为包括p-gw 2034和pcrf 2036)。

259.在至少一个实施例中,nfv架构和基础设施可以用于将一个或更多个网络功能虚拟化到包括行业标准服务器硬件、存储硬件或交换机的组合的物理资源上,所述网络功能可替代地由专用硬件执行。在至少一个实施例中,nfv系统可用于执行一个或更多个epc组件/功能的虚拟或可重新配置的实现方式。

260.图25是示出了根据至少一个实施例的用于支持网络功能虚拟化(nfv)的系统2500的组件的框图。在至少一个实施例中,系统2500被示为包括虚拟化基础设施管理器(被示为vim 2502)、网络功能虚拟化基础设施(如nfvi 2504所示)、vnf管理器(如vnfm 2506所示)、虚拟化网络功能(示出为vnf 2508)、元件管理器(示出为em 2510)、nfv协调器(示出为nfvo 2512)、以及网络管理器(示为nm 2514)。

261.在至少一个实施例中,vim 2502管理nfvi 2504的资源。在至少一个实施例中,nfvi 2504可包括用于执行系统2500的物理或虚拟资源和应用(包括管理程序)。在至少一个实施例中,vim 2502可以利用nfvi 2504来管理虚拟资源的生命周期(例如,与一个或更多个物理资源相关联的虚拟机(vm)的创建、维护和拆除)、跟踪vm实例、跟踪性能、vm实例和相关联的物理资源的故障和安全性、以及向其他管理系统暴露vm实例和相关联的物理资源。

262.在至少一个实施例中,vnfm 2506可以管理vnf 2508。在至少一个实施例中,vnf 2508可以用于执行epc组件/功能。在至少一个实施例中,vnfm 2506可以管理vnf 2508的生命周期并且跟踪vnf 2508的虚拟方面的性能、故障和安全性。在至少一个实施例中,em 2510可以跟踪vnf 2508的功能方面的性能、故障和安全性。在至少一个实施例中,跟踪来自vnfm 2506和em 2510的数据可以包括,在至少一个实施例中,由vim 2502或nfvi 2504使用的性能测量(pm)数据。在至少一个实施例中,vnfm 2506和em 2510两者可以放大/缩小系统2500的vnf的数量。

263.在至少一个实施例中,nfvo 2512可协调、授权、释放和占用nfvi 2504的资源,以便提供所请求的服务(例如,以执行epc功能、组件或切片)。在至少一个实施例中,nm 2514可提供负责管理网络的终端用户功能包,该网络可包括具有vnf、非虚拟化网络功能或两者的网络元件(vnf的管理可经由em 2510发生)。

264.基于计算机的系统

265.以下各图提出但不限于可用于实现至少一个实施例的示例性的基于计算机的系统。

266.图26示出了根据至少一个实施例的处理系统2600。在至少一个实施例中,系统2600包括一个或更多个处理器2602和一个或更多个图形处理器2608,并且可以是单处理器台式机系统、多处理器工作站系统或具有大量处理器2602或处理器核心2607的服务器系统。在至少一个实施例中,处理系统2600是结合在片上系统(soc)集成电路内的处理平台,以用于移动、手持或嵌入式设备。

267.在至少一个实施例中,处理系统2600可以包括或结合在基于服务器的游戏平台中,包括游戏和媒体控制台的游戏控制台、移动游戏控制台、手持游戏控制台或在线游戏控制台。在至少一个实施例中,处理系统2600是移动电话、智能电话、平板计算设备或移动互联网设备。在至少一个实施例中,处理系统2600还可包括与可穿戴设备耦合或集成在可穿戴设备中,例如智能手表可穿戴设备、智能眼镜设备、增强现实设备或虚拟现实设备。在至

少一个实施例中,处理系统2600是电视或机顶盒设备,其具有一个或更多个处理器2602以及由一个或更多个图形处理器2608生成的图形界面。

268.在至少一个实施例中,一个或更多个处理器2602每个包括一个或更多个处理器核心2607,以处理指令,该指令在被执行时执行针对系统和用户软件的操作。在至少一个实施例中,一个或更多个处理器核心2607中的每一个被配置为处理特定指令集2609。在至少一个实施例中,指令集2609可以促进复杂指令集计算(cisc)、精简指令集计算(risc),或通过超长指令字(vliw)进行计算。在至少一个实施例中,多个处理器核心2607可以各自处理不同的指令集2609,该指令集2609可以包括有助于仿真其他指令集的指令。在至少一个实施例中,处理器核心2607还可以包括其他处理设备,例如数字信号处理器(dsp)。

269.在至少一个实施例中,处理器2602包括高速缓存存储器(cache)2604。在至少一个实施例中,处理器2602可以具有单个内部高速缓存或多个级别的内部高速缓存。在至少一个实施例中,高速缓存存储器在处理器2602的各个组件之间共享。在至少一个实施例中,处理器2602还使用外部高速缓存(例如,三级(l3)高速缓存或最后一级高速缓存(llc))(未示出),其可以使用已知的高速缓存一致性技术在处理器核心2607之间共享该逻辑。在至少一个实施例中,处理器2602中另外包括寄存器文件2606,处理器2602可以包括用于存储不同类型的数据的不同类型的寄存器(例如,整数寄存器、浮点寄存器、状态寄存器和指令指针寄存器)。在至少一个实施例中,寄存器文件2606可以包括通用寄存器或其他寄存器。

270.在至少一个实施例中,一个或更多个处理器2602与一个或更多个接口总线2610耦合,以在处理器2602与系统2600中的其他组件之间传输通信信号,例如地址、数据或控制信号。在至少一个实施例中,接口总线2610在一个实施例中可以是处理器总线,例如直接媒体接口(dmi)总线的版本。在至少一个实施例中,接口总线2610不限于dmi总线,并且可以包括一个或更多个外围组件互连总线(例如,pci,pci express)、存储器总线或其他类型的接口总线。在至少一个实施例中,处理器2602包括集成存储器控制器2616和平台控制器集线器2630。在至少一个实施例中,存储器控制器2616促进存储设备与处理系统2600的其他组件之间的通信,而平台控制器集线器(pch)2630通过本地i/o总线提供到输入/输出(i/o)设备的连接。

271.在至少一个实施例中,存储器设备2620可以是动态随机存取存储器(dram)设备、静态随机存取存储器(sram)设备、闪存设备、相变存储设备或具有适当的性能以用作处理器存储器。在至少一个实施例中,存储设备2620可以用作处理系统2600的系统存储器,以存储数据2622和指令2621,以在一个或更多个处理器2602执行应用或过程时使用。在至少一个实施例中,存储器控制器2616还与可选的外部图形处理器2612耦合,其可以与处理器2602中的一个或更多个图形处理器2608通信以执行图和媒体操作。在至少一个实施例中,显示设备2611可以连接至处理器2602。在至少一个实施例中,显示设备2611可以包括内部显示设备中的一个或更多个,例如在移动电子设备或便携式计算机设备或通过显示器接口(例如显示端口(displayport)等)连接的外部显示设备。在至少一个实施例中,显示设备2611可以包括头戴式显示器(hmd),诸如用于虚拟现实(vr)应用或增强现实(ar)应用中的立体显示设备。

272.在至少一个实施例中,平台控制器集线器2630使外围设备能够通过高速i/o总线连接到存储设备2620和处理器2602。在至少一个实施例中,i/o外围设备包括但不限于音频

控制器2646、网络控制器2634、固件接口2628、无线收发器2626、触摸传感器2625、数据存储设备2624(例如,硬盘驱动器、闪存等)。在至少一个实施例中,数据存储设备2624可以经由存储器接口(例如,sata)或经由外围总线来连接,诸如外围组件互连总线(例如,pci、pcie)。在至少一个实施例中,触摸传感器2625可以包括触摸屏传感器、压力传感器或指纹传感器。在至少一个实施例中,无线收发器2626可以是wi-fi收发器、蓝牙收发器或移动网络收发器,诸如3g、4g或长期演进(lte)收发器。在至少一个实施例中,固件接口2628使能与系统固件的通信,在至少一个实施例中,并且可以是统一的可扩展固件接口(uefi)。在至少一个实施例中,网络控制器2634可以启用到有线网络的网络连接。在至少一个实施例中,高性能网络控制器(未示出)与接口总线2610耦合。在至少一个实施例中,音频控制器2646是多通道高清晰度音频控制器。在至少一个实施例中,处理系统2600包括可选的传统(legacy)i/o控制器2640,用于将遗留(例如,个人系统2(ps/2))设备耦合到处理系统2600。在至少一个实施例中,平台控制器集线器2630还可以连接到一个或更多个通用串行总线(usb)控制器2642,该控制器连接输入设备,诸如键盘和鼠标2643组合、相机2644或其他usb输入设备。

273.在至少一个实施例中,存储器控制器2616和平台控制器集线器2630的实例可以集成到离散的外部图形处理器中,例如外部图形处理器2612。在至少一个实施例中,平台控制器集线器2630和/或存储控制器2616可以在一个或更多个处理器2602的外部。在至少一个实施例中,处理系统2600可以包括外部存储控制器2616和平台控制器集线器2630,其可以配置成在与处理器2602通信的系统芯片组中的存储器控制器集线器和外围控制器集线器。

274.图27示出了根据至少一个实施例的计算机系统2700。在至少一个实施例中,计算机系统2700可以是具有互连的设备和组件,soc,或某种组合的系统。在至少一个实施例中,计算机系统2700由处理器2702形成,该处理器2702可以包括用于执行指令的执行单元。在至少一个实施例中,计算机系统2700可以包括但不限于组件,例如处理器2702,其采用包括逻辑的执行单元以执行用于过程数据的算法。在至少一个实施例中,计算机系统2700可以包括处理器,例如可从加利福尼亚圣塔克拉拉的英特尔公司(intel corporation of santa clara,california)获得的处理器家族、xeontm、xscaletm和/或strongarmtm,core

tm

或nervana

tm

微处理器,尽管也可以使用其他系统(包括具有其他微处理器的pc、工程工作站、机顶盒等)。在至少一个实施例中,计算机系统2700可以执行可从华盛顿州雷蒙德市的微软公司(microsoft corporation of redmond,wash.)获得的windows操作系统版本,尽管其他操作系统(在至少一个实施例中unix和linux)、嵌入式软件和/或图形用户界面也可以使用。

275.在至少一个实施例中,计算机系统2700可以用在其他设备中,例如手持设备和嵌入式应用。手持设备的至少一个实施例的一些包括蜂窝电话、互联网协议(internet protocol)设备、数码相机、个人数字助理(“pda”)和手持pc。在至少一个实施例中,嵌入式应用可以包括微控制器、数字信号处理器(“dsp”)、soc、网络计算机(“netpc”)、机顶盒、网络集线器、广域网(“wan”)交换机,或根据至少一个实施例可以执行一个或更多个指令的任何其他系统。

276.在至少一个实施例中,计算机系统2700可包括但不限于处理器2702,该处理器2702可包括但不限于一个或更多个执行单元2708,其可以配置为执行计算统一设备架构

(“cuda”)(由加利福尼亚州圣克拉拉的nvidia corporation开发)程序。在至少一个实施例中,cuda程序是用cuda编程语言编写的软件应用程序的至少一部分。在至少一个实施例中,计算机系统2700是单处理器台式机或服务器系统。在至少一个实施例中,计算机系统2700可以是多处理器系统。在至少一个实施例中,处理器2702可以包括但不限于cisc微处理器、risc微处理器、vliw微处理器、实现指令集组合的处理器,或任何其他处理器设备,在至少一个实施例中,诸如数字信号处理器。在至少一个实施例中,处理器2702可以耦合到处理器总线2710,该处理器总线2710可以在处理器2702与计算机系统2700中的其他组件之间传输数据信号。

277.在至少一个实施例中,处理器2702可以包括但不限于1级(“l1”)内部高速缓存存储器(“cache”)2704。在至少一个实施例中,处理器2702可以具有单个内部高速缓存或多级内部缓存。在至少一个实施例中,高速缓存存储器可以驻留在处理器2702的外部。在至少一个实施例中,处理器2702可以包括内部和外部高速缓存的组合。在至少一个实施例中,寄存器文件2706可以在各种寄存器中存储不同类型的数据,包括但不限于整数寄存器、浮点寄存器、状态寄存器和指令指针寄存器。

278.在至少一个实施例中,包括但不限于执行整数和浮点运算的逻辑的执行单元2708,其也位于处理器2702中。处理器2702还可以包括微码(“ucode”)只读存储器(“rom”),用于存储某些宏指令的微代码。在至少一个实施例中,执行单元2708可以包括用于处理封装指令集2709的逻辑。在至少一个实施例中,通过将封装指令集2709包括在通用处理器2702的指令集中,以及要执行指令的相关电路,可以使用通用处理器2702中的封装数据来执行许多多媒体应用程序使用的操作。在至少一个实施例中,可以通过使用处理器的数据总线的全宽度来在封装的数据上执行操作来加速和更有效地执行许多多媒体应用程序,这可能不需要在处理器的数据总线上传输较小的数据单元来一次对一个数据元素执行一个或更多个操作。

279.在至少一个实施例中,执行单元2708也可以用在微控制器、嵌入式处理器、图形设备、dsp和其他类型的逻辑电路中。在至少一个实施例中,计算机系统2700可以包括但不限于存储器2720。在至少一个实施例中,存储器2720可以被实现为dram设备、sram设备、闪存设备或其他存储设备。存储器2720可以存储由处理器2702可以执行的由数据信号表示的指令2719和/或数据2721。

280.在至少一个实施例中,系统逻辑芯片可以耦合到处理器总线2710和存储器2720。在至少一个实施例中,系统逻辑芯片可以包括但不限于存储器控制器集线器(“mch”)2716,并且处理器2702可以经由处理器总线2710与mch 2716通信。在至少一个实施例中,mch 2716可以提供到存储器2720的高带宽存储器路径2718以用于指令和数据存储以及用于图形命令、数据和纹理的存储。在至少一个实施例中,mch 2716可以在处理器2702、存储器2720和计算机系统2700中的其他组件之间启动数据信号,并且在处理器总线2710、存储器2720和系统i/o 2722之间桥接数据信号。在至少一个实施例中,系统逻辑芯片可以提供用于耦合到图形控制器的图形端口。在至少一个实施例中,mch 2716可以通过高带宽存储器路径2718耦合到存储器2720,并且图形/视频卡2712可以通过加速图形端口(accelerated graphics port)(“agp”)互连2714耦合到mch 2716。

281.在至少一个实施例中,计算机系统2700可以使用系统i/o 2722作为专有集线器接

口总线来将mch 2716耦合到i/o控制器集线器(“ich”)2730。在至少一个实施例中,ich 2730可以通过本地i/o总线提供与某些i/o设备的直接连接。在至少一个实施例中,本地i/o总线可以包括但不限于用于将外围设备连接到存储器2720、芯片组和处理器2702的高速i/o总线。示例可以包括但不限于音频控制器2729、固件集线器(“flash bios”)2728、无线收发器2726、数据存储2724、包含用户输入2725的传统i/o控制器2723和键盘接口、串行扩展端口2777(例如usb)和网络控制器2734。数据存储2724可以包括硬盘驱动器、软盘驱动器、cd-rom设备、闪存设备或其他大容量存储设备。

282.在至少一个实施例中,图27示出了包括互连的硬件设备或“芯片”的系统。在至少一个实施例中,图27可以示出示例性soc。在至少一个实施例中,图27中示出的设备可以与专有互连、标准化互连(例如,pcie)或其某种组合互连。在至少一个实施例中,系统2700的一个或更多个组件使用计算快速链路(cxl)互连来互连。

283.图28示出了根据至少一个实施例的系统2800。在至少一个实施例中,系统2800是利用处理器2810的电子设备。在至少一个实施例中,系统2800可以是,在至少一个实施例中但不限于,笔记本电脑、塔式服务器、机架服务器、刀片服务器、膝上型计算机、台式机、平板电脑、移动设备、电话、嵌入式计算机或任何其他合适的电子设备。

284.在至少一个实施例中,系统2800可以包括但不限于通信地耦合到任何合适数量或种类的组件、外围设备、模块或设备的处理器2810。在至少一个实施例中,处理器2810使用总线或接口耦合,诸如i2c总线、系统管理总线(“smbus”)、低引脚数(lpc)总线、串行外围接口(“spi”)、高清音频(“hda”)总线、串行高级技术附件(“sata”)总线、usb(1、2、3版)或通用异步接收器/发送器(“uart”)总线。在至少一个实施例中,图28示出了系统,该系统包括互连的硬件设备或“芯片”。在至少一个实施例中,图28可以示出示例性soc。在至少一个实施例中,图28中所示的设备可以与专有互连线、标准化互连(例如,pcie)或其某种组合互连。在至少一个实施例中,图28的一个或更多个组件使用计算快速链路(cxl)互连线来互连。

285.在至少一个实施例中,图28可以包括显示器2824、触摸屏2825、触摸板2830、近场通信单元(“nfc”)2845、传感器集线器2840、热传感器2846、快速芯片组(“ec”)2835、可信平台模块(“tpm”)2838、bios/固件/闪存(“bios,fw flash”)2822、dsp 2860、固态磁盘(“ssd”)或硬盘驱动器(“hdd”)2820、无线局域网单元(“wlan”)2850、蓝牙单元2852、无线广域网单元(“wwan”)2856、全球定位系统(gps)2855、相机(“usb 3.0相机”)2854(例如usb 3.0相机)或以至少一个实施例lpddr3标准实现的低功耗双倍数据速率(“lpddr”)存储器单元(“lpddr3”)2815。这些组件可以各自以任何合适的方式实现。

286.在至少一个实施例中,其他组件可以通过以上讨论的组件通信地耦合到处理器2810。在至少一个实施例中,加速度计2841、环境光传感器(“als”)2842、罗盘2843和陀螺仪2844可以可通信地耦合到传感器集线器2840。在至少一个实施例中,热传感器2839、风扇2837、键盘2846和触摸板2830可以通信地耦合到ec 2835。在至少一个实施例中,扬声器2863、耳机2864和麦克风(“mic”)2865可以通信地耦合到音频单元(“音频编解码器和d类放大器”)2864,其又可以通信地耦合到dsp 2860。在至少一个实施例中,音频单元2864可以包括但不限于音频编码器/解码器(“编解码器”)和d类放大器。在至少一个实施例中,sim卡(“sim”)2857可以通信地耦合到wwan单元2856。在至少一个实施例中,组件(诸如wlan单元2850和蓝牙单元2852以及wwan单元2856)可以被实现为下一代形式因素(ngff)。

287.图29示出了根据至少一个实施例的示例性集成电路2900。在至少一个实施例中,示例性集成电路2900是soc,其可使用一个或更多个ip核心制造。在至少一个实施例中,集成电路2900包括一个或更多个应用处理器2905(例如,cpu)、至少一个图形处理器2910,并且可以另外包括图像处理器2915和/或视频处理器2920,其中任意一个可能是模块化ip核心。在至少一个实施例中,集成电路2900包括外围或总线逻辑,其包括usb控制器2925、uart控制器2930、spi/sdio控制器2935和i2s/i2c控制器2940。在至少一个实施例中,集成电路2900可以包括显示设备2945耦合到高清多媒体接口(hdmi)控制器2950和移动工业处理器接口(mipi)显示接口2955中的一个或更多个。在至少一个实施例中,存储可以由闪存子系统2960提供,包括闪存和闪存控制器。在至少一个实施例中,可以经由存储器控制器2965提供存储器接口以用于访问sdram或sram存储器设备。在至少一个实施例中,一些集成电路还包括嵌入式安全引擎2970。

288.图30示出了根据至少一个实施例的计算系统3000。在至少一个实施例中,计算系统3000包括处理子系统3001,其具有经由可以包括存储器集线器3005的互连路径通信的一个或更多个处理器3002和系统存储器3004。在至少一个实施例中,存储器集线器3005可以是芯片组组件内的单独组件,也可以集成在一个或更多个处理器3002内。在至少一个实施例中,存储器集线器3005通过通信链路3006与i/o子系统3011耦合。在至少一个实施例中,i/o子系统3011包括i/o集线器3007,其可以使计算系统3000能够接收来自一个或更多个输入设备3008的输入。在至少一个实施例中,i/o集线器3007可以使能显示控制器,其包括在一个或更多个处理器3002中,用于向一个或更多个显示设备3010a提供输出。在至少一个实施例中,与i/o集线器3007耦合的一个或更多个显示设备3010a可以包括本地、内部或嵌入式显示设备。

289.在至少一个实施例中,处理子系统3001包括经由总线或其他通信链路3013耦合到存储器集线器3005的一个或更多个并行处理器3012。在至少一个实施例中,通信链路3013可以是许多基于标准的通信链路技术或协议中的一种,例如但不限于pcie,或者可以是针对供应商的通信接口或通信结构。在至少一个实施例中,一个或更多个并行处理器3012形成计算集中的并行或向量处理系统,该系统可以包括大量的处理核心和/或处理集群,例如多集成核心(mic)处理器。在至少一个实施例中,一个或更多个并行处理器3012形成可以将像素输出到经由i/o集线器3007耦合的一个或更多个显示设备3010a之一的图形处理子系统。在至少一个实施例中,一个或更多个并行处理器3012还可以包括显示控制器和显示接口(未示出),以使得能够直接连接到一个或更多个显示设备3010b。

290.在至少一个实施例中,系统存储单元3014可以连接到i/o集线器3007,以提供用于计算系统3000的存储机制。在至少一个实施例中,i/o交换机3016可以用于提供接口机制,以实现i/o集线器3007与其他组件之间的连接,例如可以集成到平台中的网络适配器3018和/或无线网络适配器3019,以及可以通过一个或更多个附加设备3020添加的各种其他设备。在至少一个实施例中,网络适配器3018可以是以太网适配器或另一有线网络适配器。在至少一个实施例中,无线网络适配器3019可以包括wi-fi、蓝牙、nfc的一个或更多个或其他包括一个或更多个无线电的网络设备。

291.在至少一个实施例中,计算系统3000可以包括未明确示出的其他组件,包括usb或其他端口连接、光存储驱动器、视频捕获设备和/或其变体,也可以连接到i/o集线器3007。

在至少一个实施例中,对图30中的各个组件进行互连的通信路径可以使用任何合适的协议来实现,诸如基于pci(外围组件互连)的协议(例如,pcie),或其他总线或点对点通信接口和/或协议(例如,nvlink高速互连或互连协议)。

292.在至少一个实施例中,一个或更多个并行处理器3012包括针对图形和视频处理而优化的电路(在至少一个实施例,包括视频输出电路),并构成图形处理单元(gpu)。在至少一个实施例中,一个或更多个并行处理器3012包括针对通用处理而优化的电路。在至少一个实施例中,计算系统3000的组件可以与单个集成电路上的一个或更多个其他系统元件集成。在至少一个实施例中,一个或更多个并行处理器3012、存储器集线器3005、处理器3002和i/o集线器3007可以被集成到片上系统(soc)集成电路中。在至少一个实施例中,计算系统3000的组件可以被集成到单个封装中以形成系统级封装(sip)配置。在至少一个实施例中,计算系统3000的组件的至少一部分可以被集成到多芯片模块(mcm)中,该多芯片模块可以与其他多芯片模块互连到模块化计算系统中。在至少一个实施例中,从计算系统3000中省略了i/o子系统3011和显示设备3010b。

293.处理系统

294.以下各图阐述了但不限于可用于实现至少一个实施例的示例性处理系统。

295.图31示出了根据至少一个实施例的加速处理单元(“apu”)3100。在至少一个实施例中,apu 3100由加利福尼亚州圣克拉拉市的amd公司开发。在至少一个实施例中,apu 3100可以被配置为执行应用程序,诸如cuda程序。在至少一个实施例中,apu 3100包括但不限于核心复合体3110、图形复合体3140、结构3160、i/o接口3170、存储器控制器3180、显示控制器3192和多媒体引擎3194。在至少一个实施例中,apu 3100可以包括但不限于任意数量的核心复合体3110、任意数量的图形复合体3140、任意数量的显示控制器3192和任意数量的多媒体引擎3194的任何组合。为了说明的目的,在本文中用附图标记表示相似对象的多个实例,其中附图标记标识该对象,并且括号中的数字标识所需要的实例。

296.在至少一个实施例中,核心复合体3110是cpu,图形复合体3140是gpu,并且apu 3100是将不限于3110和3140集成到单个芯片上的处理单元。在至少一个实施例中,一些任务可以被分配给核心复合体3110,而其他任务可以被分配给图形复合体3140。在至少一个实施例中,核心复合体3110被配置为执行与apu 3100相关联的主控制软件,例如操作系统。在至少一个实施例中,核心复合体3110是apu 3100的主处理器,其控制和协调其他处理器的操作。在至少一个实施例中,核心复合体3110发出控制图形复合体3140的操作的命令。在至少一个实施例中,核心复合体3110可以被配置为执行从cuda源代码派生的主机可执行代码,并且图形复合体3140可以被配置为执行从cuda源代码派生的设备可执行代码。

297.在至少一个实施例中,核心复合体3110包括但不限于核心3120(1)-3120(4)和l3高速缓存3130。在至少一个实施例中,核心复合体3110可以包括但不限于任意数量的核心3120以及任意数量和类型的高速缓存的任何组合。在至少一个实施例中,核心3120被配置为执行特定指令集架构(“isa”)的指令。在至少一个实施例中,每个核心3120是cpu核心。

298.在至少一个实施例中,每个核心3120包括但不限于获取/解码单元3122,整数执行引擎3124,浮点执行引擎3126和l2高速缓存3128。在至少一个实施例中,获取/解码单元3122获取指令,对这些指令进行解码,生成微操作,并将单独的微指令分派给整数执行引擎3124和浮点执行引擎3126。在至少一个实施例中,获取/解码单元3122可以同时分派一个微

指令到整数执行引擎3124和另一微指令到浮点执行引擎3126。在至少一个实施例中,整数执行引擎3124执行不限于整数和存储器操作。在至少一个实施例中,浮点引擎3126执行不限于浮点和向量运算。在至少一个实施例中,获取-解码单元3122将微指令分派给单个执行引擎,该执行引擎代替整数执行引擎3124和浮点执行引擎3126两者。

299.在至少一个实施例中,每个核心3120(i)可以访问包括在核心3120(i)中的l2高速缓存3128(i),其中i是表示核心3120的特定实例的整数。在至少一个实施例中,包括在核心复合体3110(j)中的每个核心3120经由包括在核心复合体3110(j)中的l3高速缓存3130(j)连接到包括在核心复合体3110(j)中的其他核心3120,其中j是表示核心复合体3110的特定实例的整数。在至少一个实施例中,包括在核心复合体3110(j)中的核心3120可以访问包括在核心复合体3110(j)中的所有l3高速缓存3130(j),其中j是表示核心复合体3110的特定实例的整数。在至少一个实施例中,l3高速缓存3130可以包括但不限于任意数量的切片(slice)。

300.在至少一个实施例中,图形复合体3140可以被配置为以高度并行的方式执行计算操作。在至少一个实施例中,图形复合体3140被配置为执行图形管线操作,诸如绘制命令、像素操作、几何计算以及与将图像渲染至显示器相关联的其他操作。在至少一个实施例中,图形复合体3140被配置为执行与图形无关的操作。在至少一个实施例中,图形复合体3140被配置为执行与图形有关的操作和与图形无关的操作。

301.在至少一个实施例中,图形复合体3140包括但不限于任意数量的计算单元3150和l2高速缓存3142。在至少一个实施例中,计算单元3150共享l2高速缓存3142。在至少一个实施例中,l2高速缓存3142被分区。在至少一个实施例中,图形复合体3140包括但不限于任意数量的计算单元3150以及任意数量(包括零)和类型的高速缓存。在至少一个实施例中,图形复合体3140包括但不限于任意数量的专用图形硬件。

302.在至少一个实施例中,每个计算单元3150包括但不限于任意数量的simd单元3152和共享存储器3154。在至少一个实施例中,每个simd单元3152实现simd架构并且被配置为并行执行操作。在至少一个实施例中,每个计算单元3150可以执行任意数量的线程块,但是每个线程块在单个计算单元3150上执行。在至少一个实施例中,线程块包括但不限于任意数量的执行线程。在至少一个实施例中,工作组是线程块。在至少一个实施例中,每个simd单元3152执行不同的线程束(warp)。在至少一个实施例中,线程束是一组线程(例如16个线程),其中线程束中的每个线程属于单个线程块,并且被配置为基于单个指令集来处理不同的数据集。在至少一个实施例中,可以使用预测(predication)来禁用线程束中的一个或更多个线程。在至少一个实施例中,通道是线程。在至少一个实施例中,工作项是线程。在至少一个实施例中,波前是线程束。在至少一个实施例中,线程块中的不同波前可一起同步并经由共享存储器3154进行通信。

303.在至少一个实施例中,结构3160是系统互连,其促进跨核心复合体3110、图形复合体3140、i/o接口3170、存储器控制器3180、显示控制器3192和多媒体引擎3194的数据和控制传输。在至少一个实施例中,除了结构3160之外或代替结构3160,apu 3100还可以包括但不限于任意数量和类型的系统互连,该结构3160促进跨可以在apu 3100内部或外部的任意数量和类型的直接或间接链接的组件的数据和控制传输。在至少一个实施例中,i/o接口3170表示任意数量和类型的i/o接口(例如,pci,pci-extended(“pci-x”),pcie,千兆以太

网(“gbe”),usb等)。在至少一个实施例中,各种类型的外围设备耦合到i/o接口3170。在至少一个实施例中,耦合到i/o接口3170的外围设备可以包括但不限于键盘,鼠标,打印机,扫描仪,操纵杆或其他类型的游戏控制器、媒体记录设备、外部存储设备、网络接口卡等。

304.在至少一个实施例中,显示控制器amd92在一个或更多个显示设备(例如液晶显示器(lcd)设备)上显示图像。在至少一个实施例中,多媒体引擎240包括但不限于任意数量和类型的与多媒体相关的电路,例如视频解码器、视频编码器、图像信号处理器等。在至少一个实施例中,存储器控制器3180促进apu 3100与统一系统存储器3190之间的数据传输。在至少一个实施例中,核心复合体3110和图形复合体3140共享统一系统存储器3190。

305.在至少一个实施例中,apu 3100实现种存储器子系统,其包括但不限于任意数量和类型的存储器控制器3180和可以专用于一个组件或在多个组件之间共享的存储器设备(例如,共享存储器3154)。组件。在至少一个实施例中,apu 3100实现高速缓存子系统,其包括但不限于一个或更多个高速缓存存储器(例如,l2高速缓存2728,l3高速缓存3130和l2高速缓存3142),每个高速缓存存储器可以是组件私有的或在任意数量的组件(例如,核心3120,核心复合体3110,simd单元3152,计算单元3150和图形复合体3140)之间共享。

306.图32示出了根据至少一个实施例的cpu 3200。在至少一个实施例中,cpu 3200由加利福尼亚州圣克拉拉市的amd公司开发。在至少一个实施例中,cpu 3200可以被配置为执行应用程序。在至少一个实施例中,cpu 3200被配置为执行主控制软件,例如操作系统。在至少一个实施例中,cpu 3200发出控制外部gpu(未示出)的操作的命令。在至少一个实施例中,cpu 3200可以被配置为执行从cuda源代码派生的主机可执行代码,并且外部gpu可以被配置为执行从这种cuda源代码派生的设备可执行代码。在至少一个实施例中,cpu 3200包括但不限于任意数量的核心复合体3210,结构3260,i/o接口3270和存储器控制器3280。

307.在至少一个实施例中,核心复合体3210包括但不限于核心3220(1)-3220(4)和l3高速缓存3230。在至少一个实施例中,核心复合体3210可以包括但不限于任意数量的核心3220以及任意数量和类型的高速缓存的任何组合。在至少一个实施例中,核心3220被配置为执行特定isa的指令。在至少一个实施例中,每个核心3220是cpu核心。

308.在至少一个实施例中,每个核心3220包括但不限于获取/解码单元3222,整数执行引擎3224,浮点执行引擎3226和l2高速缓存3228。在至少一个实施例中,获取/解码单元3222获取指令,对这些指令进行解码,生成微操作,并将单独的微指令分派给整数执行引擎3224和浮点执行引擎3226。在至少一个实施例中,获取/解码单元3222可以同时分派一个微指令至整数执行引擎3224和另一微指令至浮点执行引擎3226。在至少一个实施例中,整数执行引擎3224执行不限于整数和存储器操作。在至少一个实施例中,浮点引擎3226执行不限于浮点和向量运算。在至少一个实施例中,获取-解码单元3222将微指令分派给单个执行引擎,该引擎代替整数执行引擎3224和浮点执行引擎3226两者。

309.在至少一个实施例中,每个核心3220(i)可以访问包括在核心3220(i)中的l2高速缓存3228(i),其中i是表示核心3220的特定实例的整数。在至少一个实施例中,包括在核心复合体3210(j)中的每个核心3220经由包括在核心复合体3210(j)中的l3高速缓存3230(j)连接到核心复合体3210(j)中的其他核心3220,其中j是表示核心复合体3210的特定实例的整数。在至少一个实施例中,包括在核心复合体3210(j)中的核心3220可以访问包括在核心复合体3210(j)中的所有l3高速缓存3230(j),其中j是表示核心复合体3210的特定实例的

整数。在至少一个实施例中,l3高速缓存3230可以包括但不限于任意数量的切片。

310.在至少一个实施例中,结构3260是系统互连,其促进跨核心复合体3210(1)-3210(n)(其中n是大于零的整数)、i/o接口3270和存储器控制器3280的数据和控制传输。在至少一个实施例中,除了结构3260之外或代替结构3260,cpu 3200还可以包括但不限于任意数量和类型的系统互连,该结构3260促进跨可以在cpu 3200内部或外部的任意数量和类型的直接或间接链接的组件的数据和控制传输。在至少一个实施例中,i/o接口3270表示任意数量和类型的i/o接口(例如pci,pci-x,pcie,gbe,usb等)。在至少一个实施例中,各种类型的外围设备耦合到i/o接口3270。在至少一个实施例中,耦合到i/o接口3270的外围设备可以包括但不限于显示器,键盘,鼠标,打印机,扫描仪,操纵杆或其他类型的游戏控制器、媒体记录设备、外部存储设备、网络接口卡等。

311.在至少一个实施例中,存储器控制器3280促进cpu 3200与系统存储器3290之间的数据传输。在至少一个实施例中,核心复合体3210和图形复合体3240共享系统存储器3290。在至少一个实施例中,cpu 3200实现存储器子系统,其包括但不限于任意数量和类型的存储器控制器3280和可以专用于一个组件或在多个组件之间共享的存储器设备。在至少一个实施例中,cpu 3200实现了高速缓存子系统,其包括但不限于一个或更多个高速缓存存储器(例如,l2高速缓存3228和l3高速缓存3230),每个高速缓存存储器可以是组件私有的或在任意数量的组件(例如,核心3220和核心复合体3210)之间共享。

312.图33示出了根据至少一个实施例的示例性加速器集成切片3390。如本文所使用的,“切片”包括加速器集成电路的处理资源的指定部分。在至少一个实施例中,加速器集成电路代表多个图形加速模块种的多个图形处理引擎提供高速缓存管理、存储器访问、环境管理和中断管理服务。图形处理引擎可以各自包括单独的gpu。可选地,图形处理引擎可包括gpu内的不同类型的图形处理引擎,例如图形执行单元、媒体处理引擎(例如,视频编码器/解码器)、采样器和blit引擎。在至少一个实施例中,图形加速模块可以是具有多个图形处理引擎的gpu。在至少一个实施例中,图形处理引擎可以是集成在通用封装、线卡或芯片上的各个gpu。

313.系统存储器3314内的应用程序有效地址空间3382存储进程元素3383。在一个实施例中,响应于来自处理器3307上执行的应用程序3380的gpu调用3381而存储进程元素3383。进程元素3383包含对应应用程序3380的处理状态。包含在进程元素3383中的工作描述符(wd)3384可以是应用程序请求的单个作业或可能包含指向作业队列的指针。在至少一个实施例中,wd 3384是指向应用程序有效地址空间3382中的作业请求队列的指针。

314.图形加速模块3346和/或各个图形处理引擎可以由系统中的全部或部分进程共享。在至少一个实施例中,可以包括用于建立处理状态并将wd 3384发送到图形加速模块3346以在虚拟化环境中开始作业的基础设施。

315.在至少一个实施例中,专用进程编程模型是针对实现的。在该模型中,单个进程拥有图形加速模块3346或个体图形处理引擎。由于图形加速模块3346由单个进程拥有,因此管理程序为拥有的分区初始化加速器集成电路,并且当分配图形加速模块3346时操作系统对加速器集成电路进行初始化以用于拥有的分区。

316.在操作中,加速器集成切片3390中的wd获取单元3391获取下一个wd 3384,其中包括要由图形加速模块3346的一个或更多个图形处理引擎完成的工作的指示。来自wd 3384

的数据可以存储在寄存器3345被存储器管理单元(mmu)3339、中断管理电路3347和/或环境管理电路3348使用,如图所示。mmu 3339的至少一个实施例包括用于访问os虚拟地址空间3385内的段/页表3386的段/页面漫游电路。中断管理电路3347可以处理从图形加速模块3346接收到的中断事件(int)3392。当执行图操作时,由图形处理引擎产生的有效地址3393由mmu 3339转换为实际地址。

317.在一个实施例中,为每个图形处理引擎和/或图形加速模块3346复制相同的寄存器组3345,并且可以由系统管理程序或操作系统来初始化。这些复制的寄存器中的每一个都可以包含在加速器集成切片3390中。表1中显示了可由管理程序初始化的示例性寄存器。

318.表1

–

管理程序初始化的寄存器

319.1切片控制寄存器2实地址(ra)计划的处理区域指针3授权掩码覆盖寄存器4中断向量表输入偏移5中断向量表入口限制6状态寄存器7逻辑分区id8实地址(ra)管理程序加速器利用率记录指针9存储描述寄存器

320.表2中示出了可以由操作系统初始化的示例性寄存器。

321.表2

–

操作系统初始化寄存器

[0322][0323][0324]

在一个实施例中,每个wd 3384特定于特定的图形加速模块3346和/或特定图形处理引擎。它包含图形处理引擎进行工作或工作所需的所有信息,或者它可以是指向存储器位置的指针,其中应用程序建立了要完成的工作的命令队列。

[0325]

图34a-34b示出了根据本文至少一个实施例的示例性图形处理器。在至少一个实施例中,任何示例性图形处理器可以使用一个或更多个ip核心来制造。除了图示之外,在至少一个实施例中可以包括其他逻辑和电路,包括附加的图形处理器/核心、外围接口控制器

或通用处理器核心。在至少一个实施例中,示例性图形处理器用于soc内。

[0326]

图34a示出了根据至少一个实施例的soc集成电路的示例性图形处理器3410,其可以使用一个或更多个ip核心来制造。图34b示出了根据至少一个实施例的soc集成电路的的附加示例性图形处理器3440,其可以使用一个或更多个ip核心来制造。在至少一个实施例中,图34a的图形处理器3410是低功耗图形处理器核心。在至少一个实施例中,图34b的图形处理器3440是更高性能的图形处理器核心。在至少一个实施例中,每个图形处理器3410、3440可以是图5的图形处理器510的变体。

[0327]

在至少一个实施例中,图形处理器3410包括顶点处理器3405和一个或更多个片段处理器3415a-3415n(例如3415a、3415b、3415c、3415d至3415n-1和3415n)。在至少一个实施例中,图形处理器3410可以经由单独的逻辑来执行不同的着色器程序,使得顶点处理器3405被优化以执行针对顶点着色器程序的操作,而一个或更多个片段处理器3415a-3415n执行片段(例如,像素)着色操作用于片段或像素或着色器程序。在至少一个实施例中,顶点处理器3405执行3d图形管线的顶点处理阶段并生成图元和顶点数据。在至少一个实施例中,片段处理器3415a-3415n使用由顶点处理器3405生成的图元和顶点数据来生成在显示设备上显示的帧缓冲区。在至少一个实施例中,片段处理器3415a-3415n被优化以执行如在opengl api中所提供的片段着色器程序,其可以用于执行与在direct 3d api中所提供的像素着色器程序类似的操作。

[0328]