技术特征:

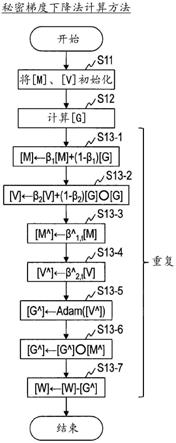

1.一种秘密梯度下降法计算方法,是由包括多个秘密计算装置的秘密梯度下降法计算系统执行的、在至少将梯度g和参数w隐匿的状态下对梯度下降法进行计算的秘密梯度下降法计算方法,其中,设β1、β2、η、ε为预先确定的超参数,

○

为每个元素的积,t为学习次数,[g]为所述梯度g的隐匿值,[w]为所述参数w的隐匿值,[m]、[m

^

]、[v]、[v

^

]、[g

^

]为元素数量与所述梯度g相等的矩阵m、m

^

、v、v

^

、g

^

的隐匿值,并设β

^1,t

、β

^2,t

、g

^

为下式,[公式1]设adam为对将值v

^

的矩阵v

^

的隐匿值[v

^

]作为输入而输出值g

^

的矩阵g

^

的隐匿值[g

^

]的秘密批量映射进行计算的函数,各秘密计算装置的参数更新部计算[m]

←

β1[m] (1-β1)[g],所述参数更新部计算[v]

←

β2[v] (1-β2)[g]

○

[g],所述参数更新部计算[m

^

]

←

β

^1,t

[m],所述参数更新部计算[v

^

]

←

β

^2,t

[v],所述参数更新部计算[g

^

]

←

adam([v

^

]),所述参数更新部计算[g

^

]

←

[g

^

]

○

[m

^

],所述参数更新部计算[w]

←

[w]-[g

^

]。2.根据权利要求1所述的秘密梯度下降法计算方法,其中,设rshift为算术右移位,b

β

为β1和β2的精度,b

β^_1

为β

^1,t

的精度,b

g^

为g

^

的精度,所述参数更新部在计算[m]

←

β1[m] (1-β1)[g]后,计算[m]

←

rshift([m],b

β

),所述参数更新部在计算[v]

←

β2[v] (1-β2)[g]

○

[g]后,计算[v]

←

rshift([v],b

β

),所述参数更新部在计算[g

^

]

←

[g

^

]

○

[m

^

]后,计算[g

^

]

←

rshift([g

^

],b

g^

b

β^_1

)。3.一种秘密深度学习方法,是由包括多个秘密计算装置的秘密深度学习系统执行的、在至少将学习数据的特征量x、学习数据的正确答案数据t和参数w隐匿的状态下对深度神经网络进行学习的秘密深度学习方法,其中,设β1、β2、η、ε为预先确定的超参数,

·

为矩阵的积,

○

为每个元素的积,t为学习次数,[g]为梯度g的隐匿值,[w]为所述参数w的隐匿值,[x]为所述学习数据的特征量x的隐匿值,[t]为所述学习数据的正确答案标签t的隐匿值,[m]、[m

^

]、[v]、[v

^

]、[g

^

]、[u]、[y]、[z]为元素数量与所述梯度g相等的矩阵m、m

^

、v、v

^

、g

^

、u、y、z的隐匿值,并设β

^1,t

、β

^2,t

、g

^

为下式,[公式2]设adam为对将值v

^

的矩阵v

^

的隐匿值[v

^

]作为输入而输出值g

^

的矩阵g

^

的隐匿值[g

^

]的秘密批量映射进行计算的函数,rshift为算术右移位,m为在一次学习中使用的学习数据的数量,h’为下式,[公式3]

设n为所述深度神经网络的隐藏层的数量,activation为所述隐藏层的激活函数,activation2为所述深度神经网络的输出层的激活函数,activation2’为与所述激活函数activation2对应的损失函数,activation’为所述激活函数activation的微分,各秘密计算装置的正向传播部计算[u1]

←

[w0]

·

[x],所述正向传播部计算[y1]

←

activation([u1]),所述正向传播部针对1以上且n-1以下的各i计算[u

i 1

]

←

[w

i

]

·

[y

i

],所述正向传播部针对1以上且n-1以下的各i计算[y

i 1

]

←

activation([u

i 1

]),所述正向传播部计算[u

n 1

]

←

[w

n

]

·

[y

n

],所述正向传播部计算[y

n 1

]

←

activation2([u

n 1

]),各秘密计算装置的反向传播部计算[z

n 1

]

←

activation2’([y

n 1

],[t]),所述反向传播部计算[z

n

]

←

activation’([u

n

])

○

([z

n 1

]

·

[w

n

]),所述反向传播部针对1以上且n-1以下的各i计算[z

n-i

]

←

activation’([u

n-i

])

○

([z

n-i 1

]

·

[w

n-i

]),各秘密计算装置的梯度计算部计算[g0]

←

[z1]

·

[x],所述梯度计算部针对1以上且n-1以下的各i计算[g

i

]

←

[z

i 1

]

·

[y

i

],所述梯度计算部计算[g

n

]

←

[z

n 1

]

·

[y

n

],各秘密计算装置的参数更新部计算[g0]

←

rshift([g0],h’),所述参数更新部针对1以上且n-1以下的各i计算[g

i

]

←

rshift([g

i

],h’),所述参数更新部计算[g

n

]

←

rshift([g

n

],h’),所述参数更新部针对0以上且n以下的各i,通过权利要求1所述的秘密梯度下降法计算方法,使用i层与i 1层之间的梯度[g

i

]来学习i层与i 1层之间的参数[w

i

]。4.根据权利要求3所述的秘密深度学习方法,其中,设b

w

为w的精度,b

y

为y的元素的精度,b

β

为β1和β2的精度,b

β^_1

为β

^1,t

的精度,b

g^

为g

^

的精度,所述正向传播计算部在计算[y

i 1

]

←

activation([u

i 1

])后,计算[y

i 1

]

←

rshift([y

i 1

],b

w

),所述反向传播计算部在计算[z

n

]

←

activation’([u

n

])

○

([z

n 1

]

·

[w

n

])后,计算[z

n

]

←

rshift([z

n

],b

y

),各所述反向传播计算部在计算[z

n-i

]

←

activation’([u

n-i

])

○

([z

n-i 1

]

·

[w

n-i

])后,计算[z

n-i

]

←

rshift([z

n-i

],b

w

),所述参数更新部针对0以上且n以下的各i,通过权利要求2所述的秘密梯度下降法计算方法,使用i层与i 1层之间的梯度[g

i

]来学习i层与i 1层之间的参数[w

i

]。5.一种秘密梯度下降法计算系统,包括多个秘密计算装置,在至少将梯度g和参数w隐匿的状态下对梯度下降法进行计算,其中,设β1、β2、η、ε为预先确定的超参数,

○

为每个元素的积,t为学习次数,[g]为所述梯度g的隐匿值,[w]为所述参数w的隐匿值,[m]、[m

^

]、[v]、[v

^

]、[g

^

]为元素数量与所述梯度g相等的矩阵m、m

^

、v、v

^

、g

^

的隐匿值,并设β

^1,t

、β

^2,t

、g

^

为下式,[公式4]

设adam为对将值v

^

的矩阵v

^

的隐匿值[v

^

]作为输入而输出值g

^

的矩阵g

^

的隐匿值[g

^

]的秘密批量映射进行计算的函数,各秘密计算装置包括参数更新部,该参数更新部计算[m]

←

β1[m] (1-β1)[g]、[v]

←

β2[v] (1-β2)[g]

○

[g]、[m

^

]

←

β

^1,t

[m]、[v

^

]

←

β

^2,t

[v]、[g

^

]

←

adam([v

^

])、[g

^

]

←

[g

^

]

○

[m

^

]、[w]

←

[w]-[g

^

]。6.一种秘密深度学习系统,包括多个秘密计算装置,在至少将学习数据的特征量x、学习数据的正确答案数据t和参数w隐匿的状态下对深度神经网络进行学习,其中,设β1、β2、η、ε为预先确定的超参数,

·

为矩阵的积,

○

为每个元素的积,t为学习次数,[g]为梯度g的隐匿值,[w]为所述参数w的隐匿值,[x]为所述学习数据的特征量x的隐匿值,[t]为所述学习数据的正确答案标签t的隐匿值,[m]、[m

^

]、[v]、[v

^

]、[g

^

]、[u]、[y]、[z]为元素数量与所述梯度g相等的矩阵m、m

^

、v、v

^

、g

^

、u、y、z的隐匿值,并设β

^1,t

、β

^2,t

、g

^

为下式,[公式5]设adam为对将值v

^

的矩阵v

^

的隐匿值[v

^

]作为输入而输出值g

^

的矩阵g

^

的隐匿值[g

^

]的秘密批量映射进行计算的函数,rshift为算术右移位,m为在一次学习中使用的学习数据的数量,h’为下式,[公式6]设n为所述深度神经网络的隐藏层的数量,activation为所述隐藏层的激活函数,activation2为所述深度神经网络的输出层的激活函数,activation2’为与所述激活函数activation2对应的损失函数,activation’为所述激活函数activation的微分,各秘密计算装置包括:正向传播部,计算[u1]

←

[w0]

·

[x]、[y1]

←

activation([u1])、针对1以上且n-1以下的各i的[u

i 1

]

←

[w

i

]

·

[y

i

]、[y

i 1

]

←

activation([u

i 1

])、[u

n 1

]

←

[w

n

]

·

[y

n

]、[y

n 1

]

←

activation2([u

n 1

]);反向传播部,计算[z

n 1

]

←

activation2’([y

n 1

],[t])、[z

n

]

←

activation’([u

n

])

○

([z

n 1

]

·

[w

n

])、针对1以上且n-1以下的各i的[z

n-i

]

←

activation’([u

n-i

])

○

([z

n-i 1

]

·

[w

n-i

]);梯度计算部,计算[g0]

←

[z1]

·

[x]、针对1以上且n-1以下的各i的[g

i

]

←

[z

i 1

]

·

[y

i

]、[g

n

]

←

[z

n 1

]

·

[y

n

];及参数更新部,计算[g0]

←

rshift([g0],h’)、针对1以上且n-1以下的各i的[g

i

]

←

rshift([g

i

],h’)、[g

n

]

←

rshift([g

n

],h’),并针对0以上且n以下的各i,通过权利要求5所述的秘密梯度下降法计算系统,使用i层与i 1层之间的梯度[g

i

]来学习i层与i 1层之间的参数[w

i

]。7.一种秘密计算装置,在权利要求5所述的秘密梯度下降法计算系统或权利要求6所述

的秘密深度学习系统中使用。8.一种程序,用于使计算机作为权利要求7所述的秘密计算装置发挥功能。

技术总结

在保持精度的状态下高速地进行秘密计算上的梯度下降法的计算。秘密梯度下降法计算方法在将梯度和参数隐匿的状态下对梯度下降法进行计算。初始化部将矩阵M、V的隐匿值[M]、[V]初始化(S11)。梯度计算部求出梯度g的矩阵G的隐匿值[G](S12)。参数更新部计算[M]

技术研发人员:三品气吹 五十岚大 滨田浩气

受保护的技术使用者:日本电信电话株式会社

技术研发日:2019.08.14

技术公布日:2022/3/18

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。