1.本发明属于智慧教育资源知识标注领域,更具体地,涉及一种知识点自动标注建模方法及系统。

背景技术:

2.数学试题知识点自动标注的主要任务是根据数学试题及解答文本,预测出试题所属的知识点,该任务在自然语言处理领域属于文本多标签分类任务,并且针对数学试题的特殊领域属性,需要进行一定的文本处理。在各个学科领域,试题资源占主导,为能给每个学生以更合适的个性化学习方案,对试题资源建立一个良好的索引结构显得尤为重要。这就需要使用知识点自动标注技术对试题进行自动标注,使得试题资源能够合理地标签化,进而规模化为对海量级别试题资源进行的自动标注任务,对实现智能教学系统中基于试题的认知诊断以及试题个性化自动推荐具有重要作用。

3.目前最广泛使用的标注方法是人工手动标注,手动标注主要通过聘请专家来对资源进行标注,虽然标注结果都较为准确,但这种方式需要大量的人力投入,在标签的一致性、可信度和后期的维护更新等问题上也都存在一定局限,这使得智能教学系统依旧不能脱离以人工成果为基础的运转,也就意味着教育技术不能从根本上变得智能。

4.当前也有一些知识点自动标注方法通过采用自然语言处理领域通用的分类模型来对试题资源进行标签分类。然而,通用的分类模型主要聚焦于算法的实现和改进,缺乏了对领域知识的融合,忽视了数学学科的特点,具体地,它们缺乏对数学试题的文本特征和语义信息的提取和研究;另外,大多数现有的分类模型都是基于二分类模型的,而数学试题往往与多个且数量不定的知识点标签相关联,标签与标签之间也有一定的关联,现有的大多数分类模型很难在捕获试题语义信息的同时考虑标签之间的联系,并且已有的知识点自动标注方法也很少关注文本多标签分类。

5.对于小学数学几何试题自动标注任务,考虑到试题常常会与多个知识点标签相关联,知识点标签往往比较固定统一,因此最常见的就是将自动标注任务视作多标签多分类任务。在处理多标签分类任务时,已有的技术大多是采用循环神经网络rnn一类的深度学习模型,但是这一类模型并不能很好的提取数学试题的用于做分类用的语义信息,所以需要找到能更好提取试题文本语义等信息的神经网络模型,这也是实现知识点自动标注技术的一大突破点。

6.为了便于理解本发明,以下对有关术语和相关概念进行解释:

7.本体:本发明中的本体指的是小学几何概念中的本体,具体为:小学数学几何概念中的数学对象的总称,例如:三角形、四边形、线、边等。

8.实体:本发明中的实体指的是小学几何试题中的实体,具体为:小学数学几何概念中的数学对象在数学试题文本中的具体表达名称,例如:三角形abc,边ac、角a等。

9.本体库:由小学几何知识体系中的本体组成,包括核心本体和属性本体,核心本体为不能够作为其他本体的属性的本体,如三角形、四边形等;属性本体为能够作为其他本体

的属性的本体,如线、边等;

技术实现要素:

10.针对现有技术的缺陷,本发明的目的在于提供一种知识点自动标注建模方法及系统,旨在解决对小学数学几何试题进行知识点自动标注的问题。

11.为实现上述目的,本发明提供了一种知识点自动标注建模方法包括以下步骤:

12.(1)统一处理步骤:

13.对初始试题集中的所有知识点加以知识点标签,所有的知识点标签组成知识点集;所述初始试题集由小学几何试题组成;

14.对于初始试题集中的每个试题,将其包含的所有的知识点标签进行全排列,对每一种知识点标签排列方式生成其对应的有序集合,所有的有序集合组成该试题的标签组集合;所有试题的标签组集合组成标签组总集;

15.(2)本体试题获取步骤:

16.对所述初始试题集中的每个试题,根据匹配模板,获得其对应的本体试题;所有试题的本体试题组成本体试题集;

17.所述匹配模板由本体库中的所有本体及其对应的正则表达式和本体标识符组成;

18.(3)输入样本获取步骤:

19.根据所述本体试题集和所述标签组总集,获得统一预训练语言模型的输入样本;

20.(4)模型训练步骤:

21.将所述输入样本输入到统一预训练语言模型中,并按设定的轮数epoch和批输入量batch_size进行训练;每一轮训练结束之后得到一个该轮训练的标注模型;

22.(5)模型获得步骤:

23.根据所有的所述标注模型,获得知识点自动标注模型。

24.优选地,所述本体试题获取步骤包括以下子步骤:

25.(1)实体识别子步骤:

26.对所述初始试题集中每个试题的每个实体,在所述匹配模板中查找与该实体相匹配的正则表达式,匹配成功的正则表达式对应的本体为该实体对应的本体;

27.对所有的实体进行编号操作,所述编号操作的目的是使得下述同一试题的不同实体的本体标识互不相同;

28.(2)本体替换子步骤:

29.根据两个实体中出现的重复字符,来确定其对应的两个本体之间的属性关系;

30.将每个实体替换为对应的本体的本体标识,核心本体的本体标识由本体标识符和对应的实体的编号组成;属性本体的本体标识依次由其所属的核心本体的本体标识符、该属性本体的本体标识符和该属性本体对应的实体的编号组成。

31.优选地,所述输入样本获取步骤包括以下子步骤:

32.(1)数据集划分子步骤:

33.将所述本体试题集按设定的比例划分为训练集和测试集;

34.在所述标签组总集中查找所述训练集中的每个本体试题对应的标签组集合,并将查找到的标签组集合加入到所述训练集中;

35.在所述标签组总集中查找所述测试集中的每个本体试题对应的标签组集合,并将查找到的标签组集合加入到所述测试集中;

36.(2)分词子步骤:

37.使用python分词工具对所述训练集中的所有的本体试题进行分词,得到一个分词词典;

38.(3)短文本替换子步骤:

39.在python分词工具自带的词典中查找得到不属于所述分词词典的多个互不相同的词,组成短文本集,所述短文本集与知识点集里的元素总数相等;

40.建立从所述短文本集到所述知识点集的短文本映射:将所述短文本集中的所有元素随机映射到所述知识点集里的所有元素;所述短文本映射为满映射;

41.以所述训练集中的每个标签组集合为原像集,根据所述短文本映射,得到一个子映射,并将其像集中的每个像依次用至少一个连接符连接起来,形成一个标签集合文本;

42.(4)拼接子步骤:

43.对所述训练集中的每个本体试题,依次将该本体试题和其对应的所有标签集合文本进行头尾拼接得到单个样本;在拼接时需要在本体试题的头部增加头部标记,在本体试题的尾部增加尾部标记,在标签集合文本的尾部增加尾部标记;

44.所述训练集的所有样本组成所述输入样本。

45.优选地,所述模型训练步骤的具体过程为:

46.将所述输入样本输入到统一预训练语言模型中按设定的轮数epoch和批输入量batch_size进行训练;

47.在每一轮训练中,使用bert预训练模型和seq-to-seq掩码方式进行微调训练,并使用优化器adam不断更新统一预训练语言模型的超参数直到交叉熵损失趋于稳定值,此时得到该轮训练的标注模型。

48.优选地,所述模型获得步骤的具体过程为:将所述测试集依次输入所有的所述标注模型,统计每个标注模型输出的试题预测知识点标签与数学试题真实知识点标签,并以此计算每个标注模型的汉明损失,选取汉明损失的值最小的标注模型作为知识点自动标注模型。

49.本发明提供了一种知识点自动标注建模系统,包括:

50.统一处理模块:

51.用于对初始试题集中的所有知识点加以知识点标签,所有的知识点标签组成知识点集;所述初始试题集由小学几何试题组成;

52.对于初始试题集中的每个试题,将其包含的所有的知识点标签进行全排列,对每一种知识点标签排列方式生成其对应的有序集合,所有的有序集合组成该试题的标签组集合;所有试题的标签组集合组成标签组总集;

53.本体试题获取模块:

54.用于对所述初始试题集中的每个试题,根据匹配模板,获得其对应的本体试题;所有试题的本体试题组成本体试题集;

55.所述匹配模板由本体库中的所有本体及其对应的正则表达式和本体标识符组成;

56.输入样本获取模块:

57.用于根据所述本体试题集和所述标签组总集,获得统一预训练语言模型的输入样本;

58.模型训练模块:

59.用于将所述输入样本输入到统一预训练语言模型中,并按设定的轮数epoch和批输入量batch_size进行训练;每一轮训练结束之后得到一个该轮训练的标注模型;

60.模型获得模块:

61.用于根据所有的所述标注模型,获得知识点自动标注模型。

62.优选地,所述本体试题获取模块包括以下子模块:

63.实体识别子模块:

64.用于对所述初始试题集中每个试题的每个实体,在所述匹配模板中查找与该实体相匹配的正则表达式,匹配成功的正则表达式对应的本体为该实体对应的本体;

65.对所有的实体进行编号操作,所述编号操作的目的是使得下述同一试题的不同实体的本体标识互不相同;

66.本体替换子模块:

67.用于根据两个实体中出现的重复字符,来确定其对应的两个本体之间的属性关系;

68.将每个实体替换为对应的本体的本体标识,核心本体的本体标识由本体标识符和对应的实体的编号组成;属性本体的本体标识依次由其所属的核心本体的本体标识符、该属性本体的本体标识符和该属性本体对应的实体的编号组成;

69.所述输入样本获取模块包括以下子模块:

70.数据集划分子模块:

71.将所述本体试题集按设定的比例划分为训练集和测试集;

72.在所述标签组总集中查找所述训练集中的每个本体试题对应的标签组集合,并将查找到的标签组集合加入到所述训练集中;

73.在所述标签组总集中查找所述测试集中的每个本体试题对应的标签组集合,并将查找到的标签组集合加入到所述测试集中;

74.分词子模块:

75.使用python分词工具对所述训练集中的所有的本体试题进行分词,得到一个分词词典;

76.短文本替换子模块:

77.在python分词工具自带的词典中查找得到不属于所述分词词典的多个互不相同的词,组成短文本集,所述短文本集与知识点集里的元素总数相等;

78.建立从所述短文本集到所述知识点集的短文本映射:将所述短文本集中的所有元素随机映射到所述知识点集里的所有元素;所述短文本映射为满映射;

79.以所述训练集中的每个标签组集合为原像集,根据所述短文本映射,得到一个子映射,并将其像集中的每个像依次用至少一个连接符连接起来,形成一个标签集合文本;

80.拼接子模块:

81.对所述训练集中的每个本体试题,依次将该本体试题和其对应的所有标签集合文本进行头尾拼接得到单个样本;在拼接时需要在本体试题的头部增加头部标记,在本体试

题的尾部增加尾部标记,在标签集合文本的尾部增加尾部标记;

82.所述训练集的所有样本组成所述输入样本。

83.优选地,所述模型训练模块包含的具体操作为:

84.将所述输入样本输入到统一预训练语言模型中按设定的轮数epoch和批输入量batch_size进行训练;

85.在每一轮训练中,使用bert预训练模型和seq-to-seq掩码方式进行微调训练,并使用优化器adam不断更新统一预训练语言模型的超参数直到交叉熵损失趋于稳定值,此时得到该轮训练的标注模型;

86.所述模型获得模块包含的具体操作为:

87.将所述测试集依次输入所有的所述标注模型,统计每个标注模型输出的试题预测知识点标签与数学试题真实知识点标签,并以此计算每个标注模型的汉明损失,选取汉明损失的值最小的标注模型作为知识点自动标注模型。

88.本发明提供了一种知识点自动标注建模装置,包括存储器和处理器;所述存储器,用于存储计算机程序;所述处理器,用于当执行所述计算机程序时,实现如上所述的知识点自动标注建模方法。

89.本发明提供了一种计算机可读存储介质,所述存储介质上存储有计算机程序,当所述计算机程序被处理器执行时,实现如上所述的知识点自动标注建模方法。

90.通过本发明所构思的以上技术方案,与现有技术相比,由于本发明对统一预训练语言模型unilm进行训练得到知识点自动标注模型,相比对其他模型进行训练得到的知识点自动标注模型,本发明的模型在提取丰富的小学几何试题文本语义信息的前提下,能够考虑到标签之间的关联关系,高效的完成小学几何试题知识点的预测,并且在一定程度上提高了知识点自动标注的可信度。

91.本发明考虑到小学几何试题的表达特点,针对小学几何本体的重要性和表示形式的多样性,提出基于匹配模板的实体识别和本体替换方法,以缓解小学几何试题文本在深度学习模型训练中的数据稀疏问题,同时能从试题文本中挖掘更多的特征增强自动标注效果。

92.考虑到统一预训练语言模型在对知识点标签的预测过程中是具有一定的顺序的,本发明对于试题中包含的所有的知识点标签进行了全排列处理,使得在微调训练的过程中,统一预训练语言模型能够更好的捕捉数学试题文本与知识点标签之间的关联关系信息,并且能避免知识点标签生成顺序的不一致造成统一预训练语言模型在训练过程中的错误反馈。

93.在生成式任务中,当前知识点标签的生成依赖于上一个知识点标签,考虑到unilm模型对短文本的生成更加精确,本发明对知识点标签进行了短文本替换,降低了生成当前知识点标签的错误率,从而避免生成错误的后续知识点标签。

94.本发明在模型训练过程中,使用bert预训练模型,能够使得统一预训练语言模型提取更加丰富的文本特征;本发明选择seq-to-seq掩码方式进行微调训练,能够使得统一预训练语言模型在执行知识点自动标注任务时能融合试题文本与知识点标签、知识点标签与知识点标签之间的关联关系;由于本发明的输入样本存在数据稀疏以及噪声多问题,因此本发明选用优化器adam进行超参数更新操作,adam可缓解数据稀疏问题、减少数据噪声

过多带来的影响。

附图说明

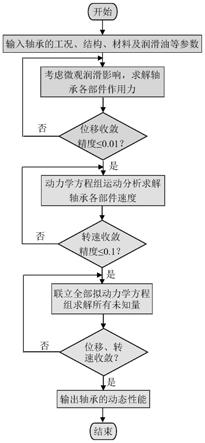

95.图1是本发明实施例提供的知识点自动标注建模方法的流程图;

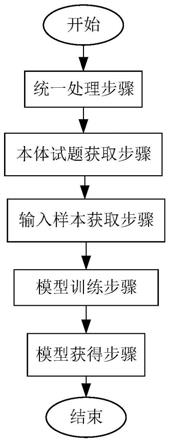

96.图2是本发明实施例提供的知识点自动标注建模方法的本体试题获取步骤的流程图;

97.图3是本发明实施例提供的知识点自动标注建模方法的输入样本获取步骤的流程图。

具体实施方式

98.为了使本发明的目的、技术方案及优点更加清楚明白,以下结合附图及实施例,对本发明进行进一步详细说明。应当理解,此处所描述的具体实施例仅仅用以解释本发明,并不用于限定本发明。

99.如图1所示,本实施例提供了一种知识点自动标注建模方法,包括统一处理步骤、本体试题获取步骤、输入样本获取步骤、模型训练步骤和模型获得步骤。

100.(1)统一处理步骤的具体过程为:

101.对初始试题集中的所有知识点加以知识点标签,所有的知识点标签组成知识点集,知识点集中的知识点标签总数为97;初始试题集由小学几何试题组成,初始试题集中的试题总数为54097;

102.对于初始试题集中的每个试题,将其包含的所有的知识点标签进行全排列,对每一种知识点标签排列方式生成其对应的有序集合,所有的有序集合组成该试题的标签组集合;所有试题的标签组集合组成标签组总集。

103.考虑到统一预训练语言模型在对知识点标签的预测过程中是具有一定的顺序的,本实施例对于试题中包含的所有的知识点标签进行了全排列处理,使得在微调训练的过程中,统一预训练语言模型能够更好的捕捉数学试题文本与知识点标签之间的关联关系信息,并且能避免知识点标签生成顺序的不一致造成统一预训练语言模型在训练过程中的错误反馈。

104.(2)本体试题获取步骤的具体过程为:对于初始试题集中的每个试题,根据匹配模板,获得其对应的本体试题;所有试题的本体试题组成本体试题集;

105.匹配模板由本体库中的所有本体及其对应的正则表达式和本体标识符组成;匹配模板的部分内容如匹配表所示:

106.匹配表

[0107][0108][0109]

如图2所示,本体试题获取步骤包括实体识别子步骤和本体替换子步骤:

[0110]

实体识别子步骤:

[0111]

对初始试题集中每个试题的每个实体,在匹配模板中查找与该实体相匹配的正则表达式,匹配成功的正则表达式对应的本体为该实体对应的本体;

[0112]

对所有的实体进行编号操作,一个实体对应一个编号,编号为单个阿拉伯数字;编号操作的目的是使得下述同一试题的不同实体的本体标识互不相同;

[0113]

本体替换子步骤:

[0114]

根据两个实体中出现的重复字符,来确定其对应的两个本体之间的属性关系;

[0115]

将每个实体替换为对应的本体的本体标识,核心本体的本体标识由本体标识符和对应的实体的编号组成;属性本体的本体标识依次由其所属的核心本体的本体标识符、该属性本体的本体标识符和该属性本体对应的实体的编号组成。

[0116]

以下是本体替换的样例:

[0117]

试题:已知三角形abc为等腰三角形,其中ab=ac=5,若∠abc为60

°

,求bc的长度。

[0118]

本体试题:已知三角形triangle#1为等腰三角形,其中triangle#1的line#1等于triangle#1的line#2等于5,若triangle#1的angle#1为60度,求triangle#1的line#3的长度。

[0119]

本实施例考虑到小学几何试题的表达特点,针对小学几何本体的重要性和表示形式的多样性,提出基于匹配模板的实体识别和本体替换方法,以缓解小学几何试题文本在深度学习模型训练中的数据稀疏问题,同时能从试题文本中挖掘更多的特征增强自动标注效果。

[0120]

(3)输入样本获取步骤的具体过程如下:根据本体试题集和标签组总集,获得统一预训练语言模型的输入样本;

[0121]

如图3所示,输入样本获取步骤包括数据集划分子步骤、分词子步骤、短文本替换子步骤和拼接子步骤:

[0122]

数据集划分子步骤:

[0123]

将本体试题集按设定的比例8:2划分为训练集和测试集;

[0124]

在标签组总集中查找训练集中的每个本体试题对应的标签组集合,并将查找到的标签组集合加入到训练集中;

[0125]

在标签组总集中查找测试集中的每个本体试题对应的标签组集合,并将查找到的标签组集合加入到测试集中;

[0126]

分词子步骤:

[0127]

使用python分词工具对训练集中的所有的本体试题进行分词,得到一个分词词典;

[0128]

python分词工具是一款非常流行的分词工具,具有高性能、准确率、可扩展性等特点。

[0129]

短文本替换子步骤:

[0130]

在python分词工具自带的词典中随机查找得到不属于分词词典的多个互不相同的词,组成短文本集,短文本集与知识点集里的元素总数相等;

[0131]

建立从短文本集到知识点集的短文本映射:将短文本集中的所有元素随机映射到知识点集里的所有元素;短文本映射为满映射;

[0132]

以训练集中的每个标签组集合为原像集,根据短文本映射,得到一个子映射,并将其像集中的每个像依次用至少一个连接符连接起来,形成一个标签集合文本;

[0133]

在生成式任务中,当前知识点标签的生成依赖于上一个知识点标签,考虑到unilm模型对短文本的生成更加精确,本发明对知识点标签进行了短文本替换,降低了生成当前知识点标签的错误率,从而避免生成错误的后续知识点标签。

[0134]

拼接子步骤:

[0135]

对训练集中的每个本体试题,依次将该本体试题和其对应的所有标签集合文本进行头尾拼接得到单个样本;在拼接时需要在本体试题的头部增加头部标记[cls],在本体试题的尾部增加尾部标记[cls],在标签集合文本的尾部增加尾部标记[cls];

[0136]

训练集的所有样本组成输入样本,输入样本的总数为105265。

[0137]

(4)模型训练步骤的具体过程为:

[0138]

将输入样本输入到统一预训练语言模型中按设定的轮数epoch和批输入量batch_size进行训练;每一轮训练结束之后得到一个该轮训练的标注模型;其中,设定的轮数epoch为20,批输入量batch_size为16。

[0139]

unilm模型是微软研究院在预训练模型bert的基础上研究得到的,被称为统一预训练语言模型。它可以完成单向、序列到序列和双向预测任务,能够优秀地处理抽象摘要、生成式问题回答和语言生成任务。

[0140]

在每一轮训练中,使用bert预训练模型和seq-to-seq掩码方式进行微调训练,并使用优化器adam不断更新统一预训练语言模型的超参数直到交叉熵损失趋于稳定值,此时得到该轮训练的标注模型。

[0141]

当模型产生了预测值之后,将对类别的预测标签与真实标签进行比较,使用交叉熵损失函数计算所产生的损失,该损失为交叉熵损失。

[0142]

本实施例在模型训练过程中,使用bert预训练模型,能够使得统一预训练语言模

型提取更加丰富的文本特征;本实施例选择seq-to-seq掩码方式进行微调训练,能够使得统一预训练语言模型在执行知识点自动标注任务时能融合试题文本与知识点标签、知识点标签与知识点标签之间的关联关系;由于本实施例的输入样本存在数据稀疏以及噪声多问题,因此本实施例选用优化器adam进行超参数更新操作,adam可缓解数据稀疏问题、减少数据噪声过多带来的影响。

[0143]

(5)模型获得步骤的具体过程为:

[0144]

将测试集依次输入所有的标注模型,统计每个标注模型输出的试题预测知识点标签与数学试题真实知识点标签,并以此计算每个标注模型的汉明损失,选取汉明损失的值最小的标注模型作为知识点自动标注模型。本实施例选择汉明损失的值为0.0063的标注模型作为最终的知识点自动标注模型。

[0145]

汉明损失用于考察样本在单个标签上的误分类情况,该指标取值越小则模型的分类性能越优,它的最优值为0代表所有的每一个样本的所有标签都被分对。

[0146]

本实施例对统一预训练语言模型unilm进行训练得到知识点自动标注模型,相比对其他模型进行训练得到的知识点自动标注模型,本实施例的模型在提取丰富的小学几何试题文本语义信息的前提下,能够考虑到标签之间的关联关系,高效的完成小学几何试题知识点的预测,并且在一定程度上提高了知识点自动标注的可信度。

[0147]

本发明提供了一种知识点自动标注建模系统,包括:

[0148]

统一处理模块:

[0149]

用于对初始试题集中的所有知识点加以知识点标签,所有的知识点标签组成知识点集;初始试题集由小学几何试题组成;

[0150]

对于初始试题集中的每个试题,将其包含的所有的知识点标签进行全排列,对每一种知识点标签排列方式生成其对应的有序集合,所有的有序集合组成该试题的标签组集合;所有试题的标签组集合组成标签组总集;

[0151]

本体试题获取模块:

[0152]

用于对初始试题集中的每个试题,根据匹配模板,获得其对应的本体试题;所有试题的本体试题组成本体试题集;

[0153]

匹配模板由本体库中的所有本体及其对应的正则表达式和本体标识符组成;

[0154]

输入样本获取模块:

[0155]

用于根据本体试题集和标签组总集,获得统一预训练语言模型的输入样本;

[0156]

模型训练模块:

[0157]

用于将输入样本输入到统一预训练语言模型中,并按设定的轮数epoch和批输入量batch_size进行训练;每一轮训练结束之后得到一个该轮训练的标注模型;

[0158]

模型获得模块:

[0159]

用于根据所有的标注模型,获得知识点自动标注模型。

[0160]

本体试题获取模块包括以下子模块:

[0161]

实体识别子模块:

[0162]

用于对初始试题集中每个试题的每个实体,在匹配模板中查找与该实体相匹配的正则表达式,匹配成功的正则表达式对应的本体为该实体对应的本体;

[0163]

对所有的实体进行编号操作,编号操作的目的是使得下述同一试题的不同实体的

本体标识互不相同;

[0164]

本体替换子模块:

[0165]

用于根据两个实体中出现的重复字符,来确定其对应的两个本体之间的属性关系;

[0166]

将每个实体替换为对应的本体的本体标识,核心本体的本体标识由本体标识符和对应的实体的编号组成;属性本体的本体标识依次由其所属的核心本体的本体标识符、该属性本体的本体标识符和该属性本体对应的实体的编号组成;

[0167]

输入样本获取模块包括以下子模块:

[0168]

数据集划分子模块:

[0169]

将本体试题集按设定的比例划分为训练集和测试集;

[0170]

在标签组总集中查找训练集中的每个本体试题对应的标签组集合,并将查找到的标签组集合加入到训练集中;

[0171]

在标签组总集中查找测试集中的每个本体试题对应的标签组集合,并将查找到的标签组集合加入到测试集中;

[0172]

分词子模块:

[0173]

使用python分词工具对训练集中的所有的本体试题进行分词,得到一个分词词典;

[0174]

短文本替换子模块:

[0175]

在python分词工具自带的词典中查找得到不属于分词词典的多个互不相同的词,组成短文本集,短文本集与知识点集里的元素总数相等;

[0176]

建立从短文本集到知识点集的短文本映射:将短文本集中的所有元素随机映射到知识点集里的所有元素;短文本映射为满映射;

[0177]

以训练集中的每个标签组集合为原像集,根据短文本映射,得到一个子映射,并将其像集中的每个像依次用至少一个连接符连接起来,形成一个标签集合文本;

[0178]

拼接子模块:

[0179]

对训练集中的每个本体试题,依次将该本体试题和其对应的所有标签集合文本进行头尾拼接得到单个样本;在拼接时需要在本体试题的头部增加头部标记,在本体试题的尾部增加尾部标记,在标签集合文本的尾部增加尾部标记;

[0180]

训练集的所有样本组成输入样本。

[0181]

模型训练模块包含的具体操作为:

[0182]

将输入样本输入到统一预训练语言模型中按设定的轮数epoch和批输入量batch_size进行训练;

[0183]

在每一轮训练中,使用bert预训练模型和seq-to-seq掩码方式进行微调训练,并使用优化器adam不断更新统一预训练语言模型的超参数直到交叉熵损失趋于稳定值,此时得到该轮训练的标注模型;

[0184]

模型获得模块包含的具体操作为:

[0185]

将测试集依次输入所有的标注模型,统计每个标注模型输出的试题预测知识点标签与数学试题真实知识点标签,并以此计算每个标注模型的汉明损失,选取汉明损失的值最小的标注模型作为知识点自动标注模型。

[0186]

本领域的技术人员容易理解,以上所述仅为本发明的较佳实施例而已,并不用以限制本发明,凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。