core图的搜寻可以在与超图的大小(结点数量多少)成线性比例的时间复杂度内完成;

12.s3、计算超图k-core中任意结点的v重要性cr(v),cr(v)表示在超图k-core中将一个结点v删除后整个k-core结点减少的个数;

13.s4、在k-core子图上进行结点的采样产生训练数据集;

14.s5、将采样产生的训练数据作为输入,在超图神经网络(hgnn)基础上融合自注意力机制进行训练;

15.s6、在给定图g,k-core值k以及结点集大小b等参数下,使用训练完成的网络预测在给定部分结果集u后,剩下所有结点作为关键结点加入结果集u的概率p;

16.s7、找到图数据上的关键结点集u

max

,u

max

=argmaxucr(u)。

17.优选的,所述步骤s1具体包括:

18.s11、基于原始数据集的各个模态构建多个超图g1,g2,

…gn

,gn=(vn,en,wn);其中vn代表第n个模态的顶点集,en代表超边集,wn代表超边的权重;

19.s12、将超图gn表示为|vn|

×

|en|关联矩阵hn的形式,其中

[0020][0021]

s13、将超图g1,g2,

…gn

对应的关联矩阵h1,h2,

…hn

进行连接,得到的h对应多模态的超图g。

[0022]

优选的,所述步骤s2具体包括:

[0023]

s21、给定超图g=(v,e,w),计算v中所有结点v的度d(v);

[0024]

s22、赋值k为1;

[0025]

s23、判断超图g是否为空,若为空跳转至s211;

[0026]

s24、判断是否存在v∈v,使得d(v)≤k;若不存在,跳转至s210;

[0027]

s25、遍历e(v)中的每条边e;

[0028]

s26、对于e中的所有结点u,赋值d(u)为d(u)-1;

[0029]

s27、将e从e中删除,跳转s25直至遍历完e(v)中的所有边;

[0030]

s28、将v从v中删除;

[0031]

s29、赋值core(v)为k,跳转s24直至遍历完所有顶点v;

[0032]

s210、赋值k为k 1,跳转s23直至超图g为空;

[0033]

s211、k-core为core(v)大于等于k的所有结点v以及结点之间的边所构成的图;

[0034]

s212、返回k-core图ck(g)。

[0035]

优选的,所述步骤s3具体包括:

[0036]

s31、给定超图g=(v,e,w),遍历v中所有结点v;

[0037]

s32、赋值g

copy

为g,将结点v从g

copy

中删除得到g';

[0038]

s33、将g'输入步骤s2得到k-core图ck(g');

[0039]

s34、计算cr(v),cr(v)=ck(g)\(ck(g')∪v);

[0040]

s35、跳转s31,直至遍历完v中所有结点v;

[0041]

s36、返回所有结点的cr(v)。

[0042]

优选的,所述步骤s4具体包括:

[0043]

s41、给定要搜寻的关键结点的个数b,训练集的大小n;

[0044]

s42、从[1,b-1]中随机生成随机数m作为采样集的大小;

[0045]

s43、按照概率从结点集v中选取结点u加入关键结点集s;

[0046]

s44、跳转步骤s43直至采样关键结点集的大小为m,生成一条训练数据x;

[0047]

s45、按照概率生成已知采样结点集s,其他结点u加入关键结点集的概率,作为训练标签y;

[0048]

s46、跳转步骤s42直至生成训练集x的大小为n;

[0049]

s47、返回生成的训练集x以及相对应的软标签y。

[0050]

优选的,所述步骤s5具体包括:

[0051]

s51、将数据集x以及相对应的软标签y输入图神经网络模块;

[0052]

s52、使用交叉熵等作为损失对网络进行训练,训练后的网络能够预测在给定关键结点集s,剩余结点作为关键结点的概率;

[0053]

s53、返回训练完成的网络n。

[0054]

优选的,所述步骤s6具体包括:

[0055]

s61、输入关键结点集s;

[0056]

s62、将关键结点集进行向量表示后输入步骤s4训练完成的网络中,得到其他所有结点加入此关键结点集的概率p;

[0057]

s63、返回其他结点加入关键结点集的概率p。

[0058]

优选的,所述步骤s7具体包括:

[0059]

s71、给定要搜寻的图g,关键结点的个数b,k-core大小k;

[0060]

s72、赋值关键结点集u为空集;

[0061]

s73、根据所述步骤s5生成的结点加入关键结点集的概率p,从剩余所有结点中选取概率最大的结点加入关键结点集u;

[0062]

s74、重复s73直至关键结点集u的大小为b;

[0063]

s75、返回关键结点集u。

[0064]

经由上述的技术方案可知,与现有技术相比,本发明公开提供了一种基于超图神经网络的关键结点集发现方法,克服了普通图上贪心算法无法利用图结构以及在大规模数据集上组合优化复杂性过高的问题,能够更加灵活、更加准确的建模现实生活中大量存在的图数据而不存在传统方法将数据转换成普通图的数据损失;另一方面基于超图神经网络能够天然地建模图结构信息并且通过采样结点集的监督学习能够隐式地表征结点组合的重要性。

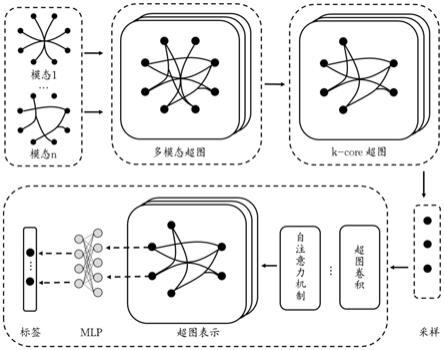

附图说明

[0065]

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据提供的附图获得其他的附图。

[0066]

图1附图为本发明提供的超图的结构示意图;

[0067]

图2附图为本发明提供的基于超图神经网络的图数据关键结点集发现的框架图;

[0068]

图3附图为本发明提供的超图神经网络模块的具体组成示意图。

具体实施方式

[0069]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0070]

本发明实施例公开了一种基于超图神经网络的关键结点集发现方法,具体包括以下步骤:

[0071]

s1、将原始图数据使用超图进行建模,建模后的超图g如图1所示,g=(v,e,w),其中v代表顶点集,e代表超边集,w代表超边的权重;

[0072]

为了进一步优化上述技术方案,步骤s1具体包括:

[0073]

s11、基于原始数据集的各个模态构建多个超图g1,g2,

…gn

,gn=(vn,en,wn);其中vn代表第n个模态的顶点集,en代表超边集,wn代表超边的权重;

[0074]

s12、将超图gn表示为|vn|

×

|en|关联矩阵hn的形式,其中

[0075]

s13、两种根据不同模态构建的超图结点相同,因此可将超图g1,g2,

…gn

对应的关联矩阵h1,h2,

…hn

进行连接,得到的h对应多模态的超图g。

[0076]

以dblp数据集为例,可以将作者作为结点,将作者的信息建模为结点的属性,将一篇文章中的所有作者构建成一条超边,文章的信息作为超边的属性,获得作者合作关系的超图数据集g1。另一方面可以将参考文献中所有文章的第一作者或通信作者之间构建一条超边,超边代表其中作者的工作被同一篇文章引用,获得引用关系的超图数据集g2;将超图g1表示为|v1|

×

|e1|

[0077]

关联矩阵h1的形式,其中同理将超图g2表示为关联矩阵h2的形式,两种根据不同模态构建的超图结点相同,因此可将两种超图的关联矩阵进行连接得到关联矩阵h,得到的h对应多模态的超图g。

[0078]

s2、在超图结构数据集上进行k-core子图搜寻;超图上k-core表示超图中的一个极大子图,其中每一个结点的度(该结点所包含的超边条数)大于等于k;在超图上进行k-core图的搜寻可以在与超图的大小(结点数量多少)成线性比例的时间复杂度内完成;

[0079]

为了进一步优化上述技术方案,步骤s2具体包括:

[0080]

s21、给定超图g=(v,e,w),计算结点集v中所有结点v的度d(v);

[0081]

s22、赋值k为1;

[0082]

s23、判断超图g是否为空,若为空跳转至s211;

[0083]

s24、判断是否存在v∈v,使得d(v)≤k;若不存在,跳转至s210;

[0084]

s25、遍历e(v)中的每条边e;

[0085]

s26、对于e中的所有结点u,赋值d(u)为d(u)-1;

[0086]

s27、将e从e中删除,跳转s25直至遍历完e(v)中的所有边;

[0087]

s28、将v从v中删除;

[0088]

s29、赋值core(v)为k,跳转s24直至遍历完所有顶点v;

[0089]

s210、赋值k为k 1,跳转s23直至超图g为空;

[0090]

s211、k-core为core(v)大于等于k的所有结点v以及结点之间的边所构成的图;

[0091]

s212、返回k-core图ck(g)。

[0092]

s3、计算超图k-core中任意结点的v重要性cr(v),cr(v)表示在超图k-core中将一个结点v删除后整个k-core结点减少的个数;

[0093]

为了进一步优化上述技术方案,步骤s3具体包括:

[0094]

s31、给定超图g=(v,e,w),遍历v中所有结点v;

[0095]

s32、赋值g

copy

为g,将结点v从g

copy

中删除得到g';

[0096]

s33、将g'输入步骤s2得到k-core图ck(g');

[0097]

s34、计算cr(v),cr(v)=ck(g)\(ck(g')∪v);

[0098]

s35、跳转s31,直至遍历完v中所有结点v;

[0099]

s36、返回所有结点的cr(v)。

[0100]

s4、在k-core子图上进行结点的采样产生训练数据集;

[0101]

为了进一步优化上述技术方案,步骤s4具体包括:

[0102]

s41、给定要搜寻的关键结点的个数b,训练集的大小n;

[0103]

s42、从[1,b-1]中随机生成随机数m作为采样集的大小;

[0104]

s43、按照概率从结点集v中选取结点u加入关键结点集s;

[0105]

s44、跳转步骤s43直至采样关键结点集的大小为m,生成一条训练数据x;如果结点v被采样,将该结点的初始特征设置为1,否则设置为0。另外还可以加入该结点的其他特征比如该结点的聚类系数、该结点所在的最大k-core的k值等;

[0106]

s45、按照概率生成已知采样结点集s,其他结点u加入关键结点集s的概率,作为训练标签y;

[0107]

s46、跳转步骤s43直至生成训练集x的大小为n;

[0108]

s47、返回生成的训练集x以及相对应的软标签y,其中x=[x1,x2,

…

,xn]

t

。

[0109]

s5、将采样产生的训练数据作为输入,在超图神经网络(hgnn)基础上融合自注意力机制进行训练;

[0110]

为了进一步优化上述技术方案,步骤s5具体包括:

[0111]

s51、构建超图ck(g)上的拉普拉斯矩阵δ,(g)上的拉普拉斯矩阵δ,dv,dv分别代表对角化的结点的度和边的度。

[0112]

s52、在训练集x中,x=[x1,x2,

…

,x

|v|

]表示超图中的顶点特征,其中x∈r

|v|*d

,每个顶点有d维特征,xi代表顶点i的特征,i∈{1,2,

…

,|v|}。将顶点特征x和超图拉普拉斯矩阵δ输入超图卷积层,再经过非线性变换。得到输出x':其中θ是可学习参数,σ是relu激活函数。

[0113]

s53、将经过第一层超图卷积的输出x'作为输入,再次输入超图卷积层,得到经过

两层超图卷积的输出:

[0114]

s54、使用自注意力机制对两层超图卷积生成的结点表示进行加和,首先生成注意力权重矩阵att,att=softmax(w

s2

tanh(w

s1

y'

t

))。w

s1

,w

s2

为两个权重矩阵。

[0115]

s55、将注意力权重矩阵att与y'相乘得到最终的超图表示

[0116]

s56、将e展开为向量e,将向量e输入到多层感知机中,使用交叉熵作为损失对网络进行训练,训练后的网络能够预测在给定关键结点集s,剩余结点作为关键结点的概率;

[0117]

s57、返回训练完成的网络n;

[0118]

s6、在给定图g,k-core值k以及结点集大小b等参数下,使用训练完成的网络预测在给定部分结果集u后,剩下所有结点作为关键结点加入结果集u的概率p;

[0119]

为了进一步优化上述技术方案,步骤s6具体包括:

[0120]

s61、输入关键结点集s;

[0121]

s62、将关键结点集进行向量表示后输入步骤s4训练完成的网络中,得到其他所有结点加入此关键结点集的概率p;

[0122]

s63、返回其他结点加入关键结点集的概率p。

[0123]

s7、找到图数据上的关键结点集u

max

,u

max

=argmaxucr(u);

[0124]

为了进一步优化上述技术方案,步骤s7具体包括:

[0125]

s71、给定要搜寻的图g,关键结点的个数b,k-core大小k;

[0126]

s72、赋值关键结点集u为空集;

[0127]

s73、根据训练完成的网络预测的其余结点加入关键结点集的概率p,从剩余所有结点中选取概率最大的结点加入关键结点集u;

[0128]

s74、重复s73直至关键结点集u的大小为b;

[0129]

s75、返回关键结点集u。

[0130]

本发明公开提供了一种基于超图神经网络的关键结点集发现方法,克服了普通图上贪心算法无法利用图结构以及在大规模数据集上组合优化复杂性过高的问题,能够更加灵活、更加准确的建模现实生活中大量存在的图数据而不存在传统方法将数据转换成普通图的数据损失;另一方面基于超图神经网络能够天然地建模图结构信息并且通过采样结点集的监督学习能够隐式地表征结点组合的重要性。

[0131]

本说明书中各个实施例采用递进的方式描述,每个实施例重点说明的都是与其他实施例的不同之处,各个实施例之间相同相似部分互相参见即可。对于实施例公开的装置而言,由于其与实施例公开的方法相对应,所以描述的比较简单,相关之处参见方法部分说明即可。

[0132]

对所公开的实施例的上述说明,使本领域专业技术人员能够实现或使用本发明。对这些实施例的多种修改对本领域的专业技术人员来说将是显而易见的,本文中所定义的一般原理可以在不脱离本发明的精神或范围的情况下,在其它实施例中实现。因此,本发明将不会被限制于本文所示的这些实施例,而是要符合与本文所公开的原理和新颖特点相一致的最宽的范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。