1.本发明涉及智能交通系统、车路协同系统技术领域,尤其涉及一种基于毫米波雷达和视频融合的车辆检测方法。

背景技术:

2.近年来,随着智能交通系统的发展,路侧服务越来越广泛的应用于城市道路交通系统。目前,城市中许多无信号交叉口缺乏信号控制,交通流混乱,易发生交通事故,亟需交通管理与控制手段。而现阶段基于视频或毫米波雷达的车辆检测都存在一定的问题,从硬件上看,雷达对目标的识别能力有限,检测的过程中会出现虚警和漏检的现象,摄像头的检测距离有限,而且易受天气影响,而能够规避一定硬件影响的目标检测算法通常复杂度较高,运算速度较慢。传统的行车轨迹预测要依托大量数据,虽然精确度高,但是较为复杂、实时性差,而在硬件设备不足的情况下,难以提供大量数据做支持。因此,为了得到更加精确的车辆轨迹数据,亟需提出一种基于毫米波雷达和视频融合的车辆检测方法,获得精确的目标车辆通过无信号交叉口的位置信息,进而进行冲突的判定,以改善无信号交叉口的交通状况,为交叉口的协同优化控制提供重要的技术方法支撑。

技术实现要素:

3.本发明目的就是为了弥补已有技术的缺陷,提供一种基于毫米波雷达和视频融合的车辆检测方法,以解决现有技术无法在交叉口精确获得车辆轨迹数据的问题。

4.本发明是通过以下技术方案实现的:

5.一种基于毫米波雷达和视频融合的车辆检测方法,具体包括以下步骤:

6.(1)空间坐标对准:引入视频数据和毫米波雷达数据,将视频和雷达坐标统一,将雷达坐标定位到图像数据上;

7.(2)时间坐标对准;采取多线程的方式完成时间坐标的对准;

8.(3)数据融合方法;使用基于检测框重叠比的数据融合算法,对毫米波雷达数据和视频数据进行分析,根据二者重合部分,选取更加准确的数据,形成新的检测框。

9.步骤(1)所述的空间坐标对准,具体步骤如下:

10.首先,引入摄像头的内部参数矩阵m

in

和外部参数矩阵m

out

;

11.f

x

、fy分别称为u轴和v轴上的归一化焦距,u0和v0为图像中心;

12.外部参数矩阵m

out

包括俯仰、偏航和滚转三参数a=pitch*π/180,b=yaw*π/180,c=roll*π/180;pitch、yaw、roll分别代表摄像头的俯仰角、偏航角和滚转角;

[0013][0014]

并将二者相乘:

[0015]mmulti

=m

in

*m

out

,m

multi

表示内部参数矩阵与外部参数矩阵乘积;

[0016]

其次,引入毫米波雷达的四个矫正系数xr,yr,zr,zc,以及毫米波雷达的俯仰角pitchr和毫米波雷达的安装高度hr,其表达式如下:

[0017]

xr=distlat;

[0018][0019]

zr=distlong;

[0020]

zc=-cosa*sinb*cosc*sina*sinc*xr cosa*sinb*sine*sina*cosc*y

t

cosa*cosb*zr 0.12

[0021]

;distlat和distlong分别代表横向距离和纵向距离;

[0022]

并用一个矩阵存储:d=(xr,yr,zr,1);

[0023]

最后,将视频和雷达坐标统一,将雷达坐标定位到图像数据上

[0024]

ur=m

multi

*d(0,0)/zc[0025]

vr=m

multi

*d(1,0)/zc。ur和vr分别代表雷达框中心横坐标和纵坐标。

[0026]

步骤(2)所述的采取多线程的方式完成时间坐标的对准,具体步骤如下:

[0027]

(a)由于视频帧快于毫米波雷达帧,应让视频帧等待毫米波雷达数据,因此当视频数据线程处理数据后,将视频数据存入队列;

[0028]

(b)当毫米波雷达获取信息,经过毫米波雷达线程处理并向融合线程传输时,同时向视频线程发送一条命令,也向融合线程传递最新存储的视频信息;

[0029]

(c)融合线程将最新收集的视频数据和毫米波雷达数据融合,完成时间上的对准。

[0030]

完成坐标的对准之后,对两者的数据进行融合。毫米波雷达会获得目标的中心点以及长宽,但由于校准的不精确和实际的误差,毫米波雷达获得的中心点与目标真正的中心位置有所差别,而再与目标长宽结合,会造成检测框有较大的偏移。视频数据会获得相对精确的检测框,根据两者的交并获得最终的检测结果。

[0031]

本发明的优点是:本发明用于解决在无信号交叉口下可以精确的获取目标车辆的位置信息;本发明是通过毫米波雷达检测目标车辆的速度、距离、角度信息,摄像头检测目标车辆的位置和类型,然后在时间和空间上将毫米波雷达和摄像头完成对准,得到最终的检测结果,可广泛应用于智能交通系统、车路协同系统等领域,为交叉口的协同优化控制提供重要的技术方法支撑。

附图说明

[0032]

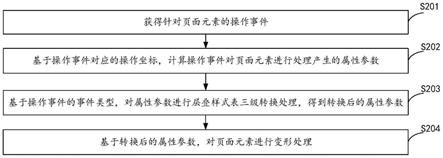

图1是本发明流程图;

[0033]

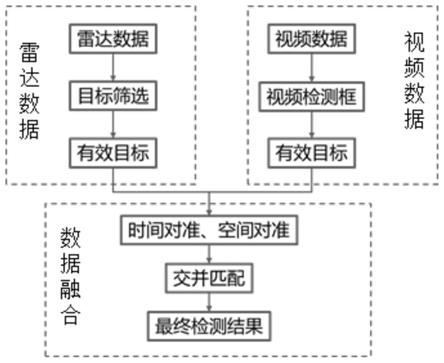

图2是本发明实施例中融合后结果示意图。

具体实施方式

[0034]

如图1所示,本实施例所述的一种基于毫米波雷达和视频融合的车辆检测方法,包括以下步骤:

[0035]

(1)空间坐标对准;首先,引入摄像头的内部参数矩阵min和外部参数矩阵m

out

。

[0036][0037]

外部参数矩阵包括俯仰、偏航和滚转三参数a=pitch*π/180,b=yaw*π/180,c=roll*π/180。

[0038][0039]

并将二者相乘:

[0040]mmulti

=m

in

*m

out

[0041]

其次,引入毫米波雷达的四个矫正系数xr,yr,zr,zc,以及毫米波雷达的俯仰角pitchr、毫米波雷达的安装高度hr,其表达式如下:

[0042]

xr=distlat;

[0043][0044]

zr=distlong;

[0045]

zc=-cosa*sinb*cosc*sina*sinc*xr cosa*sinb*sinc*sina*cosc*yr cosa*cosb*zr 0.12;

[0046]

并用一个矩阵存储:d=(xr,yr,zr,1);

[0047]

最后,将视频和雷达坐标统一,将雷达坐标定位到图像数据上

[0048]

ur=m

multi

*d(0,0)/zc[0049]

vr=m

multi

*d(1,0)/zc[0050]

(2)时间坐标对准;采取多线程的方式来完成时间的对准,具体操作过程如下:

[0051]

(a)由于视频帧快于雷达帧,应让视频帧等待雷达数据,因此当视频数据线程处理数据后,将数据存入队列。

[0052]

(b)当雷达获取信息,经过雷达线程处理并向融合线程传输时,同时向视频线程发送一条命令,也向融合线程传递最新存储的视频信息。

[0053]

(c)融合线程将最新收集的视频数据和雷达数据融合,完成时间上的对准。由于毫米波雷达和摄像头不是同时展开工作的,在实际应用时难免有一定的时间差,但经上述处理,时间差都不会超过一个周期,可以忽略不计。

[0054]

至此,完成毫米波雷达和摄像头在时间坐标上的对准。

[0055]

(3)数据融合方法;使用基于检测框重叠比的数据融合算法,对毫米波雷达数据和视频数据进行分析,根据二者重合部分,选取更加准确的数据,形成新的检测框。

[0056]

完成坐标的对准之后,对两者的数据进行融合。毫米波雷达会获得目标的中心点以及长宽,但由于校准的不精确和实际的误差,毫米波雷达获得的中心点与目标真正的中

心位置有所差别,而再与目标长宽结合,会造成检测框有较大的偏移。视频数据会获得相对精确的检测框,根据两者的交并获得最终的检测结果。雷达数据与视频数据融合过程流程图如图1所示。

[0057]

图2是使用本发明的车辆检测方法检测的结果,图像中用框框出了目标车辆,可以看出可以精确检测车辆信息。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。