1.本技术涉及深度相机识别领域,尤其涉及一种基于动态二值化算法的深度值获取方法及系统。

背景技术:

2.随着机器视觉,自动驾驶等颠覆性技术的发展,采用深度相机进行物体识别、行为识别和场景建模的相关应用越来越多,深度相机可通过该相机检测出拍摄空间的景深距离,具有高分辨率、高精度的特点,可以说深度相机就是终端和机器人的眼睛。通过深度相机获取到的数据,能准确知道图像中每个点离摄像头距离,加上该点在2d图像中的坐标,就能获取图像中每个点的三维空间坐标,通过三维坐标就能还原真实场景,实现场景建模等应用。

3.结构光相机作为深度相机的一种,通常包括红外随机点阵投影仪和热红外相机。红外随机点阵投影仪,采用特定波长的不可见红外激光作为光源,它发射出来的光经过一定的编码投影在物体上,并形成具有一定结构特征的随机点阵,再由热红外相机采集反射的随机点阵,最后通过一定算法来计算返回的编码图案的畸变,来得到物体的位置和深度信息。

4.其中,随机点阵本身是一个二值的信息,在现有技术中,从红外相机得到的都是8-bit的灰度图像,8-bit的灰度图像存在信息冗余,直接基于8-bit的匹配代价的计算,会造成不必要的计算量增多,从而在相同吞吐率要求下,结构光相机内的分析处理硬件与计算量大小呈正比,因此会导致所需硬件的面积增大,功耗增多。

技术实现要素:

5.为了实现通过简化深度值的计算,从而减小硬件面积和降低功耗,本技术提供一种基于动态二值化算法的深度值获取方法及系统。

6.本技术第一方面,提供一种基于动态二值化算法的深度值获取方法,包括:

7.获取待测物体的参照图像和红外随机点阵图像,并选取所述红外随机点阵图像任一点为待测点,所述参照图像为距离结构光相机一定距离的一个平面上的红外随机点阵图像。

8.获取所述参照图像和所述待测点对应的8-bit灰度图,通过局部动态二值化模型,将所述参照图像和所述待测点对应的8-bit灰度图,转换为1-bit图像,并得到对应的1-bit二值化值。

9.根据所述1-bit二值化值,通过匹配代价模型,得到待测点不同视差的匹配代价值。

10.根据所述待测点不同视差的匹配代价值,选取最小的匹配代价值,为待测点的初步视差。

11.根据所述初步视差,对所述初步视差进行消噪平滑,得到待测点的视差。

12.根据所述待测点的视差,将所述待测点的视差映射为待测点的深度值。

13.可选的,所述局部动态二值化模型为:

[0014][0015]

w为以p为中心的一个窗口,pn为w中的一个像素值,n为w中像素的个数,p为8-bit的灰度值,q为1-bit二值化值。

[0016]

可选的,所述匹配代价模型为:

[0017][0018]cd

为视差的匹配代价值,qn为待测点的1-bit图像中对应窗口的像素,q

′

(n,d)

为参照图像的1-bit图像中对应窗口的像素。

[0019]

可选的,所述对初步视差进行消噪平滑,得到待测点的视差的步骤中,采用亚像素估计,斑点去除以及中值滤波器,对初步视差进行消噪平滑。

[0020]

可选的,所述将待测点的视差映射为待测点的深度值的步骤中,采用三角法,利用三角关系将视差映射为深度值。

[0021]

本技术第二方面提供一种基于动态二值化算法的深度值获取系统,包括:图像获取模块、图像二值化模块、匹配模块、筛选模块、后处理模块和映射模块。

[0022]

所述图像获取模块,用于获取待测物体的参照图像和红外随机点阵图像,并选取所述红外随机点阵图像任一点为待测点。

[0023]

所述图像二值化模块,用于获取所述参照图像和所述待测点对应的8-bit灰度图,通过局部动态二值化模型,将所述参照图像和所述待测点对应的8-bit灰度图,转换为1-bit图像,并得到对应的1-bit二值化值。

[0024]

所述匹配模块,用于根据所述1-bit二值化值,通过匹配代价模型,得到待测点不同视差的匹配代价值。

[0025]

所述筛选模块,用于根据所述待测点不同视差的匹配代价值,选取最小的匹配代价值,为待测点的初步视差。

[0026]

所述后处理模块,用于根据所述初步视差,对所述初步视差进行消噪平滑,得到待测点的视差。

[0027]

所述映射模块,用于根据所述待测点的视差,将所述待测点的视差映射为待测点的深度值。

[0028]

可选的,所述局部动态二值化模型为:

[0029][0030]

w为以p为中心的一个窗口,pn为w中的一个像素值,n为w中像素的个数,p为8-bit的灰度值,q为1-bit二值化值。

[0031]

可选的,所述匹配代价模型为:

[0032][0033]cd

为视差的匹配代价值,qn为待测点的1-bit图像中对应窗口的像素,q

′

(n,d)

为参

照图像的1-bit图像中对应窗口的像素。

[0034]

可选的,所述对初步视差进行消噪平滑,得到待测点的视差的步骤中,采用亚像素估计,斑点去除以及中值滤波器,对初步视差进行消噪平滑。

[0035]

可选的,所述将待测点的视差映射为待测点的深度值的步骤中,采用三角法,利用三角关系将视差映射为深度值。

[0036]

由以上技术方案可知,本技术提供一种基于动态二值化算法的深度值获取方法及系统,通过获取待测物体的参照图像和红外随机点阵图像,并选取所述红外随机点阵图像任一点为待测点,获取所述参照图像和所述待测点对应的8-bit灰度图,通过局部动态二值化模型,将所述参照图像和所述待测点对应的8-bit灰度图,转换为1-bit图像,并得到对应的1-bit二值化值,通过匹配代价模型,得到待测点不同视差的匹配代价值,选取最小的匹配代价值,为待测点的初步视差;对所述初步视差进行消噪平滑,得到待测点的视差;将所述待测点的视差映射为待测点的深度值。本技术提供的一种基于动态二值化算法的深度值获取方法及系统,可实现减少深度算法当中的计算量,从而减小对逻辑门数的需求,在提供高质量的深度图的同时,提高深度算法加速器的面积效率和功率效率。

附图说明

[0037]

为了更清楚地说明本技术的技术方案,下面将对实施例中所需要使用的附图作简单地介绍,显而易见地,对于本领域普通技术人员而言,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

[0038]

图1为本技术实施例提供的基于动态二值化算法的深度值获取方法的流程图;

[0039]

图2为本技术实施例提供的将红外灰度图转换为二值化红外图的示意图;

[0040]

图3为本技术实施例提供的基于动态二值化算法生成的深度图;

[0041]

图4为现有的绝对距离求和算法生成的深度图;

[0042]

图5为现有的红外图像增强的绝对距离求和算法生成的深度图;

[0043]

图6为现有的普查转换算法生成的深度图;

[0044]

图7为三角法映射深度值的具体计算实施图;

[0045]

图8为本技术实施例与现有的其它方案性能对比折线图;

[0046]

图9为本技术实施例提供的基于动态二值化算法的深度值获取系统的架构图。

具体实施方式

[0047]

下面将详细地对实施例进行说明,其示例表示在附图中。下面的描述涉及附图时,除非另有表示,不同附图中的相同数字表示相同或相似的要素。以下实施例中描述的实施方式并不代表与本技术相一致的所有实施方式。仅是与权利要求书中所详述的、本技术的一些方面相一致的系统和方法的示例。

[0048]

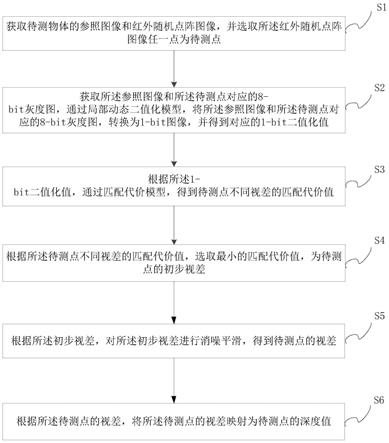

参见图1,为本技术实施例提供的基于动态二值化算法的深度值获取方法的流程图。

[0049]

本技术实施例第一方面,提供一种基于动态二值化算法的深度值获取方法,包括:

[0050]

s1,获取待测物体的参照图像和红外随机点阵图像,并选取所述红外随机点阵图像任一点为待测点,所述参照图像为距离结构光相机一定距离的一个平面上的红外随机点

阵图像。

[0051]

在本技术实施例中,使用结构光相机来获取待测物体的深度值,结构光相机中红外随机点阵投影仪和红外相机配合使用,可提供从物体表面反射回来的随机点阵的信息,拍摄到的图片当中,和参照图片深度不同的位置会产生视差。

[0052]

需要说明的是参照图像具体获取步骤为:拍摄一个和相机固定距离(如1m)的平面,得到参照平面的红外随机点阵图像,并将拍摄得到的参照图像存储到相机内部,以用于后续的视差计算。

[0053]

s2,获取所述参照图像和所述待测点对应的8-bit灰度图,通过局部动态二值化模型,将所述参照图像和所述待测点对应的8-bit灰度图,转换为1-bit图像,并得到对应的1-bit二值化值。

[0054]

如图2所示,为本技术实施例提供的将红外灰度图转换为二值化红外图的示意图。

[0055]

其中,所述局部动态二值化模型为:

[0056][0057]

w为以p为中心的一个窗口(如5pixel x 5pixel的窗口),对5x5窗口来说w为25,pn为w中的一个像素值,n为w中像素的个数,p为8-bit的灰度值,q为1-bit二值化值。

[0058]

s3,根据所述1-bit二值化值,通过匹配代价模型,得到待测点不同视差的匹配代价值。

[0059]

其中,通过基于窗口的匹配代价算法,计算出不同视差下的匹配代价。代价计算基于二值化之后的图像,计算某个像素一定范围的视差的匹配代价值。实际计算时将整个窗口内部的二值化的像素作为序列,使用汉明距离来评估代价,所述匹配代价模型为:

[0060][0061]cd

为视差的匹配代价值,qn为待测点的1-bit图像中对应窗口的像素,q

′

(n,d)

为参照图像的1-bit图像中对应窗口的像素。

[0062]

s4,根据所述待测点不同视差的匹配代价值,选取最小的匹配代价值,为待测点的初步视差。

[0063]

其中,在选取最小匹配代价值时,采用以下模型选取:

[0064]dest

=argmin(cd)

[0065]

其中,d

est

为待测点的初步视差。

[0066]

s5,根据所述初步视差,对所述初步视差进行消噪平滑,得到待测点的视差。

[0067]

其中,所述对初步视差进行消噪平滑,得到待测点的视差的步骤中,采用亚像素估计,斑点去除以及中值滤波器,对初步视差进行消噪平滑。

[0068]

亚像素估计,采用基于抛物线拟合的方法,使用临近视差的代价值来对视差作平滑处理,公式如下所示:

[0069][0070]

其中,c(d)和c(d

±n)为在视差d和d

±

n上的匹配代价。

[0071]

斑点去除,是为了去除图像当中孤立的小斑点,通过统计与中心像素视差值相差

较大的周围像素的数量,如果数量超过一个阈值,则将中心像素视为斑点,将其替换成最近的非斑点的像素值。

[0072]

中值滤波器,采用3x3的窗口,用来进一步提高平滑性。

[0073]

s6,根据所述待测点的视差,将所述待测点的视差映射为待测点的深度值。

[0074]

所述将待测点的视差映射为待测点的深度值的步骤中,采用三角法,利用三角关系将视差映射为深度值。

[0075]

如图7所示,为三角法映射深度值的具体计算实施图。

[0076]

图中,z0为参考平面距离,z为物体平面距离(即本技术实施例中的深度值),f为红外相机焦距,d为视差,b为基线距离,深度值的获取公式,具体为:

[0077][0078]

为了更好的验证本技术实施例的有益效果,下面将通过具体实施例进行说明:

[0079]

首先进行定性分析,将本技术实施例提供的动态二值化算法,生成的深度图与现有技术中的三种算法生成的深度图进行比较。如图3所示,为本技术实施例提供的基于动态二值化算法生成的深度图。如图4所示,为现有的绝对距离求和算法sum of absolute distance(sad),生成的深度图。如图5所示,为现有的红外图像增强的绝对距离求和算法enhanced sum of absolute distance(enhanced sad),生成的深度图,如图6所示,为现有的普查转换算法census transform(ct),生成的深度图。

[0080]

其中,黑色像素代表测量误差大于100mm的部分,由图3、图4、图5和图6,可知本技术实施例提供的基于1-bit动态二值化算法生成的深度图,误差大于100mm的部分的面积要明显小于其它方案。

[0081]

其次进行定量分析,如图8所示,为本技术实施例与现有的其它方案性能对比折线图。基于70个场景,就若干指标量化评估了在相同窗口尺寸的情况下本技术实施例的方案相比起其它方案的优势。其中,性能指标包含了在不同阈值下的坏点百分比(bad pixel percentage),平均绝对误差(average absolute error)和均方根误差(root-mean-square error)。坐标横轴为窗口尺寸(window size),不同形状的标志代表不同的算法,所有的指标的值越小,代表性能越好,算法越具有优势。当窗口尺寸大于13x13时,本技术实施例的方案在各个指标上相比其他前沿的方案更具优势。

[0082]

最后基于本技术实施例的方案,对结构光相机硬件加速器的面积和功率进行评估。通过smic 55nm cmos工艺实现了基于db(涉及本技术提供方案的动态二值化算法),sad,enhanced sad和ct的结构光深度算法加速器面积和功率的评估。使用17x17的匹配窗口,频率为133mhz,帧率为每秒432.94帧。面积效率和功率效率如表1所示,表1为加速器的面积和功率效率的对比表。

[0083]

表-1-加速器的面积和功率效率的对比表

[0084]

[0085]

由表1可知,基于db的加速器,代价计算模块的逻辑门相比起其他方法有79.7%-86.7%的减少。对于整个结构光深度算法加速器来说,相比起基于其他方法的加速器,面积效率提升了235%-367%,功率效率提升了35%-94%。

[0086]

由以上技术方案可知,本技术实施例提供一种基于动态二值化算法的深度值获取方法,通过获取待测物体的参照图像和红外随机点阵图像,并选取所述红外随机点阵图像任一点为待测点,获取所述参照图像和所述待测点对应的8-bit灰度图,通过局部动态二值化模型,将所述参照图像和所述待测点对应的8-bit灰度图,转换为1-bit图像,并得到对应的1-bit二值化值,通过匹配代价模型,得到待测点不同视差的匹配代价值,选取最小的匹配代价值,为待测点的初步视差;对所述初步视差进行消噪平滑,得到待测点的视差;将所述待测点的视差映射为待测点的深度值。本技术实施例提供的一种基于动态二值化算法的深度值获取方法,可实现减少深度算法当中的计算量,从而减小对逻辑门数的需求,在提供高质量的深度图的同时,提高深度算法加速器的面积效率和功率效率。

[0087]

参见图9,为本技术实施例提供的基于动态二值化算法的深度值获取系统的架构图。

[0088]

本技术实施例第二方面提供一种基于动态二值化算法的深度值获取系统,包括:图像获取模块、图像二值化模块、匹配模块、筛选模块、后处理模块和映射模块。

[0089]

s01,所述图像获取模块,用于获取待测物体的参照图像和红外随机点阵图像,并选取所述红外随机点阵图像任一点为待测点。

[0090]

s02,所述图像二值化模块,用于获取所述参照图像和所述待测点对应的8-bit灰度图,通过局部动态二值化模型,将所述参照图像和所述待测点对应的8-bit灰度图,转换为1-bit图像,并得到对应的1-bit二值化值。

[0091]

s03,所述匹配模块,用于根据所述1-bit二值化值,通过匹配代价模型,得到待测点不同视差的匹配代价值。

[0092]

s04,所述筛选模块,用于根据所述待测点不同视差的匹配代价值,选取最小的匹配代价值,为待测点的初步视差。

[0093]

s05,所述后处理模块,用于根据所述初步视差,对所述初步视差进行消噪平滑,得到待测点的视差。

[0094]

s06,所述映射模块,用于根据所述待测点的视差,将所述待测点的视差映射为待测点的深度值。

[0095]

将待测物体的参照图像和红外随机点阵图像输入进所述获取模块,并选取所述红外随机点阵图像任一点为待测点;所述获取模块将所述参照图像与待测点传递至所述图像二值化模块,所述图像二值化模块获取所述参照图像和所述待测点对应的8-bit灰度图,通过局部动态二值化模型,将所述参照图像和所述待测点对应的8-bit灰度图,转换为1-bit图像,并得到对应的1-bit二值化值;所述图像二值化模块将所述1-bit二值化值传递至所述匹配模块,所述匹配模块根据所述1-bit二值化值,通过匹配代价模型,得到待测点不同视差的匹配代价值;所述匹配模块将所述待测点不同视差的匹配代价值传递至所述筛选模块,所述筛选模块根据所述待测点不同视差的匹配代价值,选取最小的匹配代价值,为待测点的初步视差;所述筛选模块将所述初步视差传递至所述后处理模块,所述后处理模块,根据所述初步视差,对所述初步视差进行消噪平滑,得到待测点的视差,所述后处理模块将所

述待测点的视差传递至所述映射模块,所述映射模块,根据所述待测点的视差,将所述待测点的视差映射为待测点的深度值。

[0096]

由以上技术方案可知,本技术实施例提供一种基于动态二值化算法的深度值获取方法及系统,通过获取待测物体的参照图像和红外随机点阵图像,并选取所述红外随机点阵图像任一点为待测点,获取所述参照图像和所述待测点对应的8-bit灰度图,通过局部动态二值化模型,将所述参照图像和所述待测点对应的8-bit灰度图,转换为1-bit图像,并得到对应的1-bit二值化值,通过匹配代价模型,得到待测点不同视差的匹配代价值,选取最小的匹配代价值,为待测点的初步视差;对所述初步视差进行消噪平滑,得到待测点的视差;将所述待测点的视差映射为待测点的深度值。本技术实施例提供的一种基于动态二值化算法的深度值获取方法及系统,可实现减少深度算法当中的计算量,从而减小对逻辑门数的需求,在提供高质量的深度图的同时,提高深度算法加速器的面积效率和功率效率。

[0097]

本技术提供的实施例之间的相似部分相互参见即可,以上提供的具体实施方式只是本技术总的构思下的几个示例,并不构成本技术保护范围的限定。对于本领域的技术人员而言,在不付出创造性劳动的前提下依据本技术方案所扩展出的任何其他实施方式都属于本技术的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。