1.本发明涉及人工智能及无人机技术领域,特别是指一种自适应重构的高精度机载目标识别方法。

背景技术:

2.随着无人机以及人工智能技术的快速发展,无人机处理信息的密度增大,通过使用rgb吊舱获取图像,进行物体识别跟踪有着越来越重要的作用。与此同时,由于无人机距地较高,距离目标距离的增大,单纯使用图像进行识别跟踪的方式会导致物体识别极易失败且丢失目标,从而增大任务的复杂度以及任务的重复执行次数。

3.此外,受制于机载算力资源,精准复杂模型无法实现实时识别跟踪,导致目标过快出现消失在视野时造成信息的丢失。另一方面,如果使用轻量化模型,则在复杂背景的小目标识别任务中的表现也不理想。

技术实现要素:

4.有鉴于此,本发明提供一种自适应重构的高精度机载目标识别方法,该方法通过载荷控制与目标跟踪算法来补偿高精度复杂模型的实时性,可在兼顾高实时性的同时提高机载针对小目标任务识别成功率。

5.为实现上述目的,本发明所采用的方案是:

6.一种自适应重构的高精度机载目标识别方法,其包括以下步骤:

7.(1)第一阶段:

8.利用无人机的光电吊舱获取图像信息,利用yolov4

‑

custom神经网络对图像进行目标识别,提取目标的位置信息;

9.根据目标的位置信息,判断目标是否在跟踪区域,若不在,则调整吊舱姿态,使目标处于跟踪区域;

10.计算目标面积,当面积小于阈值时,放大吊舱拍摄倍数,进入第二阶段的跟踪;

11.(2)第二阶段:

12.利用surf特征检测方法对目标位置进行目标特征提取,同时利用yolov4

‑

custom神经网络对目标位置进行抽帧检测,检查是否跟踪失败,若跟踪失败,则调整跟踪区域,待跟踪稳定后,进入第三阶段的跟踪;

13.(3)第三阶段:

14.使用光流法对目标位置进行目标跟踪,同时使用surf特征检测方法对目标位置进行抽帧检测,检查是否跟踪失败,若跟踪失败,则调整跟踪区域,实现精准的实时跟踪。

15.本发明的有益效果在:

16.1、本发明只需在无人机上设置嵌入式设备和rgb光电吊舱,硬件改动小,成本低。

17.2、本发明采用三级动态调整跟踪策略的方式进行目标跟踪,极大地提高了跟踪的可靠性和实时性,具有高机动性、低时延性的特点,并能够克服嵌入式设备算力有限的问

题。

附图说明

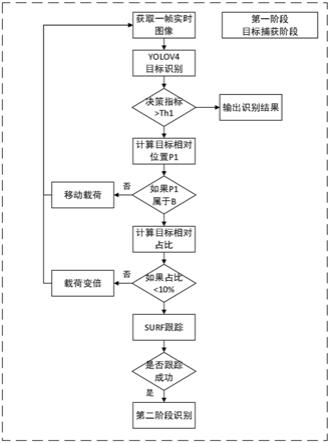

18.图1是本发明实施例方法第一阶段的流程图;

19.图2是本发明实施例方法第二阶段的流程图;

20.图3是本发明实施例方法第三阶段的流程图;

21.图4是本发明实施例方法的整体原理图。

具体实施方式

22.下面结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,在下面的描述中为了充分理解此方法,阐述了更多具体的细节,所描述的方法仅为本发明的部分实例,而非全部实例。基于本发明的实例,在此领域中没有突破性进展的前提下,所有其他实例,都属于本发明的保护范围。

23.如图4所示,一种自适应重构的高精度机载目标识别方法,其包括三个阶段:

24.第一阶段:如图1所示,在无人机起飞后,使用光电吊舱获取图像,由yolov4

‑

costom进行图像处理,提取图像中的人物信息,选择目标人物,确定其位置p,如果位置p在图像中不属于跟踪区域β,则进行吊舱控制,使其在跟踪区域β内,在使用yolov4进行识别,以确保目标位于区域β中。计算目标位置是否满足面积比>10%,如果面积比<10%,则进行吊舱变倍操作,使其满足跟踪条件后完成阶段一的目标位置获取阶段。

25.第二阶段:如图2所示,在完成目标捕获,位置确定阶段后,初始化surf跟踪,使用surf提取物体特征,尝试跟踪物体,随着目标的移动进行跟踪以及特征图的更新,与此同时,采用多线程抽样检测跟踪结果,在roi小于阈值时,跟踪失败,返回阶段一。跟踪稳定后,进入阶段三的快速的光流跟踪。

26.第三阶段:如图3所示,利用阶段二所获取的目标位置,利用光流跟踪法,持续快速跟踪,同时使用surf对所跟踪的区域进行特征匹配,即阶段二的跟踪,如果surf的特征匹配小于阈值则退出光流跟踪,进入阶段二尝试重新跟踪。如果光流跟踪稳定,则计算物体移动方向和速度,动态调整吊舱姿态以及无人机位置,实现快速的跟踪。

27.以下为一个更具体的例子:

28.一种高精度动态自适应重构的机载目标识别方法,该方法利用嵌入式设备控制rgb光电吊舱,通过使用不同的识别跟踪算法,自适应三级调整识别策略,增强了识别的准确度以及实时性。以下为具体步骤:

29.第一阶段:图像捕获,采用yolov4custom神经网络,对需要识别的物体进行识别区域提取,通过计算识别区域在图像α中的位置p,确认物体处于合适跟踪范围,如果物体在合适跟踪范围β外,调整载荷位姿后,重新通过神经网络定位物体位置p,再次计算物体所在图像面积比率,进行载荷变倍后重新识别定位物体位置,在物体位置确定在合适跟踪范围β内后,进行第二阶段的稳定跟踪。

30.第二阶段:稳定跟踪,采用surf方法提取物体特征图,构建hessian特征图,对于图像i(x,y),其hessian矩阵如下:

[0031][0032]

h的判别式为:

[0033][0034]

在使用尺度σ对图像进行高斯滤波后,其hessian判别式如下:

[0035][0036]

其中,(x,y)为像素位置,σ为使用高斯滤波的尺度值,l(x,y,σ)=g(x,y,σ)*i(x,y),代表着图像的高斯尺度空间,是由图像和不同的高斯卷积得到。i(x,y)为在图像(x,y)位置的像素值。高斯滤波g(x,y,σ)如下所示:

[0037][0038]

一阶导数是相邻像素的灰度差:

[0039]

l

x

=l(x 1,y)

‑

l(x,y)

[0040]

二阶导数是对一阶导数的再次求导:

[0041]

l

xx

=[l(x 1,y)

‑

l(x,y)]

‑

[l(x,y)

‑

l(x

‑

1,y)]

[0042]

=l(x 1,y) l(x

‑

1,y)

‑

2l(x,y)

[0043]

即:

[0044]

det(h)=l

xx

*l

yy

‑

l

xy

*l

xy

[0045]

通过这种方法可以为图像中每个像素计算出其h行列式的决定值,并用这个值来判别图像局部特征点。hession矩阵判别式中的l(x,y)是原始图像的高斯卷积,

[0046]

由于高斯核服从正态分布,从中心点往外,系数越来越小,为了提高运算速度,surf算法使用了盒式滤波器来替代高斯滤波器,所以在l

xy

上乘了一个加权系数0.9,目的是为了平衡因使用盒式滤波器近似所带来的误差,则h矩阵判别式可表示为:

[0047]

det(h)=l

xx

*l

yy

‑

(0.9*l

xy

)2[0048]

进行surf跟踪,采用surf特征对比,防止跟踪失败的同时,采用神经网络进行抽帧检测跟踪结果,如果检测到跟踪失败,返回第一阶段,否则待surf跟踪稳定后进入第三阶段。

[0049]

第三阶段:快速跟踪,采用光流法快速跟踪。对于像素i(x,y,t)在第一帧的光强度,用了dt时间,移动了dx,dy的像素,由于两帧图片时间距离较短,认为相同像素点光强度不变,即:

[0050]

i(x,y,t)=i(x dx,y dy,y dt)

[0051]

将等号右边泰勒展开后:

[0052][0053]

其中ε代表二阶无线小,可忽略不计,可得:

[0054][0055]

设u、v分别为沿着x轴、y轴的速度矢量,得:

[0056][0057]

令分别表示图像中像素点的灰度沿着x、y、t方向的偏导数可得:

[0058]

i

x

u i

y

v i

t

=0

[0059]

i

x

,i

y

,i

t

均可由图像数据求得,而(u,v)即为所求的光流矢量,由此实现基础的光流跟踪。

[0060]

根据物体移动方向、速度调整载荷的位姿、倍数,同时抽帧并使用surf检测跟踪效果,如果surf特征向量匹配度降低到阈值以下,返回第二阶段,重复阶段二、阶段三。

[0061]

本发明在无人机上使用嵌入式设备作为计算设备,使用光电吊舱获取图像信息,使用yolov4

‑

custom对所获取图像进行识别,同时判断物体位置是否合适;进入稳定跟踪后,使用surf算法,提取目标特征,进行稳定的跟踪,并进行抽帧检测,动态调整跟踪区域位置;在快速跟踪阶段,使用光流法,对目标进行快速跟踪,同时使用阶段二检测所跟踪区域的特征,动态调整跟踪位置,同时控制吊舱的姿态,确保跟踪不会丢失目标,且各指标处于合适跟踪的范围。

[0062]

总之,本发明采用带有嵌入式设备的无人机进行目标跟踪,具有高机动性、低时延性的特点。同时,为了克服算力有限的问题,本发明设计了三级动态调整跟踪策略的方式,极大地提高了跟踪的可靠性和实时性。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。