1.本发明涉及语音情感识别领域,特别是涉及一种基于注意力的多尺度卷积语音情感识别方法。

背景技术:

2.语音情感识别可以帮助机器理解用户的意图,提高交互应用场景下的用户体验。随着人机交互的深入发展,ser受到了研究人员的广泛关注,如何提取能够有效区分情感的情绪状态是目前研究的难点之一。因此,特征生成及融合是语音情感识别的关键步骤之一,即将原始的语音特征发送到特征提取器中,生成与情感相关的信息。

3.近年来,深度学习算法被广泛用于生成高度抽象的情感相关特征表示,其中卷积神经网络(cnn)成为了研究的热门。然而cnn在提取特征的过程中往往存在对冗余信息的卷积运算,造成了计算量和存储空间的浪费。为进一步提高网络的表示能力,注意力机制最近被广泛应用于不同分支的特征融合中。通道注意力机制在改善深度卷积神经网络(cnns)性能方面具有巨大的优势。为解决特征通道信息不均衡性的问题,引入了多通道卷积的神经网络模型。胡捷等人在“squeeze

‑

and

‑

excitation networks.in ieee conference on computer vision and pattern recognition(cvpr)”中提出一种全新的特征重标定策略,显式地建模卷积特征的通道之间的相互依赖关系来进行特征通道间的融合。

4.然而,一些研究通过捕获更复杂的通道来改进se模块或者结合额外的空间注意力。senet关注的是不同通道的像素的重要性可能不一样,而woo等人在“cbam:convolutional block attention module”中提出一个简单但是有效的cbam模型,既考虑不同通道像素的重要性,又考虑了同一通道不同位置像素的重要性。这些方法虽然精度较高,但往往会带来模型复杂度高、计算量大的问题。

5.为解决这个问题,王其龙等人在“eca

‑

net:efficient channel attention for deep convolutional neural networks”中提出了eca模块,证明了避免降维和适当的跨通道交互可以在保持性能的同时显着降低模型的复杂性。

6.然而,以上方案都无法解决特征提取时每一个特征通道本身的信息不均衡性。

技术实现要素:

7.基于此,本发明的目的在于,提供一种基于注意力的多尺度卷积语音情感识别方法,改进将通道注意力和空间注意力进行拼接的cbam模型,在深度学习神经网络中嵌入两个并行的通道注意力机制以及融合通道的空间注意力机制,增强有用信息并抑制对当前任务无用的信息,有利于深度模型捕获到更多情感相关的信息,找到显著的情感区域。

8.第一方面,本发明提供一种基于注意力的多尺度卷积语音情感识别方法,包括以下步骤:

9.构建语音情感识别模型,其中,所述模型包括第一卷积神经网络层、两个由注意力层和第二卷积神经网络层组成的并行通道、第一全连接层、空间注意力层、第二全连接层和

softmax分类器;

10.将待识别语音对应的语谱图输入到训练好的所述语音情感识别模型中,使得所述第一卷积神经网络层对所述语谱图进行提取低层次的语音特征,得到第一特征图;

11.将所述第一特征图分割为两个子特征图,将两个所述子特征图分别馈入到两个所述并行通道中,使得每个所述并行通道对其中一个子特征图进行并行的注意力加权处理和低层特征提取处理;

12.将两个所述并行通道的处理结果输入所述第一全连接层,进行特征融合处理,得到第二特征图;

13.将所述第二特征图输入所述空间注意力层,进行注意力加权处理;

14.将所述空间注意力层的输出结果输入所述第二全连接层,进行特征降维处理;

15.将所述第二全连接层的输出结果输入softmax分类器,得到待识别语音的情感分类结果。

16.进一步地,将所述第一特征图分割为两个子特征图,包括:

17.设置参数α,将特征图以1

‑

α:α的比例进行通道上的分割,并对占比为

ɑ

的特征图进行平均池化的下采样处理;

18.将两个并行通道的处理结果输入所述特征融合层之前,还包括:

19.对占比为

ɑ

的特征图进行上采样处理。

20.进一步地,α=0.8。

21.进一步地,所述对子特征图进行注意力加权处理,包括:

22.将所子述特征图输入所述注意力层,得到新特征图;

23.将所述新特征图与所述原子特征图相乘,得到注意力加权特征图。

24.进一步地,所述第二卷积神经网络层包括两个5

×

5的卷积层,两个卷积层后都连接一个2

×

2的最大池化层。

25.进一步地,所述第一卷积神经网络层包括5

×

5的卷积层和批标准化层。

26.进一步地,将所述第二特征图输入所述空间注意力层,进行注意力加权处理,包括:

27.计算所述第二特征图的注意力分数:

28.使用softmax信息选择机制,计算在给定任务相关的查询向量q和输入x下,选择第i个输入信息的概率α

i

。

29.进一步地,所述第二全连接层中包括dropout层。

30.第二方面,本发明还提供一种基于注意力的多尺度卷积语音情感识别装置,mmyy包括:

31.模型构建模块,用于构建语音情感识别模型,其中,所述模型包括第一卷积神经网络层、两个由注意力层和第二卷积神经网络层组成的并行通道、第一全连接层、空间注意力层、第二全连接层和softmax分类器;

32.特征图提取模块,用于将待识别语音对应的语谱图输入到训练好的所述语音情感识别模型中,使得所述第一卷积神经网络层对所述语谱图进行提取低层次的语音特征,得到第一特征图;

33.特征图分割模块,用于将所述第一特征图分割为两个子特征图,将两个所述子特

征图分别馈入到两个所述并行通道中,使得每个所述并行通道对其中一个子特征图进行并行的注意力加权处理和低层特征提取处理;

34.特征图融合模块,用于将两个所述并行通道的处理结果输入所述第一全连接层,进行特征融合处理,得到第二特征图;

35.注意力加权模块,用于将所述第二特征图输入所述空间注意力层,进行注意力加权处理;

36.特征降维模块,用于将所述空间注意力层的输出结果输入所述第二全连接层,进行特征降维处理;

37.情感分类结果输出模块,用于将所述第二全连接层的输出结果输入softmax分类器,得到待识别语音的情感分类结果。

38.本发明提供的一种基于注意力的多尺度卷积语音情感识别方法及装置,使用了一种基于传统cnn进行改进的多尺度卷积神经网络,在不增加额外计算量的前提下,充分考虑不同尺度特征图的信息特征,增加卷积核的感知域,进行高效的情感特征提取,从而提高了ser的性能。同时,改进将通道注意力和空间注意力进行拼接的cbam模型,在深度学习神经网络中嵌入两个并行的通道注意力机制以及融合通道的空间注意力机制,增强有用信息并抑制对当前任务无用的信息,有利于深度模型捕获到更多情感相关的信息,找到显著的情感区域。

39.为了更好地理解和实施,下面结合附图详细说明本发明。

附图说明

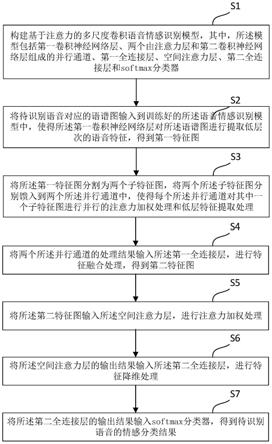

40.图1为本发明所提供的一种基于注意力的多尺度卷积语音情感识别方法的流程图;

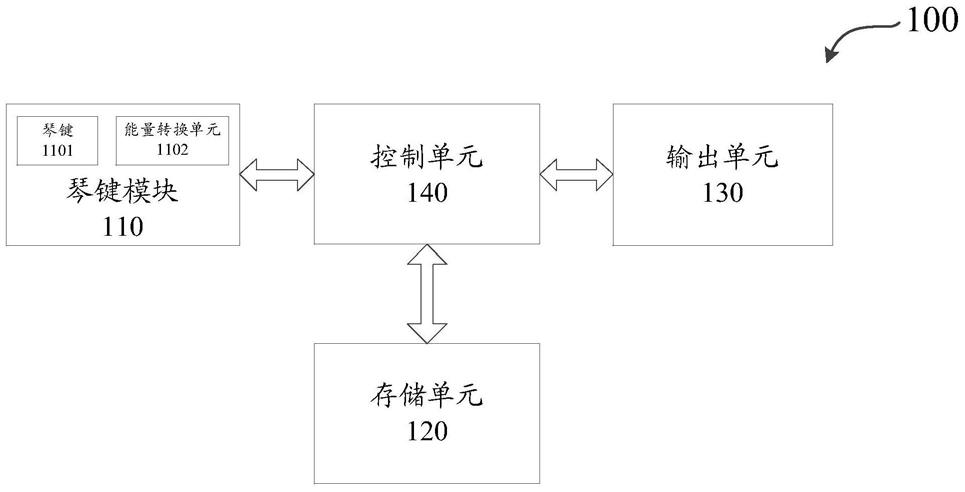

41.图2为本发明在一个实施例中所使用的语音情感识别模型的结构示意图;

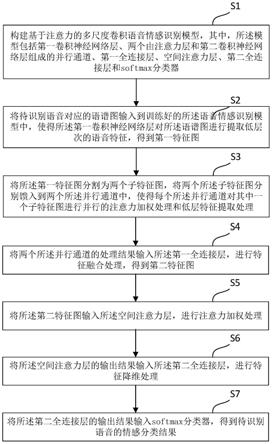

42.图3为本发明在一个实施例中将第一特征图分割为两个子特征图的流程示意图;

43.图4为本发明所提供的一种基于注意力的多尺度卷积语音情感识别装置的结构示意图。

具体实施方式

44.为使本技术的目的、技术方案和优点更加清楚,下面将结合附图对本技术实施例方式作进一步地详细描述。

45.应当明确,所描述的实施例仅仅是本技术实施例一部分实施例,而不是全部的实施例。基于本技术实施例中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其它实施例,都属于本技术实施例保护的范围。

46.在本技术实施例使用的术语是仅仅出于描述特定实施例的目的,而非旨在限制本技术实施例。在本技术实施例和所附权利要求书中所使用的单数形式的“一种”、“所述”和“该”也旨在包括多数形式,除非上下文清楚地表示其他含义。还应当理解,本文中使用的术语“和/或”是指并包含一个或多个相关联的列出项目的任何或所有可能组合。

47.下面的描述涉及附图时,除非另有表示,不同附图中的相同数字表示相同或相似的要素。以下示例性实施例中所描述的实施方式并不代表与本技术相一致的所有实施方

式。相反,它们仅是如所附权利要求书中所详述的、本技术的一些方面相一致的装置和方法的例子。在本技术的描述中,需要理解的是,术语“第一”、“第二”、“第三”等仅用于区别类似的对象,而不必用于描述特定的顺序或先后次序,也不能理解为指示或暗示相对重要性。对于本领域的普通技术人员而言,可以根据具体情况理解上述术语在本技术中的具体含义。

48.此外,在本技术的描述中,除非另有说明,“多个”是指两个或两个以上。“和/或”,描述关联对象的关联关系,表示可以存在三种关系,例如,a和/或b,可以表示:单独存在a,同时存在a和b,单独存在b这三种情况。字符“/”一般表示前后关联对象是一种“或”的关系。

49.针对背景技术中的问题,本发明提供一种基于注意力的多尺度卷积语音情感识别方法,如图1所示,该方法包括以下步骤:

50.s1:构建语音情感识别模型,其中,所述模型包括第一卷积神经网络层、两个由注意力层和第二卷积神经网络层组成的并行通道、第一全连接层、空间注意力层、第二全连接层和softmax分类器。

51.本发明所使用的语音情感识别模型是基于cnn网络和cbam模型的改进。

52.卷积神经网络(convolutional neural networks,cnn)是一类包含卷积计算且具有深度结构的前馈神经网络(feedforward neural networks),是深度学习(deep learning)的代表算法之一。卷积神经网络具有表征学习(representation learning)能力,能够按其阶层结构对输入信息进行平移不变分类(shift

‑

invariant classification),因此也被称为“平移不变人工神经网络(shift

‑

invariant artificial neural networks,siann)”。

53.convolutional block attention module(cbam)表示卷积模块的注意力机制模块,是一种结合了空间(spatial)和通道(channel)的注意力机制模块。相比于senet只关注通道(channel)的注意力机制可以取得更好的效果。

54.如图2所示,本发明所使用的语音情感识别模型,在深度学习神经网络中嵌入两个并行的通道注意力机制以及融合通道的空间注意力机制,增强有用信息并抑制对当前任务无用的信息,有利于深度模型捕获到更多情感相关的信息,找到显著的情感区域。

55.s2:将待识别语音对应的语谱图输入到训练好的所述语音情感识别模型中,使得所述第一卷积神经网络层对所述语谱图进行提取低层次的语音特征,得到第一特征图。

56.其中,语谱图为对原始语音信号进行分帧、快速傅里叶变换后堆叠转换为用颜色深浅表示幅度值的二维图。

57.优选的,所述第一卷积神经网络层包括5

×

5的卷积层和批标准化层。

58.卷积公式如下所示:

[0059][0060]

其中,*表示卷积,卷积核v=[v1,v2,...,v

c

],v

c

表示第c个卷积核的参数。输出为u=[u1,u2,...,u

c

]。x为卷积层的输入,是一个二维空间核,表示作用于x的相应通道的v

c

的单个通道。

[0061]

s3:将所述第一特征图分割为两个子特征图,将两个所述子特征图分别馈入到两个所述并行通道中,使得每个所述并行通道对其中一个子特征图进行并行的注意力加权处理和低层特征提取处理。

[0062]

优选的,如图3所示,将所述第一特征图分割为两个子特征图,包括:

[0063]

设置参数α,将特征图以1

‑

α:α的比例进行通道上的分割,并对占比为

ɑ

的特征图进行平均池化的下采样处理。

[0064]

对于α参数的设置,通过对比实验发现,当α较大时,模型可以捕获更多的有用信息,性能更佳。然而,当α增大时,模型耗时更长。因此,在一个优选的实施例中,α设置为0.8。

[0065]

之后,将两个子特征图分别馈入两条并行通道中,使得每个并行通道中的注意力层对子特征图进行注意力加权,第二卷积神经网络层对注意力加权后的子特征图进行底层特征提取处理。

[0066]

优选的,对子特征图进行注意力加权处理,包括:

[0067]

将所子述特征图输入所述注意力层,得到新特征图;

[0068]

将所述新特征图与所述原子特征图相乘,得到注意力加权特征图。

[0069]

在一个具体的实施例中,注意力加权处理包括:

[0070]

s301:通过使用全局平均池来生成通道级的统计信息,通过空间维度h

×

w收缩步骤s2中的输出u来生成统计值z,z的第c个元素的计算公式如下:

[0071][0072]

其中,u

c

(i,j)为步骤s2中的第c个元素的输出。

[0073]

s302:使用一个简单的包含sigmoid激活的门控机制,计算公式如下:

[0074]

s=f

ex

(z,w)=σ(g(z,w))=σ(w2δ(w1z))

[0075]

其中,δ表示relu激活函数,对上一步的输出z进行全连接层操作w1×

z后使用relu,然后进行全连接层操作w2δ(w1z)后使用sigmoid激活函数,得到s。w1和w2分别表示这两个全连接层的参数,以上两个操作整体就是所述的门控机制。

[0076]

s303:重加权的操作,将上一步的输出看做是每个特征通道的重要性,然后通过乘法逐通道加权到先前的特征上,完成在通道维度上的对原始特征的重标定。如下公式所示:

[0077][0078]

其中,为注意力模块最后的输出,和fscale(uc,sc)表示标量s

c

和特征映射u

c

之间的按通道相乘。

[0079]

优选的,所述第二卷积神经网络层包括两个5

×

5的卷积层,用于进一步提取低层特征;两个卷积层后都连接一个2

×

2的最大池化层,作用是丢弃特征图中除最强特征以外的其它特征。

[0080]

之后,将两个并行通道的处理结果输入所述特征融合层之前,还包括:

[0081]

对占比为

ɑ

的特征图进行上采样处理,即反卷积处理,使得特征图恢复原来的大小。

[0082]

s4:将两个所述并行通道的处理结果输入所述第一全连接层,进行特征融合处理,得到第二特征图。

[0083]

s5:将所述第二特征图输入所述空间注意力层,进行注意力加权处理。建立全局相互依赖关系,减少空间冗余信息。

[0084]

在一个具体的实施例中,给定一个任务相关的查询向量q,用注意力变量z∈[1,n]表示被选择信息的索引位置,即z=i表示选择了第i个输入信息。为方便计算,选择softmax信息选择机制。计算在给定q和x下,选择第i个输入信息的概率α

i

,如以下公式所示:

[0085][0086]

其中,输出α

i

为注意力分布,s(x

i

,q)为注意力打分函数。

[0087]

s6:将所述空间注意力层的输出结果输入所述第二全连接层,进行特征降维处理。

[0088]

优选的,在第二全连接层中添加dropout层来减少特征参数,避免模型的过拟合。

[0089]

s7:将所述第二全连接层的输出结果输入softmax分类器,得到待识别语音的情感分类结果。

[0090]

第二方面,与前述方法对应,本发明还提供一种基于注意力的多尺度卷积语音情感识别装置,如图4所示,该装置包括:

[0091]

模型构建模块,用于构建语音情感识别模型,其中,所述模型包括第一卷积神经网络层、两个由注意力层和第二卷积神经网络层组成的并行通道、第一全连接层、空间注意力层、第二全连接层和softmax分类器;

[0092]

特征图提取模块,用于将待识别语音对应的语谱图输入到训练好的所述语音情感识别模型中,使得所述第一卷积神经网络层对所述语谱图进行提取低层次的语音特征,得到第一特征图;

[0093]

特征图分割模块,用于将所述第一特征图分割为两个子特征图,将两个所述子特征图分别馈入到两个所述并行通道中,使得每个所述并行通道对其中一个子特征图进行并行的注意力加权处理和低层特征提取处理;

[0094]

特征图融合模块,用于将两个所述并行通道的处理结果输入所述第一全连接层,进行特征融合处理,得到第二特征图;

[0095]

注意力加权模块,用于将所述第二特征图输入所述空间注意力层,进行注意力加权处理;

[0096]

特征降维模块,用于将所述空间注意力层的输出结果输入所述第二全连接层,进行特征降维处理;

[0097]

情感分类结果输出模块,用于将所述第二全连接层的输出结果输入softmax分类器,得到待识别语音的情感分类结果。

[0098]

本发明所述的基于注意力的多尺度卷积模型相比于cnn网络和cbam模型,在不增加额外计算量的前提下,充分考虑不同尺度特征图的信息特征,增加卷积核的感知域,进行高效的情感特征提取。因此,该发明能够显著提升语音情感识别精度。卷积神经网络cnn由yann lecun在1998年提出以来就一直被用于各种人工智能领域的任务中,并且在语音情感识别领域取得了成功。具有局部感知的cnn能够对频谱特征的局部结构信息进行建模,并具

有更强广泛性和鲁棒性的权值共享和池化技术。而由woo等人在2018年提出的cbam模型,将通道注意力机制和空间注意力机制拼接起来,同时考虑了多方面的特征信息。本发明提出的模型在以cnn作为卷积层的基础上,考虑到不同特征通道信息的不均衡性,增加了两个并行的通道注意力机制和融合通道的空间注意力机制。

[0099]

使用不同模型进行语音情感识别的精度对比如下表所示:

[0100]

表1模型准确率的加权平均值

[0101]

modelcasia(wa%)cnn62.77cbam90.87proposed94.07

[0102]

在casia语音数据集中,本发明提出的模型准确率的加权平均值远高于cnn和cbam模型,其中比准确率为90.87%的cbam模型高3.2%。可见,本发明提出的模型有滤除冗余信息、挖掘深度特征的能力,能够显著提高语音情感识别的精度。

[0103]

本发明所提供的一种基于注意力的多尺度卷积语音情感识别方法及装置,公开了一种基于传统cnn进行改进的多尺度卷积神经网络,在不增加额外计算量的前提下,充分考虑不同尺度特征图的信息特征,增加卷积核的感知域,进行高效的情感特征提取,从而提高了ser的性能。同时,改进将通道注意力和空间注意力进行拼接的cbam模型,在深度学习神经网络中嵌入两个并行的通道注意力机制以及融合通道的空间注意力机制,增强有用信息并抑制对当前任务无用的信息,有利于深度模型捕获到更多情感相关的信息,找到显著的情感区域。

[0104]

以上所述实施例仅表达了本发明的几种实施方式,其描述较为具体和详细,但并不能因此而理解为对发明专利范围的限制。应当指出的是,对于本领域的普通技术人员来说,在不脱离本发明构思的前提下,还可以做出若干变形和改进,这些都属于本发明的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。