1.本发明属于计算机视觉、深度学习、目标检测领域,尤其涉及一种基于深度 学习的立体视觉人际安全距离检测方法。

背景技术:

2.保持人际安全距离是疫情防控的重要手段之一。提高人际距离检测的自动 化、智能化对降低疫情防控人力成本并提升防控效率有着重要意义。在医院、银 行、车站、政府服务窗口等公共场所部署机器视觉系统,自动检测人际安全距离 具有新颖性和需求迫切性。

3.naqiyuddin等人设计了一种可穿戴的人际距离检测系统,该系统由微控制 器、超声波传感器、lcd和蜂鸣器等构成,需要用户主动佩戴该装置,然后利 用超声波探测人际距离。gad等人设计了基于视觉的人际距离检测系统,利用逆 透视模型将相机采集的视频变换为鸟瞰图,基于卡尔曼滤波器和速度模型跟踪并 估计人际距离,该方法不需要用户佩戴专用设备,但人员漏检概率大,且人际距 离估计误差大。hou等人利用深度学习模型进行人际距离检测,提高了人员检测 的可靠性,但通过人员目标的像素距离估计人际距离,准确度不足;无独有偶, bhambani等人也基于单目视觉系统和深度学习模型提出了口罩检测和人际距离 检测系统,同样存在深度距离估计准确度不及水平距离估计准确度的问题。现有 个别基于立体视觉的人际安全距离估计方法,存在立体匹配计算复杂度高,难以 满足实时性要求。

4.面向人际安全距离检测的机器视觉系统及方法的研究是新冠疫情以来出现 的新需求,尽管出现了一些解决方案,但仍存在系统不易部署、人员漏检、人际 距离计算不准确、算法难以达到实时性等诸多问题。基于机器视觉系统,设计高 可靠性、高实时性的人际安全距离检测方法具有实用价值。

技术实现要素:

5.发明目的:本发明目的是提供一种基于深度学习的立体视觉人际安全距离检 测方法,可简化系统部署,提高人员检测和距离估计准确度和系统可靠性。

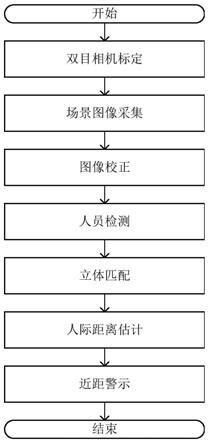

6.技术方案:本发明提供一种基于深度学习的立体视觉人际安全距离检测方 法,具体包括以下步骤:

7.(1)基于平面棋盘靶标对双目视觉系统进行标定,并使用标定后双目视觉 系统的左相机c

l

和右相机c

r

分别采集人员聚集场景图像,分别记为i

left

和i

right

;

8.(2)基于标定的相机参数,对采集的图像进行畸变校正和极线校正,得到 双目校正图像,其中,左校正图像记为右校正图像记为

9.(3)将双目校正图像分别输入深度神经网络,进行人员目标检测,输出人 员目标边框向量集,分别记为:f

l

和f

r

;每个边框向量的格式为(x,y,w,h),其 中,(x,y)表示人员目标边框左上角位置对应的像素坐标,w,h分别表示边框的宽 度和高度;

10.(4)将左校正图像中的人员目标中心点作为参考点,在极线约束和边框约 束下,

对中检测到的每个人员目标中心点p,在中寻找立体匹配点p', 计算中每个人员目标中心点p与匹配点p'的视差d,得到中心点p对应的人 员目标的三维坐标(x

p

,y

p

,z

p

);

11.(5)根据人员三维坐标计算人际距离;

12.(6)根据设定的人际距离下限,对距离过近人员进行警示提醒。

13.进一步地,所述步骤(1)包括以下步骤:

14.(11)用双目视觉系统的左相机c

l

和右相机c

r

同时采集已知尺寸的平面棋 盘靶标图像,从3个角度拍摄平面棋盘靶标,得到3对平面棋盘靶标图像(分别 记为:);

15.(12)对每幅平面棋盘靶标图像检测角点像素坐标;

16.(13)不考虑相机畸变,利用平面棋盘靶标图像(13)不考虑相机畸变,利用平面棋盘靶标图像的角点像素坐标,根据已知的平面靶标尺寸和物像方程确定左相 机c

l

和右相机c

r

的内参数和外参数初始值并利用极大似然估计优化内参数和 外参数;

17.(14)考虑相机径向畸变,利用平面棋盘靶标图像和的角点像素 坐标,估计左相机c

l

和右相机c

r

的畸变参数初始值;利用最小二乘法优化左右 两个相机的内参数、外参数和径向畸变参数,得到左相机c

l

的内参数外参 数径向畸变参数径向畸变参数和右相机c

r

的内参数外参数 径向畸变参数径向畸变参数

18.(15)根据左相机c

l

的外参数和右相机c

r

的外参数确定右相机c

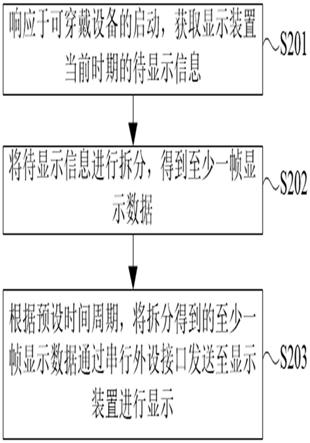

r

相对于左相机c

l

的旋转变换矩阵r,右相机c

r

相对于左相机c

l

的平移变换矩阵 t。

19.进一步地,所述步骤(2)中包括如下步骤:

20.(21)径向畸变校正:首先,创建与i

left

等大小的空白图像其次,对i

left

的每个像素坐标根据左相机c

l

的内参数及畸变参数计 算径向畸变校正坐标((u,v)),并将i

left

的位置处像素的灰度值赋给的 (u,v)位置的像素;再次,对中空值像素,进行插值处理;最后,将保存为 作为左图像i

left

畸变校正后的结果;同理,可得右图像i

right

畸变校正后的结 果

21.(22)双目极线校正:首先,根据右相机c

r

相对于左相机c

l

的旋转变换矩 阵r,将c

r

的相机坐标系和c

l

的相机坐标系各旋转r矩阵表示旋转角度的一半 使两相机坐标系平行;其次,右相机c

r

相对于左相机c

l

的平移变换矩阵t,确 定极线对准矩阵r

p

;最后,根据r

l

、r

r

、r

p

的值,分别旋转左畸变校正图像和右畸变校正图像得到左极线校正图像和右极线校正图像

22.(23)按照人员检测深度神经网络输入尺寸的要求,分别将左极线校正图像 和右极线校正图像裁剪为大小为m

×

n双目校正图像,分别记为 和

23.进一步地,步骤(3)所述深度神经网络采用yolov3目标检测网络,将检测 输出类别设置为person;或采用faster

‑

rcnn等目标检测网络,通过后处理将输 出向量格式调整

为(x,y,w,h)。

24.进一步地,所述步骤(4)包括以下步骤:

25.(41)读取左校正图像及其人员目标边框向量集f

l

,按照从左到右,从 上到下的顺序,选择一个人员边框f

l

=(x,y,w,h),计算人员中心点坐标 26.(42)在左校正图像上,以人员中心点p为中心,在左图像上选取m

×

n的 窗口w

l

作为立体匹配的支持区域;

27.(43)在右校正图像中寻找与左校正图像中人员中心点p对应的立体 匹配点p';

28.(44)根据左校正图像的参考点p和右校正图像的匹配点p'的像素 坐标,计算其视差d;

29.(45)根据标定的双目相机参数和参考点p和匹配点p'的视差值d,计算中 心点p对应的人员目标的三维坐标(x

p

,y

p

,z

p

);

30.(46)如果左校正图像中检测到的人员目标边框向量集f

l

中的边框已遍 历完毕,则结束匹配;否则,则跳转至(41)步骤继续进行下一个人员目标的三 维坐标计算。

31.有益效果:与现有技术相比,本发明的有益效果:实现了人员自动检测、人 际距离准确估计和距离过近预警。本发明的人际距离检测方法自动化程度高、距 离检测更准确、匹配计算复杂度低、检测实时性强。

附图说明

32.图1为本发明的流程图;

33.图2为本发明的双目相机示例图;

34.图3为本发明的平面棋盘靶标示意图;

35.图4为本发明的坐标系示意图;

36.图5为本发明的双目系统标定流程图;

37.图6为本发明的左相机采集场景图像示例;

38.图7为本发明的右相机采集场景图像示例;

39.图8为本发明的图像校正流程图;

40.图9为本发明的人员目标检测框图;

41.图10为本发明框选的人员目标示例1;

42.图11为本发明框选的人员目标示例2;

43.图12为本发明的立体匹配及视差计算流程图;

44.图13为本发明的双目视差示意图;

45.图14位本发明的测距误差测试曲线图。

具体实施方式

46.下面结合附图对本发明作进一步详细说明。

47.本发明提供一种基于深度学习的立体视觉人际安全距离检测方法,可以依托 双

目视觉系统、深度学习开发平台、大屏显示系统等平台实施。如图1所示,具 体包括以下步骤:

48.步骤1:基于平面棋盘靶标对双目视觉系统进行标定,如图2所示,并使用 标定后双目视觉系统的左相机c

l

和右相机c

r

分别采集人员聚集场景图像,分别 记为i

left

和i

right

。

49.标定由左相机c

l

和右相机c

r

构成的双目视觉系统的参数,包括:左相机c

l

内参数:左相机c

l

外参数:左相 机c

l

径向畸变参数:右相机c

r

内参数:右 相机c

r

外参数:右相机c

r

径向畸变参数右相机 c

r

相对于左相机c

l

的旋转变换矩阵r;右相机c

r

相对于左相机c

l

的平移变换 矩阵t;具体地,左右相机内外参数中,f

l

、f

r

分别表示左、右相机焦距,焦距,分别表示左相机传感器单位长度上的像素数,分别表示右相机传感器 单位长度上的像素数,表示左相机的主点坐标,表示右相机 的主点坐标,r

l

、r

r

分别表示左右相机的旋转矩阵,t

l

、t

r

分别表示左右相机 的平移矩阵。

50.双目系统标定时,采用如图3所示的已知方格尺寸的平面棋盘栅格作为靶 标,为了简化而不失一般性,可以靶标平面为基础建立世界坐标系 (o

w

‑

x

w

y

w

z

w

)。如图4所示,通常以相机光心为原点建立相机坐标系 (o

c

‑

x

c

y

c

z

c

),以主点为原点建立图像坐标系(o

i

‑

x

i

y

i

),以图像左上角为 原点像素为单位建立像素坐标系(o

p

‑

uv)。左右相机的外参数用于完成世界坐标系向相机坐标系的变换,左右相机的内参数用 于完成相机坐标系到像素坐标系的变换。右相机c

r

相对于左相机c

l

的旋转变换 矩阵r可由同一靶标下左右相机的外参数计算得到,同样,右相机c

r

相对于左 相机c

l

的平移变换矩阵t也可由同一靶标下左右相机的外参数计算得到。

51.标定方法如图5所示,包括如下步骤:

52.1)用双目系统的左相机c

l

和右相机c

r

同时采集已知尺寸的平面棋盘靶标 (见图3)图像,从3个角度拍摄平面棋盘靶标,得到3对平面棋盘靶标图像(分 别记为:)。采集过程中保持双目视 觉系统的相对位置关系不变,变换双目系统相对于平面棋盘靶标的角度。

53.2)对每幅平面棋盘靶标图像检测角点像素坐标。优选harris算法在每幅平面棋盘靶标上检测角点,若采用图 3所示靶标,忽略外层角点,选取中间54个角点作为有效角点坐标集合。

54.3)不考虑相机畸变,利用平面棋盘靶标图像3)不考虑相机畸变,利用平面棋盘靶标图像的角点像素坐标,根据已知的平面靶标尺寸和物像方程确定左相 机c

l

和右相机c

r

的内参和外参初始值并利用极大似然估计优化参数。对于每个 相机,利用其采集的3幅平面棋盘靶标图像,计算出3个单应矩阵;再由3个单 应矩阵确定相机的内参数,其中

和两个分数参数是作为一个整体确 定初值的,可以取相机焦距标称值作为f

l

和f

r

的初值,然后确定和的初值。 两相机的内参矩阵初始值确定后,选取一对平面靶标图像(例如:), 分别随机选取4个角点的像素坐标,求解该角度下的外参矩阵初值;然后,利用 所有角点的坐标值和极大似然法优化分别优化两个相机的内参数和外参数。

55.4)考虑相机径向畸变,利用平面棋盘靶标图像和的角点像素坐标, 估计左相机c

l

和右相机c

r

的畸变参数初始值;利用最小二乘法优化两个相机的 内参数、外参数和径向畸变参数,得到左相机c

l

的和右相机 c

r

的

56.5)根据左相机c

l

的和右相机c

r

的确定右相机c

r

相对于左相机c

l

的旋转变换矩阵r,右相机c

r

相对于左相机c

l

的平移变换矩阵t。在确定左右 相机采集一对靶标图像时的外参矩阵后,可以推导出两相机之间的变换关系(r, t),公式为:r=r

r

r

l

t,t=t

r

‑

rt

l

。

57.使用标定后双目视觉系统的左相机c

l

和右相机c

r

分别采集人员聚集场景 的1对图像,分别记为i

left

和i

right

。图6、图7给出一对场景图像示例,场景中人 员已做马赛克处理。

58.步骤2:基于标定的相机参数,对采集的图像进行畸变校正和极线校正,得 到双目校正图像,分别记为和

59.在双目系统的相机参数标定已知的情况下,对采集的图像进行校正有利于提 高立体匹配的准确度和效率。如图8所示,双目图像校正方法包括如下步骤:

60.1)径向畸变校正:首先,创建与i

left

等大小的空白图像其次,对i

left

的 每个像素坐标根据左相机c

l

的内参数及径向畸变参数计算径向畸变校正坐标((u,v)),即标((u,v)),即这里(x,y)是像素坐标(u,v)对应的图像坐 标,然后将i

left

的位置处像素的灰度值赋给的(u,v)位置的像素;再次, 对中空值像素,进行插值处理,插值算法可优选双线性插值算法;最后,将保存为作为左图像i

left

畸变校正后的结果。同理,可得右图像i

right

畸变校正 后的结果

61.2)双目极线校正:首先,根据右相机c

r

相对于左相机c

l

的旋转变换矩阵r, 将c

r

的相机坐标系和c

l

的相机坐标系各旋转r矩阵表示旋转角度的一半(即:r=r

l*

(r

r

)

‑1,r

l

和r

r

分别表示校正时左右相机内参数需左乘的矩阵),使两相 机坐标系平行;其次,右相机c

r

相对于左相机c

l

的平移变换矩阵t,确定极线 对准矩阵r

p

;最后,根据r

l

、r

r

、r

p

的值,分别旋转左畸变校正图像和右 畸变校正图像得到左极线校正图像和右极线校正图像

62.步骤3:将双目校正图像分别输入深度神经网络,进行人员目标检测,输出 人员目标边框向量集,分别记为:f

l

和f

r

;每个边框向量的格式为(x,y,w,h), 其中,(x,y)表示人员目标边框左上角位置对应的像素坐标,w,h分别表示边框的 宽度和高度。

63.按照人员检测深度神经网络输入尺寸的要求,分别将左极线校正图像和右

极线校正图像裁剪为大小为m

×

n双目校正图像,分别记为和 如果优选yolov3作为人员目标检测深度神经网络,则将校正图像裁剪为 416

×

416的大小。

64.利用人员目标检测深度神经网络,分别在和上检测人员目标,得到 人员目标边框向量集,记为:f

l

和f

r

,每个边框向量(f

l

∈f

l

或f

r

∈f

r

)的格 式为(x,y,w,h),其中,(x,y)表示人员目标边框左上角位置对应的像素坐标,w,h 分别表示边框的宽度和高度(以像素为单位)。图9是人员目标检测示意图,其 中,人员目标检测深度神经网络,优选yolov3目标检测网络,将检测输出类别 设置为person;也可采用faster

‑

rcnn等目标检测网络,通过后处理将输出向量 格式调整为(x,y,w,h)。根据目标检测网络输出的向量集,可以框选出人员目标, 图10、图11是按照目标检测网络输出向量而框选出的人员图像示例。

65.步骤4:将左校正图像中的人员目标中心点作为参考点,在极线约束和边框 约束下,对中检测到的每个人员目标中心点p,在中寻找立体匹配点p', 计算中每个人员目标中心点p与匹配点p'的视差d,得到中心点p对应的人 员目标的三维坐标(x

p

,y

p

,z

p

);如图12所示,包括如下步骤:

66.1)读取左校正图像及其人员目标边框向量集f

l

,按照从左到右,从上 到下的顺序,选择一个人员边框f

l

=(x,y,w,h),计算人员中心点坐标 67.2)在左校正图像上,以人员中心点p为中心,在左图像上选取m

×

n的窗 口w

l

作为立体匹配的支持区域。优选地,取10

×

10的窗口作为支持区域。

68.3)在右校正图像中寻找与左校正图像中人员中心点p对应的立体匹 配点p'。具体地,匹配的约束条件是极线约束和边框约束,其中,极线约束是 指,p'的行坐标值应与p的行坐标值相等;边框约束是指,p'应落入右校正图 像的人员目标边框向量集f

r

中的某个边框内。匹配的相似性度量准则是基于 支持区域的平方差之和的代价函数,即以p为中心的支持区域w

l

和以p'为中心 的支持区域w

r

内所有对应像素灰度差的平方之和。匹配的搜索策略是“赢家通 吃(winner takes all)”,即满足约束条件的取得最小度量值的点被选为匹配点。

69.4)根据左校正图像的参考点p和右校正图像的匹配点p'的像素坐 标,计算其视差d。如图13所示,经过校正的双目图像,参考点和匹配点只有 一个维度坐标不同,视差d=u

l

‑

u

r

。

70.5)根据标定的双目相机参数和参考点p和匹配点p'的视差值d,计算中心 点p对应的人员目标的三维坐标(x

p

,y

p

,z

p

)。深度维度z

p

的计算方法是 z

p

=(b

·

f

l

)/d,这里,b由平移矩阵t的x分量计算。x

p

,y

p

可由p的像素坐标 与左相机内参矩阵的逆矩阵相乘得到。

71.6)如果左校正图像中检测到的人员目标边框向量集f

l

中的边框已遍历 完毕,则结束匹配;否则,则跳转至第1)步骤继续进行下一个人员目标的三维 坐标计算。

72.步骤5:根据人员三维坐标计算人际距离。

73.根据场景中人员目标的三维坐标,计算人际距离。计算人际距离的方法是, 假设已得到两个人员的三维坐标为(x

p1

,y

p1

,z

p1

)和(x

p2

,y

p2

,z

p2

),则两个人的距离 为

74.步骤6:根据设定的人际距离下限,对距离过近人员进行警示提醒。

75.人员距离下限可根据实际情况设置,比如设置为1米。警示提醒可以通过大 屏显示和语音提示配合使用。

76.为验证本发明的人际安全距离检测方法的实用性,在以k210芯片为处理核 心的勘智开发板上,扩展如图1所示的双目摄像头,实现了本发明所公开的检测 方法。该方法能够在有限的计算资源下对人员场景视频流进行实时检测和近距预 警。其运行时间低于ahamad等人报道方法运行时间2个数量级,满足高实时要 求。

77.图14展示了用双目基线60毫米的立体视觉系统采集已知人员目标准确距离 的设定场景,运行本发明的人际安全距离检测方法,得到的测量距离与实际距离 之间的关系曲线。观察该图可知,尽管双目立体视觉系统测量机理约束下,测量 误差随实际间距呈上升趋势,但相对误差比例明显低于1%,远低于gad等人所 报道方法取得的1.69%、2.17%、3.45%的误差;也低于bhambani等人方法2% 以上的误差。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。