1.本发明涉及试题表征技术领域,特别是涉及一种基于深度语义表征的试题难度预测方法及系统。

背景技术:

2.传统教育中,试题的属性标签通常由专家手工标注,存在费时费力、科学性与一致性难以保证等问题。针对这一问题,已有研究人员利用手工筛选分类特征,利用机器学习技术构建模型对试题的各项属性进行标注。但是,此类研究仍未能充分利用试题文本中存在的丰富的语义信息,以及不同题型的文本模块之间存在的复杂的上下文关系,属性标注的精度有待提高。此外,现有研究中,也未充分重视试题的认知目标这一重要属性,认知目标对评价学习者的思维有着重要的作用,以及认知目标下试题难度评估也缺乏研究。

技术实现要素:

3.本发明的目的是提供一种基于深度语义表征的试题难度预测方法及系统,用以解决试题文本认知层级标注困难和语料不足、试题难度评估标准单一缺乏认知指导的问题。

4.为实现上述目的,本发明提供了如下方案:

5.一种基于深度语义表征的试题难度预测方法,包括:

6.基于预训练语言模型对多类型试题进行文本表征;所述多类型试题包括三种题型,为填空题、选择题和简答题;三种题型共包括四种结构文本,为题干文本、答案文本、选项文本和解析文本;

7.对试题文本表征进行特征提取和融合;

8.基于多层感知机对融合后的特征进行分类,确定多类型试题的所属知识点集合;

9.计算所述知识点集合中各知识点的拓扑距离;

10.基于深度注意力网络模型,根据融合后的特征确定所述多类型试题的认知层级;

11.基于所述试题文本表征、知识点拓扑距离以及所述认知层级预测所述多类型试题的难度。

12.进一步地,所述对试题文本表征进行特征提取和融合,具体包括:

13.采用双向长短记忆网络模型对题干文本表征和解析文本表征进行特征提取;

14.采用卷积经网络模型对答案文本表征和选项文本表征进行特征提取;

15.采用特征融合模型进行特征融合。

16.进一步地,所述采用特征融合模型进行特征融合,具体包括:

17.对于填空题,对提取到的填空题题干文本特征和填空题答案文本特征进行拼接,并输入到一层bilstm和注意力机制层进行融合;

18.对于选择题,将各选项文本特征示输入到一个注意力机制层后和选择题题干文本特征进行拼接,并输入到一层bilstm和注意力机制层进行融合;

19.对于简答题,将简答题题干文本特征和简答题答案文本特征进行拼接,并输入到

一层bilstm和注意力机制层进行融合;将简答题解析文本特征和简答题答案文本特征进行拼接,并输入到一层bilstm和注意力机制层进行融合;将融合后的特征输入至全连接层进行最终融合。

20.进一步地,所述基于所述试题文本表征、知识点拓扑距离以及所述认知层级预测所述多类型试题的难度,具体包括:

21.在训练阶段,将试题文本表征、知识点拓扑距离和认知层级作为线性回归模型的输入,并从答题记录中获取样本试题的得分率作为试题难度的标签;

22.在测试阶段,通过输入试题文本表征、知识点拓扑距离和认知层级,预测当前试题的得分率,确定试题的难度。

23.进一步地,所述知识点拓扑距离的计算公式如下:

[0024][0025]

其中,d

q

表示试题q的知识点拓扑距离,k

i

,k

j

表示试题q所属知识点集合k中的第i、j个知识点,k={k1,k2…

k

n

},n表示知识点个数。

[0026]

本发明还提供了一种基于深度语义表征的试题难度预测系统,包括:

[0027]

文本表征模块,用于基于预训练语言模型对多类型试题进行文本表征;所述多类型试题包括三种题型,为填空题、选择题和简答题;三种题型共包括四种结构文本,为题干文本、答案文本、选项文本和解析文本;

[0028]

特征提取和融合模块,用于对试题文本表征进行特征提取和融合;

[0029]

知识点集合确定模块,用于基于多层感知机对融合后的特征进行分类,确定多类型试题的所属知识点集合;

[0030]

知识点距离计算模块,用于计算所述知识点集合中各知识点的拓扑距离;

[0031]

认知层级确定模块,用于基于深度注意力网络模型,根据融合后的特征确定所述多类型试题的认知层级;

[0032]

难度预测模块,用于基于所述试题文本表征、知识点拓扑距离以及所述认知层级预测所述多类型试题的难度。

[0033]

进一步地,所述特征提取和融合模块具体包括:

[0034]

第一特征提取单元,用于采用双向长短记忆网络模型对题干文本表征和解析文本表征进行特征提取;

[0035]

第二特征提取单元,用于采用卷积经网络模型对答案文本表征和选项文本表征进行特征提取;

[0036]

特征融合单元,用于采用特征融合模型进行特征融合。

[0037]

进一步地,所述知识点拓扑距离的计算公式如下:

[0038][0039]

其中,d

q

表示试题q的知识点拓扑距离,k

i

,k

j

表示试题q所属知识点集合k中的第i、j个知识点,k={k1,k2…

k

n

},n表示知识点个数。

[0040]

根据本发明提供的具体实施例,本发明公开了以下技术效果:

[0041]

本发明归类总结试题类型和试题语言特点,综合利用融合试题上下文文本特征,基于深度注意力网络的试题文本认知层级的自动抽取模型;在确定试题认知层级基础上,结合试题上下文特征、知识点拓扑结构特征,研究基于混合神经网络模型和认知层级的试题难度自动评估框架,从而解决试题文本认知层级标注困难和语料不足、试题难度评估标准单一缺乏认知指导的问题。

附图说明

[0042]

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

[0043]

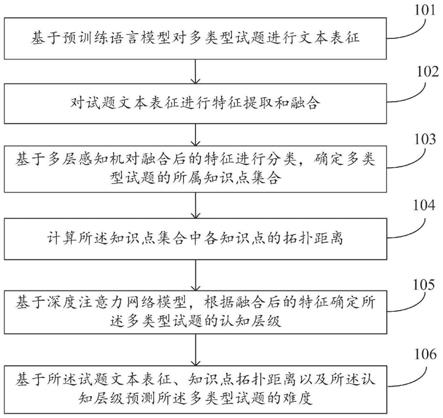

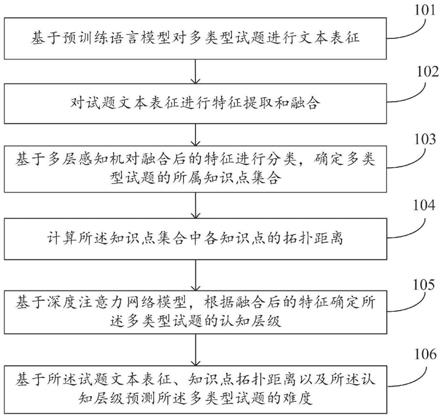

图1为本发明实施例基于深度语义表征的试题难度预测方法的流程图;

[0044]

图2为本发明实施例试题文本嵌入表示的原理图;

[0045]

图3为本发明实施例基于预训练语言模型的试题上下文编码的原理图;

[0046]

图4为本发明实施例试题文本特征提取的原理图;

[0047]

图5为本发明实施例多类型试题文本特征融合的原理图;

[0048]

图6为本发明实施例试题文本认知层级自动抽取的原理图;

[0049]

图7为本发明实施例基于认知层级的试题难度预测的原理图;

具体实施方式

[0050]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0051]

本发明的目的是提供一种基于深度语义表征的试题难度预测方法及系统,用以解决试题文本认知层级标注困难和语料不足、试题难度评估标准单一缺乏认知指导的问题。

[0052]

为使本发明的上述目的、特征和优点能够更加明显易懂,下面结合附图和具体实施方式对本发明作进一步详细的说明。

[0053]

如图1所示,本发明提供的基于深度语义表征的试题难度预测方法,包括以下步骤:

[0054]

步骤101:基于预训练语言模型对多类型试题进行文本表征;所述多类型试题包括三种题型,为填空题、选择题和简答题;三种题型共包括四种结构文本,为题干文本、答案文本、选项文本和解析文本。

[0055]

步骤102:对试题文本表征进行特征提取和融合。

[0056]

步骤103:基于多层感知机对融合后的特征进行分类,确定多类型试题的所属知识点集合。

[0057]

步骤104:计算所述知识点集合中各知识点的拓扑距离。

[0058]

步骤105:基于深度注意力网络模型,根据融合后的特征确定所述多类型试题的认

知层级。

[0059]

步骤106:基于所述试题文本表征、知识点拓扑距离以及所述认知层级预测所述多类型试题的难度。

[0060]

作为一个可选的实施例,步骤102:对试题文本表征进行特征提取和融合,具体包括:

[0061]

步骤1021:采用双向长短记忆网络模型对题干文本表征和解析文本表征进行特征提取。

[0062]

步骤1022:采用卷积经网络模型对答案文本表征和选项文本表征进行特征提取。

[0063]

步骤1023:采用特征融合模型进行特征融合。

[0064]

作为一个可选的实施例,步骤1023:采用特征融合模型进行特征融合,具体包括:

[0065]

对于填空题,对提取到的填空题题干文本特征和填空题答案文本特征进行拼接,并输入到一层bilstm和注意力机制层进行融合。

[0066]

对于选择题,将各选项文本特征示输入到一个注意力机制层后和选择题题干文本特征进行拼接,并输入到一层bilstm和注意力机制层进行融合。

[0067]

对于简答题,将简答题题干文本特征和简答题答案文本特征进行拼接,并输入到一层bilstm和注意力机制层进行融合;将简答题解析文本特征和简答题答案文本特征进行拼接,并输入到一层bilstm和注意力机制层进行融合;将融合后的特征输入至全连接层进行最终融合。

[0068]

作为一个可选的实施例,步骤106:基于所述试题文本表征、知识点拓扑距离以及所述认知层级预测所述多类型试题的难度,具体包括:

[0069]

在训练阶段,将试题文本表征、知识点拓扑距离和认知层级作为线性回归模型的输入,并从答题记录中获取样本试题的得分率作为试题难度的标签;

[0070]

在测试阶段,通过输入试题文本表征、知识点拓扑距离和认知层级,预测当前试题的得分率,确定试题的难度。

[0071]

作为一个可选的实施例,步骤104中知识点拓扑距离的计算公式如下:

[0072][0073]

其中,d

q

表示试题q的知识点拓扑距离,k

i

,k

j

表示试题q所属知识点集合k中的第i、j个知识点,k={k1,k2…

k

n

},n表示知识点个数。

[0074]

下面,将对上述方法进行详细的介绍:

[0075]

1、基于混合神经网络的多类型试题上下文特征提取与融合

[0076]

本发明拟在总结试题类型、解析试题结构的基础上,确定三种普遍、通用的试题类型(填空题、选择题、简答题)作为对象,利用预训练语言模型对文本进行向量表示后,根据不同类型的试题结构采用有针对性的混合神经网络模型来提取和融合上下文特征。

[0077]

(1)语料准备

[0078]

本发明以中小学各学段学科的教学设计、试题试卷、多媒体素材等教学资源,并分析其中各学科各种题型类型、题目结构、题目语言特点(子语言特点),梳理出各学科普遍、通用的试题类型作为本项目通用试题知识点抽取模型构建的对象,结合试题所属章节目

录、试题解析和课程大纲等知识点来源,以宾州中文树库(penn chinese treebank,pctb)标注规范作为基础,构建适用于下游试题属性标注的语料库,整理和规范化未确定试题和孤立试题。

[0079]

(2)试题文本表征和特征提取

[0080]

本发明分别对填空题、选择题和简答题进行文本表征,并根据不同题型的不同结构设计不同特征提取方法,实现试题文本的充分表征和特征提取。首先对三种题型和所属知识点给出形式化的定义:

[0081]

definition1:填空题

[0082]

定义t

fq

=[t

stem

;t

answer

]为一道填空题fq(fill in the blanks question)文本内容,t

stem

表示题干文本,t

answer

表示填空答案文本(默认研究单项填空题类型)。

[0083]

definition 2:选择题

[0084]

定义t

fq

=[t

stem

;t

opt

]为一道选择题cq(choicequestion)文本内容,t

stem

表示题干文本,t

opt

表示所有选项文本,且t

opt

={t1,t2…

t

o

},o表示选项个数,且正确选项t

i

∈t

opt

(默认研究单项选择题类型)。

[0085]

definition3:简答题

[0086]

定义t

pq

=[t

stem

;t

answer

;t

analysis

]为一道填空题pq(practical question)文本内容,t

stem

表示题干文本,t

answer

表示答案文本,t

analysis

表示答案解析,作为对答案文本的解释和补充。简答题的答案文本多为长文本,而答案解析是针对答案文本的解析,内容和细节上相对于答案更丰富。

[0087]

本发明这里只考虑简答题的答案解析,主要是简答题与答案的对应关系更加明显和具体;不管理科还是文科的简答题,答案文本多分条、分行和分点,简答题的解析也是对应的。而填空题和选择题的答案多为短文本,解析一般不能与之形成紧密联系,所以本发明暂不考虑。

[0088]

definition 4:知识点

[0089]

面向具体的学科和具体的学段(如初中数学等),依据教学大纲,将全部知识点定义为k={k1,k2…

k

m

},m表示知识点的个数,k

q

表示一道试题q考察的全部,

[0090]

通过形式化定义,本发明整合三种题型的共四种结构文本,包括t

stem

、t

analysis

、t

answer

和t

opt

。为了理解语义信息,本发明首先采用预训练语言模型bert(bidirectional encoder representation from transformers)分别对四种结构文本向量化表示,能够充分描述试题文本字符级、词级和句子级的特征信息。以t

stem

为例,bert将t

stem

={w1,w2...w

n

}中的每个词w

n

(token)通过嵌入层传递,以便将每个token转换为向量表示。如图1所示,嵌入层包括三种嵌入表示,分别是token嵌入,segment嵌入和position嵌入,通过这三个嵌入表示共同表示输入的文本。与其他表示方法如word2vec不同,bert还设计了segment嵌入和position两种形式。以模拟试题题干“accordingto the condition,deduce monotonicity”为例具体如附图2所示。

[0091]

token embedding(字符嵌入表示)的作用是将字转换为固定维数的向量表示形式,其中有两个特殊的tokens,位于句首的[cls]和位于句末的[sep],分别用于表示输入的整个句子和划分句子对。segment embedding(句子片嵌入)的作用是区分句子对中的两个句子向量,sep分割符,前面是句子1,后面是句子2,则句子1中所有token的标记为0,句子2

为1,以此类推。position embedding(位置嵌入)的作用是记录每个token在句子中的位置属性。bert将每个token表示成768维的向量,如在第b个批次处理n个输入token可以被转换为(b,n,768)的张量,因此嵌入表示e

stem

={e1,e2...e

n

},其中e

n

=e

token

(wn) e

segment

(wn) e

position

(w

n

)。

[0092]

接着,将题干文本的嵌入表示e

stem

输入bert模型中预训练的双向transformer中提取词法、句法等文本句式中隐含的信息,得到输入文本的字向量表示x

stem

={x1

,

x2...x

n

},其中x

n

=transformer

encoder

(e

n

),如附图3所示。

[0093]

经过相同的bert文本嵌入流程,本发明可以得到每种结构文本的字向量表示,分别是x

stem

、x

analysis

、x

answer

和x

opt

。接着,本发明通过分析这四种结构文本的语言特点,采用了两种不同的特征提取方法。针对题干文本x

stem

和解析文本x

analysis

,这两种结构文本更加注重文本的整体理解,具有较强的序列语义性,因此本发明采用双向长短记忆网络bilstm(bi

‑

directionallongshort

‑

term memory)来侧重于提取序列特征信息,见附图4。以题干文本x

stem

为例,输入bilstm网络结构中后隐藏状态可以表示为:

[0094]

h

t

=f(w

x

x

t

w

h

h

t

‑

1 b)

[0095]

其中x

t

∈x

stem

表示第t个字向量输入,w

x

、w

h

为当前字输入和连接上一个字隐层的权重矩阵,b为偏置。具体的,lstm相较于rnn(recurrent neural network)设计了一种记忆单元结构,通过三种门结构(输入门、遗忘门和输出门)来控制信息在记忆单元c

t

中的存储、更新和遗忘:

[0096]

i

t

=σ(w

xi

x

t

w

hi

h

t

‑1 w

ci

c

t

‑1 b

i

)

[0097]

c

t

=(1

‑

i

t

)

⊙

c

t

‑1 i

t

⊙

tanh(w

xc

x

t

w

hc

h

t

‑1 b

c

)

[0098]

o

t

=σ(w

xo

x

t

w

ho

h

t

‑1 w

co

c

t

b

o

)

[0099]

h

t

=o

t

⊙

tanh(c

t

)

[0100]

其中σ为sigmoid函数,

⊙

为hadamard乘积。普通的lstm从左到右处理第t个字得到前向隐藏状态bilstm在此基础上,增加了从右到左的后向隐藏状态前向与后向拼接最终得到题干文本字向量x

stem

的特征表示采用相同的方法,本发明也可以得到解析文本x

analysis

的序列特征表示f

analysis

。

[0101]

针对x

answer

和x

opt

,这两种结构文本一般以短文本的形式存在,且聚合着多种试题的综合特征,具有较强局部语义性,因此本发明采用一种处理文本的卷积神经网络textcnn(text convolutional neural networks)来侧重提取局部语义特征,见附图3。以答案文本x

answer

为例,设置不同大小的卷积核分别抽取字片段特征(n

‑

gram特征),卷积计算出的特征图经过最大池化(maxpooling)保留最大的特征值,然后将拼接成一个向量作为文本的表示。具体的,将x

answer

输入到textcnn中,采用一维卷积核,其宽度与输入的词向量维度d一致,只有高度不同,设有p种不同高度的卷积核,分别为h1,h2......h

p

,以其中高度为h的卷积核为例,该卷积核可表示为矩阵w

conv_h

∈r

h

×

d

,使用该卷积核在词向量x

i

上滑动进行卷积运算,当滑动窗口位于第i到第i h

‑

1个词之间时,卷积核的输出可表示为:

[0102]

[0103]

其中f为该卷积核的激活函数,b为偏置。高度为h的卷积核对矩阵共进行了i

‑

h 1次卷积运算,输出n

‑

h 1个值,拼接后得到长度为n

‑

h 1的字片段集合(feature_map),如果每种高度的卷积核都有k个,则每种卷积核产生k个n

‑

h 1长度的向量:

[0104]

conv=[conv

0:h

‑1,conv

1:h

…

conv

n

‑

h:n

‑1]

[0105]

接着对卷积核输出的每个feature_map使用长度为n

‑

h 1的池化核,进行最大池化操作:

[0106][0107]

由于每种高度的卷积核都有k个,一共有p个卷积核,因此经过池化操作将输出值拼接,得到一个长度为k

×

p的向量

[0108][0109]

其中是使用第i种高度的第j个卷积核对e

i

进行卷积并经过最大池化后输出的值,即为答案文本x

answer

的特征表示,记作f

answer

。采用同样的方法,本发明也可以得到选项文本x

opt

的特征表示f

opt

,其中每个选项文本x

opt

,i∈x

opt

的特征表示f

opt

,i∈f

opt

。

[0110]

(3)多题型多特征融合

[0111]

在对四种结构文本特征提取的基础上,本发明针对不同题型,设计适应其文本特点和做题特点的特征融合网络结构,见附图5。

[0112]

1)填空题

[0113]

在分别对填空题题干文本t

stem

表示并提取特征后得到f

stem

,对填空答案文本t

answer

表示并提取特征后得到的f

answer

,采用拼接的方式组成,并输入一层bilstm输出融合f

fq

:

[0114]

f

fq

=bilstm(concat(f

stemn

,f

answer

))

[0115]

但填空题与选择题在整体文本上存在差异,即填空题的答案文本与题干文本的结合更紧密,因为答案本身是从题干中挖空产生的,因此填空答案与题干之间也存在着句法上的语义关系。在特征融合之后n

f

表示特征向量长度。本发明将其输入到一个注意力机制层(attention层)中来处理这种整体的文本语义信息,注意力概率分布a

i

:

[0116][0117]

其中j∈[1,n

f

],为随机初始化向量,在训练过程中逐步更新,则第i个字向量特征的特征表示f

fq,i

占的比重值为:

[0118][0119]

其中w、u为权值矩阵,b为偏置值,relu为激活函数,得到每个字向量的概率分布值后,对所有字向量特征表示进行求和在平均,得到填空题整体文本t

fq

的特征向量

[0120][0120][0121]

2)选择题

[0122]

为了充分利用各个选项之间的权重匹配,方便网络学习更多试题与各个选项之间联系,本发明将各个选项的特征表示输入到一个attention层,则计算每个选项的特征表示与所有选项的特征表示的匹配得分占总体的百分率(注意力概率分布)a

i

:

[0123][0124]

其中j∈[1,o],o表示选项个数,为随机初始化向量,在训练过程中逐步更新,则第i个选项的特征表示f

opt

,i占f

opt

的比重值为:

[0125][0126]

其中w、u为权值矩阵,b为偏置值,relu为激活函数,得到每个选项的概率分布值后,对所有选项特征表示进行求和在平均,得到选项文本t

opt

的特征向量

[0127][0128]

接着采用拼接的方式组成,并输入一层bilstm输出融合特征f

cq

:

[0129][0130]

最后再采用一层注意力机制得到最终的特征

[0131]

3)简答题

[0132]

简答题的解答过程体现了一个思维逻辑过程,即运用t

stem

中条件到t

answer

中步骤的过程,同时,答案解析与答案也存在一个印证补充的过充,即t

analysis

对t

answer

中的每一个步骤给出具体的解析内容。这种t

stem

→

t

answer

→

t

analysis

语义层面的依赖也会反应在其文本特征间的依赖上,因此,本发明对这两段依赖过程分别采用attention进行表征和融合。

[0133]

针对t

stem

→

t

answer

,首先将两部分的特征拼接后输入一层bilstm,隐藏层节点个数得到融合特征f

sa

:

[0134]

f

sa

=bilstm(concat(f

s tem

,f

answer

))

[0135]

接着采用一层注意力机制权重分配得到特征向量

[0136][0137]

其中

[0138]

针对t

answer

→

t

analysis

,同样将两部分的特征拼接后输入一层bilstm,隐藏层节点个数得到融合特征f

aa

:

[0139]

f

aa

=bilstm(concat(f

answer

,f

anafysis

))

[0140]

接着采用一层注意力机制权重分配得到特征向量

[0141]

[0142]

其中

[0143]

最终经过一个全连接层fc形成两部分特征依赖的整体特征:

[0144][0145]

半监督数据计算正则化、多分类输出

[0146]

根据不同题型特点设计的特征融合模型,能够分别得到填空题、选择题和简答题的试题文本整体特征表示:和

[0147]

2.试题知识点抽取

[0148]

以为例,输入到多层感知机mlp(multilayer perceptron)进行分类,该层由两层全连接层f1、f2组成的,其中f1使用relu作为激活函数,f2的节点个数与总知识点数量m一致,假设有nm个知识点标签k={k1,k2…

k

m

},mlp将融合特征转换为长度等于m的向量最终利用softmax函数作为分类器,将f2的输出归一化,得到该选择题属于各个知识点的概率:

[0149][0150]

3.认知目标下的试题难度评估

[0151]

基于认知层级的试题难度评估要重点解决两个个问题:一是要解决试题文本认知层级标注困难和语料不足,二是要能够实现自动抽取试题文本的认知动词和确定认知层级,三是要实现融合试题认知层级等试题特征的难度自动评估模型。

[0152]

(1)试题文本认知层级自动抽取模型

[0153]

试题的认知层级隐含在试题文本中,属于一种深层特征,在前面准备工作的基础上,本发明采用了一种深度注意力网络结构(deep attentional neural network),设计了一种能够深层挖掘试题文本隐含特征的网络块,并结合残差网络实现高层网络的特征强化,见附图6。

[0154]

1)试题文本表示

[0155]

首先对试题文本进行嵌入表示,这里与前文类似,依旧采用bert来得到字向量序列x

t

,并采用前述方法得到融合特征

[0156]

接着采用多头注意力机制中的结构(multi

‑

head attention),将文本特征多次通过多头h的线性投影映射为n组(queries)、k(keys)和v(values)矩阵:

[0157][0158]

其中

[0159]

最终深度注意力网络块输出隐藏变量为y:

[0160]

y=m

·

w

[0161]

其中m=concat(m1,

…

,m

h

)。

[0162]

3)结合残差网络的深度注意力网络

[0163]

深层注意力网络由多个网络块组成,如图6所示。为了简化模型训练并获得更高的精度,在每个网络块之后使用一个残差连接块来稳定网络特征传播:

[0164]

y=x block(x)

[0165]

最后通过softmax层映射,输出试题t对应六种认知层级的概率如表,取概率最高的为该试题文本的认知层级:

[0166][0167]

但往往一道试题可能包括多种认知层级,比如既考察了记忆、理解,又考察了综合等。因此本发明需要一个对试题认知层级综合衡量的指标f

cognition

:

[0168][0169]

认知层级记忆理解运用分析综合评价概率值p

i

p1p2p3p4p5p6权重值a

i

123456

[0170]

(2)基于认知层级的试题难度评估技术

[0171]

本发明在试题认知层级自动抽取的基础上,设计了一种基于认知层级的试题难度评估技术,见附图7。整体流程包括训练和测试阶段。在训练阶段,将试题文本表征、试题知识点拓扑距离表征和认知层级作为模型输入,并从答题记录中获取试题的得分率作为试题难度的标签;在测试阶段,通过输入上述三类试题特征,预测该试题的得分率,即试题的难度。形式化定义如下:

[0172]

definition 5:得分率

[0173]

定义试题集q一道试题q

i

∈q的得分率为r

q

可以表示为:

[0174][0175]

其中w

i

表示试题q

i

的分值,record为q

i

的作答记录数,score()表示某次记录得分。

[0176]

definition6:试题知识点拓扑距离

[0177]

由def 4得k={k1,k2…

k

m

}为全部知识点集合,m表示知识点的个数,k

q

表示一道试题q考察的全部,定义知识点关系无向图g=(k,e),其中k表示知识点集合,e表示知识点间的关联关系边;两个知识点k

i

,k

j

在g中的最短拓扑距离为dfs(k

i

,k

j

),则试题q的知识点拓扑距离为:

[0178][0179]

首先本发明将试题q的各部分文本字向量x

stem

、x

anal ysis

、x

answer

和x

opt

拼接成一个全局字向量来表示试题文本信息x:

[0180]

x

q

=concat(x

stem

,x

analysis

,x

answer

,x

opt

)

[0181]

接着将其连续送入bilstm层、cnn层和节点数为d的全连接层fc,得到维数为的特征表示f

q

(具体数据流程与前文相似,不再赘述):

[0182]

f

q

=fc(cnn(lstm(x)))

[0183]

另一方面,将试题的认知层级特征f

cognition

与知识点拓扑距离d

q

相加融合成新特征值,并累加到f

q

的每个元素上:

[0184]

f

q

=add(f

cognition

,d

q

)

[0185]

f

q

=f

q

f

q

[0186]

最后采用线性回归模型,输出即为预测试题难度d(f

q

):

[0187]

d(f

q

)=w

t

·

f

q

b

[0188]

其中w

t

为权重矩阵,b为偏置向量。

[0189]

本发明还提供了一种基于深度语义表征的试题难度预测系统,包括:

[0190]

文本表征模块,用于基于预训练语言模型对多类型试题进行文本表征;所述多类型试题包括三种题型,为填空题、选择题和简答题;三种题型共包括四种结构文本,为题干文本、答案文本、选项文本和解析文本;

[0191]

特征提取和融合模块,用于对试题文本表征进行特征提取和融合;

[0192]

知识点集合确定模块,用于基于多层感知机对融合后的特征进行分类,确定多类型试题的所属知识点集合;

[0193]

知识点距离计算模块,用于计算所述知识点集合中各知识点的拓扑距离;

[0194]

认知层级确定模块,用于基于深度注意力网络模型,根据融合后的特征确定所述多类型试题的认知层级;

[0195]

难度预测模块,用于基于所述试题文本表征、知识点拓扑距离以及所述认知层级预测所述多类型试题的难度。

[0196]

其中,所述特征提取和融合模块具体包括:

[0197]

第一特征提取单元,用于采用双向长短记忆网络模型对题干文本表征和解析文本表征进行特征提取;

[0198]

第二特征提取单元,用于采用卷积经网络模型对答案文本表征和选项文本表征进行特征提取;

[0199]

特征融合单元,用于采用特征融合模型进行特征融合。

[0200]

本说明书中各个实施例采用递进的方式描述,每个实施例重点说明的都是与其他实施例的不同之处,各个实施例之间相同相似部分互相参见即可。对于实施例公开的系统而言,由于其与实施例公开的方法相对应,所以描述的比较简单,相关之处参见方法部分说明即可。

[0201]

本文中应用了具体个例对本发明的原理及实施方式进行了阐述,以上实施例的说明只是用于帮助理解本发明的方法及其核心思想;同时,对于本领域的一般技术人员,依据本发明的思想,在具体实施方式及应用范围上均会有改变之处。综上所述,本说明书内容不应理解为对本发明的限制。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。