1.本发明属于城市自动驾驶领域,具体涉及一种融合多源数据及综合多维指标的自动驾驶决策方法。

背景技术:

2.随着车载传感器精度的提高和感知数据处理技术的飞速发展,自动驾驶成为近年来的热门领域。城市自动驾驶人们接触最为频繁的驾驶场景,在城市驾驶中,给定一个起点、一个终点、一条规划路径(如通过百度地图、谷歌地图规划的驾驶路线),自动驾驶系统的任务是在城市交通中,通过控制车辆的驾驶策略,无碰撞的完成预设好的驾驶路径,驾驶策略指的是控制自动驾驶汽车的方向值、油门值和刹车值。

3.自动驾驶系统的感知数据来源于高精度车载传感器。高维度的传感数据如图片、三维点云数据需要从摄像头和雷达传感器中获得,低维度传感数据(如车辆位置、车辆方向)需要从gnss(全球导航卫星系统)传感器、imu(惯性传感器)传感器中获得。摄像头的数据能够提供道路的精细检测,但是需要经过高准确度的感知信息处理。gnss、imu传感器的数据能够直接提供车辆的位置和方向,但是系统不稳定,在立交桥、高楼附近信号弱,容易失效。目前的自动驾驶感知技术,一部分是从摄像头中检测目标(其他车辆、行人、车道线),一部分是从传感器数据直接获得感知数据(如车辆的位置),缺乏一种自动化的方法将二者结合。因此,合理融合多源传感器数据,为环境感知和车辆自身的感知提供更为丰富的信息,十分必要。一个合理的多维综合指标对于自动驾驶系统的训练和评估都十分重要。目前的自动驾驶系统或者是关注车辆的横向控制(控制车辆的方向),将车辆距离车道线的偏移距离作为控制指标;或者是关注车辆的纵向控制(控制车辆的速度),将车辆的刹车的行为作为控制指标。但是城市自动驾驶系统需要在复杂的交通环境下同时控制车辆的方向的速度,需要一个综合指标评估自动驾驶系统的驾驶状态的好坏。

4.现有技术的基于计算机视觉的方法都会人工标注一些目标的位置(如行人、汽车)用于训练,现有技术的这种训练方法虽然直观,但是耗时耗力。

5.现有技术的方法仅对于自动驾驶汽车速度的控制进行评估或者是对自动驾驶汽车方向的控制进行评估,缺少一个综合的评估方法,难以用于指导城市中驾驶策略的训练。

6.例如,申请号为201510883479.2的专利公开了一种基于单目视觉的自动驾驶汽车换道控制方法,通过图像处理模块对车道线进行识别和处理,通过上位机模块计算出方向盘转角增量,从而实现自动换道,然而,上述方法并不适用于一些复杂交通情况,比如在密集车流中的换道策略,不仅需要考虑车辆的方向,也要控制车辆的速度避免和其他车辆的碰撞。而上述方法仅仅实现了车辆方向的自动控制,在实际场景中,自动驾驶车辆需要同时控制车辆的方向和速度,才能实现一个安全可靠的驾驶过程。

7.又例如申请号为200810059963.3的专利公开了一种基于车载传感器网络的驾驶员状态评估系统,其中的车辆驾驶状态评估传感器网络,实时监控驾驶员对车辆做出的驾驶行为,包括启动、换挡、刹车、转向灯驾驶行为,判断车辆在紧急行车状况时做出的驾驶行

为是否得当,但是此评估系统缺乏对于目标状态的合理定义,只能用于一些紧急情况下的驾驶行为评估,无法提供自动驾驶系统驾驶策略的实时、全面的评估。

技术实现要素:

8.针对现有技术中的缺陷空白,本发明提出一种融合多源数据及综合多维指标的自动驾驶决策方法,为城市中的自动驾驶提供安全、鲁棒(robust的音译,指异常和危险情况下系统生存的能力)的驾驶策略。

9.本发明所述方法包括以下步骤:

10.步骤1、单目视觉信息处理,训练图像处理模块,将高维的图片信息处理为一维的特征向量,构建环境感知数据集,使用噪声增强驾驶策略在无人驾驶环境中采集图像数据,通过车载单目摄像头保存图像数据,使用噪声增强的驾驶策略把随机噪声引入到专家策略中并让专家策略能够收集到一些错误驾驶所对应的图像以利于驾驶策略的训练,专家策略是基于人类驾驶经验设计的一系列包含环境模型、驾驶员模型和汽车模型在内的复杂规则集合,在收集好图像信息之后,使用这些信息进行图像处理模块的自监督训练,图像处理模块使用自监督的方法把rgb图像使用一个编码器提取为一维特征向量并使用重参数技巧将一维的特征向量重构为rgb图像,通过编码器

‑

解码器结构对环境特征进行提取,提取对于驾驶策略有用的环境信息并为驾驶策略的训练提供输入环境信息;

11.步骤2、多源传感数据融合,环境感知模块融合摄像头传感器、gnss传感器、imu传感器和速度传感器数据,共同构造环境感知信息;所述的多源数据融合包含两部分,分别为经步骤1训练好的图像处理模块和直接接收传感器低维数据的偏移计算模块,图像处理模块用于接收rgb摄像头采集的图像,得到图像感知信息,偏移计算模块用于接收路径规划器产生的航点数据,imu传感器信息、gnss传感器信息和速度传感器信息,计算自车和航点之间的偏移距离和偏移角度,自车即为受本发明所述自动驾驶决策方法控制的车辆,具体包括以下步骤:

12.步骤201、从gnss传感器得到当前自车位置(x0,y0),从路径规划器和自车位置得到距离当前自车位置最近的航点(x

w

,y

w

),从imu传感器得到当前车辆的偏航角α;

13.步骤202、将全局坐标系转换为相对坐标系,以当前自车位置为原点,根据下面的公式(1)计算航点相对位置(x

′

w

,y

′

w

):

[0014][0015]

步骤203、根据下列公式(2)计算车辆方向向量(x1,y1):

[0016][0017]

步骤204、根据下列公式(3)计算车辆偏移角度θ:

[0018][0019]

步骤205、根据车辆位置和航点位置,计算车辆偏移距离d,如以下公式(4)所示:

[0020]

[0021]

步骤206、综合上述结果,偏移计算模块得到度量向量(θ,d,v);

[0022]

步骤207、将图像处理模块得到的特征向量和上述步骤得到的度量向量结合,环境感知模块得到t时刻的环境特征向量环境z

t

;

[0023]

步骤3、多维评价指标综合,设计一个策略评估模块,对自动驾驶当前的横向控制即车辆方向的控制和纵向控制即车辆速度的控制的好坏进行实时评估,用于以下步骤5的训练,也能用于其他驾驶策略的评估,所述的策略评估模块包含自动驾驶系统横向控制的评估、纵向控制的评估和事件评估三个部分,策略评估模块的计算包括以下步骤:

[0024]

步骤301、自动驾驶系统横向控制的评估对于自动驾驶车辆的方向控制进行评估,使沿车道行驶的驾驶策略得到高的评估并使远离车道行驶的驾驶策略得到低的评估,横向评估分为对于自动驾驶车辆偏移角度的评估和对于偏移距离的评估,输入是偏移距离、道路宽度、偏移角度和最大偏移角度,输出是横向评估值;

[0025]

步骤302、自动驾驶系统纵向控制的评估对于自动驾驶车辆的速度控制进行评估,使能够沿目标速度稳定的驾驶策略得到高的评估,使错误的速度控制驾驶策略得到低的评估,具体分为前方有障碍物时车辆速度的评估和前方无障碍物时车辆速度的评估,纵向控制评估的输入是通过车载速度传感器得到的车辆速度、预设的最大速度、距离前方障碍物的距离,输出是纵向评估值;

[0026]

步骤303、自动驾驶系统的事件评估,步骤301和步骤302中的评估是一个密集的评估方法,对每一时刻的车辆驾驶策略进行评估,得到一个评估值,事件评估是通过某些特定的事件触发才有评估值,其他情况下评估值为0,将事件分为5个危险事件和1个成功事件,5个危险事件包含:碰撞动态物体(行人或者车辆)、碰撞静态物体(路边的护栏或电线杆)、车辆阻塞(长时间速度低于某个阈值)、偏离路线(车辆的偏移距离大于某个阈值)、超速(车辆速度超高某个阈值),1个成功事件为在规定时间内无碰撞驶完既定路线;

[0027]

将纵向评估值记为r

lg

,横向控制评估值记为r

la

,事件评估值记为r

et

,策略评估模块的输出如以下公式(5)所示:

[0028]

r=r

lg

r

la

r

et

……

(5),

[0029]

是自动驾驶系统纵向评估、横向评估、事件评估的线性和;策略评估模块不仅能够对城市道路中的驾驶策略进行全面的评估,还能够指导以下步骤5中的驾驶策略的训练;

[0030]

步骤4、异步驾驶信息收集,使用分布式结构,在不同环境中在线收集驾驶信息并存储在驾驶信息池中,用于步骤5中的驾驶策略的训练;异步信息收集体现在每个工作进程含有独立的自动驾驶环境,各个进程间的驾驶信息收集互相独立,同时进行,通过分布式的框架,增加相同时间内产生的驾驶信息的个数与多样性以提高驾驶策略训练的效率;

[0031]

步骤5、驾驶策略模块训练,将环境感知模块固定,使用分布式在线深度强化学习训练方法控制自动驾驶系统与自动驾驶环境进行交互,训练得到一个鲁棒的驾驶策略,驾驶策略模块包括长短期记忆人工神经网络、策略网络和状态价值预估网络,长短期记忆人工网络用于从前后多帧对应的环境特征向量中提取时序特征,策略网络用于输出驾驶策略即转向值、油门值、刹车值,其中转向值的范围是[

‑

90,90],

‑

90代表向左转90

°

,90代表向右转90

°

,油门值的范围是[0,1],0代表不踩油门,1代表油门全部踩下,刹车值的范围是[0,1],0代表不踩刹车,1代表刹车全部踩下,状态价值预估网络是对当前自动驾驶状态的好坏进行预估,驾驶策略模块根据策略评估模块给出的评估值并更新驾驶策略模块中的长短期

记忆人工神经网络、策略网络和状态价值预估网络,驾驶策略模块的更新包括以下步骤:

[0032]

步骤501、初始化工作进程,初始化路线池,路线池中含有l条路线,每个路线包括路线的起始航点和路线的完成度,路线的完成度的范围从0%到100%,初始化局部驾驶策略模块中的模型参数,清空驾驶信息池;

[0033]

步骤502、根据ε

‑

greedy的方法选择当前的路线,从[0,1]的均匀分布中随机采集一个概率值p,基于贪心的策略选择一条路线用于训练如以下公式(6)所示:

[0034][0035]

ε=0.2;

[0036]

步骤503、构建交通场景,在城镇中随机生成100辆专家策略控制的自动驾驶汽车且沿着道路正常行驶并且遵守交通规则,在路边随机生成150个行人,行人在遵守交通规则的情况下随意走动,初始化自车的位置为路线的起点;

[0037]

步骤504、在时刻t,自车通过传感器(rgb摄像头、速度传感器、imu传感器、gnss传感器)收集传感数据,放入环境感知模块中,得到环境特征向量z

t

,把环境特征z

t

放入历史特征存储器中,在历史特征存储器中得到环境特征向量序列如以下公式(7)所示:

[0038]

z

t:t

‑7=[z

t

,z

t

‑1,z

t

‑2,z

t

‑3,z

t

‑4,z

t

‑5,z

t

‑6,z

t

‑7]

……

(7),

[0039]

步骤505、将特征序列z

t:t

‑7放入长短期记忆人工神经网络,得到时序特征

[0040]

步骤506、将时序特征放入策略网络中,得到驾驶策略的分布π

t

,根据分布采样得到转向值油门值刹车值

[0041]

步骤507、自车执行驾驶策略自动驾驶环境更新;

[0042]

步骤508、根据当前自车的状态,使用策略评估模块计算策略评估值r

t

,当发生步骤303中任意一个事件,则m

t

=0,否则m

t

=1,将(z

t

,a

t

,r

t

,π

t

(a

t

),m

t

)作为一个驾驶信息样本存入驾驶信息池当的长度等于128,进入步骤509,更新驾驶策略模块;

[0043]

步骤509、得到小批量样本集合z,a,r,m,π,z

i

∈z,a

i

∈a,r

i

∈r,v

i

∈v,π

i

∈π,m

i

∈m;

[0044]

步骤510、对第i个样本,根据以下公式(8)计算策略评估的折扣累积和:

[0045][0046]

其中,代表长短时记忆神经网络的输出,v代表状态价值预估网络的输出,根据如下公式(9)计算状态价值预估网络的损失l

v

:

[0047][0048]

其中,

[0049]

步骤511、根据如下公式(10)计算策略网络损失l

π

:

[0050][0051]

其中,δ

i

为更新前后的策略差距,定义为π

i

为更新后的当前策略

网络的输出,为更新前策略网络的输出。a

i

称为优势函数,a

i

=g

i

‑

v

i

,优势函数描述了当前驾驶策略的相对好坏,a

i

>0代表当前驾驶策略下选取的动作好,a

i

<0代表当前驾驶策略下采取的动作差;

[0052]

步骤512、根据步骤510和步骤511,得到当前驾驶策略模块的总损失

[0053]

步骤513、根据使用反向梯度传播计算神经网络的梯度;

[0054]

步骤514、把梯度存入模型更新梯度池。

[0055]

本发明的有益效果如下:

[0056]

1、本发明所述方法使用自动化自监督的训练方法,自动化收集训练数据集,自监督的训练图像处理模块,无需人工标注数据集和预先采集专家驾驶数据信息,大大降低了驾驶策略训练成本,在图像处理模块的训练阶段,本发明所述方法采取的是自监督的方法,无需特殊标注。在驾驶策略模块的训练中,本发明所述方法使用预先定义好的策略评估模块指导训练,无需提前采集专家策略的驾驶信息,只需要驾驶策略和环境进行互动,利用自身采集的样本进行训练,降低了训练的成本;

[0057]

2、本发明所述方法使用的传感器融合方法将图像信息与低层传感数据向融合并为自动驾驶提供更全面丰富的环境信息,本发明所述方法使用自监督训练得到的图像处理模块对图像信息进行处理并得到一维的特征向量,将底层传感数据进行计算并得到自车的偏移距离、偏移角度、速度,构成度量向量并将特征向量与度量向量结合以完成传感数据的融合;

[0058]

3、本发明所述方法设计了一个完整的策略评估模块,包含了对于驾驶策略的横向控制和纵向控制的综合评估,本发明所述方法考虑到横向控制和纵向控制的评估,同时将短期评估与事件评估相结合,更为完整与合理。

附图说明

[0059]

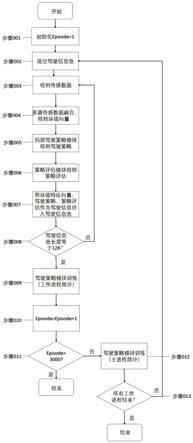

图1为本发明所述方法的整体流程图;

[0060]

图2为本发明所述方法的多源传感数据融合流程图;

[0061]

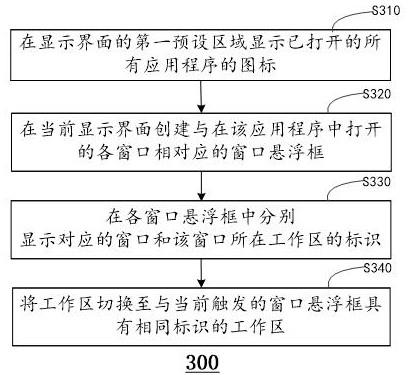

图3为本发明所述方法的多维评价指标综合流程图;

[0062]

图4为本发明所述方法的驾驶策略模块训练工作进程流程图;

[0063]

图5为本发明所述方法的驾驶策略模块训练主进程流程图。

具体实施方式

[0064]

下面结合说明书附图和具体实施例对本发明内容作进一步详细说明。

[0065]

如图1所示,本发明所述方法的分为一个主进程和四个工作进程;步骤001到步骤011为工作进程中的整体流程,各个工作进程中流程相同,因此只展示一遍;步骤012到步骤013为主进程中的整体流程;在工作进程中,首先从自动驾驶环境中使用传感器得到环境感知数据,通过单目视觉信息处理处理得到特征向量;通过偏移计算模块的计算,将特征向量与向量相结合,得到环境特征向量,完成多源传感数据融合;驾驶策略模块接收环境特征向量信息,通过神经网络的处理得到驾驶策略,在多维评价指标综合中使用策略评估模块得到策略评估;将以上环境特征向量、策略评估、驾驶策略一起作为驾驶信息存储至驾驶信息池,完成异步驾驶信息收集;待驾驶信息池中的信息数量达到阈值之后,进行驾驶策略模块

训练,下面结合说明书附图对步骤1

‑

5进行详细说明。

[0066]

步骤1中图像处理模块的作用是将三维的rgb图像提取为一维的特征向量,提取有效信息,压缩特征空间,具体训练过程如下;

[0067]

步骤101、编码器是一个将三维的rgb图像映射为一维的特征向量的神经网络,为编码器的参数,设图像中的每个像素点是x

i

,生成的一维隐变量向量z;

[0068]

步骤102、解码器p

θ

是一个将一维的特征向量映射为三维的rgb图像的神经网络,θ为解码器的参数,隐变量经过重采样后再放入解码器;

[0069]

步骤103、根据以下公式(11)计算重构过程的损失:

[0070][0071]

步骤104、训练完成后,将编码器的参数固定化,使用作为接下来的图像处理模块。

[0072]

如图2所示,环境感知向量不仅包含从图片中提取到的信息,还包含一些计算得到的度量信息,两者的结合让环境信息更加全面,本发明所述方法用到的车载传感器有rgb摄像头、imu传感器、gnss传感器和速度传感器以及一个路径规划器,产生路线中距离车辆最近的航点,本发明所述方法使用参数固定的训练好的编码器处理rgb图像,得到一个一维的特征向量,本发明所述方法使用自车位置与航点位置的距离作为偏移距离d,把自车方向和航点方向之间的角度作为偏移角度θ,把d,θ和自车速度v一起作为度量向量与之前得到的特征向量一起作为环境感知模块产生的环境特征向量作为后续驾驶策略模块的输入。

[0073]

如图3所示,步骤3中多维指标综合的具体计算方法包括以下步骤:

[0074]

步骤301、计算横向评估值r

la

如以下公式(12)所示:

[0075][0076]

其中,d为当前车辆位置距离航点的偏移距离,d

max

为当前行驶道路的宽度,θ为车辆偏移角度,θ

max

为最大偏移角度,设置为π,横向评估中,车辆驾驶位置的目标为航点,距离航点越近,评估值越高,距离航点越远,评估值越低;

[0077]

步骤302、计算纵向评估值r

lg

,纵向评估值如以下公式(13)所示:

[0078][0079]

其中,v

min

为建议的最低行驶速度,v

max

为建议的最高行驶速度,设置为9,v

tg

为目标行驶速度,当前方出现障碍物时,v

min

=0,v

tg

的值为车辆距离障碍物的距离;当前方没有障碍物时,v

min

=5,v

tg

=7;

[0080]

步骤303、计算事件评估值r

et

,当出现成功事件时,r

et

=1,当出现任意一个危险事件时,r

et

=

‑

1,当没有出现事件时,r

et

=0。

[0081]

步骤4中异步信息收集整体框架分为1个主进程和4个工作进程,主进程中包含一个全局驾驶策略模块和一个adam参数优化器,每个子进程中有一个局部驾驶策略模块和一个局部的自动驾驶环境,主进程和工作进程中的驾驶策略模块结构相同,网络具体参数可能不同,一个模型更新梯度池负责从工作进程中收集模型的梯度并将所有工作进程的模型

梯度累加后传至主进程并进行模型更新。

[0082]

如图4所示,具体说明驾驶策略模块在工作进程中的训练流程,因为空间限制,4个工作进程中仅展示工作进程1的流程,其他3个流程相同,包括以下步骤:

[0083]

步骤501、初始化工作进程,初始化路线池,路线池中含有l条路线,每个路线由两部分组成,一个是路线的起始航点,一个是路线的完成度(范围从0%到100%),初始化局部驾驶策略模块中的模型参数。清空驾驶信息池,设置episode=0;

[0084]

步骤502、根据公式(6)选择新路线;

[0085]

步骤503、构建交通场景,在城镇中随机生成100辆专家策略的自动驾驶汽车且沿着道路正常行驶并且遵守交通规则,在路边随机生成150个行人,行人在遵守交通规则的情况下随意走动,初始化自车的位置为路线的起点;

[0086]

步骤504、在时刻t,自车通过传感器(rgb摄像头、速度传感器、imu传感器、gnss传感器)收集传感数据,放入环境感知模块中,得到环境特征向量z

t

,把特征z

t

放入历史特征存储器中,在历史特征存储器中得到环境特征向量序列z

t:t

‑7=[z

t

,z

t

‑1,z

t

‑2,z

t

‑3,z

t

‑4,z

t

‑5,z

t

‑6,z

t

‑7];

[0087]

步骤505、将特征序列z

t:t

‑7放入长短期记忆人工神经网络,得到时序特征

[0088]

步骤506、将时序特征放入策略网络中,得到驾驶策略的分布π

t

,根据分布采样得到转向值油门值刹车值

[0089]

步骤507、自车执行驾驶策略自动驾驶环境更新;

[0090]

步骤508、根据当前自车的状态,使用策略评估模块计算策略评估值r

t

,当发生步骤303中任意一个事件,则m

t

=0,否则m

t

=1,把(z

t

,a

t

,r

t

,π

t

(a

t

),m

t

)作为一个驾驶信息样本存入驾驶信息池当的长度等于128,进入步骤509;否则,进入步骤518;

[0091]

步骤509、得到小批量样本集合z,a,r,m,π。z

i

∈z,a

i

∈a,r

i

∈r,π

i

∈π,m

i

∈m;

[0092]

步骤510、对第i个样本,根据公式(8)计算策略评估的折扣累积和g

i

,根据公式(9)计算状态价值预估网络的损失l

v

;

[0093]

步骤511、根据公式(10)计算策略网络损失l

π

;

[0094]

步骤512、根据步骤510和步骤511,得到当前驾驶策略模块的总损失l=l

v

l

π

,根据总损失,使用反向梯度传播计算神经网络的梯度;

[0095]

步骤513、把局部模型的梯度存储到主进程的模型更新梯度池中;

[0096]

步骤514、当接收到主进程的信号,则进入步骤515,否则等待;

[0097]

步骤515、局部驾驶策略模块从全局模型中拷贝模型中神经网络的参数;

[0098]

步骤516、episode=episode 1;

[0099]

步骤517、当episode>3000,则结束工作进程,否则进入步骤518;

[0100]

步骤518、当发生事件,即m

t

=0,则计算和更新当前路线的完成度,然后进入步骤502,重新选择训练路线;否则,进入步骤504,继续当前路线的驾驶信息数据的采集。

[0101]

下面结合图5介绍主进程的更新流程:

[0102]

步骤519、初始化主进程,初始化全局驾驶策略模块中的参数,清空模型更新梯度池;

[0103]

步骤520、检查是否所有的工作进程中的局部驾驶模块完成了梯度的计算,当完成,则进入步骤521,否则,等待1s后继续检查;

[0104]

步骤521、把模型更新梯度池中的相同模型参数的梯度对应相加,根据模型梯度,使用adam优化器更新全局模型参数;

[0105]

步骤522、清空模型更新梯度池;

[0106]

步骤523、通知所有工作进程;

[0107]

步骤524、检查是否所有工作进程均结束,当所有工作进程均结束,则结束主进程,否则,进入步骤520。

[0108]

具体的,本发明的实施例使用了一个具有高可信度的自动驾驶模拟器carla,carla针对3d的城市场景,包含静态物体的3d模型,如建筑物、草地绿植、交通标志、基础设置,动态物体如车辆、行人,累计40种不同的建筑物,16种车辆,50种行人模型,能反映真实物体的大小,在nocrash基准场景中进行测试,nocrash中包含3种交通情况,分别为dense(城镇中随机生成100辆车辆和250个行人),regular(城镇中随机生成20辆车辆和50个行人),empty(城镇中不生成其他车辆和行人),每个城镇中25条路线(每条路线拥有不同的起点和终点),6种不同的天气(4中用于训练,2种用于测试),nocrash基准场景中使用的度量指标是成功率,当一辆车无碰撞的沿路径从起点行驶到终点,则成功率为1,否则,成功率为0。最终的成功率是所有路线成功率的平均值。

[0109]

下面介绍本发明实施例在训练时的具体细节,在训练驾驶策略模块时,在城镇1中随机生成100辆车和150个行人,车只能沿着车道行驶,且遵守交通规则,人能够在道路旁随意走动,也能够穿越马路,用于训练的路线共有112条,每天条路线在100m左右,具有不同的起始点,涉及到4种驾驶命令即沿道路行驶,在路口左转,在路口右转,在路口直行;在训练中,一共有4个工作进程,每个进程的随机种子分别为1,2,3,4,adam优化器的学习率为0.0003,γ=0.99,∈=0.1。在训练路径的重新选择中,ε=0.2。

[0110]

下面详细评估一下算法最后的结果,采用以下六个基准算法进行对比:

[0111]

da

‑

rb :一种基于数据融合的驾驶策略训练方法,依据每个样本的重要程度选择重要的驾驶信息样本进行学习,同时使用一个样本池不断选择出具有高不确定性的样本进行学习。da

‑

rb 仅在dense场景下进行测试。

[0112]

fasnet:一种基于状态

‑

动作特征预测的驾驶策略训练方法,使用一个深度预测性编码网络预测自动驾驶的状态和动作,最终的驾驶策略是多任务下产生的驾驶策略的加权和。

[0113]

cil:一种基于条件的驾驶策略模仿学习训练方法,提出了4分支结构,不同的命令(沿道路行驶,路口直行,路口左转,路口右转)对应不同的策略模型,能够实现自动化的城市驾驶,此方法为基础的自动驾驶方案,其中的4分支结构被后来的自动驾驶方法广泛应用。

[0114]

cal:一种基于下游任务的驾驶策略训练方法,将驾驶策略的学习分为感知任务的学习和驾驶策略的学习,在感知任务的学习中,使用诸多下游任务辅助感知任务的学习,有利于接下来的驾驶策略的学习。

[0115]

cilrs:一种模仿学习和深度强化学习相结合的训练方法,将训练过程分为两个阶段,第一个阶段使用模仿学习,学习提前收集好的专家策略的驾驶信息,然后把感知任务模

块迁移到深度强化学习模块中,使用深度强化学习方法继续训练自动驾驶的驾驶策略。

[0116]

iarl:一种目前效果最好的基于深度强化学习的训练方法,使用离线的深度强化学习方法训练自动驾驶训练策略,重点关注城市驾驶中驾驶策略对于信号灯的反应,使用了大量的训练样本,最终得到较好的训练结果。

[0117]

lbc:一种目前效果最好的基于模仿学习的训练方法,将训练过程分为两阶段,第一个阶段是对于感知任务的学习,第二个阶段是对于驾驶策略的学习,在第一个阶段中,驾驶策略采用基于规则的驾驶策略,所以更关注感知任务的自动化学习,在第二个阶段,将感知任务模型的参数固定,学习驾驶策略。

[0118]

本发明实施例的两组仿真测试如下:

[0119]

1、nocrash基准场景:使用上述7种方法作为对比,展示在3种不同场景(dense、regular、empty)、6种不同天气(4种训练天气,两种测试天气)下的路线完成率,dense场景含有100辆车和150个行人、regular场景中含有20辆车和50个行人、empty场景中不含有车辆和行人。由于carla的版本更替,da

‑

rb 、fasnet、cil、cilrs、cal这5种基准方法只能在小于carla0.9.10的版本下进行训练和测试,iarl和lbc这两种方法既能够在小于carla0.9.10的版本下进行训练和测试,也能够在carla的最新版本0.9.10下进行训练和测试。本发明实施例展示了其在不同版本下的训练和测试结果,实验结果如表1a、表1b所示。

[0120]

2、碰撞加强场景:nocrash基准场景尽管能够对驾驶策略有一个完整的测评,但是由于生成的车辆和行人的种类和位置都是随机的且运动方向也是随机的,因此结果具有一定程度的不可复现性,本发明实施例设置了两种特殊的困难的驾驶场景,用于测试自动驾驶系统对于速度的控制,这两种场景按照障碍物的不同分为其他车辆阻塞场景和其他行人阻塞场景。

[0121]

其他车辆阻塞场景:当自车行驶至场景触发点时,自车前方10m处会出现一辆样式随机的汽车,此时,自车必须减速至停止,且等待一段时间,前方车辆消失,才能继续行驶。

[0122]

其他行人阻塞场景:当自车行驶至场景触发点时,自车前方10m处会出现一个电话亭,一个外观随机的行人从会电话亭中走出,横穿马路,并停在自车所在道路中央。此时,自车必须减速至停止,且等待一段时间,等待行人穿过马路后,再继续行驶。

[0123]

第一组实验仿真结果如表1a、表1b所示,表1a是本实施例和其他对比方法在城镇1中的测试结果,能够看到,本实施例在carla0.9.10版本中取得了最高的成功率;比如,在训练天气,交通为dense的情况下,本实施例实现了路线完成率为82%的结果,比lbc的路线完成率高23%,比iarl的路线完成率高23%,说明本实施例在极为拥堵的交通情况下仍能取得较好的驾驶策略。

[0124]

表1b是本发明实施例和其他对比方法在城镇2中的测试结果,测试路线,测试天气的结果能够很好反应各个方法在驾驶策略中的泛化能力,比如,本实施例在交通为empty的情况下,成功率到达了78%,仅比训练天气的结果(完成率为92%)低了14%,而低于carla0.9.10的版本下,在训练天气、交通为empty的情况下取得最高结果(完成度为100%)的方法lbc,在测试环境下仅取得了70%的成功率,结果降低了30%,说明方法对于不同天气的泛化效果不好,在真实场景中应用存在障碍。

[0125]

第二组仿真实验结果表2所示,carla0.9.10中共有27种车辆,每种车辆对应一条测试路线,每条路线测试3次,因此其他车辆阻塞场景需要对自动驾驶汽车一共测试81次,

carla0.9.10种共有26种行人,每种行人对应一条测试路线,每条路线测试3次,因此其他行人阻塞场景需要对自动驾驶汽车一共测试78次,从表2能够看出,相比于其他对比方法iarl和lbc,本发明实施例在两种场景中均取得了最好的结果,在其他车辆阻塞的场景中,本发明实施例取得100%的成功率,说明本发明实施例训练得到的自动驾驶系统,对于所有类型的汽车障碍物,均有良好的避让能力;在其他行人阻塞的场景中,本发明实施例取得97.4%(76/78)的成功率,说明本发明实施例训练得到的自动驾驶系统,对于大部分外观的行人,都有良好的避让能力,也就是能够等待行人过完马路之后再继续驾驶。

[0126]

表1a

[0127][0128]

表1b

[0129][0130]

表2

[0131][0132]

本发明并不限于上述实施方式,在不背离本发明实质内容的情况下,本领域技术人员可以想到的任何变形、改进、替换均落入本发明的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。