1.本发明涉及目标识别与定位的技术领域,具体涉及一种基于相机与激光雷达的目标识别与定位方法。

背景技术:

2.现有的技术中,班组伴随机器人人员跟随技术发展尚不成熟,有的只侧重于识别算法,有的只侧重于定位算法,例如基于无线通信、牵引绳及其他特殊设备的方法,主要存在以下问题:

3.1、难以有效识别与定位。对于采用特殊设备进行引导目标定位的方法,在运行过程中,仅能得到目标的位置,而无法得知当前引导目标的类别。对于依靠相机进行目标识别的算法,在位置解析上存在较大偏差,不能保证定位的精度。

4.2、安全因素。基于无线通信的方法受电磁干扰影响较大,因此实时传输目标定位的方式易丢失目标位置或解析错误,存在较大安全隐患;依靠牵引绳这类方法,由于牵引绳的限制,无法保证能有效通过所有地形路段,易造成安全事故。

5.3、便捷性不佳。依靠特殊设备对引导人员进行定位的方法,均对引导人员携带装备有较大限制,造成极大的不便,同时也对引导人员进行了较大约束,有违设计初衷。

6.现有的目标识别与定位算法在动态环境中需要长时间对目标进行运算以保证目标识别与定位成功率。

技术实现要素:

7.有鉴于此,本发明提供了一种基于相机与激光雷达的目标识别与定位方法,能够在识别目标的同时对目标进行定位,准确性高。

8.本发明采用的技术方案如下:

9.一种基于相机与激光雷达的目标识别与定位方法,方法步骤如下:

10.步骤1:通过激光雷达获取目标点云数据;

11.步骤2:对获取的点云数据进行目标聚类分割,得到原始聚类点云;

12.步骤3:通过相机获取目标的像素信息;

13.步骤4:基于深度学习算法对目标进行识别,获取目标的像素位置;

14.步骤5:通过激光雷达和相机联合标定,建立激光雷达坐标系下点云坐标点到图像像素坐标系下像点的转换关系;

15.步骤6:将所述原始聚类点云转换到图像像素坐标系下,与目标识别框中心像素坐标进行比较,得到目标聚类点云,完成目标识别与定位。

16.进一步地,步骤6中得到目标聚类点云的具体方法如下:

17.将投影转换到图像像素坐标系下且位于目标识别框内的坐标点作为目标范围点云;

18.利用欧式聚类算法将所述目标范围点云数据分割为多个聚类点云;

19.将多个聚类点云的中心点转换为图像坐标系下的像点,再依次计算所有聚类点云中心的像点与目标识别框中心像点的距离,得到距离最短的聚类点云中心像点,该聚类点云即为目标聚类点云。

20.进一步地,确定目标聚类点云之后还包括:

21.将目标聚类点云中的所有点云数据通过坐标转换求出与之对应的图像像素坐标系中的像点,再依次计算所有像点与目标识别框中心像点的距离,得到距离的最小值,该值对应的坐标点即为目标的位置。

22.进一步地,所述深度学习算法采用yolov3算法。

23.进一步地,所述目标识别与定位方法搭载在mlu100 d2芯片上。

24.有益效果:

25.1、本发明通过激光雷达和相机联合标定,建立激光雷达坐标系下点云坐标点到图像像素坐标系下像点的转换关系,在联合标定的支持下,将原始聚类点云转换到图像像素坐标系下,与目标识别框中心像素坐标进行比较,得到目标聚类点云,完成目标识别与定位,在识别目标的同时对目标进行定位;

26.本发明不依赖辅助传感器,仅通过机器人主流传感器激光雷达与相机实现识别与定位功能;其次,本发明单帧目标处理识别与定位准确率高,在连续视频拆分为单帧进行处理时就能保证目标识别与定位的准确性。

27.2、本发明求解出目标点云聚类中与目标人员所对应的点的位置,能够避免目标人员与周围物体贴近时目标人员的位置出现极大偏差,提高定位的精确性。

28.3、本发明使用yolov3算法进行目标识别,该算法在识别速度上有着较大的优势,在硬件配置较低时也能基本满足实时性的需求。

29.4、现有的目标识别技术大都基于nvidia gpu进行图像处理运算,本算法使用搭载mlu100 d2芯片实现目标识别,实现了目标识别模块国产化。

附图说明

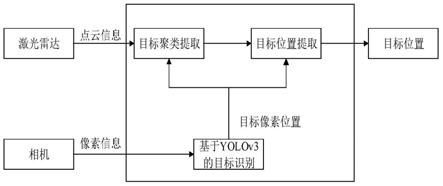

30.图1为本发明流程图。

31.图2为目标聚类点云的提取流程图。

32.图3为目标位置提取流程图。

33.图4为测试实验平台组成模块示意图。

34.图5为自主导航系统软件架构示意图。

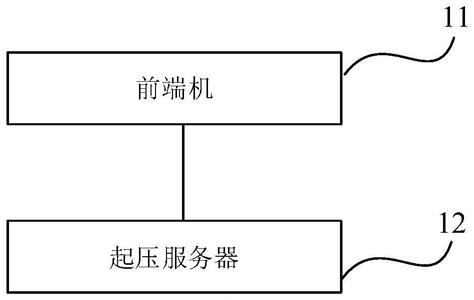

35.图6为集成方案。

36.图7为实施例整体流程示意图。

具体实施方式

37.下面结合附图并举实施例,对本发明进行详细描述。

38.本发明提供了一种基于相机与激光雷达的目标识别与定位方法,如图1所示,方法步骤如下:

39.步骤1:通过激光雷达获取目标点云数据;

40.步骤2:对获取的点云数据进行目标聚类分割,得到原始聚类点云;

41.步骤3:通过相机获取目标的像素信息;

42.步骤4:基于深度学习算法对目标进行识别,获取目标的像素位置;本实施例中深度学习算法采用yolov3算法;

43.步骤5:通过激光雷达和相机联合标定,建立激光雷达坐标系下点云坐标点到图像像素坐标系下像点的转换关系;

44.步骤6:将所述原始聚类点云转换到图像像素坐标系下,与yolov3目标识别框中心像素坐标进行比较,得到目标聚类点云,完成目标识别与定位。

45.其中,如图2所示,得到目标聚类点云的具体方法如下:

46.步骤601,提取目标范围点云:通过将原始点云数据投影到图像像素坐标系下,投影点落在目标识别框(基于yolov3的目标识别标出的目标识别框)内部的三维坐标点组成可能包含目标位置的点云,作为目标范围点云;

47.步骤602,对点云数据进行聚类分割:利用欧式聚类算法将所述目标范围点云数据分割为多个聚类点云;

48.步骤603,求解最近聚类中心得出目标聚类点云:将多个聚类点云的中心点转换为图像坐标系下的像点,再依次计算所有聚类点云中心的像点与目标识别框中心像点的距离,得到距离最短的聚类点云中心像点,该聚类点云即为目标聚类点云。

49.在实际环境中,极有可能出现目标人员与周围物体贴近的情况,如实验室中,目标人员与桌子靠在一起,实车环境中,目标人员与周围草堆、巨石太近。在这种情况下,若以目标点云聚类的中心点三维坐标表示目标人员的位置则会出现极大地偏差,因此,还需要求解出目标点云聚类中与目标人员所对应的点的位置。如图3所示,将目标聚类点云中的所有点云数据通过坐标转换求出与之对应的图像像素坐标系中的像点,再依次计算所有像点与目标识别框中心像点的距离,得到距离的最小值,该值对应的坐标点即为目标的位置。

50.如图4所示,基于地面无人机动系统的测试实验平台用于采集地面无人平台实际运行环境中的相关数据,为实验测试提供原始数据。该平台由操控单元、自主导航系统和地面机动平台组成。其中,自主导航系统承载于地面机动平台上,而操控单元则独立部署,操作人员通过操控单元与测试实验平台进行交互。操控单元由远程操控单元与近程操控单元组成。其中,远程操控单元基于加固型计算机构建,通过无线网络通信设备与测试实验平台链接;利用部署在计算机上的操控软件,实现平台状态监视、遥控操控及自主作业任务管理等功能。地面机动平台采用轮式电驱动方案,动力源采用高密度锂电池,总体布置采用分层隔舱化设计,下层布置动力电池、驱动电机及驱动控制设备;中层布置计算设备和网络设备;上层布置传感器设备和通信设备。自主导航系统是测试实验平台的核心,如图5所示,主要由环境感知设备、定位定向设备、网络设备、数据存储设备、计算设备及控制系统软件等组成。按照功能划分,主要包括环境感知、目标识别与定位、局部路径规划、路径跟踪控制、数据采集等模块组成,支撑平台自主作业。其中的目标识别与定位采用的即为本发明的方法。

51.本实验测试方案采用当前无人车的自主控制计算机与搭载国产智能加速卡的计算机相结合的方式,总体集成方案如图6所示。借助国产智能加速卡的并行运算能力(类似nvidia的cuda),使用移植的yolov3算法进行目标识别与定位,并输出目标边界框的像素坐标,然后发送到自主控制计算机。自主控制计算机的cpu负责将激光雷达采集的点云数据进

行聚类,然后结合已接收目标中心点像素信息,与点云数据进行融合获取已识别目标中心的位置,即实现目标定位。为可视化目标识别与定位算法效果,将国产自主控制计算机获取的激光雷达坐标系统下的目标中心点坐标发送到国产智能加速卡计算机,然后投影到像素坐标系并绘制深度信息于图片上并输出。无人车自主导航系统的其他模块均在自主控制计算机上运行,两台计算机采用dnet的以太网(tcp)通信方式,使用本发明提出的基于相机与激光雷达的目标识别与定位方法构建目标识别与定位模块。基于国产智能加速卡的计算机发布目标像素坐标信息(k,x,y,h,w),分别表示目标编号、识别框中心点坐标、识别框的高和宽,vlp16激光雷达模块发布三维点云信息,目标识别与定位模块订阅以上两组信息,整体流程如图7所示。结合目标的像素信息与点云信息,可以输出目标中心点在激光雷达坐标系下的三维坐标。

52.本应用实施例中,实验平台采用youbot机器人,youbot移动机器人平台由kuka公司研制,底盘为四轮移动平台。在该平台部署基于国产芯片的智能计算机、自主控制计算机、vlp

‑

16激光雷达、相机以及其他自主导航相关的传感器。其中,基于国产芯片的智能计算机配置见表1,寒武纪mlu100 d2芯片性能参数见表2。通过测试,基于yolov3的目标识别与定位方法在搭载国产智能芯片的计算机上识别速率为21帧/s,基于激光雷达的目标定位的帧率为20帧/s,因此算法工作速率由较低的决定,为20帧/s。

53.表1基于国产芯片的智能计算机配置

[0054][0055]

表2寒武纪mlu100 d2芯片性能参数

[0056][0057]

为测试算法定位准确率,本应用实施例分别进行了不同距离单目标静态测试、不同距离多目标静态测试和动态测试,不同距离单/多目标静态测试的距离设置分别为2m,3m,4m,5m,6m,动态测试将目标的活动范围限制在车前方6m范围内。通过实验得出本发明的准确率随距离的增加逐渐降低,有效检测范围为6m,静态条件下定位准确率在90%以上,在无遮挡条件下几乎不受目标数量的影响,但在机器人平台移动时,定位准确率有明显下降,受影响较大。

[0058]

由此可见,本发明与现有的目标识别和目标定位算法相比,有以下优点:

[0059]

(1)模块组成单一可靠:现有目标识别与定位算法对各类辅助传感器依赖较强,靠主流传感器很难保证识别与定位的准确性。本发明不依赖辅助传感器,仅通过机器人主流传感器激光雷达与相机实现识别与定位功能;

[0060]

(2)能在识别目标的同时对目标进行定位:现有的目标识别与目标定位算法只是针对目标识别或目标定位某一项进行处理;

[0061]

(3)识别模块国产化:现有的目标识别技术大都基于nvidia gpu进行图像处理运算,本发明使用寒武纪mlu100 d2芯片实现目标识别,实现目标识别模块国产化。

[0062]

(4)单帧目标处理识别与定位准确率高:现有的目标识别与定位算法在动态环境中需要长时间对目标进行运算以保证目标识别与定位成功率,本发明将连续视频拆分为单帧进行处理时就能保证目标识别与定位的准确性。

[0063]

综上所述,以上仅为本发明的较佳实施例而已,并非用于限定本发明的保护范围。凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。