1.本发明涉及一种深度学习模型识别领域,主要应用在深度学习模型的安全领域,具体涉及一种基于侧信道信息获取深度学习模型结构的方法及系统。

背景技术:

2.侧信道攻击是一种基于侧信道信息的攻击技术。侧信道信息意为加密设备中的除与密文直接相关的显式信息外的其他信息,如设备的功耗、电磁辐射、时间消耗等等。随着人工智能技术在军事、民用等行业的不断渗透,其安全问题与攻防技术越来越受到关注。传统的人工智能技术安全性考量仅停留在软件层面,通过对深度学习模型的输入添加扰动,即生成对抗样本使模型输出错误分类。这样的攻击通常按对模型的了解程度分为黑盒攻击与白盒攻击,前者对模型信息一无所知,而后者则确切地知道模型的架构、训练数据、以及模型权重等信息。显然,对模型了解地越多,攻击的威胁性越大,白盒攻击通常在攻击效果上要优于黑盒攻击。如果能够多了解一些模型信息,对攻击者的攻击而言将更具有优势。实际上,在模型运行时,攻击者在硬件层面上对设备的时空资源消耗进行分析可以获得部分的模型信息,被分析的这类信息统称为侧信道信息。通过侧信道信息实现对模型的破解则称为侧信道攻击。

3.基于嵌入式智能设备部署深度学习模型应用非常常见,例如图像识别、信号识别、自然语言处理等。因此,有一大部分深度学习模型会以部署在嵌入式智能设备上的方式向市场提供人工智能方面的服务。对于这一类模型,我们无法直接从嵌入式智能设备上获取它们运行的模型信息,但是能够获取其模型对设备资源的使用情况,进而通过对资源的使用来判定其正在运行的模型。就嵌入式智能设备而言,攻击者可用的侧信道信息有功率消耗,数据传输时间等侧信道信息。现有技术是利用cpu的缓存(cache)实现对深度学习模型信息的窃取。本发明通过获取嵌入式智能设备的功耗,提供一种基于侧信道信息获取深度学习模型结构的方法及系统,以比较简单的实际操作,实现对不同深度学习模型的结构获取。

4.公开号为cn111565189a的基于深度学习的侧信道分析方法,结合侧信道分析技术中的模板攻击技术,将传统分析中的数理统计技术转化为深度学习模型,并且结合功耗特性进行网络模型设计,同时结合监督训练与非监督训练。但是该方法实施起来非常复杂,这具有很大的局限性。

技术实现要素:

5.本发明要克服对部署在嵌入式智能设备上的深度学习模型在没有设备操作权限下很难获取到关于深度学习模型的任何信息的缺点,提供一种侧信道攻击方法,在不需要设备操作权限下,通过外部截取嵌入式智能设备的功率轨迹间接的获取深度学习模型信息。

6.本发明的技术构思为:本发明通过实验表明不同的深度学习模型由于结构的不

同,在嵌入式智能设备上运行时消耗的功耗也不同,可以根据功耗轨迹使用适当的机器学习算法推导出模型结构。

7.本发明实现上述发明目的所采用的技术方案如下:

8.1、一种基于侧信道信息获取深度学习模型结构的方法及系统,其特征在于,包括以下步骤:

9.s1:搭建采集嵌入式智能设备运行时的功率信息的实验平台;

10.s2:在嵌入式智能设备上分别单独运行卷积层、池化层、激活函数层和全连接层,同时实时的采集功耗信息;

11.s3:对采集的功率信息进行处理;

12.s4:基于卷积神经网络,搭建模型结构分类器,对采集到的数据进行训练;

13.s5:使用生成的深度学习模型结构分类器对模型进行分析,以混淆矩阵的方式呈现测试结果。

14.进一步的,所述步骤s1具体包括:

15.从嵌入式智能设备的电源端引出两根导线,然后用数字示波器采集功率信息,目的是为了获取模型在设备上运行时的功率信息。

16.进一步的,所述步骤s2具体包括:

17.s2.1:深度神经网络包括卷积层conv、池化层pl、激活函数层ac和全连接层fc,它们的功耗定义如下:

[0018][0019][0020]

p

ac

(c,l,w)=p

ac

αclw (3)

[0021]

p

fc

(x,y)=p

m

xy p

a

xy (4)

[0022]

其中p

conv

为卷积层功耗、p

pl

为池化层功耗、p

ac

为激活函数层功耗、p

fc

为全连接层功耗;p

m

为乘法功耗系数、p

a

为加法功耗系数、p

c

为比较功耗系数、p

ac

[0023]

为激活函数功耗系数;c、w、l分别为输入的长宽高,f为卷积核的大小,s为滤波步长,n为滤波器个数,x为第一个全连层的神经元个数,y是输出神经元的个数;

[0024]

s2.2:在嵌入式智能设备上分别单独运行不同维度的卷积层,分别运行最大池化和平均池化,分别运行不同的激活函数和全连接层,是为了满足不同的深度学习模型可能使用不同维度卷积层、池化层、激活函数层和全连接层,不同的层在嵌入式智能设备上运行时消耗的功耗也不同,可以根据功耗轨迹使用适当的机器学习算法识别模型结构。

[0025]

进一步的,所述步骤s3具体包括:

[0026]

用限幅平均滤波法对采集的数据进行数据清洗,是为了把无效的数据点去掉,有利于后面的模型生成,对清洗后的数据进行阈值分割,对分割的每一段数据取均值、中值、方差,然后给每一段数据打上对应的标签,这就生成了训练模型结构分类器的训练集。

[0027]

进一步的,所述步骤s4具体包括:

[0028]

卷积神经网络包括四个卷积层,使用5

×

5、3

×

3和1

×

1卷积核尽力压缩模型参数

量,并在每次池化操作后将特征通道数翻倍,以尽量保持特征的完整性,使用relu非线性激活函数,减少训练中神经元死亡的概率和过拟合,softmax激活函数使神经网络的输出变为了概率分布,使分类更加的精确。

[0029]

实现权利要求1所述的一种基于侧信道信息获取深度学习模型结构方法的系统,包括:数据采集模块、数据处理模块、模型结构分类器生成模块、模型结构分类器测试模块;

[0030]

所述数据采集模块在嵌入式智能设备上分别运行不同维度的卷积层,分别运行最大池化和平均池化,分别运行不同的激活函数和全连接层,同时采集设备运行时的各种功耗数据;

[0031]

所述数据处理模块用限幅平均滤波法对采集的数据进行数据清洗,然后对清洗后的数据进行阈值分割,对分割的每一段数据取均值、中值、方差;

[0032]

所述模型结构分类器生成模块利用采集的数据训练生成模型结构分类器,具体包括:搭建模型结构分类器包括四个卷积层,卷积核为5

×

5、3

×

3和1

×

1,并在每个卷积层后面加上最大池化层,两个全连接层,在第一个全连接层后面使用relu激活函数,在第二个全连接层后面使用softmax激活函数,然后把处理后的数据输入给模型结构分类器,让模型结构分类器进行学习;

[0033]

所述模型结构分类器测试模块利用生成的深度学习模型结构分类器对深度学习模型进行分析,以混淆矩阵的方式呈现测试结果;

[0034]

所述的数据采集模块、数据处理模块、模型结构分类器生成模块和模型结构分类器测试模块依次连接。

[0035]

本发明的有益效果为:

[0036]

(1).合理利用嵌入式智能设备,价格便宜部署简单,采集数据方便,易于分析;

[0037]

(2).本发明表明深度学习模型在运行时,嵌入式智能设备的功耗与其内在模型结构存在相关性,通过对这种相关性的分析,可以推导出模型的结构;

[0038]

(3).本发明让我们更好地了解在模型运行情况下侧信道泄漏的漏洞,以便能更好的保护用户的权利和数据;

[0039]

(4).本发明不需要访问训练数据,并且允许通过向网络馈送已知的随机输入来进行模型获取。

[0040]

本发明的优点在于:本发明可以在不需要设备操作权限下,通过外部截取嵌入式智能设备的功率轨迹间接的获取深度学习模型信息,以根据功耗轨迹使用适当的卷积神经网络识别出模型的具体结构。

附图说明

[0041]

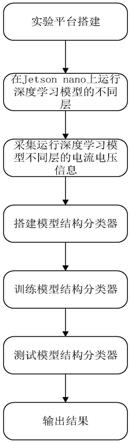

图1是本发明方法的流程图;

[0042]

图2是本发明所用的实验平台连接图;

[0043]

图3是本发明的卷积层采集数据曲线;

[0044]

图4是池化层采集数据曲线;

[0045]

图5是激活函数层采集数据曲线;

[0046]

图6是全连接层采集数据曲线;

[0047]

图7是本发明的模型结构分类器测试结果图;

[0048]

图8是本发明的系统结构示意图。

具体实施方式

[0049]

下面结合说明书附图对本发明的具体实施方式作进一步详细描述。

[0050]

参照图1~图8,一种基于侧信道信息获取深度学习模型结构的方法及系统,包括以下步骤:

[0051]

s1:搭建采集嵌入式智能设备运行时的功率信息的实验平台如图2,具体包括:

[0052]

嵌入式智能设备选择英伟达的jetson

‑

nano,价格便宜性能优越,同时带有gpu,可以运行大多数的深度学习模型,功率信息采集设备选择数字示波器,数字示波器采集频率非常的高,可以完整的采集到模型运行时的功率信息,连接如图2。

[0053]

s2:在嵌入式智能设备上分别单独运行卷积层、池化层、激活函数层和全连接层,同时实时地采集设备的功耗信息,具体包括:

[0054]

s2.1:在jetson nano上使用pytorch深度学习框架分别运行卷积层、池化层、激活函数层和全连接层,同时实时地采集设备运行每一层的功耗信息,如图3、4、5、6,其中卷积层conv、池化层pl、激活函数层ac和全连接层fc,它们的功耗定义如下:

[0055][0056][0057]

p

ac

(c,l,w)=p

ac

αclw

ꢀꢀ

(3)

[0058]

p

fc

(x,y)=p

m

xy p

a

xy

ꢀꢀ

(4)

[0059]

其中p

conv

为卷积层功耗、p

pl

为池化层功耗、p

ac

为激活函数层功耗、p

fc

为全连接层功耗;p

m

为乘法功耗系数、p

a

为加法功耗系数、p

c

为比较功耗系数、p

ac

为激活函数功耗系数;c、w、l分别为输入的长宽高,f为卷积核的大小,s为滤波步长,n为滤波器个数,x为第一个全连层的神经元个数,y是输出神经元的个数;

[0060]

s2.2:深度学习模型不同的层在嵌入式智能设备上运行时消耗的功耗也不同,可以根据功耗轨迹使用适当的机器学习算法识别模型结构。

[0061]

s3:对采集的功率信息进行处理,具体包括:

[0062]

用限幅平均滤波法对采集的数据进行数据清洗,是为了把无效的数据点去掉,有利于后面的模型生成,对清洗后的数据进行阈值分割,对分割的每一段数据取均值、中值、方差,这样就统一了数据的输入大小,然后给每一段数据打上对应的标签,这就生成了训练模型结构分类器的训练集。

[0063]

s4:基于卷积神经网络,搭建模型结构分类器,对采集到的数据进行训练,具体包括:

[0064]

卷积神经网络包括四个卷积层,使用5

×

5和3

×

3卷积核尽力压缩模型参数量,并在每次池化操作后将特征通道数翻倍,以尽量保持特征的完整性,使用relu非线性激活函数,减少训练中神经元死亡的概率和过拟合,softmax激活函数使神经网络的输出变为了概率分布,使分类更加的精确。

[0065]

s5:使用生成的深度学习模型结构分类器对模型进行分析,以混淆矩阵的方式呈现测试结果,如图7,具体包括:

[0066]

在jetson

‑

nano上运行一个完整的深度学习模型,同时我们用示波器采集功率信息,然后经过数据处理变成测试集,输入给模型结构分类器,模型分类器会输出一个混淆矩阵,显示出模型包含几个层。

[0067]

实现本发明的一种基于测信道信息的深度神经网络黑盒对抗样本生成方法的系统,如图8包括:数据采集模块、数据处理模块、模型结构分类器生成模块、模型结构分类器测试模块;

[0068]

所述数据采集模块,在嵌入式智能设备上分别运行不同维度的卷积层,分别运行最大池化和平均池化,分别运行不同的激活函数和全连接层,同时采集设备运行时的各种功耗数据,具体包括:

[0069]

s2.1:在jetson nano上使用pytorch深度学习框架分别运行卷积层、池化层、激活函数层和全连接层,同时实时地采集设备运行每一层的功耗信息,如图3、4、5、6,其中卷积层conv、池化层pl、激活函数层ac和全连接层fc,它们的功耗定义如下:

[0070][0071][0072]

p

ac

(c,l,w)=p

ac

αclw

ꢀꢀ

(3)

[0073]

p

fc

(x,y)=p

m

xy p

a

xy

ꢀꢀ

(4)

[0074]

其中p

conv

为卷积层功耗、p

pl

为池化层功耗、p

ac

为激活函数层功耗、p

fc

为全连接层功耗;p

m

为乘法功耗系数、p

a

为加法功耗系数、p

c

为比较功耗系数、p

ac

为激活函数功耗系数;c、w、l分别为输入的长宽高,f为卷积核的大小,s为滤波步长,n为滤波器个数,x为第一个全连层的神经元个数,y是输出神经元的个数;

[0075]

s2.2:深度学习模型不同的层在嵌入式智能设备上运行时消耗的功耗也不同,可以根据功耗轨迹使用适当的机器学习算法识别模型结构。

[0076]

所述数据处理模块,用限幅平均滤波法对采集的数据进行数据清洗,然后对清洗后的数据进行阈值分割,对分割的每一段数据取均值、中值、方差,具体包括:

[0077]

用限幅平均滤波法对采集的数据进行数据清洗,是为了把无效的数据点去掉,有利于后面的模型生成,对清洗后的数据进行阈值分割,对分割的每一段数据取均值、中值、方差,这样就统一了数据的输入大小,然后给每一段数据打上对应的标签,这就生成了训练模型结构分类器的训练集。

[0078]

所述模型结构分类器生成模块利用采集的数据训练生成模型结构分类器,具体包括:

[0079]

搭建模型结构分类器包括四个卷积层,卷积核为5

×

5、3

×

3和1

×

1,并在每个卷积层后面加上最大池化层,两个全连接层,在第一个全连接层后面使用relu激活函数,在第二个全连接层后面使用softmax激活函数,然后把处理后的数据输入给模型结构分类器,让模型结构分类器进行学习;

[0080]

所述模型结构分类器测试模块具体包括:

[0081]

利用生成的深度学习模型结构分类器对深度学习模型进行分析,以混淆矩阵的方式呈现测试结果;

[0082]

所述的数据采集模块、数据处理模块、模型结构分类器生成模块和模型结构分类器测试模块依次连接。

[0083]

本说明书实施例所述的内容仅仅是对发明构思的实现形式的列举,本发明的保护范围不应当被视为仅限于实施例所陈述的具体形式,本发明的保护范围也及于本领域技术人员根据本发明构思所能够想到的等同技术手段。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。