1.本发明属于自动驾驶策略生成技术领域。

背景技术:

2.决策是自动驾驶整体技术谱系中的关键一环。一般情况下,自动驾驶的技术模块组成按照顺序包括:感知

→

全局路径规划

→

决策

→

局部运动规划

→

车辆控制5个环节,其中决策直接决定了后续运动规划和车辆控制的安全性和效率,是自动驾驶承上启下的关键技术环节。

3.当前自动驾驶决策模块多是采用基于规则的方法来构建,也就是尽可能枚举每一种自动车辆可能遇到的驾驶情景,然后,预先设置好每一种驾驶情境下自动车辆需要执行的决策行为。这种做法存在诸多的弊端:(1)自动驾驶,尤其是开放道路下的自动驾驶,常常面对的交通场景具有高度的动态性、复杂性和不确定性,这使得定义一个相对“完备”的“状态

‑

决策”规则集十分困难,甚至是不可能的;(2)基于规则的决策方法过于“僵硬”,遇到事先没有定义好的情况,自动驾驶车将不知道如何做出决策,有可能造成安全事故或者“停机”状态。

4.因此,为了克服基于规则的自动驾驶决策带来的问题,另外一种常见的做法是基于学习的方式来构建决策模块,例如较为前沿、常用的是强化学习(尤其是深度强化学习)。基于学习的自动驾驶决策,通过自动驾驶车辆与环境的大量互动,不断的收集“驾驶经验”,从而提高自身的决策制定水平,无需人为事先制定规则集,此外,基于学习的方法,对于训练过程中没有碰到的驾驶情景,天然的具有很好的泛化能力。因此,基于强化学习的自动驾驶决策被认为是一种极具潜力的研究方法。但同时,其也存在一个极其严重的潜在问题,那就是基于学习的自动驾驶决策,无法整合考虑自动驾驶情况下的安全性和平稳性。

技术实现要素:

5.本发明目的是为了解决现有基于学习的自动驾驶决策存在安全性和平稳性差的问题,提出了一种基于对抗生成模仿学习的自动驾驶控制方法。

6.本发明所述一种基于对抗生成模仿学习的自动驾驶控制方法,该方法包括:

7.步骤s1、采集目标自动驾驶车辆同向所有车道内的动态、静态目标的位置、速度以及自身的位置、航向角和速度信息;

8.步骤s2、利用地图、车道线、交通标志标线和步骤s1获取的信息,获取目标自动驾驶车辆所在环境的状态地图;

9.步骤s3、将步骤s2所述状态地图、目标自动驾驶车辆及周边车辆实时状态输入至决策器,决策器采用经对抗生成的训练方式训练的深度神经网络,获取目标自动驾驶车辆的决策行为信号;

10.步骤s4、利用步骤s2所述状态地图和目标自动驾驶车辆的决策行为信号,采用bezier曲线作驾驶路径规划,获得规划路径;

11.步骤s5、在规划路径上进行等时间间隔抽样,获取采样点,并采用曲线拟合算法,获取每两个采样点间路径的速度和加速度;

12.步骤s6、利用每两个采样点间路径的速度和加速度,采用pid控制方法,获得目标自动驾驶车辆的动作控制信号。

13.进一步地,本发明中,步骤s3中,决策器还包括判别器,所述判别器用于在决策器的深度神经网络进行训练;

14.所述训练的步骤为:将不同环境的状态地图下决策器生成的操作指令与相应环境下驾驶专家的实际操作控制信号共同输入至判别器,判别器将判别结果发送至决策器,决策器利用所述判别结果,采用对抗生成的训练方式对所述深度神经网络进行训练,直至决策器生成的策略与驾驶专家的实际操作控制信号相同,或相同概率达到99%,停止对决策器进行训练。

15.进一步地,本发明中,步骤s1中,采用视觉传感器、激光雷达、毫米波雷达、gps和惯性观测单元多源传感器融合获取目标自动驾驶车辆周边的动态、静态目标的位置、速度以及自身的位置、航向角和速度信息。

16.进一步地,本发明中,决策器采用经对抗生成的训练方式训练的深度神经网络,获取目标自动驾驶车辆的决策行为信号的方法为:

17.经对抗生成的训练方式训练的深度神经网络分为深度卷积神经网络和深度全连接神经网络;

18.将状态地图输入至深度卷积神经网络,输出状态地图的高阶表征向量;

19.将目标自动驾驶车辆的周边车辆实时状态输入至深度全连接神经网络,输出自动驾驶车辆自身及周边车辆实时状态的高阶表征向量;

20.将对所述状态地图的高阶表征向量与自动驾驶车辆自身及周边车辆实时状态的高阶表征向量进行拼接,获得目标自动驾驶车辆的决策行为信号。

21.进一步地,本发明中,步骤s3中,决策行为信号包括:横向决策信号、纵向决策信号和速度决策信号。

22.进一步地,本发明中,横向决策信号包括:向左变道、保持当前车道和向右变道信号;

23.纵向决策信号为固定时间段内自动驾驶车辆沿路径行进的距离;

24.速度决策信号包括:最低速度、最高速度和最低速度与最高速度之间等间隔抽取的四个速度值,其中,最低速度为0,最高速度根据当前道路环境下道路等级的限速确定。

25.进一步地,本发明中,步骤s4中,采用bezier曲线做驾驶路径规划的方法为:

26.利用公式一计算获得:

27.b(t)=(1

‑

t)3p

s

3(1

‑

t)2tp1 3(1

‑

t)2t2p2 t3p

g

,t∈[0,δt]

ꢀꢀ

公式一

[0028]

其中,b(t)是规划的路径,p

s

,p

g

分别表示起始和目标点;p1,p2为中间控制点,δt为规划时间。

[0029]

进一步地,本发明中,步骤s5中,获取路径每段的速度和加速度的方法为:

[0030]

采用两个采样点间路径依次拟合每个样本点的速度,所述两个采样点间路径表示:

[0031]

s

k

=a

k

b

k

t c

k

t2 d

k

t3 e

k

t4,t∈[0,(δt)]

ꢀꢀ

公式二

[0032]

其中,s

k

为第k个样条曲线位移;所述第k个样条曲线为第i

‑

1个采样点和第i个采样点间路径曲线,a

k

、b

k

、c

k

、d

k

、e

k

分别表示第k个样条曲线的多项式系数;

[0033]

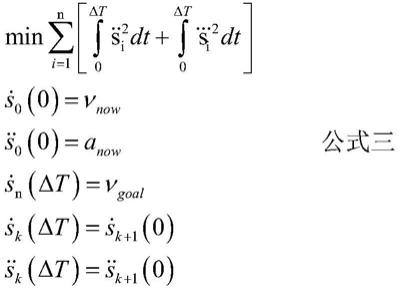

以加速度和颠簸程度最小,且保持车道曲线的连续性为目标,对速度进行规划,具体为:

[0034][0035]

其中,i为第i个采样点,n表示采样点总个数,v

now

表示自动驾驶车辆初始时刻的速度;v

goal

表示自动驾驶车辆处初始时刻的目标期望速度;a

now

表示自动驾驶车辆初始时刻的加速度;为表示r时刻,第i采样点处位移的一阶导数;为表示r时刻,第i个采样点处位移的二阶导数,为表示t时刻,第i个采样点处位移的三阶导数,为目标自动驾驶车辆该次控制初始位置时的位移的一阶导数,为目标自动驾驶车辆该次控制初始位置时的位移的二阶导数,为目标自动驾驶车辆到达第n个采样点处位移的一阶导数;表示第k个样条曲线的末端时刻的一阶导数,表示第k 1个样条曲线的初始时刻的一阶导数,表示第k个样条曲线的末端时刻的二阶导数,表示第k 1个样条曲线的初始时刻的二阶导数。

[0036]

进一步地,本发明中,步骤s6中,获得目标自动驾驶车辆的动作控制信号的方法为:

[0037]

通过公式四计算获得:

[0038][0039]

其中,u(t)表示目标自动驾驶车辆的动作控制信号,k

p

,k

i

,k

d

分别表示比例、积分和导数项的系数;e(t)是误差函数,t

i

为自动驾驶车辆行驶至采样点i处对应的时刻,t

i

‑1为自动驾驶车辆行驶至采样点i

‑

1处对应的时刻,δt表示第自动驾驶车辆行驶在两个采样点之间的时间。

[0040]

进一步地,本发明中,步骤s3中,对抗生成的训练方式的训练函数为:

[0041][0042]

其中,π为决策器神经网络,πθ(a|s)表示在特定环境特征s下,决策器采取策略a的概率,θ表示决策器神经网络的待学习参数的集合,ψ表示判别器神经网络的待学习参数集合;s表示目标自动驾驶车辆面对的环境特征,a表示目标自动驾驶车辆的决策动作;s

e

,a

e

分别代表驾驶专家对应的特定环境特征和决策动作;e表示求取数学期望;d

e

表示驾驶专家操作指令的示范数据集合,d

ψ

是判别器的判决函数。

[0043]

本发明通过人类驾驶专家的演示数据,利用深度神经网络自动学习人类驾驶专家的决策行为,并且能够很好的泛化到不同的交通情景下自动驾驶任务;保留了基于学习方法的良好泛化特性,同时由于整合了局部轨迹规划和车辆控制传统模块,又能够保证自动驾驶的安全性和平稳性。同时采用对抗生成模仿学习方式,显著优于行为克隆、监督学习等学习方式,无需标注难以界定的驾驶员决策行为,而是直接从客观可观测的车辆控制行为数据中自动学习到决策行为。

附图说明

[0044]

图1是本发明所述方法流程示意图;

[0045]

图2是采用本发明所述方法进行路径规划示意图。

具体实施方式

[0046]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有作出创造性劳动的前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0047]

需要说明的是,在不冲突的情况下,本发明中的实施例及实施例中的特征可以相互组合。

[0048]

具体实施方式一:下面结合图1和图2说明本实施方式,本实施方式所述一种基于对抗生成模仿学习的自动驾驶控制方法,该方法包括:

[0049]

步骤s1、采集目标自动驾驶车辆同向所有车道内的动态、静态目标的位置、速度以及自身的位置、航向角和速度信息;

[0050]

步骤s2、利用地图、车道线、交通标志标线和步骤s1获取的信息,获取目标自动驾驶车辆所在环境的状态地图;

[0051]

步骤s3、将步骤s2所述状态地图、目标自动驾驶车辆及周边车辆实时状态输入至决策器,决策器采用经对抗生成的训练方式训练的深度神经网络,获取目标自动驾驶车辆的决策行为信号;

[0052]

步骤s4、利用步骤s2所述状态地图和目标自动驾驶车辆的决策行为信号,采用bezier曲线作驾驶路径规划,获得规划路径;

[0053]

步骤s5、在规划路径上进行等时间间隔抽样,获取采样点,并采用曲线拟合算法,获取每两个采样点间路径的速度和加速度;

[0054]

步骤s6、利用每两个采样点间路径的速度和加速度,采用pid控制方法,获得目标自动驾驶车辆的动作控制信号。

[0055]

本发明提出了一种基于模仿学习的自动驾驶决策模块构建方法,其核心是:通过人类专家的驾驶示范收集各种驾驶场景下的车辆控制动作行为,包括油门、制动和方向盘的控制;在此基础上,基于模仿学习的理论,建立一种从底层车辆控制数据中学习人类专家决策逻辑的智能模块,并最终将该智能模块泛化到各种复杂的交通情景中,从而实现安全、高效的自动驾驶决策。该方法即无需事先制定“情景

‑

决策”规则集,同时又能够最大限度的保证自动驾驶的安全性和平稳性,克服了单纯基于规则和基于强化学习两种方式的缺点,

具备容易泛化、更安全、更平稳的特点。

[0056]

进一步地,本实施方式中,步骤s3中,决策器还包括判别器,所述判别器用于在决策器的深度神经网络进行训练;

[0057]

所述训练的步骤为:将不同环境的状态地图下决策器生成的操作指令与相应环境下驾驶专家的实际操作控制信号共同输入至判别器,判别器将判别结果发送至决策器,决策器利用所述判别结果,采用对抗生成的训练方式对所述深度神经网络进行训练,直至决策器生成的策略与驾驶专家的实际操作控制信号相同,或相同概率达到99%,停止对决策器进行训练。

[0058]

进一步地,本实施方式中,步骤s1中,采用视觉传感器、激光雷达、毫米波雷达、gps和惯性观测单元多源传感器融合获取目标自动驾驶车辆周边的动态、静态目标的位置、速度以及自身的位置、航向角和速度信息。

[0059]

本实施方式中采用状态感知模块获取自动驾驶车辆决策所需要的一切必要信息,包括预置的高精度地图、路径导航、车道线、交通标志标线、自动驾驶车辆周边动态及静态目标的位置、速度以及自动驾驶车辆自身的位置、航向角、速度等信息。这一模块可以通过视觉传感器、lidar、毫米波雷达、gps、imu等多源传感器融合的方式来实现。感知模块输出的状态地图如图2所示。这里以超车的情况为例,黑色车辆为自动驾驶车辆,其余颜色车辆为周边社会车辆。该感知地图同时整合了自动驾驶车辆和周边相关车辆的位置、速度等信息,它们将被一起输出到决策器深度神经网络中,用于自动驾驶的决策制定。

[0060]

进一步地,本实施方式中,步骤s3中,决策器采用经对抗生成的训练方式训练的深度神经网络,获取目标自动驾驶车辆的决策行为信号的方法为:

[0061]

经对抗生成的训练方式训练的深度神经网络分为深度卷积神经网络和深度全连接神经网络;

[0062]

将状态地图输入至深度卷积神经网络,输出状态地图的高阶表征向量;

[0063]

将目标自动驾驶车辆的周边车辆实时状态输入至深度全连接神经网络,输出自动驾驶车辆自身及周边车辆实时状态的高阶表征向量;

[0064]

将对所述状态地图的高阶表征向量与自动驾驶车辆自身及周边车辆实时状态的高阶表征向量进行拼接,获得目标自动驾驶车辆的决策行为信号。

[0065]

本实施方式中,采用决策器获取决策行为信号,决策器的架构采用了3部分组成,一部分为以状态地图为输入的深度卷积神经网络,另一部分为以目标自动驾驶车辆和周边车辆实时状态为输入的深度全连接神经网络,将这2部分的输出拼接起来,共同输入到另外一个小型的全连接神经网络,最终输出自动驾驶的决策行为。

[0066]

进一步地,本实施方式中,步骤s3中,决策行为信号包括:横向决策信号、纵向决策信号和速度决策信号。

[0067]

进一步地,本实施方式中,横向决策信号包括:向左变道、保持当前车道和向右变道信号;

[0068]

纵向决策信号为固定时间段内自动驾驶车辆沿路径行进的距离;

[0069]

速度决策信号包括:最低速度、最高速度和最低速度与最高速度之间等间隔抽取的四个速度值,其中,最低速度为0,最高速度根据当前道路环境下道路等级的限速确定。

[0070]

本实施方式中,自动驾驶的决策分为3个部分,分别是:(1)横向决策,包括向左变

道、保持当前车道和向右变道;(2)纵向决策,包括4个不同的类别,每个类别描述了一定时间内自动驾驶车辆沿着路径行进的距离;(3)速度决策,最低速度和最高速度被均匀划分为4个连续段,每个段对应一个速度决策备选值。

[0071]

进一步地,本实施方式中,步骤s4中,采用bezier曲线做驾驶路径规划的方法为:

[0072]

利用公式一计算获得:

[0073]

b(t)=(1

‑

t)3p

s

3(1

‑

t)2tp1 3(1

‑

t)2t2p2 t3p

g

,t∈[0,δt]

ꢀꢀ

公式一

[0074]

其中,p

s

,p

g

分别表示起始和目标点;p1,p2为中间控制点,δt为规划时间。

[0075]

进一步地,本实施方式中,步骤s5中,获取路径每段的速度和加速度的方法为:

[0076]

采用两个采样点间路径依次拟合每个样本点的速度,所述两个采样点间路径表示:

[0077]

s

k

=a

k

b

k

t c

k

t2 d

k

t3 e

k

t4,t∈[0,(δt)]

ꢀꢀ

公式二

[0078]

其中,s

k

为第k个样条曲线位移;所述第k个样条曲线为第i

‑

1个采样点和第i个采样点间路径曲线,a

k

、b

k

、c

k

、d

k

、e

k

均表示第k个样条曲线的多项式系数;

[0079]

以加速度和颠簸程度最小为目标,且保持车道曲线的连续性的前提下,对速度进行规划,具体为:

[0080][0081]

通过公式三获得样条曲线段内及断点和初始时刻的速度和加速度信号,其中,i为第i个采样点,n表示采样点总个数,v

now

表示自动驾驶车辆初始时刻的速度;v

goal

表示自动驾驶车辆处初始时刻的目标期望速度;a

now

表示自动驾驶车辆初始时刻的加速度;为表示t时刻,第i采样点处位移的一阶导数;为表示t时刻,第i个采样点处位移的二阶导数,为表示t时刻,第i个采样点处位移的三阶导数,为目标自动驾驶车辆该次控制初始位置时的位移的一阶导数,为目标自动驾驶车辆该次控制初始位置时的位移的二阶导数,为目标自动驾驶车辆到达第n个采样点处位移的一阶导数;表示第k个样条曲线的末端时刻的一阶导数,表示第k 1个样条曲线的初始时刻的一阶导数,表示第k个样条曲线的末端时刻的二阶导数,表示第k 1个样条曲线的初始时刻的二阶导数。

[0082]

进一步地,本实施方式中,获得目标自动驾驶车辆的动作控制信号的方法为:

[0083]

通过公式四计算获得:

[0084]

[0085]

其中,u(t)表示目标自动驾驶车辆的动作控制信号,k

p

,k

i

,k

d

分别表示比例、积分和导数项的系数;e(t)是误差函数,t

i

为自动驾驶车辆行驶至采样点i处对应的时刻,t

i

‑1为自动驾驶车辆行驶至采样点i

‑

1处对应的时刻,δt表示第自动驾驶车辆行驶在两个采样点之间的时间。

[0086]

进一步地,本实施方式中,步骤s3中,对抗生成的训练方式的训练函数为:

[0087][0088]

其中,π为决策器神经网络,π

θ

(a|s)表示在特定环境特征s下,决策器采取策略a的概率,θ表示决策器神经网络的待学习参数的集合,ψ表示判别器神经网络的待学习参数集合;s表示目标自动驾驶车辆面对的环境特征,a表示目标自动驾驶车辆的决策动作;s

e

,a

e

分别代表驾驶专家对应的特定环境特征和决策动作;e表示求取数学期望;d

e

表示驾驶专家操作指令的示范数据集合,d

ψ

是判别器的判决函数;

[0089][0090]

分别表示当前目标自动驾驶车辆的面对环境特征的集合和目标自动驾驶车辆的决策动作的集合。

[0091]

其中,奖励函数用于决策器的反馈调整信号(即决策器依据判别器给出的判别评分,改进自身的策略),特定状态和行为对s,a下,决策器所获得的奖励与判别器的评分输出的对数成正比(评分越高,奖励越大,评分越低,奖励越小)

[0092][0093]

依据奖励函数,决策器神经网络采用策略梯度下降的方式最小化下面的目标函数,从而调整自身的参数集合θ,达到训练的目的,目标函数公式如下:

[0094][0095]

其中,e表示求取数学期望;τ为任意决策轨迹(也就是自动驾驶车辆与环境互动的状态动作对序列),τ

t

为第τ个决策序列轨迹的决策阶段数;s

t

,a

t

为第t(t∈[0,τ

t

])个决策阶段所处的状态和所采取的策略,为奖励函数。

[0096]

该方法的整体工作流程如图1所示。自动驾驶车辆搭载各种类型的传感器,行驶于各种类型的交通情境中,通过预置的状态感知模块,能够获得自动驾驶车辆决策制定所需要的状态地图。基于深度神经网络的决策器以状态地图为输入,以相应的决策制定为输出,进一步该输出又传递给下游的局部规划模块和车辆控制模块,最终转换为控制车辆的动作。本发明的核心是构建决策器的深度神经网络模型。决策器的训练采用了对抗生成的方式。决策器负责生成控制车辆的决策,连带下游的局部规划和控制模块,最终产生车辆控制动作,另外人类驾驶专家根据决策器同样的输入情景,生成人类专家的“标准动作”,二者共同作为判别器的输入,最终通过这种对抗生成的方式,使得决策器不断的模仿人类专家的决策行为,最为实现可泛化、平稳、安全的决策器。

[0097]

虽然在本文中参照了特定的实施方式来描述本发明,但是应该理解的是,这些实施例仅仅是本发明的原理和应用的示例。因此应该理解的是,可以对示例性的实施例进行许多修改,并且可以设计出其他的布置,只要不偏离所附权利要求所限定的本发明的精神和范围。应该理解的是,可以通过不同于原始权利要求所描述的方式来结合不同的从属权

利要求和本文中所述的特征。还可以理解的是,结合单独实施例所描述的特征可以使用在其他所述实施例中。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。