1.本发明涉及训练机器可学习函数的计算机实现的方法,以及对应的系统。本发明还涉及包括指令和/或函数参数的计算机可读介质。

背景技术:

2.机器可学习函数具有比手动设计的算法更准确得多地执行任务的潜力。例如,机器可学习函数(例如基于卷积神经网络或类似技术)已示出能够针对诸如识别数位、在猫和狗之间进行区分等各种图像分类任务实现良好的准确度。典型地,这样的机器可学习函数在训练数据集(例如,包括用它们期望的分类标记的图像)上被训练。一般地,训练示例越多,经训练的函数的所得准确度就越好。

3.在许多实际情形中,获得覆盖足够广泛的输入的训练数据的可行性是阻碍机器学习解决方案的实际采用的主要障碍。例如,在(半)自主车辆领域中,机器可学习函数具有实行对于控制或监视车辆所需的各种任务的潜力,例如,车辆环境的相机图像的图像分析,从而例如对危险的交通情形进行警告。然而,获得用于这样的任务的训练数据需要在车辆周围的驾驶;这是昂贵的,并且甚至可能是危险的。此外,车辆环境的图像可以以许多不同的方式变化,例如在场景的总体配置方面(前面是否有另一汽车,附近是否有行人等)而且还在许多其他方面(例如,汽车在其上行驶的道路类型;交通标志看起来的样子,这因国家而异;天气条件;等等)变化。

4.这使得几乎不可能获得覆盖车辆可能遇到的所有可能情形组合、特别是在极端情况下的训练数据集。另一方面,尤其是当用于做自动化驾驶决策时,机器可学习函数可靠地处理尤其是这样的极端情况是至关重要的。因此,合期望的是,使用具有高度泛化能力的、例如对训练数据集中没有直接覆盖的输入也提供准确结果的函数。

5.一种已知的有助于泛化能力的机器学习技术是所谓的群等变卷积网络,例如,如t. cohen等人的“group equivariant convolutional networks”(通过引用并入本文,并且可在https://arxiv.org/abs/1602.07576处获得)中所描述的。群等变卷积网络是深度神经网络,即,通过经由多个相应的参数化层传递输入来处理输入(在该情况下是图像)的函数。在群等变卷积网络中,这些相应层处的表示被建模为线性g空间,其中g是表示可以应用的变换集合的预定义的数学群(即,具有满足闭包、关联性、恒等式和可逆性的二进制运算的集合)。等变性意味着,给定层输入上的变换t

g

和层输出上的t

g

',其中g∈g,恒等式成立。例如,旋转或镜像输入应当导致输出的对应旋转。给予神经网络层的该附加结构允许更高效地对数据进行建模,并改进泛化能力,这本质上是因为关于期望的函数输出的知识可以在输入和它们的变换变量之间共享。

6.不幸的是,使函数等变的现有技术有若干缺点。需要变换群g的复杂分析公式,并且附加地,这些变换必须提前已知并硬编码到模型架构中。此外,当使用该函数时,使用变换群,使得模型架构取决于训练中使用的变换类型,并且从而与用于应用机器学习技术的标准工具(例如卷积神经网络的标准实现)不兼容。变换还需要符合变换群g的群公理。因

此,仅能指定受限的(几何类型)变换集合。

技术实现要素:

7.将合期望的是,训练机器可学习函数,例如图像分类器或图像特征提取器,使得改进泛化能力,但是不需要将变换集成到模型架构中。特别地,将合期望的是,奖励不根据数学群结构表现的输入观察变化的可预测性。还将合期望的是,在不影响机器可学习函数的模型架构的情况下改进它们的泛化能力,例如,使得经训练的函数是标准的卷积神经网络等。

8.根据本发明的一个方面,提供了用于训练机器可学习函数的计算机实现的方法和对应的系统,分别如权利要求1和14所定义的。根据本发明的一个方面,描述了一种计算机可读介质,如权利要求15所定义的。

9.各个方面涉及通过优化目标函数来训练机器可学习函数(换言之,学习参数化机器可学习函数的参数集合)。许多类型的机器可学习函数和适用于训练它们的目标函数是已知的。例如,学习任务可以是分类或回归。训练可以例如基于训练输入观察和对应训练输出的标记数据集来监督,目标函数被配置为最小化机器可学习函数的函数输出与对应训练输出之间的差异。训练也可以是无监督的,例如,特征提取器的学习(特征提取也称为表示学习)。在任一种情况下,可以使用常规的目标函数。

10.令人感兴趣的是,为了改进泛化能力,机器可学习函数可以因在机器可学习函数的一层处对输入观察之间的差异集合可预测地响应而被奖励。这类似于群等变卷积神经网络,其强制:将给定的g

‑

动作应用于输入观察导致将对应的g

‑

动作应用于层的输出。然而,令人感兴趣的是,发明人设想到不是通过将特定的变换集合硬编码到模型架构中,而是通过在用于训练机器可学习函数的目标函数中包括正则化目标来奖励可预测性。例如,可预测性程度降低的正则化目标可以包括在要最小化的损失函数中,或者可预测性程度增加的正则化目标可以包括在要最大化的目标函数中。

11.特别地,目标函数可以基于第一和第二输入观察对,以及指示这些第一和第二观察之间差异的差异标记。例如,第一和第二观察可以是大体对应场景的图像,例如,两者都可以是其中车辆正因交通灯而停止的车辆环境。差异标记可以挑出第一和第二观察之间的特定差异,例如在以下方面的差异:天气条件;车辆前方的车辆类型;其中获得图像的国家(以及相应的,目前的交通灯和/或交通标志的类型);等等。优选地,选择观察对,使得除了由差异标记指示的差异之外,它们尽可能地彼此对应。

12.特别地,差异标记可以表示变换,根据所述变换,可以从第一观察获得(至少近似地获得)第二观察。因此,交换第一和第二观察典型地也导致另一个差异标记。然而,令人感兴趣的是,从中选择差异标记的差异集合不需要具有任何特定的数学结构,特别地,它不需要是数学意义上的群。

13.为了评估用于鼓励某一层处的可预测性的正则化目标,可以将机器可学习函数应用于第一和第二观察,以获得该层处的相应表示。正则化目标然后可以通过鼓励在给定这些表示的差异标记的情况下在这些表示之间的互统计相关性来奖励可预测性。换言之,给定差异标记,一个表示提供的关于另一个表示的信息量可以由目标函数最大化。这样的互统计相关性可以例如依据条件互信息或交互信息来计算,如下面更详细讨论的。

14.通过在给定差异标记的情况下鼓励表示的互统计相关性,获得正则化器,所述正则化器改进经训练函数的泛化能力和鲁棒性。也就是说,函数被有效地奖励来学习一对输入观察之间的差异如何影响函数输出。因此,如果相同的差异也适用于未看见的观察,则该函数能够更好地处理该差异。

15.在所实现的结果方面,这类似于由群等变卷积网络所提供的改进的泛化能力,并且实际上,本发明人能够示出,当依据条件互信息来表述时,群等变卷积网络为正则化目标提供了最优效果。然而,令人感兴趣的是,所提供的技术提供比群等变卷积网络更大得多的灵活性,从而导致了若干实际优势。

16.通过使用基于互统计相关性的差异,获得适用于广泛的差异集合的度量,例如不需要假设特定的数学群结构。这允许捕获实际情形中出现的各种类型的差异,例如,天气条件的差异、观察发生的国家的差异等。也不需要明确定义差异是如何将一个输入变换成另一个输入的:具有输入观察对和伴随的差异标记就足够了,并且甚至可以从数据中学习差异标记。对于该对也不需要完全不同并且仅需要根据差异类型而不同,例如,观察之间可能存在其他差异(尽管如果有更紧密的对应关系,则训练更有效)。对于对其应用正则化目标的表示,根本不需要给定任何变换作为输入,并且因此,函数本身可以学习表示输入的最优方式。

17.此外,在目标函数中的包含允许针对其他训练目标平衡可预测性。实际上,互统计相关性可以被视为不可预测性和可预测性之间的连续统一体。因为正则化项典型地针对目标函数的其他项进行加权,所以函数本身可以自动达到对于当下学习任务适当的统计相关性量,而不是无论如何都被迫严格地强制等变性。这也改进了函数对其中过于严格地强制等变性将会降低性能的情形的适用性。

18.通过适配目标函数(例如,代替于模型架构)鼓励可预测性的另一优点在于,可以获得经训练的函数,其架构不取决于训练期间考虑的差异类型,例如用于应用经训练的函数的硬件/软件不需要取决于或支持提供这样的差异的各种变换。因此,与用于应用机器学习函数的常规软件/硬件的兼容性、例如卷积神经网络评估软件/硬件被改进。

19.关于对其应用正则化目标的层,若干种选择是可能的。无论机器可学习函数的类型如何,目标都可以应用在输出层处。如果机器可学习函数以其他方式不遵循分层结构,这也适用,例如,也适用于非神经网络。如果机器可学习函数是特征提取器、例如图像特征提取器,则输出层是特别好的选择,这是因为在该情况下,然后由正则化目标提供的可预测性可以被使用它的其他组件完全使用。对于具有内部层的机器可学习函数、诸如神经网络和深度高斯过程,可能的是替代地或附加地将正则化目标应用于函数的内部层,或者将相应的正则化目标应用于多个相应的内部层。始终讨论用于机器可学习函数和/或要正则化的层的有益选择。

20.可选地,机器可学习函数可以是图像分类器或图像特征提取器。这样的图像处理模型特别地不得不处理输入变化的问题,并且因此尤其受益于具有改进的泛化能力。一般地,图像分类器可以将输入图像映射到一个或多个分类输出。例如,图像分类器可以是检测模型,例如,提供分类输出的函数,该分类输出指示对象是否存在于整个图像中或图像片段中。图像分类器也可以是语义分割模型,例如提供多个分类输出的函数,所述分类输出指示图像的各个像素或片段中对象的存在。图像特征提取器可以将输入图像映射到图像特征向

量,例如用于在分类或其他下游应用中使用。通过使用所描述的训练技术,可以获得更有效和鲁棒的图像处理模型。

21.可选地,机器可学习函数可以是在整体图像分类器中使用的图像特征提取器。在该情况下,可能的是在未标记的训练数据集上训练图像特征(即,训练不使用任何可获得的分类标记),并且然后在标记训练数据集上训练整体图像分类器。标记数据集例如可以是对于其而言标记可获得的未标记训练数据集的子集,或者可以是单独的数据集。典型地,未标记数据比标记数据更容易获得。通过将特征提取器的训练与分类器的训练分离,没有标记的数据可以用于训练特征提取器。当单独训练特征提取器时,学习可泛化的特征尤其重要,并且因此,所提供的正则化目标是有益的。在本示例中,正则化目标典型地应用于特征提取器的输出层。当训练分类器时,也可以微调特征提取器(其可以或可以不包括使用正则化目标),但是这不是必需的。

22.可选地,目标函数可以包括机器可学习函数的多个相应层的多个相应正则化目标。函数(诸如神经网络)的不同层倾向于在不同的抽象层次处表示输入观察。通过在若干层处应用正则化目标,可以因此在若干抽象层次处奖励泛化能力。例如,在训练期间,在每一层,正则化目标可以从目标函数中被包括和移除,以查看它在该层处是否具有有益的效果。

23.可选地,第一和第二输入观察是表示相同类型场景的图像,例如包括相似对象或多个对象的相似配置的场景。例如,两个图像可以表示车辆的环境,例如,以供用在(半)自主车辆的视觉模型中。例如,一对中的两个图像可以表示如下场景:其中车辆正在高速公路上巡航,其中它正因交通灯而停止,其中行人正意外地穿过道路;等等。然而,其中需要对变换区域的鲁棒性的其他应用领域也是可能的。

24.在这样的情况下,差异标记可以指示场景中的对象或场景本身的属性的差异(例如,汽车品牌;汽车类型;汽车应当靠左还是靠右;或者其中捕获图像的国家,这可以被视为若干场景属性的代理)。差异标记还可以指示场景的观察条件的差异,例如以下方面的差异:天气条件;由图像捕获的对象的遮挡水平;图像中对象的位置或取向;等等。通过包括关于这样的语义上有意义的差异的正则化目标,可以奖励函数对这些差异及差异对函数输出的影响进行推理,从而结果得到关于这些差异更好地泛化的函数。

25.可选地,机器可学习函数可以是卷积网络。卷积网络——也称为卷积神经网络(cnn)——已被证明对各种学习任务有效,特别是图像分析。它们相应的层典型地表示相应抽象层次处的输入观察。通过选择cnn的内部层,可以在正则化目标中适当地考虑输入观察之间的各种差异。

26.可选地,评估正则化目标可以包括在给定差异标记的情况下估计第一和第二表示之间的互信息。该所谓的条件互信息提供了一种确定输入观察表示之间的互统计相关性的合适的、信息理论驱动的方式。然而,也可以估计关于这三个变量的其他互信息,诸如第一表示和给定第二表示的差异标记之间的互信息,或者第二表示和给定第一表示的差异标记之间的互信息。例如,正则化目标可以包括也如下所述的交互信息,该交互信息可以基于这些互信息。代替于使用基于互信息的度量,互统计相关性的其他度量、例如在给定第一表示和差异标记的情况下第二观察的条件熵或者信息变化也是可能的。

27.使用(条件)互信息特别有益的一个原因是因为它可以根据可训练的互信息估计

模型来高效地估计。尽管直接计算(条件)或估计互信息或相关量(诸如条件熵)也是可能的,但使用可训练的估计模型大幅改进了性能。令人感兴趣的是,例如,通过在目标函数中包括互信息估计模型的学习目标,已知的互信息估计模型可以与机器可学习函数同时训练。这样,用于估计互信息的函数可以随着机器可学习函数的训练的进行而逐步更新,而不是每次机器可学习函数改变时都不得不从头开始学习。

28.可选地,正则化目标还可以被配置为抑制第一和第二表示之间不以差异标记为条件的互相关性,其例如由第一和第二表示之间的互信息(不以差异标记为条件)所测量。这样,可以抑制函数为两个输入观察提供相同的表示,换言之,可以抑制函数确定不仅是等变的而且甚至是不变的表示。这样的不变表示很可能是正则化目标的局部最优。然而,不变性可能不利于函数的泛化能力,因为它有效地奖励函数丢弃关于标记差异的信息,而不是学习如何以非平凡的方式响应它。在网络结构函数中,这可能是由于变换信息更深地传播和有序结构化到网络中,不变网络可能丢弃所述变换信息。因此,尤其是在几乎没有用于极端情况的训练数据的情况下,通过这样惩罚不变性可以实现更好的泛化能力。

29.具体地,正则化目标可以包括以差异标记为条件的互信息和不以差异标记为条件的互信息之间的差异。该差异也称为第一表示、第二表示和差异标记之间的交互信息。注意到,也可以在不明确计算上面提及互信息的情况下计算交互信息;然而,将领会,无论交互信息是以哪种方式计算的,它一般既奖励给定差异标记的第一和第二表示之间的互统计相关性,又抑制不以差异标记为条件的表示之间的互相关性。

30.为获得输入观察对和对应的差异标记,设想到若干选项。第一输入观察典型地来自训练数据集。可选地,给定差异标记,可以从第一输入观察和差异标记生成第二输入观察。例如,可以应用根据差异标记的变换,例如,图像中的对象可能被部分遮挡;可以模拟天气条件的差异,例如,通过添加雪或雨;等等。给定观察对,使用机器可学习的标记函数来确定差异标记也是可能的。例如,一些观察对的标记可以用来训练用于标记其他对的标记函数,从而减少所需的标记努力;或者标记函数甚至可以以无监督的方式训练,使得根本不需要手动指定标记。

31.本文描述的技术可以应用于各种类型的输入观察。这包括图像,但也包括各种其他类型的传感器数据,包括雷达数据、超声数据、激光雷达数据、运动数据等。例如,在计算机控制系统的上下文中,传感器数据可以提供对计算机控制系统和/或其环境的观察。在这样的情况下,可以基于机器可学习函数的输出来监视和/或控制计算机控制系统。计算机控制系统的示例包括机器人,(半或完全)自主车辆、家用电器、电动工具、制造机器、个人助理和访问控制系统。例如,可以监视的系统包括监控系统和医疗(成像)系统。

32.本领域技术人员将领会,本发明的上面提及的实施例、实现和/或可选方面中的两个或更多个可以以被认为有用的任何方式组合。

33.在本描述的基础上,本领域技术人员可以对任何系统和/或任何计算机可读介质实行修改和变化,所述修改和变化对应于对应计算机实现的方法的所描述的修改和变化。

附图说明

34.本发明的这些和其他方面将根据以下描述中作为举例描述的实施例以及附图而清楚,并参考实施例和附图被进一步阐明,附图中:

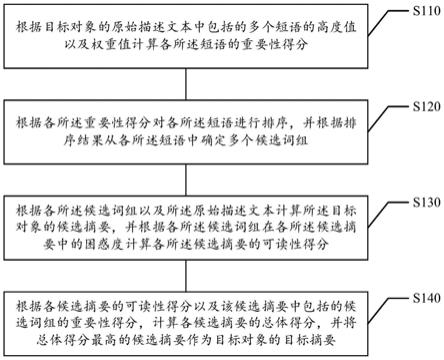

图1示出了用于训练机器可学习函数的系统;图2示出了用于应用机器可学习函数的系统;图3示出了用于将机器可学习函数作为(半)自主车辆一部分应用的系统;图4示出了机器可学习卷积网络的详细示例;图5a示出了使用正则化目标训练机器可学习函数的详细示例;图5b示出了生成用于在训练机器可学习函数中使用的第二输入观察的详细示例;图5c示出了训练机器可学习函数的详细示例,该机器可学习函数是用于在整体图像分类器中使用的图像特征提取器;图6示出了训练机器可学习函数的计算机实现的方法;图7示出了包括数据的计算机可读介质。

35.应当注意的是,各图纯粹是图解性的,并且没有按比例绘制。在各图中,对应于已经描述的元素的元素可以具有相同的参考标号。

具体实施方式

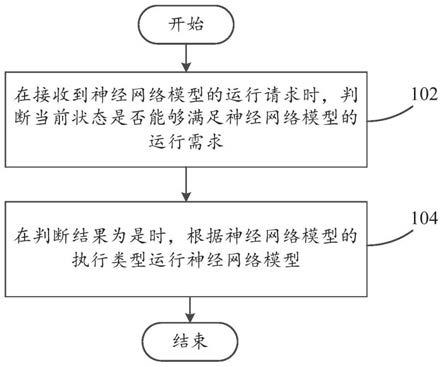

36.图1示出了用于训练机器可学习函数的系统100。机器可学习函数可以将输入观察映射到函数输出。机器可学习函数可以包括一个或多个内部层和/或输出层。该函数可以被训练为由应用机器可学习函数的系统(例如,图2的系统200)使用,特别是使得能够基于机器可学习函数的输出来监视和/或控制计算机控制系统。

37.系统100可以包括数据接口120。数据接口120可以用于访问包括多个训练输入观察的训练数据集030。数据接口120还可以用于访问正被训练的机器可学习函数的参数040的集合。一旦被学习,参数040可以用于将机器可学习函数应用于观察,也如关于图2所讨论的。例如,也如图1中所图示的,数据接口可以由数据存储接口120构成,数据存储接口120可以经由数据通信122从数据存储装置021访问数据030、040。例如,数据存储接口120可以是存储器接口或持久存储接口(例如,硬盘或ssd接口),但也可以是个人、局域或广域网接口(诸如蓝牙、zigbee或 wi

‑

fi接口或以太网或光纤接口)。数据存储装置021可以是系统100的内部数据存储装置,诸如硬盘驱动器或ssd,但也可以是外部数据存储装置,例如,网络可访问的数据存储装置。在一些实施例中,数据030、040可以各自例如经由数据存储接口120的不同子系统从不同的数据存储装置进行访问。每个子系统可以具有如上针对数据存储接口120所描述的类型。

38.系统100还可以包括处理器子系统140,处理器子系统140可以被配置为在系统100的操作期间,通过优化目标函数来学习机器可学习函数的参数集合。优化可以包括因在机器可学习函数的一层(例如,内部层或输出层)处对输入观察之间的差异集合可预测地响应而奖励机器可学习函数。优化可以借助于包括在目标函数中的正则化目标来奖励所述可预测性。

39.为了执行优化,处理器子系统140可以获得:来自训练数据集的第一输入观察;对应的第二输入观察;和来自差异集合的差异标记,其指示第一和第二输入观察之间的差异。处理器子系统140还可以应用机器可学习函数,以在机器可学习函数的该层处分别确定第一和第二输入观察的第一和第二表示。处理器子系统140还可以评估正则化目标。正则化目标可以被配置为在给定第一和第二输入观察之间的差异标记的情况下,奖励第一和第二表

示之间的互统计相关性。系统100可以经由输出接口输出学习的参数集合,例如通过经由数据接口120更新存储装置021中的参数集合,通过经由通信接口向第三方提供参数集合,等等。

40.图2示出了用于应用如本文所述那样例如通过图1的系统100或者根据图6的计算机实现的方法600训练的机器可学习函数的系统200。例如,系统200可以是车辆控制系统、机器人控制系统、制造控制系统或建筑控制系统。系统200还可以可选地执行训练,例如,系统200可以与系统100相组合。

41.系统200可以包括数据接口220,该数据接口220用于访问经训练的机器可学习函数的参数040的集合。相同的考虑和实现选项适用于图1的数据接口120。图中所示的是数据接口220,其经由数据通信222从存储装置022访问参数040,类似于图1的存储装置021和数据通信122。

42.系统200还可以包括处理器子系统240,该处理器子系统240可以被配置为在系统200的操作期间,将由参数040参数化的机器可学习函数应用于计算机控制系统和/或其环境的观察。基于机器可学习函数的输出,可以以常规方式监视和/或控制计算机控制系统。相同的考虑和实现选项适用于图1的处理器子系统140。

43.图2还示出了系统200的各种可选组件。例如,在一些实施例中,系统200可以包括用于直接访问传感器数据224的传感器接口260,传感器数据224提供计算机控制系统和/或其环境的观察。例如,传感器数据224可以由传感器072在环境082中获取。传感器可以布置在环境082中,但是也可以远离环境082布置,例如如果可以远程测量(一个或多个)量的话。传感器072可以但不需要是系统200的一部分。传感器072可以具有任何合适的形式,诸如图像传感器、激光雷达传感器、雷达传感器、压力传感器、容器温度传感器等。传感器接口260可以具有在类型上对应于传感器类型的任何合适的形式,包括但不限于低级通信接口(例如,基于i2c或spi数据通信),或如针对数据接口220所述类型的数据存储接口。

44.在一些实施例中,系统200可以包括致动器接口280,用于向环境082中的致动器092提供控制数据226。这样的控制数据226可以由处理器子系统240生成,以基于机器可学习函数的输出来控制致动器。致动器可以但不必是系统200的一部分。例如,致动器可以是电气、液压、气动、热、磁和/或机械致动器。具体但非限制性的示例包括电动机、电活性聚合物、液压缸、压电致动器、气动致动器、伺服机构、螺线管、步进电动机等。这样的类型的控制参考图3针对(半)自动车辆进行描述。

45.在其他实施例中(图2中未示出),系统200可以包括到呈现设备的输出接口(诸如显示器、光源、扬声器、振动电动机等),该输出接口可以用于生成感觉可感知输出信号,该输出信号可以基于函数输出生成。感觉可感知输出信号可以直接指示函数输出,但是也可以表示导出的感觉可感知输出信号,例如,以供在计算机控制系统的引导、导航或其他类型的控制中使用。

46.一般而言,本说明书中描述的每个系统——包括但不限于图1的系统100和图2的系统200——可以体现为诸如工作站或服务器之类的单个设备或装置,或者体现在其中。该设备可以是嵌入式设备。该设备或装置可以包括执行适当软件的一个或多个微处理器。例如,相应系统的处理器子系统可以由单个中央处理单元(cpu)来体现,但是也可以由这样的cpu和/或其他类型的处理单元的组合或系统来体现。软件可能已经被下载和/或存储在对

应的存储器、例如易失性存储器(诸如ram)或非易失性存储器(诸如闪存)中。替代地,相应系统的处理器子系统可以以可编程逻辑的形式在设备或装置中实现,例如作为现场可编程门阵列(fpga)。一般而言,相应系统的每个功能单元可以以电路的形式实现。相应的系统也可以以分布式方式实现,例如,涉及不同的设备或装置,诸如分布式本地或基于云的服务器。在一些实施例中,系统200可以是车辆、机器人或类似的计算机控制系统的部分,和/或可以表示被配置为控制这样的系统的控制系统。

47.图3示出了上述的示例,其中系统200被示为在环境50中操作的(半)自主车辆62的控制系统。自主车辆62可以是自主的,因为它可以包括自主驾驶系统或驾驶辅助系统,其中后者也被称为半自主系统。在该示例中,系统200使用的输入观察可以是车辆环境的图像。训练中使用的差异标记可以指示例如天气条件的差异,和/或环境中对象的遮挡水平和/或位置和/或取向的差异。

48.自主车辆62可以例如并入系统200,以基于从集成到车辆62中的视频相机22获得的传感器数据来控制自主车辆的转向和制动。例如,系统200可以控制电动机42执行(再生)制动,假如预期自主车辆62与交通参与者碰撞的话。系统200可以控制转向和/或制动以避免与交通参与者碰撞。为此目的,系统200可以从相机22获得车辆62周围的交通情形的图像,并根据交通情形是否安全对其进行分类。如果交通情形被认为是不安全的,则系统200可以采取对应的动作。由于不安全交通情形的图像典型地难以获得,所以在学习识别它们时,泛化能力特别重要。

49.各种实施例涉及使用正则化目标来因在函数的某一层处对输入观察之间的差异集合可预测地响应而奖励机器可学习函数。特别地,该正则化目标可以包括在给定该层处的输入观察之间的差异标记的情况下,评估所述输入观察的表示之间的互信息,和/或评估表示和差异标记之间的交互信息。用于正则化目标的这些选择现在从数学的观点来看——特别是参考cohen等人在“group equivariant convolutional networks”中所描述的等变性的概念——是合理的。

50.如cohen参考文献中所述,对于从一个空间映射到另一个空间的映射,,群中的群元素g,以及群动作,如果映射和变换互换,即:,则映射可以被称为是

‑

等变的,或者相对于群g的动作等变。特别地,如果空间中的变换的动作是恒等式变换,则映射可以被称为是

‑

不变的,即:。因此,等变映射是对其输入的已知差异可预测地响应的映射的示例,特别是在输入通过应用输入的已知变换而彼此相关的情况下。

51.然而,令人感兴趣的是,发明人设想到例如依据随机变量之间的关系从统计学上定义这样的可预测性。这样,获得了更一般的定义,该定义不太严格,并且不需要根据群结构进行变换。可预测性的该基于统计的定义可以称为“信息等变性”。该定义可以如下驱动。

52.使用与等变性相似的符号,由空间中的随机变量x标示到机器可学习函数的输入观察。令随机变量标示第二输入观察,并且令随机变量g标示x和之间的差异。例如,在等变性设置中,g可以是从采样的群元素,并且可以是,即,变换的输入观察,其通过空间中的群动作被定义为g和的确定性组合。注意到,如果g独立于x,那么来自的样

本可以被视为来自的另一个i.i.d.样本。给定随机或确定性映射,根据该映射的第一和第二输入观察的表示可以分别标示为和。这里,z是随机变量;例如,如果是确定性的,则它的条件分布是处的点质量。通过使用该符号,映射如何响应输入观察之间的差异的可预测性可以依据以z和g为条件的的熵来定义:熵越小,可预测性越高。特别地,可以在数学上示出,针对群的

‑

等变性意味着最小条件熵。

53.通过使用已知的恒等式,条件互熵可以分解为,其假设g独立于x和z,并且因而与它们不共享互信息。因此,代替于最小化条件熵,可能的是取而代之,在给定差异标记g的情况下最大化第一和第二表示z,之间的条件互信息。这使得例如能够使用互信息估计模型,如别处所述。注意到,在确定性的情况下,z(和)的熵可以由x的熵定上限,并且因此,这样的最大化也可以明确地最大化z和两者的熵,因为只有当它们个体的熵最大化时,它们的互信息才最大化。

54.此外,可以注意到,潜在的退化最优是对由g指示的差异不变的映射(例如,)。尽管熵的最大化可以防止该解成为全局最优,但是仍然存在该解作为局部最优被获得的可能性,尤其是当使用互信息估计模型估计互信息时。同样,因为不变性是解决各种区别性学习任务所要求的全部,因此该局部最优的出现是可以预期的。然而,该局部最优在泛化能力方面是不合期望的。

55.为了抑制经训练的机器可学习函数中的不变性,并且因此进一步改进泛化能力,可以在正则化目标中包括附加项,该附加项抑制第一和第二表示之间不以差异标记为条件的互相关性。特别地,和z之间的互信息(不以g为条件)可以被最小化。例如,可以使用以下正则化目标:。

56.令人感兴趣的是,该正则化目标对应于变量、和g之间的交互信息的已知统计度量。该度量基本上表示三者中共同包含的信息量,该信息量不包含在两者的子集中。通过使用该交互信息,可以在没有不变解的情况下获得信息等变映射,并且z和可以被奖励为独立的。

57.图4示出了机器可学习函数mlf 040的详细但非限制性的示例,在该情况下是卷积网络。这样的卷积网络也被称为卷积神经网络(cnn)。卷积网络是一种特殊类型的神经网络。神经网络也称为人工神经网络。神经网络典型地包括多个后续的节点层。神经网络的参数典型地包括神经网络节点的权重。例如,网络的层数量可以是至少5或至少10,并且节点和/或权重的数量可以是至少1000或至少10000。

58.广义地说,卷积网络是其中至少一层是卷积层的神经网络,如下面所讨论的。各种卷积网络架构是已知的,包括所谓的全卷积网络,其中网络的每一层都是卷积层。例如,该架构通常用于图像分类中的语义分割任务。另一种已知的架构是图中所示的架构,其中cnn包括两个组件:卷积部分,包括至少一个卷积层;以及密集(例如,全连接)部分,包括至少一个密集层。例如,该架构通常用于图像分类中的检测任务。

59.为了说明起见,现在描述可以如何使用这样的cnn来获得输入观察io 210的函数输出fo 230。对cnn的输入典型地在空间上例如表示为定大小为的体积(volume),其中维度d=1例如用于灰度图像,并且维度d=3通常用于彩色图像。已知的是还将其他类型的数据(例如,音频数据)表示为这样的体积。

60.如图中所示,输入观察io可以被输入到机器可学习函数mlf,更具体地,输入到多个过滤器(或者在一些情况下,单个过滤器)的第一层cl1 212

‑

1。每个过滤器可以在输入观察io之上进行卷积,一起产生激活体积或“潜在表示”。激活体积的每个“切片”可以是所述多个过滤器之一的输出。潜在表示可以具有与输入观察io的大小相比不同的大小(例如,空间分辨率)。潜在表示然后可以用作到后续层cl2 212

‑

2的输入。cl2的(一个或多个)过滤器然后可以在由第一层cl1输出的潜在表示之上进行卷积,以产生第二潜在表示。该过程可以针对另外的层212继续。贯穿cnn的该卷积部分,潜在表示与输入观察的空间关系典型地被保留,尽管潜在表示的空间维度可能因潜在表示而异,以及因输入观察的空间维度而异。

61.在cnn的卷积部分的最后一层clk 212

‑

k(通常称为最后一个卷积层,尽管在一些实施例中,卷积部分的最后一层clk可能不一定是卷积层,只要它保留如上面所讨论的空间关系即可)之后,所得的潜在表示lrk 222在该示例中被输入到密集层中的第一层dl1 214

‑

1。密集层214可以是全连接层,其中每个全连接层的神经元连接到另一层中的所有神经元。在穿过cnn的密集部分之后,可以输出函数输出fo,例如分类分数或分类分数集合。

62.图5a示出了使用正则化目标训练机器可学习函数的详细但非限制性的示例。

63.示出的是机器可学习函数mlf 520。机器可学习函数mlf可以将输入观察映射到函数输出。一般地,机器可学习函数mlf可以是确定性函数(例如,常规的神经网络),但是该函数也可以是随机的(例如,贝叶斯神经网络)。

64.例如,输入观察可以是图像或表示为图像的其他类型的传感器数据,或者以不同方式表示的传感器数据。例如,输入观察可以包括某个物理量的(直接或间接)测量的时间序列,或者多个这样的时间序列。下面针对图像解释了各种特征,但是所述特征也适用于其他类型的传感器数据。

65.函数输出可以具有各种类型。例如,函数输出可以包括指示图像或图像的一个或多个片段是否属于一个或多个给定类的图像分类输出。机器可学习函数mlf可以是图像分类器,例如检测模型或语义分割模型。对于检测模型,输出可以包括一个或多个分类分数。对于语义分割模型,输出可以包括与输入相似定尺寸的分类输出,该分类输出表示针对输入图像的相应片段的存在信息。机器可学习函数mlf还可以例如是图像特征提取器,在该情况下,函数输出可以是提取特征的向量。

66.机器可学习函数mlf的函数输出在本文被称为机器可学习函数的“输出层”,并且函数输出被称为输出层处的输入观察的表示。例如,输出层处的输入观察的表示可以包括至少10个、至少100个或至少1000个特征。输入观察可以包括至少100个、至少1000个或至少1000个特征。在一些实施例中,例如,在对象检测模型中,输出表示比输入观察具有更少的特征;但是,例如在语义分割模型的情况下,输出表示的特征数量和/或空间维度也可以与输入观察的特征数量和/或空间维度相同。

67.除了输出层,机器可学习函数mlf可能具有一个或多个内部层。也就是说,评估机

器可学习函数mlf可以包括依次评估一个或多个层,先前层的输出被用作到下一层的输入。具有层的机器可学习函数包括神经网络(特别是深度神经网络)和深度高斯过程。例如,机器可学习函数mlf可以是卷积网络(例如如参考图4所描述的),特别是全卷积网络。然而,对于机器可学习函数mlf而言不需要具有分层结构;例如,机器可学习函数可以是支持向量机等。

68.机器可学习函数mlf可以通过参数集合(图中未示出)来参数化,该参数集合可以在训练机器可学习函数时被学习。例如,参数可以包括神经网络权重等。例如,参数的数量可以是至少1000或至少10000。

69.在优化操作opt 570中,可以通过优化目标函数来学习参数。对于例如分类、回归、特征提取、自动编码等相应学习任务而言适当的各种目标函数是已知的,并且可以在这里使用。可以使用常规的训练技术,包括迭代优化目标函数。例如,可以使用诸如随机梯度下降的随机优化技术,例如,使用如kingma和ba的“adam: a method for stochastic optimization”(可在https://arxiv.org/abs/1412.6980处获得,并且通过引用并入本文)中公开的adam优化器。如已知的,这样的优化方法可以是启发式的和/或达到局部最优。训练可以在逐个实例的基础上或在(例如,最多或至少64个或最多或至少256个实例)批次中执行。

70.该图图示了基于多个输入观察和对应训练输出的训练数据集的有监督学习。在该情况下,通过优化opt评估的目标函数典型地包括要基于机器可学习函数的函数输出和对应的训练输出之间的差异最小化的训练损失(有时称为重构损失)。图中示出的是输入观察io1 511,其被输入到机器可学习函数以得到对应的函数输出fo1 531’。对于输入观察,优化opt可以将函数输出fo1与训练输出to1 531进行比较,并基于该比较来调整机器可学习函数mlf的参数。优化opt也可以执行无监督学习,在该情况下,机器可学习函数典型地仍然应用于训练实例,但是目标函数不基于训练输出。不管训练是有监督的还是无监督的,训练输入观察的数量可以是例如至少1000、至少10000或至少10000。

71.令人感兴趣的是,为了因在机器可学习函数的一层处对输入观察之间的差异集合可预测地响应而奖励机器可学习函数mlf,正则化目标reg 560可以被包括在正被优化的目标函数中。应用正则化目标的层可以是输出层,或者内部层。还可能的是,包括机器可学习函数的多个相应层(例如,内部层或输出层)的多个相应正则化目标。为了易于解释,这里讨论单个正则化目标:通过对所使用的每个正则化目标重复所描述的操作,可以实现多个正则化目标。

72.正则化目标reg可以依据将机器可学习函数应用于一对输入观察io1 511和io2 512的结果来定义,输入观察io1 511和io2 512根据给定的差异标记dif 513而不同。用于获得该对io1、io2和对应的差异标记dif的选项在别处讨论。差异标记集合典型地被选择为离散的,例如,包括至多或至少5个、至多或至少10个、或至多或至少25个可能的差异。然而,原则上使用连续差异标记也是可能的。给定输入观察io1和io2,机器可学习函数mlf可以被应用(至少部分地)以在为其定义正则化目标reg的层处得到输入观察的对应表示r1 541和r2 542。基于表示r1和r2以及差异标记dif(典型地基于多个这样的三元组r1、r2、dif),可以评估正则化目标reg。

73.正则化目标reg可以被配置为在给定差异标记dif的情况下奖励第一表示r1和第

二表示r2之间的互统计相关性。如别处所述,存在各种选项用于定义该正则化目标,包括通过在给定r1和dif的情况下最小化r2的条件熵和通过在给定dif的情况下最大化r1和r2的互信息,例如,。正则化目标reg还可以抑制第一表示r1和第二表示r2之间不以差异标记dif为条件的互相关性,例如,通过最小化r1和r2之间不以差异标记dif为条件的互信息,例如。例如,正则化目标可以包括r1、r2和dif之间的交互信息,例如。例如根据超参数λ对项和不同地加权也是可能的,例如,。

74.为了评估正则化目标reg,可以使用用于计算或估计相应统计量的各种常规技术。然而,该图图示了基于(条件)互信息的正则化目标,其中根据可训练的互信息估计模型mie 550来估计(条件)互信息。这样的可训练的互信息估计模型的示例在m. belghazi 等人的“mine: mutual information neural estimation”(可在https://arxiv.org/abs/1801.04062处获得,并且通过引用并入本文)中公开。相应的互信息估计模型可以用于估计以差异标记dif为条件的互信息,例如,;和不以差异标记为条件的互信息,例如,。对于前者,mine的技术可以适于通过从以差异标记为条件的分布中采样来以直接的方式估计条件互信息。令人感兴趣的是,(一个或多个)互信息估计模型可以在优化opt中与机器可学习函数mlf的训练同时优化,所述优化例如基于单个目标函数。这允许互信息估计随着机器可学习函数被更新而逐步适配。

75.注意到,鉴于互信息恒等式鉴于互信息恒等式,交互信息也可以例如使用如上所述的互信息估计模型被估计为或。

76.现在继续进行如何获得输入观察和对应的差异标记的三元组io1、io2、dif,设想到若干种可能性。在一些实施例中,这样的三元组可以作为训练数据集的一部分可获得。这可以称为监督设置。在图5b中图示的另一种可能性是在生成操作gen 580中,从输入观察io1和差异类型dif生成输入观察io2。这可以称为自监督设置。可以使用适合于当下应用的任何生成操作gen。差异类型dif可以指示要应用于输入观察io1的变换,例如,其可以是诸如旋转和/或平移的几何变换,而且也可以是对输入观察io1的合成修改,以修改场景中对象的属性,或者修改观察条件。例如,车辆环境的图像可以被适配以引入雪或雨,将白天场景改变为夜晚场景,等等。

77.图中未示出的第三选项是使用机器可学习标记函数从输入观察io1和io2中确定差异标记dif。该函数可以在执行优化opt之前被训练,但是与函数mlf同时学习该函数(例如,使用多任务学习)一般是优选的。标记函数的训练可以是有监督的。例如,在差异标记对于输入观察子集可获得的情况下,可以在该子集上学习标记函数,并将其应用于没有标记可获得的对。令人感兴趣的是,训练也可以是无监督的,从而使得能够完全消除标记努力。例如,可以如m. caron等人的“deep clustering for unsupervised learning of visual features”(可在https://arxiv.org/abs/1807.05520处获得,并且通过引用并入本文)中所述那样来训练标记函数。

78.图5c示出了详细但非限制性的示例,其中正被训练的机器可学习函数是用于在整体图像分类器ci 590中使用的图像特征提取器。也就是说,整体图像分类器ci可以通过以

下操作对输入观察io、例如输入图像进行分类:应用机器可学习函数mlf来获得函数输出fo,该函数输出fo提供从输入观察io提取的特征向量;以及使用另外的机器可学习函数对所得的提取特征fo执行分类ci。在该情况下,为了训练整体图像分类器,可以首先如本文所述那样训练机器可学习函数,而不使用分类标记。因此,也可以使用没有分类标记可获得的输入观察io。

79.此后,在优化操作opt2 579中,可以在标记有期望的训练分类输出tco 595’的训练示例io上训练整体图像分类器。该优化操作opt2至少学习输出分类的另外的机器可学习函数ci的参数;可选地,优化opt2也可以微调机器可学习函数mlf。为此,可选地,用于机器可学习函数mlf的正则化目标reg可以被包括在用于训练整体分类器的目标函数中。

80.图6示出了训练机器可学习函数的计算机实现的方法600的框图。机器可学习函数可以将输入观察映射到函数输出。机器可学习函数可以包括一个或多个内部层和/或输出层。方法600可以对应于图1的系统100的操作。然而,这不是限制,因为方法600也可以使用另一系统、装置或设备来执行。

81.方法600可以包括,在标题为“访问训练数据、参数”的操作中,访问610以下各项:包括多个训练输入观察的训练数据集;和机器可学习函数的参数集合。

82.方法600可以包括,在标题为“学习参数”的操作中,通过优化目标函数来学习620机器可学习函数的参数集合。优化可以包括因在机器可学习函数的一层处对输入观察之间的差异集合可预测地响应而奖励机器可学习函数。优化可以借助于包括在目标函数中的正则化目标来奖励所述可预测性。

83.在学习操作620中执行的优化可以包括,在标题为“获得观察、差异标记”的操作中,获得622以下各项:来自训练数据集的第一输入观察;对应的第二输入观察;和来自差异集合的差异标记,其指示第一和第二输入观察之间的差异。优化还可以包括,在标题为“应用函数来确定表示”的操作中,应用624机器可学习函数来在机器可学习函数的该层处分别确定第一和第二输入观察的第一和第二表示。优化还可以包括,在标题为“在给定差异标记的情况下奖励表示的相关性”的操作中,评估626正则化目标,其中正则化目标可以被配置为在给定第一和第二输入观察之间的差异标记的情况下,奖励第一和第二表示之间的互统计相关性。

84.将领会,一般而言,图6的方法600的操作可以以例如连续地、同时地或其组合之类的任何合适的顺序执行,在适用的情况下,这服从例如通过输入/输出关系而成为必要的特定顺序。

85.(一种或多种)方法可以在计算机上实现为计算机实现的方法、专用硬件或两者的组合。同样如图7中所图示,用于计算机的指令(例如可执行代码)可以例如以机器可读物理标记的系列710的形式和/或作为具有不同电气(例如磁性或光学)属性或值的一系列元素存储在计算机可读介质700上。可执行代码可以以暂时或非暂时的方式存储。计算机可读介质的示例包括存储器设备、光学存储设备、集成电路、服务器、在线软件等。图7示出了光盘700。替代地,计算机可读介质700可以包括暂时或非暂时数据710,其表示由本文提供的计算机实现的方法训练的机器可学习函数的参数集合。

86.示例、实施例或可选特征——无论是否被指示为非限制性的——都不应被理解为限制所要求保护的本发明。

87.应当注意,上面提及的实施例说明而不是限制本发明,并且本领域技术人员将能够在不脱离所附权利要求的范围的情况下设计许多替代实施例。在权利要求中,置于括号之间的任何参考标记不应被解释为限制权利要求。动词“包括”及其词形变化的使用不排除除权利要求中所陈述的元素或阶段之外的元素或阶段的存在。一元素前面的冠词“一”或“一个”不排除多个这样的元素的存在。诸如

“……

中的至少一个”的表述当在元素列表或群组之前时表示从该列表或群组中选择所有元素或元素的任何子集。例如,表述“a、b和c中的至少一个”应当理解为包括:仅a;仅b;仅c;a和b两者;a和c两者;b和c两者;或全部a、b和c。本发明可以借助于包括若干不同元件的硬件以及借助于适当编程的计算机来实现。在列举了若干构件的设备权利要求中,这些构件中的若干个可以由同一个硬件项目来体现。在相互不同的从属权利要求中记载某些手段的仅有事实并不指示这些手段的组合不能被有利地使用。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。