1.本发明涉及一种基于深度学习的行人再识别算法。行人再识别(person re

‑

identification,reid)可以在多摄像机产生的数据中,获取目标行人短期内出现的位置及相应时间,进而构建出目标行人的活动轨迹及行为分析。

背景技术:

2.卷积的本质是进行特征的融合,而该融合在空间层面上是局部的,在通道层面上却是默认为全部融合,显然,不同通道的信息对结果的影响同样是不同的。于是提出了se(squeeze and excitation)模块(参考hu j,shen l,sun g.squeeze

‑

and

‑

excitation networks[c]//proceedings of the ieee conference on computer vision and pattern recognition.2018:7132

‑

7141)。se模块将视角从空间层面移开,关注特征通道之间的关系,使得特征关注更加重要的通道。

[0003]

se模块可以认为是通道注意力机制,而文献认为仅仅结合通道域是不够全面的,于是结合了通道注意力机制和空间注意力机制,提出了cbam(convolutional block attention module),其通过实验发现通道注意力机制与空间注意力机制的串联要比并联效果更好(参考woo s,park j,lee j y,et al.cbam:convolutional block attention module[c]//proceedings of the european conference on computer vision(eccv).2018:3

‑

19)。由神经网络提取出的特征更关注于显著特征,由此获得的全局特征可能会忽略一些真正拥有辨识性的细微特征,于是研究者们开始关注如何获得更细粒度的特征,目前获取局部特征的主流方向为水平切片与人体姿态分割。人体姿态分割方法需要单独训练人体姿态识别网络后再进行行人再识别。通过水平切片方法获得的特征看似仅代表图片的局部,但在经过深层网络的提取后,感受野实际已经覆盖全图,只是侧重不同。文献表明,即使只使用通过水平切片所获得的局部特征仍能取得不错的性能(参考sun y,zheng l,yang y,et al.beyond part models:person retrieval with refined part pooling(and a strong convolutional baseline)[c]//proceedings of the european conference on computer vision(eccv).2018:480

‑

496)。文献表明,在训练中联合全局特征与局部特征会获得更好的效果(参考luo h,jiang w,zhang x,et al.alignedreid :dynamically matching local information for person re

‑

identification[j].pattern recognition,2019,94:53

‑

61)。

[0004]

还有文献提出了alignedreid方法(参考fan x,jiang w,luo h,et al.spherereid:deep hypersphere manifold embedding for person re

‑

identification[j].journal of visual communication and image representation,2019,60:51

‑

58)。该算法提取特征后分为两个分支,一为经过全局平均池化得到的全局特征,并利用全局特征来进行难样本挖掘;二为通过对特征图进行水平平均池化而获得的8块局部特征。直接水平切片获取的局部特征可能会出现对齐不准的问题。于是提出了dmli(dynamically matching local information)方法,通过局部特征间计算欧式距离并寻找

最短路径的思想,达到了局部特征自动对齐的效果,但在关键特征提取部分不够强力。其提出的spherereid通过修改softmax损失,将特征映射在映射到球面上,使得分类仅与角度有关,消除分类中模的影响,获得了较好的效果。

[0005]

文献提出了circle loss损失函数,该函数在形式上统一了分类损失及度量损失。该损失函数在人脸识别、车辆重识别和行人重识别等任务上均取得了较好的反响(参考sun y,cheng c,zhang y,et al.circle loss:aunified perspective of pair similarity optimization[c]//proceedings of the ieee/cvf conference on computer vision and pattern recognition.2020:6398

‑

6407)。

[0006]

分类损失与度量损失结合可以获得更优的效果,然而在多损失联合的情况中容易出现不同损失收敛不同步的情况。文献提出了一种名为bnneck的方法(参考luo h,gu y,liao x,et al.bag of tricks and a strong baseline for deep person re

‑

identification[c]//2019ieee/cvf conference on computer vision and pattern recognition workshops(cvprw).ieee,2019:1487

‑

1495),即对进行分类损失计算的特征进行批量归一化,对进行三元组损失计算的特征不进行批量归一化。此时进行分类损失会获得更好的效果,并改善了使用多个损失函数时不同损失收敛不同步的情况。

[0007]

但是在实践中发现通道注意力机制串联空间注意力机制的效果在行人再识别任务中并不理想。

技术实现要素:

[0008]

为了解决上述问题,本发明旨在提供一种基于深度学习的多级特征提取网络行人再识别方法。本发明为特征提取阶段设计了frm方法,仅部分的利用空间注意力机制,使网络获得了多层次多样的特征,并结合了多种损失函数,使算法获得了较好的效果。

[0009]

本发明的技术方案为:

[0010]

一种基于深度学习的多级特征提取网络行人再识别方法,其步骤包括:

[0011]

1)对行人再识别网络进行每一轮训练时,每次从行人再识别数据集中提取一批数据并采用数据增强措施对其进行扩充;

[0012]

2)利用扩充后的数据训练行人再识别网络;将当前批次扩充后的数据依次通过block1、block2对其进行特征提取后得到特征向量f={x1,

…

,x

b

},然后将特征向量f分别输入行人再识别网络的分支一和分支二;x

b

代表第b张图像的特征数据,c代表图像对应特征图的通道数,h代表图像对应特征图的高,w代表图像对应特征图的宽;block1、block2为seresnet

‑

50中的特征提取模块,sfgm为次级特征生成模块,gem为广义均值池化,bn为批量归一化;

[0013]

3)所述分支一从特征向量f中提取每一图像对应的全局特征;所述分支二从特征向量f中提取每一图像对应的次级特征;

[0014]

4)将所述全局特征以及每一所述次级特征分别依次通过bn操作、全连接层、circle loss、标签平滑、softmax loss处理后得到一对应的损失值;将所述全局特征通过辅助损失函数center loss计算得到一损失值、将所述全局特征通过损失函数triplet loss with adaptive weights计算得到一损失值;

[0015]

5)根据步骤4)所得各损失值计算一总损失值,根据该总损失值调整优化所述行人

再识别网络的网络参数,得到完成一批次训练后的行人再识别网络;

[0016]

6)重复1~5的步骤,直到完成设定轮次(即每轮训练时,整个训练集训练一遍)的训练,得到训练完成后的行人再识别网络;

[0017]

7)对于每一待识别图像,利用训练完成后的行人再识别网络提取该待识别图像的全局特征、次级特征并对其进行bn处理后进行特征融合,得到待识别图像特征;计算各待识别图像特征与目标图像特征的相似度,再进行相似度排序,获得与目标图像相似图片列表。

[0018]

进一步的,所述分支二提取次级特征的方法为:特征向量首先经过sfgm生成待提取次一级特征向量,随后将该待提取次一级特征向量经过block3

‑

1提取后输入两个分支,即第二级分支一、第二级分支二,第二级分支一将输入特征依次通过block4

‑

1、gem获得次一级特征;第二级分支二通过sfgm从输入特征中获得待提取次二级特征向量;待提取次二级特征向量通过block4

‑

2后再次分为两个分支,即第三级分支一、第三级分支二,第三级分支一通过gem从待提取次二级特征向量中获得次二级特征;第三级分支二将待提取次二级特征向量依次通过sfgm、gem获得次三级特征;其中block3

‑

1、block4

‑

1、block4

‑

2为seresnet

‑

50中的特征提取模块。

[0019]

进一步的,次级特征生成模块sfgm的数据处理方法为:设输入特征向量为of,首先对输入特征向量of分别在通道维度上进行最大值池化与均值池化,随后将池化后的两个特征向量在通道维度进行拼接,获得特征向量f1;再对特征向量f1进行卷积操作,获得特征向量f2;再对特征向量f2进行批量归一化即bn操作;最后利用sigmoid激活函数获得区间为[0,1]的空间权值矩阵m;生成所述空间权值矩阵m中权值大于p的掩模mask,通过掩模mask将所述空间权值矩阵m中权值大于p的值置为w,其它置为~w,获得空间权值矩阵m1;将所述空间权值矩阵m1拓展为与特征向量of相同通道维度空间权值矩阵m2;然后将所述空间权值矩阵m2与特征向量of点乘后与特征向量of相加获得特征向量f3;特征向量f3通过relu函数进行激活后输出。

[0020]

进一步的,采用数据增强措施对每一图像分别进行如下处理:

[0021]

11)将图像高宽比例调整为2:1,生成一新图像;

[0022]

12)对图像进行随机水平翻转,生成一新图像;

[0023]

13)对图像进行随机裁剪,生成一新图像;

[0024]

14)对图像进行归一化,生成一新图像;

[0025]

15)对图像进行随机擦除,生成一新图像。

[0026]

进一步的,步骤11)中,将图像像素调整为[高,宽]=[256,128]大小;所述分支一将特征向量f依次通过block3、block4和gem提取所述全局特征,block4中的步长从2调整为1,block3、block4为seresnet

‑

50中的特征提取模块。

[0027]

进一步的,步骤4)中,先使用circle loss调节类间距离,然后采用softmax loss使得所有类别在概率空间具有最大的对数似然。

[0028]

进一步的,通过triplet loss with adaptive weights计算的损失值为weights计算的损失值为其中,d(x

a

,x

p

)、d(x

a

,x

n

)分别代表目标x

a

与正样本x

p

和负

样本x

n

之间的相似度;p(a)、n(a)分别代表目标a的正负样本集合。

[0029]

进一步的,通过center loss计算的损失值为其中,b为样本数,x

i

代表样本i的特征值,代表样本i的类别的中心。

[0030]

与现有技术相比,本发明的积极效果为:

[0031]

在行人再识别(person re

‑

identification,reid)任务中,行人的运动范围往往是跨越多个摄像区域的,且其运动方向及行为无法被约束,而不同场景中存在的不相关的人或物也会为我们获取目标行人信息造成干扰。同时监控系统也存在着单一摄像头拍摄角度固定、不同摄像头之间角度不同和图像分辨率较低等诸多特性。这些特性使得行人再识别任务存在许多困难。本发明提出了一种基于seresnet

‑

50的多级特征提取网络(multistage feature extraction network,mfen)。在质量较差的图像中提取出更丰富多样的行人特征将有效提高网络的再识别能力,而mfen通过本发明提出的特征再提取方法(feature re

‑

extraction method,frm)可以获取图片中的多级关键特征。实验表明,mfen相较aanet

‑

50,在market1501数据集上map提高了3.85%,rank

‑

1提高了0.71%;在dukemtmc

‑

reid数据集上map提高了2.74%,rank

‑

1提高了1.28%。

附图说明

[0032]

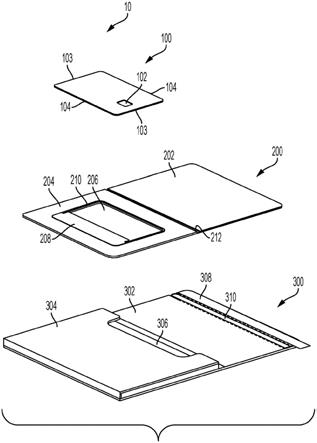

图1是多级特征提取网络整体结构图。

[0033]

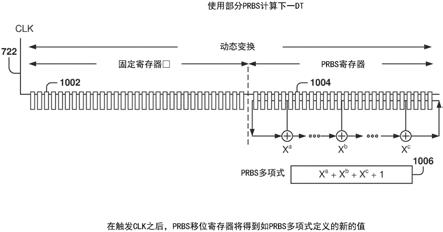

图2是次级特征生成模块结构图。

[0034]

图3是受试者工作特征曲线图。

具体实施方式

[0035]

为了进一步说明本发明的目的、技术方案的特点和优点,以下结合附图,对本发明进行进一步的详细说明。此处所描述的具体实施例仅仅用于解释本发明,并不用于限定本发明。

[0036]

为了更高效的提取细粒度特征,本发明提出了一种基于seresnet

‑

50的多级特征提取网络(multistage feature extraction network,mfen)。mfen可分为数据增强、frm与多级特征融合、多损失函数联合训练三个部分。

[0037]

mfen主体结构如图1所示。其中虚连接线为测试路线;sfgm:次级特征生成模块;frm:特征再提取方法;gem:广义均值池化;bn:批量归一化;block:seresnet

‑

50中的提取模块,block1~4结构均相同,但通道数等参数根据输入数据不同设置不同,例如:block1是输入数据”1*2

”‑

>a函数(属性=1)

‑

>输出数据“4*2”,那么block2为输入数据”4*2

”‑

>a函数(属性=4)

‑

>输出数据“16*2”,以此类推;loss:指损失函数。

[0038]

1.1数据增强

[0039]

由于公开行人再识别数据集较小,行人再识别网络在训练中容易出现过拟合现象。为了缓解过拟合现象,对行人再识别网络进行每一批次训练时,本发明分别采用以下几种数据增强措施对行人再识别数据集中的每一图像进行处理:

[0040]

(1)将图像像素调整为[高,宽]=[256,128]大小。图像高宽比例为2:1,以对应人体形状,防止图像产生畸变。对于图像大小数值的选择,第一是考虑到图像的长宽若为2的

指数倍将会充分利用计算资源;第二是考虑到调整后的图像若已大于原图像大小,此时再增大长宽的收益不大(参考luo h,gu y,liao x,et al.bag of tricks and a strong baseline for deep person re

‑

identification[c]//2019ieee/cvf conference on computer vision and pattern recognition workshops(cvprw).ieee,2019:1487

‑

1495.);第三是考虑到,数值过大会对网络运行速度造成不小的负担。

[0041]

(2)对图像进行概率为0.5的随机水平翻转,以增强模型泛化能力,缓解过拟合。

[0042]

(3)对图像进行差距为10的随机裁剪,以增强模型泛化能力,缓解过拟合。

[0043]

(4)对图像进行归一化,以降低仿射变换带来的影响。归一化采用均值为[0.485,0.456,0.406],标准差为[0.229,0.224,0.225]两组从imagenet训练集中抽样计算出的数值。

[0044]

(5)对图像进行概率为0.5的随机擦除。随机擦除方法会在原图随机选择一个矩形区域,将该区域的像素替换为随机值,形成类似于遮挡的效果,以增强模型泛化能力,缓解过拟合现象的发生。

[0045]

训练过程中训练集完整的输入过一遍称为一轮(epoch),行人再识别网络会进行特定轮次的训练。由于上述部分方法存在随机性,那么同一图像每一轮训练时产生的扩充数据都会出现变化,不仅达到扩充数据的效果,还有减少计算量等等好处方便训练。

[0046]

1.2frm与特征融合

[0047]

在质量较差的图像中提取出更丰富多样的行人特征将有效提高网络的再识别能力。为了获得更有效多样的特征,本发明提出了一种特征再提取方法(feature re

‑

extraction method,frm)。为了更好的提取关键特征,本发明将seresnet

‑

50的block4模块中的步长从2调整为1,使得最终获取的特征图大小由原8*4扩大为16*8,这将使网络获得更细粒度的特征。

[0048]

通道注意力机制串联空间注意力机制后理论上会使网络的识别能力提高。但是在行人再识别任务中,本发明通过实验发现事实并非如此。这也许是因为行人再识别任务的图像因为遮挡、因拍摄角度或距离导致的无关信息过多和低分辨率等原因而质量较差,使加入空间注意力机制后的这种识别能力的增强反而使网络出现了错误的判断。全局特征与局部特征联合训练网络会取得更好的效果,然而通过水平切片来提取局部特征会出现对齐不准的问题。

[0049]

结合以上问题,本发明想到“部分的使用”空间注意力机制,仅利用空间注意力机制从全局判断特征的重要性,再将一部分特征剥离出去,而不是机械的“硬切割”。并且对这样剥离部分后的特征向量进行再提取,我们就会获得更多的有效特征。

[0050]

最初frm试图去除的是非关键特征,这是因为考虑到存在一些不相关的物体会干扰网络的判断,但实验表明这并无效果。这也许是因为网络对重要的特征的判断未必是正确的。可能我们去除的非关键特征是目标行人的一部分,保留的却是背景中的树。

[0051]

于是frm改为去除关键特征,这样提取出的次级特征会更侧重于相对不是特别明显的细节特征。这些特征通过一层一层的剥离,表现的会比单一的全局特征更富层次性,网络会因此获得更多信息。而这样自学习的特征剥离行为也会起到数据增广的效果,网络学习到了比原始数据集更多样的特征图,这会令网络的泛化能力得以提高。实验表明,frm对网络性能的提高是明显的。

[0052]

frm是次级特征生成模块(secondary feature generation module,sfgm)与特征提取部分的结合。

[0053]

若一个批次(batch)的输入数据为f={x1,

…

,x

b

},f∈r

b

×

c

×

h

×

w

,x∈r

c

×

h

×

w

代表单张图片的数据,b∈n

代表一批次中同时处理的图片数量(batch size),xb代表第b张图片的数据,c∈n

代表特征图的通道数,h∈n

代表特征图的高,w∈n

代表特征图的宽。

[0054]

如图1所示,图像在完成数据增强后,经过seresnet

‑

50的block1、block2获得特征向量f∈r

b

×

512

×

32

×

16

并输入到sfgm进行处理。此时行人再识别网络分为两个分支,第一级分支一直接通过block3、block4和gem提取全局特征;第一级分支二通过frm提取次级特征。在frm方法中,特征向量首先经过sfgm生成待提取次一级特征向量,随后经过block3

‑

1提取后,再次分为两个分支,第二级分支一通过block4

‑

1、gem获得次一级特征;第二级分支二通过sfgm获得待提取次二级特征向量。待提取次二级特征向量通过block4

‑

2后再次分为两个分支,第三级分支一通过gem后获得次二级特征;第三级分支二通过sfgm、gem获得次三级特征。

[0055]

在sfgm中,输入一个特征向量of∈r

b

×

c

×

h

×

w

,对of首先分别在通道维度上进行最大值池化与均值池化,随后将池化后的两个特征向量在通道维度进行拼接,获得特征向量f1∈r

b

×2×

h

×

w

。再对特征向量f1进行卷积核为7*7的卷积操作,获得特征向量f2∈r

b

×1×

h

×

w

。再对特征向量f2进行批量归一化即bn操作。最后利用sigmoid激活函数获得区间为[0,1]的空间权值矩阵m∈r

b

×1×

h

×

w

。进行bn操作是为了防止输入数据进入非饱和区,以避免sigmoid激活函数可能出现的梯度消失现象,加快网络收敛。

[0056]

生成空间权值矩阵m中权值大于p的掩模mask∈r

b

×1×

h

×

w

,通过掩模判断,将空间权值矩阵m中权值大于p的值置为w,w=0,其它置为~w,~w=1,获得空间权值矩阵m1∈r

b

×1×

h

×

w

。空间权值矩阵m1拓展为与特征向量of相同通道维度空间权值矩阵m2∈r

b

×

c

×

h

×

w

。空间权值矩阵m2与特征向量of点乘后与特征向量of相加完成一个残差单元获得特征向量f3∈r

b

×

c

×

h

×

w

。特征向量f3通过relu函数进行激活。sfgm流程如图2所示。

[0057]

sfgm在未添加残差单元时,网络性能的表现不够稳定,在添加残差单元后,不稳定的情况得以改善。本发明认为是由于残差单元缓解了特征图在再提取过程中可能出现的大量关键特征缺失与网络的退化问题。

[0058]

在最终完成特征提取之前还进行了广义均值池化gem(generalized mean pooling)获得向量f4∈r

b

×

c

×1×1。gem公式如(1)所示:

[0059][0060]

其中f

c

∈r

h

×

w

指第c个通道的单通道特征图;x指特征值,n=h

×

w;p为指定参数值。之所以称为广义是指当参数p=1时是全局平均池化,当p=∞时是最大值池化。当p>1时将会增强图像对比度,使图像更关注局部特征。

[0061]

由此mfen获得全局特征、次一级特征、次二级特征和次三级特征四份特征。在测试时,四份特征将在通道维度融合后进行余弦相似度计算。获得余弦相似度矩阵后即可进行排序,相似度越大代表图片之间越相似。根据特征所对应的标签,即可获得对应图片的相关信息。

[0062]

1.3多损失函数联合训练

[0063]

本发明在网络中联合了4种损失函数,分别为triplet loss with adaptive weights(参考lawen h,ben

‑

cohen a,protter m,et al.attention network robustification for person reid[j].arxiv preprint arxiv:1910.07038,2019)、softmax loss、center loss(参考wen y,zhang k,li z,et al.adiscriminative feature learning approach for deep face recognition[c]//european conference on computer vision.springer,cham,2016:499

‑

515)、circle loss。

[0064]

考虑到特征归一化后进行分类损失效果更好,于是本网络在计算softmax loss前对特征进行bn操作。次级特征由于缺失部分关键特征导致可能出现误差,故仅全局特征计算triplet loss with adaptive weights和center loss。

[0065]

softmax loss是常用的分类损失函数,若存在目标分数向量d=f(x)∈r

c

,c为分类数,y为真实标签位置,则公式如(2)所示:

[0066][0067]

在全监督学习中,标签是一个one

‑

hot向量,这形成了一个强监督约束,从而使得过拟合现象加深,为了缓解这种情况,本网络在计算分类损失时使用了标签平滑技术(参考szegedy c,vanhoucke v,ioffe s,et al.rethinking the inception architecture for computer vision[c]//proceedings of the ieee conference on computer vision and pattern recognition.2016:2818

‑

2826),其公式如(3)所示:

[0068][0069]

其中q

i

∈r

c

指样本i的向量;n∈n

指类别数;ε=0.1指平滑参数。

[0070]

softmax loss的目的是让所有的类别在概率空间具有最大的对数似然,然而行人再识别任务并非仅仅考虑分类问题。特征之间也许分类是清晰的,但其类间距离也许会小于类内距离,因此需要更好的度量空间。通过使用circle loss调节类间距离,随后进行softmax loss可以获得更好的效果。circle loss的目标可以理解为使最小的同类相似度大于最大的非同类相似度。circle loss如公式(4)所示:

[0071][0072]

其中k∈n

指正样本个数,l∈n

指负样本个数,γ∈r为缩放因子,指与目标非同类的图片j与目标的距离,指与目标同类的图片i与目标的距离,m∈r为类间距离。如果一批次包括24张图片,其组成为6位行人的各4张图片。非同类即其他5人的5*4张图片,同类即同一行人的除本张外的其他3张。

[0073]

triplet loss with adaptive weights相比难样本三元组损失的只关注于最难的样本,它认为只考虑极端情况是不妥的,况且若存在一定数量的数据标注错误,使用难样本三元组损失将导致网络难以收敛。由于硬间隔(hard margin)一旦达到设定值就会失去

继续推动类间距离的动力,本发明采用软间隔(soft margin),这会不断拉近正样本距离并推开负样本。其公式如(5)、(6)和(7)所示:

[0074][0075][0076][0077]

其中d(x

a

,x

p

)、d(x

a

,x

n

)分别代表目标x

a

与正样本x

p

和负样本x

n

之间的相似度;p(a)、n(a)分别代表目标a的正负样本集合。由(6)与(7)所示,这使得正样本距离越大,权重越大;负样本距离越大,权重越小。

[0078]

center loss是一种辅助损失函数,它的特点为可以减小类内间距,达到聚集的效果,但不会改变类间间距。其公式如(8)所示:

[0079][0080]

其中b∈r为样本数,x

i

∈r代表样本i的特征值,代表样本i的类别的中心。

[0081]

本发明中circle loss与softmax loss串联得到分类损失,并与triplet loss with adaptive weights和center loss并联得到总损失。结构可见图1。具体组成比例可见表3、表4。当网络达到预期性能时训练出的参数保存在一个文件里。

[0082]

2实验相关

[0083]

2.1实验环境及重要参数

[0084]

本发明实验环境如表1所示。本网络采用了ranger优化器,其结合了radam及lookahead优化器,使其达到了更高的性能。特别说明,表12、13中使用了resnet50在imagenet数据集上的结果来进行预训练。

[0085]

表1实验环境

[0086]

显卡nvidia rtx2080显存8gbcpuinter core i7 5代内存16gb操作系统linux开发语言python3.6集成开发环境pycharm实验框架pytorch1.3显卡计算平台nvidia cuda10深度学习加速库nvidia cudnn7

[0087]

重要超参数如表2所示。其中训练batch size为4*4是指对4个不同行人分别提取4

张图片。

[0088]

表2重要超参数表

[0089][0090][0091]

在模型训练的初期,由于输入大量新数据,模型参数会进行快速调整,此时使用较大学习率将容易陷入局部最优的情况,而如果长期保持低学习率又会造成模型收敛过慢,在训练后期为了寻找损失的最低点,又需要更低的学习率。于是本发明采用warm up学习策略。其公式如(9)所示:

[0092][0093]

本网络损失函数比例组成如表3所示。考虑到triplet loss with adaptive weights的数值相比softmax loss是较低的,为了使网络对前者的数值变动更加敏感,因此降低了softmax loss的比例。

[0094]

表3损失函数比例表

[0095]

损失函数组成比例softmax loss0.5triplet loss with adaptive weights1center loss0.0005

[0096]

其中triplet loss with adaptive weights与center loss仅使用全局特征。softmax loss使用全局特征与由frm取得的三份次级特征获得的损失组成比例如表4所示。考虑到非全局特征缺失部分特征,因此所占比例相对较小。通过多次对比试验的结果表明,这种比例是相对较好的。

[0097]

表4 softmax loss比例

[0098]

特征组成比例全局特征1/2次一级特征1/4次二级特征1/8次三级特征1/8

[0099]

2.2数据集

[0100]

market1501数据集:发布于2015年的白天在清华大学校园内采集的大型单帧数据集。该数据集拥有6个摄像头采集的共1501名行人的32668张图片。训练集含751名行人共19732张图片;测试集含750名行人共12936张图片;待检测图片集含3368张图片。数据集图片分辨率均为128

×

64。图片均由检测器自动分割而成。其内分机器标注与人工标注两类标签,目前学界主要使用机器标注标签。数据集特色:存在脏数据、数据集较大、夏季采集、待检测图片集存在同一行人多张照片。

[0101]

dukemtmc

‑

reid数据集:发布于2016年的白天在杜克大学校园内采集的大型单帧数据集。该数据集拥有由8个摄像头采集的1404名行人共36411张图片,都由人工分割标注完成。训练集含702个行人共16522张图片;测试集含702行人共17661张图片;待检测图片集含2228张图片。数据集图片分辨率均为204

×

61。数据集特色:数据集较大,提供了行人的特殊属性,如性别、有无背包等;采集时天气寒冷,导致行人撞衫和遮挡情况严重。

[0102]

2.3算法主要指标

[0103]

平均准确度(mean average precision,map)和首位命中率(rank

‑

1 accuracy)是目前衡量行人再识别算法性能最主要的指标。

[0104]

rank

‑

1 accuracy为在返回结果中置信度最高的图片的命中率。当待检测图像为多个时,取平均值。

[0105]

其中ω∈n

为query同id的第k个查询结果的集合;n∈n

为所有与查询图片同id的图片数目;n

q

∈n

为需要查询的图片的数量;tp(true positive)为将正类预测为正类数;fp(false positive)为将负类预测为正类数。map公式如(10)、(11)和(12)所示。

[0106][0107][0108][0109]

2.4对比实验与分析

[0110]

表5、表6分别为在market1501数据集及dukemtmc

‑

reid数据集下对方法的消融试验。其中ca指通道注意力机制;frm指加入本发明frm方法。

[0111]

表5消融实验对比(market1501)

0.585.6%94.0%0.184.7%94.0%086.1%94.4%

[0122]

表8为gem后bn层参数共享方案对比。方案bn(α)表示bn层参数全部不共享;方案bn(β)表示全部共享;方案bn(γ)表示再提取特征之间bn层参数共享,而与全局特征bn层参数不共享。本发明在实验中发现,对特征进行批量归一化时,方案bn(α)或方案bn(β)均会导致网络性能下降。而方案bn(γ)会获得较好结果。

[0123]

本发明认为这是在三次抹除显著特征后,由此得出的特征向量不足以体现数据集整体的数值分布,不能很好的进行批量归一化,而共享将缓解这一情况,并且不会影响到全局特征。

[0124]

表8 gem后bn层参数共享方案对比

[0125]

参数共享方案maprank

‑

1bn(α)84.7%94.0%bn(β)84.2%94.0%bn(γ)86.1%94.4%

[0126]

表9为circle loss参数共享方案对比。方案c(α)表示circle loss参数全部共享,方案c(β)表示全局特征的参数与次级特征的参数之间不共享,次级特征之间circle loss参数共享。方案c(γ)表示circle loss参数全部不共享。可见方案c(γ)效果更好。

[0127]

表9 circle loss参数共享方案

[0128]

模型方法maprank

‑

1c(α)85.5%94.3%c(β)85.0%94.2%c(γ)86.1%94.4%

[0129]

如表10中所示,其中p值组=[p值(次一级特征),p值(次二级特征),p值(次三级特征)]。本网络采用p值组=[0.85,0.90,0.95]。从表4.10中我们可以得到一个大致的规律:即越深层网络提取的特征的p值应越大。因为网络层数越深,所提取出的特征图越小,提取出特征也越抽象准确。而特征图越小,特征向量的感受野越大,此时p值较低容易将过多的关键特征去除。

[0130]

表10 frm中p值组对比

[0131][0132]

[0133]

表11为不同batch size下网络性能对比,其中batch size在32及以上的是使用了4张gtx1080ti(11g)显卡进行训练。由表11可见batch size在一定范围内的增大对网络的性能有一定提升,但过高就会出现性能下降的情况。其中p为不同行人数量,k为同行人图片数量。其中market1501数据集采用mfen

‑

a方案对比;dukemtmc

‑

reid采用mfen

‑

b方案对比。可见对于mfen,batch size设置为6*4最佳。

[0134]

表11不同batch size下网络性能对比

[0135][0136]

mfen在market1501数据集上的受试者工作特征(roc)曲线图如图3所示。横轴为误识率,即非目标中被判断为目标的比率;纵轴为命中率,即被提取出的目标图片数目/数据集中的目标图片数目。

[0137]

在market1501数据集上进行测试,rk指重排序后的指标。mfen训练轮次(epoch)为120,耗时4.5小时。最终实验结果如表12所示。

[0138]

表12 market1501数据集

[0139][0140][0141]

表13为mfen在dukemtmc

‑

reid数据集的表现,及与其他行人再识别算法的对比。

mfen训练轮次(epoch)为140,耗时6.5个小时。

[0142]

表13 dukemtmc

‑

reid数据集

[0143][0144]

通过mfen所提取出的次级特征会更侧重于相对不是特别明显的细节特征。这些特征通过层层剥离,表现的会比单一的全局特征更富层次性,网络会因此获得更多信息。而网络也学习到了比原始数据集更多样的图像,这使网络的泛化能力得以提高。同时结合多种损失函数使得mfen在全监督、单标注、单帧任务中取得了较好的性能。

[0145]

以上公开的本发明的具体实施例和附图,其目的在于帮助理解本发明的内容和精髓,并不用以限制本发明。凡在本发明的精神和原则范围之内,所做的任何修改、替换和改进等,均应包含在本发明保护的范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。