1.本发明涉及自然语言处理和机器学习技术领域,具体涉及一种基于语义分析过滤化妆品互联网虚假评论的方法。

背景技术:

2.随着电商网络的快速发展,线上消费成为了人们生活重要的组成部分,但是线上消费也存在一定的弊端和风险。在化妆品领域,由于消费者无法在购买前了解产品的真实情况,此时大部分消费者就会去浏览参考用户评论,线上留言和评论是消费者决策的重要参考因素之一。由于线上评论可以在很大程度上影响消费者的决策,受利益的驱使,商家存在雇佣个人或机构撰写虚假评论的行为,同时存在恶意评论抹黑商家从而影响商家的真实信用问题,虚假的评论会误导消费者的决策,因此有效识别虚假评论具有重要意义。

3.对于虚假评论检测识别,通常基于文本或用户行为等进行研究,基于文本进行研究的方法可以分为基于语义特征和基于语法特征的研究。基于语义的研究主要是针对评论文本,在语义层面进行特征抽取,主要包含相似观点以及情感分析等方面;基于语法的研究是从评论文本中的词性特征角度进行分类;基于用户行为特征的研究主要挖掘以评论产品、评论文本以及用户为中心的特征。

4.现有技术cn111259140a公开基于lstm(long short-term memory)多实体特征融合的虚假评论检测方法,联合评论的文本特征与行为特征,对评论的时序联合特征进行再提取得到特征向量,学习新的特征并构建分类器对评论进行判断。现有对虚假评论的检测识别技术主要依靠特征工程将评论文本的特征进行组合,以寻求最优句子的中间表达,然后根据中间表达来训练分类模型,这样的模型虚假评论识别效果不佳。因此,提高虚假评论检测方法的准确性是一个亟需解决的问题。

技术实现要素:

5.本发明的目的在于,提供一种基于语义分析过滤化妆品互联网虚假评论的方法,利用textcnn、bert和bilstm三种模型基于监督学习训练一种自然语言处理模型,来过滤化妆品互联网虚假评论。

6.为实现上述技术目的,达到上述技术效果,本发明是通过以下技术方案实现:

7.基于语义分析过滤化妆品互联网虚假评论的方法,通过对预处理后的化妆品评论数据进行正负样本的筛选与标注,利用textcnn、bert和bilstm对评论文本特征提取并融合提取的文本语义特征,对特征赋予权重并训练分类器判定评论是否虚假,并训练调优得到最终模型用于化妆品虚假评论的检测。

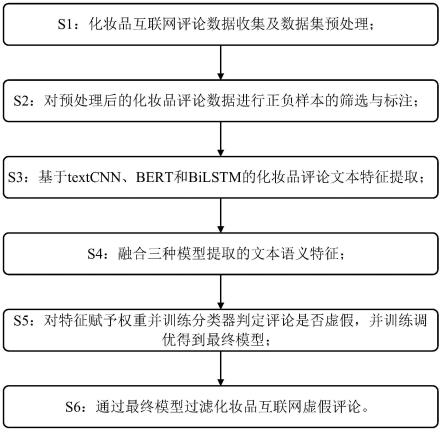

8.基于语义分析过滤化妆品互联网虚假评论的方法,包括以下步骤:

9.s1:化妆品互联网评论数据收集及数据集预处理;

10.s2:对预处理后的化妆品评论数据进行正负样本的筛选与标注;

11.s3:利用textcnn、bert和bilstm的化妆品评论文本特征提取;

12.s4:融合textcnn、bert和bilstm三种模型提取的文本语义特征;

13.s5:对特征赋予权重并训练分类器判定评论是否虚假,并训练调优得到最终模型;

14.s6:通过最终模型过滤化妆品互联网虚假评论。

15.进一步的,所述s1包括:

16.s101:收集化妆品互联网评论数据;

17.s102:对化妆品评论数据集进行预处理。

18.进一步的,所述s101收集化妆品互联网评论数据:

19.利用爬虫程序抓取电商网站的化妆品评论数据,包括评论内容、评论分数和评论者信息。

20.进一步的,所述s102对化妆品评论数据集进行预处理:

21.设定评论长度阈值为θ,删除评论文本长度小于θ的评论;

22.过滤非法字符和无含义的字符,并进行分词处理;分词处理后得到的数据去停用词。

23.进一步的,所述s2对预处理后的化妆品评论数据进行正负样本的筛选与标注,包括:

24.s201:利用基于bert的电商评论情感分析模型,对预处理后的数据进行行化妆品评论的情感分析,判断文本内容为正向情绪或负向情绪;

25.结合评分进一步判定评论是否为虚假评论,如果评论判断为正向情绪并且评分小于评判标准3分(总分5分),则判定此评论为虚假评论;如果评论判断为负向情绪并且评分大于评判标准3分(总分5分),则判定此评论亦为虚假评论;

26.筛选并标注为虚假评论,作为负样本1;

27.s202:利用基于bert的通用文本匹配模型,将s201中未标注的数据进行化妆品评论的文本匹配,来寻找与虚假评论相似的文本,将大于相似度阈值ε的评论判定为虚假评论;

28.筛选并标注为虚假评论,作为负样本2;

29.s203:利用基于bert的文本内容反垃圾模型,将s202中未标注的数据进行化妆品评论的垃圾文本内容识别,其分类为正常、辱骂、涉政或恶意推广标签,将大于设定阈值的评论判定为虚假评论;

30.筛选并标注为虚假评论,作为负样本3;

31.s204:对s203中未标注数据进行过评论的用户的所有评论数量降序排列,将前k%的所有用户的评论判定为虚假评论;

32.筛选并标注为虚假评论,作为负样本4;

33.s205:将s204中未标注的数据根据化妆品评论对其他用户的有用程度降序排列,提取前面与已经筛选的负样本总数量相等的评论;

34.筛选并标注为正常评论,作为正样本;

35.s206:将上述s201-s205得到的所有正负样本汇总,得到一个正常评论和虚假评论条数相等的样本集,作为训练集。

36.进一步的,所述基于textcnn、bert和bilstm的化妆品评论文本特征提取方法包括:

37.(1)基于textcnn的化妆品评论文本特征提取方法具体包括:

38.卷积层特征公式为:

39.ci=f(w

·

x

i:i h-1

b)

40.卷积层输出矩阵为:

41.c=[c1,c2,c3,

…

,c

n-h 1

]

[0042]

其中,ci表示特征,f表示激活函数,w表示卷积核矩阵,x

i:j

表示输入矩阵x的第i行第j列,h表示卷积核高度,b表示偏置参数,n表示输入行数;

[0043]

池化层使用maxpool最大值池化方法,不定长的卷基层的输出上获得一个定长的全连接层的输入;

[0044]

进一步采用正则化的方法在倒数第二层加入dropout方法,防止隐藏层过拟合,并用l2范数约束权重向量;

[0045]

将训练集数据输入到textcnn模型,得到其文本特征矩阵;

[0046]

(2)基于bert的化妆品评论文本特征提取方法具体包括:

[0047]

bert模型具体设置如下:

[0048]

l=12,h=768,a=12,t=110*106;

[0049]

其中,l表示层数,即transformer blocks块的数量,h表示隐藏层的大小,a为自注意力的数量,t为所有参数的数量;

[0050]

第一个输入的token是特殊的符号[cls],它的含义是分类(class的缩写);bert将一串词向量作为输入,词向量在编码器encoder的栈中不断向上流动;每一层都会经过self-attention层,并通过一个前馈神经网络,然后将结果传给下一个编码器encoder;

[0051]

将训练集数据输入到bert预训练模型,得到其文本特征矩阵;

[0052]

(3)基于bilstm的化妆品评论文本特征提取方法具体包括:

[0053]

lstm加入了输入门、遗忘门、输出门和一个内部记忆单元c

t

。输入门控制当前计算新状态以多大程度更新到记忆单元;遗忘门控制前一步记忆单元中的信息有多大程度被遗忘;输出门控制当前输出有多大程度上取决于当前的记忆单元;

[0054]

前向的lstm与后向的lstm结合成双向bilstm;

[0055]

假设化妆品互联网评论通过分词处理后,得到n个词为:{x1,x2,

…

,xn},每个词经过词向量的映射得到对应的词向量ei,假设经过lstm后正向的输出为h

nr

,逆向的输出为h

nl

,则第n个词经过bilstm后得到的向量为:其中,表示的是对应向量元素相加;

[0056]

在bilstm的模型上加入attention层,在bilstm中用最后一个时序的输出向量作为特征向量。attention首先计算每个时序的权重,然后将所有时序的向量进行加权求和作为特征向量;

[0057]

假设h是所有词经过bilstm后得到的向量的集合:h=[h1,h2,

…

,hn],则attention计算方法如下:

[0058]

首先将h通过一个tanh激活函数,得到m=tanh(h),然后与一个维度为文本序列长度的参数矩阵p相乘,并通过softmax操作得到权值q=softmax(p

t

·

m);将q加到bilstm的输出结果上,得到句子最终的向量表示:v=h

·qt

;

[0059]

将训练集数据输入到bilstm模型,得到其文本特征矩阵。

[0060]

进一步的,所述s4融合三种模型提取的文本语义特征包括:

[0061]

将得到的基于textcnn模型的文本特征、基于bert预训练模型的文本特征和基于bilstm模型的文本特征,融合到同一维度,具体使用向量拼接concatenate方式实现;融合公式如下:

[0062]ei

=concat(ci,ti,bi)

[0063]

其中,ei表示三种模型拼接融合后的向量,ci表示基于textcnn模型的特征向量,ti表示基于bert模型的特征向量,bi表示基于bilstm模型的特征向量。

[0064]

进一步的,所述s5对特征赋予权重并训练分类器判定评论是否虚假,并训练调优得到最终模型,包括:

[0065]

在全连接层前引入attention注意力机制,给特征向量分配权重,公式如下:

[0066]

zg=ωz·ei

bz[0067]

其中,zg表示attention的输出序列,ωz表示权重矩阵,ei表示attention输入向量,bz表示偏差;

[0068]

将上述结果输入到全连接层训练,经过softmax层分类器,将化妆品评论分为正常评论和虚假评论两类,并进行反复训练调优模型,直到获得最终模型。

[0069]

进一步的,所述s6通过最终模型过滤化妆品互联网虚假评论,将所有未标注的化妆品评论输入到s5所得的最终模型,进行化妆品虚假评论的检测,若为虚假评论则过滤掉。

[0070]

本发明的有益效果包括:

[0071]

(1)本发明的基于语义分析过滤化妆品互联网虚假评论的方法,通过textcnn、bert和bilstm三种模型基于监督学习方法训练了一种自然语言处理模型,来过滤化妆品互联网虚假评论,能够从局部信息和全局信息全面有效地识别和筛选欺骗性评论、破坏性评论、非法评论等虚假评论,防止虚假评论误导其他用户消费和恶意攻击商家,为互联网化妆品商家和用户提供一个健康公平的电商平台;

[0072]

(2)本发明的基于语义分析过滤化妆品互联网虚假评论的方法,化妆品互联网评论数据的收集利用爬虫程序抓取互联网中海量的、综合的、多源的真实化妆品评论数据,综合海量化妆品评论信息能够更加准确地训练化妆品虚假评论识别模型,使模型更符合实际情况,能解决真实问题;对数据集进行清洗转换等预处理,让数据更准确可靠,降低垃圾数据对本发明识别准确性的影响,降低虚假评论识别的误差;

[0073]

(3)本发明的基于语义分析过滤化妆品互联网虚假评论的方法,基于性能优越的bert模型完成自然语言处理,对预处理后的化妆品评论数据进行正负样本的筛选与标注,bert预训练模型能够获取上下文相关的双向特征表示,语义分析更准确,并且不需要分词,支持文本分类任务,模型构建过程和步骤更加简单。此外,bert模型从多维度考虑了样本数据的特征,提高了对化妆品评论标记的准确性,也提高了训练集的数据质量;

[0074]

(4)基于文本卷积神经网络提取化妆品评论文本特征,其模型简单,训练速度快,文本特征提取准确全面,能够实时准确地发现互联网中化妆品虚假评论信息,及时提醒消费者;

[0075]

(5)本发明的基于语义分析过滤化妆品互联网虚假评论的方法,融合了三种模型提取的文本语义特征,对文本语义特征进行全方位多角度的扩充,更加完整准确地地提取文本特征,解决单一模型导致的文本特征不完善、分类准确率较低的问题;

[0076]

(6)本发明的基于语义分析过滤化妆品互联网虚假评论的方法,在全连接层前引入attention注意力机制,其参数少、速度快、训练效果好,通过对特征赋予权重能有效捕捉重点特征,不丢失重要信息。

[0077]

当然,实施本发明的任一产品并不一定需要同时达到以上所述的所有优点。

附图说明

[0078]

图1为本发明实施例所述基于语义分析过滤化妆品互联网虚假评论的方法流程图;

[0079]

图2为本发明实施例所述评论文本语义信息提取流程图;

[0080]

图3为本发明实施例所述textcnn特征提取方法示意图;

[0081]

图4为本发明实施例所述bert特征提取方法示意图;

[0082]

图5为本发明实施例所述bilstm特征提取方法示意图。

具体实施方式

[0083]

为了更清楚地说明本发明实施例的技术方案,下面将结合附图对实施例对本发明进行详细说明。

[0084]

基于语义分析过滤化妆品互联网虚假评论的方法,通过对预处理后的化妆品评论数据进行正负样本的筛选与标注,由textcnn、bert和bilstm对评论文本特征提取并融合提取的文本语义特征,对特征赋予权重并训练分类器判定评论是否虚假,并训练调优得到最终模型用于化妆品虚假评论的检测。

[0085]

下面结合具体实施例对本发明进行说明:

[0086]

实施例:

[0087]

如图1所示

[0088]

基于语义分析过滤化妆品互联网虚假评论的方法,包括以下步骤:

[0089]

s1:化妆品互联网评论数据收集及数据集预处理;

[0090]

s101:收集化妆品互联网评论数据;

[0091]

利用爬虫程序抓取各电商网站的化妆品评论数据,包括评论内容、评论分数和评论者信息;

[0092]

本实施例中,利用爬虫程序抓取互联网中真实的化妆品评论数据,能更加准确地训练化妆品虚假评论识别模型,使模型更符合实际,能解决真实问题;

[0093]

s102:对化妆品评论数据集进行预处理;

[0094]

设定评论长度阈值为10,删除评论文本长度小于10的评论;

[0095]

过滤非法字符和无含义的字符,例如数字序列、表情、符号、代码、标签等字符;

[0096]

对上述过滤步骤处理后得到的数据进行分词处理,本实施例中,使用中文分词工具jieba来进行分词操作,并删除标点符号;

[0097]

对分词处理后得到的数据去停用词。

[0098]

本实施例中,对数据进行清洗转换等预处理,让数据更可靠,降低垃圾数据对本发明的影响,降低虚假评论识别的误差。

[0099]

s2:对预处理后的化妆品评论数据进行正负样本的筛选与标注:

[0100]

s201:利用机器学习平台pai的bert电商评论情感分析模型,对预处理后的数据进行行化妆品评论的情感分析,判断文本内容为正向情绪或负向情绪;

[0101]

结合评分进一步判定评论是否为虚假评论,如果评论判断为正向情绪并且评分小于评判标准3分(总分5分),则判定此评论为虚假评论;如果评论判断为负向情绪并且评分大于评判标准3分(总分5分),则判定此评论亦为虚假评论;

[0102]

筛选并标注为虚假评论,作为负样本1;

[0103]

s202:利用机器学习平台pai的bert通用文本匹配模型,将s201中未标注的数据进行化妆品评论的文本匹配,来寻找与虚假评论相似的文本,将大于相似阈值0.98的评论判定为虚假评论;

[0104]

筛选并标注为虚假评论,作为负样本2;

[0105]

s203:利用机器学习平台pai的bert文本内容反垃圾模型,将s202中未标注的数据进行化妆品评论的垃圾文本内容识别,其分类为正常、辱骂、涉政或恶意推广标签,将大于设定阈值0.98的评论判定为虚假评论;

[0106]

筛选并标注为虚假评论,作为负样本3;

[0107]

s204:将s203中未标注的数据进行评论用户的评论数量降序排列,将前1%的所有用户的评论判定为虚假评论;

[0108]

筛选并标注为虚假评论,作为负样本4;

[0109]

s205:将s204中未标注的数据根据化妆品评论对其他用户的有用程度降序排列,提取与已经筛选的负样本总数量相等的评论;

[0110]

筛选并标注为正常评论,作为正样本;

[0111]

s206:将上述s201-s205得到的所有正负样本汇总,得到一个正常评论和虚假评论条数相等的样本集,作为训练集;

[0112]

本实施例中,基于bert模型,对预处理后的化妆品评论数据进行正负样本的筛选与标注。从多维度考虑样本数据的特征,既提高了对化妆品评论标记的准确性,也提高了训练集的质量。

[0113]

s3:基于textcnn、bert和bilstm的化妆品评论文本特征提取包括:

[0114]

(1)基于textcnn的化妆品评论文本特征提取方法具体包括:

[0115]

卷积层特征公式为:

[0116]ci

=f(w

·

x

i:i h-1

b)

[0117]

卷积层输出矩阵为:

[0118]

c=[c1,c2,c3,

…

,c

n-h 1

]

[0119]

其中,ci表示特征,f表示激活函数,w表示卷积核矩阵,x

i:j

表示输入矩阵x的第i行第j列,h表示卷积核高度,b表示偏置参数,n表示输入行数;

[0120]

池化层使用maxpool最大值池化方法,在不定长的卷基层的输出上获得一个定长的全连接层的输入;

[0121]

采用正则化的方法在倒数第二层加入dropout方法,防止隐藏层过拟合,并用l2范数约束权重向量;

[0122]

将训练集数据输入到textcnn模型,得到其文本特征矩阵;

[0123]

(2)基于bert的化妆品评论文本特征提取方法具体包括:

[0124]

bert模型设置如下:

[0125]

l=12,h=768,a=12,t=110*106;

[0126]

其中,l表示层数,即transformer blocks块的数量,h表示隐藏层的大小,a为自注意力的数量,t为所有参数的数量;

[0127]

第一个输入的token是特殊的符号[cls],它的含义是分类(class的缩写)。bert将一串词向量作为输入,词向量在编码器encoder的栈中不断向上流动。每一层都会经过self attention层,并通过一个前馈神经网络,然后将结果传给下一个编码器encoder;

[0128]

将训练集数据输入到bert预训练模型,得到其文本特征矩阵。

[0129]

(3)基于bilstm的化妆品评论文本特征提取方法具体包括:

[0130]

lstm加入了输入门、遗忘门、输出门和一个内部记忆单元c

t

。输入门控制当前计算新状态以多大程度更新到记忆单元;遗忘门控制前一步记忆单元中的信息有多大程度被遗忘;输出门控制当前输出有多大程度上取决于当前的记忆单元;

[0131]

前向的lstm与后向的lstm结合成双向bilstm;

[0132]

假设化妆品互联网评论通过分词处理后,得到n个词为:{x1,x2,

…

,xn},每个词经过词向量的映射得到对应的词向量ei,假设经过lstm后正向的输出为h

nr

,逆向的输出为h

nl

,则第n个词经过bilstm后得到的向量为:其中,表示的是对应向量元素相加;

[0133]

在bilstm的模型上加入attention层,在bilstm中用最后一个时序的输出向量作为特征向量。attention首先计算每个时序的权重,然后将所有时序的向量进行加权求和作为特征向量;

[0134]

假设h是所有词经过bilstm后得到的向量的集合:h=[h1,h2,

…

,hn],则attention计算方法如下:

[0135]

首先将h通过一个tanh激活函数,得到m=tanh(h),然后与一个维度为文本序列长度的参数矩阵p相乘,并通过softmax操作得到权值q=softmax(p

t

·

m);将q加到bilstm的输出结果上,得到句子最终的向量表示:v=h

·qt

;

[0136]

将训练集数据输入到bilstm模型,得到其文本特征矩阵。

[0137]

本实施例中,采用bert预训练模型提取化妆品评论文本特征,bert预训练模型能够获取上下文相关的双向特征表示,语义分析更准确,并且不需要分词,自动支持文本分类任务,模型构建过程和步骤更简单。

[0138]

s4:融合三种模型提取的文本语义特征包括:

[0139]

将得到的基于textcnn模型的文本特征、基于bert预训练模型的文本特征和基于bilstm模型的文本特征,融合到同一维度,具体使用向量拼接concatenate方式实现;融合公式如下:

[0140]ei

=concat(ci,ti,bi)

[0141]

其中,ei表示三种模型拼接融合后的向量,ci表示基于textcnn模型的特征向量,ti表示基于bert模型的特征向量,bi表示基于bilstm模型的特征向量;

[0142]

本实施例中,融合三种模型提取的文本语义特征,对文本语义特征进行扩充,更加完整地提取文本特征,解决单一模型导致的文本特征不完善、分类准确率较低的问题。

[0143]

s5:对特征赋予权重并训练分类器判定评论是否虚假,并训练调优得到最终模型,

包括:

[0144]

在全连接层前引入attention注意力机制,给特征向量分配权重,公式如下:

[0145]

zg=ωz·ei

bz[0146]

其中,zg表示attention的输出序列,ωz表示权重矩阵,ei表示attention输入向量,bz表示偏差;

[0147]

将上述结果输入到全连接层训练,经过softmax层分类器,将化妆品评论分为正常评论和虚假评论两类,并进行反复训练调优模型,直到获得最终模型;

[0148]

在全连接层前引入attention注意力机制,其参数少、速度快、训练效果好,对特征赋予权重能有效捕获重点,不丢失重要信息。

[0149]

s6:通过最终模型过滤化妆品互联网虚假评论,包括:

[0150]

将所有未标注的化妆品评论输入到s5所得的最终模型,进行化妆品虚假评论的检测,若为虚假评论则过滤掉;

[0151]

本发明通过三种深度学习模型训练化妆品评论识别模型,有效识别和过滤虚假评论,并且有效提升了虚假评论检验准确度。

[0152]

以上公开的本发明优选实施例只是用于帮助阐述本发明。优选实施例并没有详尽叙述所有的细节,也不限制该发明仅为所述的具体实施方式。显然,根据本说明书的内容,可作很多的修改和变化。本说明书选取并具体描述这些实施例,是为了更好地解释本发明的原理和实际应用,从而使所属技术领域技术人员能很好地理解和利用本发明。本发明仅受权利要求书及其全部范围和等效物的限制。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。