1.本发明属于人工智能领域,更具体地,涉及一种基于加权特征融合的语音表情多模态情感识别方法。

背景技术:

2.随着人工智能的飞速发展,情感识别作为人机交互的核心组成单元也被应用于许多领域,包括智能家居、旅游推荐系统、健康监测等。科研人员经过对情感识别的深入研究,逐渐形成一套被广泛使用的分类标准。在这套情感分类标准中,它被分为六类:生气、厌恶、恐惧、悲伤、惊讶和高兴。此外,情感识别主要包括语音、表情、生理信号情感识别。语音情感识别通过分析人讲话时的语速、语调、语义来识别人的情感状态。表情情感识别通过面部表情、肌肉走势来分析识别人的情感状态;生理信号情感识别通过分析人的呼吸、心率、血压、脑电信号和体温等生理信号来识别人的情感状态。其中,表情和语音情感识别被广泛、深入的研究,因为它可以简单、直观的构造表情和语音情感识别数据集。

3.科研人员对单模态的语音情感识别和表情情感识别进行了大量的研究,发现单模态情感识别所表达的情感信息不够完整,其识别率远不能达到人们的期望。此外,人类情感是融合多种模态的综合表现形式,且模态之间具有一定的互补性。例如,当人高兴的时候,通常脸上充满笑容,声音洪亮;当人生气的时候,通常脸部阴沉、瞪大眼睛、声音低沉、且血压、脑电信号和体温等各种生理信息也会发生变化,这些均表示人类情感是融合多种模态的综合表现形式,且模态之间具有互补性。因此,为充分利用各模态之间的互补性来提高情感识别的识别率,情感识别的研究重点逐渐由单模态向多模态转移。

4.多模态情感识别的核心是融合方法,包括决策层融合、模型层融合、特征层融合。决策层融合首先利用多个分类器识别每个模态的情感状态,然后采用均值、求和、乘积等决策规则进行融合。该融合方法原理简单、但是它未利用各个情感模态之间的互补性。模型层融合利用不同模态之间的相关性实现多模态情感识别,但是它需要综合考虑各个模态之间的特性,并需要具体实验确定模型层融合的参数,这严重限制了模型层融合的发展。

5.特征层融合首先提取各个模态的特征,然后进行融合并分类。该融合方法利用各个情感模态之间的互补性,其被广泛的应用在多模态情感识别中。

技术实现要素:

6.本发明的目的是提出一种基于加权特征融合的语音表情多模态情感识别方法,实现提高语音表情多模态情感识别的识别率。

7.为实现上述目的,本发明提出了一种基于加权特征融合的语音表情多模态情感识别方法,包括:

8.提取情感视频中的语音信息和表情信息进行分帧处理,提取语音关键帧和表情关键帧,并提取语音关键帧的mfcc特征;

9.将提取的语音关键帧和表情关键帧进行对齐处理,并通过利用语音和表情模态的

互补性计算加权特征融合中的语音权重和表情权重;

10.利用完成训练的残差网络提取所述语音mfcc特征中的语音高阶情感特征,并利用完成训练的3d-cnn神经网络提取所述表情关键帧中的表情高阶情感特征;

11.利用所述语音权重、所述表情权重分别对所述语音高阶情感特征和所述表情高阶情感特征进行加权,获得加权后的语音高阶情感特征和加权后的表情高阶情感特征;

12.将加权后的语音高阶情感特征和加权后的表情高阶情感特征输入到多层感知机mlp中进行加权特征融合并完成情感分类。

13.优选地,所述提取语音关键帧包括:

14.利用语音vad算法提取语音信息中的关键帧。

15.优选地,所述提取表情关键帧包括:

16.提取表情分帧中的脸部区域并利用信息熵提取表情关键帧。

17.优选地,所述提取语音mfcc特征包括:

18.对语音信息的高频部分进行补偿预处理;

19.采用fft变换将完成预处理的语音信息转为频域,获得语音信息的频谱;

20.利用梅尔滤波器组处理语音信息的频谱得到语音信息的梅尔频谱;

21.对得到语音信息的梅尔频谱进行频率分析,得到语音信息的梅尔倒谱;

22.基于得到语音信息的梅尔倒谱,利用离散余弦变换计算语音信息的mfcc特征;

23.计算语音信息mfcc特征的一阶差分和二阶差分。

24.优选地,所述通过利用语音和表情模态的互补性计算加权特征融合中的语音权重和表情权重,包括:

25.对语音关键帧和表情关键帧进行对齐处理后,判断对齐数据帧中的语音关键帧和表情关键帧是否为包含情感特征的有效关键帧;

26.若对齐数据帧中的语音关键帧和表情关键帧均为有效关键帧,则将语音关键帧和表情关键帧的权重均设置为1;

27.若对齐数据帧中的语音关键帧为有效关键帧,表情关键帧为无效关键帧,则将对齐数据帧中对应的表情关键帧的权重设置为0,并将对齐数据帧中对应的语音关键帧的权重设置为2;

28.若对齐数据帧中的表情关键帧为有效关键帧,语音关键帧为无效关键帧,则将对齐数据帧中对应的语音关键帧的权重设置为0,并将对齐数据帧中对应的表情关键帧的权重设置为2;

29.统计语音关键帧为有效关键帧且表情关键帧为无效关键帧的对齐数据帧的总帧数,以及表情关键帧为有效关键帧且语音关键帧为无效关键帧的对齐数据帧的总帧数;

30.基于表情关键帧的总帧数、语音关键帧的总帧数、表情关键帧为有效关键帧且语音关键帧为无效关键帧的对齐数据帧的总帧数、语音关键帧为有效关键帧且表情关键帧为无效关键帧的对齐数据帧的总帧数,计算加权特征融合中的语音权重和表情权重。

31.优选地,加权特征融合中的所述语音权重被定的计算公式为:

[0032][0033]

加权特征融合中的所述表情权重被定义为的计算公式为:

[0034][0035]

其中,其中,ws为加权特征融合中的语音权重,wv为加权特征融合中的表情权重,size(

·

)表示向量的长度,cv表示保存表情关键帧的位置参数的矢量,size(cv)表示表情关键帧的总帧数,cs表示保存语音关键帧的位置参数的矢量,size(cs)表示语音关键帧的种帧数,p为表情关键帧为有效关键帧且语音关键帧为无效关键帧的总帧数,q为语音关键帧为有效关键帧且表情关键帧为无效关键帧的对齐数据帧的总帧数。

[0036]

优选地,所述残差网络包括依次连接的5个相同结构的残差块以及2个全连接层,其中,每个所述残差块包括依次连接的2个卷积层、3个relu激活函数层和2个归一化层;

[0037]

其中,最后一个全连接层的神经元个数为2048。

[0038]

优选地,所述3d-cnn神经网络包括依次连接的七个卷积层、五个池化层和2个全连接层;

[0039]

其中,最后一个全连接层的神经元个数为2048。

[0040]

优选地,所述利用所述语音权重、所述表情权重分别对所述语音高阶情感特征和所述表情高阶情感特征进行加权,通过以下公式计算:

[0041][0042][0043]

其中,xw为加权后的语音高阶情感特征,yw为加权后的表情高阶情感特征,ws为语音权重,wv为表情权重,为所述残差网络输出的语音高阶情感特征,为所述3d-cnn输出的表情高阶情感特征的维度。

[0044]

优选地,所述多层感知机mlp包括输入层、两个隐藏层和输出层,其中,所述输入层包含4096个神经元,两个隐藏层分别包含2048个神经元和1024个神经元,所述输出层的神经元的数量等于情感类别的数量。

[0045]

本发明的有益效果在于:

[0046]

本发明的方法首先提取语音关键帧和表情关键帧,并提取语音mfcc特征,然后将提取的语音关键帧和表情关键帧进行对齐处理,并通过利用语音和表情模态的互补性计算加权特征融合中的语音权重和表情权重,之后利用完成训练的残差网络提取语音mfcc特征中的语音高阶情感特征,并利用完成训练的3d-cnn神经网络提取表情关键帧中的表情高阶情感特征,然后利用语音权重、表情权重分别对语音高阶情感特征和表情高阶情感特征进行加权,获得加权后的语音高阶情感特征和加权后的表情高阶情感特征,最后将加权后的语音高阶情感特征和加权后的表情高阶情感特征输入到多层感知机mlp中进行加权特征融合并完成情感分类,本发明充分利用语音和表情模态之间的互补性,采用语音和表情关键帧对齐技术并利用语音和表情模态的互补性计算加权特征融合中的语音和表情权重,通过这些权重被输进特征融合层mlp对语音高阶情感特征和表情高阶情感特征进行加权融合,有效地提高了多模态情感识别的识别率。

[0047]

本发明的系统具有其它的特性和优点,这些特性和优点从并入本文中的附图和随后的具体实施方式中将是显而易见的,或者将在并入本文中的附图和随后的具体实施方式

中进行详细陈述,这些附图和具体实施方式共同用于解释本发明的特定原理。

附图说明

[0048]

通过结合附图对本发明示例性实施例进行更详细的描述,本发明的上述以及其它目的、特征和优势将变得更加明显,在本发明示例性实施例中,相同的参考标号通常代表相同部件。

[0049]

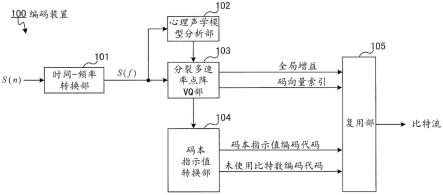

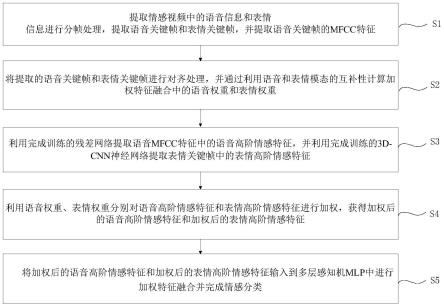

图1示出了本发明实施例的一种基于加权特征融合的语音表情多模态情感识别方法的步骤流程图。

[0050]

图2示出了本发明实施例的一种基于加权特征融合的语音表情多模态情感识别方法的原理图。

[0051]

图3示出了本发明实施例的一种基于加权特征融合的语音表情多模态情感识别方法中语音信息的mfcc特征图。

[0052]

图4示出了本发明实施例的情感识别方法在rml数据集上每类情感的识别率的实验结果。

[0053]

图5示出了本发明实施例的情感识别方法在enterface05数据集上每类情感的识别率的实验结果。

[0054]

图6示出了本发明实施例的情感识别方法在baum-1s数据集上每类情感的识别率的实验结果。

具体实施方式

[0055]

本发明基于特征层融合方法,提出了一种基于加权融合的语音表情多模态情感识别方法,首先提取各个模态的特征,然后进行融合并分类。其原理为:首先,情感视频被分为语音和表情信息,语音信息利用语音vad算法消除语音信息的噪声并保存语音关键帧,表情信息利用信息熵建模情感产生是一个连续过程并保存表情关键帧;然后,为充分利用语音和表情模态之间的互补性,并保存重要的情感信息,利用语音和表情关键帧对齐技术计算语音和表情的权重;其次,语音关键帧的mfcc特征和表情关键帧被分别输入到残差网络和3d-cnn中提取高阶语音和表情情感特征;最后,语音和表情高阶情感特征被输入到多层感知机(multilayer perceptron,mlp)中进行加权融合和情感分类,且加权融合的权重由语音和表情关键帧对齐技术计算,这充分地利用了语音和表情模态之间的互补性,有效地提高了语音表情多模态情感识别的识别率。

[0056]

下面将参照附图更详细地描述本发明。虽然附图中显示了本发明的优选实施例,然而应该理解,可以以各种形式实现本发明而不应被这里阐述的实施例所限制。相反,提供这些实施例是为了使本发明更加透彻和完整,并且能够将本发明的范围完整地传达给本领域的技术人员。

[0057]

实施例

[0058]

如图1所示,本实施例提供一种基于加权特征融合的语音表情多模态情感识别方法,该方法具体包括:

[0059]

s1:提取情感视频中的语音信息和表情信息进行分帧处理,提取语音关键帧和表情关键帧,并提取语音关键帧的mfcc特征;

[0060]

s2:将提取的语音关键帧和表情关键帧进行对齐处理,并通过利用语音和表情模态的互补性计算加权特征融合中的语音权重和表情权重;

[0061]

s3:利用完成训练的残差网络提取语音mfcc特征中的语音高阶情感特征,并利用完成训练的3d-cnn神经网络提取表情关键帧中的表情高阶情感特征;

[0062]

s4:利用语音权重、表情权重分别对语音高阶情感特征和表情高阶情感特征进行加权,获得加权后的语音高阶情感特征和加权后的表情高阶情感特征;

[0063]

s5:将加权后的语音高阶情感特征和加权后的表情高阶情感特征输入到多层感知机mlp中进行加权特征融合并完成情感分类。

[0064]

下面对本实施例的上述步骤进行具体解释说明。

[0065]

本实施例的基于加权特征融合的语音表情多模态情感识别方法的原理如图2所示,本实施例方法采用的网络模型主要包括预处理、残差网络、3d-cnn、加权特征融合层(多层感知机mlp)。

[0066]

执行s1:提取情感视频中的语音信息和表情信息进行分帧处理,提取语音关键帧和表情关键帧,并提取语音关键帧的mfcc特征。

[0067]

本步骤为预处理提取语音和表情关键帧并计算加权特征融合中的语音和表情权重。首先,情感视频被分为语音和表情信息,并被分帧为语音帧和表情帧;然后,语音帧利用语音vad算法提取语音关键帧并被提取语音mfcc特征;其次,表情帧被提取脸部区域并利用信息熵提取表情关键帧。

[0068]

具体过程包括如下步骤:

[0069]

s101:提取语音关键帧。

[0070]

具体地,语音信息分为语音段和噪声段,语音段包含情感特征,而噪声段的情感特征接近于零。这说明噪声段不但难以提高情感识别的性能,反而会造成数据污染来降低情感识别的性能。针对上述问题,本文利用语音vad算法消除语音信息的噪声段,并保存语音段作为语音关键帧。具体地,语音vad算法采用短时能量和过零率的双阈值检测方法,其中语音信息的短时能量定义为:

[0071][0072]

其中,x(m)表示语音信息,w(n-m)表示窗函数。

[0073]

语音信息的过零率被定义为:

[0074][0075]

其中,sgn[x(m)]是一个符号函数,它被定义为:

[0076][0077]

语音信息的语音段能量高、过零率低,噪声段能量低、过零率高。因此,通过短时能量和过零率设置双阈值,每一帧语音信息均被计算属于噪声段和语音段。语音信息的语音段被定义为语音关键帧sk,并定义一个矢量cs保存语音关键帧sk的位置参数i。

[0078]

s102:提取表情关键帧。

[0079]

具体地,表情信息包含脸部区域和背景区域,情感信息主要存在脸部区域。因此,本发明利用viola-jones方法提取表情信息的脸部区域,因为该方法首先利用积分图计算表情图像的一个或者多个矩阵特征,然后训练多个弱分类器,并利用adaboost方法对弱分类器进行强化,最后利用级联的方式进行分类,它是一种简单、方便的人脸检测方法。此外,情感的产生是一个连续的过程,即情感的产生一般经历如下步骤:开始、最大化、减少、结束。当提取情感最大化时的表情帧时,这有效地减少表情关键帧的冗余。此外,表情图像可以作为二维离散信号,通过信息熵计算情感信息,当图像信息熵越大,包含的信息越多,更好地反映图像的主要信息;当图像信息熵较小时,包含的信息较少,更难地反映图像的主要信息。因此,本发明基于信息熵和情感产生是一个连续的过程提取表情关键帧,具体的原理如下:

[0080]

首先,表情图像的信息熵被计算。对于大小为m

×

n,灰度范围为(0<l<256)的表情图像i,它在坐标(x,y)上的灰度值被定义为f(x,y),其取值范围为[0,l-1]。此外,定义第i个表情图像的灰度级j的个数为f

i,j

(x,y),那么灰度级j的概率定义为:

[0081][0082]

基于式(4),第i个表情图像的信息熵定义为:

[0083][0084]

n帧表情图像的平均信息熵被定义为:

[0085][0086]

基于式(5),每帧表情的信息熵被计算,并把n帧表情图像的信息熵的极大值定义为表情参考帧vr。因为情感产生是一个连续的过程,当表情图像的信息熵越大,它包含较多的情感信息,故表情参考帧vr包含较多的情感信息。此外,表情参考帧vr的位置参数i被定为cv。同时,为保证每一个表情参考帧vr都是有效的,表情参考帧vr应满足hi(i)>h

ave

。

[0087]

其次,表情关键帧被提取。由表情参考帧vr的定义可知,vr包含的情感信息高于其它帧,它被作为表情关键帧的一部分。然而,表情参考帧vr数量通常不能满足特征提取模型的要求。因此,需要选择其它帧也作为表情关键帧的一部分。本发明计算表情参考帧vr与其它原始表情帧之间的相似度来判断其它原始表情帧是否可以作为表情关键帧,因为其它帧越相似于表情参考帧vr,它包含越多的情感信息。在计算相似度时,采用常用的感知哈希算法和汉明距离。具体地,首先利用感知哈希算法计算表情帧的哈希指纹,然后利用汉明距离计算表情参考帧vr与其它原始表情帧之间的相似度。如果汉明距离小于10,两个表情帧相似,如果汉明距离大于10,两个表情帧不相似。最后将与表情参考帧vr相似的原始表情帧的位置参数i加入到cv中,并把cv中位置参数i对应的表情帧y(i)定义为表情关键帧vk。

[0088]

s103:提取语音关键帧的mfcc特征。

[0089]

具体地语音mfcc特征常用于语音识别,因为它基于倒谱特征,符合人类的听觉习

惯,是一种有效的语音特征提取方法。语音mfcc包括预处理、快速傅里叶变换(fast fourier transform,fft)、梅尔频谱、梅尔倒谱。

[0090]

具体原理如下:

[0091]

语音信息的高频部分会受到口腔、鼻腔的影响而造成失真,通常利用预处理对语音信息的高频部分进行补偿,其被表示为:

[0092]

x

pre

(n)=x(n)-ax(n-1)0.9<a<1.0 (9)

[0093]

其中,x

pre

(n)表示预处理后的语音信息,x(n)表示第n时刻的语音信息,a是一个经验值,它通常取值0.98。

[0094]

语音信息的频域更方便观察语音信息的特征,通常采用fft变换将语音信息转为频域,其被表示为:

[0095][0096]

其中,m表示每帧语音信息的fft的点数,它一般取值256或512。最后,通过计算式(10)的模的平方得到语音信息的频谱。

[0097]

利用梅尔滤波器组处理语音信息的频谱得到语音信息的梅尔频谱。其中,梅尔滤波器组通常选择三角滤波器,其被定义为:

[0098][0099]

其中,m表示梅尔频率,它与语音信息的频率f的关系被表示如下:

[0100][0101]

语音信息的梅尔频率被频率分析之后得到语音信息的梅尔倒谱。具体地,每个滤波器组输出的对数能量s(m)被计算,其被表示为:

[0102][0103]

利用离散余弦变换计算语音信息的mfcc特征c(n),其被表示为:

[0104][0105]

最后,计算语音信息mfcc特征的一阶差分d

t

,其被表示为:

[0106][0107]

其中,c

t

表示第t个语音信息的mfcc特征,k和q分别表示语音信息mfcc特征的时间差和阶数。此外,由式(15)和d

t

,可以计算语音信息的二阶差分。

[0108]

为更直观展示语音信息的mfcc特征,图3展示了语音信息的mfcc特征、一阶mfcc特征和二阶mfcc特征,以及梅尔倒谱图、一阶梅尔倒谱图、二阶梅尔倒谱图。其中,一阶和二阶mfcc特征分别由mfcc特征和式(15)计算得到,梅尔倒谱图由mfcc特征压缩得到。利用梅尔倒谱图、一阶梅尔倒谱图、二阶梅尔倒谱图模仿图像的rgb三通道,这有效地提取了语音信息的时间特征和空间特征,因为语音mfcc提取了语音信息的空间特征,语音mfcc的一阶和二阶差分有效地提取语音信息的时间特征。

[0109]

执行s2:将提取的语音关键帧和表情关键帧进行对齐处理,并通过利用语音和表情模态的互补性计算加权特征融合中的语音权重和表情权重;

[0110]

本步骤具体包括:

[0111]

对语音关键帧和表情关键帧进行对齐处理后,判断对齐数据帧中的语音关键帧和表情关键帧是否为包含情感特征的有效关键帧;

[0112]

若对齐数据帧中的语音关键帧和表情关键帧均为有效关键帧,则将语音关键帧和表情关键帧的权重均设置为1;

[0113]

若对齐数据帧中的语音关键帧为有效关键帧,表情关键帧为无效关键帧,则将对齐数据帧中对应的表情关键帧的权重设置为0,并将对齐数据帧中对应的语音关键帧的权重设置为2;

[0114]

若对齐数据帧中的表情关键帧为有效关键帧,语音关键帧为无效关键帧,则将对齐数据帧中对应的语音关键帧的权重设置为0,并将对齐数据帧中对应的表情关键帧的权重设置为2;

[0115]

统计语音关键帧为有效关键帧且表情关键帧为无效关键帧的对齐数据帧的总帧数,以及表情关键帧为有效关键帧且语音关键帧为无效关键帧的对齐数据帧的总帧数;

[0116]

基于表情关键帧的总帧数、语音关键帧的总帧数、表情关键帧为有效关键帧且语音关键帧为无效关键帧的对齐数据帧的总帧数、语音关键帧为有效关键帧且表情关键帧为无效关键帧的对齐数据帧的总帧数,计算加权特征融合中的语音权重和表情权重。

[0117]

具体地,将语音关键帧sk和表情关键帧vk对齐,对齐后的帧数据存在如下三种情况:

[0118]

1)语音信息不是有效关键帧,表情信息是有效关键帧。这种情况的帧数定义为p。

[0119]

2)语音信息是有效关键帧,表情信息不是有效关键帧。这种情况的帧数定义为q。

[0120]

3)语音信息是有效关键帧,表情信息是有效关键帧。这种情况的帧数定义为m。

[0121]

对于情况1),它应该被加强处理。例如,当人们过于惊讶而说不出话时,此时对应的语音关键帧不是有效关键帧,但人们的面部表情由于过度吃惊而提供更多的情感信息。在这种情况下,该帧的表情信息提供更多重要的情感信息,对于多模态情感识别尤为重要,需要重点处理。相似地,情况2)也需要重点处理。此外,特征层融合中的语音和表情高阶情感特征一般采用串联或并联的方式进行连接,这表明特征融合中语音和表情高阶情感特征的权重均为1。但是,这种特征融合方法未重点考虑情况1)和情况2),影响了多模态情感识别的性能。因此,本发明利用加权特征融合来重点处理情况1)和情况2),具体原理如下:

[0122]

首先,语音和表情关键帧的权重均设置为1,因为特征层融合时语音和表情高阶情感特征的权重均为1。其次,对于情况1)中的重要情感信息,语音和表情关键帧的情感权重为均为1,但是此帧的语音信息不是关键帧。为了处理这种情况,利用语音和表情模态之间的互补性,把语音关键帧的权重被转移到表情关键帧,即情况1)中的表情关键帧(有效关键帧)的权重为2。相似地,也利用语音和表情模态之间的互补性,把情况2)中的语音关键帧的权重设置为2。这种处理方式通过加大情况1)和情况2)的权重来重点处理重要的情感信息,有效的提高了多模态情感识别的性能。最后,基于上面的分析,语音和表情的权重被定义为:

[0123][0124][0125]

其中,ws为加权特征融合中的语音权重,wv为加权特征融合中的表情权重,size(

·

)表示向量的长度,cv表示保存表情关键帧的位置参数的矢量,size(cv)表示表情关键帧的总帧数,cs表示保存语音关键帧的位置参数的矢量,size(cs)表示语音关键帧的种帧数,p为表情关键帧为有效关键帧且语音关键帧为无效关键帧的总帧数,q为语音关键帧为有效关键帧且表情关键帧为无效关键帧的对齐数据帧的总帧数。

[0126]

由式(7)和(8)可知,情况1)和情况2)的帧数p和q越多,语音和表情的权重越大,越有利于多模态情感识别。

[0127]

执行s3:利用完成训练的残差网络提取语音mfcc特征中的语音高阶情感特征,并利用完成训练的3d-cnn神经网络提取表情关键帧中的表情高阶情感特征。

[0128]

具体地,如图2所示,残差网络提取语音的高阶情感特征,它包含5个相同结构的残差块(rb1-rb2-rb3-rb4-rb5)和2个全连接层(fc6-fc7)。其中,每一个残差块包含2个卷积层(cl1-cl2),3个relu激活函数层,2个归一化层(bn),具体的参数如表1所示。此外,全连接的fc7层的神经元个数是2048,这表示残差网络输出的语音高阶情感特征为

[0129]

表1残差网络的参数

[0130][0131]

残差网络的训练过程如下:首先,残差网络的fc7层之后添加一个softmax层,其实现六种情感的分类。然后,利用反向传播算法优化下式来更新残差网络的参数,其被表示为:

[0132][0133]

其中,k表示语音训练样本的个数,si表示第i个语音训练样本,θs表示残差网络的参数,yi表示标签,γs(si;θs)表示残差网络fc7层输出的高阶情感特征,softmax(γs(si;θs))表示softmax层输出的分类结果,表示损失函数,其被定义为:

[0134][0135]

其中,表示式(16)中的softmax(γs(si;θs)),l表示情感的类别:生气、厌恶、恐惧、悲伤、惊讶和高兴,其值设置为6。y

i,j

和分别表示第i个语音训练样本的第j个的情感类别的标签和fc7层输出的分类结果。

[0136]

进一步地,如图2所示,利用3d-cnn提取表情信息的高阶情感特征,它最初为动作识别设计的深度学习网络,后来也被应用在视频分类和多模态情感识别中,因为它利用三维卷积操作有效地提取情感视频的时间特征和空间特征。3d-cnn包含七个卷积层(cl1-cl2-cl3-cl4a-cl4b-cl5a-cl5b),五个池化层(pool1-pool2-pool3-pool4-pool5),2个全连接层(fc6-fc7),具体参数如表2所示。其中,3d-cnn的fc7层的神经元个数是2048,这表示3d-cnn输出的表情高阶情感特征的维度为此外,3d-cnn的训练过程相似于残差网络,只需把式(16)和(17)中的语音训练样本和语音标签修改为表情训练样本和表情标签即

可。

[0137]

表2 3d-cnn的参数表

[0138][0139]

执行s4-s5:利用语音权重、表情权重分别对语音高阶情感特征和表情高阶情感特征进行加权,获得加权后的语音高阶情感特征和加权后的表情高阶情感特征。将加权后的语音高阶情感特征和加权后的表情高阶情感特征输入到多层感知机mlp中进行加权特征融合并完成情感分类。

[0140]

如图2所示,残差网络和3d-cnn的fc7层输出的语音和表情高阶情感特征分别利用式(7)和(8)加权,它们被表示如下:

[0141][0142][0143]

加权后的高阶语音特征xw和表情特征yw被输入到多层感知机mlp中完成六种情感的分类。具体地,残差网络和3d-cnn的fc7层分别包含2048个神经元,故mlp的输入层包含4096个神经元。mlp的两个隐藏层分别包含2048个神经元和1024个神经元。mlp输出层神经元的数量等于情感类别的数量,定义为6。因此,mlp的结构为4096-2048-1024-6。此外,mlp的训练过程也相似于残差网络。

[0144]

本实施例中,还包括:

[0145]

步骤s6:对本实施例的方法的表情识别效果进行实验验证。

[0146]

首先,准备数据集。

[0147]

rml数据集是公开的语音表情情感识别数据集,由莱森多媒体实验室从八个不同

语言、口音和文化背景的受试者中收集。它包含720个情感视频片段,分别表达六种基本情感:生气、厌恶、恐惧、悲伤、惊讶和高兴。所有情感视频片段在安静明亮的环境下拍摄,采样率为22050hz,帧率为30fps。

[0148]

enterface05数据集是公开的语音表情情感识别数据集,从14个国家的42名受试者中收集。它包含1290个视频片段,分别表达了六种基本情感:生气、厌恶、恐惧、悲伤、惊讶和高兴。所有情感视频片段也是在安静明亮的环境下拍摄,采样率为48000hz,帧率为25fps。

[0149]

baum-1s数据集是公开的语音表情情感识别数据集,它包含1222个情感视频片段,只有521个情感视频片段表达了六种基本情感:生气、厌恶、恐惧、悲伤、惊讶和高兴。不同于enterface05和rml数据集,baum-1s数据集是受试者情感的自我表达。帧率为30fps。

[0150]

然后,设置实验参数:

[0151]

实验参数如表3所示,利用pytorch实现残差网络、3d-cnn和加权特征融合网络mlp。残差网络和3d-cnn先分别预训练,然后把fc7层输出的高阶语音和表情情感特征输入到加权特征融合网络mlp中进行训练。为获得更好的融合结果,训练mlp过程中,残差网络和3d-cnn的参数被固定。

[0152]

表3实验参数

[0153][0154]

进行消融实验:

[0155]

消融实验结果被展示在表4中,语音单模态和表情单模态分别采用图2中残差网络和3d-cnn实现六种情感的分类,语音表情多模态采用本实施例方法实现六种情感的分类。通过对比单模态和多模态的识别率可知,多模态融合有效地提高语音表情情感识别的识别

率,因为情感是融合多个模态的综合表现形式,各个模态之间具有互补性,而多模态融合可以利用模态之间的互补性,这有效地提高语音表情多模态情感识别的识别率。

[0156]

表4消融实验结果

[0157][0158][0159]

进行融合实验:

[0160]

由表5可知,本发明提出的加权特征融合的识别率高于特征层融合、平均决策融合、乘积决策融合。原因是:平均和乘积决策融合均是决策层融合,它们分别利用残差网络和3d-cnn识别六种情感,然后分别利用平均和决策规则进行融合。这两种融合方法相对于单模态情感识别提高了识别率,但是它未考虑语音和表情模态之间的互补性,导致识别率较低。特征层融合利用图2中的方法识别六种情感,只是未采用加权融合,该方法未处理上述步骤s2中情况1)和情况2)的重点信息,导致较低的识别率。相反,本发明的方法在特征层融合的基础上利用加权的方式重点处理了情况1)和情况2)的重点信息,有效地提高了语音表情情感识别的识别率。

[0161]

表5融合实验结果

[0162]

[0163][0164]

最后进行每个情感类别的实验。

[0165]

本实施例的方法在三个数据集上每一个情感类别的实验结果被分别展示在图4~图6。

[0166]

由图4~图6可知,生气、高兴、惊讶等高强度的情感类别更容易识别。

[0167]

以上已经描述了本发明的各实施例,上述说明是示例性的,并非穷尽性的,并且也不限于所披露的各实施例。在不偏离所说明的各实施例的范围和精神的情况下,对于本技术领域的普通技术人员来说许多修改和变更都是显而易见的。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。