一种基于改进cascade r-cnn的多物体抓取预测方法

技术领域

1.本发明属于图像检测和机器人抓取技术领域,涉及一种基于改进cascade r-cnn的多物体抓取预测方法。

背景技术:

2.对于机器人的平面抓取任务,首先需要计算的是给定物体的位姿。面对不同种类、形状和颜色的物体,需要对物体进行抓取标注,采用学习的方法让机器人模拟人抓取物体是一项重要的研究。康奈尔大学首先提出基于学习方式的抓取数据集(cornell grasp dataset),采用五参数表达抓取位姿,对于图像中每一个物体标注旋转抓取框,在实际抓取实验中也取得良好的表现,该研究称为抓取检测。很多针对物体抓取的现有实现方案主要是针对单物体进行抓取,对多物体的抓取研究较少。因此,亟需一种多物体抓取方法,解决复杂环境下多物体的机器人抓取与分类问题,提高协作型机器人与环境的交互能力,完成精准抓取。

技术实现要素:

3.为解决上述技术问题,本发明提供一种基于改进cascade r-cnn的多物体抓取预测方法,能在多物体场景下实现对多物体的准确抓取检测。

4.本发明提供一种基于改进cascade r-cnn的多物体抓取预测方法,包括:

5.步骤1:将摄像头固定在机械臂末端进行手眼标定和摄像头内参标定;

6.步骤2:通过摄像头拍摄包含多种物品的图像,构成原始图像数据集,为原始图像绘制抓取框并进行扩充处理,获得多目标抓取图像数据集;

7.步骤3:构建改进cascade r-cnn网络,并利用多目标抓取图像数据集对网络进行训练;

8.步骤4:通过摄像头获取rgb图像,并输入到改进cascade r-cnn网络中进而预测图像中每个物品的可行抓取框;

9.步骤5:机械臂根据预测的可行抓取框,确定物品位置并进行抓取。

10.在本发明的于多阶段神经网络的多物体抓取方法中,所述步骤1中的手眼标定具体为:

11.1)打印一个标定板,贴在平面上;

12.2)将机械臂移动到某个位姿,记录机械臂在当前位姿时末端的姿态;

13.3)使用机械臂上的相机,采集标定板在相机中的位姿,并记录;

14.4)将机械臂的位姿x和机械臂在位姿x时相机采集到标定板在相机中的位姿组成一组位姿信息;

15.5)重复2)、3)直到采集了17组以上位姿信息;

16.6)根据采集的多组位姿信息进行计算,获得关系转换矩阵。

17.在本发明的于多阶段神经网络的多物体抓取方法中,所述步骤1中的摄像头内参

标定具体为:

18.1)打印一张棋盘格并贴在一个平面上,作为标定物;

19.2)通过调整标定物或相机的方向,为标定物拍摄一些不同方向的照片;

20.3)从照片中提取棋盘格角点;

21.4)估算理想无畸变的情况下,五个内参和六个外参;

22.5)应用最小二乘法估算实际存在径向畸变下的畸变系数;

23.6)据径向畸变下的畸变系数,采用极大似然法,进行优化估算,得到相机的内参矩阵、径向畸变和切向畸变。

24.在本发明的于多阶段神经网络的多物体抓取方法中,所述步骤2包括:

25.步骤2.1:选取32类物品,将不同物品组合以不同姿态摆放,通过机械臂末端的摄像头拍摄原始图像,构成原始图像数据集;

26.步骤2.2:通过labmel软件为原始图像中的每个物品进行抓取框标注,使得每个图像具有抓取标签,包含抓取框的位置参数和角度分类;

27.步骤2.3:先将640

×

480的原始图像由中心向四周呈正方形裁剪,得到351

×

351的图像;

28.步骤2.4:然后向四周进行扩充75像素,采用opencv中的replicate模式,得到501

×

501图像;

29.步骤2.5:进行像素的沿水平方向和竖直方向的平移,再进行5次180

°

内随机角度的旋转,最后进行一次图像的resize,得到多张320

×

320的图像,进而获得相对于原始数据集100倍的扩充。

30.在本发明的于多阶段神经网络的多物体抓取方法中,所述步骤2.2中位置参数包括:抓取框的高度、宽度、质心坐标和抓取角度,所述抓取角度为抓取框高度方向与图像横轴的夹角;

31.所述角度分类为:在0

°

~180

°

内将各物品的抓取框与图像横轴方向的夹角分为18个类别。

32.在本发明的于多阶段神经网络的多物体抓取方法中,所述步骤3中的改进cascade r-cnn网络包括:resfpnet特征提取网络、区域建议网络和级联检测网络;所述resfpnet特征提取网络用于对输入的rgb图像进行特征提,生成多尺度融合的特征图;多尺度融合的特征图输入到所述区域建议网络中生成候选抓取框;候选抓取框投影到多尺度融合特征图上输入到级联检测网络中;级联检测网络用于进行角度分类评估以及候选抓取框的预测,最终提取出最优检测抓取框。

33.在本发明的于多阶段神经网络的多物体抓取方法中,resfpnet特征提取网络在resnext网络的基础上增加了带有空洞卷积的空间金字塔池化模块,在进行特征融合过程中使用带有空洞卷积的空间金字塔池化模块对浅层特征图进行上采样,再与上采样前的深层特征图融合。

34.在本发明的于多阶段神经网络的多物体抓取方法中,所述级联检测网络包括三个检测器,每个支路的检测器中均包含:池化层、全连接层和卷积层,池化层用于将特征图处理为固定大小,全连接层用于进行角度分类预测,卷积层用于进行候选抓取框预测,前一检测器的卷积层输出的候选抓取框投影到多尺度融合特征图上再输入到后一检测器中进行

角度分类预测和候选抓取框预测。

35.在本发明的于多阶段神经网络的多物体抓取方法中,所述改进cascade r-cnn网络中角度分类预测的损失函数是交叉熵,表示如下:

[0036][0037]

其中,θi表示的是角度分类标签值,表示的是角度分类预测值;

[0038]

对于抓取框的位置预测的损失函数,采用平方误差表示如下:

[0039][0040]

其中,xi,yi表示的是抓取框质心坐标标签值,表示的是抓取框质心坐标预测值;hi表示的是抓取框高度标签值,表示的是抓取框高度预测值;wi表示的是抓取框宽度标签值,表示的是抓取框宽度预测值。

[0041]

本发明的一种基于改进cascade r-cnn的多物体抓取预测方法,提出了一种改进cascade r-cnn网络,该网络由resfpnet特征提取网络、区域建议网络和级联检测网络构成,resfpnet特征提取网络是在resnext网络的基础上增加了带有空洞卷积的空间金字塔池化模块,进行特征融合时对浅层特征图进行上采样,再与上采样前的深层特征图融合,可以减少特征丢失。级联检测网络包括三个检测器,都包括全连接层和卷积层两个支路,可同时实现角度分类预测和候选抓取框预测。本发明方法可以在多物体场景下快速而准确的得到每个物体的抓取位姿,从而实现对未知物体的高准确度抓取。

附图说明

[0042]

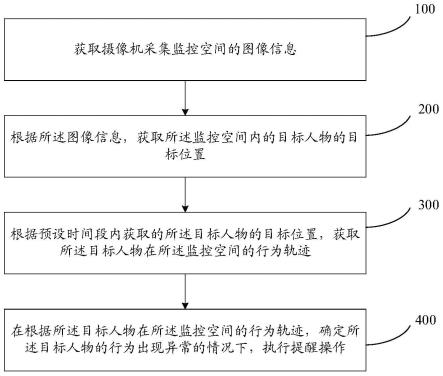

图1是本发明的一种基于改进cascade r-cnn的多物体抓取预测方法的流程图;

[0043]

图2是本发明的改进cascade r-cnn网络结构图。

具体实施方式

[0044]

如图1所示,本发明的一种基于改进cascade r-cnn的多物体抓取预测方法,包括:

[0045]

步骤1:将摄像头固定在机械臂末端进行手眼标定和摄像头内参标定;

[0046]

具体实施时,手眼标定具体为:

[0047]

1)打印一个标定板,贴在平面上;

[0048]

2)将机械臂移动到某个位姿,记录机械臂在当前位姿时末端的姿态;

[0049]

3)使用机械臂上的相机,采集标定板在相机中的位姿,并记录;

[0050]

4)将机械臂的位姿x和机械臂在位姿x时相机采集到标定板在相机中的位姿组成一组位姿信息;

[0051]

5)重复2)、3)直到采集了17组以上位姿信息;

[0052]

6)根据采集的多组位姿信息进行计算,获得关系转换矩阵。

[0053]

具体实施时,摄像头内参标定具体为:

[0054]

1)打印一张棋盘格并贴在一个平面上,作为标定物;

[0055]

2)通过调整标定物或相机的方向,为标定物拍摄一些不同方向的照片;

[0056]

3)从照片中提取棋盘格角点;

[0057]

4)估算理想无畸变的情况下,五个内参和六个外参;

[0058]

5)应用最小二乘法估算实际存在径向畸变下的畸变系数;

[0059]

6)据径向畸变下的畸变系数,采用极大似然法,进行优化估算,得到相机的内参矩阵、径向畸变和切向畸变。

[0060]

步骤2:通过摄像头拍摄包含多种物品的图像,构成原始图像数据集,为原始图像绘制抓取框并进行扩充处理,获得多目标抓取图像数据集,所述步骤2包括:

[0061]

步骤2.1:选取32类物品,将不同物品组合以不同姿态摆放,通过机械臂末端的摄像头拍摄原始图像,构成原始图像数据集;

[0062]

具体实施时,收集生活中常见的32类物品,每类物品可以选取不同样式的多个物品。拍摄时每张图片可以包含1个或多个物品,不同图像中物品的摆放姿态不同,共采集得到700张图像。

[0063]

步骤2.2:通过labmel软件为原始图像中的每个物品进行抓取框标注,使得每个图像具有抓取标签,包含抓取框的位置参数和角度分类;

[0064]

位置参数包括:抓取框的高度、宽度、质心坐标和抓取角度,所述抓取角度为抓取框高度方向与图像横轴的夹角;

[0065]

角度分类为:在0

°

~180

°

内将各物品的抓取框与图像横轴方向的夹角分为18个类别。

[0066]

步骤2.3:先将640

×

480的原始图像由中心向四周呈正方形裁剪,得到351

×

351的图像;

[0067]

步骤2.4:然后向四周进行扩充75像素,采用opencv中的replicate模式,得到501

×

501图像;

[0068]

步骤2.5:进行像素的沿水平方向和竖直方向的平移,再进行5次180

°

内随机角度的旋转,最后进行一次图像的resize,得到多张320

×

320的图像,进而获得相对于原始数据集100倍的扩充。

[0069]

制作的数据集,由于图像样本种类和数量以及时间的限制,数据量达不到大规模数据集的标准,容易导致模型欠拟合,网络无法学习到有效的特征,因此在进行网络训练之前,需要对数据集进行增强处理,数据增强的方法与单目标抓取检测的方法基本一致,同时需要考虑多目标在图片中的视野占比大于单目标,在进行旋转和平移的情况下,可能导致物体超出边界,对应的抓取框无效,故在此之前,需要对图片进行resize以及padding,保证物体不发生形变的同时,尽量使得物体保持在视野之中,剔除增强后无效的抓取框,采集得到的图片尺寸是640

×

480,经过增强后的图片尺寸是320

×

320,最后将生成的图像数据导入到符合coco目标检测数据集格式json文件中,生成的训练集图片45000张,测试集15000张,每个图像包含抓取框的位置参数、角度分类和物品类别信息。

[0070]

步骤3:构建改进cascade r-cnn网络,并利用多目标抓取图像数据集对网络进行训练;

[0071]

如图2所示为改进cascade r-cnn网络,包括:resfpnet特征提取网络、区域建议网络(rpn)和级联检测网络。所述resfpnet特征提取网络用于对输入的rgb图像进行特征提,

生成多尺度融合的特征图。多尺度融合的特征图输入到所述区域建议网络中生成候选抓取框。候选抓取框投影到多尺度融合特征图上输入到级联检测网络中。级联检测网络用于进行角度分类评估以及候选抓取框的预测,最终提取出最优检测抓取框。

[0072]

resfpnet特征提取网络在resnext网络的基础上增加了带有空洞卷积的空间金字塔池化模块,在进行特征融合过程中使用带有空洞卷积的空间金字塔池化模块对浅层特征图进行上采样,再与上采样前的深层特征图融合。以减少特征丢失。与普通卷积相比,空洞卷积多出了空洞率为rate的参数,其中rate控制感受野的大小,rate越大感受野越大。

[0073]

带空洞卷积的空间金字塔池化模块不仅可以扩大感受野,而且不影响图像的分辨率以及不增加额外计算量。因此,针对于不同尺度目标对应感受野的不同,本发明将三种不同空洞率的空洞卷积进行并联,然后经过上采样,这样可获取目标周边不同范围、不同大小的信息。不同的空洞卷积范围不相同,这样卷积后就保留范围不同的特征,有效减少特征损失。带空洞卷积的空间金字塔池化模块未改变特征图的大小,同时感受野范围随之控制,有利于提取多尺度信息。

[0074]

所述级联检测网络包括三个检测器,每个支路的检测器中均包含:池化层、全连接层和卷积层,池化层用于将特征图处理为固定大小,全连接层用于进行角度分类预测,卷积层用于进行候选抓取框预测,前一检测器的卷积层输出的候选抓取框投影到多尺度融合特征图上再输入到后一检测器中进行角度分类预测和候选抓取框预测。

[0075]

所述改进cascade r-cnn网络中角度分类预测的损失函数是交叉熵,表示如下:

[0076][0077]

其中,θi表示的是角度分类标签值,表示的是角度分类预测值;

[0078]

对于抓取框的位置预测的损失函数,采用平方误差表示如下:

[0079][0080]

其中,xi,yi表示的是抓取框质心坐标标签值,表示的是抓取框质心坐标预测值;hi表示的是抓取框高度标签值,表示的是抓取框高度预测值;wi表示的是抓取框宽度标签值,表示的是抓取框宽度预测值。

[0081]

步骤4:通过摄像头获取rgb图像,并输入到改进cascade r-cnn网络中进而预测图像中每个物品的可行抓取框;

[0082]

步骤5:机械臂根据预测的可行抓取框,确定物品位置并进行抓取。

[0083]

以上所述仅为本发明的较佳实施例,并不用以限制本发明的思想,凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。