1.本发明涉及生物识别技术领域,特别是涉及一种用于跨设备掌纹识别的对抗生成网络训练方法、跨设备掌纹识别方法及系统。

背景技术:

2.生物识别技术是指利用人体生物特征进行身份认证的一种技术。更具体一点,生物特征识别技术就是通过计算机与光学、声学、生物传感器和生物统计学原理等高科技手段密切结合,利用人体固有的生理特性和行为特征来进行个人身份的鉴定。生物识别技术被认为是最为方便与安全的识别技术。相较于传统的身份识别技术,生物特征识别具有唯一性、稳定性、方便性以及不易伪造和假冒等特点。生物识别技术应用越来越广泛,且较为成熟,在身份认证方面表现突出。全球众多厂商纷纷推出了基于生物特征识别技术的软硬件产品及行业解决方案,相关工程项目与应用方案在金融、电信、信息安全、生产制造、医疗卫生、电子政务、电子商务、军事等行业或领域得到广泛应用。

3.在生物特征中,掌纹图像便于采集,同时又包含了大量的特征,即使是由手机采集的低分辨率的掌纹图像也包含了可见的特征(如主线、皱纹、乳突纹、细节点和三角点等)及不可见的特征。相比于人脸识别,掌纹识别具有更高的稳定性和更良好的私密性,不易于伪造,且可以很好的区分双胞胎;相比于指纹识别,掌纹图像面积大,对分辨率要求低,不需要与采集设备进行接触;相比于视网膜、虹膜、静脉识别,掌纹图像采集设备造价低廉且更为方便;相比于步态、字迹、声音识别,掌纹识别稳定可靠,掌纹的形态主要由遗传基因控制,即使特殊原因导致表皮剥落,新生的纹路依然保持原有不变的结构。因此掌纹识别具有准确率高、用户易于接受、安全稳定性高等优点,拥有更为广泛的应用场合。

4.传统的生物识别技术中,采集生物特征的时候都需要用户在一定程度上进行配合,比如固定的角度、姿势、环境、与传感器进行接触等,降低了方便性。在需要与采集设备接触的情况下,更是牵扯到卫生问题。为了消除这些限制,研究了约束较少,甚至无约束的生物识别技术。通常来说,约束较少的生物识别技术拥有更短的数据获取时间、更好的可用性和更高的社会接受程度,进一步扩大了生物特征识别的应用场景。常见的非接触式生物识别技术有掌纹识别、人脸识别、指纹识别、虹膜识别、静脉识别、声音识别以及步态识别等。其中人脸识别、声音识别、步态识别的稳定性较低,易于伪造;指纹识别、虹膜识别、静脉识别对采集设备要求较高,不利于大面积推广。非接触式掌纹识别作为一种典型的无约束的生物识别技术,可以在手掌不接触传感器的情况下轻松地被智能手机采集到,在现实世界中具有广阔的应用前景,如智能移动设备的访问控制、基于智能移动终端的金融领域应用等。

5.在非接触式掌纹识别中,由于移除了接触式辅助定位装置,会由于采集时手掌发生的形变而对识别精度造成很大影响。没有辅助定位装置的约束,采集到的掌纹图像会存在各种各样的质量问题,如光照不均、掌纹形变、图像模糊等。而现有的基于接触式采集设备的识别算法,在这样的图像上无法取得令人满意的识别精度。

6.在实际应用中,掌纹识别系统往往会遇到两个问题。第一,训练数据存在缺失,如部分样本的数据丢失或因损毁导致不可用。第二,用于采集训练数据的设备往往与用于采集验证数据的设备是不同的。不同品牌手机摄像头的参数不同,也使得不同手机采集到的掌纹图像存在较大差异。因此不同手机采集来的掌纹数据,可以看作属于不同的域或模态。现有的掌纹识别方法在这种情况下往往并不能达到一个优秀的识别率。

技术实现要素:

7.本发明的目的是提供一种对抗生成网络训练方法、跨设备掌纹识别方法及系统,对于跨设备采集得到的掌纹进行补全,进而提高对于跨设备采集的掌纹的识别率。

8.为实现上述目的,本发明提供了如下方案:

9.本发明提供一种对抗生成网络训练方法,包括:

10.将样本集划分为训练组和待用组;所述样本集包括多张由不同设备采集得到的掌纹图像;

11.将所述训练组输入至自注意力循环对抗生成网络进行训练,以得到优化对抗生成网络;所述自注意力循环对抗生成网络包括生成器和判别器;所述生成器包括依次连接的第一卷积模块、第一自注意力模块、残差模块、第二自注意力模块和反卷积模块;

12.将所述待用组输入至所述优化对抗生成网络,以计算所述待用组中每个待用数据对应的质量分数;所述质量分数用于表征待用数据在所述优化对抗生成网络中的训练学习难易程度;

13.对多个所述质量分数进行升序,将升序后前k个质量分数对应的待用数据从所述待用组添加至所述训练组,以得到对应的更新后训练组和更新后待用组;

14.将所述训练组更新为所述更新后训练组,将所述待用组更新为所述更新后待用组,判断所述待用组中待用数据的数量是否为零;

15.若所述待用组中待用数据的数量不为零,则返回将所述训练组输入至自注意力循环对抗生成网络进行训练,以得到优化对抗生成网络的步骤;

16.若所述待用组中待用数据的数量为零,则将所述训练组输入至自注意力循环对抗生成网络进行训练,以得到最终对抗生成网络。

17.可选地,所述第一自注意力模块包括:

18.第一映射子模块,用于对所述第一卷积模块输出的特征数据进行第一卷积映射,以得到键数据;

19.第二映射子模块,用于对所述第一卷积模块输出的特征数据进行第二卷积映射,以得到查询数据;

20.第三映射子模块,用于对所述第一卷积模块输出的特征数据进行第二卷积映射,以得到值数据;

21.第一特征子模块,用于对所述键数据和所述查询数据进行第一点乘计算,然后对第一点乘结果进行归一处理,以得到自注意力特征图;

22.第二特征子模块,用于对所述值数据和所述自注意力特征图进行第二点乘计算,然后为第二点乘结果增加权重,以得到输出特征映射;

23.自注意力子模块,用于根据所述输出特征映射和所述第一卷积模块输出的特征数

据确定目标向量序列。

24.可选地,所述自注意力子模块,具体包括:

25.根据公式

26.y=γo x

27.确定目标向量序列;

28.其中,y表示目标向量序列,γ表示预设可学习的变量,o表示输出特征映射,x表示第一卷积模块输出的特征数据。

29.可选地,所述待用数据对应的质量分数的计算公式为:

[0030][0031][0032]

其中,score

x

表示第x生成图像的质量分数,所述第x生成图像为待用数据x输入至优化对抗生成网络后得到的生成图像;表示数学期望,x~p

data

(x)表示从数据分布p

data

(x)中采样得到样本x,f表示优化对抗生成网络中的第一生成器,g表示优化对抗生成网络中的第二生成器,|| ||1表示1范数;||f(g(x))-x||1表示样本x通过生成器f生成与y类似的x尖,再将x尖通过生成器g还原成的x与原始的样本x的相似性,||f(x)-x||1表示样本x通过生成器f生成的x与原始样本x的相似性;

[0033]

scorey表示第y生成图像的质量分数,所述第y生成图像为待用数据y输入至优化对抗生成网络后得到的生成图像;y~p

data

(y)表示从数据分布p

data

(y)中采样得到样本y;||g(f(y))-y||1表示样本y通过生成器g生成与x类似的y尖,再将y尖通过生成器f还原成的y与原始的样本y的相似性,||g(y)-y||1表示样本y通过生成器g生成的y与原始样本y的相似性。

[0034]

可选地,所述自注意力循环对抗生成网络的损失函数包括:

[0035][0036]

其中,x表示训练组中的第一类数据,y表示训练组中的第二类数据,且所述第一类数据与所述第二类数据为由不同设备采集得到的掌纹图像数据;g表示通过x生成y的生成器;f表示通过y生成x的生成器;d

x

表示判断掌纹图像数据是否属于x的判别器;dy表示判断掌纹图像数据是否属于y的判别器;表示损失函数,表示自注意力循环对抗生成网络的损失函数,表示对抗损失函数,表示循环一致性损失函数;λ表示调节权重的参数。

[0037]

可选地,所述第一卷积模块包括依次连接的第一反射填充子模块、第一卷积子模块、第二卷积子模块和第三卷积子模块;

[0038]

所述残差模块包括依次连接的多个残差子模块;

[0039]

所述反卷积模块包括依次连接的第一反卷积子模块、第二反卷积子模块、第二反射填充子模块、第四卷积子模块和激活模块。

[0040]

为达上述目的,本发明还提供了如下技术方案:

[0041]

一种跨设备掌纹识别方法,包括:

[0042]

获取第一设备采集的第一掌纹图像和第二设备采集的第二掌纹图像;

[0043]

将所述第一掌纹图像和所述第二掌纹图像分别输入至最终对抗生成网络,以得到对应的第三掌纹图像和第四掌纹图像;多个所述第一掌纹图像和对应的第三掌纹图像构成第一识别样本集,多个所述第二掌纹图像和对应的第四掌纹图像构成第二识别样本集;所述最终对抗生成网络是由对抗生成网络训练方法得到的;

[0044]

利用所述第一识别样本集训练分类器,以得到第一掌纹识别模型;

[0045]

利用所述第二识别样本集训练分类器,以得到第二掌纹识别模型;

[0046]

获取待识别掌纹图像;

[0047]

若所述待识别掌纹图像为所述第一设备采集,则将所述待识别掌纹图像输入至所述第一掌纹识别模型进行掌纹识别;

[0048]

若所述待识别掌纹图像为所述第二设备采集,则将所述待识别掌纹图像输入至所述第二掌纹识别模型进行掌纹识别。

[0049]

可选地,所述分类器为resnet-50网络。

[0050]

一种跨设备掌纹识别系统,包括:

[0051]

掌纹识别模型构建模块,用于:

[0052]

获取第一设备采集的第一掌纹图像和第二设备采集的第二掌纹图像;

[0053]

将所述第一掌纹图像和所述第二掌纹图像分别输入至最终对抗生成网络,以得到对应的第三掌纹图像和第四掌纹图像;多个所述第一掌纹图像和对应的第三掌纹图像构成第一识别样本集,多个所述第二掌纹图像和对应的第四掌纹图像构成第二识别样本集;所述最终对抗生成网络是由对抗生成网络训练方法得到的;

[0054]

利用所述第一识别样本集训练分类器,以得到第一掌纹识别模型;

[0055]

利用所述第二识别样本集训练分类器,以得到第二掌纹识别模型;

[0056]

待识别图像获取模块,用于获取待识别掌纹图像;

[0057]

掌纹识别模块,分别与所述掌纹识别模型构建模块和所述待识别图像获取模块连接,用于:

[0058]

当所述待识别掌纹图像为所述第一设备采集时,将所述待识别掌纹图像输入至所述第一掌纹识别模型进行掌纹识别;

[0059]

当所述待识别掌纹图像为所述第二设备采集时,将所述待识别掌纹图像输入至所述第二掌纹识别模型进行掌纹识别。

[0060]

根据本发明提供的具体实施例,本发明公开了以下技术效果:

[0061]

本发明提供了一种对抗生成网络训练方法、跨设备掌纹识别方法及系统,获取不同设备采集得到的掌纹图像,并分为训练组和待用组。利用训练组对自注意力循环对抗生成网络进行训练,利用待用组选取质量分数较低,即相对可靠的掌纹图像,并添加至训练组中进行训练,直至待用组中的所有数据均加入至模型训练,从而实现基于自步学习的模型训练,缓解非接触式掌纹图像的噪音和形变对数据补全工作和识别工作的影响。另外,自注意力循环对抗生成网络包括生成器和判别器,生成器中设置了自注意力模块,通过该自注意力模块的设置,能够使用较小的计算成本,捕捉长距离依赖;而生成器和判别器构成的对

抗生成网络,能够对不同设备采集到的掌纹进行补全,其不需要成对的图像,就可以实现从源域到目标域的图像风格转换。即通过循环对抗生成网络,可充分利用不同设备采集到的掌纹图像,对缺失数据进行弥补,使得生成的缺失图像既可以保留掌纹本身的生物特征信息,又可以符合缺失的设备采集到的图像风格,为进一步的掌纹识别提供更全面的数据基础,进而提高跨设备采集的掌纹的识别率。

附图说明

[0062]

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

[0063]

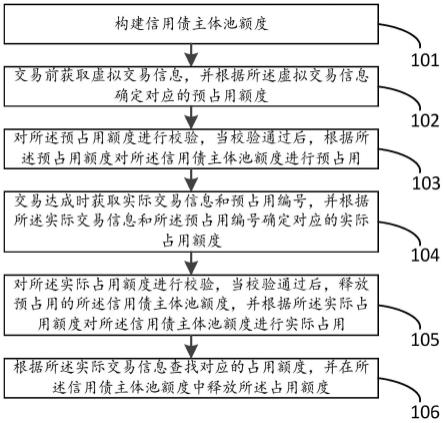

图1为本发明对抗生成网络训练方法的流程示意图;

[0064]

图2为本发明对抗生成网络训练实例结构图;

[0065]

图3为本发明自注意力循环对抗生成网络中损失函数计算的结构示意图一;

[0066]

图4为本发明自注意力循环对抗生成网络中损失函数计算的结构示意图二;

[0067]

图5为本发明自注意力循环对抗生成网络中损失函数计算的结构示意图三;

[0068]

图6为本发明第一自注意力模块的结构示意图;

[0069]

图7为本发明跨设备掌纹识别方法的流程示意图;

[0070]

图8为本发明跨设备掌纹识别系统的结构示意图。

具体实施方式

[0071]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0072]

要知道,实际应用中图像采集设备多种多样,比如不同型号的手机摄像头。在采集掌纹图像进行训练的时候,很难保证所有的掌纹图像都来自同一个设备,更多的情况是一部分用户使用设备a采集,一部分使用设备b进行采集。这导致无论是用设备a采集到的掌纹图像,还是设备b采集到的图像都是不完整的,而两部分图像合起来又包含了所有用户的信息。

[0073]

并且,不同设备采集到的图像风格也会不同,实际应用中无法将不同设备采集到的图像直接混合以后作为训练数据进行模型的训练,这样会导致掌纹识别准确率大幅下降。而两部分数据又分别缺少一部分用户数据,分开训练也无法实现理想的准确率。

[0074]

而本发明所采用的循环对抗生成网络能够将两种设备或者多种设备拍摄得到的不同风格的图像进行转换。以两种设备为例,将设备a采集到的图像风格转换为设备b的风格,同时也将设备b采集到的图像的风格转换为设备a的风格。通过循环对抗生成网络将两个设备采集到的图像风格转换后,得到符合设备b风格的图像和符合设备a风格的图像,这样就可以直接与原本由设备a和设备b采集到的图像进行混合,从而达到数据补全的目的。

[0075]

例:张三的掌纹由设备a采集,李四由设备b采集。直接使用两人采集到的图像训练

的话识别率很低。现通过循环对抗生成网络,生成风格与设备a很像的李四的掌纹图像和风格与设备b很像的张三的图像。这样用由设备a采集到的张三的图像和生成的风格与设备a相似的李四的图像组成训练数据进行训练,模型的识别率就会大大提高。原本缺失的由设备a采集的李四的掌纹数据由循环对抗生成网络生成出来了。

[0076]

为使本发明的目的、特征和优点能够更加明显易懂,下面结合附图和具体实施方式对本发明作进一步详细的说明。

[0077]

实施例一

[0078]

如图1所示,本实施例提供一种对抗生成网络训练方法,包括:

[0079]

步骤100,将样本集划分为训练组和待用组;所述样本集包括多张由不同设备采集得到的掌纹图像。

[0080]

对应图2中,训练组为待用组为训练组中数据的数量与待用组中数据的数量的比例可根据实际情况进行设置。

[0081]

步骤200,将所述训练组输入至自注意力循环对抗生成网络进行训练,以得到优化对抗生成网络;所述自注意力循环对抗生成网络包括生成器和判别器;所述生成器包括依次连接的第一卷积模块、第一自注意力模块、残差模块、第二自注意力模块和反卷积模块。所述判别器包括依次连接的多个卷积模块,具体的卷积模块的数量可根据需要进行设置,在本发明的一个具体实施例中,判别器包括三个依次连接的卷积模块。

[0082]

其中,第一卷积模块输入的图像进行特征提取,降低网络参数,保证网络的稀疏性,防止过拟合。第一自注意力模块让模型不仅仅考虑某个像素点,而是让模型自己选择感受野,从而减少对外部信息的依赖,捕捉到更多数据内部相关性。残差模块实现对图像风格的转换,对比传统的u-net结构,采用残差模块能够保证网络结构的复杂度,并且避免出现梯度消失问题。反卷积模块将图像特征还原到目标图像尺寸。

[0083]

具体地,所述第一卷积模块包括依次连接的第一反射填充子模块、第一卷积子模块、第二卷积子模块和第三卷积子模块;所述残差模块包括依次连接的多个残差子模块;所述反卷积模块包括依次连接的第一反卷积子模块、第二反卷积子模块、第二反射填充子模块、第四卷积子模块和激活模块。

[0084]

图3、图4和图5均为自注意力循环对抗生成网络中损失函数计算的结构示意图,图3中,x通过生成器g生成数据分布与y相似的数据,y通过生成器f生成类似x的数据,两个判别器分别对生成的图像进行判断,判断是否符合目标数据集的数据分布。图4和图5是同一个过程的两个方向。图4是掌纹图像x由g生成的图像y尖,再次通过f生成掌纹图像x尖,然后去计算x和x尖之间的差异损失。方向反过来就是图5。

[0085]

基于图3、图4和图5可得所述自注意力循环对抗生成网络的损失函数包括:

[0086][0087]

其中,x表示训练组中的第一类数据,y表示训练组中的第二类数据,且所述第一类数据与所述第二类数据为由不同设备采集得到的掌纹图像数据;g表示通过x生成y的生成器;f表示通过y生成x的生成器;d

x

表示判断掌纹图像数据是否属于x的判别器;dy表示判断掌纹图像数据是否属于y的判别器;表示损失函数,表示自注意力循环对抗生成网络的损失函数,具体表示同一性损失;表示对抗损失函数,对应图3中的部分

损失函数;表示循环一致性损失函数,对应图4和图5中的循环一致性损失函数(cycle-consistency loss);λ表示调节权重的参数。循环一致性损失函数需要采用图4和图5两部分进行计算是因为计算cycle-consistency loss的数据流转是一个圈,一张图表现不出来,而两者合起来才是一个完整的cycle-consistencyloss。公式中出现两次是因为图3中存在两个方向的损失,但是两个方向的损失的数学表达式不一样。

[0088]

自注意力机制注是注意力机制的变体,其减少了对外部信息的依赖,更擅长捕捉数据或特征的内部相关性。注意力机制来源于人类视觉注意力机制,简单来说是一种权重参数的分配机制,目标是协助模型捕捉重要信息。自我注意是一种特殊的注意机制,通过(key,query,value)的三元组提供了一种有效的捕捉全局上下文信息的建模方式,可以帮助实现点对点之间的对齐。

[0089]

所述第一自注意力模块包括第一映射子模块、第二映射子模块、第三映射子模块、第一特征子模块、第二特征子模块和自注意力子模块。如图6所示,第一映射子模块用于对所述第一卷积模块输出的特征数据进行第一卷积映射,以得到键数据;即将第一卷积模块输出的特征数据x映射至q空间,q(x)=wqx,wq表示q空间映射参数。第二映射子模块用于对所述第一卷积模块输出的特征数据进行第二卷积映射,以得到查询数据;即将第一卷积模块输出的特征数据映射至k空间,k(x)=wkx,wk表示k空间映射参数。第三映射子模块用于对所述第一卷积模块输出的特征数据进行第二卷积映射,以得到值数据;即将第一卷积模块输出的特征数据映射至v空间,v(x)=wvx,wv表示v空间映射参数。

[0090]

第一特征子模块用于对所述键数据和所述查询数据进行第一点乘计算,然后对第一点乘结果进行归一处理,以得到自注意力特征图;即a=softmax(qk

t

),a表示自注意力,即自注意力特征图;k

t

表示对映射到k空间的数据进行转置,qk

t

表示相乘,对应图6中圆圈里面一个乘号。第二特征子模块用于对所述值数据和所述自注意力特征图进行第二点乘计算,然后为第二点乘结果增加权重wf,以得到输出特征映射o;即o=f(av),f(x)=wfx。自注意力子模块用于根据所述输出特征映射和所述第一卷积模块输出的特征数据确定目标向量序列。具体地,根据公式y=γo x确定目标向量序列;其中,y表示目标向量序列,γ表示预设可学习的变量,o表示输出特征映射,x表示第一卷积模块输出的特征数据。

[0091]

第二自注意力模块的结构与第一自注意力模块的结构完全相同,在此不再赘述。

[0092]

步骤300,将所述待用组输入至所述优化对抗生成网络,以计算所述待用组中每个待用数据对应的质量分数;所述质量分数用于表征待用数据在所述优化对抗生成网络中的训练学习难易程度,换而言之,质量分数用来衡量生成图像质量,以间接反映训练学习难易度。质量分数越高,图像质量越低,学习难度越高。本发明采用类似于循环对抗生成网络损失函数的方法(cycle-consistency loss结构)来计算生成图像的质量分数,待用数据对应的质量分数的计算公式为:

[0093][0094]

其中,score

x

表示第x生成图像的质量分数,所述第x生成图像为待用数据x输入至优化对抗生成网络后得到的生成图像;表示数学期望,x~p

data

(x)表示从数据分布p

data

(x)中采样得到样本x,f表示优化对抗生成网络中的第一生成器,g表示优化对抗生成网络

中的第二生成器,|| ||1表示1范数;||f(g(x))-x||1表示样本x通过生成器f生成与y类似的x尖,再将x尖通过生成器g还原成的x与原始的样本x的相似性,||f(x)-x||1表示样本x通过生成器f生成的x与原始样本x的相似性。

[0095]

同理可得,类似的针对y的质量分数计算公式如下:

[0096][0097]

其中,scorey表示第y生成图像的质量分数,所述第y生成图像为待用数据y输入至优化对抗生成网络后得到的生成图像;y~p

data

(y)表示从数据分布p

data

(y)中采样得到样本y;||g(f(y))-y||1表示样本y通过生成器g生成与x类似的y尖,再将y尖通过生成器f还原成的y与原始的样本y的相似性,||g(y)-y||1表示样本y通过生成器g生成的y与原始样本y的相似性。

[0098]

步骤400,对多个所述质量分数进行升序,将升序后前k个质量分数对应的待用数据从所述待用组添加至所述训练组,以得到对应的更新后训练组和更新后待用组。具体地,添加至训练组的k个待用数据占待用组中所有待用数据的比例,是可根据实际情况进行设置的。

[0099]

步骤500,将所述训练组更新为所述更新后训练组,将所述待用组更新为所述更新后待用组,判断所述待用组中待用数据的数量是否为零。

[0100]

步骤600,若所述待用组中待用数据的数量不为零,则返回将所述训练组输入至自注意力循环对抗生成网络进行训练,以得到优化对抗生成网络的步骤;

[0101]

步骤700,若所述待用组中待用数据的数量为零,则将所述训练组输入至自注意力循环对抗生成网络进行训练,以得到最终对抗生成网络。

[0102]

自步学习的核心是挑选容易学习的数据,逐步加入到训练过程中,而不是一开始就让所有数据都参与到训练中,以图2为例,图中每一横排都是一次迭代,每次迭代分为训练和排序两个步骤。每次迭代开始时,数据会被分为训练数据和剩余数据两组。具体过程如下:

[0103]

第一次迭代:

[0104]

在所有数据(样本集)中,随机选取部分数据作为训练组剩下的数据作为待用组为训练组中数据的数量=样本集所有数据的量*r

ini

。r

ini

表示第一预设比例。

[0105]

训练步骤:训练组直接输入到自注意力循环对抗生成网络中进行训练,通过预设损失函数进行模型优化;损失函数收敛后训练结束。

[0106]

排序步骤:将待用组输入到训练完成的自注意力循环对抗生成网络中,计算每个生成图像的质量分数score,然后按照从低到高进行排序。选取分数最低的k个数据。k=待用组的数量*rk。rk表示第二预设比例。

[0107]

第一次迭代结束。

[0108]

第二次迭代:

[0109]

将上次迭代所得k个数据从剩余数据中取出,添加到训练分组中,得到更新后训练组更新后待用组为重复第一次迭代中的训练和排序步骤。其中参数rk保持不变。

[0110]

第n次迭代,即最后一次迭代,此时待用组中数据的数量为零:

[0111]

重复上述步骤直到最后一次迭代,将所有数据都作为训练数据加入到训练过程中,直到损失收敛后训练结束,得到最优的模型,即最终对抗生成网络。

[0112]

实施例二

[0113]

如图7所示,本实施例提供一种跨设备掌纹识别方法,包括:

[0114]

步骤10,获取第一设备采集的第一掌纹图像和第二设备采集的第二掌纹图像。

[0115]

步骤20,将所述第一掌纹图像和所述第二掌纹图像分别输入至最终对抗生成网络,以得到对应的第三掌纹图像和第四掌纹图像;多个所述第一掌纹图像和对应的第三掌纹图像构成第一识别样本集,多个所述第二掌纹图像和对应的第四掌纹图像构成第二识别样本集;所述最终对抗生成网络是由实施例一中所述的对抗生成网络训练方法得到的。

[0116]

步骤30,利用所述第一识别样本集训练分类器,以得到第一掌纹识别模型;所述分类器为resnet-50网络。

[0117]

步骤40,利用所述第二识别样本集训练分类器,以得到第二掌纹识别模型。

[0118]

步骤50,获取待识别掌纹图像。

[0119]

步骤60,若所述待识别掌纹图像为所述第一设备采集,则将所述待识别掌纹图像输入至所述第一掌纹识别模型进行掌纹识别。

[0120]

步骤70若所述待识别掌纹图像为所述第二设备采集,则将所述待识别掌纹图像输入至所述第二掌纹识别模型进行掌纹识别。

[0121]

具体算法如下:

[0122]

算法1自步学习训练策略。

[0123]

calscore()返回质量分数。

[0124]

rank()按照质量分数进行排序。

[0125]

top()返回得分最低的前k个图像。

[0126][0127]

实施例三

[0128]

如图8所示,为了执行上述实施例二对应的方法,以实现相应的功能和技术效果,本实施例提供了一种跨设备掌纹识别系统,包括:

[0129]

掌纹识别模型构建模块11,用于:

[0130]

获取第一设备采集的第一掌纹图像和第二设备采集的第二掌纹图像;

[0131]

将所述第一掌纹图像和所述第二掌纹图像分别输入至最终对抗生成网络,以得到对应的第三掌纹图像和第四掌纹图像;多个所述第一掌纹图像和对应的第三掌纹图像构成第一识别样本集,多个所述第二掌纹图像和对应的第四掌纹图像构成第二识别样本集;所述最终对抗生成网络是由实施例一中所述的对抗生成网络训练方法得到的;

[0132]

利用所述第一识别样本集训练分类器,以得到第一掌纹识别模型;

[0133]

利用所述第二识别样本集训练分类器,以得到第二掌纹识别模型。

[0134]

待识别图像获取模块21,用于获取待识别掌纹图像。

[0135]

掌纹识别模块31,分别与所述掌纹识别模型构建模块11和所述待识别图像获取模块21连接,用于:

[0136]

当所述待识别掌纹图像为所述第一设备采集时,将所述待识别掌纹图像输入至所述第一掌纹识别模型进行掌纹识别;

[0137]

当所述待识别掌纹图像为所述第二设备采集时,将所述待识别掌纹图像输入至所述第二掌纹识别模型进行掌纹识别。

[0138]

相对于现有技术,本发明还具有如下优点:

[0139]

本发明利用循环对抗生成网络来实现不同设备间的数据互补,一个是利用自注意力模型对循环对抗生成网络进行优化。相对于传统的训练方法是将数据全部输入到上文所提模型中计算损失函数,然后通过反向传播优化网络中的参数。本发明提出了通过自步学习的思想进行模型的训练,即在剩余数据中挑选容易学习的数据,逐步将所有数据投入到

训练过程中充分利用不同设备采集到的掌纹图像,对缺失数据进行弥补,使得生成的缺失图像既可以保留掌纹本身的生物特征信息,又可以符合缺失的设备采集到的图像风格,为进一步的掌纹识别提供更全面的数据基础,进而提高跨设备采集的掌纹的识别率。

[0140]

本说明书中各个实施例采用递进的方式描述,每个实施例重点说明的都是与其他实施例的不同之处,各个实施例之间相同相似部分互相参见即可。

[0141]

本文中应用了具体个例对本发明的原理及实施方式进行了阐述,以上实施例的说明只是用于帮助理解本发明的方法及其核心思想;同时,对于本领域的一般技术人员,依据本发明的思想,在具体实施方式及应用范围上均会有改变之处。综上所述,本说明书内容不应理解为对本发明的限制。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。