1.本发明涉及一种用于生成经训练的带至少一个不变积分层的卷积神经网络以对移动平台的环境的数字图像的对象进行分类的方法。

背景技术:

2.为了控制至少部分自动化移动平台,深度神经网络(英文deep neural network dnn)可以被用于包括对象的分类在内的各种任务,例如用于对周围交通成员的识别和分类、即对象识别。接着,可以依据对象识别的结果来控制该至少部分自动化移动平台。

3.dnn必须在使用大量标记数据的情况下被训练。然而,对数据的标记工作强度高、辛苦而且费时。因而重要的是:提高在训练dnn时的数据效率,以便减少所需的标记数据量,以便实现所希望的性能。

技术实现要素:

4.根据本发明的方面,提出了按照独立权利要求的特征的用于生成经训练的带至少一个不变积分层的卷积神经网络以对对象进行分类的方法、用于对二维数字图像中的对象进行分类的方法、卷积神经网络的用于对对象进行分类的应用、卷积神经网络的用于提供控制信号的应用、卷积神经网络、装置、计算机程序产品和机器可读存储介质。有利的设计方案是从属权利要求以及随后的描述的主题。

5.提出了一种用于利用多个训练周期来生成经训练的带至少一个不变积分层的卷积神经网络以对移动平台的环境的数字图像的对象进行分类的方法,其中每个训练周期具有如下步骤:在该训练周期的一个步骤中,提供移动平台的环境的具有至少一个对象的数字图像。在该训练周期的下一步骤中,提供被分配给该数字图像的参考图像,其中该至少一个对象在该参考图像中被标记。在该训练周期的下一步骤中,提供该数字图像,作为带至少一个不变积分层的卷积神经网络的输入信号。在该训练周期的下一步骤中,使带至少一个不变积分层的卷积神经网络匹配,以便在对该数字图像的至少一个对象进行分类时使该分类与相应的所分配的参考图像的偏差最小化。

6.为了对数字图像的对象进行分类,可以使用卷积神经网络。为了训练这种网络,使用参考图像、即在其中标记这些对象的图像。

7.神经网络提供用于机器学习、用于协作以及用于处理复杂的数据输入的多种不同算法的框架。这种神经网络学习依据示例来执行任务,而通常并不曾用特定于任务的规则来予以编程。

8.这种神经网络基于不同单元或节点的聚集,这些单元或节点称为人工神经元。每个连接都可以将信号从一个人工神经元传输到另一个人工神经元。接收到信号的人工神经元可以对该信号进行处理并且接着将其它与该人工神经元连接的人工神经元激活。

9.在神经网络的常规的实现方案中,在人工神经元的连接处的信号是实数,而且人

工神经元的输出通过该人工神经元的输入之和的非线性函数来被计算。这些人工神经元的连接通常具有权重,该权重随着学习进行而适配。该权重使在连接处的信号的强度提高或降低。人工神经元可具有阈,使得只有当总信号超过该阈时才输出信号。通常,多个人工神经元分层组合。不同的层可能针对它们的输入执行不同类型的变换。信号可能在多次遍历这些层之后从第一层、即输入层到达最后一层、即输出层。

10.这种人工神经网络的架构可以是根据多层感知器(multi-layer-perceptron,mlp)网络来构造的神经网络。多层感知器(mlp)网络属于人工前馈(feed-forward)神经网络家族。原则上,mlp由至少三个神经元层组成:输入层、中间层(hidden layer(隐藏层))和输出层。这意味着该网络的所有神经元都被分层,其中一层的一个神经元总是与下一层的所有神经元连接。不存在到上一层的连接而且不存在跳过一层的连接。除了输入层之外,还存在不同的神经元层,这些神经元具有非线性激活函数并且与下一层的神经元连接。深度神经网络可具有四个这种中间层。

11.这种卷积神经网络必须针对它们特定的任务来予以训练。在此,神经网络的相对应的架构的每个神经元例如都获得随机的初始权重。接着,将输入数据发到网络中,并且每个神经元都以其权重来对输入信号进行加权并且将结果继续交给下一层的神经元。接着,在输出(output)层提供总结果。误差的大小可以被计算,以及每个神经元占该误差的份额可以被计算,而且接着每个神经元的权重都朝着使该误差最小化的方向改变。接着,递归地进行遍历,重新测量该误差并且使这些权重适配,直至该误差低于预先给定的极限。

12.不变积分层是神经网络的一层,该层借助于通过不变函数对卷积层的输出特征图的变换群的积分来确定群均值矩阵,其中该不变积分层在更下文还更详细地被描述。在此,在使具有该不变积分层的卷积神经网络匹配时,也使该不变积分层的参数匹配。

13.通过使用具有执行不变积分的新的卷积神经网络层的卷积神经网络,将几何先验知识包含在内,其方式是显式地确保待分类对象的不变特性,如旋转不变性和/或平移不变性和/或缩放不变性和/或仿射变换的不变性。在此提高了数据效率,原因在于对于神经网络的训练来说对于所限定的精度需要更少的数据和/或在数据数量相同的情况下精度得以提高。

14.因此,使用该方法能够减少对训练数据进行标记的时间花费和成本花费,原因在于可以减少所需的标记数据量,以便实现这样构造的神经网络的所希望的性能。

15.在此,这里所描述的具有不变积分的网络层可微分,以便借此能够借助于反向传播来实现卷积神经网络的匹配。

16.在本发明的该总体描述中,方法步骤的顺序现在被描述为使得该方法易于理解。但是,本领域技术人员将认识到:这些方法步骤中的多个方法步骤也可以以另一顺序来被遍历并且得出相同或相对应的结果。在这个意义上,可以相对应地改变这些方法步骤的顺序。一些特征配备有数字,以便改善可读性或者使分配更加明确,但是这并不意味着存在特定的特征。

17.按照该方法的一个方面,提出:带至少一个不变积分层的卷积神经网络具有至少一个卷积层和至少一个不变积分层,而且该不变积分层借助于通过该卷积层的不变函数对该卷积层的输出特征图的变换群的积分来确定群均值矩阵。

18.在此,该群均值矩阵可以根据如下公式来被确定:

其中x:是3d张量,该3d张量包括特征图,尺寸为:高度 x 宽度 x 通道;f:是由至少一个函数组成的向量;g:是特征图的变换,并且g描述了来自变换群g中的单个变换。

19.其中群均值a通过不变函数f对作用于输入空间x的变换g ∈ g的积分来被定义。

20.即,该不变积分层在群等变神经网络特征空间上被使用,该群等变神经网络特征空间借助于等变卷积层来被计算。

21.因此,可以通过变换群g关于现有问题引入关于诸如旋转不变性和/或平移不变性和/或缩放不变性和/或仿射变换的不变性等不变性的专业知识。

22.群论构成不变积分的基础。群g是由元素集合组成的数学抽象,在闭合、结合性、中性元素和可逆性公理下的操作作用于这些元素。

23.如果可以确定在函数f的输入x(特征图为多重;特征空间)的变换g ∈ g与该函数的输出的相对应的变换g' ∈ g之间的精确关系,则该函数被视为关于变换群g是等变的。其中撇号旨在表示输出的变换与输入x的变换不完全相同;在此,得出等变性的数学定义为:其中f:由至少一个不变或等变函数组成的向量;f(x) :等变特征空间;x:3d张量,该3d张量包括特征图。高度 x 宽度 x 通道;g: 特征图的变换;g': 函数的输出值的变换。

24.对于等变函数,输出变换是可预先确定的;对于不变函数,该输出变换是恒等式(例如乘法中的1)。因此,得出不变性的数学定义为:等变函数的示例是卷积层,该卷积层对于平移是等变的。在实践中,也有兴趣贯彻除平移以外的其它变换群、例如旋转、缩放或仿射变换的不变性。不变积分是一种用于关于对称变换构造完整的特征空间的算法。

25.如果所有关于变换群g等价的模式都被映射到特征空间中的同一点,而所有不同的模式都被映射到不同的点,则特征空间被定义为完整。这意味着:整个特征空间相对于输入信号的变换g ∈ g而言是不变的。

26.为此可以使输入特征归一化,其中使用在训练期间所确定的逐通道最小值。

27.xi= max (ε, xiꢀ‑ꢀ

x

min 1),其中 0 《 ε

ꢀ≪ꢀ

1由此来防止不变积分层的指数和输入的梯度消失,由此能够使用反向传播算法。

28.按照本发明的一个方面,提出:不变函数f是卷积层的输出特征图的单项式。

29.在此,单项式是多项式的一种特殊形式,该单项式仅包含一项并且按如下来被定义:其中x:3d张量,该3d张量包括特征图,尺寸为:高度 x 宽度 x 通道;f:由至少一个函数组成的向量;m:单项式;g:是特征图的变换,并且g描述了来自变换群g中的单个变换:k:单项式阶数,即输入特征的大小;:单项式指数,该单项式指数在使神经网络匹配时被适配。

30.对于不变函数f来说,所有可能的单项式m(x)的集合是用于生成完整的特征空间的不错的选择。

31.群论可以表明:在不变积分中使用单项式时,变换不变的特征通过该不变积分来被抑制,并且变换不变的特征相对于其它特征的差异借此被放大。

32.所有可能的单项式的数量的上限是,但不是全部都被计算,原因在于它是一个非常高的值。系数bi在神经网络的训练期间被训练。

33.按照该方法的一个方面,提出:该变换是旋转和/或平移。

34.在此,群均值矩阵或群均值向量可以根据如下公式来被确定:其中x:3d张量,该3d张量包括特征图,尺寸为:高度 x 宽度 x 通道;f:由至少一个函数组成的向量;g:是特征图的变换,并且g描述了来自变换群g中的单个变换:k:单项式阶数;u、v:是在特征图上的像素位置;:单项式距离;:单项式指数,该单项式指数在使神经网络匹配时被适配;和:旋转角度。

35.按照该方法的一个方面,提出:该变换是旋转和/或平移和/或缩放。

36.在此,群均值矩阵或群均值向量可以根据如下公式来被确定:其中x:3d张量,该3d张量包括特征图,尺寸为:高度 x 宽度 x 通道;f:由至少一个函数组成的向量;g:是特征图的变换,并且g描述了来自变换群g中的单个变换:k:单项式阶数;u、v:是在特征图上的像素位置;:单项式距离;:单项式指数,该单项式指数在使神经网络匹配时被适配;:旋转角度;和s:缩放因子。

37.不变积分层计算群均值,以便在使用一组单项式m(x)的情况下显式地约束不变特征空间,例如通过对二维平移(u, v)、缩放(s)和旋转φ的群的积分。在此,可以在使用任意变换群g的单项式的情况下计算群平均。

38.有利地,从该不变积分层中得出:对象识别相对于相关对象的旋转、缩放和平移而言是不变的。由此,从鸟瞰图来看,例如车辆在对象分类时与其在数字图像上的取向无关。

39.按照该方法的一个方面,提出:不变积分通过在公式1中所描述的关系来被确定:

(1)其中参数如上所述:k:单项式阶数;u、v:在特征图上的像素位置;:单项式距离;:单项式指数;x:3d张量,该3d张量包括特征图;和:旋转角度。

40.按照该方法的一个方面,提出:不变积分通过在公式2中所描述的关系来被确定:(2)其中参数如上所述:k:单项式阶数;u、v:在特征图上的像素位置;:单项式距离;:单项式指数;x:3d张量,该3d张量包括特征图;:旋转角度;和s:缩放因子。

41.按照该方法的一个方面,提出:对单项式进行参数化,而且随机生成单项式的参数,而且从随机生成的参数中选择经优化的参数。

42.借助于迭代方法来选择单项式的参数,即阶数、距离和指数。

43.如果需要m个单项式(例如m=5),则随机选择m 1个(例如6个)参数组合。对于由m个参数组成的m 1个可能组合中的每个组合,计算线性分类器及其验证精度。未曾在表现最好的分类器中使用的参数组合被丢弃并且由新的、随机选择的组合来替代。该过程被重复一定数量(例如100次)的步骤,以便找到最优的m个参数组合。

44.这种选择单项式的参数、即阶数、距离和指数的方法简单且快速。

45.替代地,借助于剪枝(pruning)方法来选择单项式的参数,即阶数、距离和指数。如果需要m个单项式(例如m=5),则随机选择n》m个(例如100个)参数组合。借助于n个单项式来对神经网络进行预训练,并且借助于剪枝方法来直接或迭代地确定对该网络的正确分类做出最大贡献的n个参数组合。对分类的贡献例如可以通过在单项式的输出处的权重的绝对值之和来被确定。这些选择单项式的参数、即阶数、距离和指数的方法简单、快速,而且能够实现对该网络的直接的端到端训练。

46.按照该方法的一个方面,提出:卷积神经网络具有多个卷积层,在该不变积分层确定群均值矩阵之前,所述多个卷积层突出对于对象的分类来说重要的特征。由此,对于对象分类来说重要的特征被突出。

47.这种提取对于该分类来说重要的特征的方法减少了用于计算不变积分的计算花费。例如,在此丢弃关于对象的平移和/或颜色的对于分类来说不重要的信息。

48.提出了一种用于对在移动平台的环境的数字图像、尤其是二维数字图像中的对象进行分类的方法,该方法具有如下步骤:在第一步骤中,提供移动平台的环境的数字图像。在下一步骤中,借助于经训练的带至少一个不变积分层的卷积神经网络,根据上述方法之一以及作为带至少一个不变积分层的卷积神经网络的输入信号的数字图像,按照多个对象类别来对该数字图像进行分类,其中带至少一个不变积分层的卷积神经网络已借助于多个数字参考图像以及相应的数字参考图像的经分类的对象来被训练为关于所述多个对象类别来对这些数字参考图像的对象进行分类;而且对该数字图像的对象进行分类。

49.这种对象分类方法尤其适合于至少部分自动化移动平台,诸如适合于自主车辆。

50.提出了带至少一个不变积分层的卷积神经网络的用于对在移动平台的环境的数字图像中的对象进行分类的应用,该卷积神经网络是根据上述方法之一来被训练的。

51.由于不变积分层是卷积神经网络的一部分,得出精度更高的优点,如上文已经解释过的那样,或者需要更少的标记数据以满足分类任务的特定精度。

52.提出了根据上述方法之一来被训练的带至少一个不变积分层的卷积神经网络的用于对在移动平台的环境的数字图像中的对象进行分类的应用,其中基于该分类的结果来提供用于操控至少部分自动化移动平台的控制信号和/或基于该分类的结果来提供用于向至少部分自动化移动平台的乘员报警的报警信号。

53.术语“基于”应关于“基于该分类的结果来提供控制信号”的特征广义地理解。该术语应被理解为使得:根据该分类的结果,使用对控制信号的任何确定或计算,其中这并不排除也还使用其它输入参量用于对控制信号的这种确定。这相对应地适用于对报警信号的提供。

54.有利地,从对至少部分自动化移动平台的环境的对象的分类中,得出根据经分类的并且被探测到的对象来控制该移动平台的可能性,例如以便避免事故。

55.按照一个方面,说明了一种带至少一个不变积分层的卷积神经网络,该卷积神经网络是根据上述方法之一来被训练的。

56.利用这种卷积神经网络,所描述的分类任务可以轻易被集成到不同系统中。

57.按照一个方面,说明了一种装置,该装置具有带至少一个不变积分层的卷积神经网络,该卷积神经网络是根据上述方法之一来被训练的。

58.利用这种装置,相对应的方法可以轻易被集成到不同系统中。

59.按照一个方面,说明了一种计算机程序,该计算机程序包括指令,在通过计算机来执行该计算机程序时,这些指令促使该计算机来执行上述方法之一。这种计算机程序使得所描述的方法能够在不同系统中使用。

60.说明了一种机器可读存储介质,在其上存储有上述计算机程序。借助于这种机器可读存储介质,能转移上述计算机程序。

61.移动平台可以被理解为至少部分自动化的移动系统和/或驾驶员辅助系统。示例可以是自动部分自动化的车辆或具有驾驶员辅助系统的车辆。也就是说,在该上下文中,至少部分自动化的系统包含关于至少部分自动化的功能性的移动平台,但是移动平台也包含车辆和其它包括驾驶员辅助系统在内的移动机械。移动平台的其它示例可以是;具有多个传感器的驾驶员辅助系统;移动多传感器机器人,诸如机器人吸尘器或割草机;多传感器监控系统;制造机器;私人助理;或者访问控制系统。这些系统中的每个系统都可能是完全或部分自动化的系统。

62.说明了一种装置,该装置被设立为执行上述方法之一。

63.借助于这种装置,可能的是:使上述方法例如可用于嵌入到移动平台中。

64.说明了一种计算机程序,该计算机程序包括指令,在通过计算机来执行该程序时,这些指令促使该计算机来执行上述方法之一。

65.借助于这种计算机程序,上述方法例如可以以简单的方式和方法能被用于移动平台。

66.说明了一种机器可读存储介质,在其上存储有上述计算机程序。

67.借助于这种机器可读存储介质,能转移上述计算机程序产品。

附图说明

68.本发明的实施例参考图1来示出并且在下文更详细地予以阐述。其中:图1示出了用于利用经训练的带至少一个不变积分层的卷积神经网络来对移动平台的环境的数字图像的对象进行分类的方法。

具体实施方式

69.图1示意性示出了图像110如何在步骤s1中利用带不变积分层的神经网络的多个卷积层来被转换成特征图120。在步骤s2中,执行对特征图120的不变积分并且创建群均值向量130。接着,带不变积分层的卷积神经网络的后续的全连接层利用步骤s3来得出分类向量140,从该分类向量中能读取对象的相对应的分类结果。

70.用于分类的不变神经网络的架构通常由2个部分构成。第一部分是等变层序列,用于将信号下采样到更小的分辨率,目的在于获得所期望的数据并且丢弃冗余信息。由于层的等变性,当层的输入以预先确定的方式(例如旋转)被变换时,卷积层的输出会发生可预测的变化。

71.在第二部分中,等变特征空间被转换成不变特征空间,在输入的变换时,该不变特征空间不发生变化。为此,使用不变积分层。基于以这种方式获得的特征,使用多个全连接层,以便获得分类结果。

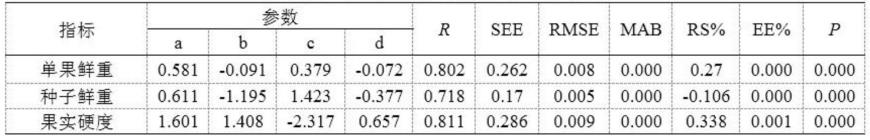

72.在表格1中列举了不变神经网络的架构的示例。用于获得等变特征的部分由d个连续的等变卷积层(例如d=6)组成,其内核大小为n1至n_d(例如n1=24,n2=32,

……

)。在这些层之间使用relu、批量归一化(batchnormalisierung)和最大池化(maxpooling)。

73.不变积分层使用5个多项式,以便将等变特征空间转换成一维不变特征向量。在此基础上,使用具有神经元m1至m_k(例如m1= 90,m2=90)的k个全连接块,以便从不变特征中获得分类分数。表格1:用于分类的不变网络的结构输入信号:28x28x1图像24个等变变换(equivariantconv)9x9。relu。batchnorm(批量归一化)。32个等变变换7x7。relu。batchnorm。maxpool(最大池),步幅(sride)2。36个等变变换7x7。relu。batchnorm。36个等变变换7x7。relu。batchnorm。maxpool,步幅2。64个等变变换7x7。relu。batchnorm。96个等变变换5x5。relu。batchnorm。relu。不变积分层,5个单项式。全连接层,90个神经元。relu。batchnorm。全连接层,90个神经元。relu。batchnorm。全连接层,10个神经元。softmax。

74.对神经网络的监督训练使用带不变积分层的卷积神经网络的输入信号和所希望的输出信号(公知为“ground truth(地面实况)”)的训练集。所希望的输出信号例如可以是

分类标签。根据带不变积分层的卷积神经网络的实际输出值以及所希望的输出信号,计算要被优化的所谓的损失函数,即为了优化该损失函数而被计算的带不变积分层的卷积神经网络的参数或权重。通过使用这些权重计算损失函数的梯度来进行该优化,这可以通过迭代地应用链式法则来实现。该方法也称为反向传播。

75.为了可以在深度神经网络内使用不变积分层并且借助于反向传播算法来使前面的层可优化,单项式必须能对它们的输入数据求导。该求导计算如下:能看到:值必须是,借此该梯度不会“消失”(即变为0),这会妨碍对前面的层的训练。

76.还可以表明:对单项式指数的求导也被定义。因而,这些单项式指数可以在神经网络的训练过程期间被优化。

77.这里还重要的是:所有值都是,原因在于否则一方面对数没有被定义,另一方面乘积的梯度会再次消失。

78.因而,使用上文提及的特征图移位:。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。