1.本发明涉及通信技术领域,尤其涉及一种数据搬迁方法、装置、设备及计算机可读存储介质。

背景技术:

2.在5g网络中,用户数据将寄存在udm(unified data management,统一数据管理功能)网元中,代替4g网络中的hss(home subscriber server,归属签约用户服务器)网元。因此需要将用户数据从hss网元割接至udm融合设备中去,而hss设备和udm融合设备有可能是异厂家的情况,不同场景的用户数据格式不同,这给数据搬迁带来了难度。现有技术主要通过人工编写数据格式转换规则来实现,但由于设备厂家较多,需要对每一种转换编写转换规则,导致数据搬迁效率较低、自动化程度不足。

技术实现要素:

3.本发明的主要目的在于提供一种数据搬迁方法、装置、设备及计算机可读存储介质,旨在解决如何提高数据搬迁的效率的技术问题。

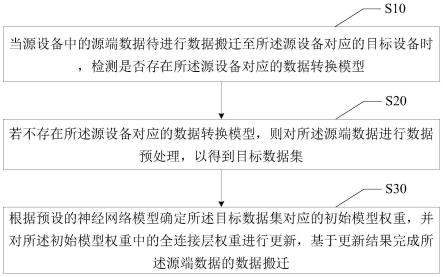

4.为实现上述目的,本发明提供一种数据搬迁方法,包括以下步骤:

5.当源设备中的源端数据待进行数据搬迁至所述源设备对应的目标设备时,检测是否存在所述源设备对应的数据转换模型;

6.若不存在所述源设备对应的数据转换模型,则对所述源端数据进行数据预处理,以得到目标数据集;

7.根据预设的神经网络模型确定所述目标数据集对应的初始模型权重,并对所述初始模型权重中的全连接层权重进行更新,基于更新结果完成所述源端数据的数据搬迁。

8.可选地,根据预设的神经网络模型确定所述目标数据集对应的初始模型权重的步骤,包括:

9.获取所述目标数据集中的所有目标源端数据,依次遍历各所述目标源端数据,确定所述遍历的目标源端数据对应的注意力权重;

10.计算所述遍历的目标源端数据和所述注意力权重的乘积;

11.计算各所述目标源端数据对应的乘积的和值,并根据预设的神经网络模型对所述和值进行模型训练,以得到初始模型权重。

12.可选地,确定所述遍历的目标源端数据对应的注意力权重的步骤,包括:

13.获取所述目标数据集中所述目标设备对应的所有初始数据,并确定各所述初始数据中的待执行数据;

14.将所述遍历的目标源端数据和所述待执行数据输入至预设的注意力计算公式进行计算,以得到所述遍历的目标源端数据对应的注意力权重。

15.可选地,对所述初始模型权重中的全连接层权重进行更新,基于更新结果完成所述源端数据的数据搬迁的步骤,包括:

16.依次遍历各所述初始数据,若遍历的初始数据和所述待执行数据不匹配,则确定所述初始模型权重中的全连接层权重,根据所述遍历的初始数据对所述全连接层权重进行更新,以得到新全连接层权重;

17.根据所述新连接层权重对所述神经网络模型继续进行模型训练,若所述神经网络模型收敛,则确定所述源端数据已完成数据搬迁。

18.可选地,对所述源端数据进行数据预处理,以得到目标数据集的步骤,包括:

19.获取所述目标设备中与所述源端数据对应的历史数据,构建所述源端数据和所述历史数据之间的数据对,将所述数据对作为初始数据集;

20.对所述初始数据集进行文本序列化处理,以得到目标数据集。

21.可选地,检测是否存在所述源设备对应的数据转换模型的步骤之后,包括:

22.若存在所述源设备对应的数据转换模型,则将所述源端数据转换为整数序列数据,将所述整数序列数据输入至所述数据转换模型进行模型训练,基于所述模型训练的训练结果完成所述源端数据的数据搬迁。

23.可选地,将所述整数序列数据输入至所述数据转换模型进行模型训练,基于所述模型训练的训练结果完成所述源端数据的数据搬迁的步骤,包括:

24.若所述整数序列数据存在多个,则遍历各所述整数序列数据,并将遍历的整数序列数据输入至所述数据转换模型进行模型训练,其中,所述数据转换模型将所述整数序列数据编码为上下文向量,并对所述上下文向量进行解码更新,得到数据词;

25.基于所述模型训练的训练结果确定各所述整数序列数据对应的所有数据词,将各所述数据词迁移至所述目标设备,并在各所述数据词迁移完成时,确定所述源端数据的数据搬迁完成。

26.此外,为实现上述目的,本发明还提供一种数据搬迁装置,包括:

27.检测模块,用于当源设备中的源端数据待进行数据搬迁至所述源设备对应的目标设备时,检测是否存在所述源设备对应的数据转换模型;

28.预处理模块,用于若不存在所述源设备对应的数据转换模型,则对所述源端数据进行数据预处理,以得到目标数据集;

29.数据搬迁模块,用于根据预设的神经网络模型确定所述目标数据集对应的初始模型权重,并对所述初始模型权重中的全连接层权重进行更新,基于更新结果完成所述源端数据的数据搬迁。

30.此外,为实现上述目的,本发明还提供一种数据搬迁设备,数据搬迁设备包括存储器、处理器及存储在存储器上并可在处理器上运行的数据搬迁程序,数据搬迁程序被处理器执行时实现如上述的数据搬迁方法的步骤。

31.此外,为实现上述目的,本发明还提供一种计算机可读存储介质,计算机可读存储介质上存储有数据搬迁程序,数据搬迁程序被处理器执行时实现如上述的数据搬迁方法的步骤。

32.本发明通过在确定源端数据待进行数据搬迁,且不存在源设备对应的数据转换模型时,会对源端数据进行数据预处理,以得到目标数据集,并确定目标数据集对应的初始模型权重,对初始模模型权重中的全连接层权重进行更新,以完成源端数据的数据搬迁,从而避免了现有技术中通过人工编写数据格式转换规则来实现数据搬迁,导致数据搬迁的效率

低,智能性差的现象发生,提高了数据搬迁的效率。

附图说明

33.图1是本发明实施例方案涉及的硬件运行环境的终端\装置结构示意图;

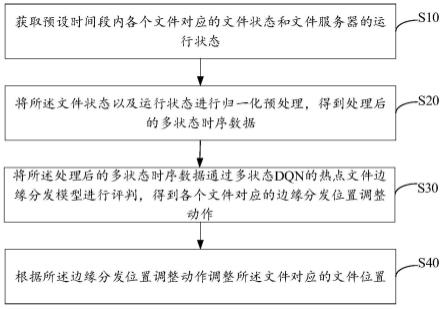

34.图2为本发明数据搬迁方法第一实施例的流程示意图;

35.图3为本发明数据搬迁装置的装置单元示意图;

36.图4为本发明数据搬迁方法中模型的处理流程示意图;

37.图5为本发明数据搬迁方法中的整体流程示意图。

38.本发明目的实现、功能特点及优点将结合实施例,参照附图做进一步说明。

具体实施方式

39.应当理解,此处所描述的具体实施例仅仅用以解释本发明,并不用于限定本发明。

40.如图1所示,图1是本发明实施例方案涉及的硬件运行环境的终端结构示意图。

41.本发明实施例终端为数据搬迁设备。

42.如图1所示,该终端可以包括:处理器1001,例如cpu,网络接口1004,用户接口1003,存储器1005,通信总线1002。其中,通信总线1002用于实现这些组件之间的连接通信。用户接口1003可以包括显示屏(display)、输入单元比如键盘(keyboard),可选用户接口1003还可以包括标准的有线接口、无线接口。网络接口1004可选的可以包括标准的有线接口、无线接口(如wi-fi接口)。存储器1005可以是高速ram存储器,也可以是稳定的存储器(non-volatile memory),例如磁盘存储器。存储器1005可选的还可以是独立于前述处理器1001的存储装置。

43.可选地,终端还可以包括摄像头、rf(radio frequency,射频)电路,传感器、音频电路、wifi模块等等。其中,传感器比如光传感器、运动传感器以及其他传感器。具体地,光传感器可包括环境光传感器及接近传感器,其中,环境光传感器可根据环境光线的明暗来调节显示屏的亮度,接近传感器可在终端设备移动到耳边时,关闭显示屏和/或背光。当然,终端设备还可配置陀螺仪、气压计、湿度计、温度计、红外线传感器等其他传感器,在此不再赘述。

44.本领域技术人员可以理解,图1中示出的终端结构并不构成对终端的限定,可以包括比图示更多或更少的部件,或者组合某些部件,或者不同的部件布置。

45.如图1所示,作为一种计算机存储介质的存储器1005中可以包括操作系统、网络通信模块、用户接口模块以及数据搬迁程序。

46.在图1所示的终端中,网络接口1004主要用于连接后台服务器,与后台服务器进行数据通信;用户接口1003主要用于连接客户端(用户端),与客户端进行数据通信;而处理器1001可以用于调用存储器1005中存储的数据搬迁程序,并执行以下操作:

47.参照图2,本发明提供一种数据搬迁方法,在数据搬迁方法的第一实施例中,数据搬迁方法包括以下步骤:

48.步骤s10,当源设备中的源端数据待进行数据搬迁至所述源设备对应的目标设备时,检测是否存在所述源设备对应的数据转换模型;

49.由于目前的数据搬迁效率低,因此在本实施例中是利用迁移学习将已有的源设备

a至目标设备b的用户数据搬迁模型迁移至新的源设备i至目标设备j的用户数据搬迁场景中。并且在本实施例中,迁移学习是指针对小样本数据集导致的过拟合问题,冻结模型部分网络层在大规模源域训练过的权重参数,转移到小规模目标域中并重新训练该模型最后的全连接层,然后将训练之后的参数保存。在迁移学习中,我们已有的知识叫做源域,要学习的新知识叫目标域。之所以需要迁移学习,是因为数据的标签很难获取,当有些任务的数据标签很难获取时,就可以通过其他容易获取标签且和该任务相似的任务来迁移学习;从头建立模型是复杂和耗时的,也即是需要通过迁移学习来加快学习效率。

50.迁移学习的严格定义为:给定源域ds={xs,fs(x)}和学习任务ts,目标域dt={xt,ft(x)}和学习任务tt,迁移学习旨在源域不同于目标域或学习任务tt不同于学习任务ts的条件下通过使用学习任务ts和源域ds={xs,fs(x)}所获取的知识来帮助学习目标的在目标域dt的预测函数ft(.)。

51.本实施例中所应用到的模型为编解码循环神经网络模型。将编解码模型用于网元告警摘要场景,编码器用于将原网元告警编码成一个固定长度的向量,即上下文向量,解码器用于从编码后的上下文向量中生成告警摘要。其中编码器采用双向长短期记忆神经网络,解码器采用长短期记忆神经网络。

52.长短期记忆(lstm,long short-term memory)是一种特殊的循环神经网络类型。lstm通过控制缓存中的值保存的时间,可以记住长期的信息,适合进行长序列的学习。每个神经元有四个输入和一个输出,每个神经元内有一个存放记忆的数值,每一个lstm神经元中含有三个门控:遗忘门、输入门、输出门。所述双向长短期记忆(bilstm,bidirectional long short-termmemory)是长短期记忆的变种,模型可从两个方向学习,输入层的数据会经过向前和向后两个方向推算,最后输出的隐含状态再进行concat(合并数组),再作为下一层的输入,原理和lstm类似,只是多了双向计算和concat过程。

53.编码器-解码器架构是一种组织循环神经网络的方式,主要用于解决含多个输入或多个输出的序列预测问题。

54.编码器:负责将输入的序列进行逐字编码,编码成一个固定长度的向量,即上下文向量;

55.解码器:解码器负责读取编码器输出的上下文向量,并生成输出序列。

56.在本实施例中引入注意力机制将从编码器获得的更加丰富的上下文提供给解码器,编码器会传递更多的数据给解码器,相比传统模型中编码器只传递编码阶段的最后一个隐藏状态,而注意力机制模型中编码器传递所有的隐藏状态给解码器。同时注意力提供这样一种学习机制,当预测每一个时步上输出的序列时,解码器可以学习在更加丰富的上下文中需要聚焦于何处。注意力机制使得模型可以按需要聚焦于输入序列中的相关部分,注意力网络会给每一个输入分配一个注意力权重,如果该输入与当前操作越相关则注意力权重越接近于1,反之则越接近于0,这些注意力权重在每一个输出步骤都会重新计算。

57.因此在本实施例中,当源设备中的用户数据(即源端数据)待进行数据搬迁至源设备对应的目标设备时,可以将所需搬迁的源设备i和目标设备j的名称输入至提前设置好的判断模块中进行判断,也就是检测是否存在源设备对应的数据转换模型。若存在数据转换模型,则可以直接根据此数据转换模型完成数据搬迁操作。

58.步骤s20,若不存在所述源设备对应的数据转换模型,则对所述源端数据进行数据

预处理,以得到目标数据集;

59.当经过判断发现不存在源设备对应的数据转换模型时,则需要新建数据转换模型。从可以先获取源设备i的用户数据,将其每一条用户数据转换为目标设备j的用户数据,即目标设备对应的初始数据,并获取源设备的用户数据(即源端数据),再进行数据预处理,即将源设备i和目标设备j的用户数据对作为初始数据集,再对初始数据集进行文本清洗和文本序列化,以得到目标数据集。

60.其中,数据预处理的过程可以是获取待进行数据搬迁的源设备a的用户数据(即源端数据),并将源设备a的每一条用户数据转换为目标设备b的用户数据,再将源设备a和目标设备b的用户数据对作为初始数据集,并进行文本清洗和文本序列化,以完成数据预处理。

61.并且源设备的源端数据x可以表示为:x=(x1,x2,x3,...,xn),其中,xn是输入的第n个词。目标设备的用户数据y可以表示为:y=(y1,y2,y3,...,ym),其中,ym是输入的第m个词。在对初始数据集进行文本清洗并将其文本序列化时,可以对初始数据集中数据对所在文本进行以下操作,即移除所有标点符号,然后对文本进行分词,同时对每个词索引化,使得每一段文本被转化成一段索引数字,并且对未达到最大文本长度的序列补零。再取源设备和目标设备中用户数据的最长长度user_length作为其统一的索引序列长度,将源设备和目标设备用户数据的词典大小统一设置为user_vocab_size。

62.并且在本实施例中,在获取到目标数据集时,还可以是将目标数据集划分为训练集和测试集,即将目标数据集的90%划分为训练集,将目标数据集的10%划分为测试集。训练集用于训练模型,测试集用于测试模型性能。

63.步骤s30,根据预设的神经网络模型确定所述目标数据集对应的初始模型权重,并对所述初始模型权重中的全连接层权重进行更新,基于更新结果完成所述源端数据的数据搬迁。

64.预设的神经网络模型可以是用户基于自身需求提前设置的数据转换模型,也可以是已完成数据搬迁的其它历史神经网络模型。因此在获取到目标数据集后,可以直接根据提前设置好的神经网络模型将目标数据集中的源端数据(即目标源端数据)转换为该神经网络模型权重,即初始模型权重,并将将该初始权重中除最后一个全连接层以外的权重进行迁移,仅对最后一个全连接层进行重新训练。经过多个回合训练收敛后的模型权重作为本次源设备i至目标设备j的用户数据转换模型权重。从而利用迁移学习快速对新的异厂家用户数据搬迁模型进行训练。

65.其中,如图4所示,本实施例中的神经网络模型由1个输入层、5个隐藏层(1个嵌入层、2个bilstm编码层、2个注意力lstm解码层)、1个输出层(全连接层)组成。主要包含编码器和解码器两部分:编码器由两层双向长短期记忆神经网络组成,负责提取源设备用户数据特征,并将其编码成内部表征(上下文向量),从而获取到含义;解码器由两层长短期记忆神经网络组成,使用编码后的源设备用户数据上下文向量和上一时刻生成的目标设备用户数据来生成下一个时刻的用户数据词。具体地,神经网络模型的第一层为输入层:将输入索引化后的源设备用户数据,每条用户数据的索引序列长度为user_length,因此该层输出数据的形状为(none,user_length)。第二层为嵌入层(embedding):利用词嵌入(word embedding)将每个单词转化为向量,输入数据维度为user_vocab_size,输出设置为需要将

单词转换为128维度的空间向量,输入序列长度为user_length,因此该层输出数据的形状为(none,user_length,128)。该层的作用是对源设备用户数据的词进行向量映射(word embeddings),将从tokenizer输出的每个词的索引转换为128维的固定形状向量。第三、四层为bilstm编码层:均含128个bilstm神经元,激活函数设置为“relu”,该层输出数据的形状为(none,user_length,128)。第五、六层为注意力lstm解码层:均含128个注意力机制lstm神经元,激活函数设置为“relu”。该层输出数据的形状为(none,user_length,128)。第七层全连接(dense)层(输出层):包含dense全连接神经元个数为suser_vocab_size,激活函数设置为“softmax”,将softmax输出结果,送入多类交叉熵损失函数。该层输出数据的形状为(none,user_vocab_size)。将注意力解码层的输出形状转换成最终输出的维度。模型训练:将训练回合数设置为1000(epochs=1000),批处理大小设置为20(batch_size=20),选择categorical crossentropy多类交叉熵作为损失函数即目标函数(loss='categorical_crossentropy'),梯度下降优化算法选择adam优化器用于改善传统梯度下降的学习速度(optimizer='adam')。模型收敛后则导出该模型的权重。

66.此外,为辅助理解本实施例中的数据搬迁的原理流程的理解,下面进行举例说明。

67.如图5所示,包括离线训练流程和在线转换流程,先根据源设备i和目标设备j的名称,判断是否属于已有转换模型,若是,则将源设备a用户数据输入至用户数据预处理模块进行数据预处理,再将其输入至源设备a至目标设备b的用户数据转换模型,即根据编码器和解码器进行编解码处理,并输出目标设备b用户数据,从而完成离线训练流程,完成数据搬迁操作。若不属于已有转换模型,则进行用户数据转换模型迁移训练,以得到源设备i至目标设备j的用户数据转换模型,并且此时也已完成数据搬迁操作。其中在离线训练流程中,用户数据进行数据预处理,可以是初次建立模型时,可随机选取源设备a用户数据搬迁至目标设备b的场景,从用户数据预处理模块中获取历史待搬迁的源设备a的用户数据,人工将其每一条用户数据转换为目标设备b的用户数据,将源设备a和目标设备b的用户数据对作为本模型的数据集,并对数据集进行中文文本清洗和文本序列化。初次建立模型时,可随机选取源设备a用户数据搬迁至目标设备b的场景,从用户数据预处理模块中获取历史待搬迁的源设备a的用户数据,人工将其每一条用户数据转换为目标设备b的用户数据,将源设备a和目标设备b的用户数据对作为本模型的数据集,并对数据集进行中文文本清洗和文本序列化。

68.在本实施例中,通过在确定源端数据待进行数据搬迁,且不存在源设备对应的数据转换模型时,会对源端数据进行数据预处理,以得到目标数据集,并确定目标数据集对应的初始模型权重,对初始模模型权重中的全连接层权重进行更新,以完成源端数据的数据搬迁,从而避免了现有技术中通过人工编写数据格式转换规则来实现数据搬迁,导致数据搬迁的效率低,智能性差的现象发生,提高了数据搬迁的效率。

69.进一步地,基于上述本发明的第一实施例,提出本发明数据搬迁方法的第二实施例,在本实施例中,上述实施例步骤s30,根据预设的神经网络模型确定所述目标数据集对应的初始模型权重的步骤的细化,包括:

70.步骤a,获取所述目标数据集中的所有目标源端数据,依次遍历各所述目标源端数据,确定所述遍历的目标源端数据对应的注意力权重;

71.步骤b,计算所述遍历的目标源端数据和所述注意力权重的乘积;

72.在本实施例中,在计算初始模型权重时,可以获取目标数据集中的所有待进行数据搬迁的源端数据,即目标源端数据,然后再遍历各个目标源端数据,并根据提前设置的注意力权重计算公式来计算遍历的目标源端数据对应的权重。即可以先设置t

x

为输入时间步骤的个数;ty为输出时间步骤的个数;attentioni为在输出时间步骤i的注意力权重;ci为在输出时间步骤i的上下文。因此计算注意力权重的公式可以为attentioni=softmax(dense(x,y

i-1

))。其中,所有注意力权重的权重长度为t

x

;所有注意力权重的权重之和为1。并在计算得到遍历的目标源端数据对应的注意力权重后,还需要计算遍历的目标源端数据和注意力权重的乘积。

73.步骤c,计算各所述目标源端数据对应的乘积的和值,并根据预设的神经网络模型对所述和值进行模型训练,以得到初始模型权重。

74.并且会计算所有目标源端数据对应的乘积的和值,并将此和值作为上下文,即:

[0075][0076]

然后再将所得的上下文输入到长短期记忆神经层中,即yi=lstm(ci)。

[0077]

即将和值输入到提前设置的神经网络模型进行模型训练,以得到初始模型权重。

[0078]

在本实施例中,通过遍历目标数据集中的目标源端数据,并计算其对应的注意力权重,遍历的目标源端数据和注意力权重的乘积,再获取所有目标源端数据对应的乘积的和值,并根据神经网络模型进行模型训练,以得到初始模型权重,从而保障了获取到的初始模型权重的有效性。

[0079]

具体地,确定所述遍历的目标源端数据对应的注意力权重的步骤,包括:

[0080]

步骤d,获取所述目标数据集中所述目标设备对应的所有初始数据,并确定各所述初始数据中的待执行数据;

[0081]

在本实施例中,在计算注意力权重时,可以先获取目标数据集中与目标设备相关的所有初始数据(即目标设备中的用户数据,模型的输出部分)。然后在各个初始数据中选择一个初始数据作为本次进行模型训练的输出部分,并将选择的初始数据作为待执行数据。

[0082]

步骤e,将所述遍历的目标源端数据和所述待执行数据输入至预设的注意力计算公式进行计算,以得到所述遍历的目标源端数据对应的注意力权重。

[0083]

将遍历的目标源端数据和待执行数据一起输入到提前设置的注意力计算公式中进行计算,并将计算结果作为遍历的目标源端数据对应的注意力权重。

[0084]

在本实施例中,通过获取目标数据集中与目标设备关联的待执行数据,并将遍历的目标源端数据和待执行数据输入至注意力计算公式进行计算,得到注意力权重,从而保障了获取到的注意力权重的准确性。

[0085]

具体地,对所述初始模型权重中的全连接层权重进行更新,基于更新结果完成所述源端数据的数据搬迁的步骤,包括:

[0086]

步骤f,依次遍历各所述初始数据,若遍历的初始数据和所述待执行数据不匹配,则确定所述初始模型权重中的全连接层权重,根据所述遍历的初始数据对所述全连接层权重进行更新,以得到新全连接层权重;

[0087]

在本实施例中,在得到初始模型权重后,只会对初始模型权重中的全连接层进行

更新,然后再进行模型训练。因此可以先遍历各个初始数据,即遍历各个输出部分,并将遍历的初始数据和待执行数据不相同时,即遍历的初始数据和待执行数据不匹配,则可以直接将神经网络模型中的待执行数据替换为遍历的初始数据,以完成对全连接层权重的更新,得到新全连接层权重。

[0088]

步骤g,根据所述新连接层权重对所述神经网络模型继续进行模型训练,若所述神经网络模型收敛,则确定所述源端数据已完成数据搬迁。

[0089]

然后再根据新全连接层权重继续对神经网络模型进行模型训练,确定神经网络模型是否收敛,若未收敛,则更新新全连接层权重,直至收敛。若神经网络模型收敛,则确定源端数据已完成数据搬迁。

[0090]

在本实施例中,通过通过根据遍历的初始数据对初始模型权重中的全连接层权重进行更新,并继续进行模型训练,直至神经网络模型收敛,才确定源端数据已完成数据搬迁,从而保障了数据搬迁的正常进行。

[0091]

进一步地,对所述源端数据进行数据预处理,以得到目标数据集的步骤,包括:

[0092]

步骤h,获取所述目标设备中与所述源端数据对应的历史数据,构建所述源端数据和所述历史数据之间的数据对,将所述数据对作为初始数据集;

[0093]

步骤k,对所述初始数据集进行文本序列化处理,以得到目标数据集。

[0094]

在本实施例中,对源端数据进行数据预处理的方式可以是先获取目标设备中与源端数据对应的历史数据(即已存在的用户数据,如获取待搬迁的源设备a的用户数据,人工将其每一条用户数据转换为目标设备b的用户数据(即历史数据)),然后再构建源端数据和历史数据之间的数据对,并将所有的数据对作为初始数据集。再对初始数据集进行文本清洗处理,并进行文本序列化处理,以得到目标数据集。

[0095]

在本实施例中,通过获取目标设备中与源端数据对应的历史数据,并建立数据对,将其作为初始数据集,对初始数据集进行文本序列化处理,得到目标数据集,从而保障了获取到的目标数据集的有效性。

[0096]

进一步地,基于上述本发明的第一实施例,提出本发明数据搬迁方法的第三实施例,在本实施例中,上述实施例步骤s10,检测是否存在所述源设备对应的数据转换模型的步骤之后,包括:

[0097]

步骤m,若存在所述源设备对应的数据转换模型,则将所述源端数据转换为整数序列数据,将所述整数序列数据输入至所述数据转换模型进行模型训练,基于所述模型训练的训练结果完成所述源端数据的数据搬迁。

[0098]

在本实施例中,当经过判断发现源设备对应的数据转换模型时,可以直接将源设备i用户数据批量输入至用户数据预处理模块,用户数据预处理模块将用户数据中的每个词索引化,使用户数据文本文本转化为整数序列,从而得到整数序列数据,并将整数序列数据逐条输入至数据转换模型中进行模型训练,即通过由两层双向长短期记忆层组成编码器,提取源设备用户数据特征,并将其编码成上下文向量;再通过由两层注意力长短期记忆层组成的解码器,使用编码后的源设备用户数据上下文向量和上一时刻生成的目标设备用户数据来生成下一个时刻的用户数据词,最终逐条输出目标设备j的用户数据。并输出完成后,确定已经完成源端数据的数据搬迁。

[0099]

在本实施例中,通过当存在数据转换模型时,将源端数据转换为整数序列数据输

入至数据转换模型中进行模型训练,已完成数据搬迁,从而保障了数据搬迁的正常进行。

[0100]

具体地,将所述整数序列数据输入至所述数据转换模型进行模型训练,基于所述模型训练的训练结果完成所述源端数据的数据搬迁的步骤,包括:

[0101]

步骤n,若所述整数序列数据存在多个,则遍历各所述整数序列数据,并将遍历的整数序列数据输入至所述数据转换模型进行模型训练,其中,所述数据转换模型将所述整数序列数据编码为上下文向量,并对所述上下文向量进行解码更新,得到数据词;

[0102]

在本实施例中,若整数序列数据存在多个时,可以遍历各个整数序列数据,并将遍历的整数序列数据中的所有数据直接输入到数据转换模型中进行模型训练,即数据转换模型会将整数序列数据编码为上下文向量,由两层注意力长短期记忆层组成的解码器,使用编码后的源设备用户数据上下文向量和上一时刻生成的目标设备用户数据来生成下一个时刻的数据词。

[0103]

步骤y,基于所述模型训练的训练结果确定各所述整数序列数据对应的所有数据词,将各所述数据词迁移至所述目标设备,并在各所述数据词迁移完成时,确定所述源端数据的数据搬迁完成。

[0104]

再根据模型训练的训练结果来确定所有整数序列对应的所有数据词,并将各个数据词进行逐条迁移至目标设备中,当各个数据词迁移完成时,就可以直接确定源端数据的数据搬迁完成。

[0105]

通过在整数序列数据存在多个时,根据数据转换模型对遍历的整数序列数据进行编码和解码处理,得到数据词,再将所有数据词迁移至目标设备,以完成数据迁移操作,从而保障了数据迁移的正常进行。

[0106]

此外,参照图3,本发明实施例还提供一种数据搬迁装置,包括:

[0107]

检测模块a10,用于当源设备中的源端数据待进行数据搬迁至所述源设备对应的目标设备时,检测是否存在所述源设备对应的数据转换模型;

[0108]

预处理模块a20,用于若不存在所述源设备对应的数据转换模型,则对所述源端数据进行数据预处理,以得到目标数据集;

[0109]

数据搬迁模块a30,用于根据预设的神经网络模型确定所述目标数据集对应的初始模型权重,并对所述初始模型权重中的全连接层权重进行更新,基于更新结果完成所述源端数据的数据搬迁。

[0110]

可选地,数据搬迁模块a30,用于:

[0111]

获取所述目标数据集中的所有目标源端数据,依次遍历各所述目标源端数据,确定所述遍历的目标源端数据对应的注意力权重;

[0112]

计算所述遍历的目标源端数据和所述注意力权重的乘积;

[0113]

计算各所述目标源端数据对应的乘积的和值,并根据预设的神经网络模型对所述和值进行模型训练,以得到初始模型权重。

[0114]

可选地,数据搬迁模块a30,用于:

[0115]

获取所述目标数据集中所述目标设备对应的所有初始数据,并确定各所述初始数据中的待执行数据;

[0116]

将所述遍历的目标源端数据和所述待执行数据输入至预设的注意力计算公式进行计算,以得到所述遍历的目标源端数据对应的注意力权重。

[0117]

可选地,数据搬迁模块a30,用于:

[0118]

依次遍历各所述初始数据,若遍历的初始数据和所述待执行数据不匹配,则确定所述初始模型权重中的全连接层权重,根据所述遍历的初始数据对所述全连接层权重进行更新,以得到新全连接层权重;

[0119]

根据所述新连接层权重对所述神经网络模型继续进行模型训练,若所述神经网络模型收敛,则确定所述源端数据已完成数据搬迁。

[0120]

可选地,预处理模块a20,用于:

[0121]

获取所述目标设备中与所述源端数据对应的历史数据,构建所述源端数据和所述历史数据之间的数据对,将所述数据对作为初始数据集;

[0122]

对所述初始数据集进行文本序列化处理,以得到目标数据集。

[0123]

可选地,检测模块a10,用于:

[0124]

若存在所述源设备对应的数据转换模型,则将所述源端数据转换为整数序列数据,将所述整数序列数据输入至所述数据转换模型进行模型训练,基于所述模型训练的训练结果完成所述源端数据的数据搬迁。

[0125]

可选地,检测模块a10,用于:

[0126]

若所述整数序列数据存在多个,则遍历各所述整数序列数据,并将遍历的整数序列数据输入至所述数据转换模型进行模型训练,其中,所述数据转换模型将所述整数序列数据编码为上下文向量,并对所述上下文向量进行解码更新,得到数据词;

[0127]

基于所述模型训练的训练结果确定各所述整数序列数据对应的所有数据词,将各所述数据词迁移至所述目标设备,并在各所述数据词迁移完成时,确定所述源端数据的数据搬迁完成。

[0128]

其中,数据搬迁装置的各个功能单元实现的步骤可参照本发明数据搬迁方法的各个实施例,此处不再赘述。

[0129]

此外,本发明还提供一种数据搬迁设备,所述终端包括:存储器、处理器、及存储在所述存储器上的数据搬迁程序,所述处理器用于执行所述数据搬迁程序,以实现上述数据搬迁方法各实施例的步骤。

[0130]

本发明还提供了一种计算机可读存储介质,所述计算机可读存储介质存储有一个或者一个以上程序,所述一个或者一个以上程序还可被一个或者一个以上的处理器执行以用于实现上述数据搬迁方法各实施例的步骤。

[0131]

本发明计算机可读存储介质具体实施方式与上述数据搬迁方法各实施例基本相同,在此不再赘述。

[0132]

需要说明的是,在本文中,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者系统不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者系统所固有的要素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在包括该要素的过程、方法、物品或者系统中还存在另外的相同要素。

[0133]

上述本发明实施例序号仅仅为了描述,不代表实施例的优劣。

[0134]

通过以上的实施方式的描述,本领域的技术人员可以清楚地了解到上述实施例方法可借助软件加必需的通用硬件平台的方式来实现,当然也可以通过硬件,但很多情况下

前者是更佳的实施方式。基于这样的理解,本发明的技术方案本质上或者说对现有技术做出贡献的部分可以以软件产品的形式体现出来,该计算机软件产品存储在如上所述的一个存储介质(如rom/ram、磁碟、光盘)中,包括若干指令用以使得一台终端设备(可以是手机,计算机,服务器,空调器,或者网络设备等)执行本发明各个实施例所述的方法。

[0135]

以上仅为本发明的优选实施例,并非因此限制本发明的专利范围,凡是利用本发明说明书及附图内容所作的等效结构或等效流程变换,或直接或间接运用在其他相关的技术领域,均同理包括在本发明的专利保护范围内。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。