5g通信助理文本分类的方法、装置、电子设备及存储介质

技术领域

1.本发明涉及文本分类技术领域,具体而言,涉及一种融合深度学习模型的5g通信助理文本分类的方法、装置、电子设备及存储介质。

背景技术:

2.目前,通信运营商在云改数转的引领下,5g通信助理业务快速发展,用户数量屡创新高,5g通信助理每天产生大量数据,文本的分类与深度处理非常重要。

3.传统的文本分类方法主要分为两类:一是基于词典的数据分类,将数据与建立的词典库进行比对从而进行分类;二是基于机器学习的数据文本分类,该方法常常依赖于人工设计的特征,并且文本表示存在着稀疏、高维度的问题。在特征工程的基础上,使用朴素贝叶斯、余弦相似度等分类模型进行分类。

4.但是5g通信助理进行文本分类任务时与普通文本分类任务有一定的区别,一是这些数据涉及类别广泛,且都为自动语音识别技术(asr)转换成的自然语言文本,存在词序不规范,并且可能出现实体识别不正确的问题。二是5g通信助理产生的文本存在类别不均衡的特征,少数几个场景的文本数量极多,存在长尾现象。三是存在很多无意义的对话,这些特点为意图识别与文本分类增添了难度。

5.因此,为了提升服务质量,挖掘数据潜在价值,亟需研发一种规避以上问题,通过融合深度学习模型的5g通信助理文本分类的方法。

技术实现要素:

6.本发明要解决的技术问题是现有模型对当前场景下分类正确率低的问题,并能够提升服务质量、挖掘数据潜在价值,提供一种面向5g通信助理多场景语料数据进行文本分类的方法。

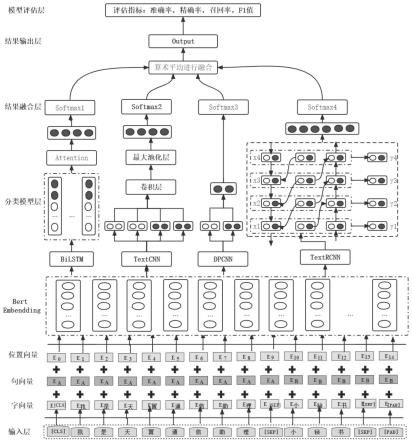

7.为解决上述技术问题,根据本发明的一个方面,提供一种5g通信助理文本分类的方法,方法基于5g通信助理全场景语料数据进行分类,语料数据包括通话id、通话内容、通话角色、通话场景类别、通话开始时间、通话结束时间的数据,方法包括如下步骤:s1、对语料数据进行asr(自动语音识别)转换,再对数据进行etl数据清洗操作,etl数据清洗包括:数据抽取、数据转换和数据加载,进而得到模型所需的原始语料数据集;s2、数据输入,采用参数级别上亿的预训练模型bert将每个输入的原始语料数据通过token(输入文本中的字)向嵌入(embendding)层传递,以便将每个token转换为字向量表示,同时bert还具有额外的嵌入层,额外的嵌入层包括以句向量嵌入和位置向量嵌入的形式;将字向量、词向量和位置向量进行合并,生成训练数据,传递给bert的嵌入层进行输出;s3、由bert的嵌入层将训练数据输入到分类模型,由分类模型分别进行训练,分类模型包括基于attention机制改进的bilstm(双向lstm)模型、text cnn模型、dpcnn模型、text rcnn模型;s4、结果融合,将由基于attention机制改进的bilstm模型、text cnn模型、dpcnn模型、text rcnn模型输出的语义特征,分别输入至分类器层,进而得到分类场景下各分类类别的预测概率;s5、将步骤s4

得到的各分类类别的预测概率,采用算数平均进行融合,输出分类结果。

8.根据本发明的实施例,在步骤s1后,可再对原始语料数据集进行包括分词、去掉停用词的操作。

9.根据本发明的实施例,基于attention机制改进的bilstm模型可采用双向lstm(bi-lstm)来获取每个字词的上下文语义信息,bi-lstm通过前向和后向的lstm捕获第t时刻前向隐藏层backward

t

和后向隐藏层状态向量forward

t

,然后融合forward

t

和backward

t

形成最后隐藏层状态向量last

t

作为第t时刻节点对应的字词上下文语义向量表示,前向隐藏层状态向量forward

t

的计算过程如下:

10.i

t

=f(wi·

[forward

t-1

,e

t

] bi)

ꢀꢀ

(1)

[0011]ft

=f(wf·

[forward

t-1

,e

t

] bf)

ꢀꢀ

(2)

[0012]ot

=f(wo·

[forward

t-1

,e

t

] bo)

ꢀꢀ

(3)

[0013]ct

=f

t

*c

t-1

i

t

*tanh(wc·

[forward

t-1

,e

t

] bc)

ꢀꢀ

(4)

[0014]

forward

t

=o

t

*tanh(c

t

)

ꢀꢀ

(5)

[0015]

其中,forward

t-1

是第t-1时刻前向隐藏层状态向量,e

t

是嵌入层第t个位置的输出向量,f是sigmoid激活函数,w权重矩阵,b是偏置项矩阵,tanh是双曲正切函数,*是元素方式的乘积运算,c

t

是状态变量,c

t

和输出门一起决定最后的输出;因bilstm网络结构中遗忘门策略,上下文语义信息的缺失不可避免,因此融合模型将bert输出的词向量喂入bilstm模型,进而得到每个单词的最终上下文表示

[0016][0017][0018]

其中,代表向量拼接运算;

[0019]

在bilstm模型后融合注意力机制(attention)模型能将每个字词的上下文表示向量分配一个重要度(权重)来衡量不同字词对文本全局语义特征的重要程度,进而得到文本全局语义特征表示f

global

,f

global

的计算公式如下:

[0020][0021][0022][0023]

其中,ww是可训练参数,bw是偏置项矩阵,是u

t

的转置矩阵,uw是一个随机初始化的、可学习的词级别上下文向量,a

t

是第t时刻单词的归一化权重。

[0024]

根据本发明的实施例,text cnn模型可包括输入层(embedding layer)、卷积层(convolution)、池化层(pooling)、全连接层(fc);输入层是由bert的embendding层进行输入表示的词向量,pooling操作选择将卷积得到的列向量的最大值提取出来,相当于(pad_size-filter_size 1)维变成一维,即将每个卷积核的最大值连接起来,即通过pooling来消除句子之间长度不同的差异,池化层后面加上全连接层,并添加用于防止过拟合的l2正则化和dropout正则化方法;最终的输出层需要进行softmax概率归一化,然后使用softmax

后的预测输出结果和真实标签计算交叉熵损失。

[0025]

根据本发明的实施例,dpcnn模型可通过包括不断加深网络、固定feature map的数量的操作,实现抽取长距离的文本依赖关系,其中,每当使用一个size=3和stride=2进行max pooling进行池化时,每个卷积层的计算时间减半(数据大小减半),从而形成一个金字塔(pyramid)。

[0026]

根据本发明的实施例,text rcnn模型可将卷积层换成双向rnn(循环神经网络),从而形成双向rnn、池化层、输出层的网络结构,用双向循环结构获取上下文信息,这比传统的基于窗口的神经网络更能减少噪声,而且在学习文本表达时可以大范围的保留词序;其次使用最大池化层获取文本的重要部分,自动判断哪个特征在文本分类过程中起更重要的作用。text rcnn模型训练包括如下步骤:s31、第一栏中间的word embedding层,输入的句子维度为[batch_size,seq_len],seq_len为输入的句子的长度,然后经过embedding层,加载预训练词向量或者随机初始化,词向量维度为embed_size,最终embedding layer层的输出为[batch_size,seq_len,embed_size];s32、接着将embedding layer层的输出输入到双向rnn中,前向和后向所有时刻的隐层状态输出分别都是[batch_size,seq_len,hidden_size];s33、拼接操作,需要同时把前向、后向、embedding layer三层输出拼接到一起,最终的维度为[batch_size,seq_len,hidden_size*2 embed_size]。

[0027]

根据本发明的实施例,步骤s4中,结果融合可将bilstm模型和attention模型融合输出的全局语义特征表示为f

global

,将textcnn模型输出的局部语义特征表示为f

local1

,将dpcnn模型输出的深层局部语义特征表示为f

local2

,将textrcnn模型输出的局部语义特征表示为f

local3

;然后分别将f

global

输入至soft max 1分类器层,进而得到分类场景的各分类类别的预测概率矩阵p1,将f

local1

输入至soft max 2分类器层,进而得到分类场景下各分类类别的预测概率矩阵p2,将f

local2

输入至soft max 3分类器层,进而得到分类场景下各分类类别的预测概率矩阵p3,将f

local3

输入至soft max 4分类器层,进而得到分类场景下各分类类别的预测概率矩阵p4:

[0028]

p1=soft max 1(wg·fglobal

bg)

ꢀꢀ

(11)

[0029][0030][0031][0032]

其中,wg,为训练权重矩阵,bg,为偏置项。

[0033]

根据本发明的实施例,步骤s5中,结果输出可对结果融合层输出的概率矩阵p1,p2,p3,p4,采用取算术平均数的方式进行融合,得到分类类别的最终预测概率矩阵p

final

:

[0034][0035]

采用最小化交叉熵损失函数作为模型训练的目标函数进行模型的迭代优化。

[0036][0037]

其中,n为训练样本数,c为类别数,q为样本的真实标签,采用one-hot进行编码,λ时l2正则化超参数。

[0038]

根据本发明的实施例,5g通信助理文本分类的方法还可包括步骤:s6、模型评估,通过采用包括准确率acc(accuracy)、精确率pre(precision)、召回率rec(recall)及f

1-score值的评价指标,对融合模型效果进行评价,计算公式如下:

[0039][0040][0041][0042][0043]

其中,tp是将正类预测为正类的样本数,fn是将正类预测为负类的样本数,fp是将负类预测为正类的样本数,tn是将负类预测为负类的样本数。

[0044]

根据本发明的第二个方面,提供一种5g通信助理文本分类的装置,其包括:输入模块,输入模块对语料数据进行asr(自动语音识别)转换,再对数据进行etl数据清洗操作,etl数据清洗包括:数据抽取、数据转换和数据加载,进而得到模型所需的原始语料数据集;bert嵌入模块,采用参数级别上亿的预训练模型bert将每个输入的原始语料数据通过token(输入文本中的字)向嵌入(embendding)层传递,以便将每个token转换为字向量表示,同时bert还具有额外的嵌入层,额外的嵌入层包括以句向量嵌入和位置向量嵌入的形式;将字向量、词向量和位置向量进行合并,生成训练数据,传递给bert的嵌入模块进行输出;由bert的嵌入模块将训练数据输入到分类模型模块,由分类模型分别进行训练;分类模型模块,分类模型模块包括基于attention机制改进的bilstm(双向lstm)模型、text cnn模型、dpcnn模型、text rcnn模型;结果融合模块,结果融合模块将由基于attention机制改进的bilstm模型、text cnn模型、dpcnn模型、text rcnn模型输出的语义特征,分别输入至分类器层,进而得到分类场景下各分类类别的预测概率;结果输出模块,将各分类类别的预测概率,采用算数平均进行融合,输出分类结果。

[0045]

根据本发明的实施例,5g通信助理文本分类的的装置还可包括:模型评估模块,模型评估模块通过采用包括准确率acc(accuracy)、精确率pre(precision)、召回率rec(recall)及f

1-score值的评价指标,对融合模型效果进行评价。

[0046]

根据本发明的第三个方面,提供一种电子设备,包括:存储器、处理器及存储在存储器上并可在处理器上运行的5g通信助理文本分类程序,5g通信助理文本分类程序被处理器执行时实现上述的5g通信助理文本分类方法的步骤。

[0047]

根据本发明的第四个方面,提供一种计算机存储介质,其中,计算机存储介质上存储有5g通信助理文本分类程序,5g通信助理文本分类程序被处理器执行时实现上述的5g通信助理文本分类方法的步骤。

[0048]

与现有技术相比,本发明的实施例所提供的技术方案至少可实现如下有益效果:

[0049]

为了提升服务质量,挖掘数据潜在价值,本发明采用一种融合深度学习模型进行文本分类,针对5g通信助理的特征,发明了一种融合深度学习模型的5g通信助理文本特征分类方法。该方法通过端到端的方式学习特征表示并解决了文本表示稀疏、高维度的问题。

在基于深度神经网络模型的文本分类方法中,文本卷积神经网络(textcnn)模型采用跨空间模式,借助滑动空间窗口大小来捕捉文本的局部语义特征,但textcnn有个最大问题是固定filter_size的视野,一方面无法建模更长的序列信息,忽视了句子在时间维度上的先后顺序,另一方面filter_size的超参调节也很繁琐;循环神经网络(recurrent neural network,rnn),能够更好的表达上下文信息,bi-directional rnn(双向lstm)从某种意义上可以理解为可以捕获变长且双向的的"n-gram"信息。其采用递归计算获得全局语义特征,常用于识别跨时间维度的模式,但是缺乏捕捉局部语义特征的能力。循环卷积神经网络(textrcnn)模型将用于捕获上下文信息的循环结构和具备捕获局部语义特征的卷积结构相结合,无需人工设计的特征,自动判断最大池化层哪些词在文本分类中起关键作用,以捕捉文本中的关键成分。深度金字塔卷积神经网络(dpcnn)是一种基于word-level级别的dpcnn网络,dpcnn通过不断加深网络,可以抽取长距离的文本依赖关系,但是dpcnn网络的加深会损失更多的语义信息。基于注意力机制(attention mechanism)模型能将有限的注意力集中在重要语义信息上,但它未考虑词与词之间的先后顺序关系;上述深度学习模型因其网络结构差异,在具备自身优势的同时也存在一些不足。本发明采用一种融合深度学习模型在尽可能减小网络深度的前提下融合了多个模型的优势,用bert模型作为词嵌入层,以获得更好的通信语料文本表示,用bilstm与attention相结合的方式提取全局语义特征,用textcnn模型提取文本多个粒度下的局部语义特征,采用dpcnn模型抽取长距离的文本依赖关系,采用text rcnn模型获取上下文信息,在学习文本表达时可以大范围的保留词序,最大池化层获取文本的重要部分。最后把四个模型的结果通过取平均值进一步融合,进而预测出场景文本分类类别。融合模型可以利用各模型的优势,并提取多方面的语义特征来保留更多的语义信息,具有更好的泛化能力,更高的预测准确度。

[0050]

本发明在平衡网络深度的同时,用bert模型作为词嵌入层,可以通过在海量的语料的基础上运行自监督学习方法为通信语料文本学习一个较好的特征表示。

[0051]

本发明将bilstm模型与attention机制模型相结合的方式提取全局语义特征和全局语义信息,同时融合textcnn模型提取文本多维度的局部语义特征,融合dpcnn模型抽取长距离的文本依赖关系,融合text rcnn模型获取上下文信息,在学习文本表达时可以大范围的保留词序,获取文本的重要部分,融合模型具备更高的预测准确度。

[0052]

本发明采用面向5g通信助理多场景语料数据的建模方法,解决现有模型对当前场景下分类正确率低的问题,同时融合模型能够提取多方面的语义特征,提升模型性能,并且实现端到端的全流程训练方式,具备广泛的应用场景和商业价值。

[0053]

依据本技术方案,可以在5g通信助理应用场景下有效的部署与应用,实现自主研发能力的替代,同时实现各项nlp算法功能的持续优化。同时可以在运维工单文本分类、客服文本分类等任务中广泛应用。

附图说明

[0054]

为了更清楚地说明本发明实施例的技术方案,下面将对实施例的附图作简单地介绍,显而易见地,下面描述中的附图仅仅涉及本发明的一些实施例,而非对本发明的限制。

[0055]

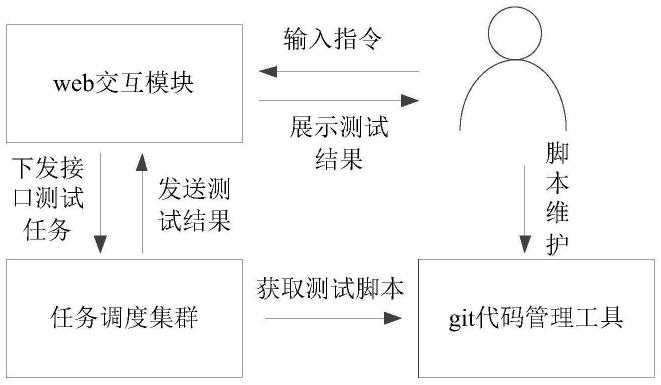

图1是示出依据本发明实施例的5g通信助理业务建模方法流程图;

[0056]

图2是示出依据本发明实施例的5g通信助理文本分类方法的流程图;

[0057]

图3是示出依据本发明实施例的基于bilstm模型和attention模型融合的网络结构;

[0058]

图4是示出依据本发明实施例的基于text cnn模型的网络结构;

[0059]

图5是示出依据本发明实施例的基于dpcnn模型的网络结构;

[0060]

图6是示出依据本发明实施例的基于textrcnn模型的网络结构。

具体实施方式

[0061]

为使本发明实施例的目的、技术方案和优点更加清楚,下面将结合本发明实施例的附图,对本发明实施例的技术方案进行清楚、完整地描述。显然,所描述的实施例是本发明的一部分实施例,而不是全部的实施例。基于所描述的本发明的实施例,本领域普通技术人员在无需创造性劳动的前提下所获得的所有其它实施例,都属于本发明保护的范围。

[0062]

除非另作定义,此处使用的技术术语或者科学术语应当为本发明所述领域内具有一般技能的人士所理解的通常意义。本发明专利申请说明书以及权利要求书中使用的“第一”、“第二”以及类似的词语并不表示任何顺序、数量或者重要性,而只是用来区分不同的组成部分。同样,“一个”或者“一”等类似词语也不表示数量限制,而是表示存在至少一个。

[0063]

图1是示出依据本发明实施例的5g通信助理业务建模方法流程图;图2是示出依据本发明实施例的5g通信助理文本分类方法的流程图。

[0064]

5g通信助理文本分类的方法基于5g通信助理全场景语料数据进行分类,语料数据包括通话id、通话内容、通话角色、通话场景类别、通话开始时间、通话结束时间的数据。

[0065]

如图1和图2所示,5g通信助理文本分类的方法包括如下步骤:

[0066]

s1、对语料数据进行asr(自动语音识别)转换,再对数据进行etl数据清洗操作,etl数据清洗包括:数据抽取、数据转换和数据加载,进而得到模型所需的原始语料数据集。

[0067]

s2、数据输入,采用参数级别上亿的预训练模型bert将每个输入的原始语料数据通过token(输入文本中的字)向嵌入(embendding)层传递,以便将每个token转换为字向量表示,同时bert还具有额外的嵌入层,额外的嵌入层包括以句向量嵌入和位置向量嵌入的形式;将字向量、词向量和位置向量进行合并,生成训练数据,传递给bert的嵌入层进行输出。

[0068]

s3、由bert的嵌入层将训练数据输入到分类模型,由分类模型分别进行训练,分类模型包括基于attention机制改进的bilstm(双向lstm)模型、text cnn模型、dpcnn模型、text rcnn模型。

[0069]

s4、结果融合,将由基于attention机制改进的bilstm模型、text cnn模型、dpcnn模型、text rcnn模型输出的语义特征,分别输入至分类器层,进而得到分类场景下各分类类别的预测概率。

[0070]

s5、将步骤s4得到的各分类类别的预测概率,采用算数平均进行融合,输出分类结果。

[0071]

本发明在平衡网络深度的同时,用bert模型作为词嵌入层,可以通过在海量的语料的基础上运行自监督学习方法为通信语料文本学习一个较好的特征表示。

[0072]

根据本发明的一个或一些实施例,在步骤s1后,可再对原始语料数据集进行包括分词、去掉停用词的操作。

[0073]

图3是示出依据本发明实施例的基于bilstm模型和attention模型融合的网络结构。

[0074]

如图3所示,因单方向的长短期记忆神经网络(lstm)模型是基于历史时间节点(前一时间点)的语义信息训练模型,进而预测当前时间节点的语义信息,一般当前时间点的语义信息输出仅仅蕴含历史时间点的序列语义信息,缺失当前时间点未来的序列语义信息。因此融合模型采用双向lstm(bi-lstm)来获取每个字词的上下文语义信息,bi-lstm通过前向和后向的lstm捕获第t时刻前向隐藏层backward

t

和后向隐藏层状态向量forward

t

,然后融合forward

t

和backward

t

形成最后隐藏层状态向量last

t

作为第t时刻节点对应的字词上下文语义向量表示,前向隐藏层状态向量forward

t

的计算过程如下:

[0075]it

=f(wi·

[forward

t-1

,e

t

] bi)

ꢀꢀ

(1)

[0076]ft

=f(wf·

[forward

t-1

,e

t

] bf)

ꢀꢀ

(2)

[0077]ot

=f(wo·

[forward

t-1

,e

t

] bo)

ꢀꢀ

(3)

[0078]ct

=f

t

*c

t-1

i

t

*tanh(wc·

[forward

t-1

,e

t

] bc)

ꢀꢀ

(4)

[0079]

forward

t

=o

t

*tanh(c

t

)

ꢀꢀ

(5)

[0080]

其中,forward

t-1

是第t-1时刻前向隐藏层状态向量,e

t

是嵌入层第t个位置的输出向量,f是sigmoid激活函数,w权重矩阵,b是偏置项矩阵,tanh是双曲正切函数,*是元素方式的乘积运算,c

t

是状态变量,c

t

和输出门一起决定最后的输出;因bilstm网络结构中遗忘门策略,上下文语义信息的缺失不可避免,因此融合模型将bert输出的词向量喂入bilstm模型,进而得到每个单词的最终上下文表示

[0081][0082][0083]

其中,代表向量拼接运算;

[0084]

在bilstm模型后融合注意力机制(attention)模型能将每个字词的上下文表示向量分配一个重要度(权重)来衡量不同字词对文本全局语义特征的重要程度,进而得到文本全局语义特征表示f

global

,f

global

的计算公式如下:

[0085][0086][0087][0088]

其中,ww是可训练参数,bw是偏置项矩阵,是u

t

的转置矩阵,uw是一个随机初始化的、可学习的词级别上下文向量,a

t

是第t时刻单词的归一化权重。

[0089]

图4是示出依据本发明实施例的基于text cnn模型的网络结构。

[0090]

如图4所示,text cnn模型包括输入层(embedding layer)、卷积层(convolution)、池化层(pooling)、全连接层(fc);输入层是由bert的embendding层进行输入表示的词向量,pooling操作选择将卷积得到的列向量的最大值提取出来,相当于(pad_

size-filter_size 1)维变成一维,即将每个卷积核的最大值连接起来,即通过pooling来消除句子之间长度不同的差异,池化层后面加上全连接层,并添加用于防止过拟合的l2正则化和dropout正则化方法;最终的输出层需要进行softmax概率归一化,然后使用softmax后的预测输出结果和真实标签计算交叉熵损失。

[0091]

图5是示出依据本发明实施例的基于dpcnn模型的网络结构。

[0092]

如图5所示,dpcnn模型通过包括不断加深网络、固定feature map的数量的操作,实现抽取长距离的文本依赖关系,其中,每当使用一个size=3和stride=2进行max pooling进行池化时,每个卷积层的计算时间减半(数据大小减半),从而形成一个金字塔(pyramid)。相当于在n-gram上再做n-gram,越往后的层,每个位置融合的信息越多,最后一层提取的就是整个序列的语义信息。

[0093]

图6是示出依据本发明实施例的基于textrcnn模型的网络结构。

[0094]

如图6所示,text rcnn模型将卷积层换成双向rnn(循环神经网络),从而形成双向rnn、池化层、输出层的网络结构,用双向循环结构获取上下文信息,这比传统的基于窗口的神经网络更能减少噪声,而且在学习文本表达时可以大范围的保留词序;其次使用最大池化层获取文本的重要部分,自动判断哪个特征在文本分类过程中起更重要的作用。text rcnn模型训练包括如下步骤:s31、第一栏中间的word embedding层,输入的句子维度为[batch_size,seq_len],seq_len为输入的句子的长度,然后经过embedding层,加载预训练词向量或者随机初始化,词向量维度为embed_size,最终embedding layer层的输出为[batch_size,seq_len,embed_size];s32、接着将embedding layer层的输出输入到双向rnn中,前向和后向所有时刻的隐层状态输出分别都是[batch_size,seq_len,hidden_size];s33、拼接操作,需要同时把前向、后向、embedding layer三层输出拼接到一起,最终的维度为[batch_size,seq_len,hidden_size*2 embed_size]。

[0095]

根据本发明的一个或一些实施例,步骤s4中,结果融合将bilstm模型和attention模型融合输出的全局语义特征表示为f

global

,将textcnn模型输出的局部语义特征表示为f

local1

,将dpcnn模型输出的深层局部语义特征表示为f

local2

,将textrcnn模型输出的局部语义特征表示为f

local3

;然后分别将f

global

输入至softmax1分类器层,进而得到分类场景的各分类类别的预测概率矩阵p1,将f

local1

输入至softmax2分类器层,进而得到分类场景下各分类类别的预测概率矩阵p2,将f

local2

输入至softmax3分类器层,进而得到分类场景下各分类类别的预测概率矩阵p3,将f

local3

输入至softmax4分类器层,进而得到分类场景下各分类类别的预测概率矩阵p:

[0096]

p1=soft max1(wg·fglobal

bg)

ꢀꢀ

(11)

[0097][0098][0099][0100]

其中,wg,为训练权重矩阵,bg,为偏置项。

[0101]

根据本发明的一个或一些实施例,步骤s5中,结果输出对结果融合层输出的概率矩阵p1,p2,p3,p4,采用取算术平均数的方式进行融合,得到分类类别的最终预测概率矩阵p

final

:

[0102][0103]

采用最小化交叉熵损失函数作为模型训练的目标函数进行模型的迭代优化。

[0104][0105]

其中,n为训练样本数,c为类别数,q为样本的真实标签,采用one-hot进行编码,λ时l2正则化超参数。

[0106]

本发明将bilstm模型与attention机制模型相结合的方式提取全局语义特征和全局语义信息,同时融合textcnn模型提取文本多维度的局部语义特征,融合dpcnn模型抽取长距离的文本依赖关系,融合text rcnn模型获取上下文信息,在学习文本表达时可以大范围的保留词序,获取文本的重要部分,融合模型具备更高的预测准确度。

[0107]

根据本发明的一个或一些实施例,5g通信助理文本分类的方法还包括步骤:s6、模型评估,通过采用包括准确率acc(accuracy)、精确率pre(precision)、召回率rec(recall)及f

1-score值的评价指标,对融合模型效果进行评价,计算公式如下:

[0108][0109][0110][0111][0112]

其中,tp是将正类预测为正类的样本数,fn是将正类预测为负类的样本数,fp是将负类预测为正类的样本数,tn是将负类预测为负类的样本数。

[0113]

为了提升服务质量,挖掘数据潜在价值,本发明采用一种融合深度学习模型进行文本分类,针对5g通信助理的特征,发明了一种融合深度学习模型的5g通信助理文本特征分类方法。该方法通过端到端的方式学习特征表示并解决了文本表示稀疏、高维度的问题。在基于深度神经网络模型的文本分类方法中,文本卷积神经网络(textcnn)模型采用跨空间模式,借助滑动空间窗口大小来捕捉文本的局部语义特征,但textcnn有个最大问题是固定filter_size的视野,一方面无法建模更长的序列信息,忽视了句子在时间维度上的先后顺序,另一方面filter_size的超参调节也很繁琐;循环神经网络(recurrent neural network,rnn),能够更好的表达上下文信息,bi-directional rnn(双向lstm)从某种意义上可以理解为可以捕获变长且双向的的"n-gram"信息。其采用递归计算获得全局语义特征,常用于识别跨时间维度的模式,但是缺乏捕捉局部语义特征的能力。循环卷积神经网络(textrcnn)模型将用于捕获上下文信息的循环结构和具备捕获局部语义特征的卷积结构相结合,无需人工设计的特征,自动判断最大池化层哪些词在文本分类中起关键作用,以捕捉文本中的关键成分。深度金字塔卷积神经网络(dpcnn)是一种基于word-level级别的dpcnn网络,dpcnn通过不断加深网络,可以抽取长距离的文本依赖关系,但是dpcnn网络的加深会损失更多的语义信息。基于注意力机制(attention mechanism)模型能将有限的注

意力集中在重要语义信息上,但它未考虑词与词之间的先后顺序关系;上述深度学习模型因其网络结构差异,在具备自身优势的同时也存在一些不足。本发明采用一种融合深度学习模型在尽可能减小网络深度的前提下融合了多个模型的优势,用bert模型作为词嵌入层,以获得更好的通信语料文本表示,用bilstm与attention相结合的方式提取全局语义特征,用textcnn模型提取文本多个粒度下的局部语义特征,采用dpcnn模型抽取长距离的文本依赖关系,采用text rcnn模型获取上下文信息,在学习文本表达时可以大范围的保留词序,最大池化层获取文本的重要部分。最后把四个模型的结果通过取平均值进一步融合,进而预测出场景文本分类类别。融合模型可以利用各模型的优势,并提取多方面的语义特征来保留更多的语义信息,具有更好的泛化能力,更高的预测准确度。

[0114]

根据本发明的第二个方面,提供一种5g通信助理文本分类的装置,其包括:输入模块、bert嵌入模块、分类模型模块、结果融合模块和结果输出模块。

[0115]

输入模块对语料数据进行asr(自动语音识别)转换,再对数据进行etl数据清洗操作,etl数据清洗包括:数据抽取、数据转换和数据加载,进而得到模型所需的原始语料数据集。

[0116]

bert嵌入模块采用参数级别上亿的预训练模型bert将每个输入的原始语料数据通过token(输入文本中的字)向嵌入(embendding)层传递,以便将每个token转换为字向量表示,同时bert还具有额外的嵌入层,额外的嵌入层包括以句向量嵌入和位置向量嵌入的形式;将字向量、词向量和位置向量进行合并,生成训练数据,传递给bert的嵌入模块进行输出;由bert的嵌入模块将训练数据输入到分类模型模块,由分类模型分别进行训练。

[0117]

分类模型模块包括基于attention机制改进的bilstm(双向lstm)模型、text cnn模型、dpcnn模型、text rcnn模型。

[0118]

结果融合模块将由基于attention机制改进的bilstm模型、text cnn模型、dpcnn模型、text rcnn模型输出的语义特征,分别输入至分类器层,进而得到分类场景下各分类类别的预测概率。

[0119]

结果输出模块将各分类类别的预测概率,采用算数平均进行融合,输出分类结果。

[0120]

本发明采用面向5g通信助理多场景语料数据的建模方法,解决现有模型对当前场景下分类正确率低的问题,同时融合模型能够提取多方面的语义特征,提升模型性能,并且实现端到端的全流程训练方式,具备广泛的应用场景和商业价值。

[0121]

根据本发明的一个或一些实施例,5g通信助理文本分类的的装置还包括:模型评估模块,模型评估模块通过采用包括准确率acc(accuracy)、精确率pre(precision)、召回率rec(recall)及f

1-score值的评价指标,对融合模型效果进行评价。

[0122]

依据本技术方案,可以在5g通信助理应用场景下有效的部署与应用,实现自主研发能力的替代,同时实现各项nlp算法功能的持续优化。同时可以在运维工单文本分类、客服文本分类等任务中广泛应用。

[0123]

根据本发明的又一方面,提供一种5g通信助理文本分类的设备,包括:存储器、处理器及存储在存储器上并可在处理器上运行的5g通信助理文本分类程序,5g通信助理文本分类程序被处理器执行时实现上述的5g通信助理文本分类方法的步骤。

[0124]

根据本发明还提供一种计算机存储介质。

[0125]

计算机存储介质上存储有5g通信助理文本分类程序,5g通信助理文本分类程序被

处理器执行时实现上述的5g通信助理文本分类方法的步骤。

[0126]

其中,在所述处理器上运行的5g通信助理文本分类程序被执行时所实现的方法可参照本发明5g通信助理文本分类方法各个实施例,此处不再赘述。

[0127]

本发明还提供一种计算机程序产品。

[0128]

本发明计算机程序产品包括5g通信助理文本分类程序,所述5g通信助理文本分类程序被处理器执行时实现如上所述的5g通信助理文本分类方法的步骤。

[0129]

其中,在所述处理器上运行的5g通信助理文本分类程序被执行时所实现的方法可参照本发明5g通信助理文本分类方法各个实施例,此处不再赘述。

[0130]

通过以上的实施方式的描述,本领域的技术人员可以清楚地了解到上述实施例方法可借助软件加必需的通用硬件平台的方式来实现,当然也可以通过硬件,但很多情况下前者是更佳的实施方式。基于这样的理解,本发明的技术方案本质上或者说对现有技术做出贡献的部分可以以软件产品的形式体现出来,该计算机软件产品存储在如上所述的一个存储介质(如rom/ram、磁碟、光盘)中,包括若干指令用以使得一台终端设备(可以是手机,计算机,服务器,空调器,或者网络设备等)执行本发明各个实施例所述的方法。

[0131]

以上所述仅是本发明的示范性实施方式,而非用于限制本发明的保护范围,本发明的保护范围由所附的权利要求确定。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。